*移動・再投稿(元 https://qiita.com/kzuzuo/items/9a149e69642ee7b3221e )

*20211003,502 bad gateway対策として,前,中,後へ分割

前 https://qiita.com/kzuzuo/items/4670b5ff7526319680f4

中 https://qiita.com/kzuzuo/items/237b9f5192464817aa40

後 https://qiita.com/kzuzuo/items/756470e6e17c54aa5e2e

2018年4月頃より余暇業務外で,知財関連AI,SDIと連動して教師類似特許抽出・スコア順並び替えを行う点眼分野専用自動化AI,の実装・実データでの試行と検証を行ってきた.

2018年10月頃完成,2019年4月現在は試行しつつの改良・検証段階.

モデルの個性が見られ続けている.

何に起因するどのような個性であるのか知りたくも,本業が忙しくなり余暇においても優先として時間配分できなくなっている.

しかし知りたい.個性があるならそれをコントロールすることで,様々に活用ができるはずだ.

いっそのこと公開してみる.

どなたか協力,またはこれらから課題発見し検討・公開してくれることを願って・・・

*以下,随時更新追記します.区切りを見つけてまとめ直す予定.

*以下,*と()はメモ(*と()だらけのネタ帳と化している.)

*思いつき即なぐり書きしており穴だらけ.考えが変わり矛盾している箇所も多々.

*繰り返される追記により話が前後している部分が多くある.

*複数の言語を混ぜると検索し難くなるため基本的に日本語に統一。google翻訳そのものを貼り付けたりもする。

*専門が異なり固有名詞が出てこない.自分の考えはP.インクベルセンの「情報検索研究一認知的アプローチ」にほぼ記載されていたのでこれに使用されている用語に書き直してゆく.

*2019年4月に提唱のあったMachine behaviorが,本件における該当分野となってゆくのだろう.

*実装しながら論文読みついで基礎を学び忘れ学び過去の通説は覆され,適切な知識形成がおっつかないよ!と泣き言を書いてみる.

*未だに自分が既存の技術のうち何に該当することをしているのか,どの部分が既存ではないのか,理解していない.この理解は実装においては近視的にはあまり重要ではないのだが,わかっていないことがわかっていない状態が維持されれば,必ずどこかで失敗の道に迷い込むことになる.知らねば.

*用語「AI」について.複数のモデルを扱いまた組み合わせ組み替えてゆくに当たり,深層でないモデルやニューラルと言えないモデル,機械学習とも言えない知識グラフなども扱ってゆく.end2endでない場合,表現が難しい.モデルをまとめて表すときには,用語「AI」と広い定義で記載することとする.

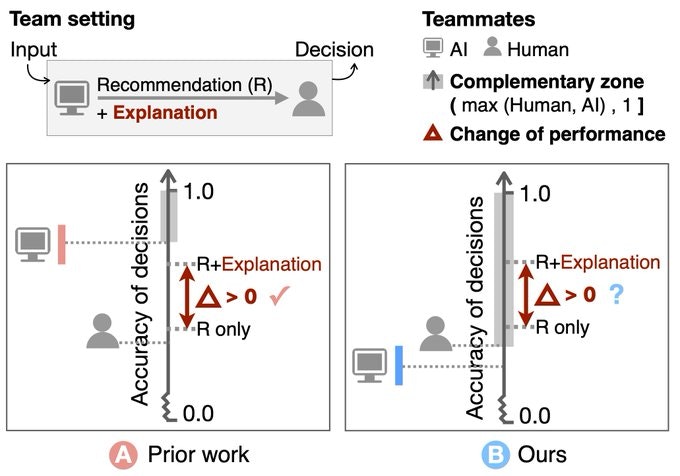

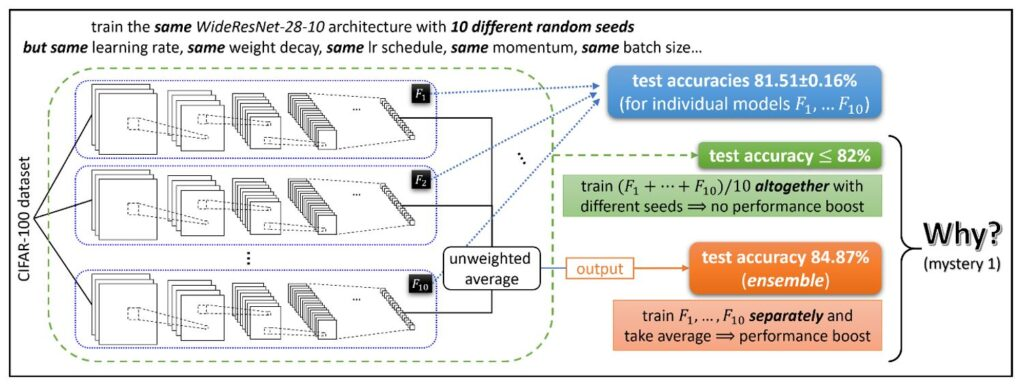

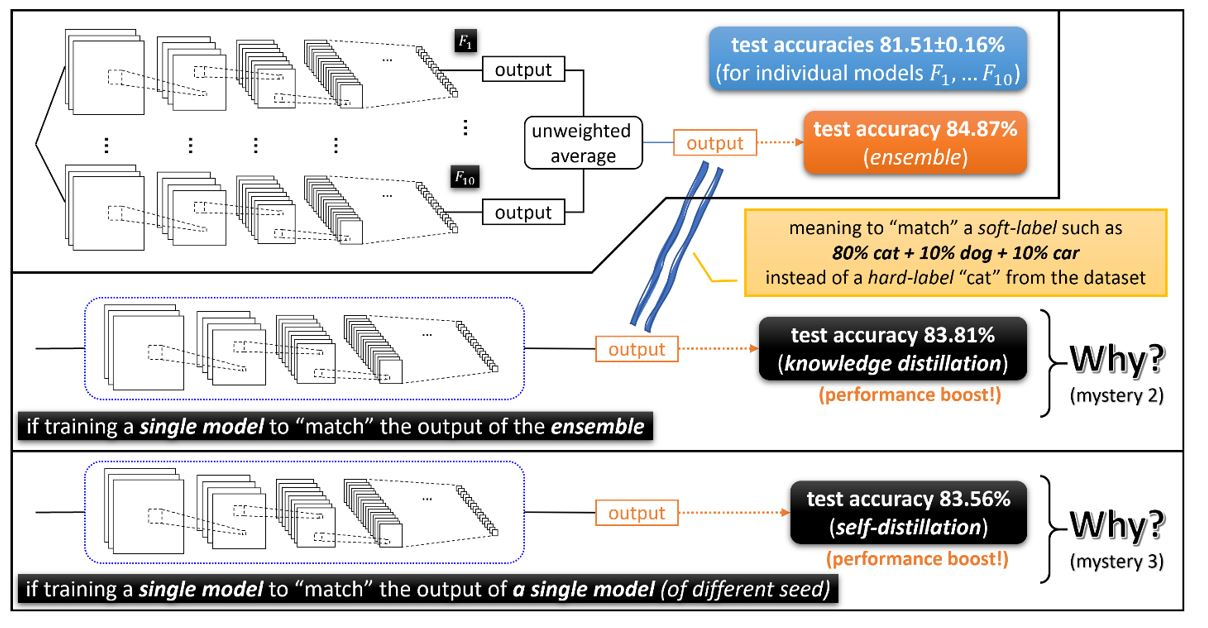

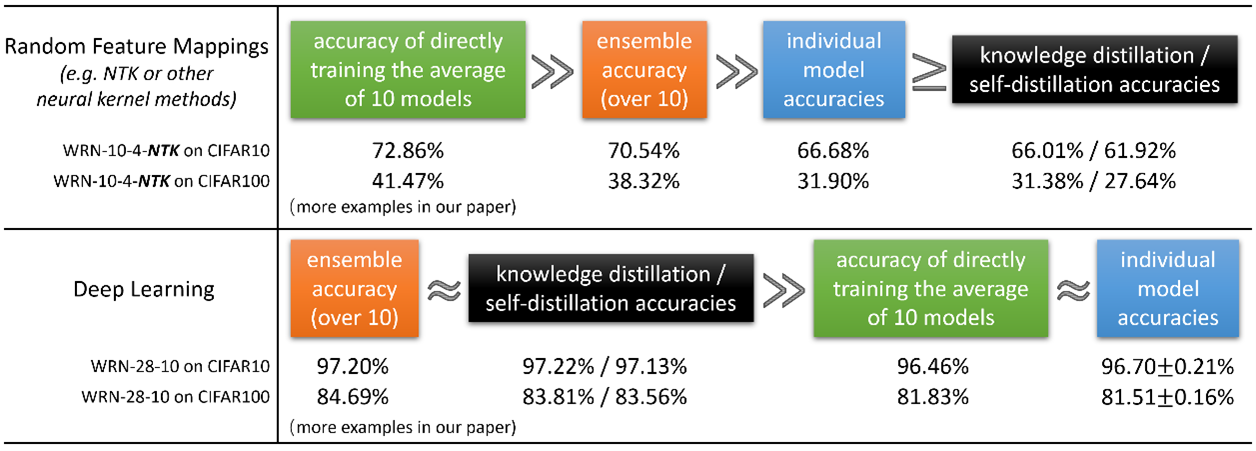

・202105時点において最新である、同じような疑問に向き合っている内容を持つまとまった記事は、次であろうと思われます。

Three mysteries in deep learning: Ensemble, knowledge distillation, and self-distillation

Published January 19, 2021

By Zeyuan Allen-Zhu , Senior Researcher Yuanzhi Li , Assistant Professor, Carnegie Mellon University

https://www.microsoft.com/en-us/research/blog/three-mysteries-in-deep-learning-ensemble-knowledge-distillation-and-self-distillation/

Towards Understanding Ensemble, Knowledge Distillation and Self-Distillation in Deep Learning

https://arxiv.org/abs/2012.09816

Are Pre-trained Convolutions Better than Pre-trained Transformers?

arXiv:2105.03322 (cs)[Submitted on 7 May 2021]

https://arxiv.org/abs/2105.03322

やっと、やっと、引用を追えば良いと言える文献が現れた・・・

やってきた:

複数の深層学習モデルを組み合わせた自然言語AI実装の一例と

モデルの多様性に注目した展望(概報)

2018年12月提出

http://patentsearch.punyu.jp/asia/2018hayashi.pdf

https://sapi.kaisei1992.com/wp-content/uploads/2019/03/2018hayashi.pdf

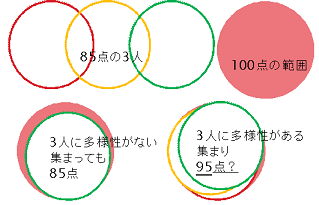

- 複数のモデルの個性とその多様性を評価するシンプルな手法.

- モデルCの市販AIは、201903にBERTに置き換えている.

- recall,AUCを評価基準として良好な結果が出ている.必要性はあり実現可能であり再現もある.ただし,実効性は不明. (評価データセットが十分でないので数値評価はしていない.→9ヶ月実データ試用結果は下記の通り.実効性があると言ってよいだろう.→val460検証結果の一部は下記の通り.目的に対し十分だろう.)

- 今後,認知的観点と解釈学的概念から実用をふまえた理解を深める必要があるだろう. (自然言語に真値は存在しない,正しい答えに見えるためには個別の認知に適合することが重要,と前提.)(「情報検索研究一認知的アプローチ」p32参照。今後,テンプレートマッチング,特徴・統語分析,および文脈解析の観点を超えた理解を,認知的観点から進める必要があり,そうして初めて「実用」といえる段階になるだろう.)(認知検討→各モデルとヒト認知との比較実施.期待通り→検討中…)(創造性検討→創造性発揮例ありしかし満足できるものではない→改良中…)

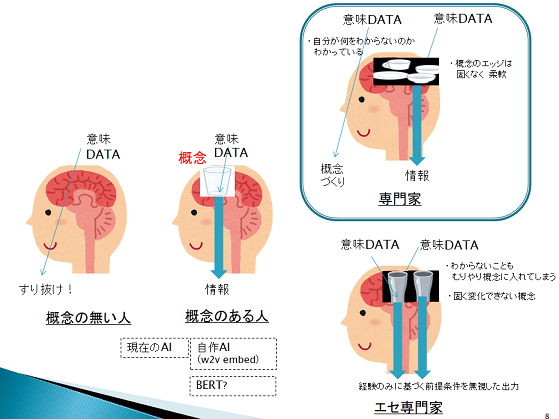

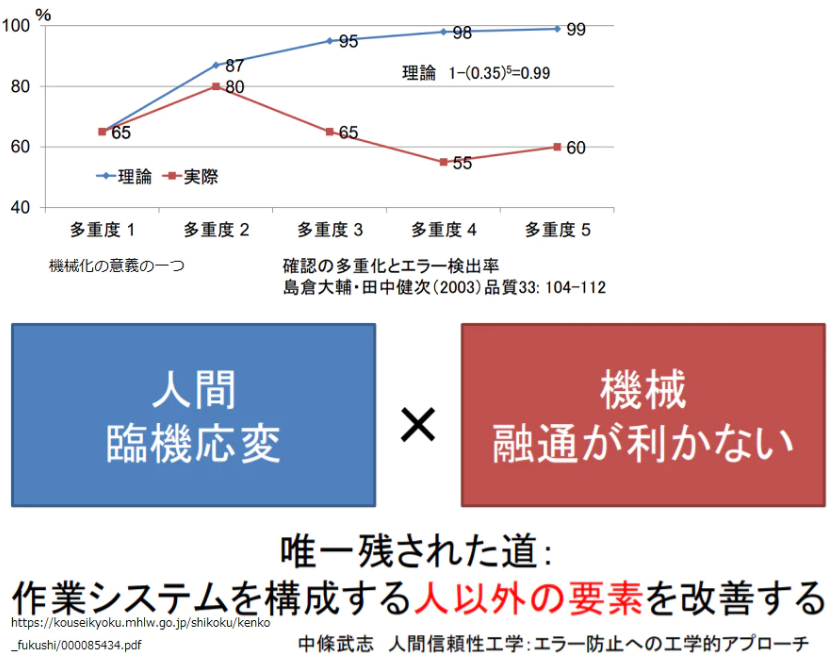

*このAI使用の前提は,ヒトが補完をすること.この種のAIには,今のところ,ヒトの代替をできるほどの能力はない.すでに人手が足りているならその代替にはならない.不可能を可能にしてくれるが可能をより良い可能にはしてくれない.その理解の上で,ヒト代替に近づくAIにできないか,個人用アシスタントAIとできるか,試してみたい.

(「情報検索研究一認知的アプローチ」p201参照。AIには従来のような概念知識を持たない「情報検索専門家」でなく、概念知識を持つ「専門家」となることを期待している.)

*AIを用いた実データによるSDI確認試行を9ヶ月続けた.その期間内において重要な特許を見落としたと言える案件は(再確認中だが見つかっているものは)多様性評価で上位15%(BERTモデルで48%とBERTが足を引っ張った)となった1件のみ.この1件もヒトが救済している.

人手が足りない会社における実用として,個人用アシスタントAIとして,十分ではないだろうか.

(判別しにくい分野の特許群ではこうはならないと思うけれど.難しいタスクを簡単なタスクに変換することも重要。)(それぞれのモデル(ヒト含める)の不得意分野が明確になれば,さらに性能をあげられるだろう.)(特許調査に100%はない,というのはその通り.母集団の外の特許は見つけられない.人が調査する際には確認可能な件数に母集団を限定する必要があるが,AIの場合その制限は少ない.この母集団を広く取ることができるという点においては,人よりAIの方が確実に優れていると言える.)(AIとヒトとで比較したとき,ヒトがすべての範囲で優れているということはない.例えば……先日ある調査会社にクリアランス調査を依頼し評価十分と言える方(この方の調査能力が低いと言う人は多分いないし,この方の調査能力が低いなら調査能力が高いと客観的に言えるヒトはほぼいないとなるだろう)に調査していただいたのだが,見事に最重要特許2件落としてだなぁ……この最重要特許はAIが拾い上げた.ここで言いたいのは,ヒトも完璧ではないようにAIも完璧ではない,AIが完璧でないようにヒトも完璧でない.ヒトをAIに置き換えることが難しいのと同じように,AIをヒトに置き換えることも難しい.ただ,ヒトとAIはお互いに補えうる,ということだ.AIが100%見分けたかどうかは結果に過ぎず最重要ではない.まず重要な問題は,ヒトとAIにつき,互いが間違える部分を再現性を持って補ってゆくことができるか,である.つまりアシスタントできるか,だ.)(ヒトとAIの協働には可能性を感じている.協働にはAIの個性を理解する必要があると感じている.個人用アシスタントAIがベストと,今も感じている.))(創造を組み入れた未来予測型の個人用AIが可能だと考えているし,まだ不可能を網羅していない(というか,創造性の部分にはまだほぼ手を付けていない.))

*現在,100カ国語+から日本語への翻訳機能を実装している.これはSDIで重要となる迅速な読解,ひいてはROIの向上に,大きく寄与する.

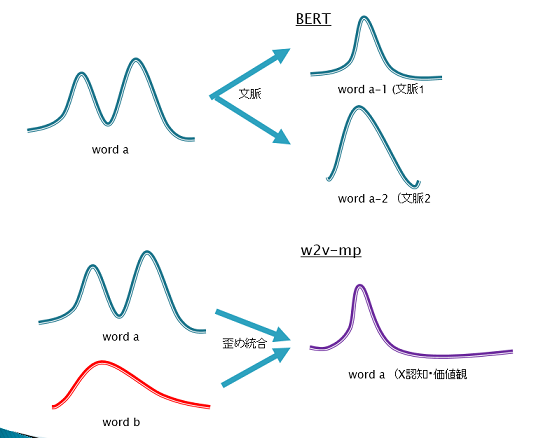

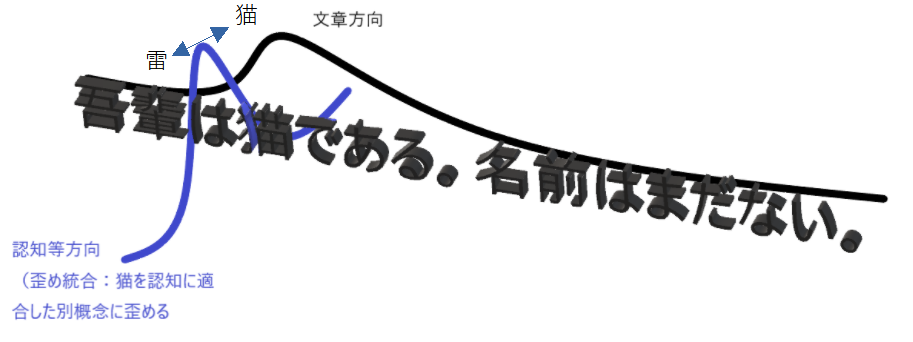

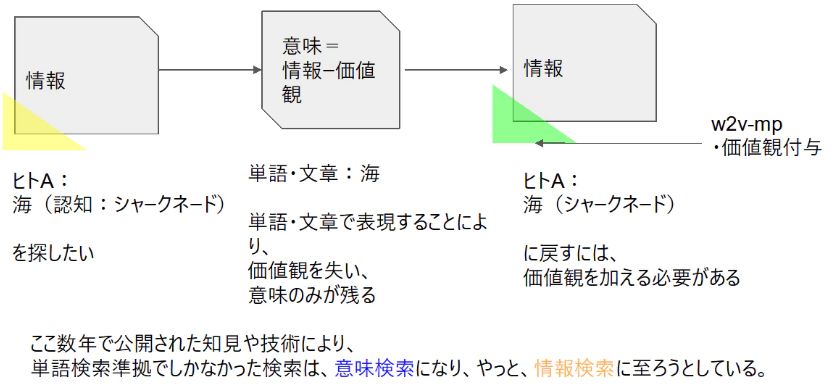

*分散表現モデルの学習に用いるコーパスを変化させる手法は従来から行われているが,その視点は多くが「意味」の範囲内・文脈レベルである(分野ごとの語彙や文型の違いなど)(のように見えているが,統計をとったわけでも最適なサーベイを見つけて確認したわけでもない).自分は意味を超えた「情報」・価値観レベルの視点で検討している.

(コーパスで何でもできると考えているわけではない.コーパスに基づく分散表現は必須,構造も必須,それらを如何に統合するかが課題だろう.)

*自分の勝手な思い込みは十分集まった.そろそろ基礎を進める時期か.課題認識してゆるく柔軟な概念をつくってから学ばないと右から左なのだよね.

(何かを知らないという飢餓感がモチベーションの源なのだが,多くのインプットに基づく課題の知が,何かを知らないという飢餓感の源泉となっている.)(固有名詞のような知識は飢餓感の源泉にはならないし,逆に無知の知を失い間違った安心感により飢餓感を失いうる.人によるだろうけれど.)

→coursera Deeplearning.ai Natural language processing 16週講義修了。T5、Reformer含むattention modelまでの講義。ちっとはマシになったかね。

→coursera How to Win a Data Science Competition: Learn from Top Kaggler 5週講義修了。一通りは撫でられたかな.

→Control and Robotics 多様体論へのいざない 基礎数学 大阪大学大学院

https://www.youtube.com/watch?v=6npSJdMQqVY

下記*()コメントへの修正をはじめよう。

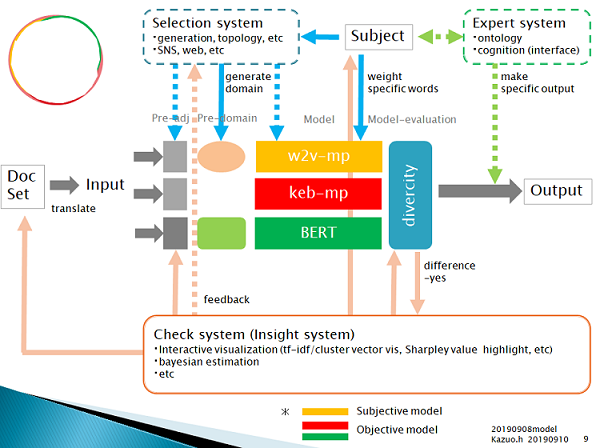

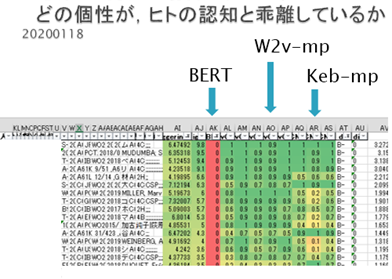

・201909現在のシステム構成.

Doc set(xlsx)をメールに添付して送信すると,output(xlsx)がメールに添付され返される.

・model: モデル

w2v-mp: word2vec pretrained maxpooling model. This like CNN.

keb-mp: keras embedding maxpooling model. This like CNN.

BERT: Bidirectional Encoder Representations

w2vkeb-mp: w2v-mpモデルのみがその個性を示したサンプルをkeb-mpモデルの正解教師に加え再学習するモデル(自己教師の一種?data augumentation?)。上位概念下位概念の発散収束コントロールテスト、創造性テスト用。並列でなく直列とした場合の理解を深めるために試行。

congnitive-w2v-mp:w2v-mpに対し任意にattentionを適用させるモデル。再事前学習不要にどこまでドメインの変化をコントロールできるかテストするために試用。

mbart、またはmT5追加予定

なお教師データは、正解教師データ約100件、不正解教師データ約100件としており、いずれのモデルにおいても同じ教師データを用いている。(少ない教師量から必要十分かつ最大の結果を得ることを目的の一つとしている。)(また教師データが頻繁に変わると意図しない特性となり得ることが明らかなので、教師データは最低限のみ変更することとする。)

・pre-adj: 前処理

入力テキストの前処理を行う.前処理方法はモデルにより異なる。oov処理含む。

*やっと事前知識分散表現において使わない語彙もそのベクトル空間を適切に作るには重要という考えに至った。oov処理はpre-domainにおいて主に行うこととする。

・pre-domain: モデルに与える事前知識

・Subject: 認知ベース.

・Check system(insight system, alert system, school system, knowledge distillation system): 学習・評価結果の理論化、作成された理論や任意の教師無しモデルなどを利用したフィードバック補正、創造? 類似を提示することによる説明

Expert systemの逆.

知識構造があることが明確であり、構造がシンプルであり、構造が未知ならば、構造をシンプルに取り出し適用させましょうってこと。

tfidf embeddings/cluster vis: tfidf-word2vec-clustering visualization 目視確認と自動母集団検証・修正。さらに、高スコア結果それぞれに近似する特定範囲を抽出して教師データをaugmentationし再学習してもよいし、好スコア結果から重要な特徴を抽出してexpert systemに渡してもよい。検証中。

Bayesian estimation: Bayesian Designと記載すべきか.自動仮説最適化データ作成・修正.自動概念追加.(expert systemに渡す、決定木とベイジアンネットワークを組み合わせた特徴量エンジニアリングシステムも作成中)

SHAP highlight: 目視確認と事前知識と比較した自動仮説最適化データ作成・修正

mbart: 検証中

mT5: 検証中

多様性評価手法は2年間特に問題ない結果を出力してきた。2年間の全データを使用して、一つの蒸留モデルを組み、検討に入れる予定。

・Expert system: 外部から持ち込んだ理論の適用

巨人の肩、メタ構造、構造、human in the loop 含む。外部足場scaffolding?

check systemの逆.外部から持ち込んだ理論とは,check systemが作り上げた理論も含む(けれど,いまのところ吟味して適用したいので図の中ではつなげていない.) メタ構造も含む。

関連を因果に変換.専門的認知と検索者認知に適合させる.

知識構造が明確であり、構造が既知ならば、その構造を優先させましょうってこと。

特定のメールアドレスに単語を入力して送信すると、その後、モデルがその単語を自動的に重視するようにしてある。気になった出来事があればメール送信しておくだけ。自分の認知との適合性向上についてもっと簡略化したいが現状ここまで。

(現状,簡易的なオントロジーと,単語重視,特定分類重視による.)(この部分で文章検索の利点と単語検索の利点が融合するハイブリッドとしている.)(このexpert systemは過去にあったそれと異なり,支配的影響力を持たず,多様性を持つ個性の一部として不足を補うように働く.)(データに含まれる差別(データのバイアス)を素直に抽出してしまう点で、AIは子供だ。差別とは社会的に生み出された必然性のない概念であり、子供には基本的にわからない。必要な差別と不要な差別を見分ける必要があり,そのため、AIには大人のバイアス(モデルのバイアス:モデルの個性により与えられるバイアス.バイアスを加えられ形成された事前確率や構造といってもよい?)を与えておかないといけないと思う.(データのバイアスは無くすことができないのだから(check systemで手を入れているけれど),適切と思われるモデルのバイアスをかけて補正することは健全だと思う.ヒトではこれを教育と呼んでいるはず.様々な教育(真値のない複数の適切と思われるモデルの個性による関与)は多様性を提供する.これは歓迎されることだろう?(きちんと評価する能力があれば,だが).)。損失関数などにより方向性を与えデータから自発的に学ばせることにより教育がなされるが,それだけでは不要な差別も採用されてしまう.不要な差別を除き適切な差別を採用「されやすく」するためのモデルの個性であり,その個性の一つ(比較的まっとうで限定的な知識を持つ個性)としてのexpert systemと言っても良い?.)(データのバイアスと不足、情報のバイアスと要約、知識のバイアスとエッジの間違い、知恵のバイアス。色々ごっちゃになっていることが多くの問題を生み出している気がする。)(ある画像分類モデルが学習により2通りの正答ルートを作り上げたとする。Aルートは犬の顔を認識して犬と分類した。Bルートは背景の芝生を認識して犬と分類した。さて、どちらが正解だろうか?。実は双方正解だ、またはどちらが正解とは言えないというのが正解だ。教師は、犬自体を認識させたかったのかもしれず、芝生にいる犬を全体として認識させたかったのかもしれない。これが与えられていないときに不正解は問えない。このように、結果は結局、教師の認識に依存してしまう。(そして結果は結局、教師でない受け手が自ら仮定した認知において判断される)(画像では絶対的な答えを与えられうるだろうとしても、自然言語では絶対性はよりあいまいになり絶対的な答えを与えがたくなる)。

我々は常に、質の良いデータを利用した、質の良いルートに導く、優秀な教師となれるだろうか?。なれない。この花何?と聞かれたら名前を答える。このような教師であって疑問に思わない程度の教師がほとんどだろう。そこで過去の優れた教師による結果、巨人の肩を利用することになる。これが、ここに記載したExpert systemの役割となる。)(一言で言えば、ルールと法律の積み重ねの違い、と言えようか?)

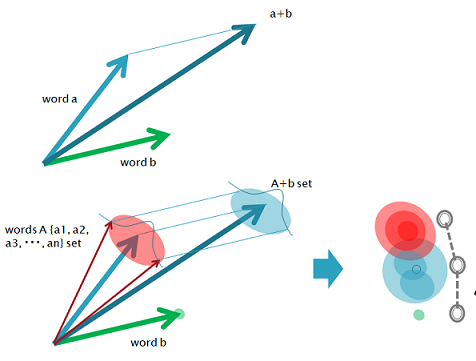

・Selection system: w2v-mpに対し,概念を「歪め統合」しニーズと検索者認知に適合させ,創造性を付与する.

(多分,Retrofittingと呼ばれる技術の範囲内なのだと思う.)(未知語処理含む.)

・divercity: 多様性評価手法

(現状,ある閾値で足切りしその範囲内でFP件数を考慮した重み付けをを行う評価基準を用いており,認知・正解両面において,良好な結果が得られている.)(引き続き,安定性があるかどうか,理由がわかるかどうか,最適なエキスパートシステムは何か考慮しつつ、新たな評価基準の設定を進めている.)(モデルの個性に基本特性があるようなので、メタモデル化する予定。メタモデルの評価は弱く考慮する。)

*現在のAI分野において最高に面白いと思っていることは、帰納的でブラックボックスな予測から、演繹的な仮説を生み出し、データを追加した後それを再度帰納的予測にかけ仮説深化してゆくループだ。

このような事が計算機上で可能となった時代に生きていることに興奮するし、これができるのと出来ないのとでは明確な差が出るだろうことに危機感も感じている.

*「言葉の集合と分布と概念の外縁とそしてエッジの動的平衡を扱う理系」という意味で、自然言語処理と知財は、かなり類似していると思う。外縁の作り方は課題によるとして、知財の皆がそれぞれ自らの課題に沿った自然言語処理を始めると面白いと思う。

「知財言語処理」という分野を作っても良いのではないだろうか.

*法律分野ではエッジ,概念の領域範囲の明確化,が重要となる.エッジを明確化するには曖昧さがないほうが良い.曖昧さをなくすには,Bowやルールベースを用いると良いだろう.法律分野のうち,例えば契約文章は重要語の多様性があまりないが,特許文章は重要語の多様性が大きく,類義語が多く表現の解像度が異なりもする.契約文章では相性通りのBoWやルールベースを当てはめやすいが,特許文章ではそれでは限界がある.

特許文章は特殊で,エッジの重要性を保ったまま,文章の多様性にも対応させる,という,衝突しかねない概念を両立させないといけない.

特許文章処理は,自然言語処理において,かなり面白い分野,チャレンジするに値する分野となると思う.

*特許分野において様々にAIが利用できるであろうが,SDIでのAI利用は,前述のエッジと多様性に加え,適切に結果を出すには創造性が必要であろうことさらに受け手の認知を無視できないことから,基礎でありつつ難解で応用範囲が広い分野であると考えている.

まあつまり,面白いってこった.

やっている:

1. 本当にモデルに個性があるのか?

2. モデルに個性を作るには?

3. 多様性を評価しより良い結果を得るには?

4. モデルに創造性をもたせることはできるのか?

現状:

本業優先かつ基礎が成ってないためなかなか進まない.しかし結果は知りたい.

得られている結果:

1. 本当にモデルに個性があるのか?

あるようだ.

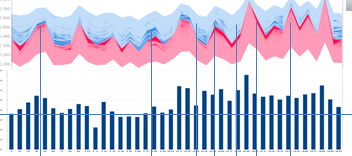

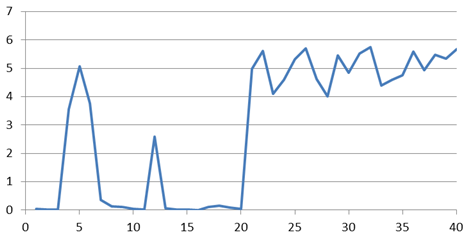

A.3つのモデルにおいてn=3の予測結果を比較してゆく過程で、正答不正答において,モデルに依存した個性らしき差が見られている.確率的多様性では無いようであった.

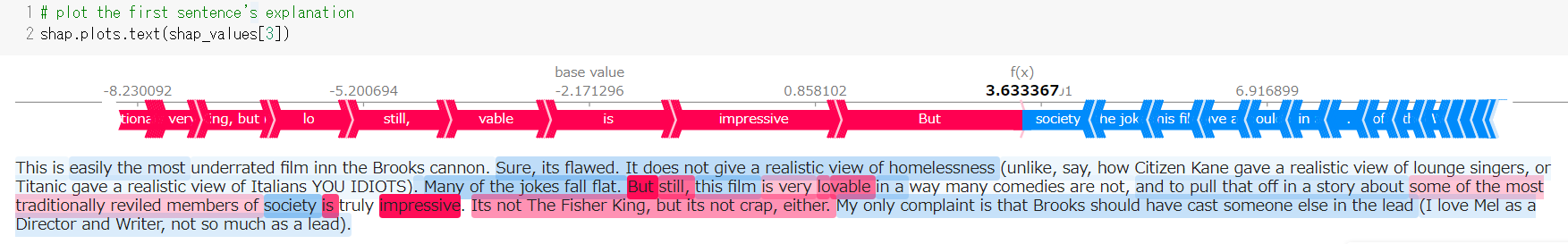

B.SHAP (SHapley Additive exPlanations) https://github.com/slundberg/shap を自然言語に適用し検討したところ,正答不正答において,モデル間に個性らしき差が見られている.

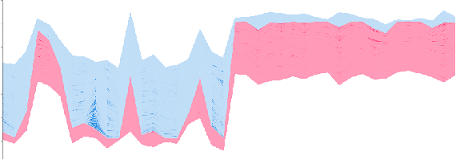

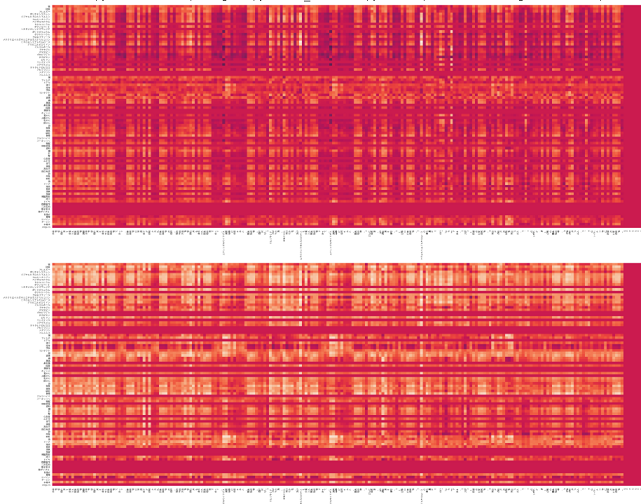

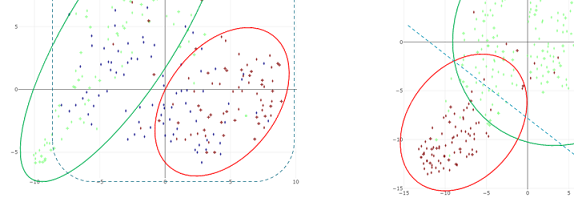

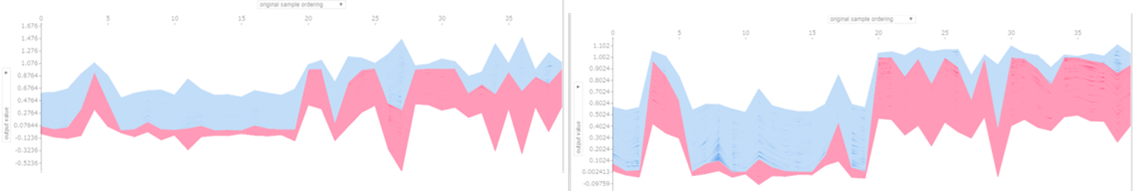

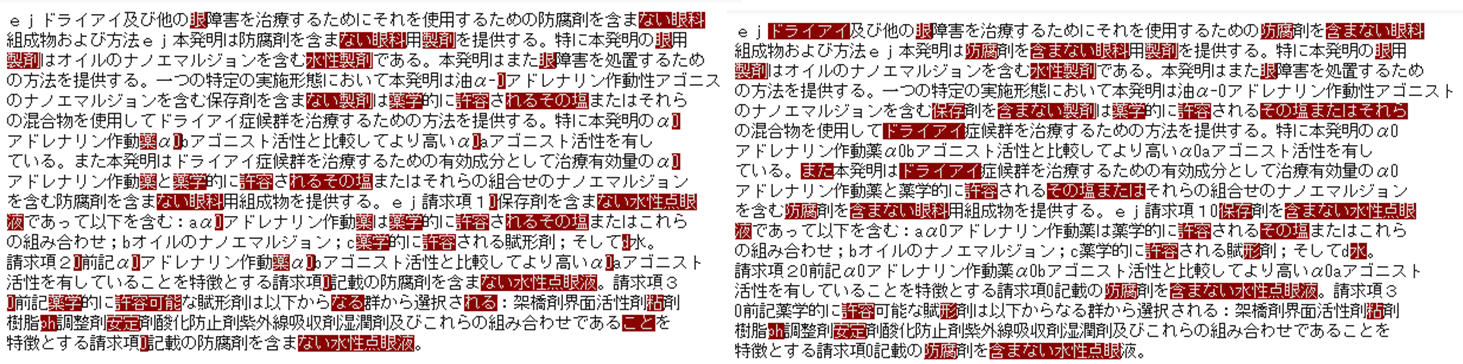

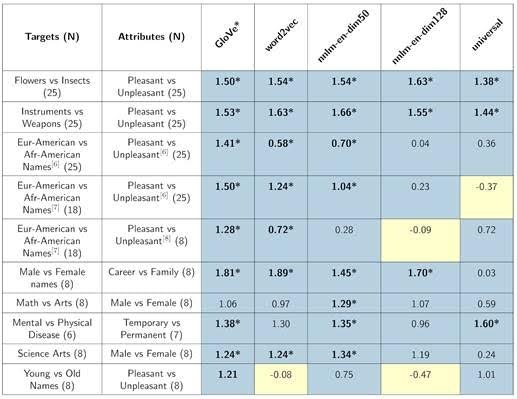

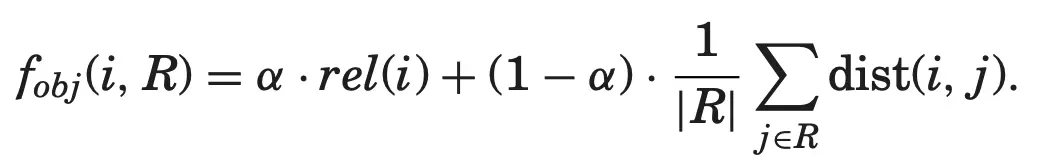

図1)force_plot.pre-trained word2vecベースのmaxpoolingモデル(左).keras embedベースのmaxpoolingモデル(右).

(横軸:バリデーション用特許文章40サンプル.左半分が不正解候補20件.右半分が正解候補20件.縦軸:赤帯青帯の境界は正解予測値.基本的に,赤帯は正解特徴の強さを表し,青帯は不正解特徴の強さを表す.)

・複数回試行したが,波形のパターンは安定.

乱数固定はしていない.左のモデルは学習のたびに予測値が変動しやすいのだが,それでも波形は安定.

*SHAP実例

Explainable machine-learning predictions for the prevention of hypoxaemia during surgery

https://www.nature.com/articles/s41551-018-0304-0

*次の資料はわかり易い。

How to use in R model-agnostic data explanation with DALEX & iml

https://www.slideshare.net/kato_kohaku/how-to-use-in-r-modelagnostic-data-explanation-with-dalex-iml

p116- SHAP

*SHAP を用いて機械学習モデルを説明する

https://www.datarobot.com/jp/blog/explain-machine-learning-models-using-shap/

*モデルにより波形が異なる.差があるということは価値があるということ.

=>あるモデルのみが正解できる部分を抽出してゆけば,総合性能は向上するはず.

*あるモデルのみが正解できる部分を抽出してゆくとは、モデルごとの集合を重ね合わせてゆくことと同じ。

適切な集合を重ね合わせることは、精度高くかつ再現率の高い結果、最終的に得た母集団の総合性能の高さ、を得るために、情報検索者が当然に行っていること(単一集合では不可能な精度再現率の両立を精度の高い集合に細分化して足し合わせることでカバーする)。

それぞれのモデルが汎用性の高い個性を持って精度の高い集合を作っているならば、モデルを組み合わせるとは情報検索者と同じことをしていると言える。

汎化された総合性能を考えるに、モデルの個性把握は重要。

(上記は交差エントロピーを前提としている)

双方ともに,他のモデルと個性が異なっているとは言える.しかし,正解候補の評価値と不正解候補の評価値の差が小さすぎ使いづらい.(分離を良くすることは容易だと思うのだがどのような設計思想なのだろう.)(市販AIはランダムフォレストではなかったはずだがなぜこれほど似たのか.)(再確認するも,変わらず.)(個人的には、決定木から得られる集合に関するルールを良いモデルの個性として使えるか疑問に思っている。単体で使う場合は問題ないのだろうけれど。)

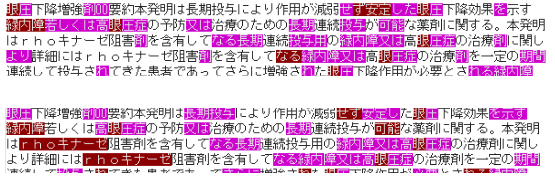

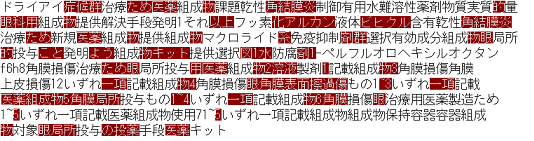

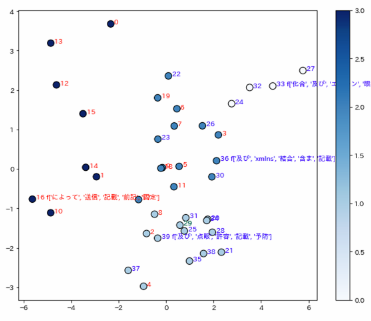

C.SHAP値を用い重要語にハイライトをつけたが・・・単語ベースでは明確なモデル間差は見られていない.=>見られた.

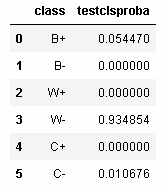

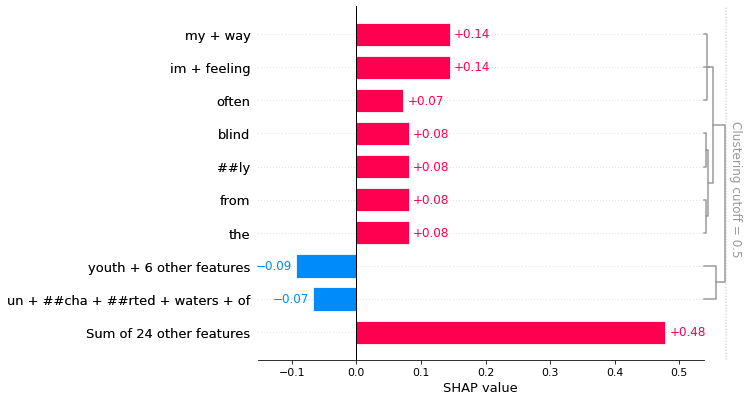

図2)pre-trained word2vecベースのmaxpoolingモデル(左)とkeras embedベースのmaxpoolingモデル(右)でSHAP値上位となる単語を比較(個性差が見られなかった特許の場合の1)

code

・正答不正答における個性差が見られなかった特許(図2)において,ハイライトされた単語に大差はないように見える.再現性もある.(あえていえば右のモデルのほうがtfidf的か.)(いや異なると判断すべきだろう→個性比較へ)

・正答不正答における個性差が見られた特許において,ハイライトされた単語に明確な差があった.(左のモデルでは期待通りの「価値観に基づく類義・関連語の統合」が起きているようだ.調査方針が丸わかりになるため公開せず.)

*正答不正答における個性差が見られなかった特許のうち不正解と正答されない傾向にあった特許において,ハイライトされた単語は明らかなノイズであった.SHAPはノイズ発見の役にも立ちそうか.

・同じ単語でもSHAP値が異なることがある.(図のモデルでは前後数単語poolしている.)

*少なくとも,記号系が得意なモデルと得意でないモデルがある.(これはモデルのアルゴリズムから予測できた.ただし,記号が付されていない特許でも差が現れているので,他にも差の原因があるのは確か.)(ウインドウサイズが個性に影響していないのだが,アルゴリズムからするとそうなる理由がわからない.)

*LIME https://github.com/marcotcr/lime も試用した.傾向はSHAPと似ていたが,再現性が低く機能語に当たりやすい傾向があった.

*主題と異なるが,ここから特徴語を取り出している.(特許と実製品とのリンクは重要である.特徴語からの実製品抽出を試行中.)

・BERT名詞限定におけるハイライト一例.

SHAPではない破壊手法.収束確認していない.再現性確認していない.

名詞限定としてもある程度妥当な語がハイライトされる.面白い.

(queryとkeyから得られるattentionにマルコフ性があるとして、queryの名詞に対し重みが大きいといえるkeyの単語は助詞ではないであろうから当然か?。一応attentionの重み付けをしたベクトルかattention自体と比較しておこう。)

*なぜその特許を正答としたのか擬人化した各モデルに尋ねればこんな回答が返ってくるだろうか.

・・w2v-mp:教えられた意味に基づけば異なるが私が思うに検索者は製剤特許という構造を持つものを情報として得たいのではないかと考えたため(うむ.実際はそうでもないが好ましい意見だ).

・・keb-mp:与えられた教師とデータを総合したところこれらが特徴と言えたから(真面目だ).

・・BERT:文脈から分類すると関連する単語はこれだったから.概念?因果?何それ(ファインマンに謝れ).

・・BERTm:肝と言える関連名詞がこれだったから.概念?因果?何それ(うむう).

・個性比較(正答不正答における個性差が見られなかった特許)

*w2v-mpではwswによりドライアイを強調していることに注意。wswを抜いて比較するのを忘れていた)

すべて,特徴らしい単語にハイライトがついており,モデルごとに異なっている.

単語における個性が確認できる.

どのモデルも正答している.そしてモデルごとに注目した単語が異なっている。正答とすべき根拠となる単語が複数あるところ,モデルごとに異なる視点で,ルートで,正答にたどり着いたように見える.

多様性評価において価値があるといえる個性となっているようだ.

(多様性評価において価値のある個性となっているかどうかについては,偶然そう見える結果のみ観ている,認知バイアスがある,可能性を否定しきれない.ある程度の検証と理論的考察がやはり必要だ。しかし,理論的背景がどのようであるか,考えもつかない(分布で表現することになるのだろうか.シンプルに単語の出現頻度で表現するか.).どうしたものか.手持ちのデータ全てを確認し,全てそう見える,とまとめてしまおうか・・・)

・後述するように,ヒト認知との適合にモデルごとに差が,ヒト認知における個性の存在が,観られている.

(この部分を突き詰めることにより、視点の違いが何故生まれるのか理解できるのではないか。)

*今更だが,個性の定義を明確にしておいたほうが良さそうだ.

個性とは,

・goo国語辞書によると「個人または個体・個物に備わった、そのもの特有の性質。個人性。パーソナリティー」.

・wikipediaによると「個人や個体の持つ、それ特有の性質・特徴。特に個人のそれに関しては、パーソナリティと呼ばれる」

はっきりしているな.

「モデル間に違いがあり,違いに再現性があれば,個性がある」と言っても良さそうだ.

あるモデルでしか正解できないサンプルが存在し,それに再現性があれば,そのモデルに個性があると言えるだろう.

ヒトの認知と常に近いモデルであり他のモデルよりも常に優れるのであれば,そのモデルに個性があると言えるだろう.

ヒトの認知のうちある範囲に付き,常に近いモデルであるならば,そのモデルに個性があると言えるだろう.

特有の性質はいくらでも考えられる.

モデルの個性は,「見つかった特有の性質を,他のモデルと比較し,総合的に」,表現すればよいか.比較対象には一般的なモデルも欲しいところだが・・・keb-mpのCNN版を一般的なモデルとすれば良いか.

(本文中で「個性らしき」「個性があるのでは」と書いてきたが,断言しても良さそうだ.)

疑問点・課題:

A. SHAPを正しく使用できているか

できているはず。

SHAPがいつの間にかテキストにもHuggingFace transformersにも正式に対応していた。比較確認する。

SHAPにおいて赤帯青帯の境界に示される正解予測値は予測値そのものと同じである.この出力ができている点については,SHAPを正しく使用できているはず.赤帯青帯の幅についても,SHAPを正しく使用できているはず.

個別の単語に対するハイライト強度については,SHAPを正しく使用できているはずだが,コードを追いきれておらずまたSHAPの自然言語への適用が少なく,確証がない.結果としては,妥当にハイライトされているように見える.

(特定の文章内における単語ハイライト妥当性、WSW実施時の単語ハイライト強度と予測値変動。)

*Keras LSTM for IMDB Sentiment Classification

https://slundberg.github.io/shap/notebooks/deep_explainer/Keras%20LSTM%20for%20IMDB%20Sentiment%20Classification.html

*モデルの個性を理解してゆくにあたり,理解に必要な手法が共通しているに越したことはない.SHAPは汎用性がありそうなのでできるだけ使ってゆきたいのだが.

(モデル限定となるがattentionからの理解が流行している.しかし疑問もあるそうだ.Attention is not Explanation https://arxiv.org/abs/1902.10186 )

*p26~モデルの解釈性(201908)

https://speakerdeck.com/mimihub/20190827-aws-mlloft-lt5?slide=29

*GoogleのExplainable AIはsharpley valueを計算しているとのこと.GoogleのExplainable AIが自然言語にどう対応してゆくか確認してゆくこと.

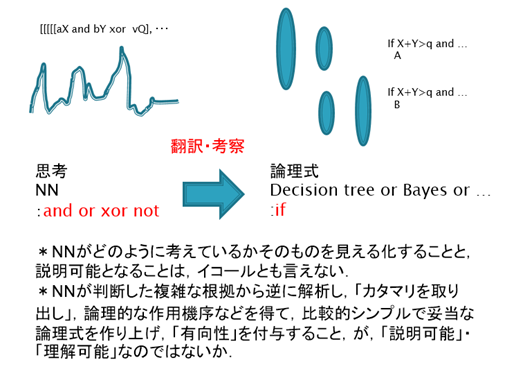

*説明と理解。

NNが判断した複雑な根拠から逆に解析し,「カタマリとなるクラスタを取り出し」,論理的な作用機序などを得て,比較的シンプルで妥当な論理式を作り上げ,「有向性を付与」すること,が,「説明可能」,ひいては「理解可能」につながるのではないだろうか.

(ヒトは思考の末に直感に反しさえもする理論を作り上げ説明し理解するのであって、

直感を複雑なままとらえ説明し理解するのではない.少なくともヒトへの説明には,単純化が必須であると思う.理解自体には単純化が必須とは言えないが.)

(さらに,多様性の立場に立つと,一つのNNが判断した根拠は正答を導く唯一の道ではない,として,多様な道のすり合わせによりより良い理論が形成される,と考えたいところ.耳に注目して動物を見分けても良いし,眼に注目して見分けても良いし,他でも良い.正しい答えを導くそれら組み合わせはまた多くあるだろう.その多くの組み合わせをまとめて,論理式を作るべき,という考え方. 一つのNNでその論理式の形成までたどり着くかと言われると,多分,一つのNN,一つの伝播範囲?,では,それほど大きな多様性は生まれないのではないかな・・・分布がある程度近似してしまい,例えば眼は必ず考慮する,などとなってしまうのでは.)

SHAPは「カタマリ」を取り出すに妥当と思う。問題は「有向性」だ。これは「理解」に含めてCで扱うことにする。

(「ヒトによる理解」には有向性が必要でありその派生として「説明」にも有向性が必要となるが、本質的には説明に有向性は不要だと思う。ヒトによる理解に有向性が必要である理由は、ヒトは7つほどしか「根拠」を把握できないところ、有向性を付与することにより7つの「根拠」からでも、より多くの理解が得られるようになるから、ではないかな。とするなら、「複雑な根拠を7つほどのカタマリに圧縮するクラスタリング」と有向性付与が、ヒトへの説明における答えとなるのだろう。)(カタマリを抽出することをローカルな説明と呼び、カタマリに有向性を足したものを抽出することをグローバルな説明と呼ぶ、と分けたほうが良いか。本手法では、ローカルな説明はSHAP、グローバルな説明はcheck system全体?、となろうか。)(多分,説明を受けるものと説明するものの間で,「ドメイン(分布)のすり合わせ」ができて初めて,「説明」が「理解」となるのだろう.(最初からすり合わせておいたほうが良いと思うが,最後にすり合わせることも可能だろう.))

*SHAPハイライトに加えて単語間の共起性を示すようにすれば、現状使用しているモデルにおいて必要な「検索者に対する」「説明」は充分かな。さらに加えるとしても、ほかのモデルを参照したり自分で見直すインサイトを与えるため、そのモデルが重視しやすい単語・構造と重視しにくい単語・構造を示す(check system全体で補正してしまうが補正したと示すほうが良いだろう)程度か。(「モデル個性の評価のために行う」「理解」は別。)

*次の用語に統一し整理すべき?.

・Data(データ)… 整理されていない情報。いわゆる「ローデータ」 =「データ」

・Information(情報)… データを何らかの基準で整理(カテゴライズ)したもの =「カタマリ」(セグメンテーションとクラスタリングが混ざるかな・・・)

・Knowledge(知識)… Informationから導き出される、規則性、傾向、知見 =「有向性付与」(各クラスタに対する要約付与,だけでもよいか?)

・Wisdom(知恵)… 「人が」Knowledgeを活用して判断する力 =「理解」

*今ひとつ「説明」の行き場がないかな・・・

*産総研人工知能研究センター【第40回AIセミナー】機械学習モデルの判断根拠の説明(Ver.2)(202001)

https://www.slideshare.net/SatoshiHara3/ver2-225753735

*tidymodels+DALEXによる解釈可能な機械学習 / Tokyo.R83(202001)

https://speakerdeck.com/dropout009/tokyo-dot-r83

*以降、説明可能は下記Cに記載することとする。

*SHAPがいつの間にかテキストにもHuggingFace transformersにも正式に対応していた。

ドキュメントも豊富に。これで前例がほぼ無いなか掻き分けないで済む。ありがたい。そんな能力ないんだよ・・・

https://shap.readthedocs.io/en/latest/example_notebooks/api_examples/plots/text.html

機械学習モデルを解釈する指標SHAPを自然言語処理に対して使ってみた

https://qiita.com/m__k/items/87cf3e4acf414408bfed

B. モデルの個性をどう作るか.

正答不正答において,モデル間に個性がみられている.

正答不正答における個性のみからでは,モデルの個性をどう作ればよいのか,定かになっていない.

w2v-mpモデルの個性を恣意的に調整するために,wswを追加した.

ヒト認知を示す個性として,Expert system,eswを追加した.

ヒト認知との適合において,モデル間に個性がみられた.(keb-mpとBERTは(なぜか)ヒト認知との適合においてほぼ互い重複しない結果を示した.)

ヒト認知における個性において,その個性が発揮される理由とアルゴリズムが理解できれば,モデルの個性をどう作ればよいのか,理解できるだろう.

w2v-mpは文章を上位概念で、keb-mpは文章を下位概念で認識しているように見える。

上位概念下位概念で捉えていることが確認でき、その要因がつかめたならば、モデルの個性をどう作ればよいのか,理解できるだろう.

SHAPを正しく使用できているとして,

・ハイパーパラメータを変えてみたが,今のところ,個性の変化は見られていない.

(赤帯青帯の幅が全体的に変化する程度.波形のパターンは変化せず.local minimumが少なくなるようにモデルを作っているがその影響か.)(window sizeが個性に影響しない点が意外であった.averagepoolingでなくmaxpoolingとしたためか.window sizeが大きいとリークが云々という文献を読んだ気がするがメモをするのを忘れてしまった・・・)(すべてのパラメータについて確認しきれているわけではない.)(少なくとも,正則化が個性を明確にするだろう.)

・keras embedベースのmaxpoolingモデルと,keras embedベースのCNNモデルで比較した場合でも,個性の変化は見られていない.(転移学習でも個性の変化までは望み薄であろうか.)

・ランダムフォレストも試したがacc0.75と低すぎたため検討できなかった.

・文字レベルの前処理や,品詞限定の前処理によって,個性が表れるかもしれない.

(特許では,名詞重視で形容詞副詞が少ないという特徴がある?(形容詞を書くぐらいならそれを表すデータを書く)ため機能語を削ることができそれにより個性が際立つのでは.)(結果として,名詞限定により正解がより上位に集中する結果となった経験がある.FNが増えてしまったが.)(契約書コーパスと法律コーパスの品詞比較など https://speakerdeck.com/mimihub/20190827-aws-mlloft-lt5?slide=18 )(既知の知識に従い前処理を過剰にしてゆけばその結果は古典的な統計手法による結果に近づく.それなら最初から古典的な統計手法を用いたほうが良い.深層学習においては,前処理は最低限にするか,慎重に見極めないといけない.)

・分散表現のpre-train学習に用いるコーパスが個性に大きく影響を与えるのではないか,と思っている.

(個性をもたせるには,コーパスには偏りが必要でありかつコーパスが大きすぎてもいけない,とすべきだろう.すると未知語oovが増加しやすいので,未知語処理が重要となる.ベクトル平均は次善の策とわかっていたのでより適切になるよう一応の対応済み.magnitude https://github.com/plasticityai/magnitude に期待している.)(未知語処理も個性に寄与しているようだ.)(201909時点の未知語処理実装は,transformerを分散表現メインに書き直したような構造となっている。)

・ホットリンク日本語大規模SNS+Webコーパス

https://www.hottolink.co.jp/blog/20190304-2.

・BERTは個性がないが高性能,という意味で外せない個性だろう.

(実装すれば多分市販AI不要となるだろう(今でも不要といえば不要だが,個性解析できてないことに加えて今後の改良に期待して残している.)

→201903BERT実装

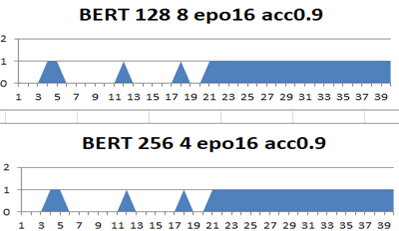

*標準のmultilingual modelでfine-tuning BERT試行.入力サイズ1/3で epo16 acc0.9 4min.入力サイズ1/2で epo16 acc0.9 6min.=>記事の最後にBERTの結果を追加する.

・Juman++&BPE 黒川河原研BERT日本語Pretrainedモデル

http://nlp.ist.i.kyoto-u.ac.jp/index.php?BERT日本語Pretrainedモデル

・SentencePiece hottoSNS-BERT

https://www.hottolink.co.jp/blog/20190311-2

・MeCab StockMark日本語ビジネスニュースコーパスBERT事前学習済モデル

https://qiita.com/mkt3/items/3c1278339ff1bcc0187f

*英語では,

BioBERT

https://arxiv.org/abs/1901.08746

SciBERT

https://arxiv.org/abs/1903.10676

などもあるようです.PatBERTは見当たらないな・・・

→Jieh-Sheng Lee and Jieh Hsiang.

PatentBERT: Patent clas-

sification with fine-tuning a pre-trained BERT model.

arXiv

preprint arXiv:1906.02124, 2019.

・BERT以降のSoTA:

MTDNN

https://arxiv.org/abs/1901.11504

Improving Language Understanding by Generative Pre-Training(transformers and unsupervised pre-training)

https://openai.com/blog/language-unsupervised/

Unified Language Model Pre-training for Natural Language Understanding and Generation (Microsoft)

https://arxiv.org/abs/1905.03197

XLNet: Generalized Autoregressive Pretraining for Language Understanding

https://arxiv.org/abs/1906.08237

RoBERTa

https://arxiv.org/abs/1907.11692

ALBERT: A Lite BERT for Self-supervised Learning of Language Representations

https://openreview.net/forum?id=H1eA7AEtvS

https://github.com/google-research/google-research/tree/master/albert

RACEでみた進歩.

http://www.qizhexie.com/data/RACE_leaderboard

・・・

*Unsupervised Data Augmentation

https://arxiv.org/abs/1904.12848

「教師なしに用いる」データを作る手法.これは使えそうか.

*Making Convolutional Networks Shift-Invariant Again

https://arxiv.org/abs/1904.11486

*Predictive Uncertainty Estimation via Prior Networks.

http://arxiv.org/abs/1802.10501

*一般形は特殊形の代わりにはならない.

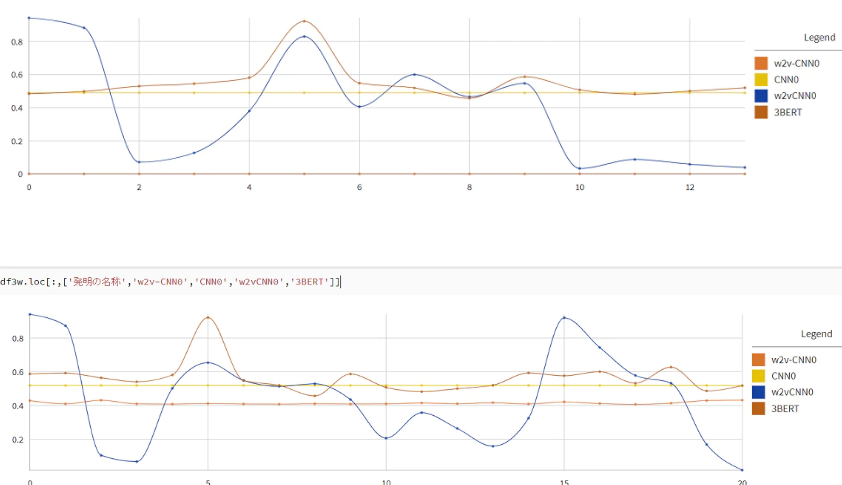

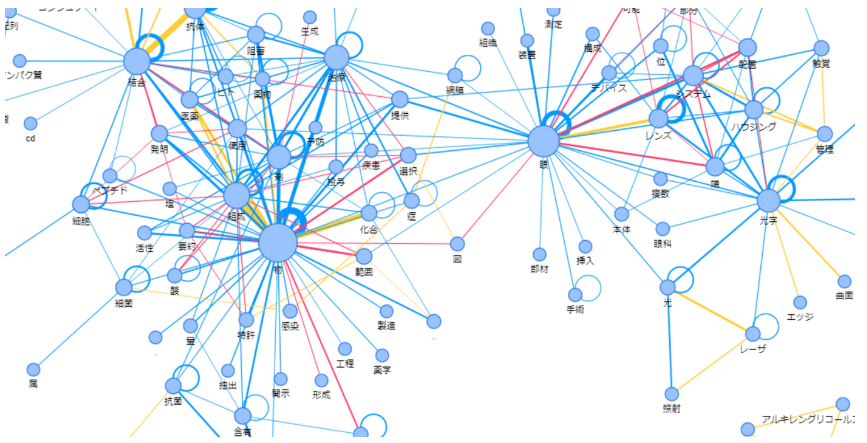

・個性の調整について.

上記システムのweight specific words(wsw)と記載した箇所では,w2v-mpの個性の調整を行っている.

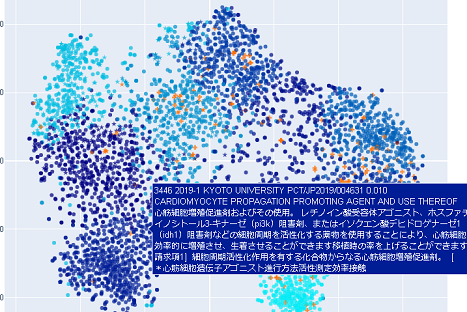

下図(上)から(下)への変化は,w2v-mpモデルに単語「rhoキナーゼ」を重視させることをwswにより試み,その結果「rhoキナーゼ」に期待通りハイライトが当たったことを示している.

(このような柔軟な調整が可能とできるのは自作ならではといえようか.)(モデル内部をいじっている.モデルの理解とメタ知識を利用している.)(ちょっとした事で使いやすくなるのだが,自作でなく市販ツールを用いているとそのちょっとした事ができないのだよね.ベンダーに注文つけてもこのような機能つけてくれたりしないか時間がかかる.AIではこのようなユーザー特化が重要と思っているのでできないというのは致命的ではないだろうか.)(教師データは基本的に過去からしか得られないため,このようなプロアクティブな手法も重要.)(この単語重視により,本特許の順位は164位から84位に上昇.上位100位までの変動を確認するも本特許以外は+-12位内で変わらず.個性を大きく変更せずに,特定の単語を重視させることができたと言って良いだろう.様々な条件が考えられ十分に検証できているとは言えないが.(上記単語を含んでいても,すでに順位が高い場合はほぼ順位に変動なし,など.))(言うまでもないが,何らかの教師が本筋.ただ,安易な教師変更は意図しない性能悪化を招くため,教師変更をした場合には,必ず,全体の検証をし直さないといけない.上記手法はその毎回の詳細な検証をほぼ不要とできるだろう.)

*上図は教師を追加した場合のkeb-mp.図(右)のように,教師データを追加すれば正解候補に正答することは簡単.しかし,ただ単に教師データを追加したのみの場合,図(左)が示唆するようにFPが増えるなど,全体のバランスが崩れうる.

(そも改善用の良い教師データが得られるのは事後であるのであるから,教師データでの改良は,常に手遅れである,と言える.)(data augumentationには基本的に反対.注意深く行ったときのみ可,と考えている.)(自然言語分野において,大量に教師データを追加した場合でも全体のバランスを崩さないといえる深層学習モデルは,今のところ,BERTなどTransformer系モデルぐらいではないだろうか?.)

*Two models of double descent for weak features

https://arxiv.org/abs/1903.07571

過学習のリスクは特徴より教師が小さい場合には低下する?

*ヒトは対象物がある特定の範囲に入るか否かを決めるとき,次のような類別をしていると言われる.

1カテゴリの「ルール」に適合するか

2カテゴリ内の「ある特定の対象と類似」するか

3カテゴリの「基本形」に類似するか

さて,現状のモデルはどこまでできているだろうか.

ルールベースの文構造では担保しきれないことは,文章表現の多様性から見て明らかに思える.n-gramも限界があるだろう.transformerに期待はできるが十分でなく,さらに「構造を抽出する蒸留」が必要となるのだろう.下記,Unsupervised Distillation of Syntactic Information from Contextualized Word Representationsのような.

*Hyperparameter Tuning and Implicit Regularization in Minibatch SGD

Anonymous

26 Sep 2019 (modified: 26 Sep 2019)ICLR 2020 Conference

https://openreview.net/forum?id=ryGWhJBtDB

バッチサイズとノイズ支配,精度.ああ,なるほど.

・ヒト認知との適合についてはC参照.

*Document Scanner using Computer Vision

https://towardsdatascience.com/document-scanner-using-computer-vision-opencv-and-python-20b87b1cbb06

昔々pdfをpyocrだったか?を使って6000件ほど処理させたことがあったが、まともに認識されたのは5割ほどだったかな。そろそろやり直してみるか。

C. モデルの個性をどう理解・評価するか.理解するためのモデルによる自己説明を含めて

*魯の哀公が孔子に尋ねた

「諺に『大勢でいれば迷うことはない』とあるが、今群臣と相談して政治をしているのに国が乱れるのはどういうわけだろう」。

孔子曰く,

「大勢に聞くと言うのは臣下の間で様々な答えが出るものです、しかし今は群臣がみな季孫と同じように振舞うので一人に尋ねているのと同様です」

どのようにモデルの個性を「理解」・「評価」すればよいかにつき,答えを得ていない.

(暫定的な評価をおこなっているがなぜか結果は悪くはない.)(ヒントとなり得る文献等を収集中.)

retrofitting分野の最新研究を追跡すれば,w2v-mpの「理解」に繋がりそうだ.

ヒト認知との適合において個性が確認できた.モデルの個性の「理解」に繋がりそうだ.

check systemによりなされる「モデルによる自己説明」が,「理解」の前提として重要と再認識した.説明可能AIについて,Sharpley値含め,再確認してゆく.

上位概念下位概念を認識し分けているとできれば、「評価」は比較的容易にできるだろう。

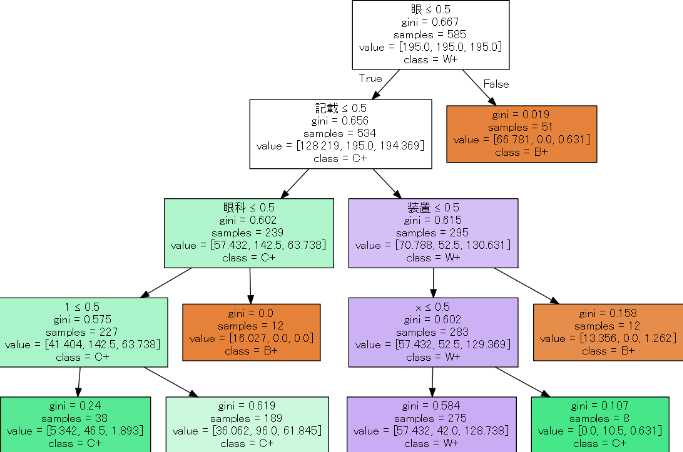

決定木によりモデルの個性の「理解」を試みたところ、単語への直接的な依存性に傾向が見られそうであった。1つの説明になり得るだろう。

決定木によりモデルの個性の「理解」を試みる過程で、XORを見分けられるかどうかが個性に影響しているかもしれないとの示唆があった。

ヒトの「認知構造」や「理解構造」において,「直感的な認知や理解とはいえないXOR」が必須である、のであれば面白い。

認知や理解が認知や理解されやすい構造から成り立っているとは限らないわな

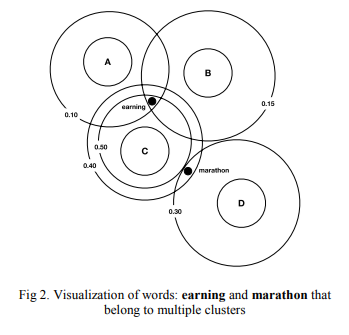

・モデルの個性を多く作り,クラスタ分けして,クラスタに特徴的な単語とモデルごとに特徴的な単語を比較し,特徴的な単語を任意に入れ替え比較しつつ,FA,因子分析を行い,「理解」につなげ,その理解をもとにどのように「評価」するべきかの結論を得る予定.

(得られた主因子いくらかをノードとしてベイジアンネットワークに入れることができるかはたまたベイジアンニューラルネットワークで解くか.主因子をSHAP値から読み取るか.どれが最適か,他の手法が良いのか,やってみないとわからない?.とりあえず単語間の相関を無視してナイーブベイズからかな….あるモデルのみが正解する特許を集めナイーブベイズで学習し,ある単語においてあるモデルとなる確率を出し,これをそのままモデル採用の重みにしてみるか?.この有効性を見てから別の手法を考えるか.)

・「理解」について.理解の深さがが正確な評価につながるはずである.しかし見通しが立っていない.

理解するに当たり,共通してありうる構造として文法からのアプローチを取ることが良いのか,認知からのアプローチが良いのか,数式からのアプローチが良いのか.まず,図表を作り,理解できうるか,主因子がどれほどあるか,確認してゆく予定.

(人間の脳は巨視的にはベイジアンだそうな.)(因子が少ないと言えるならQCAも使えないか.個性をブール代数で表現できればわかり易い.演繹的には使えないし要約に無理があるだろうけれど.)(kaggle慣れしている人らはこのような状況に強いのだろうか.このあたりは特に専門家に頼りたいところだ.)

・「評価」について.理解がどのレベルでなされるか,例えば単語レベルなのか,文法レベルなのか,数式レベルなのか,はたまた行動レベルなのか,不明であるため,どのように評価できるか,そも評価可能かどうかも不明である.

基本的には,現在の簡易的な多様性評価手法で行っているように,「良い部分のみ評価する」と「集合知・集団的知性」に基づく良い結果が得られるだろう.「いわゆる」アンサンブルのような平均評価では,集合知は失われ,集合知に基づくベストな結果は得られないだろう.

(良い部分のみ評価する手法だけでは,見落とされたTP(FN)抽出と同時にFP抽出もなされ,総合評価としては向上しない結果にもなりうる.しかし,結果として,現在使用しているモデルの「組み合わせ」ではそうなっていない.この状態を維持するにはFPの多いモデルを避けるだけでよいのだろうか.十分な評価データセット用いた詳細な検証が必要だろう.)(現状,目視で個性が表れた部分を確認し主観的に評価しているが,数字で表現できるべきだろう.しかし,理解が表現レベルであり,表現が意味を超えるところに帰するならば,属人的評価基準を免れないかもしれない.)(p208設計および評価を行うためには,いくつかの補完的な方法を組み合わせて用いるべきだ.この結論は本質的には,定性的方法と計量的な社会学の手法とを組み合わせて,認知的アプローチと行動主義的アプローチとを相互に補完させるようにすることを示唆している.)(適切な評価とは,脳の自然な作用から得られるものではないどころかそれに逆らうもの,ヒトがヒトと言える所以「脳の自然な作用に逆らってまで作りだす理論化」により得られるものだと考えている.適切な評価が「学習」からそのまま得られるとは思っていない.今のところ.(学習で評価する場合,蒸留を用いることができるが,蒸留は幻想的な真値を仮定しており自然言語では現実と離れすぎるのではないだろうか.)(小から大を予測するのではなく大を構造化し予測する,シミュレーションの解析結果を用いたインサイトベースの理論化,のような作業が必要だろう.この章の最後に示す図の「設計範囲のインサイト」のような.))(良いとは何かは,それが新規な場合,事後的にしか認識できえないので,事前に設定することが難しい.この場合事前設定で得られるのは,良いものの一部となる.良い部分を評価するのは良いが,良いと評価できなかったが良い部分を捨てないような評価手法とする,これが難しい.少なくとも,複数の評価,多様性評価が必須であることはわかるが….ある意味,性能を上げることを目標とするのではなく,許容範囲まで性能を落とすことが重要なのかもしれない.)(明記しておいた方は良いと思い直したので明記するが、一つのAIで十分な性能が出ると確認できれば、多様性評価は放棄しますよ。現状そうではないけれど。)

*「いわゆる」アンサンブルは,biasとvarianceのバランスを補正,高variancesを低減(バギングなど)または高biasを低減(ブースティングなど)し,より良い結果を得る手法.多様性評価手法は,高バイアス(基本的には,モデルのバイアス)を個性とみなし「積極的に利用」し,現実に存在する幅のある答え(言語は離散的なイメージなので現実的には答えが常に一つに収束するわけではない.文脈を考慮しても価値観で分かれうる.真値が複数あるイメージ.最適化手法だけでは解けない.)に対応できるようにし,より良い結果を得る手法(高バリアンスを個性と誤解しているのではという疑いがまだあるが).

*(自分の手法において,「教師データ」と,「検証データ」は,「同じ性質のものではない」.教師データは,何を将来求めるかという視点において,注意深く選定・加工されている.同じ不正解でも,学習に用いたい不正解と,学習に用いたくない不正解が存在する.安易なクロスバリデーションによる検証は本件において意味がない.(*ここで記載した検証データはテストデータのことだな・・・最初からCV対象ではなかった。反省。以下、誤解によるものであるがそのまま残しておく。下記は、dataset はtraining+val用には教育用に手を入れたあとのデータを使い、test用には手を入れないデータを使う、その意味でtraing+valとtestを混同してはいけない、CVはtrainig+valデータで行う、datasetをtrain,val,testに分けるだけでは教育として足りないのではないの?というアタリマエのことです。自分はtrainingデータ不足のため、valを作らず、parameter tuningもtestの結果を見て行っています。そのためいつしかval=testと誤解しており、testにCV?と間違えてしまったようです。なお、testをval、valをtestと、人により使い分けが異なるので理解の妨げとなりよろしくないと(責任転嫁の言い訳)。)(ある患者に対するある薬の実効性を観るに当たり,他の患者を含めたCVを行ったとしたら,それに意味があるだろうか?.必要なのはその患者にあった処方をすることだ.医薬品を多数の患者に処方するようなCVを繰り返してもそれは達成されない.実務屋は,開発者と同じ役割ではなく(だけでなく),医師と同じ役割を果たさないといけない.(医師がAI実装に関与してきている現状は、かなり良い流れなのだろうな。AIベンダーは安易には医療AIに進出できないとも言える、医療AIに参加できたベンダーこそが実力を示したことになる、などとも言えるか?))(過去一般に,バリデーション不十分により検証データで性能が出ているのに実データで性能が出ない例が多見されてきた.これを解決するためにCVが重視されるようになったわけだが…同じラベルがついていればどれも同じ価値だと黙示的に前提して,汎用されすぎているように思う.いや殆どの課題はバイアスをなくす前提であろうからそれでよいのですが.)(近年見られるCV?を絶対視したような?学習モデルから得られる結果には,個人的にどうにも違和感を覚えることがある.ある仮説の結果ではあるのだろうが顧客の認知を考えていないような違和感,古典的統計手法やルールベースから得られた結果では感じなかった違和感だ.言うなれば,「自然言語版の不気味の壁」のような.基本的に,古典的統計手法等は,広く通じる認知から得られた主要因を考慮しやすいため,どの顧客の認知にも適合しやすく違和感が生じ難いと思われる.一方,学習から得られた結果は,広く通じる主要因からなるとは限らず,バイアスのある主要因からなることがあり,後者では違和感が生じやすいのではないか.後者にCVを行えば分散が減少し数値は良くなるかもしれないが,バイアスに収束するだけで違和感は変わらない.違和感を無くすには,前者となるようにデータを増やしバイアスを薄めるか,主要因を適切なバイアスとなるように誘導する必要があるだろう.特定のバイアスに誘導する立場において(自分の立場だ),学習データを目的に合わせ任意に厳選するならば,CVに意味はなくなる.学習データは検証データと同価値ではなくなるからだ.)(モデルの性能を比較し示したいならCVのランダム化比較試験は重要である。しかし,それを自然言語モデルで行う際には,データセットが統一されているか,目的に対して適当かどうか,サンプルサイズが十分かどうか,サンプルの分布が適切かどうか,など検討する必要があるのだが,それをしていない事が多いように見える.)(自然言語特有なのかもしれないが.何というか,そもそも一貫した考え方が存在せず様々な正しい考え方,言うなれば様々な有用なバイアス,があるだけだというのに,無理やりそのすべてを潰して現実的に意味がない不気味な考え方に収束させており,それが押し付けがましい感覚を生む,というか.同じ単語同じ組み合わせ同じ共起性のとき,そこから単一のルールを導いたとして,それは目的にかなっているのだろうか,という疑問が.まあそも真値が存在しないとし多様性視点でみているので思い込みもあろう.))(そも文章とは,数値のように連続しており差が明確なものではなく,独立しており一つ一つが意味を持って異なる差が未知のものである.それを評価するには,特定の視点を設定し,差を設定する必要がある.その視点によっては他文章を同価値として比較できるが,どちらかと言えば,CVが有効なほど多くの文章を同価値とできる視点は例外的ではないだろうか.同一データセットにおけるモデル性能の比較など.)(CV自体が問題であるわけではない.)(少数教師において、一部の教師データを削減すれば容易に分布が崩れる。Leave one outでも同じ。そこまでしてtrainからvalデーターを得ることにこだわる必要はなく、CVにこだわる必要もない。実データで検証しても良い、という選択肢を示しておくのもありだと思っている)

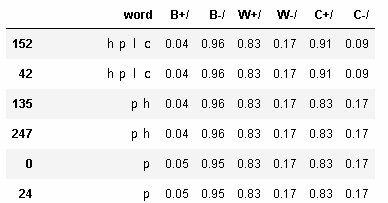

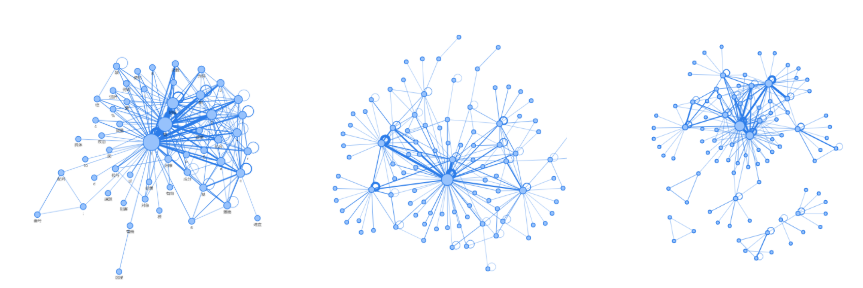

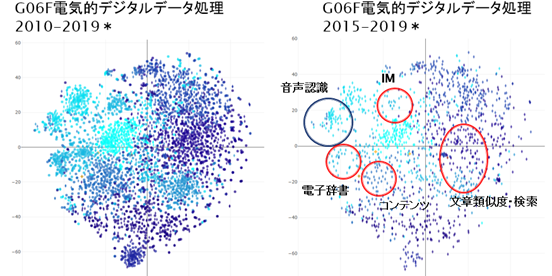

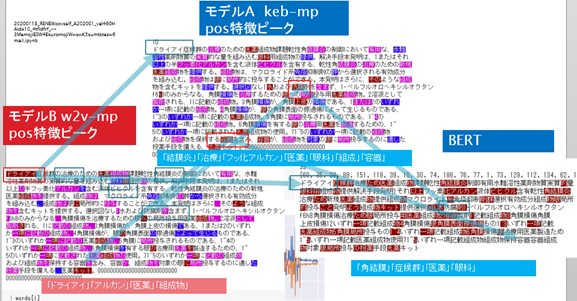

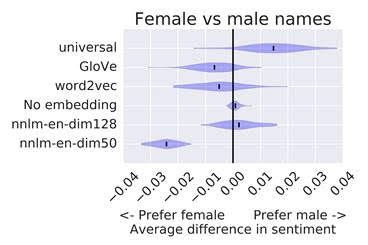

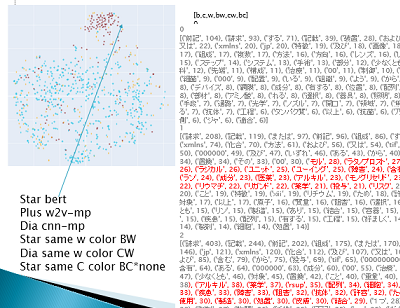

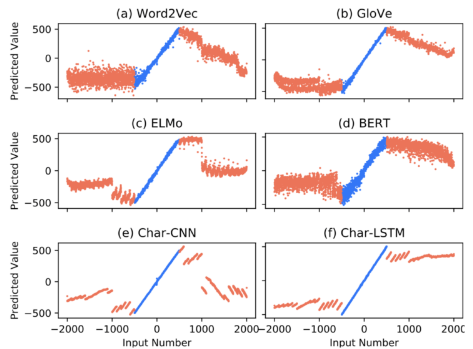

図3)特許ごとのtfidf上位5単語を特定のpre-trained word2vecモデルによりベクトルに変換・合計し,疑似的に類義・関連語を偏らせた場合の特許の分散を見たk-meansーFA図の1.それぞれの分散表現モデルによる影響の感覚を掴み理解のきっかけとするために試験的に行ったもの.(素直にモデルの隠れ層からベクトルを取り出すべきだったと思わなくもない.)(ストップワードを削る前の図.)

*Phase transition in PCA with missing data: Reduced signal-to-noise ratio, not sample size!

https://arxiv.org/abs/1905.00709

code

*言語は人間が作ったのだから人間はその因子を理解可能だ,という仮説に基づくやり方だが実際どうか…モデルによっては重要そうな因子を捨てており,理解不可能に変化しているかもしれない.もし,単語が主因子であり,単語だけで9割程度の説明ができるならば,認識容易性は高そうではある.

*社会的ネットワークの知識が,評価に重要となるのではないかな・・・

*pre-trained word2vecとkeras embedのダブルヘッドをconcatするだけで評価できる可能性もあると思っているのだが,まだ試していない.多様性評価で重要となる「良い部分のみ評価する」構造がないため,足を引っ張り合う気もするが. =>足を引っ張り合っていた.

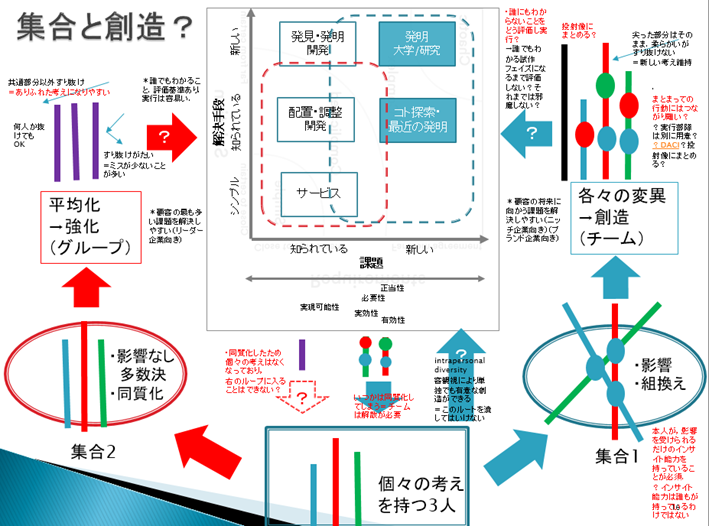

(互いの独自性のある良い部分は薄くなり,共通する悪い部分はより大きく足を引っ張る.集団化しただけのヒトでもよく見る構造だ.チームとグループは評価手法が異なるとまず理解しておかなければいけない.多様性はチームに該当し,チームでは差を良い点としてピックアップする方法などが必要.浅い理解のまま強権で選択するか(現時点の多様性評価手法はこれ),Googleのようにコストをかけ予め理解しておくか,Google Sprintのように誰でも理解可能な段階まで進めて選択するか(目的関数をAUCの最大化とするのは王道だろう.汎化しないだろうが),3Mのように立証責任を転換し理解責任つまり否定材料がない場合は高評価としておくか….(社会実験している気分になってくるな…))

(文章ベクトルを得るにあたり,文章ベクトルそのものを計算する手法,自分が採用するmaxpoolingモデルのように加工して得る手法,センテンスベクトルを得て合計する手法などがある.このうちセンテンスベクトルを得て合計する手法がより良い有効性を持つ結果が得られる手法となりそうだが,現状あまり良好な結果が出ていない印象.その理由は前記と類似し,「足を引っ張る特徴」が,センテンスベクトルの合計では強い重みを持ち残ってしまうからではないかと.手動重み付けがなされているが,本質的解決ではない.より良い部分のみ評価する改良,文章のトピックと共通するトピックを持つセンテンスの重みを最初から高めておく,など必要ではないかなそれも今ひとつかもしれないが(トピックモデルと組み合わせればよいのか?(センテンスが短すぎまた類義語を吸収しきれないのでそのままではイマイチのようだ).他のベイズ的手法を用いても良いな.分散断表現のクラスタを用いても良い)(減算つまり全体からの一部削除が答えかもしれない)(既存の文章ベクトル作製技術をそのまま用いても,自身の目的に対し十分と言える結果を得ることは難しいだろう.word2vecなど単語分散表現ベクトルからはじめ,自身の目的に応じ自作し独自の文章ベクトルを作ったほうが,手っ取り早いだろう.1つの専用から汎用が得られていると夢を見るのは妄想にすぎるのではないか(お前が言うな?))(様々な文献を見ゆくに,文章ベクトルを直接作ってしまう手法には先がないと感じている.例えば,単語ベクトルの組み合わせ検討動向からすると単語ベクトルの集計手法が確定されてしまうdoc2vecには先がなく,カーネル削減手法の重要性からすると単純に提示するしかないモデルには先がない.自作するなら,何らかの単語ベクトルから始め,技術の推移に合わせて柔軟に目的に応じた文章ベクトルを作れるようにしておくべきだと思う.)(doc2vecはなんというか、ものの特性を一方向からしか見られなくするよう導くような名称で、個人的には好ましく思わない。)(単語ベクトルでも大きすぎるという意見もあるだろう.形態素の究極は何か.今の自然言語処理分野は、分散表現を分子または原子として、素粒子探索や周期表、高次元折りたたみ構造などを同時に探索しているかのようであり、非常に面白い.実は基本構造など無い、または基本構造はより曖昧な電子雲のようなもの、と結論付けられるかもしれずまた面白い.)(ここで言う構造を学習する手法のことを、メタラーニングと呼ぶらしい。few-shotlearnigもメタラーニングの一種とか。)

code

*評価につき参考のため,モデルの個性とその評価基準を擬人化して適当に表現してみる.

・・pre-trained word2vec maxpoolingモデルは,1を聞いて10の発想をする天才肌だが思考があさってにもゆくので,少数の自信のある主張を高く評価すべき.

・・keras embed maxpoolingモデルは,漏れなくカバーする手堅い凡人なので,広く普通に評価するべき.

・・BERTは,秀才だが自身を持って間違え間違いを認めない厄介な積極派なので,主張を広く採用するが自信のある主張でも低く評価すべき.

(安定して高い性能を誇るモデルでも低く評価しなければならない,ばらつきが大きいが最も高い性能が得られるモデルを高く評価しなければならない,かもしれない,というのは面白いな.このあたり,教育論か何かに参考となるものがありそうだ.また,目的関数で処理するにしても,目的関数は個性ごとに可変である必要があるのかなと思わなくもない.)

知識人は問題を解決し、天才は問題を未然に防ぐ。(アインシュタイン)

知識人と天才は相補的であるはず.

| model | 認知的観点 | 解釈学的概念 |

|---|---|---|

| keb-mp | 2 | 2 |

| w2v-mp | 3 | 1 |

| BERT | 2 | 3 |

| Thaïs | 3 | 3 |

| ※ | 概念知識? | 情報検索知識? |

| ※ | 精度? | 再現率? |

・ブラックボックスのまま理解する「機械行動:machine behavior」と呼ばれる新しい学問領域をつくるべきだという提案

https://www.nature.com/articles/s41586-019-1138-y

https://www.media.mit.edu/publications/review-article-published-24-april-2019-machine-behaviour/

「無作為化実験、観察推論、および集団ベースの記述統計 - 量的行動科学でよく使用される方法 - は、機械行動の研究の中心となるはずです」

同感だが,データが必要か.帰無仮説・p値は使いたくないところだが.

『犯罪捜査のためのテキストマイニング』には集団ベースの記述統計の記載が多くあったはず.見直してみる.

・丸山宏(2019)

高次元科学への誘い https://japan.cnet.com/blog/maruyama/2019/05/01/entry_30022958/

同感.過剰な還元主義か.

*認知には2つの考え方がある.認知できる小さな構造の組み合わせから大きな構造が説明できるという考え方(デカルト.モジュール.還元主義?.群知能),そして,認知できる複雑な構造から単純な法則を見つけ出そうという考え方(上記の高次元科学?).例えば画像におけるニューラルを理解しようという試みは前者か.自分が行ったハイライトは前者か後者か.この記事や機械行動,自分が悩んでいる部分は後者か.(メタラーニングや例えばtfidfなど分布は後者か)

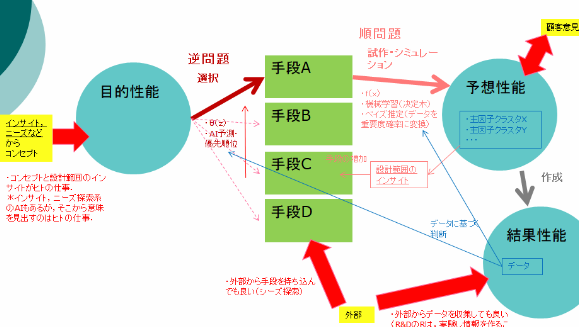

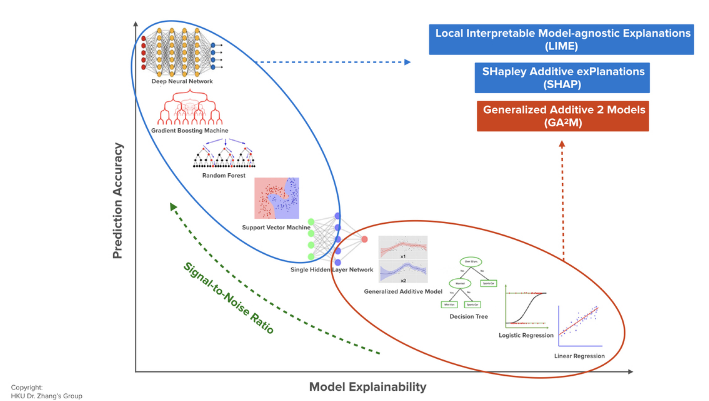

*目的効果を得る最適手段の予測においては,関連・相関のみ知ることができれば良いのでブラックボックスで良い(高次元科学?.ここでは恣意的な主成分分析は厳禁と理解している).予測した解決手段から実際の効果を予測するシミュレーションにおいては,相関以上の因果が必要・説明できることが必要で,その説明は新たな理解と理論につながる(還元主義?.ここでは主成分を抽出した理論・仮説形成が重要と理解している).と切り分けるべきなのだろう.

各モデルの予測結果を決定木・ベイズ推定・有向ネットワークを用い説明し理論化する手法が本筋か.SHAPは,個性の存在を証明する手段と,個性の特徴の重みを表現する手法として,明確に切り分け用いるべきなのだろう.

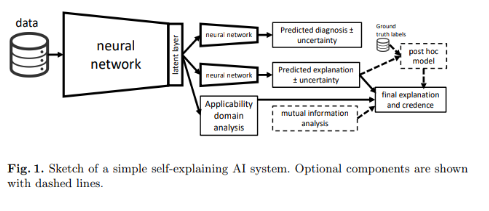

図x)左のAIは目的効果を得る最適手段の予測.右のAIは予測した解決手段から実際の効果を予測.左のAIは統計,右のAIは統計を確率に変換,と言っても良い.例えるなら,左は臨床の結果である統計,右は医師による統計と診断とオミックス情報などに基づく患者に適用できる確率への変換.(まったく考えがまとまっていないのだが,逆問題をAI・ベイズp(x仮説|yデータ)などで解かせ,順問題においてベイズp(yデータ|x仮説)からそれぞれのデータの寄与確率をもとめる,といったイメージか?.)(「なぜそれが良いのかわからないが,それが良いと仮定して,データを構造化することによりとある理論が生まれる」、と説明すると一言で言えるか.)

*AIが予測するCOVID-19の3つの重症化因子(202004)

https://aitimes.media/2020/04/02/4589/?6598

オミックスデータや診断データをもとに学習?.

個別診断やオミックス情報などに基づき「適用できる確率」を求める課題については,(広い意味での)AIが得意とするところだろう.個別診断についてはその独自性から,オミックス情報についてはその多量複雑性から.

本件については,データから年齢の情報がリークしているだけというわけではないよね?

*読んでいないが次が参考になりそう

A practical baysian framework for backpropagation networks. neural computation, 4(3): 448-492, 1992.

・世界の「謎」解くカギ、深層学習は「因果性」を発見できるか?

深層学習の人工知能(AI)は、多くのデータの中から関連性を発見することは得意だが、因果性を見い出すことはできない。5月上旬に米国で開催された「ICLR2019」で、著名なAI研究者が因果関係を分析する新しいフレームワークを提唱した。

by Karen Hao2019.05.17

https://www.google.com/amp/s/www.technologyreview.jp/s/141062/deep-learning-could-reveal-why-the-world-works-the-way-it-does/amp/

*内容確認できていないが,minst色変更誤判断問題につき,改善するには色違いすべてを学習するのではなく,個別に学習すると良い?.ネットワークの利用?.複数のモデルを用いた多様性評価とその発想の根本である社会的ネットワークの考え方に近いだろうか.社会的ネットワークを学び直し答えを探すべきか.単純なネットワークを深堀した研究に答えがあるだろうか.

(ベイジアンネットワークに戻った気もする)(モデルごとの知識マップを立体的に作っておき重ならない部分はそのモデル重視,重なっている部分は高さで重み付けし集計,トピックに一般化させてベイジアンネットワークに入れそのモデルとする確率を評価の重みとする,などで評価できると思っているが,この方法では知識マップ作成に予め枠をつくる必要があるという問題がある.数千程度の特許をPCAなどで図示して,高さを加えた図をモデルごとに作成し…どれだけ時間がかかるか…トピックで近似できると良いのだがバイアスが…適切とするのは空白にも意味を持たせないといけないが…)

*これでよいのかな

Information theory holds surprises for machine learning

https://www.santafe.edu/news-center/news/information-theory-holds-surprises-machine-learning

Caveats for information bottleneck in deterministic scenarios

https://arxiv.org/abs/1808.07593

【論文】メタ強化学習による因果推論

https://qiita.com/kodai_sudo/items/780b3e05c150f9c9dda6

*多様体を1つのニューラルネットワークの中で作り上げてゆく必要はない。多くのニューラルネットワークで作り上げた多様体を最後につなげたほうが良いかもしれない。多様体を相互依存なく独立に加工できるから。(トポロジーを学びなおしているが多様体について誤解があったので後ほど修正削除予定.)

*AIに常識をもたせるタスクと、個性評価手法のゴールについて。

まず、一つの多クラス分類ニューラルネットワークでは分類しきれない課題であり、複数のニューラルネットワークが必要だったと前提する。

ベイジアンネットワークを上流に配置し、その末端にある目的ノードに、それぞれ独立したニューラルネットワークを接続するとする。ベイジアンネットワークでは「ある国」で「ある四足動物」を見かける確率が出力できるとする。

四足動物であることがわかっている画像があるとして、その四足動物は、「日本」では「犬」か「猫」である確率が高いだろう。これは常識を表す。

求められた確率に従い、猫を見分けるニューラルネットワークと、犬を見分けるニューラルネットワークを稼働させる。

結果として、例えば猫だと、常識を加味して判断されることになる。

さて、日本を前提としたので猫と判断されたが、実は「小さな虎」の画像だったかもしれない。

https://www.reddit.com/r/rarepuppers/comments/bb7lfg/the_mystic_tiger_boye/?utm_content=title&utm_medium=post_embed&utm_name=b4322056f05c4faba1ce818d731245fd&utm_source=embedly&utm_term=bb7lfg

その場合は間違えてはいるが、認知的には正しいと言える。人も同じように間違えうるだろう。もし「東南アジア」を仮説としていれば、「虎」と判断する確率は向上していただろう。東南アジアの常識として(例えです)

認知を用いモデルの個性を評価する手法は、例えばこのように、ベイジアンネットワーク・ニューラルネットワークの組み合わせから、形成できるのかもしれない。

独立したニューラルネットワークを多数存在する目的ノード全てに置いていてはあまりにコスト高であるので、一つのニューラルネットワークに統合できる分類と統合できない分類の見極めが重要となるだろう。

ある目的ノードとある目的ノードで共通となるニューラルネットワークを見出すことが重要となるだろう。その為には,ニューラルネットワークの隠れ層からのリーク(隠れ層の共通性やベイズ推定を用いた手法など)や転移学習を用いることが,重要となるのだろう。

最終的には、「複雑なベイジアンネットワークと、50ぐらいのニューラルネットワーク」、つまり脳と同じような構成に圧縮できるのではないだろうか。

個性と多様性評価手法のゴールは、ここかもしれない。

だからまあなんだな、さっさとどの個性を選択すべきかの評価手法を

*上記虎について言い換え。

間違えているが、**「関連」としては正しい。これが間違えだと確信してしまう理由は、確認するヒトが後付で結果の事実をもとに認知バイアスを適用させる作業をし、「時系列と逆方向で因果」**を作り上げているているからではないだろうか。モデルで関連を得たあとに「後付のない因果を整理する構造」(常識を判断うる構造?)を付与することは重要に思える。ベイズは順番を考慮できるから因果を整理する構造の候補としてよろしい・・・?。

https://qiita.com/kzuzuo/items/2bce9e4fe58021a25430

*十分複雑でかつ多量データから事前知識等学んだend to endモデルは、上記のような因果を整理する構造を持ちうるのだろうか?。transformerは因果を整理する構造・・・を保有しているように見えなくもないがかなり偏った認知バイアスを持った後付のある因果を整理する構造となっている印象がある。

*ネットワークが複雑になりすぎないようにノードを限定する必要がある。ノードをある概念範囲内でまとめてゆく必要があるのだが、その概念範囲を、恣意的なセグメントから限定すべきなのか、例えばTDAで求めるクラスタで限定すべきなのか、常識は限定的に数えられるとしてそのまま設定すべきなのか。ベイジアンニューラルネットワークが答えなのかもしれない。

*GRAPH TRANSFORMER

https://openreview.net/pdf?id=HJei-2RcK7

なるほど逆もよいな.下流にグラフを配置することにより「わからない」が適切に抽出でき,「本当の専門家AI」により近づけられるかもしれない.

どのように評価するかにおいて適切な評価は学習で得られないと考えている,と書いたが,なるほど.出力部分に知識グラフを接続し評価することもできるか.ベイズの結果をリアルタイムにグラフ化し人はその内容を定期チェック,でよいか.

*基本的には,「上位概念」(動物,非生物などセグメンテーション)や「常識」はニューラルより上流に配置し,「下位概念」(具体的な診断結果など)や「わからない」はニューラルより下流に配置すべきと思うが,上流に配置されたグラフをあまり見ない…ああ明示されていないが,前処理や入力のグラフ化が該当しているのか?

*Utilization of Bio-Ontologies for Enhancing Patent Information Retrieval

https://ieeexplore.ieee.org/document/8754131

*いずれにせよ,まずデータ集め.(「ほぼ」だの「多分」だの「思う」だのばかりでは.)

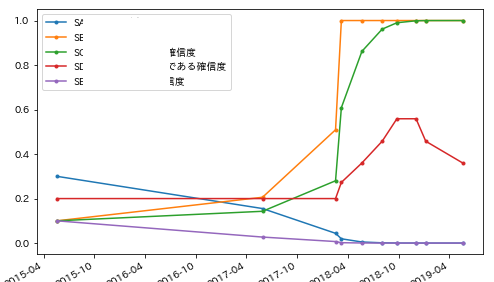

*201906現在,実データで確認されている性能は次の通り.

・・BERT以外のモデル(市販AIは除く)は,正解を上位10-15%以内に集め,一部を20%付近に見逃す.

・・BERTは,殆どの正解を上位2%以内に集めるが,一部を30%付近に見逃す.

・・多様性評価は,殆どの正解を4%以内に集め,正解を10%以内に集める.

(今のところ,実データでこれを大きく外さない.あっても良いと思うのだが,下位に落ちた正解が見つからない.特許文章は比較的類似を見分けやすい文章だとは思うが,ここまで実データで性能が出続けるとは思わなかった.)

(と書いたあとにBERTがやらかした.実データ内のある正解となってほしい特許を,30%どころでなく48%に配置.残り2モデルは同じ特許を,8%,11%に,3モデル多様性評価は同じ特許を15%に,3モデル平均評価は同じ特許を17%に配置している.3モデル多様性評価の15%は,BERTのみを使用していた場合母集団の半分近くまで確認しなければ見つからないことを思えばだいぶ救済しているといえるが,10%を超えると感覚的なありがたみがない.)

(作成中の検証用データには,教師データと重複する情報を含まない?,後付で欲しかったと言える特許を含めても良さそうだ.概念により教師データ不足をカバーするのも目的の一つだしな.5割正解すれば御の字程度の難しい検証データとしよう.)(しかし,汎的な立証にはならないな.うーむ.数式で示す部分を増やすしか無いか.)(実データで実効性あり.検証データをより良く作っても傍証にはなっても証明にはならない.何らかの理論的説明は必須だろう.この点明らかに自分の能力不足があるので先人に頼るわけだが,理論的説明を十分にする文献が見つからないな.数式の理解不足で説明されているのに気づけない感も多々あるが.)

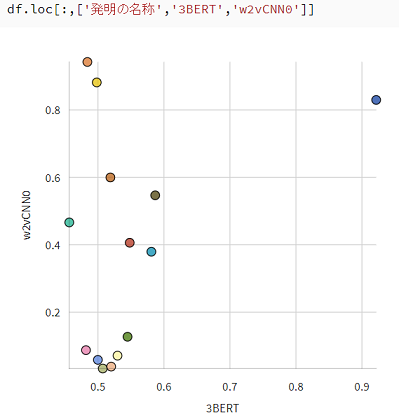

まだ暫定的なテストデータを用いた暫定値だが,例えばP(単語「眼」|モデル)は,高い順にBERT0.89 > keb-mp0.67 > w2v-mp0.11 となる.SHAPや実データの結果から得られる感覚とだいたい一致するか.

*暫定的なテストデータにおいて,使用したBERTは,使用したあるアルファベット文字列に弱いという結果が得られている.この結果をどのような上位概念にまとめ上げることができるか定かではないが,仮説としては,ある条件のアルファベット自体に弱いのではないかと思っている.とりあえず,暫定的にモデルの前処理方法に手を加えてみることとする.(良し悪し.)

とりあえず,このままナイーブベイズでモデル個性の評価を補正する予定.

現状の各モデルは,ウィンドウ処理により位置普遍性を持ち,分散表現は近距離作用しかないから,ナイーブの前提にある程度適合する・・・はず・・・なので,そこそこの性能は出るのではないだろうか.

*モンテカルロ法を利用しヒートマップなど確認しつつ相関を拾い理論を作り出す手法も試行中.分布をどうしたものか.

*限られた特徴語からベイジアンMCMC個人差多次元尺度構成法を用いた場合,どのように解釈できるのだろうか.

*ベイズ深層学習が答えなのかもしれない.重みの分布と確信度が得られるなら,それをもとにモデルの個性を評価すれば良い?.事件があるたびに確信度を更新すれば意思決定は容易となる。

須山敦志(2019)

ベイズ深層学習

講談社サイエンティフィク

筑波大HCOMP研究室の勉強会資料です.

https://speakerdeck.com/catla/beizushen-ceng-xue-xi-3-dot-3-3-dot-4

*動的ベイズ推定

*PACベイズ理論はモデル分布の事前/事後確率間のKLダイバージェンスを一種の複雑度とみなし汎化ギャップを評価する https://arxiv.org/abs/1901.05353

*ジェリー・Z・ミュラー(2019)

測りすぎーなぜパフォーマンス評価は失敗するのか

みすず書房

https://www.msz.co.jp/book/detail/08793.html

1情報の種類

2情報の有益性

3測定を増やすことの有益性

4標準化された測定に依存しないことによるコストは。他の情報源はあるか

5測定の目的。誰が見るのか

6測定のコストは

7なぜ評価を求めているのか

8測定方法は誰がどのように開発したのか

9最も優れた方法でさえ汚職や目標のズレがある

10限界の認識

最終的に重要なのは、どれか一つの測定基準と判断の問題ではなく、判断のもととなる情報源としての測定基準。測定基準にどのように重みをもたせるのか。その特徴的歪みを認識しているか。測定できないものを認識しているか。

評価基準を作ることで、その評価基準から外れたものを評価できなくなる誤り。最低限ここにハマらないよう気をつけなければ。

*言論マップ、議論マイニング

*いまさらだが,「知識ベース knowledge base」を調べると良いのか?.知識ベースの領域に個性と多様性の議論があるのか?

https://speakerdeck.com/cfiken/nlpaper-dot-challenge-wai-bu-zhi-shi-niji-dukuying-da-sheng-cheng-sabei?slide=28

文章の意味と個性

相澤彰子 国立情報学研究所教授

NHK技研R&D 2018.4

https://www.google.com/url?sa=t&source=web&rct=j&url=https://www.nhk.or.jp/strl/publica/rd/rd168/pdf/P02-03.pdf&ved=2ahUKEwjeiY3N0qLkAhWgy4sBHetKAMoQFjACegQIBhAB&usg=AOvVaw3GuRDWW9Jo1MiaEfm7uxW6

表現上の個性と認識上の個性は…

*あるべき文章ベクトルについて.

文章のベクトル表現は、曲げたりひねったりできず、予めある仮説に基づき直線上に配置するしかない。これに不満がある。ベクトルはもっとシンプルに、仮説の変化により柔軟に変化できるべきだ。

シンプルな文章ベクトルを柔軟に曲げる手法を考えよう。

*伸び縮み可能とできれば、解像度の違う文章、上位下位概念で書き分けられた文章にも対応できるか.すれば特許文献と各原著文献やSNS情報を同一平面に図示することも可能か.

*文章ベクトルを伸び縮みさせる手法の候補として再帰型ニューラルネットワークがあるわけだが,可能であれば教師なしとしたい.なぜ教師無しとしたいか、それは、ものには無限の特性があり、どの表現も無限に可能であることから、教師ありではいつまでたっても不足となるためだ。充分に足りる、はあり得るが。

*自然言語においてCNN,poolingを用いる際の問題の原因の一つに、画像では全体が一定の解像度であるところ、文章ではその部分ごとに解像度が変化する点があると思う。一定のウインドウでは全解像度に耐えられず、マルチウインドウでもどの部分がその解像度にマッチしているか定かでは無いため適切な重みとなっているか定かではない?(多様体として抽出できているが重みが打ち消される?ノイズだらけになる?ネガポジの打ち消しが強すぎる?)(トポロジーを学びなおしているが多様体について誤解があったので後ほど修正削除予定.).解像度を認識してウインドウサイズを可変とする処理ができれば、上位概念下位概念を吸収したより良い結果が得られるのではないだろうか。

*上位概念と下位概念の解像度の統一を目的とした変換について.

下位概念1単語と,それを説明する10単語があったとする.この次元を統一し,可視化等で同一表面に提示したい.

たとえば,2つの次元が異なるが類似する文章があったとする.

文章Aにはある下位概念1単語が含まれ,文章Bにはそれを説明する10単語が含まれていたとする.

文章Aにつき1単語を分散表現として得る.文章Bにつき10単語それぞれの分散表現を得る.

文章Bの10単語は分散表現上類似しているはずだから?,同一クラスタに配置される?.

同一クラスタとなった10単語の分散表現を合計する.

文章Aの1単語の分散表現と文章Bの合計された分散表現は類似し,解像度変換が達成できる.

・・・とうまくゆけば良いのだが,問題だらけだ.

まず,このままでは,文章Aの1単語も,周辺の単語を巻き込み足されてしまうだろう.重要でない周辺単語を除く処理が必要.

*現在,tfidfで抽出して上記処理を行うプログラムを試作し動かしているが,ある程度の次元統一と同一表面での可視化が可能となっているかもしれない.(tfidf embeddings/cluster vis)

同一特許の要約(下位概念で記載されているもの)・請求項(上位概念と下位概念が含まれるもの)・明細(上位概念の記載が多いもの)を別に読み込ませ,どれほど近くに現れるか見てみるか・・・

*教師なしで可能なauto encoderを用いるのが妥当だろうか。

*解像度の変換(言い換えのこと)を行う1手段がattentionであるわけだが??,直接圧縮しているわけではない?.依存しすぎてよいのだろうか.attentionもpoolingも似た作業を行っているが,伝播と圧縮の両立性という点ではpoolingにもまだ目が.

*次の文献を見つけた.

Pay Less Attention with Lightweight and Dynamic Convolutions

https://arxiv.org/abs/1901.10430

CNNーattention.Dynamic Convolutionは局所的なself-attentionともみなせるとのこと.

(チャンネルをグループ分けする部分については,「多様体としては抽出できているが重みが打ち消される」問題を解決しようとしているように見える.CNNのチャンネルはネガポジで打ち消す事があるその傾向を考えれば,グループ分けでなくクラスタリングするほうが良さそうに思える.またチャンネル数の動的適正化機能を入れても同じかもしれない.(トポロジーを学びなおしているが多様体について誤解があったので後ほど修正削除予定.)

https://qiita.com/koreyou/items/328fa92a1d3a7e680376

(CNNの打ち消し対策の1.正規化後に、バッチからの共分散とサンプル毎の分散を組み合わせて脱相関

Channel Equilibrium Networks

Sep 25, 2019 ICLR 2020 Conference Blind

https://openreview.net/forum?id=BJlOcR4KwS )

*attenntion部分について,多様性評価手法ならではのやり方としては,BERTからattentionを拾っておいて,他モデルの重み付けに使うというのも良いかもしれぬ.(以上考え方はBERTと同じといえば同じ.)

*QAタスクの性能向上はほとんどの自然言語タスクへ影響を与える.解像度の変換問題も,QAタスクで解決させることもできるだろうか.(ActiveQAなど適当か?)

Talk to books

https://books.google.com/talktobooks/

Universal Sentence Encoder https://arxiv.org/pdf/1803.11175.pdf

Both the transformer and DAN based universal encoding models provide sentence level embeddings that demonstrate strong transfer performance on a number of NLP tasks. The sentence level embeddings surpass the performance of transfer learning using word level embeddings alone. Models that make use of sentence and word level transfer achieve the best overall performance.

*複数のモデルを用いるとはある意味多様な解像度に対応しうるともいえるか.ならば,上位概念下位概念変換モデルを追加すると良いか。(Window sizeの拡張版といったイメージか?.しかしwindow sizeがモデルの個性に与える影響が大きいと言えるデータを見つけてはいない。)(解像度対応はBERTモデルが担当しているとして検討を打ち切ってもよいか.工夫の余地がない点が気になるが)

*解像度が同一である場合の置き換え手法には,ルールベースの辞書や分散表現,wikipedia2vecなどがある.ルールベースで解像度を増加させることは可能だが,単に解像度を増加させるだけでは文脈を無視する結果につながる.

*解像度変換のタスクがあった気がしてきたぞ(いまさら)

QQPタスクで,解像度が違う文章の同一性が判断できる.同一言語間の翻訳タスクも同じか.後は教師なしだが・・・これ教師なしでできるなら翻訳も教師なしでできることになるな・・・転移学習でも・・・

SQuADタスクで質問文を一定とすれば,textから1次元のwordが取り出せるけれど.これ教師なしでできるのか?.

教師なしで1次元に圧縮するとは,文章の本質の数値をえること.word2vecは分散を圧縮しているだけであり文章の本質の数値を得ているわけではない.学習無しで文章の本質を得るには・・・文章の特徴語を抽出して特徴語の分散表現を合計するぐらいしか思いつかない.ウインドウサイズを1から30ぐらいまで変化させ文章をソートしウインドウ内の単語分散ベクトルをすべて合計したリストを作り,リスト内部で最も近い数値を抽出し,文章全体をもっとも小さなウインドウとなっていた単語群となるようにおきかえてゆけば,解像度は揃うが・・・助詞まで含めた合計が意味的に等しい単語の数値とほぼ等しくなるようにできうるものか?.BERTベクトルなら?.

a b c a b

a b c d e f 同じ意味の文章だが異なる単語が使われている

a b o p q r

a bとd e fが同じ意味であり,a+b≒x,d+e+f≒xとする.ウインドウサイズ2のウインドウがabをxと計算,ウインドウサイズ3のウインドウがdefをxと計算.文章の最初の単語から順番に全ウインドウ集計結果から最近値をソートし,最もウインドウサイズの小さい単語群に置き換えてゆく.

a b c a b

a b c a b 同じ意味の文章→同じ文章

a b o p q r

または

x c x (int)

x c x (int)

x o p q r (int)

そのままCNNにかける場合,CNNにおいて全マルチウインドウのconcatを行えば,上記変換のための多様体ができいるといえ,そうであるなら解像度変換ができているかもしれないわけだが・・・いや,これを学ぶ過程はないし,そも学習に任せた結果と任意に行う結果は異なるか.とはいえとりあえずaveragepoolingモデルをマルチウインドウ化してみるか(accuracyに大差がなかったためしていなかった)(トポロジーを学びなおしているが多様体について誤解があったので後ほど修正削除予定.).前処理としての文章の解像度変換も試してみよう(数値がほぼ等しく,が達成できずノイズだらけになると思うけれど.最低でもあと一つ何かが必要.

Attentionにwindow概念を適用し広げればどうなるのだろう?attention自体がwindowの代わりをしてはいるのではあるが.

→SpanBERT

https://arxiv.org/abs/1907.10529 範囲と範囲の境界を予測

*「無料でオープンソースの写真管理ソフトが特許を侵害している」と謎の企業によって非営利団体が訴えられる

https://gigazine.net/news/20190926-shotwell-lawsuit-patent/

AIには,このような特許を見つけ出す性能を持つことを期待している.そのため自分は,AIに上位概念下位概念変換や解像度変換能力の高さを求めている.辞書では限界があるため分散表現に期待する.するとノイズが増える.それをカバーするためにも,多様性評価手法が必要となる.他の手法があればそれでも良いのだが,今のところ,教師依存の手法しかないように見えている.

*複数粒度の分割結果に基づく日本語単語分散表現

https://www.anlp.jp/proceedings/annual_meeting/2019/pdf_dir/P8-5.pdf

解像度ではなく粒度のほうが良い?.ここで言う粒度は形態素の区切りの違いにより類義語が類似とならないことを問題視しているが,自分は上位概念と下位概念で類似とならないことを問題視している.少々異なるか.

*(以下考えがまとまっていない)

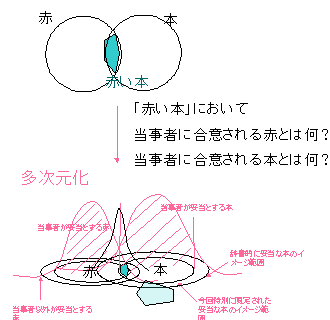

私は昔から,単語を「集合」と「分布」(分布だけでも良いけれど)よりなる概念として,少なくとも3次元上の概念として認識しており(特許を読むものは多かれ少なかれ似た認識を持っていると思うが),文章はその和か積だろうと認識していた.今は,単純な和や積ではないと考えている.単語を表す集合・分布は原子の電子雲のようなものと考えており,分子の電子雲が原子の電子雲の単純な和となっていないように,文章の集合・分布は,ある構造的ルールに基づいた(例えば重心位置の違いを考慮した)計算をして求められるべきではないかと考えている.

(ベイズがその答えを与えてくれるのではないかとなんとなく思っている.KLダイバージェンスで分布の距離を測って・・・てそれなら)(GCNや化学物質予測タスクにおけるBERTの利用についても,興味深く思っている.)(機械学習モデルに入力する文章を,単語の集合・分布をノードとしたグラフとすれば,面白いのではないであろうか.前後または同一クラスタとなった単語間の距離をエッジとしつつ分布を重ねるなど、ありうるのではないか.)(構造形成について、基本的にはCNN類似+ウインドウの構造化である程度良い結果が得られるかと思っている.…位置普遍性は重要だが、弱い位置情報を与えてみてもよいのか?試してみるか)

(単語の分散表現は単語の集合・分布を内包しているとも言えるかもしれない.集合は文脈として内包しているとできるだろう.分布はどうか.自動的にガウス分布を仮定しており(というのもおかしいが)検討されていない気がする.真値があることを仮定してしまっている気が.この場合,複数の真値を仮定する必要がある認知に対応できないのではないか.(ピーク高さを表す重みと、足切りを表し「集合の広さを確率分布に従い変化させる」重みの2つを利用すれば?)(ある単語のベクトルの周りには、単語が設定されていないが類似するベクトルが存在し、ある単語周りにガウス分布している。という分布の考え方。「空」単語ベクトルの扱いをどうするかが重要になるのか?。空単語ベクトルの生成自体は分布を仮定しランダムサンプリングすれば良い。文章内の単語すべての単語ベクトルを、平均や和を含め、shapley値を高さとした等高線を用い図示し、類似する2文章で比較するなどすれば、分布に関しなにか見えてくるか?)(単語ベクトルのいくらかの次元は認知である,または認知を加えるべきである,としても良いが,concatは何故かいまいち.認知は,多次元と並列平等に扱うのではなく,多次元全体に正規化を施した上で影響を与えるようにする必要があるのだろう.単語ベクトルの次元全てに平等に影響を与えるのではなく,分布を仮定し影響を与える必要があるのだろう.てこれがそも記憶ネットワーク,transformerか.認知分布をどのように設定するかは興味深い.予め概念として認知分布を作っておく,つど教師データから学習し認知分布を作る,リアルタイムに認知分布を指定する,フィードバック制御として認知分布を設定する,すべてが必要に思う.)

文章について.

単語の分散表現の単純な和は短文では意味を残すが長文では意味を残し難いと知られている.何らかの単純な和でない構造が必要と理解されている.自分はこれは(biasでなくvalianceの影響もあろうが)分布の問題ではないかと考えている(というより,そうだったら興味深いな,に近い).文章の分布形成はモデルに依存しているように思う.CNN類似モデルではマルチウインドウが文章の分布形成を受け持っていると言えなくもないかもしれない(複数峰をmaxpoolingで選出することにより個性抽出ができる,できている,かもしれない).最近のモデルにおけるクラスタ利用の流れは一部を削減することで,擬似的に適当な分布を作っていると言えるのかもしれない.「モデルの個性」の正体は,これら文章の分布形成の違いかもしれない.分布が異なるならそれは概念の違いといえ,概念の違いが認知上の個性ならば,「モデルの個性」は正しく「個性」と言えるのかもしれない.)(分布もbiasとvaliance双方含み見分けがたいところがなんとも.ガンマ分布とベイズかな最終的には))(→本文のベクトルの伸び縮みにつながる.)(まあ自分はガウス分布を想定したままモデルごとに真値を1つにまとめ(あとに述べる「類義・関連語」の価値観に基づく「歪め統合」のこと),異なるモデルが持つそれぞれの真値を最終的に評価計算する手段をとったわけだが,より上流で対応できるのではないだろうか.)(BERT,attentionはボトムアップ注意、w2vembmaxpはトップダウン注意、相互補完しているため多様性評価がうまく行っている、などと考えて良いものか(…逆か?))(日本認知科学会2019ヤフーポスター、圏論に基づく分散表現の加減算の定式化に向けて.単語ベクトルの点をオントロジー(トポロジーだったか)で面に変換し?(分布を考えるよりトポロジーを用いたほうがモデルに相対的に最適化しやすく適切だろうな)圏論を用い射の構造抽出して分散表現の説明とし理解につなげる?と理解してよいのか.定式化後、ベクトルの乗算等の性質も検討?.うーむ,わからんが,ベクトル群をクラスタリングした後クラスタ群をノードとした有向グラフとすることとどのように異なるのだろうか?.この定式化ができれば,特許請求項の数式化も見えてくるだろうか.とても楽しみ.興味深く追跡してみる. https://research-lab.yahoo.co.jp/en/nlp/20190905_miyazaki.html )(概念を別に作る視点と概念を構造を用い誘導して作る視点が混ざっており何言ってるのかわからないな我ながら.)(化学物質合成タスクでSMILES記法条件下のMolecular transformerがSoTAとなったのを見るとBERTで十分と思わなくもない.)(BERTの手法なら空ベクトルを補いやすいかな.)(メタラーニングを追うと良さそう)

単語に分布をつけると重心が適切にずれる?.文章ベクトルを作るにあたり,機能語はルールベースで分布と距離を微調整するように使えば良い?.意味語は認知分布に関わるだろうが,機能語は認知分布に関わだろうか?.

*Analysis of Word Embeddings using Fuzzy Clustering

https://arxiv.org/abs/1907.07672

"In contrast to hard clustering techniques, where one point is assigned exactly to only one cluster, fuzzy clustering allows data points to pertain to several clusters with different grades of membership"

このあたりどうだろうか.複数クラスタの共通部分に変換すれば解像度変換もできそうでもある.ソフトクラスタリングには他の手法もあるがいずれでも分布を持ち込めるか?

単語を分布で考えるモデルは,1gramのいわゆる言語統計モデルや無限語彙モデルと呼ばれる基礎モデルであるようだ.

伊庭幸人,持橋大地ら(2018)

ベイズモデリングの世界

岩波書店 p69−

https://sites.google.com/site/iwanamidatascience/BayesModeling

ここから独立生起仮説を外すとその延長として,n-gramモデルや無限n-gramモデルがあると.また言葉の意味の統計モデルとしてトピックモデルの一種であるLDA(階層ベイズを取り入れた)が.さらにword2vecが紹介されている.これらは上記に言う構造を形成していると言えるのだろう.(これらを分布という視点で見ていなかった.勉強不足やな.)

さて,これらでも十分でないことはわかっている.基本に帰りつつ,他の構造も仮定できないか考えることとしよう.上記のように,内容語としての単語でなく,機能語の役割を考え直すことはできるのだろうか.

Randall K. JamiesonJohnathan E. AveryBrendan T. JohnsMichael N. Jones(2018)

An Instance Theory of Semantic Memory

Computational Brain & Behavior, 1(2), 119–136

https://link.springer.com/article/10.1007/s42113-018-0008-2

プローブ部分が上記分布と類似するか.分布と分散表現,認知についての記載あり.考え方が似ている.著者追跡してゆくか.

*人類の文化的躍進のきっかけは、7万年前に起きた「脳の突然変異」だった:研究結果

「記憶のなかの複数の単語を意味のあるメンタルイメージとして合成するプロセスは、「前頭前野統合(Prefrontal Synthesis)」または「メンタル統合(Mental Synthesis)」と呼ばれている」

「「単語の柔軟な組み合わせと入れ子構造は、すべてのヒト言語に特徴的な機能です。このため言語学者は現代的な言語を『再帰言語』と呼んでいるのです」と、ヴィシェドスキーは言う。

しかし、複数の単語が複雑に組み合わさった入れ子構造の文章が理解できるかどうかは、受け手の前頭前野外側での「統合」能力にかかっている。そしてこれを可能にするメンタル統合能力の発達には、非常に重要な時期があるという」

https://wired.jp/2019/09/01/recursive-language-and-imagination/

https://riojournal.com/article/38546/element/8/24430/

メンタル結合能力。立体視と同じく後天的なんやな。概念構造形成時の誘導が重要なのでは。

*The Cognitive Tradeoff Hypothesis

https://www.youtube.com/watch?v=ktkjUjcZid0

短期記憶と言語・予測のトレードオフ。進化における喪失と取得。概念構造形成時の誘導は重要に思える。どのような誘導が必要なのだろうか.忘却だろうか.「特徴を抽出するのでなく非特徴を如何に削減するか」が重要ではないか.AIでも,得られた特徴をあえて削減することが必要なのではないか.

(削減に付き,ランダム性の高いdropout以外の構造には何があるだろうか.クラスタリングが答えである気がする.)(「平均の平均の周りに分布する」モデルとすれば,個性(ここではデータの個性)を取り入れつつ全体の情報も利用でき安定した推定が可能となるとのこと.前述「ベイズモデリングの世界」)(これが近年のクラスタリング利用活発化の理由だろうか.クラスタリングにより,「データの個性」を拾い上げることができる(個性的なデータは単独で1クラスタを形成する).「モデルの個性」とは,「モデルが拾い上げる「データの個性」に差違があること」,と表現するとよいかもしれない.自分のモデルの多くは(下記tfidf可視化含めて),このクラスタリング(と分散表現を組み合わせて)を利用している.).(共有の視点で考えれば,予測型AIに多様性を用いる方向性は正しいように思える.)(クラスタリングによりメモリ削減など性能を落としつつ改善させよう,としたところ,結果として,従来より性能が向上した,という結論となっている文献がそこそこ目立つようになってきている気がする.どこかで集計してみるか.)

*理研ワークショップメモ(理解を間違えているかもしれない)

・ものづくりの時代の流れは,「もの(毎回実験)→理論・式(シミュレーション)→計算(可視化・解析・予測)→データ駆動(計測→ネットワーク→AI)」.

・「測定」自体の先鋭化による「多量のデータ」作成→「ネットワーク」による技術の保管・共有→保管された技術と多量の測定データを処理する「AI」,が重要となってくる.

*可視化は,AIのブラックボックスを解明するためやAIの説明責任のような文脈で語るのではなく,AIとヒトが互いを?理解しつつ協同するため,という文脈で語るべきかと思う.

*Diversity in Machine Learning

https://arxiv.org/abs/1807.01477

https://arxiv.org/pdf/1807.01477v2.pdf

!そのままのタイトルだが,Computer Vision and Pattern Recognitionに分類されていたため見逃していた.

機械学習における多様性に関するサーベイ.

201905v2において,「モデル(らの)多様性」の項が加えられたようだ.良きかな.しかし,この項に付されている引用は殆ど無い.個性の評価手法に関するヒントはない.v3に期待.

"IV. MODEL DIVERSIFICATION

In addition to the data diversification to improve the performance with more informative and less redundant samples, we can also diversify the model to improve the representational ability of the model directly. As introduction shows, the machine learning methods aim to learn parameters by the machine itself with the training samples. However, due to the limited and imbalanced training samples, highly similar parameters would be learned by general machine learning process. This would lead to the redundancy of the learned model and negatively affect the model’s representational ability.

Therefore, in addition to the data diversification, one can also diversify the learned parameters in the training process and further improve the representational ability of the model (D-model). Under the diversification prior, each parameter factor can model unique information and the whole factors model a larger proportional of information [22]. Another method is to obtain diversified multiple models (D-models) through machine learning. Traditionally, if we train the multiple models separately, the obtained representations from different models would be similar and this would lead to the redundancy between different representations. Through regularizing the multiple base models with the diversification prior, different models would be enforced to repulse from each other and each base model can provide choices reflecting multi-modal belief [27]. In the following subsections, we’ll introduce the diversity methods for D-model and Dmodels in detail separately.

B. D-MODELS

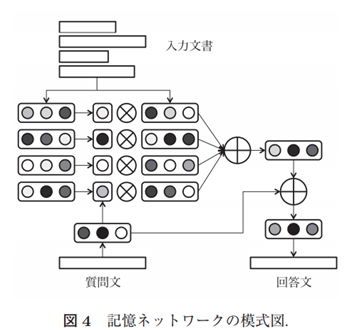

The former subsection introduces the way to diversify the parameters in single model and improve the representational ability of the model directly. Much efforts have been done to obtain the highest probability configuration of the machine learning models in prior works. However, even when the training samples are sufficient, the maximum a posteriori (MAP) solution could also be sub-optimal. In many situations, one could benefit from additional representations with multiple models. As Fig. 4 shows, ensemble learning (the way for training multiple models) has already occurred in many prior works. However, traditional ensemble learning methods to train multiple models may provide representations that tend to be similar while the representations obtained from different models are desired to provide complement information. Recently, many diversifying methods have been proposed to overcome this problem. As Fig. 6 shows, under the model diversification, each base model of the ensemble can produce different outputs reflecting multi-modal belief. Therefore, the whole performance of the machine learning model can be improved. Especially, the D-models play an important role in structured prediction problems with multiple reasonable interpretations, of which only one is the groundtruth [27]."

「図4で示すように、アンサンブル学習(複数のモデルをトレーニングする方法)は、以前の多くの研究ですでに行われています。しかしながら、複数のモデルを訓練するための伝統的なアンサンブル学習方法は、類似する傾向がある表現を提供し得るが、異なるモデルから得られた表現は補完情報を提供することが望まれる。最近、この問題を克服するために多くの多様化方法が提案されている。図6に示すように、モデルの多様化の下で、各基本モデルは異なる出力を生成することができます。したがって、機械学習モデル全体の性能を向上させることができる」

自分の見解と同じ.Recently, many diversifying methods have been proposed to overcome this problem.に引用なし.Recently,manyなら例示してほしいが.up

"VI. APPLICATIONS

Diversity technology in machine learning can significantly improve the representational ability of the model in many computer vision tasks, including the remote sensing imaging tasks [20], [22], [77], [112], camera relocalization [87], [88], natural image segmentation [29], [31], [95], object detection [32], [109], machine translation [96], [113], information retrieval [99], [114], [158]–[160], social network analysis [99], [155], [157], document summarization [100], [101], [162], web search [11], [98], [156], [164], and others."

*AI Samuraiのシステム構成をみた.

非常に誠実なシステムという印象.類似検索は「キーワード検索」「ベクトル類似度(分散表現)」「グラフ分析」から行い,何らかの方法でスコアを集計している(任意重み付けであると聞いたような聞かなかったような).3つの検索手法は,まとめればCNNと同じようなことをしているわけだが,あえてCNNにしないことで短文に対応しやすくしつつ明確性を高めているように見える.この点,誠実に見える(お前は分散表現任せで不誠実だ?.非常にごもっとも.).

ただ,この3つの検索手法,分布が十分に異なっている(類義語を十分に引き出している)のであろうか?.公開されている特許を読む限り,実際はもっと複雑なのだろう.

*GeoInformatica 2019, Volume 23, Issue 2, pp 221–242

Using word embeddings to generate data-driven human agent decision-making from natural language

https://link.springer.com/article/10.1007/s10707-019-00345-2

「このアプローチでは、フィールドインタビューのトランスクリプトからWebの非構造化データまでのテキストソースを使用して、人間の認知をキャプチャおよび表現できます。ここでは、言語のベクトルベースの表現である単語の埋め込みを使用して、類似性比較を使用して推論するエージェントを作成します。このアプローチは、さまざまな自然言語の意思決定タスクにわたる人間の意思決定バイアスに対する理論的期待を反映するのに効果的であることが証明されています。概念実証エージェントベースのモデルを提供します」

"prompt = "Linda is 31 years old, single, outspoken and very bright. Sh

e majored in philosophy. As a student, she was deeply concerned with i

ssues of discrimination and social justice, and also participated in a

ntinuclear demonstrations. Which of the following is most probable?"

options = [ "Linda is a bank teller.",

"Linda is a bank teller and active in the feminist movement.",

"Linda is a feminist."

[0.2744873996226564, 0.5923732736455332, 0.35307643353440243]"

def calculate_phrase_vector(word_set, embeddings):

'''

Input: list of words

Output: average vector

'''

phrase_vector = np.zeros(embeddings.dimensions)

for word in word_set:

# goes through each word, finds the vector in the precomputed vector file,

# multiplies it by the frequency of that word, and then adds it to the phrase vector

try:

phrase_vector = np.add(phrase_vector, embeddings.get_embedding(word))

except:

print("Skipped", word, "in phrase vector")

try:

phrase_vector = np.divide(phrase_vector, len(word_set)) # averages the phrase vector by total number of words in phrase

except:

print("Phrase Vector 0")

phrase_vector = np.zeros(embeddings.dimensions)

return phrase_vector

えええ

*Does Technological Diversity Help or Hurt Small Firms? The Moderating Role of Core Technological Coherence

https://ieeexplore.ieee.org/document/8384275

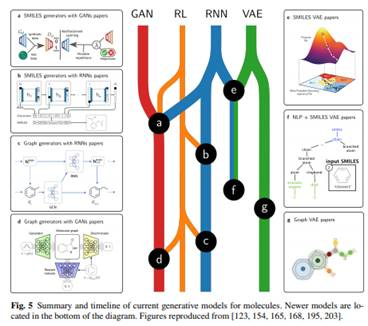

*Generative Models for Automatic Chemical Design

https://arxiv.org/pdf/1907.01632.pdf

https://speakerdeck.com/elix/elix-cbi-2019?slide=20

*我が国の伝統的な組織的意思決定方法をマルチエージェントシミュレーションで実装するためのモデル設計

https://www.jstage.jst.go.jp/article/jasmin/201906/0/201906_181/_pdf/-char/ja

「この組織的意思決定方法による効果について 宮本は『村でとりきめをおこなう場合には,みんなの納得のいくまで何日でもはなしあう』

『みんなが納得のいくまではなしあった。だから結論が出ると,それはキチンと守らねばならなかった』と述べており,十分な合意が形成されることを指摘している。

H.A.サイモンの意思決定は,

「情報活動」「設計活動」「選択活動」「検討活動」の順にプロセスが定義され,問題解決のための代替案を「選択活動」で評価する際にも,各代替案を評価する統一的な観点を定義し,評価スコアを定め,最大の評価スコアとなった代替案を採用するといった。定量的なものである。

・各エージェントがお互いに十分な意見交換を行うこと

・各エージェントの意見が全体の結論に対し程度の差はあっても加味されていること

集約した探索進路ベクトルを数学的なベクトル合成に相当する演算により合成することで求める」

ううむ

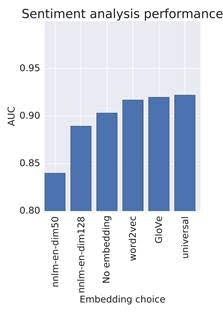

*Semantics derived automatically from language corpora contain human-like biases

https://science.sciencemag.org/content/356/6334/183.full

*Text Embedding Models Contain Bias. Here's Why That Matters.(Google AI Blog)

https://developers.googleblog.com/2018/04/text-embedding-models-contain-bias.html

「Googleでは、意図しないバイアス分析と緩和戦略を積極的に研究しています。これは、すべてのユーザーに適した製品を作成することにコミットしているためです」

自分は,「すべてのユーザーに適した製品を作成すること」とは「逆」の,「個人用アシスタントAI」を想定している.方向性は悪くないようだ.

"The Word Embedding Association Test (WEAT) was recently proposed by Caliskan et al. [5] as a way to examine the associations in word embeddings between concepts captured in the Implicit Association Test (IAT). We use the WEAT here as one way to explore some kinds of problematic associations.」

いまさらだが,個性評価にはこのWEATテストまたは類似手法が役に立つのか?

Table 1: Word Embedding Association Test (WEAT) sc7ores for different embedding models. Cell color indicates whether the direction of the measured bias is in line with (blue) or against (yellow) the common human biases recorded by the Implicit Association Tests. Statistically significant (p < 0.01) using Caliskan et al. (2015) permutation test. Rows 3-5 are variations whose word lists come from [6], [7], and [8]. See Caliskan et al. for all word lists. For GloVe, we follow Caliskan et al. and drop uncommon words from the word lists. All other analyses use the full word lists."

"For developers who use these models, it's important to be aware that these associations exist, and that these tests only evaluate a small subset of possible problematic biases. Strategies to reduce unwanted biases are a new and active area of research, and there exists no "silver bullet" that will work best for all applications. When focusing in on associations in an embedding model, the clearest way to determine how they will affect downstream applications is by examining those applications directly."

うむう

"We'll evaluate the quality of the sentiment classifier using the area under the ROC curve (AUC) metric on a held-out test set.

Here are AUC scores for movie sentiment classification using each of the embeddings to extract features:"

"At first, Tia's decision seems easy. She should use the embedding that result in the classifier with the highest score, right?

However, let's think about some other aspects that could affect this decision.

Looking at the WEAT scores for various embeddings, Tia notices that some embeddings consider certain names more "pleasant" than others. That doesn't sound like a good property of a movie sentiment analyzer. It doesn't seem right to Tia that names should affect the predicted sentiment of a movie review. She decides to check whether this "pleasantness bias" affects her classification task."

"In this case, she takes the 100 shortest reviews from her test set and appends the words "reviewed by _______", where the blank is filled in with a name. Using the lists of "African American" and "European American" names from Caliskan et al. and common male and female names from the United States Social Security Administration, she looks at the difference in average sentiment scores."

"There is no one "right" answer here. Many of these decisions are highly context dependent and depend on Tia's intended use. There is a lot for Tia to think about as she chooses between feature extraction methods for training text classification models."

"Conclusions

To better understand the potential issues that an ML model might create, both model creators and practitioners who use these models should examine the undesirable biases that models may contain.

We've shown some tools for uncovering particular forms of stereotype bias in these models, but this certainly doesn't constitute all forms of bias.

Even the WEAT analyses discussed here are quite narrow in scope, and so should not be interpreted as capturing the full story on implicit associations in embedding models.

For example, a model trained explicitly to eliminate negative associations for 50 names in one of the WEAT categories would likely not mitigate negative associations for other names or categories, and the resulting low WEAT score could give a false sense that negative associations as a whole have been well addressed. These evaluations are better used to inform us about the way existing models behave and to serve as one starting point in understanding how unwanted biases can affect the technology that we make and use. We're continuing to work on this problem because we believe it's important and we invite you to join this conversation as well."

単語の分布,文章の分布の問題とするか.

*個性について.個人的には,個性とは概念の違いのことだと考えている.

(ここで言う概念のことを,認知科学では表象と言うらしい?.この場合,「概念」=「価値観」・「辞書」=表象,(「データ」→表象→「情報」)=「歪め統合」=プロジェクション,と理解してよいのか? 特集「プロジェクション科学」編集にあたって https://www.jstage.jst.go.jp/article/jcss/26/1/26_6/_pdf/-char/ja )

(プロジェクションの考え方は、価値共創、ものと顧客双方のスキル・ナレッジが必要とするサービスとサービスが交換されるという考え方に似ているかな.「価値共創」は認知考慮、個性考慮そのものか.顧客がそのスキル・ナレッジを用いてものから価値を抽出している,という考え方は認知そのものだな.多様性評価も価値共創そのものか.)

*個人的には,モデルの理解が足りない状態で適切な教師を設定することは難しいと考えている.例えば,単語を主因子とするモデルであればそのような教師を渡すべきであるし,単語と互いの共起性を主因子とするモデルであればそのような教師を渡すべきである.サリバン先生はヘレンに水に触れさせ水に名前があることを学ばせたが,熱い,冷たい状態を水と呼ぶと学んでしまう可能性もあった.教師はヘレンを理解し学ばせる必要があった.

また,概念として保持したいデータは概念として学ばせるべきであり,直接教えたいデータは教師として学ばせるべきであると考えている.「教師データ」とは流れる水,「概念」とはそれを通す河の形,そしてその双方が変化するなか,ある流れを得たいときにどちらの変化が必要なのか見極めなければならない.その水は河の形を作れるのか,その河の形はその水を受け入れるに適切なのか,水を受け入れる際に河の形を変えてよいのか.

必要な理解は,データ1結果7数学2ぐらいのウエイトか.

*概念とqはデータを入れ情報を出力する入れ物.人は,多くのインプットに基づき脳内に概念という入れ物(河の形)を削り,そこにデータ(水)を流してゆく.概念において最も重要なのは,その境界であって,中身ではない.(別の言い方をすれば,概念とは母集団の階層とエッジの適切な把握,データとはその母集団に高さと構造を持って入る多様体.…うまく表現できない.適切に訓練された専門家の脳にはエッジを流動的に見極める概念がある,ぐらいに留めるべきか.)(概念を入れ物とみなすのでなく、データに概念を付加したものが情報であるとする考え方もあるそうです.)

*データに触るためには概念という入れ物が必要.概念を作るためには多くのデータインプットが必要.これを学習という(学習とは概念を作る行為であり,データを詰め込むことではない).概念がない状態とは,重要なデータがこぼれ落ちる,理解できないことが理解できない状態.非専門家と専門家の違いは,概念のエッジの認識と更新にある.非専門家は,概念が形成できていないか,一度概念を作ったのち更新しない状態にある.概念を更新しない状態とは,硬い入れ物となり変化に対応できない前こうだったと経験のみ持ち出す判断を取りがちな状態である.(本当の)専門家は,概念を流動的に変化させる.現在よく見られるAIは,概念形成を教師データのみに丸投げしており,適切な概念形成のために十分と言える構造をまだ持っていない.それにより,データが多量に必要かつバランスを崩しやすいものとなっており,バランスを取ることができれば概念のあるものや専門家に,取れなければ概念が無いもの(データを受けられない)やエセ専門家(データを適切でない概念に入れる)になるという,コントロールされていない不安定な状態にあるように思える.

自然言語では概念形成に必要十分なデータを毎回適切に用意することが難しい(似た文章データを用意することはできるが,画像と異なりそれが概念形成に寄与するかどうかわからない(猫という概念に当てはまる画像データを用意することは容易だが,猫という概念に当てはまる文章データを用意するのは困難.これは「認知」にも関わるから.ある場合では猫からフランスを認知してほしいかもしれないが,猫からフランスを認知する情報を付与した文章を「特定の教師データとして」揃えることはまず無理だろう.))(認知を考慮しない大量の類似教師データを用いることにより,意味レベルでは正しい答えを導き得るが,認知レベルではそうならないだろう.自然言語における実用では,認知を無視することはできない.「認知を考慮した少数教師データ」で判定を可能とするモデルが必要である,と考えている.)(欲しい答えを教えたとしても、それが概念形成に役立っていると言えるのか明確ではない.教師データを安易に変える手法は悪手だろう.)(認知科学では、意識的処理における概念によるトップダウン駆動と、無意識処理における知覚によるボトムアップ駆動の考え方があるようだ。画像は後者、言語は前者、自ずと手法は異なる、というべきなのかもしれない。).

概念形成のための構造を備えた(あらかじめ概念を作っておいた)専門家AIがいま必要だと思っている.

(概念形成のための構造でも認知を取り入れた構造でも同じ…か?.)(ついで,その概念構造は1つに収束しないとも考えている.つまり、本質的に最適化問題ではないためそれだけでは解けない、と考えている。)(自分は概念を,後に述べるように,「辞書」と「価値観」に分けている.)(文章に加え図表や数式を用いるのは誤解の余地を減らすため.文章は「意味(文脈含む)」を表すが,「認知」の問題により「情報」を適切には表さないため,誤解の余地が大きい.この点が画像系と自然言語系の本質的違いだろう.文章のみを用いかつ誤解の余地を小さくするには,「意味」を「情報」に変換する「概念・認知処理の構造」を備えることが必須だろう.)(BERTで自然言語でも転移学習が有効だとわかったことは,予め概念を作っておくという視点においてとても価値のあることだった.個性という面から観るとそれだけでは不十分だが.)(転移学習は元ドメインから目標ドメインに転移させるが,元ドメインが概念すべてを学んでいることを前提とする.これから,「概念の形に絶対的な答えがある(例えば句構造の絶対化など)」と前提しかねない.画像ではそれで良いだろう(縦線斜線耳構造などは絶対としても良い)が、自然言語ではそれはエセ専門家への道となりかねない(文法的に正しい文しか認めないなど)し,創造性は生まれにくくなるだろう.先に述べた,個性という面から観るとそれだけでは不十分だが,とはその意味.だからBERTをモデルの一つ以上に扱うつもりは,今のところ,無い(蒸留に関しても同じ考え方をしている.こちらはやりようがあるだろうけれど.)(とりま,RoBERTの延長技術がどうなるか見守リ、要事入れ替える.))(とはいえ,転移学習の元ドメインにおいてどのような構造が得られるかにも依存する.柔らかい概念(句以下?3-gramぐらい?)で止めておけば,個性の源として機能するだろう.→BERTの項参照)(この項,全体的に書き直した方は良いな.概念について2通りのイメージをしているのにそのまま混ぜてしまったからわけわからん.)

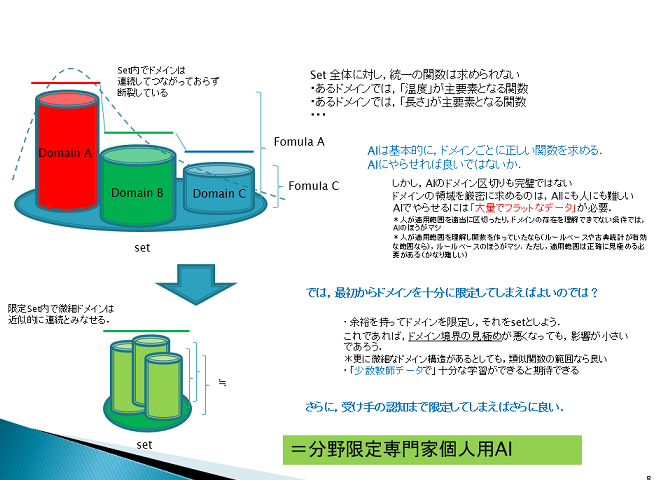

上記図は、少数教師を最も単純な方法で達成する考え方を示したもの。

後述している常識グラフ→ニューラルネットワーク→専門家グラフの流れの前半部分、と言っても良い。

この手法を取らずとも、ドメインの調整手法は様々ある。自分は以下にクラスタリングと表現していることが多い。AIには大量にデータが必要だ、という条件は、絶対的なものではない。

なお上記は、帰納的予測のあとの演繹的仮説づくりにおける理解可能性にも関係する。

(AIが使えない、という人は、まずこの辺りから見直すべきだと思う。AIが使えないではなく、AIを使えない、例がとても多いように観える。まあ使い方を工夫しようもないAIもあるけれど。)(回帰と同じく,関数がHölder関数で表現でき活性化関数がReluであるときの効率的な近似,といえばよいのか?. https://tech.preferred.jp/ja/blog/deep-nonpara-regression/ )(ドメイン間で共通する要素を学習したい場合には,最近はマルチタスク学習を行うことが多いらしい.自分の場合は目的上多分不要だが.)

*小さいデータにもとづいてディープラーニングを使う方法(201912)

https://ainow.ai/2019/12/12/181633/

まとまった記事が公開された.このうち「モデルの分解」が上記に該当.

コサインロスは手元の実装でも予想外に良い結果を生んでいて納得感がある.

「昨年のNIPsに提出された論文「現代のニューラルネットワークは小さなデータセットに一般化される」では、著者たちはディープラーニングニューラルネットワークを多数の小さなニューラルネットワークが合わさったものとして捉えている。「特徴を抽出するのに増えていく階層をもつ各層に注目するよりは、最終層が提供する集合的メカニズムに着目するほうが賢明だ」と論文では述べている(※訳註3)。わたしも小さいデータを活用するためにこの論文のアイデアを使ったのだが、論文にあるような集合的効果の利点をうまく活用するためにぜひニューラルネットワークを構築してほしい」

Matthew Olson Abraham J. Wyner Richard Berk (2018)

Modern Neural Networks Generalize on Small Data Sets

32nd Conference on Neural Information Processing Systems (NeurIPS 2018), Montréal, Canada.

https://papers.nips.cc/paper/7620-modern-neural-networks-generalize-on-small-data-sets.pdf

前述していたように、まさに,そのとおりだと思う.自分がやってきたことは,泥臭いが,ここだ(一つのディープニューラルネットワークが多数の小さなニューラルネットワークをあわせたものそのもの,と期待通りになるか,という点には,上記に「構造」として述べたとおり,個人的には疑問があるが.).

というかこの論文見つけられていないといかんやんかわし・・・

この文献があれば他者への説明がかなり簡単になるな良きかな。

ここから被引用引っ張れば良い文献が見つかってゆきそうやな・・・

元記事:How To Use Deep Learning Even with Small Data(201911)

https://towardsdatascience.com/how-to-use-deep-learning-even-with-small-data-e7f34b673987

*@AndrewYNg

Deep Learning is getting really good on Big Data/millions of images. But Small Data is important too. Am seeing many exciting applications at Landing AI where you can get good results w/100 images. Hope more researchers work on Small Data--ML needs more innovations there.

4:48 - 2018年9月28日 · Palo Alto, CA

*few-shot-learningは流行の只中.

*end-to-end学習は,ドメインの区切りを見分け難くし多様性が低下するという点で,現状,どうなのかなと思わなくもない.ドメインの区切りを見分けやすくし多様性を維持する技術も開発されつつあるようで,将来的には,上記ドメインの話は,古い技術のみ使う場合,という限定がつくかもしれない.個人的には,解決手段が難しいというよりも,情報と多様性を見分けられるデータを揃えることが難しい気がしている.マルチタスク学習は,比較的少数の教師しかない場合でも,情報と多様性を維持することができやすい技術である,と考えており,興味深く見つめている.

https://qiita.com/Ishio/items/6ec1b3e84da647a8025e

*Talk to book(transformer)において,「モデルの多様性」を検索

https://books.google.com/talktobooks/query?q=importance%20of%20diversity%20for%20model%20on%20machine%20learning&

"This diversity of models gives machine learning systems great problem solving power. However, it can also be a bit daunting for the designer to decide which is the best model, or models, are for a particular problem.(view in book)

from Python: Deeper Insights into Machine Learning

by Sebastian Raschka, David Julian, John Hearty

Packt Publishing, 2016 ⦁ Science

“Python: Deeper Insights into Machine Learning” by Sebastian Raschka, David Julian, John Hearty"

お、おう。これは読まねばなるまいか。まず著者からやな。

" Other approaches to increase diversity rely on the use of a high-level model to combine object-level models derived from different machine-learning techniques, e.g., stacked generalization [41.78]. Alternatively, we can inject structural diversity in the...(view in book)

from Springer Handbook of Computational Intelligence

by Janusz Kacprzyk, Witold Pedrycz

Springer Berlin Heidelberg, 2015 ⦁ Science

“Springer Handbook of Computational Intelligence” by Janusz Kacprzyk, Witold Pedrycz"

"To further demonstrate how diversity can produce complexity, I present a model by Nowak and May (1993). This model considers the evolution of cooperation in a spatial setting.(view in book)

from Diversity and Complexity

by Scott E. Page

Princeton University Press, 2010 ⦁ History and Biographies ⦁ Science"

biasかvalianceか.双方diversityと表現されていてわかりにくい.

(関係ないが,特許の先行技術調査や権利化可能性探索タスクについて.Talk to bookやwisdom XのようなQAで解決するとよいと思うのだ・・・.主引例は文章全体の類似性で探し,副引例はQAで探す,これが能力的にも業務フロー的にもベストではないか.構成要素毎の類似性からでは要素間の組み合わせの引力を計算できないため限界があると思う.ここは変化する部分でもあるし,素直に人にやらせたほうが筋が良いのでは・・・.と考え自分はそうしている.

(数千件の母集団を作りtfidf embeddings/cluster visから主因例を探し、副引例をtalk to booksとwisdon x、google patent Σsimillarから探す。解像度変換ができ、書籍データが十分データベース上に掲載されるようになるなら、これで十分と思える。ついでに言うと、この2つが達成されているシステム等は今のところ無いと思う。どうせ中途半端なら・・・)(非特許文献や書籍の全文検索もできるように,となれば,Googleにしかできない気がする.)(Google patentのΣsimillarは,時期からするとTalk to bookと同じく,Transformaerであろう.明確でないが,すでにできるようになっている,のかもしれない.)

http://www.peterbloem.nl/blog/transformers

*Learning to Discover Novel Visual Categories via Deep Transfer Clustering

https://arxiv.org/abs/1908.09884

改善のため内部でクラスタリング処理.最近良く見る気が.「特徴を抽出するのでなく非特徴を如何に削減するか」という視点で良いのだよねこのクラスタリングは.

*Revealing the Dark Secrets of BERT

https://arxiv.org/abs/1908.09884

Attentionヘッド一部削除で性能向上.どのように削除するattentionを選択したのか興味深い.

*Errudite: Scalable, Reproducible, and Testable Error Analysis

https://medium.com/@uwdata/errudite-55d5fbf3232e

UW Interactive Data Lab

Aug 13 · 11 min read

Error analysis is a compass, and we need it to be accurate.

Error analysis — the attempt to analyze when, how, and why machine-learning models fail — is a crucial part of the development cycle: Researchers use it to suggest directions for future improvement, and practitioners make deployment decisions based on it. Since error analysis profoundly determines the direction of subsequent actions, we cannot afford it to be biased or incomplete.

But how are people doing error analysis today? If you read some quotes from ACL papers (a top conference for NLP, or Natural Language Processing), this is what you see:

“We performed an error analysis on a sample of 100 questions.”

We randomly select 50 incorrect questions and categorize them into 6 classes.

We sample 100 incorrect predictions and try to find common error categories.

クラスタリングでエラー累計.エラー文章が教師データより希少だという問題はあるが.

*Reflection on modern methods: when worlds collide—prediction, machine learning and causal inference

https://academic.oup.com/ije/advance-article/doi/10.1093/ije/dyz132/5531243

因果推論サーベイ?

*A Topological Analysis of Patent Statistics" (with Emerson G. Escolar, Yasuaki Hiraoka, and Yasin Ozcan)

https://arxiv.org/abs/1909.00257

*「減算と縮約」

https://ci.nii.ac.jp/naid/40019565591

全体を圧縮する縮約でなく、全体から削減する減算?。「特徴を抽出するのでなく非特徴を如何に削減するか」と同じ方向性と理解してよいのかな.多くのAIや,アンサンブルの平均,concat,文章の解像度の違い,に感じていた違和感はこのあたりかもしれない.w2v-mpには「減算」を行わせるようにしたいものよ.L1正則化を再検討しても良いかもしれない.

「多様体がない部分を削除することは良いが、多様体があるかどうかわからない部分を削除してはいけない,解る部分のみを抽出することは良くはない,解る部分以外を削除する考えではいけない.わからないものは通せという,3M準拠基準?で評価することが重要」と勝手に理解した.まだ原文を読んでいないが.

(原文入手.哲学そのもの?.

「想起としての記憶力」は上記で述べたような,知覚とともに回路をなし記憶のイメージで文字を埋め合わせ紙面上に投射され文字に取って代わる.「縮約としての記憶力」は知覚「に」混入し,現在そのものを構成する.この2つが認識の主観的な側面を構成する.知覚の主観的覆いからの純化のため縮約否定.縮約抜きの知覚考察の結果としての「減算」.減算に伴う削除とは多様体を局所的に分離し表層的になること(クラスタリングと理解してもよいのか?).生成とは削除(遮断)のこと.遮断自体が変化する必要がある.記憶力の役割は縮約によって量から質を得ることにあり,反対に減算モデルでは潜在的なものを考えるにあたりこの2軸では不十分となる.圧縮と拡散が対応.減算モデルにおいては向かわなければならないものに到達すること以上に悪いことはないのではないか(動的平衡の話か?)〜

まあなんだな,自分の目的においてこのようなことも理解しておく必要があるということはわかる.ルールベースでないところで「学習時に構造を導くモデル」が必要とするならば,その構造が,言語全体を上位概念に行き着くした場合どのようなものになるか,を考えて想定しなければならない.そうでなければ実装しようがない.その構造を想定するにあたり,どうしても多様体の姿を考えないといけないだろう.それには哲学のようなものの理解も必要なのだろう(数学的に多様体を考えたほうが良いのかもしれないが,どうしても認知できる特徴に寄せたくなるのよね・・・).まあ,哲学書を分類できるAIならば合格,という基準を作れば良いのではないだろうか,と投げやりに考えてしまう程度に頭が痛い.)(トポロジーを学びなおしているが多様体について誤解があったので後ほど修正削除予定.)(現在の広範な知識からのフードバックのような印象も.トートロジー気味に思えてきた.)(w2v-mpの歪め統合は、縮約か?.主観否定の為の減算なのだから、バイアス重視の歪め統合は縮約で良いのか?.全体としては減算だが部分的には縮約?.)

スパース仮説,全て独立でなく少ない独立成分が基底となると仮定し次元集約すること,が減算?.

減算と縮約はどちらか選択するものでなく統合するもの,と思えてきている.カプセルネットワークではないけれど,**少ない独立成分を選ぶのではなく,少ない独立成分をカプセルに押し込める,言い換えれば解像度を考慮し歪め統合する,**必要があるのではないかな.

*Gated Convolutional Neural Networks for Domain Adaptation

https://deepai.org/publication/gated-convolutional-neural-networks-for-domain-adaptation

自分より上流で処理しているが参考になる.多くの概念を作って評価基準…いやこれは自分と逆,別概念からの流用か?.gateの工夫次第では…いや,これwindowの多様性のみから概念を作っているので限界があるか.どちらかといえばランダムなクラスタリング手法に近いか。

システム図にpre-train部分をpre-domainと表記したが,domainと表記して正解のようだ.

キーワードdomain流しで検索すればモデルの個性についての関連文献も見つかるか?.前述のサーベイには記載がなかったが.

*辻井潤一(2016)

研究の個人史─言語処理,言語理解,人工知能─

人工知能 31(4)

https://t.co/mNnA6ggFCf?amp=1

「記号や構造による定式化が自然に見える意味処理や推論処理も、その計算過程の多くは無意識下での非明示的な処理で実現されている」

*最適な感覚統合で「主体感」を定量化-心理実験を統一的に再現する理論-

Roberto Legaspi, Taro Toyoizumi,

"A Bayesian psychophysics model of sense of agency",

Nature Communications, 10.1038/s41467-019-12170-0

http://www.riken.jp/pr/press/2019/20190918_1/

「行動と帰結の間に因果関係のある認識の「確からしさ(確率)」が、実験的に報告されている主体感の強弱とよく一致することが分かりました。さらに、この理論を用いて、これまでは統一的に理解することが困難だった主体感に関する心理実験を説明することに成功し、主体感を定量化する新しい数式を提案しました」

*「能動学習と受動学習とで比較し,能動学習の方が成績がでるが「学習した感」は低いという結果.学習した感を評価基準とすれば」

Measuring actual learning versus feeling of learning in response to being actively engaged in the classroom

https://www.pnas.org/content/116/39/19251

AIを使う観点において重要となりそうか.因果が明確にならないとAIを使っている気にはならない?.AIに課題まで提示されないと満足できない?.

「皆にインサイトを得る能力とモチベーションがある」という前提は,あまり当てはまらないのか?.ならばインサイトの次のステップ,「妥当な因果を示す仮説の提示」,まで,AIにやらせるべきか.

*西田勇樹(2019)

洞察問題解決における無意識的過程に関する研究:プライミング法を用いた検討

cognitive study 26(2) 291

https://www.jstage.jst.go.jp/article/jcss/26/2/26_291/_pdf/-char/ja

「手がかり妨害効果(インサイト?が問題解決の成績をかえって低下させる現象)は抑制機能(無関係な情報を排除する認知機能)が強く働く人で現れることを明らかにした」

ふむう.

*初期から用いていた40件の検証用データval40では,多様性評価を適用させると正解候補に全問正答してしまう状態となっており,現状以上に理解をすすめることが難しくなっている.さらなる理解を得るため一定の基準に従い前向きに検証用データの収集を始めて(と言っても基準を公開して収集してきたわけではないので今ひとつだが)半年以上,やっとある程度のデータが集まった.

Val460: 460件の検証用データ.教えていないかつ重要でもないけれど個人的に興味深い,という重要度Cの特許群を加えたハードなもの(教師データと語彙が共通していないことも多く,ある程度の創造性がなければ正答できないであろう.というかいくらなんでも無理だろう…理屈の上では,w2v-mpの歪め統合範囲に複数の単語が入っていれば正答可能だがその同時確率は…)(重要度Cには,後発シェア計算特許や,いらすとやのイラストがあって面白いな,という何をどう考えても高スコアとすることは無理だと思われる特許も含みます.)

→1評価の結果

| 重要度 | 正解候補 上位10%以内相当率 |

|---|---|

| A | 98.7% |

| B | 91.7% |

| C | 72.4% |

*実データにおいて上位10%となる評価値の平均を閾値とし,それを越えたval460サンプルの割合を10%以内相当率とした.

(閾値を設定した再現率で表現してもよいのだけれど.精度は目的上重要ではないので示さない.F1値は精度に引きずられるため目的上適切な指標とならないため示さない.)

*重要度A:落としたくない重要特許.

*重要度B:重要ではないが,教師内容を拡張して拾い上げて欲しい知っておきたい特許.

*重要度C:重要ではなく教えておらず知っておく必要もないが,個人的に興味がある特許.

*書いておいてなんだが,この絶対値は自分の課題においてそうできた以上の意味がないので,公開する意味は殆どないだろう.ある薬がある個人に対しどれだけ効いたかそれのみは,他の個人にどれだけ効くものなど示すものではなく他の個人にとって重要ではない.ある個人にとっては非常に重要なことだが.

(その抗うつ薬はあなたに効くか – AIが予測するうつ病治療効果202003 https://aitimes.media/2020/04/01/4562/?6598 「あなたに」効くか.どのように個人特化した検証をしたのだろう・・・ああ,脳波から一般的特徴をとってきたのか・・・.しかし,個別診療にもAIが出張ってきた・・・まあ,EBMとなり難い,「エビデンスから予測し難い」,「個々の診断結果が重要となる」,「個別診療」については,「多次元の診断結果を迅速に計算できる」AIのほうがヒトよりもそも向いているか.)

*Aはこの程度だろう(相当率100%となるのは上位11%のとき.).Bはもう少し改善必要あり.Cは50%もあればと考えていたのだが予想以上.重要度Cはw2v-mpの創造性を観察するために設定したようなものだが,分析の結果はどうなるだろうか.ざっと眺めた限りではもう少し創造的であって欲しい.

*興味深い点として,正解候補では個性が見られていると言える特許が多いのに対し,不正解候ではあまり個性が見られないという点がある.自分の教師の作り方をから考えると,幹と枝葉のうち,枝葉において個性が現れていることを示しているようで興味深い.

*現在は更に改良を進めており,重要度Bもほぼ100%に到達している(expert systemによる効果.AIだけで100%なんて無理に決まってんじゃない(おい)).しかし,本当に欲しいところは重要度C,ヒトが思いつかない部分の創造性だ(expert systemでは正解率が上がリにくい部分).この部分に関する考え方や手段・評価手法に関し,(いい加減本気で忙しいので趣味の範囲で)調査を進めてゆかねば.

*あれだけ時間かけて用意した検証データがそれを考慮した改良により一瞬で意味を失う…なにか虚しい.

*一旦休止するか.あとは改良のための文献メモに徹することにしよう.

*分野限定個人用AIの検証には,同一分野の複数の個人による主観的な検証が必要となる.ぶっちゃけ狭すぎる.さてどうしたものか・・・

*ElasticsearchとBERTを組み合わせて類似文書検索

https://hironsan.hatenablog.com/entry/elasticsearch-meets-bert

BERTベクトルで類似検索.時代の推移は早い.ベンダーだよりかなこの辺りは.

*Googleが自然言語処理の弱点「言い換え」を克服するデータセットを公開

https://gigazine.net/amp/20191004-paws-x-dataset-google?__twitter_impression=true

言い換えを教師ありで解決させようとした場合,どれだけのデータが必要となるのであろうか.

*Anonymous

Unsupervised Distillation of Syntactic Information from Contextualized Word Representations

26 Sep 2019 (modified: 26 Sep 2019)ICLR 2020 Conference Blind

https://openreview.net/forum?id=HJlRFlHFPS

Keywords: dismantlement, contextualized word representations, language models, representation learning

TL;DR: We distill language models representations for syntax by unsupervised metric learning

「文構造と文意を別々に識別できるモデルを教師なしで得ることを目指している.構造が同じで語彙が異なるものをPositive、その逆をNegative.」

"We demonstrate that our transformation clusters vectors in space by structural properties, rather than by lexical semantics. "

構造と単語の意味を切り分ける蒸留?.disentangleはこれからさらに注目されそうだ.切り分けられるなら少数教師により近づく.創造性を検討するなら,単語の意味を残し構造は無視する,などできると良いだろう.

*Disentangled な表現の教師なし学習手法の検証

https://research.preferred.jp/2019/10/disentangled-represetation/

あまり考えたことがなかったが,分散表現の次元毎の特性を確認するのも面白いか.

(original [('オロパタジン', 1.0), ~

0 disentangle 0 [('思い知る', 0.4159422516822815), ~

20 disentangle 0 [('辺鄙', 0.43800055980682373), ~

40 disentangle 0 [('なで切り', 0.28907349705696106),~

~

ベクトルを1割ずつ抽出し類似単語を得てみた。合成すればオロパタジンという意味になるはず。今回の抽出の仕方だと、オロパタジンとは、「思い知り」「辺鄙」で「なで切り」~「オロパタジン(1割まで削ってもまだオロパタジンが出てくる・・・)」であり「両目」で「グロンサンゴールド」であるらしい。・・・うーん?。どう考えるべきか。5割ほどまでの抽出ではほぼ変化なしであったので(高次元なので当然ともいえるが語彙が不足しているともいえる)1割まで削ったこと自体には問題はない?。今回はテストであるので不連続に抽出した。本来なら分布を考慮した抽出をするべきなのだろう。でなければ意味のある単語として抽出できないだろう(試行錯誤した結果からするとそうでもない?)。どうしたものか。1割と2割を比較すれば例えば「思い知り」と「辺鄙」を足した場合どうなるか見てゆけば、ツリー構造とでき理解につながるか?。いや類似度0.4程度では表出された単語から意味を読み取ることは難しいか?・・・。意味を読み取るには類似度0.8付近となる単語があるとよいだろう。この単語を得るに語彙が絶対的に不足しているが、語彙を増やすことはそも目的に反する。いや、高次元では0.4でも十分な類似といえばそう。まずどこかで閾値を見極めるか?。ううむ。より類似語が密集しているであろう単語を選び再検討するか?)

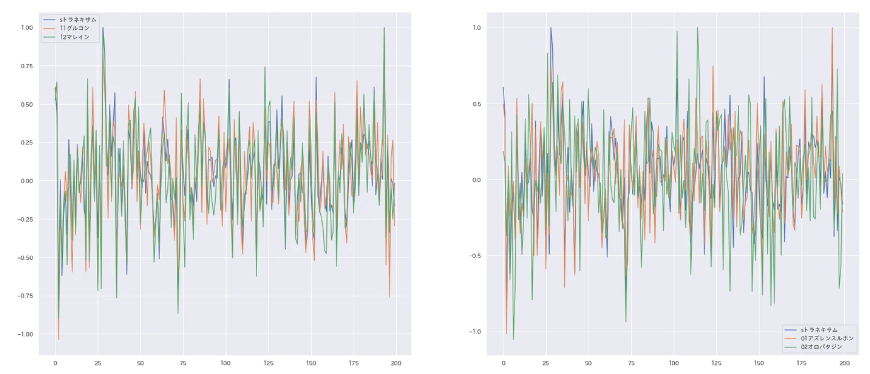

左は,トラネキサム,グルコン,マレインのベクトルを重ねた図.右は,トラネキサム,アズレンスルホン,オロパタジンのベクトルを重ねた図.

右について.1割まで削ってもまだオロパタジンとなった100-120範囲のピークを観察するに,この範囲は確かにオロパタジンらしいのかもしれないな・・・きちんと検証していないが.この部分を変更すると別の主剤に変わるようなスタイル変換ができたなら面白いが・・・よく考えたら歪め統合しているので認識できるかわからないか.

(左について.創造性の項でトラネキサム,グルコン,マレインの置き換えを述べているが,このように類似したベクトルとなっている.maxpoolingにおいてはほぼ同じだろう.)

次元ごとのdisentangleは保留。単語レベルの足し引きでdisentangleが達成できるか見てみよう。オロパタジンベクトルから両目ベクトルを少しずつ引いていったなら、どのように変化するだろうか。*

*Disentanglement Survey:Can You Explain How Much Are Generative models Disentangled?(201910)

https://www.slideshare.net/mobile/HidekiTsunashima/disentanglement-surveycan-you-explain-how-much-are-generative-models-disentangled

*J. Gerard Wolff(2019)

Information Compression as a Unifying Principle in Human Learning, Perception, and Cognition

Complexity Volume 2019, Article ID 1879746, 38 pages

https://doi.org/10.1155/2019/1879746

「人間の学習,知覚,認知における統一原理としての情報圧縮

このホワイトペーパーでは、人間の学習、知覚、認知の多くが情報圧縮、より具体的には「パターンのマッチングと統合による情報圧縮」(ICMUP)として理解されるという考えの証拠を検討します。~」

*クラスタリングはスパースモデリングと同じ方向なのか.構造を意識したクラスタリングはスパースモデリングと異なり性能を向上させることもできるので少々異なるか.

*Juan J.Lastra-DíazaJosuGoikoetxeabMohamed AliHadj TaiebcAnaGarcía-SerranoaMohamedBen AouichacEnekoAgirreb(201910)

A reproducible survey on word embeddings and ontology-based methods for word similarity: Linear combinations outperform the state of the art

Engineering Applications of Artificial Intelligence

Vol.85 Page.645-665

https://www.sciencedirect.com/science/article/pii/S0952197619301745