これは何

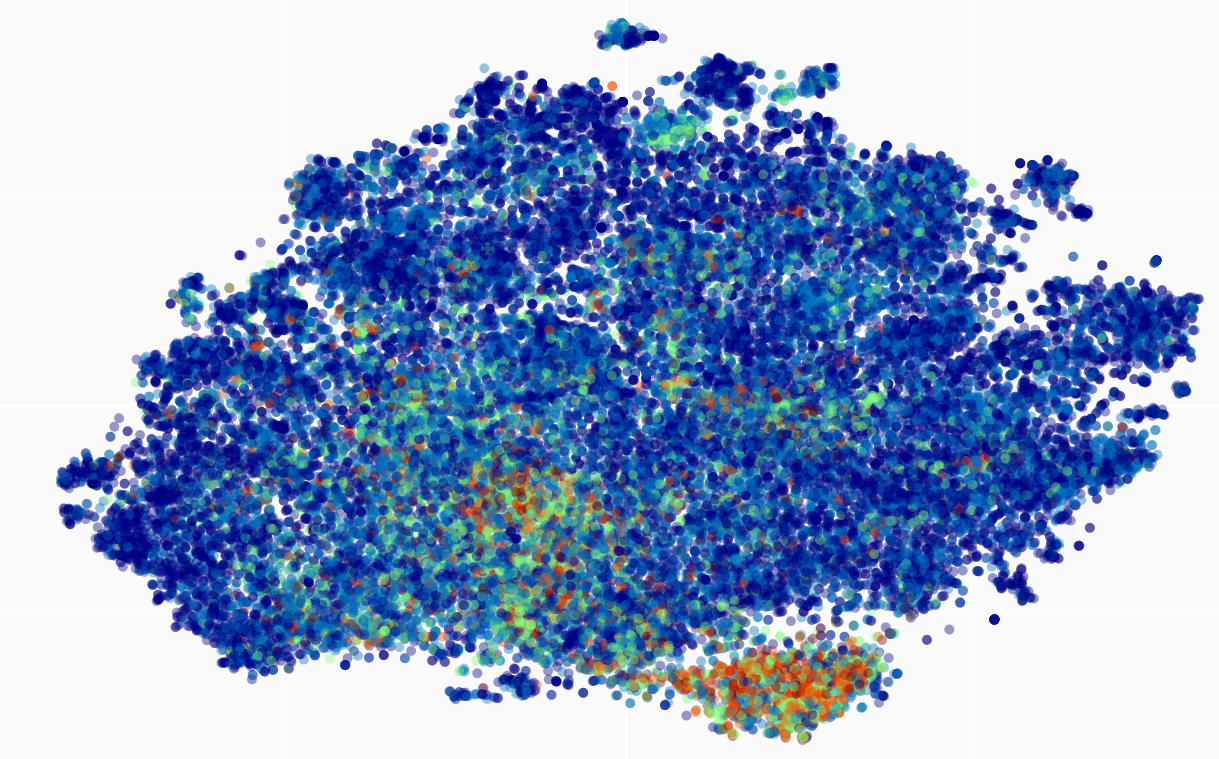

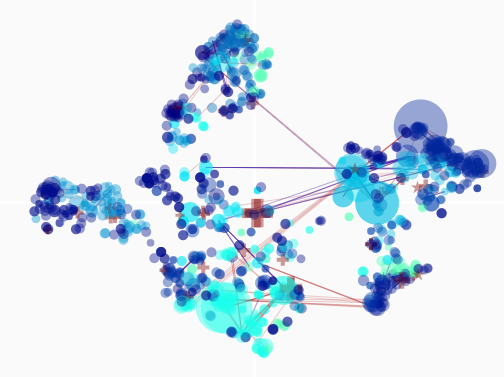

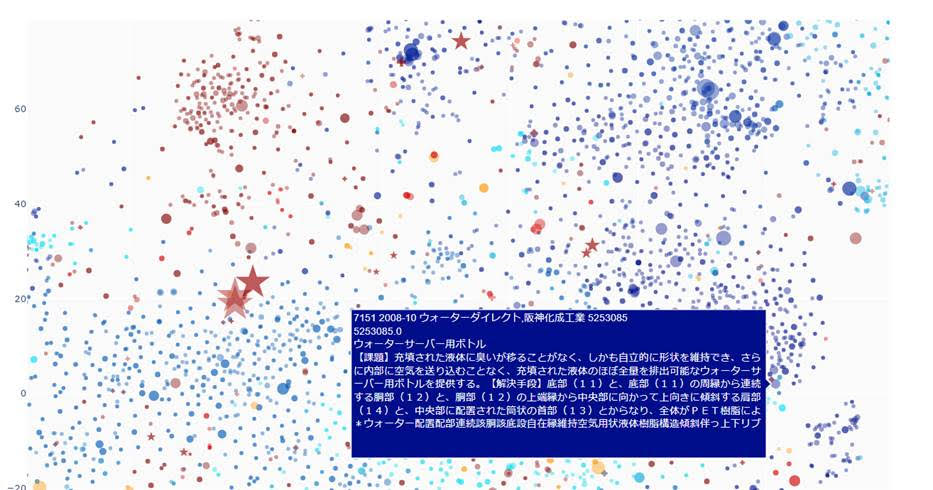

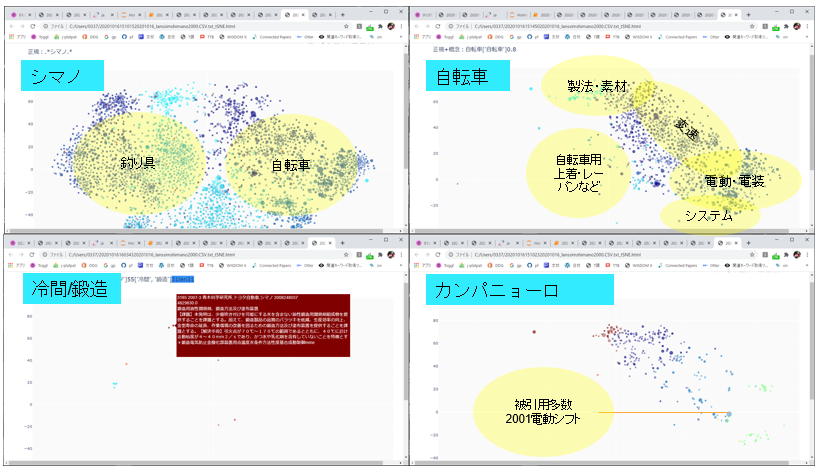

- 複数の特許等の文章を「特定の母集団における互いの類似度」を元に2次元空間上に配置し,インタラクティブに閲覧・探索的データ分析など行うコードです.

- クラスター解析による全体技術動向俯瞰に加え,個別確認,検索,技術要素等ネットワーク化,特許生成,様々な分析を行うコードと言っても良いでしょう.

- 重要な特徴は3点.

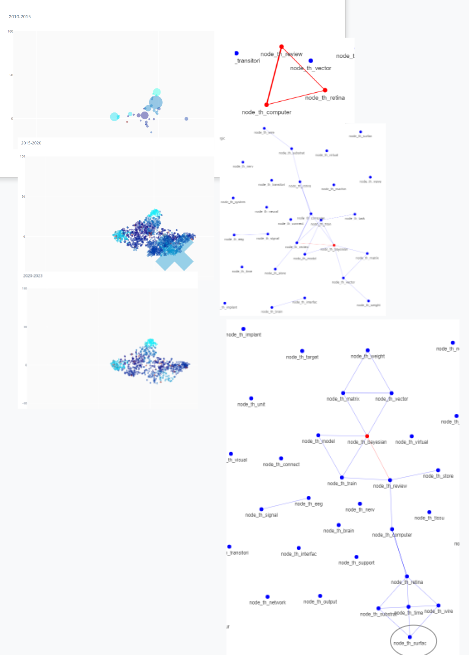

-- 俯瞰図で「特許間の相対的な位置」を把握し、

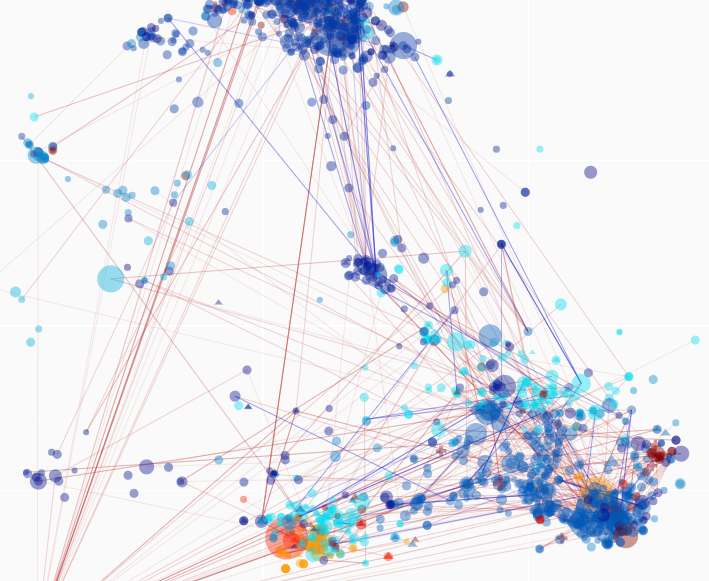

-- ネットワークで「要素間の具体的なつながり」を明確とし、

-- 特許生成で「存在しないデータの補完」をし、

基礎研究の特許などに基づく有望な応用開発の具体的例示とその稼ぎ方などのもととなる未来予測など行います

(技術ステージごとに異なる手法を用います。

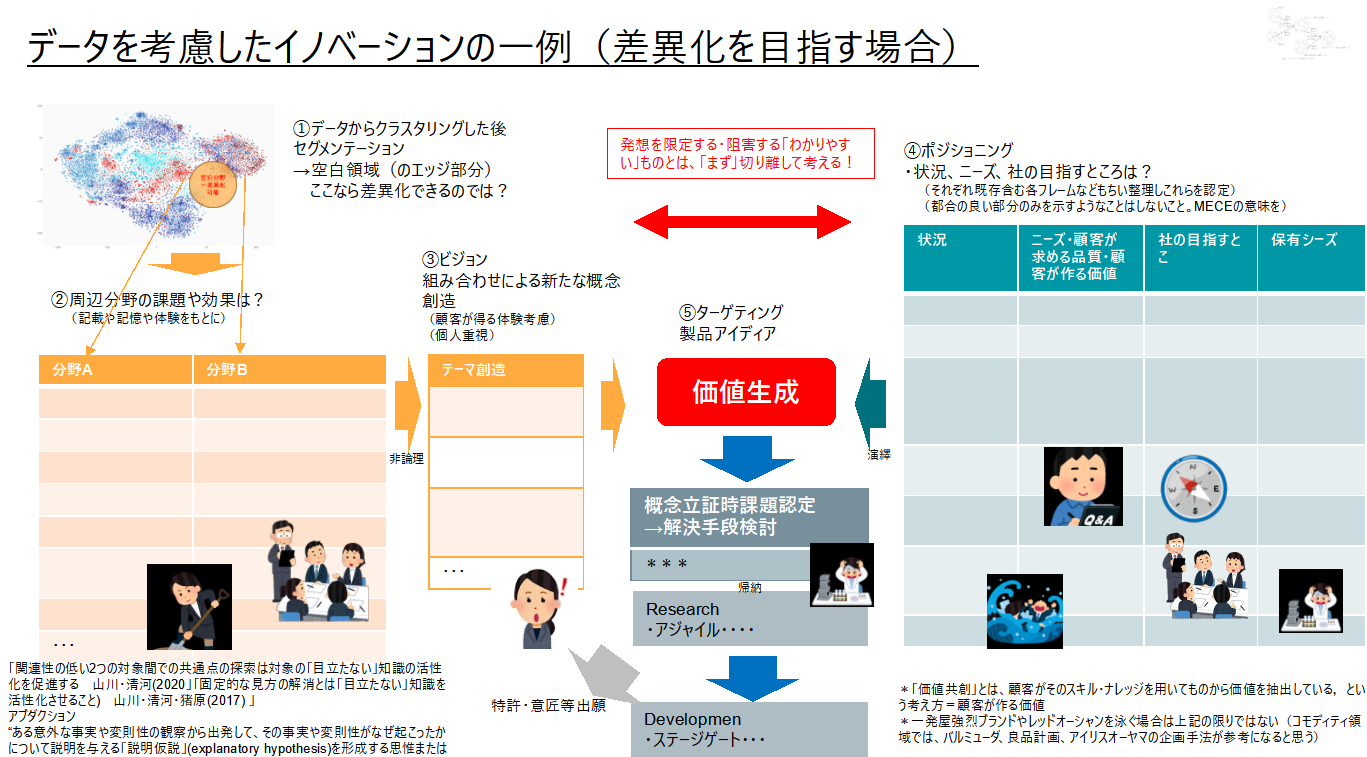

萌芽技術ステージや技術加速ステージでは、俯瞰図から確認可能な構造に基づくホワイトスペース・ブルーオーシャンの発生の確認とネットワークのエッジやノードの生成確認を行い、基礎特許などを抽出し、M&A探索やベンチャーの技術の立ち上がり探索や投資先探索を行います。

技術停滞期では、俯瞰図確認とネットワーク確認を行い、有望な応用特許などを抽出し、技術シフトのウォッチングやニッチ探索や大学などによる技術提携企業候補探索を行います。

技術衰退期では、俯瞰図確認とネットワーク確認を行い、コモディティによる技術の無意味化と出願価値の喪失を見極め、不要技術の選別を行い、技術開発からサービスなどへの移行判断や別技術への投資切替判断などを行います。

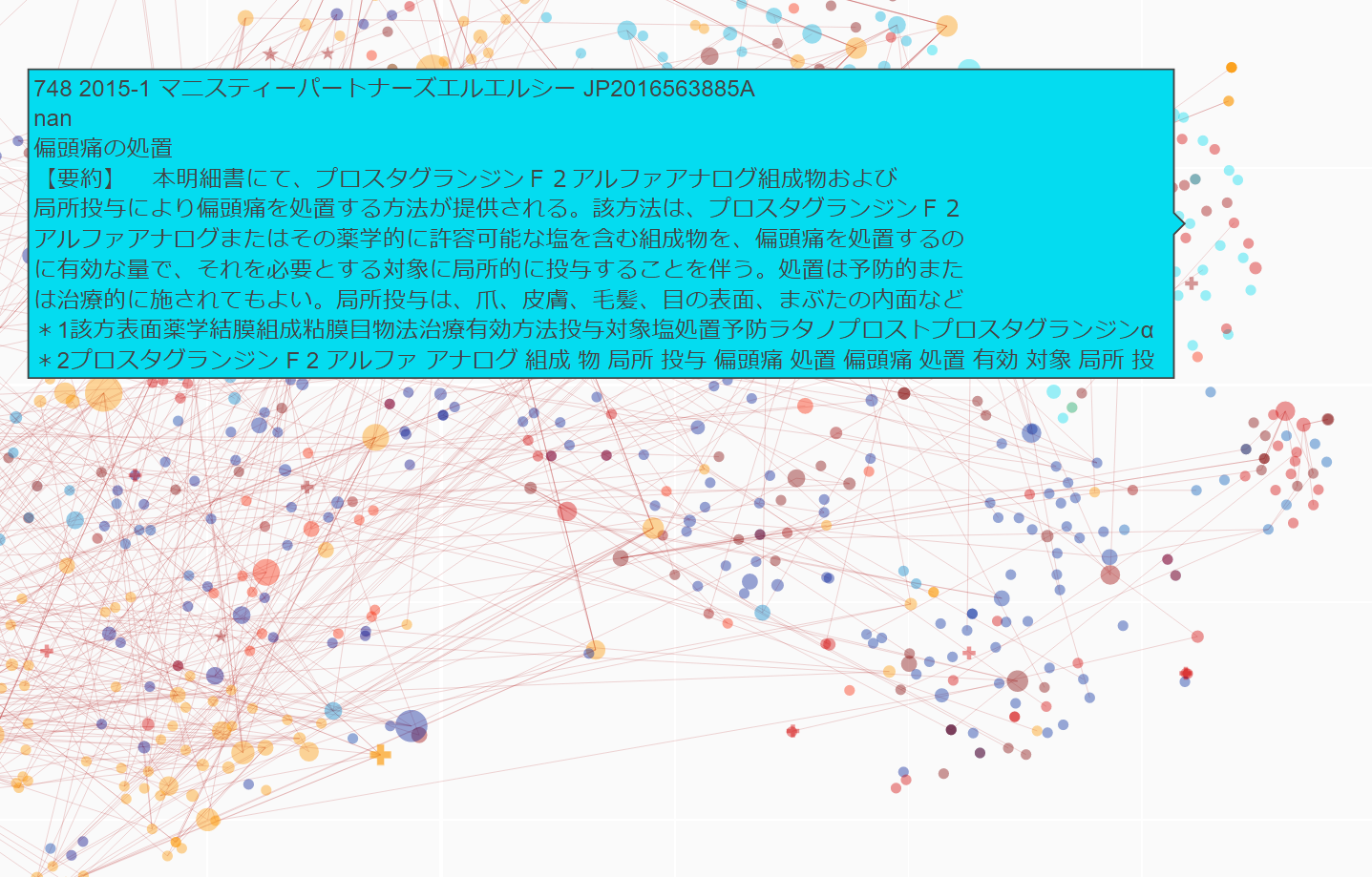

それぞれの時期において、ホワイトスペースやクラスタの境界やエッジなど、特定の座標に価値を見出したなら、座標を用いた特許生成を行い、目的領域で「価値のあるアイディア」の具体化などを行います。). - マウスオーバーでそれぞれの特許の概要を見ることができ,Google patentで該当の特許を開くことができます.

- 工夫次第で様々な目的・用途に用いることができるでしょう.

- 文章はベクトルとして扱います。様々な文章ベクトルの生成方法がありますが、基本的には、Compositional Distributional Semantics (CDS),文の統語構造を考慮した語の意味ベクトルとなるように, 文章ベクトルを生成しています。transformerが局所的な分布仮説をattentionで拡張しているイメージとするならば、本手法は母集団に限定した分布仮説を、attentionでは避けがたい主観的な文脈をできるだけ使わずに客観的な文脈のみを、計算言語学(統語、tfidfなど統計)という演繹を利用することで拡張しているイメージです。

追記メモ

-

追記を繰り返しており整合性も取れておらず非常に読みにくい状態です.近日中に再整理します.

-

技術だけではなく方法論が重要となります。後ろ向きに検証し、前向きに予測することが重要となるでしょう。現在検証中です。

-

お題をいただけますと助かります。後ろ向き検証ではどうもわかりきったものを恣意的に選んで言えるかもしれない危惧があるところです。

-

個人的には、会社の方針に追従する結果を出すだけのご機嫌伺いのようなデータ分析に非常に大きな危機感を覚えており、データサイエンスはまず現場のものであるべき、今一度舵を切り直すべき、と考えております。

-

事業の方向を決めるに、特許分析のみではたりないことは自明です。ホワイトスペースは基礎特許が取れるという目指す方向の明確化はできますが、ノイズだらけであり、その範囲の中で具体的に期間を指定して成功するスペースがどこになるかは見えません。人金の動きを見て確度高く予測する方法もありますが、特許の課題をGPTなどで再構成し、それによりグラウンドの情報を課題に付与し、その課題の伸長を確認し、ノイズを減らす手法もあります。統合的に判断すると良いところ、その構造化も行っています。

-

できうることを現状まとめると次の通り(検討中)

既存コモディティ分野における成功確率の高い方向の示唆

既存分野維持向き.ゴミ貯めから,事業課題の推移と立ち上がりの特定

済) 「要素」ネットワーク時系列分析

検討中) 前向き分析・予測

新規分野参入における重要特許の迅速抽出

投資・スタートアップ向き,重要なイノベーションの特定,知財リスクの特定

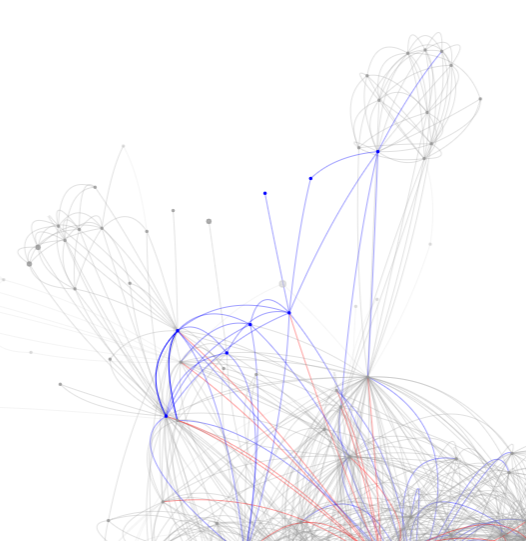

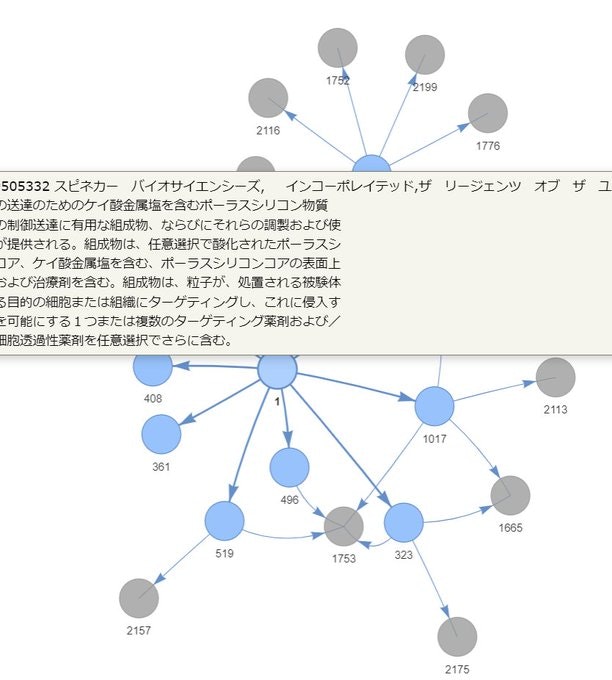

済) 「特許引用」ネットワークの分析

済・検証中) 後ろ向き分析

関連企業動向分析

バッティングしない方向や,力を入れるべき方向,競業候補の特定,ブランド影響力

済) 注力領域の可視化

保有技術の活用

保有技術の応用先の探索

済) Clarivateの手法

検討中) 課題を利用した手法は可能

済) 具体的なキーワードが用いられていない類似領域で別用途を探すも可能(キーワード含まない&概念検索で具体特定されていない分野を抽出)

全分野における今後伸長する分野の特定

対象外.

※なお、現在は、技術発展と衰退のサイクルの軸において、そのどこに注目技術や企業が位置しているか配置し、配置ごとにどのような対応が有効かのテンプレートづくりをしており、テンプレートが完成し次第、軸を増やし機械学習に落とし込むことを模索しています。具体的には、コモディティからの対処法の予測システムを作っています。

- 文章の類似とは、一義的に決まるものではありません。多元的なものであり、視点によってどのような類似が必要か規定されます。

本手法では、それぞれの特許等の文章は、その目的、視点に応じた任意の複数の手段でベクトル化されます.作成されたベクトルは目的に応じ再構成されます.

(ベクトルに対し目的に応じ様々な肉付けや補正を行います.より一般化させたいならCLIPから得たベクトルにより肉付けをします.より特許分類を考慮したいならCPC分類問題をArcFaceなど距離学習や対照学習にかけ補正します.その他debiasingをする場合には任意の中立化による投影や均等化による距離補正を行い補正します.より特定のドメインを考慮したいならそのドメインで学習したモデルから得たベクトルにより肉付けをします.ホットな特許領域を抽出したいなら引用グラフと文章ベクトルを用いGraphSAGEから得たベクトルを利用します.CNN, RNN, transformerなどアルゴリズムの利点と欠点を考慮して採用します.医療用語ならJaMIEやMedNER-Jを流用するなどありえます.この他、何らかの全体最適化をすることが好ましいです.

補正参考:

ごくシンプルには次の通り

def neutralize(word, bias, vec_map):

e = vec_map[word]

e_biascomponent = (np.dot(e,bias)/(np.linalg.norm(bias)**2)) * bias

e_debiased = e - e_biascomponent

return e_debiased

)

ほか

・水木栄 岡崎直観

埋め込み表現の意味適応による知識ベース語義曖昧性解消

https://www.anlp.jp/proceedings/annual_meeting/2023/pdf_dir/C3-1.pdf

・OpenAI の Embeddings API はイケてるのか、定量的に調べてみる

https://qiita.com/akeyhero/items/ce371bfed64399027c23

・Discovering Universal Geometry in Embeddings with ICA

https://arxiv.org/abs/2305.13175

各種言語や画像モデルの埋め込みに共通する意味の独立成分を可視化など

・Nonparametric Bayesian Deep Visualization

http://chasen.org/~daiti-m/paper/ishizuka21npdv.pdf

・複数のベクトルが必要、≒元の高次元情報からどの情報を取り出すか、という考え方は、例えば、次元圧縮に注目すれば、次のようにも収束されるのでしょう。

・Dynamic visualization of high-dimensional data

https://www.nature.com/articles/s43588-022-00380-4

https://www.biorxiv.org/content/10.1101/2022.05.27.493785v1

・Deep TDA: "Why you should use Topological Data Analysis over t-SNE or UMAP?"

https://datarefiner.com/feed/why-tda

・Semantics in High-Dimensional Space

https://www.frontiersin.org/articles/10.3389/frai.2021.698809/full

・高次元空間の意味論

・高次空間の空白について,平均から類似を見るのではなく,発明文書生成とした理由の一つ

・1から座標-言語モデルを作成し発明文書生成した場合と,GPT4など高度な言語モデルに座標アダプタをつけて発明文書生成した場合とで,何が異なることになるか興味深い.母集団以外から技術常識を持ち込み補完しつつ生成された発明文章はより大きな価値を持つのか,それとも技術常識そのもとなるなどしてより小さな価値となるのか

・次はとても興味深い.

「・意味論的空間は、グローバルな構造ではなく、そのローカルな構造と近隣の観点から見ると興味深いものです。

• 意味論的空間に対する操作や、そのグローバル構造に影響を与えるような意味論的空間の操作や変換は、有益になる可能性は非常に低く、計算の点で無駄である可能性が非常に高いです。」

・Automatic Data Curation for Self-Supervised Learning: A Clustering-Based Approach

https://arxiv.org/abs/2405.15613

データ一様化にk-means〜

・NV-Embed: Improved Techniques for Training LLMs as Generalist Embedding Models

https://arxiv.org/abs/2405.17428

今ひとつ性能が低かったLLM、decodee embeddingの改良。

transformerベースのembeddingはencodeeもdecoderも素直じゃない印象ですが、双方改良が試みられ続けています。

・招待講演2: 今井むつみ先生 (慶応義塾大学)

タイトル: 言語習得に記号接地は必要か

言語処理学会30周年記念シンポジウム

知識を選択する機能である知恵がアブダクション?

知識選択モデルとを組み合わせることで創造性の説明ができることを踏まえるに面白いな。

・ジョブスの述べる知性 1982

https://m.youtube.com/watch?si=lzbF1DfhLzeRzI4V&v=ymbD_a-G1IQ&feature=youtu.be

「 多様な経験と創造性:未来のために考えるべきこと

知性と視点

講演者は、知性とは「ズームアウト」して全体像を見る能力であり、細部に囚われずに大局を把握する力だと述べます。賢い人々は、他人が気付かないような明白な解決策を見つけることができ、そのために時折罪悪感を感じることがあると説明しています。

イノベーションと経験の多様性

イノベーションを生み出すには、異なる経験を結びつける能力が必要です。一般的な道(高校から大学へ進学するなど)を歩むだけでなく、詩人として数年間を過ごしたり、異なる文化や背景を持つ人々と交流することで、新しい視点を得ることができます。ウォルト・ディズニーが一度LSDを使用し、「ファンタジア」のアイデアを得たという逸話も紹介され、多様な経験が創造性を刺激することが強調されています。」

個人的はそのとおりと思いますね。

昔からイノベーションの答えが出ていると思います。

現在では、意味空間という演算可能な空間があり、「その高分次元空間を「高次元のまま」覗く俯瞰窓」を作れます。

適切な技術を使えば、人の記憶に頼るしかなかった1982より、再現があり客観的に、イノベーションを起こすことができるはずです。

個人的には、俯瞰ツールを分類ツールやわかりやすい見える化ツールとして使っているうちは、どうにもならんのではと感じています。

・論理的思考については原始人も現代人も違いはないとも言われているところ、結果としては差があるようです。なぜかと言われれば、個人的には、知性の問題だと認識しています。

ロジカルシンキングは論理的思考とMECEからなりますが、原始人にできていないのはMECEでしょう。

人間は通常7つしか物事を把握できないと言われているところ、漏れなくダブりなくのMECEも人間の自然な能力に従えば7つ程度しか検討しなくなるでしょう。しかし、現実の要素は数百を超えます。人間の自然な能力ではMECEを達成できないのです。原始人の限界です。

どうしてきたか。原始人は記録手段を持たず、網羅的な検討ができませんでした。そこをスタートとして、文字を発明し記録し、記録を保管するようになり、記録を整理し網羅図として作成しその構造から知識を得て、高次元科学の考え方を採用し、より複雑なMECEを扱えるようになってゆき、現代人の判断に至っているわけです。

知性とは網羅俯瞰能力であるところ、MECEとはいわば、知性を表す指標ともできるでしょう。

記録もしない口頭伝達レベルでは現代人でも原始人と同じ程度の知性しか持てず、網羅俯瞰できる技術を使えば現代人の知性を持てるようになる、と言ってよいでしょう。

ここで紹介するような網羅俯瞰図は、原始人の判断から逃れ、より高度な知性を持つための、知性向上ツールといっても面白かもしれません。

・高次元データセットに潜む幾何構造と深層学習 : その解析と大自由度力学系への応用

本武 陽一

https://repository.dl.itc.u-tokyo.ac.jp/records/48134

・Zipf 白色化:タイプとトークンの区別がもたらす良質な埋め込み空間と損失関数

横井 祥

https://speakerdeck.com/eumesy/zipfian-whitening

個人的には,白色化等しない構造が多少のアルゴリズムの差はあろうとデータに対し正しい構造といえるところ,白色化等を行うと疑似的なクラスタリングが行われることにより構造が「単純化され」「既存」タスクに適合的となる,というイメージを持っています.そのため特定の目的が無い場合には白色化等は危険なのではと.(構造のゆがみの原因を研究してはいません)

タイプ(単語の種類)とトークン(単語の数)の違いを考慮した埋め込み空間の補正は,ちょうど本記事のtfidf etc embeddings cluster reconstructing visでやっていることであり,興味深かった.意味と頻度(多ければよいわけではなく,低頻度の一部が重要),タイプの補正を行った,でとらえた埋め込み空間はやはり良いのだろう.

白色化等を行うと~と記載したが,資料と自分の考えは同じ方向であるように見えた.

word2vecは低頻度語を考慮するため下手したら最新の埋め込みモデルより足し算の結果が良いことがある(経験的にもその通りでした。なのでいまだにword2vecベースでのベクトルを使っています。)

対照学習も低頻度語を考慮する?

頻度考慮の白色化を

ドメイン母集団に特化したほうが性能が上がるってのもtfidf etc embeddings cluster reconstructing visでやっていることですね.やってきている方向は正しいようです.

文の頻度については,文とは単語のタイプの一形態であり,「意味という空間」におい単語と同じでありて同一の次元数で表現されるべきもの,つまり文と単語は見分ける必要はない,と認識しているますが,もう少し考えてみる必要があるかもしれません.

・Discovering State Variables Hidden in Experimental Data

https://arxiv.org/abs/2112.10755

画像からの内部次元の予測と隠れ状態変数の利用

母集団ごとの説明次元の出力を組み込んでおくと解釈のベースができ面白いかも

・言語モデルの内部機序:解析と解釈

Benjamin Heinzerling 横井 祥 小林 悟郎

https://speakerdeck.com/eumesy/analysis_and_interpretation_of_language_models

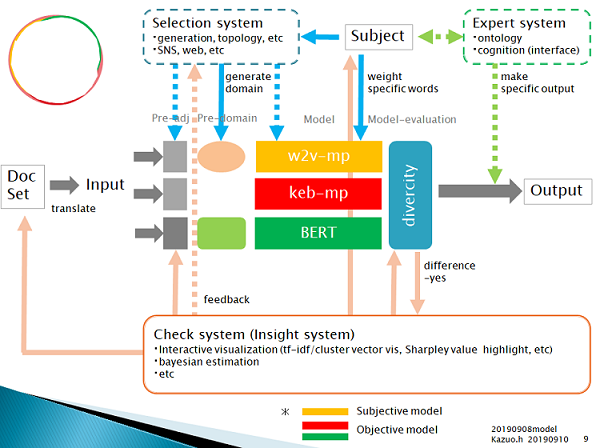

上図はつまり、このページで試行していることです。

上図ではサブネットワークを作ってから接続しています。

ネットワーク理論で述べられる、「フル接続ネットワークは性能が低い、サブネットワーク間の接続という形のネットワークの性能は高い」、というやつですね。

(なお個人的には、部署間のサイロを解決させることによる業績向上は、サブネットワークが形成されておりかつどこまでやってもサブネットワークが破壊されるほどのフル結合とはならない大企業ではうまく動く気はしますが、サブネットワーク=専門化が不十分なところフル結合になりやすい中小企業では逆に、部署間の垣根を無くせば専門性の低下と業績低下につながるのだと思えています。まあつまり、小規模言語モデルではこうはゆかないのだろうな、と。)

・The Geometry of Categorical and Hierarchical Concepts in Large Language Models

https://arxiv.org/abs/2406.01506

「線形表現仮説(Linear Representation Hypothesis)」 に基づき、

バイナリ概念(例: 男性⇔女性)は、LLMの表現空間内の直線方向として表現される 階層的関係(例: 動物 → 哺乳類 → 犬)は、表現空間内で「直交する」関係としてエンコードされる カテゴリ的概念(例: {哺乳類、鳥類、爬虫類、魚類})は、多面体(polytopes)として表現される

という知見が示されている。

シンプルにX軸が階層の主要素、y軸が同一階層の種類の主要素、となったと理解してよいのか? tfidf cluster visで特許を母集団とした際には、X軸か機械・生物のバイナリの主要素、y軸が機械の複雑さや生物の複雑さ、で図示できることが多い。

これは次の示唆があるともいえる。

・第一の主要素について数値を増減することにより、階層を変更した結果が得られる(X座標操作で階層変更ができる)

・第二の主要素について数値を増減することにより、その階層における複雑さを変更した結果が得られる(y座標操作で複雑さ変更ができる)

・x, y ,z軸からなる構造を探索することにより、特定の結果が得られうる(例えば、特定軸を固定した際に見られる円錐がブルーオーシャンンの新規事業を表す、など)

・単語分散表現のなす幾何的配置と単語共起行列の もつ内部構造の分析

前田晃弘

https://dspace.jaist.ac.jp/dspace/bitstream/10119/18344/5/paper.pdf

(1) 幾何学的配置の発見

単語ベクトルは、意味関係に応じて特定の幾何構造(平行四辺形、正四面体、五角形など)を形成する。

特に、類推関係(King - Man + Woman ≈ Queen)は、平行四辺形の性質を満たしている。

(2) 数学的解析

単語共起行列はテンソル積を用いて表現可能であり、言語の分布構造が線形代数的に記述できることを示した。

平行四辺形を形成するための必要十分条件を導出し、単語分散表現が持つ線形性の起源を数学的に説明。

「従来のベクトル空間モデル(VSM)や分布仮説(distributional hypothesis)を超えた、より構造的なアプローチ」

個人的に興味がある方向はこれ。

これにより、いわゆるQA形式の生成AIではたどり着きがたい、成功する新規事業などの、IPランドスケープに関わるゴールにたどり着けると考えている。(例えば、成功する新規事業という意味は、シンプルには、特定の軸を設定したうえで見つかる円錐形の構造として抽出可能だと仮定し検証しているところ。少なくとも試した数例においては正しい。)

・部分空間の擬似直交性によるTransformer 言語モデルの内部表現の解釈

https://www.anlp.jp/proceedings/annual_meeting/2025/pdf_dir/P2-12.pdf

・独立成分分析による事前学習済み多言語モデルの層を横断した単語埋め込み表現の分析

https://www.anlp.jp/proceedings/annual_meeting/2025/pdf_dir/P2-15.pdf

ICAによる解析は興味深いところ

・TrendScape 1.0: 言語モデルの潜在空間上の概念探索

https://www.anlp.jp/proceedings/annual_meeting/2025/pdf_dir/P2-25.pdf

?埋め込み表現のネットワーク化は以下のようにtfidf cluster visでも行っているし、そう珍しい方法でもないと思う。相違点は?

「提案するアプローチは 5 つの主要なステップから構成される.

まず,入力は潜在空間における埋め込み表現と整列され,格納される.

次に,探索空間のサンプリングが行われ,例えば概念 A から概念 B へのベクトル空間の関係が抽出され,それがネットワークに構造化される.

続いて,探索空間を再サンプリングしながら,パスの周辺を探索する.

最後に,空間内の関係が再構築され,可視化される.」

「Trendscape 法は,単語埋め込みを基に作品間の概念的な「道筋」を可視化する本研究の核心的手法である.その適用は以下の 4 つの主要ステップで構成される:」

「1 探索空間の構築:二つの作品(source と target)間の概念的橋渡しとなる単語群を特定するため,“word2vec-google-news-300” の’closer_than’ メソッドを用いてサンプリングを行った.このメソッドは,source と target の両方に「近い」単語を効率的に抽出する.さらに,計算効率と多様性のバランスを取るため,サンプリングした単語群からランダムに500 語を選択し,初期探索空間とした.」

2つの作品の主要共通?単語を取り出してそれで比較すると。共通しない単語も抽出するのか?

「2. ネットワーク構造化:抽出された単語群の関係性を構造化するため,scikit-learn ライブラリのAgglomerativeClustering を用いて階層的クラスタリングを実行した.クラスタリングの結果に基づいて単語間にエッジを作成し,その重みをコサイン類似度の 2 乗として設定した.この手法により,意味的に近い単語同士が強く結びついたネットワーク構造が形成された」

単語ベース?クラスタで類似度を得て単語ノード間エッジと重みに?

「3. 経路探索:構築されたネットワーク上で,sourceから target への最短経路を探索した.この過程では,networkx ライブラリの最短経路アルゴリズムを基本としつつ,意味的な関連性をより重視するため,独自のヒューリスティック関数を実装した.具体的には,各ステップで top-k(k=3)の候補を考慮する確率的な探索を行い,局所的な最適解に陥るリスクを軽減した.」

作品間で共通していない単語ノードと共通している単語ノード含めた経路探索?

「4. 結果の統合:探索の安定性と網羅性を高めるため,上記のプロセスを複数回繰り返し,得られた結果を統合した.最終的なネットワークは,pyvis ライブラリを用いて可視化し,概念間の関係性を直感的に理解できるよう工夫した.」

「これらのステップを通じて,作品間の概念的な架け橋となる単語の系列を特定し,その関係性を視覚化することに成功した.」

うーん、全ネットワークを作って、作品との近さでネットワーク再形成する手法じゃダメなのかな。作品間の関係を明確に観察するにはノードの色分けで判断できるこちらのほうが見やすいか。ただ、後付け処理はやりにくそうだな。うーん、作品と要素の類似性を後付けで計算し、ノードの色を設定したほうがより良いかな

・ベンチャー企業によるブルーオーシャン戦略の実施は効果があるか

https://cir.nii.ac.jp/crid/1050006275874652800

確かにブルー・オーシャンを発見し実行すれば足りる問題ではない。

・ブルー・オーシャン戦略による市場創造に向けた異常検知技術を用いた特許戦略変化の知識獲得

https://www.google.com/url?sa=t&source=web&rct=j&opi=89978449&url=https://www.jstage.jst.go.jp/article/pjsai/JSAI2023/0/JSAI2023_2L4GS302/_pdf&ved=2ahUKEwiYpIyNp5eMAxWzm68BHaZgBe0QFnoECCYQAQ&usg=AOvVaw0RpvRjPRljI7d8aXElE265

Local Outlier Factor(LOF) の使用による異常値検出と新規性や技術シフトの検出も面白そう。個人的にはこのようなスカラーでなく、より高次の幾何構造を持って検出する必要があるとは思う。

・Training Large Language Models to Reason in a Continuous Latent Space.

https://arxiv.org/abs/2412.06769

「そもそもAIは、なぜ言葉で考える必要があるのか?」

まさに。

個人的な見解

*個人的には,データベースはデータを入手するもの,分析・解析・探索ツールは自ら作るもの,と考えております.

自然言語分野では特に,Data analystであっても,Data scientistのように「データから未知をモデル化し理解する方法を自ら生み出さ」なければ,analystの目的である「データからインサイトを得て答えを出す」こともできない,と考えています.

(自然言語分野ではData analystとData scientistはほぼ同じと認識しています.)(常に構造を事前に決めデータベースなどに整理しておけるものではなく,「探索または分析時にリアルタイムに構造化する必要がある」と認識している.そのためにはリアルタイムにモデルを選択し使うまたはモデルを作る必要がある.といえばよいでしょうか? )

現時点において,「必要に足りるだけの自然言語処理技術を備えた探索ツール」は存在しておらず,古典的なテキストマイニング以上の探索を行いたいなら自らプログラムを組み作るほかない,と認識しています.

※「(発売に関し規制が厳しいので)開発者自身にしか使えない道具が世界には山ほどある」とは納得する意見でした。

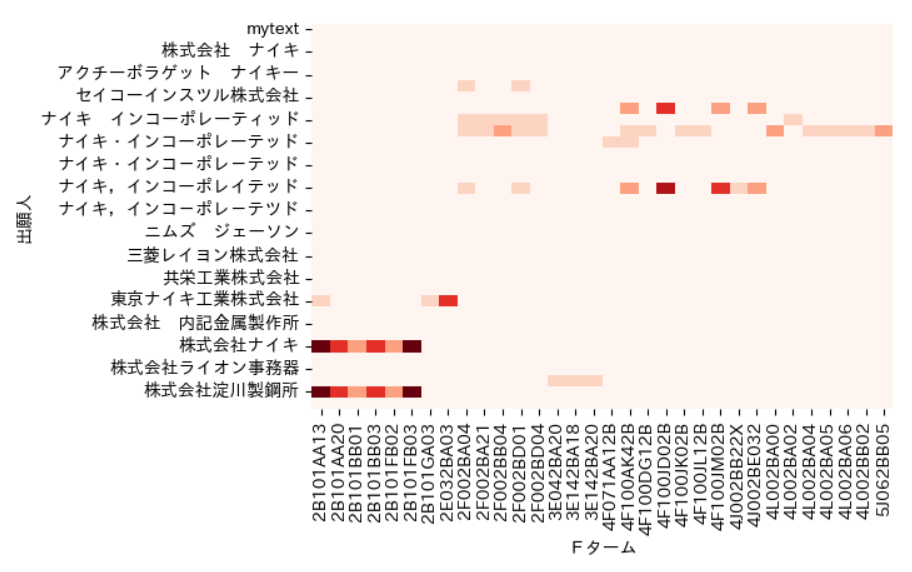

使用例1:キーワード検索でも分類検索でもない,第三の検索手法として

次のような記事を見つけたとします.

ナイキのDX,厚底内部と特許に見る速さの秘密,競合他社の対抗策は?

https://xtrend.nikkei.com/atcl/contents/18/00288/00002/

ナイキの厚底シューズ.どのような特許があるのでしょうか?

検索してみましょう.

J-PlatPatで検索.出願人:"ナイキ" AND キーワード:"シューズ" 0件

ナイキがシューズに関する特許を出願していないとは考えにくいです.シューズという用語を使っていないのでしょう(ツッコミ不要)

↓

tfidf embeddings/cluster visを使ってみる.

任意の検索ツールで検索.出願人(名寄せあり):"ナイキ"

(検索漏れが多くありますがここでは考慮しません.なお,名寄せがうまく動作していないようです)

ダウンロード

↓

ダウンロードしたファイルを指定し,コード実行

↓

5分ほど猫と遊びつつ待つ

↓

表示されたグラフを確認

・右上に板系のクラスタ

・左と下にゴルフ系のクラスタ

・右に通信系のクラスタ

・中央に「機能・材料・構造系」のクラスタ

があると確認された.

記事からするとナイキの厚底シューズは「機能的でプレート入り構造」であるようです.

該当する特許は,該当しそうなクラスタを考慮すると「中央少々上寄り付近」に存在しているでしょうか?

↓

別ウインドウで開いているインタラクティブHTMLをあさります.

期待通りの特許が,期待通りの中央上寄り付近で見つかりました.

↓

tab, enter

→Google Patentで目的の公報を開き,個別確認を行います.

このように,キーワードも分類も使わずとも検索することができます.

(その他,キーワードでの正規検索や分類検索,特徴検索など,pandasで可能な検索は全てできます.)

*下記記載にあるような,「キーワードでも分類でも難しい検索」をする際にはこの手法が向いているでしょう.

[知財塾]練習問題シリーズの種明かしと検索の難易度

https://note.com/sakaimisato/n/n512d162618b1

*基本的に縦軸横軸に意味はありませんが,

「呼び水」を使えば,「方向に意味」を付与できます

軸に認知できる意味をもたせることにより,任意の方向の検索がしやすくなります.

やり方は単純,目的の母集団に対し「軸としたい分類(など)のダミー集合」を加え処理し,ダミーを非表示とするだけです.

例えば,ある企業の製剤特許のうちキットに関わる製剤特許を抽出したい場合には,キットのダミー集合を加え処理します.すると,製剤特許のうちキットに関わる特許のみが他より離れて表示されやすくなります.その方向はキットを示す方向であり,その軸上にはキットの重さが表現されています.

ダミー集合には,個人的には特許分類を使うことが多いです.MeSHや遺伝子など他の分類でも良いでしょう.

全く関連のないダミー母集団を用いれば,広く関連する特許群が一つにまとまりやすくなります.ニュース記事の周りに関連特許を集めたい場合は,この手法を採用しても良いでしょう.

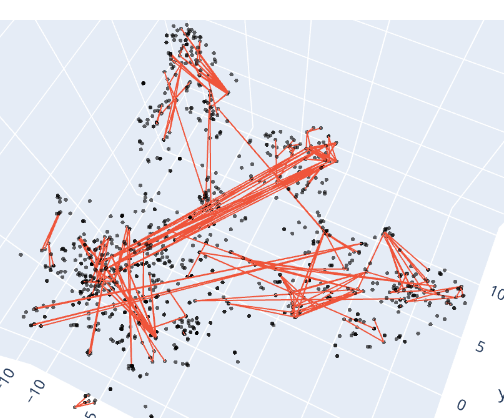

*明示的に1軸を任意の軸とすることもできます

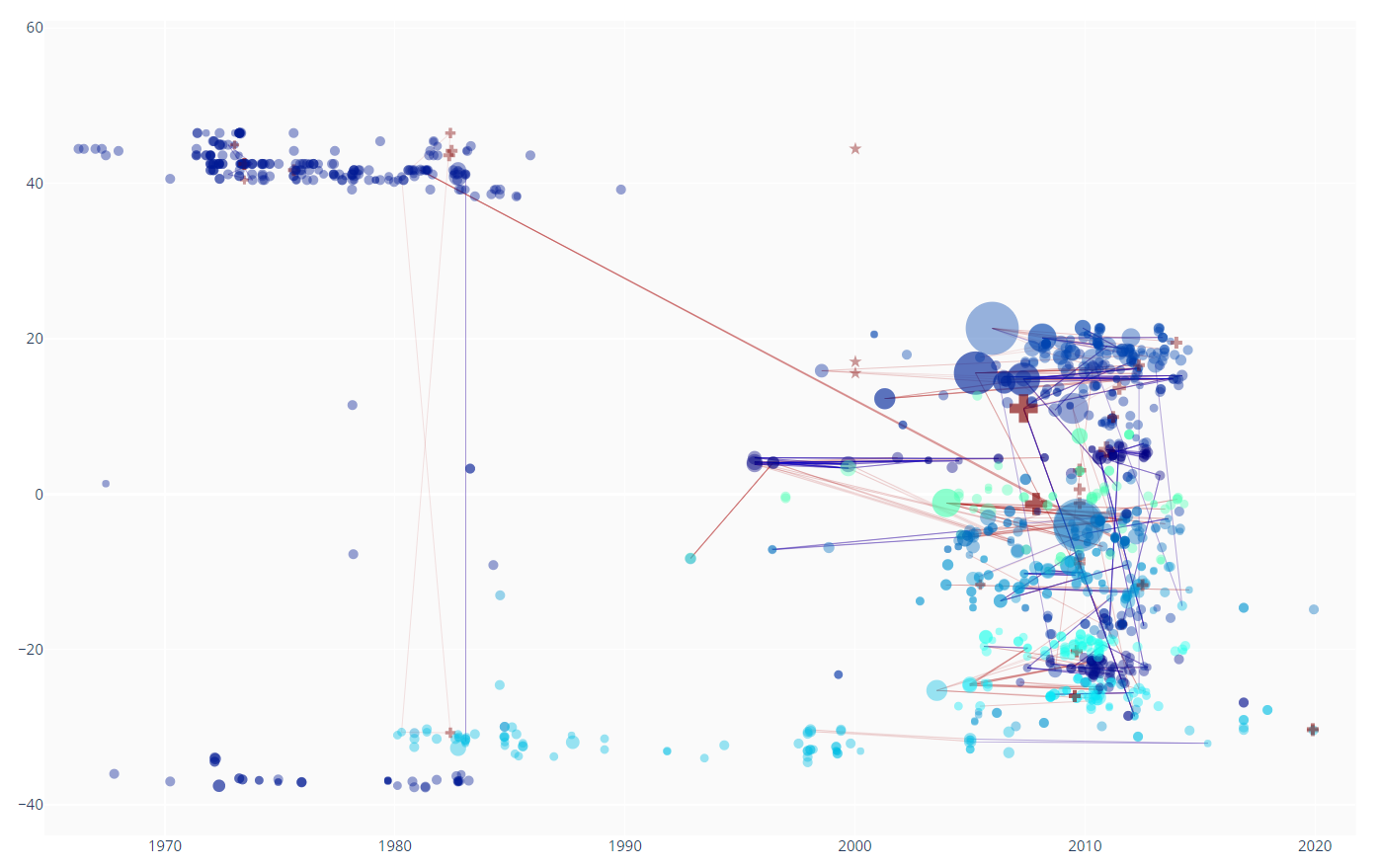

次は,x軸を時系列とした例です.

過去からの引用なのか,別分野からの引用なのか,など見やすくなります.

特定の企業の特許を母集団とした場合には,次のようなことがわかるでしょう.

被引用数が少なくとも,引用線が繋がっている最も古い特許は,その企業にとって重要な特許でしょう.

他分野に多くの引用線を伸ばしている特許は,その企業のコア技術に近いものとなっているでしょう.

SDIの母集団について適用すれば,原出願が古い≒分割が多く重要であろう特許,を抽出することもできます.

優先日付きの公開,通常出願等の公開,日本移行したPCTの公開,登録公報の公開,のはっきりした帯も見えますね.

母集団を登録公報に限定すれば,重要であろう,早期権利化した特許も見やすくもなります.

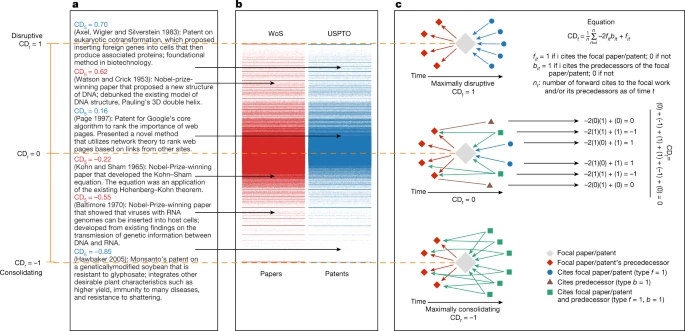

引用の解釈については様々な資料がありえますが、、次を読んでおけば良いでしょう

Papers and patents are becoming less disruptive over time

https://www.nature.com/articles/s41586-022-05543-x

※座標のコントロールには次のようなやり方もあります。

例えば脳の位置とあるキーワードを相関させたいとき。

そのキーワードの母集団の座標を得て脳の位置と合うように修正し新たな座標を得る、これを繰り返し、脳の位置とキーワードが相関した座標を作り、コレに基づき図示すればよいわけです。

市販ツールを使わない場合このような工夫はしやすいですね。

*処理対象は特許に限りません.単一性のある適度に長文のテキスト群であれば何でも良いです.

例えば

文献と特許を同時に表示した例:

ニーズ調査能力は大企業ほど高く有利となります.これを打ち破るには探索・解析,「変化プロセスの解明」からのニーズ把握が必要でしょう.特許・文献・ニュースを混合することにより,この解明はより容易になるでしょう.

(特許と文献では使われている用語の解像度が異なりますので,うまく統合できないこともあります.関連の低い呼び水を用いクラスタを圧縮する,CLIPを通し一般化する,文章生成モデルを介する,トピックモデルを用い粒度を荒くする,汎用モデルを通す,疑似対照学習により補正する,ネットワーク化し中心性の問題に返還する,本手法のみですが鋳型の大きさを小さくする,など行うと良いでしょう)(ドメイン特化した結果はモノの影を映すが,その影はモノ自体ではない.複数の影を用いてモノの形を再構成する.特許は長く伸びた影であることが多くニュースはそれら重心に近い影であることが多いところどう近づけるか.やっていることはまあそんなところです.)

小説の人気度と小説間の類似度の関係の例:

読みたい小説の内容をイメージし,そのイメージがどのトピックの組み合わせからなるか考え,トピックが俯瞰図上のどのクラスタと適合するか確認し,そのクラスタの周辺にある人気度の高い小説を選び,読む,なども面白いでしょう.キーワード検索で読みたい小説を見つけることは,人気作品のマネが多い分野では特に,かなり難しいですからね・・・

日本語NLPコンペ?参加記録: 小説家になろう ブクマ数予測 ~”伸びる”タイトルとは?~

https://qiita.com/kzuzuo/items/82ef280f9e6962eb00b2

目的、視点に応じた任意の複数の手段でのベクトル化の例:

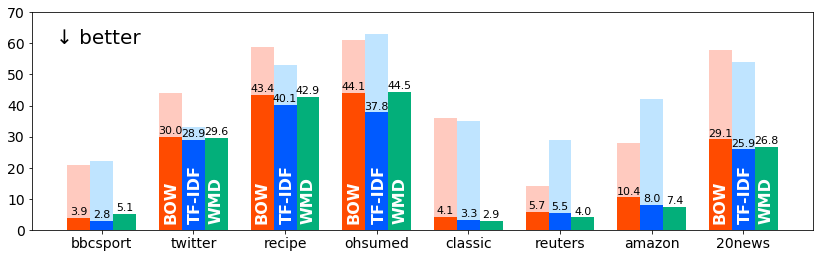

いくらかのベクトル化手法を紹介しておきます.

基本は,先のナイキの例を示すに当たり使用したベクトルです.

以下,tfidf embeddings cluster vecと呼ぶことにします.

トピックモデルでベクトルを作ることもできます.

以下,topic embeddings vecと呼ぶことにします.

BERT ベクトルは…置いておいて、

text-embedding-ada-002でベクトルを作ることもできます。

以下、text-embedding-ada-002 vecとします。

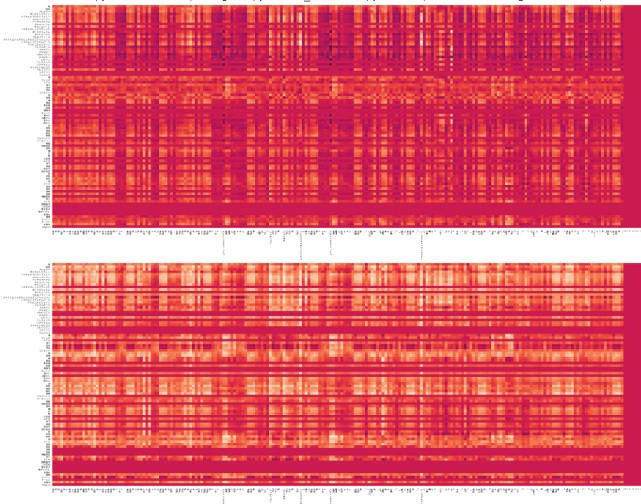

・ナイキの例 tfidf embeddings cluster vec(使用単語数調整)

使用単語数を変更したためクラスタが圧縮されている.

(可視化アルゴリズムのパラメーターは変更していない)

「フットウェアの運動能力感知システム」特許は,通信系のクラスタの近くに配置されている.

「センサーシステムを備える履物」特許と「(履物に備えられる)運動感知システム」特許は,離れている.

not表現の有無は同じクラスタに配置される.

発明それぞれを別に配置しつつ,否定や細かな表現は無視し同じクラスタにまとめます.頻度を考慮するので,文末の発明の主体が注目されやすくなっています.(複数の請求項が記載されていれば,文末の発明の主体を表す単語は自動的に多くなります)

特許文章を図示するにtfidf embeddings cluster vecは第一選択として理想的でしょう.

*一定以上単語数が少ない文章を右下の隔離したクラスタに配置しているため,全体としては歪んでいる.

・ナイキの例 topic embeddings vec

トピックモデルを使うと,クラスタが圧縮されやすい.

圧縮されすぎており全体構造を失い気味ではある(パラメータ次第だが).

前述通り,特許と文献を同時に確認する際など有用な場合もある.

後述する,クラスタの境界は認識し難い.

「フットウェアの運動能力感知システム」特許は,履物・機能構造系のクラスタの近くに配置されている.

「センサーシステムを備える履物」特許と「(履物に備えられる)運動感知システム」特許は,同じ場所に配置される.「ゴルフボール」特許と「ゴルフボールを製造する方法」特許は同じ場所に配置される.

同じ特許文章に含まれうる発明群を同じクラスタにまとめます.文章内の単語は等価値に計算されるので,文末の発明の主体が注目されることは特にありません.

*元のベクトルは文章の再構成をするイメージですが,トピックモデルは文章のトピックを追加します.

ここではLDAを用いました.LDAはスパースモデルとベイズ推定の組み合わせのようなものです.

・ナイキの例 tfidf embeddings cluster vec と topic embeddings vec を合成

合成するとバランスが良い場合もある

「フットウェアの運動能力感知システム」特許は,履物・機能構造系のクラスタの近くに配置されているが,トピックモデルよりより通信系のクラスタの近くに配置されている.

※トピックモデルよりICAで特徴要素を取り出したほうが,分散表現を考慮できてよいのかな,と思わなくもない.

Discovering Universal Geometry in Embeddings with ICA

https://arxiv.org/abs/2305.13175

https://nlp-colloquium-jp.github.io/schedule/2023-12-20_momose-oyama/

これって意味が大きいとされる大きなノルムの要素を取り出すのとどの程度の差ががあるのであろうか・・・回転させて解釈可能性を向上させる対応をもう少しして良いかなと感じた

*1次元増やすとこんな感じ

ああ,このクラスタの配置が難しいのね,この点が独立性が強いのね,などわかります.

2次元ぷろっとにおいて、もう少し情報がほしい、このクラスタの重なりに意味があるのかないのか、と感じたら、3次元プロットで確かめるのも良いでしょう.

・ナイキの例 text-embedding-ada-002 vec

https://openai.com/blog/new-and-improved-embedding-model

*発明の主体に注目するかどうかなどを任意にコントロール出来ない,ある程度上位概念での類似を一つのクラスタに圧縮したい,広範なテキストに対し事前学習しているため特定の母集団を指定して解析する際に類似したベクトルとなりすぎる、双方向でないアルゴリズムでは偏りが出やすい,などの理由により,あまり使いません.BERTベクトルも同じですね.ただし,将来的にはわかりません.

*OpenAI’s Embedding Model With Vector Database

https://betterprogramming.pub/openais-embedding-model-with-vector-database-b69014f04433

※PLaMoをベースにしたテキスト埋め込みモデルの開発

https://tech.preferred.jp/ja/blog/plamo-based-embedding/

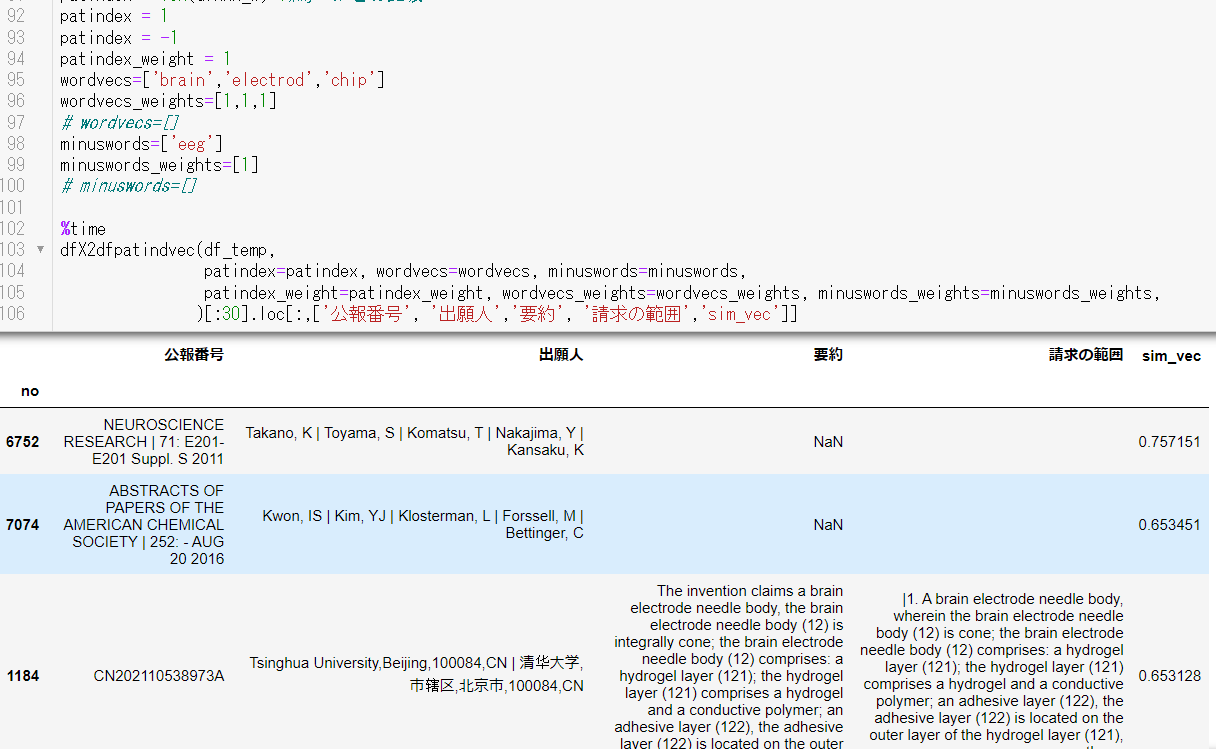

使用例1.1:単語レベルまたは文章レベルの概念検索 -概念の引き算・概念の重み付け検索- -文章群に対するChatGPT APIを用いた質疑応答-

ベクトルを用いた検索もが可能です.ここでは概念検索と呼ぶことにします.

概念は単語ベクトルでもよく,文章ベクトルでも良いです.

概念を引くこともできます.

概念に重みを付与することもできます.

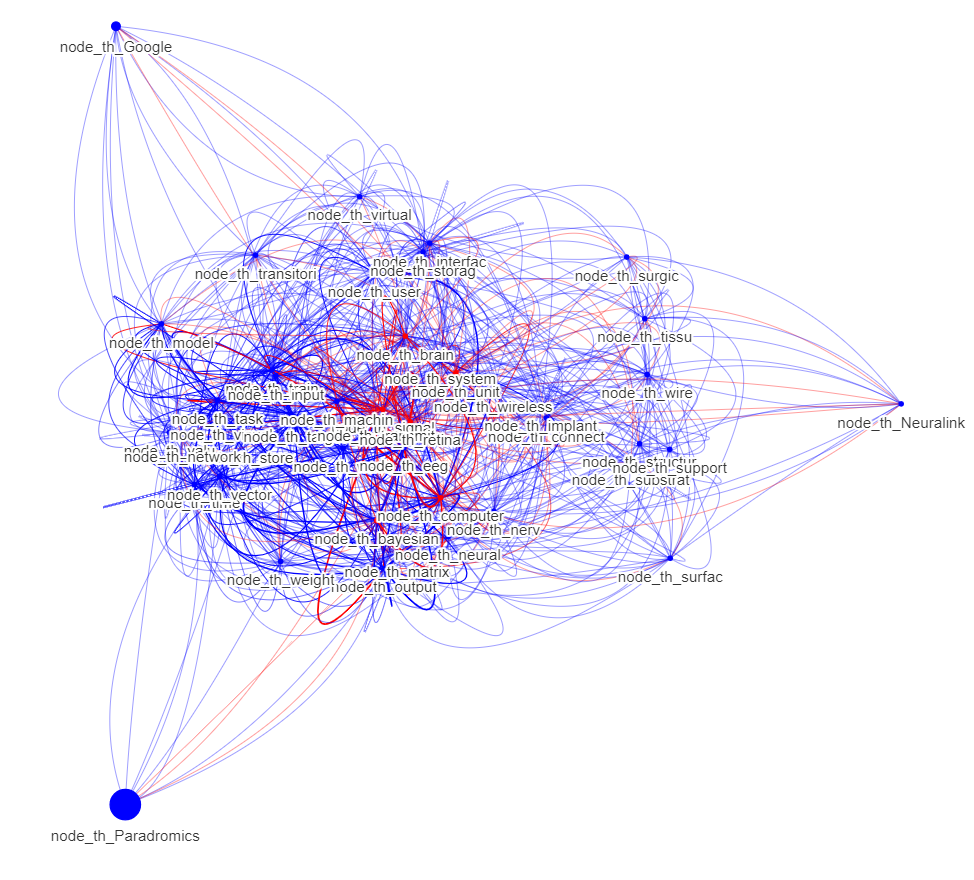

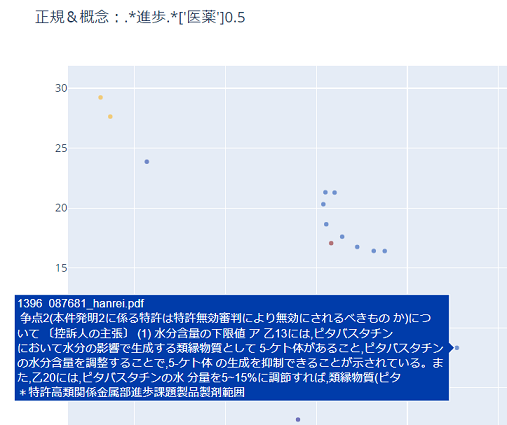

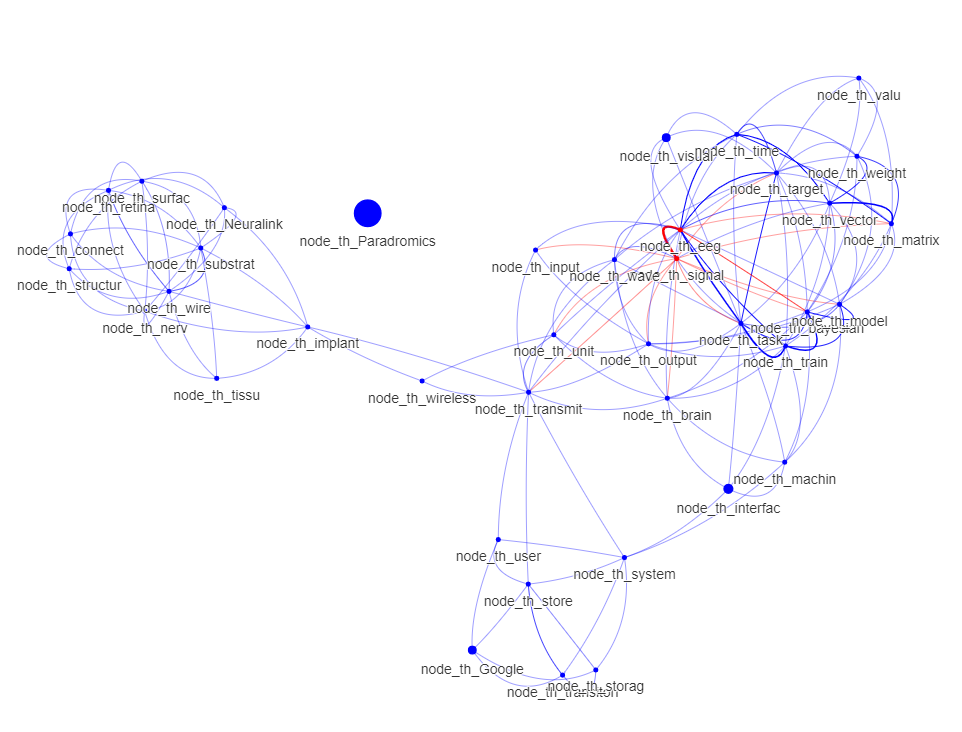

Brain Computer Interfaceに関する母集団に対し,

['brain','electrod','chip'] のキーワードを概念として与え,

['eeg'] の概念を引き,

概念検索した結果はこんな感じ.

sim_vecが概念との類似度です.

母集団中の特定の文章を概念として与え,

この文章概念に対し,特定のキーワード概念を足しまたは引き,

概念検索することもできます.

ある特許をベースとして,もう少しだけ特定の方向を考慮した特許を探したい,という場合に使うと良いでしょう.

使用例1で発見したシューズ特許に対し,軸に現れていない細かい方向,例えばシューズの重さについて加味した特許はないかな?という場合など.

戦略の探索時などよく使いますね.

(ある傾向群に付き平均を取り,この特許群の概念とこの特許群の概念の差は「戦略概念」を示すではこの特許にこの戦略概念を足したら?,またはこの特許群の概念とこの特許群の概念の差は「分野概念」を示すではこの特許からこの分野概念を引き別の分野概念を足したら?,同じ方向を試行している会社や個人を見つけ協働する,など検討し実践してみるのも面白いところです.)

(演算等で生成した概念からdecoderを用い文章生成もしたいところですね.欲しい特許が概念で表現できているなら,その文章は生成できます.例えば,「空白領域,未知領域,新規分野の概念を演算等により形成し,その空白領域等において例えばどのような特許を出願すべきか例示できるわけです」→使用例1.2へ)

概念ごとの重みを考慮して検索することも可能です.

1 * 'brain' + 2 * 'electrod' + 1 * 'chip'

って感じですね.

なお,いわゆるAIが行っている計算は,これをデータに基づき細分化して組み直したものと考えても良いでしょう.重み付けをきちんと設定し,検索できるなら,いわゆるAIより検索結果は良いものとなり得るでしょう

*同じくベクトル空間を扱うtext-to-imageでも重み付けは有用です.

0.5 * 'a girl' + 0.4 * 'winter' + 0.1 * 'summer'を,入力部分を少々改変したstable diffusionに概念として与えた場合に生成される画像は,

女性を中心として,雪景色のなか夏のように光は強く狂い桜が咲いている=冬日和

ってとこでしょうか.重み付けどおり画像が生成されたかと思います.

単語に重み付けをすることにより,文章そのものよりも要点を制御しやすくなるでしょう.呪文のように,文章からの要点抽出をブラックボックスと認知されるアルゴリズムに任せていては,要点の制御はし難いです(例えば,あるアルゴリズムは,文頭の単語を重視したり,色を無視するなど知られています.)

※FRONTEOのベクトル加算の考え方は,非常にシンプルだけど面白そうですね.

加算により評価値がどれだけ変化するか確認し,その加算した因子の重要性を評価するのも良いでしょう.

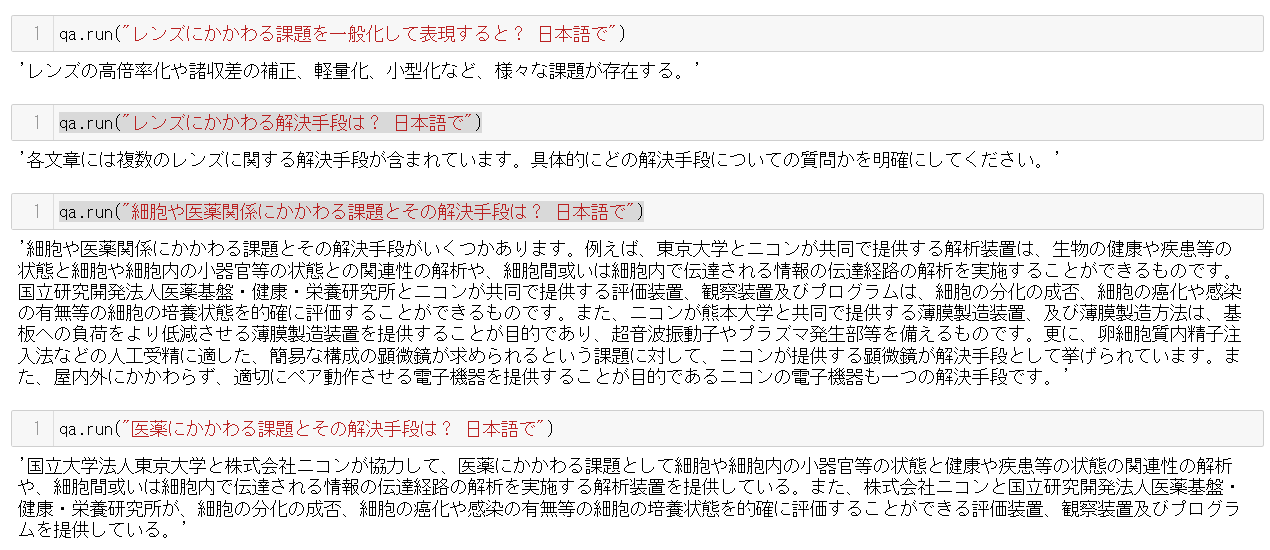

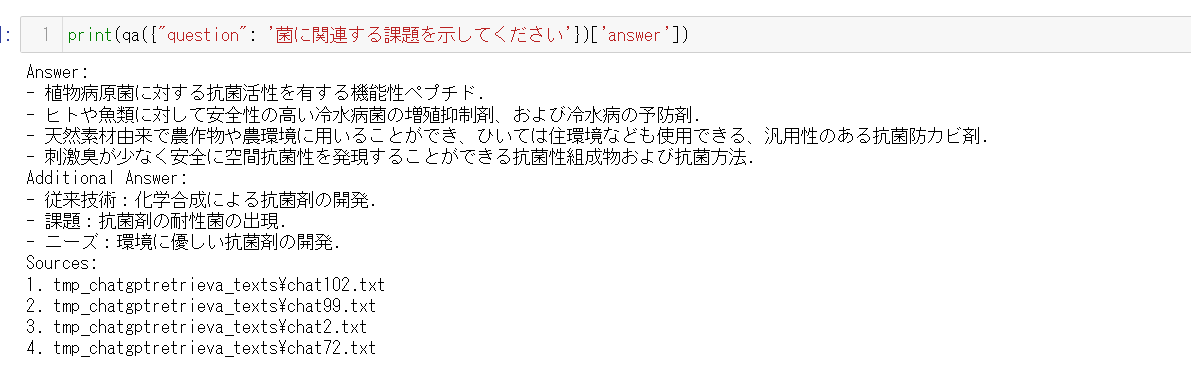

文章母集団に対するChatGPT APIを用いた質疑応答

検索により上位k件の特許を抽出し、その範囲に対してRetrievalQAを用いChatGPTによる質疑応答を行うこともできるようになりました。

https://python.langchain.com/en/latest/modules/chains/index_examples/vector_db_qa.html

「X社の特許でxに関する特許を100件求め、これらに対し,(分類が詳細でなかったり多分類にわたっていたり,キーワードが複数の表現で表されるなどの事情により,分類やキーワードで絞り込み難い事柄や、複数の言語や扱いづらい言語で記載されている事項)を,質疑応答により求める」

「tfidf visが強力に分散仮説を利用しており「単語が間違って使われてもまた省略しても」再現率高く検索しやすいのに対し、ChatGPTを使うことでそこまで強力な仮定をおかず「分散仮説は利用するがその文脈でその単語である場合にはやはりそのように解釈する」精度高く検索でき、意図的に相補的にできる」

など.すばらしいですね.

柔軟検索と呼びましょうか。

次のように呼ばれるようにもなっているようです

RAG(Retrieval-augmented generation)

自分が昔から欲しかった,解像度変換,いわゆる言い換えを含んだ検索ができる,ともいえます.

文章母集団に対するChatGPT APIを用いた質疑応答は,まだ改良中ですが,例えばこんな感じの短いコードで達成できます.

import shutil

from langchain.document_loaders import TextLoader

from langchain.embeddings.openai import OpenAIEmbeddings

from langchain.vectorstores import Chroma

from langchain.text_splitter import CharacterTextSplitter

import glob

from langchain.prompts.chat import ChatPromptTemplate, SystemMessagePromptTemplate,

umanMessagePromptTemplate

from langchain.llms import OpenAIChat

from langchain.chains import RetrievalQAWithSourcesChain

def df2ChatGPT(dfxxx_w, return_source_documents=0):

df = dfxxx_w.copy()

df = df.reset_index(drop=True)

df_text = '出願日:'+df['出願日'].astype(str) +' 出願人:'+ df['出願人'] +' 内容:'+ df['名称'] +' ' \

+ df['要約'] + df['請求の範囲'].str[:100]

filespath = 'tmp_chatgptretrieval_texts'

try:

os.mkdir(filespath)

except:

shutil.rmtree(filespath)

os.mkdir(filespath)

for i in range(len(df_text)):

tmp_df_text = df_text.iloc[i]

with open(filespath + f'/chat{i}.txt', mode='w', encoding='UTF-8') as f:

f.write(tmp_df_text)

files = glob.glob(filespath+'/' + '**/*.txt', recursive=True)

text_all = []

for i, file in tqdm(enumerate(files)):

loader = TextLoader(file, encoding='UTF-8')

documents = loader.load()

text_splitter = CharacterTextSplitter(chunk_size=400, chunk_overlap=0)

texts = text_splitter.split_documents(documents)

text_all += texts

embeddings = OpenAIEmbeddings()

docsearch = Chroma.from_documents(text_all, embeddings)

system_template="""Use the following pieces of context to answer the users question.

If you don't know the answer, just say that you don't know, don't try to make up an answer.

*箇条書きで回答してください.

Answer in japanease:

{summaries}

"""

messages = [

SystemMessagePromptTemplate.from_template(system_template),

HumanMessagePromptTemplate.from_template("{question}")

]

prompt = ChatPromptTemplate.from_messages(messages)

chain_type_kwargs = {"prompt": prompt}

qa = RetrievalQAWithSourcesChain.from_chain_type(

OpenAIChat(temperature=0),

chain_type="stuff",

retriever=docsearch.as_retriever(search_kwargs={"k": 9}),

chain_type_kwargs=chain_type_kwargs,

reduce_k_below_max_tokens=True

)

return qa

seikiword = '.*菌.*'

qa = df2ChatGPT(dfxxx[ dfxxx['要約'].str.contains(seikiword, na = False)

| dfxxx['請求の範囲'].str.contains(seikiword, na = False)

| dfxxx['名称'].str.contains(seikiword, na = False)

])

print(qa({"question": '菌に関連する課題を示してください'})['answer'])

GPT-4に課題を挙げさせ,その課題が特許母集団に現れているかChatGPT APIで確認し,現れていない課題であれば,新しいことでありかつ戦略的な特許ができうる課題だとみなす

なども可能性がありそうです.(以下は「上記課題の中で,これまでに公開された特許記載の課題に含まれていないものはありますか」と聞いていますが,ここをChatGPT APIに置き換え,存在する特許の中にあるかどうかを聞くわけです.)

https://eager-duck-e33.notion.site/Issues-with-Footwear-0c3a0a5a0613410b8ca51a49d70de68b

- 履物に関し,一般的な課題を10こ挙げよ

「サイズの不一致: 履物のサイズが個々の足に合わない場合があります。標準化されたサイズ表記でも、ブランドやモデルによって微妙な違いがあることが一般的です。

足の健康問題: 適切でない履物は、足の健康問題(例: 足の痛み、骨折、水ぶくれ、タコ、外反母趾など)を引き起こす可能性があります。

耐久性: 履物の耐久性が低いと、短期間で劣化や破損が発生し、頻繁に買い替える必要があります。

価格: 履物の価格は、ブランドや素材、製法によって大きく異なり、予算に合わせて選ぶことが難しい場合があります。

環境への影響: 履物の製造や廃棄による環境への負荷が懸念されており、サステナブルな選択が求められています。

デザインと機能性のバランス: 美しさと快適さを兼ね備えた履物を見つけることは、時に困難です。

シーズンや用途の適合性: 履物を購入する際、季節や用途に応じて適切なタイプを選ぶ必要があります。これには、防水性、通気性、保温性などの特性が関与します。

製品の品質管理: 履物の製造過程での品質管理が不十分だと、不良品が市場に出回る可能性があります。

メンテナンス: 履物によっては、適切な手入れや修理が必要であり、それらの手間やコストが問題になることがあります。

動物の福祉: 動物由来の素材(例: 皮革)を使用した履物は、動物の福祉やエシカルな課題を考慮する必要があります。」

- 履物に関し,満たされていない課題,満たされていないニーズを10こ挙げよ

「完全なサイズカスタマイズ: 消費者の足の形状やサイズに完全に合わせたカスタマイズオプションが、多くのブランドではまだ提供されていません。

汎用性の高い履物: 1足で様々なシーンや目的に対応できる、本当に汎用性の高い履物が市場にはまだ十分提供されていません。

サステナブルな素材と製法: 環境に優しい素材や製法を用いた履物は増えていますが、まだすべてのブランドや製品で採用されているわけではありません。

センサー搭載による健康管理: 履物に組み込まれたセンサー技術によって、足の健康状態や歩行の質をモニタリングする製品が一般的でない。

自動調整機能: 着用者の足に合わせて自動的にフィット感や締め付けを調整する機能が、ほとんどの履物にはまだ搭載されていません。

軽量化と耐久性の両立: 軽量でありながら耐久性に優れた履物は、市場でまだ十分に提供されていない場合があります。

一貫したエシカル基準: 動物福祉や労働者の権利に配慮したエシカルな基準を徹底的に実践するブランドや製品が、まだ十分に普及していません。

普及価格帯の高品質履物: 低価格帯でも高品質な履物を提供するブランドや製品が、まだ市場には十分に存在しない場合があります。

抗菌・防臭機能の向上: 履物における抗菌・防臭機能は、依然として改善の余地があると考えられます。

無料・迅速な試着・交換サービス: オンラインショッピングが一般的になる中、無料で迅速な試着・交換サービスを提供する企業はまだ限られています。」

- 上記課題の中で,これまでに公開された特許記載の課題に含まれていないものはありますか(つまり,新しいコトとなりえるものはありますか)

「私の知識は2021年9月までのものであり、最新の特許については把握していません。ただし、これまでの特許においては、いくつかの課題に取り組んでいる例があります。例えば、履物のサイズカスタマイズや自動調整機能に関する特許が存在します。しかし、以下のような課題については、特許がまだ十分に取り組んでいない可能性があります。

汎用性の高い履物: 1足で様々なシーンや目的に対応できる、本当に汎用性の高い履物の特許はまだ少ないかもしれません。

センサー搭載による健康管理: 履物に組み込まれたセンサー技術によって、足の健康状態や歩行の質をモニタリングする製品に関する特許は、まだ十分に開発されていない可能性があります。

サステナブルな素材と製法: 環境に優しい素材や製法を用いた履物に関する特許は増えていますが、まだすべてのブランドや製品で採用されているわけではなく、新しい素材や製法に関する特許はまだ開発の余地があるでしょう。

一貫したエシカル基準: 動物福祉や労働者の権利に配慮したエシカルな基準を徹底的に実践するブランドや製品に関する特許は、まだ十分に普及していない可能性があります。

抗菌・防臭機能の向上: 履物における抗菌・防臭機能に関する新しい技術や素材の特許は、まだ開発の余地があるでしょう。

特許の取得に関しては、状況が日々変化しているため、最新の情報を調査することが重要です。特許データベースや公的機関のウェブサイトを利用して、最新の特許情報を入手することをお勧めします。」

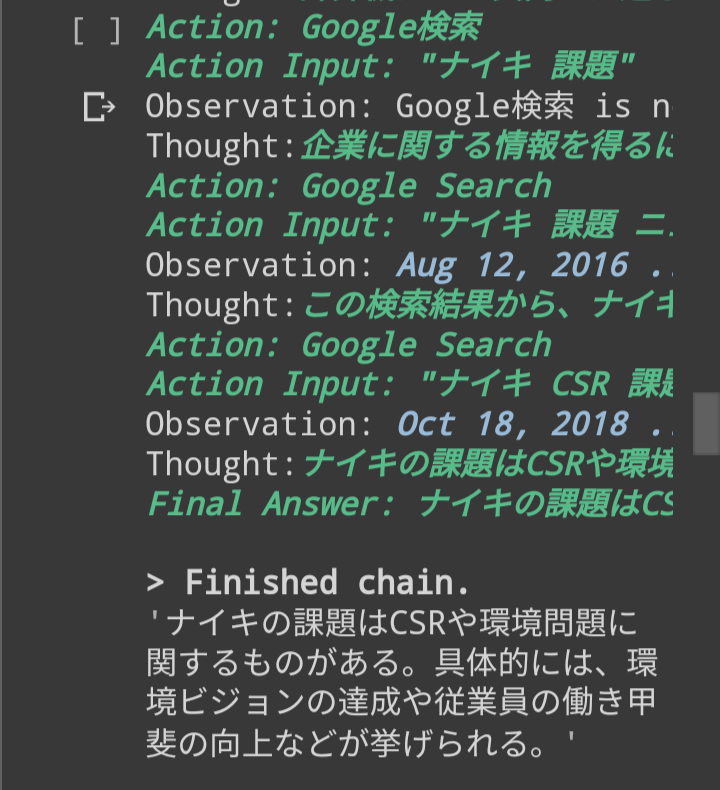

・ChatGPTの知識不足を補うために、google検索やwikipediaなどを組み合わせても良いですね.

乱暴な例ですが検索例は以下の通り.

*Google Driveに保存している大量の文献PDFファイルについて,その知識の範囲内を,ChatGPTで質問応答できるようにもできます.DuckDBを永続化しましたので,今後は質問があったら入力するだけです..

便利ですねぇ本当に.Google Driveの検索機能はいまいちですからねぇ・・・

費用はembeddingをどのモデルで行うかに依存するでしょう.OpenAIEmbeddings()つまりtext-embedding-ada-002を用いて7500円ほどでした(後日価格改定がありました。半額ほどで済むはずです。).

安上がりとするには、入力トークン数が大きいかつドメインが異なりすぎないモデルが必要ですが…

もう使わないかなと思っていた次をベクトル抽出のために用いても良いかもしれません。

中間表現の取り出し方については,つぎなど参考になるでしょう

Explore T5

https://www.kaggle.com/code/debarshichanda/explore-t5

ChatGPTにかける前のベクトルによる抽出がボトルネックになるようです。ChatGPTで言い換えを考慮した検索をしたいのでその前の抽出で言い換えが除かれてはよろしくありません。レーベンシュタイン距離はいまいちでしょうし…どうしたものでしょうね。

※Llama 2 + multilingual-e5-large で LangChain のRetrievalQAを試す

https://note.com/npaka/n/n3164e8b24539

embeddingをどのモデルで行うかについて、今ならe5が良いでしょうか。

入力トークン数は514ですが

※embeddingをrinnaやe5を用い行い、PDFのRQAをした例。

alfredplpl/RetrievalQA.py

https://gist.github.com/alfredplpl/57a6338bce8a00de9c9d95bbf1a6d06d

※Kaggle - LLM Science Exam

Use LLMs to answer difficult science questions

https://www.kaggle.com/competitions/kaggle-llm-science-exam/leaderboard

多分初めてのRAGコンペ

LLMのfine tuningよりもembedingのアンサンブルのほうが良かった様子。

自分もベクトル合成やアンサンブルを多用しますがそんな印象はありますね。第一選択はやはりこちらかな。

※JapaneseEmbeddingEval

https://github.com/oshizo/JapaneseEmbeddingEval

埋め込み表現と特定の評価手法での評価

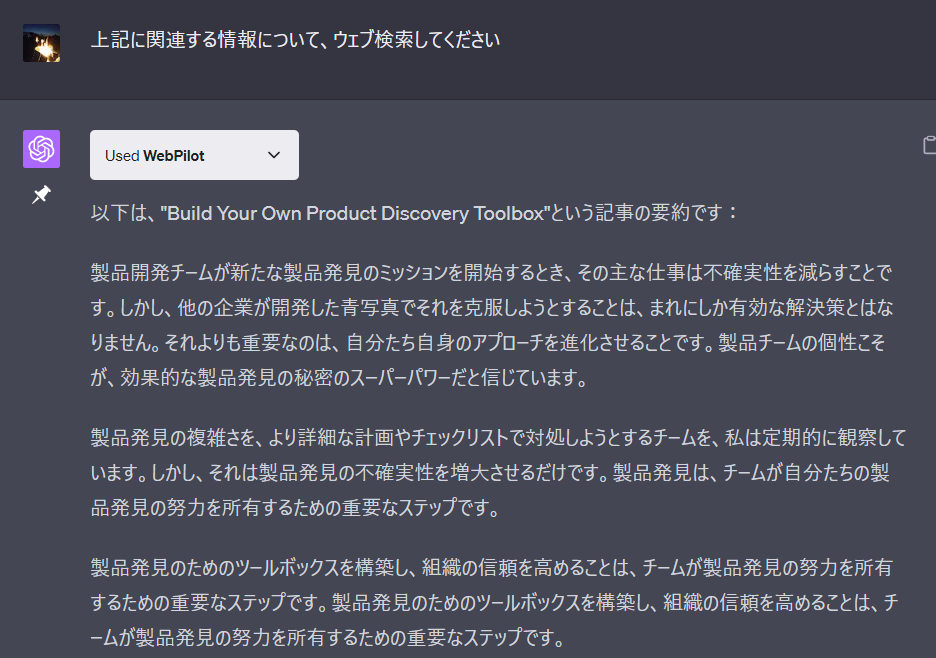

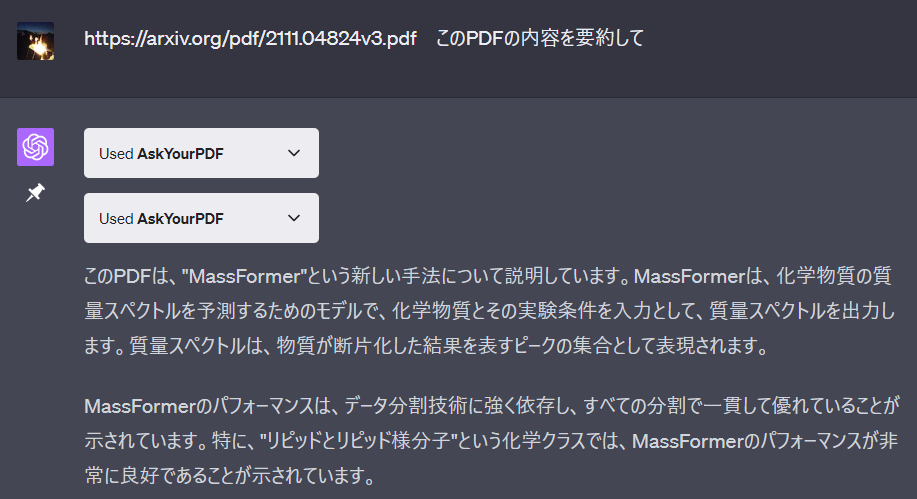

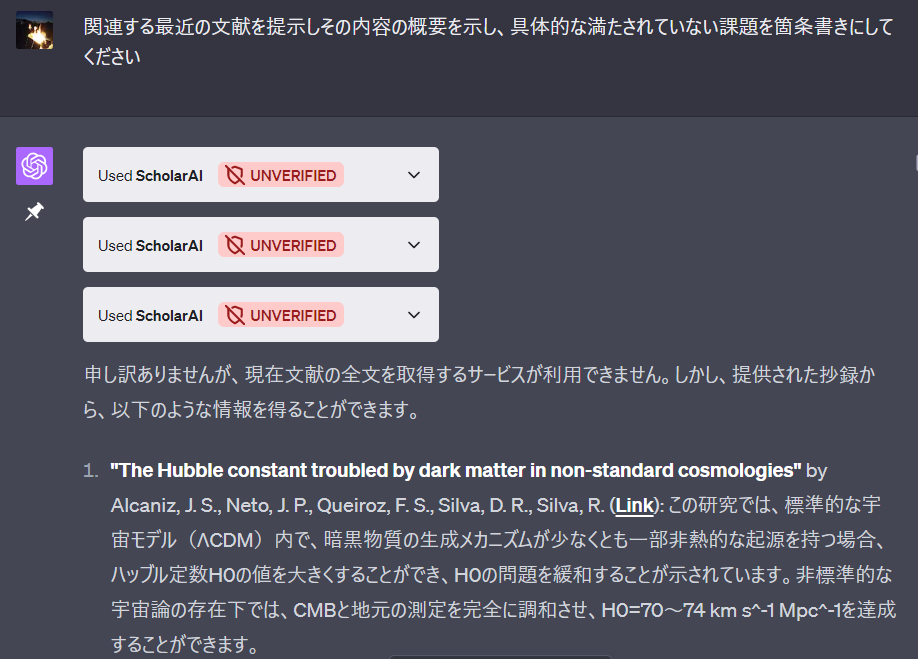

・ChatGPT plugin も面白いですね.

次など興味深く使っています

webpilot

web検索

askyourPDF

PDF読み取り

scholorAI

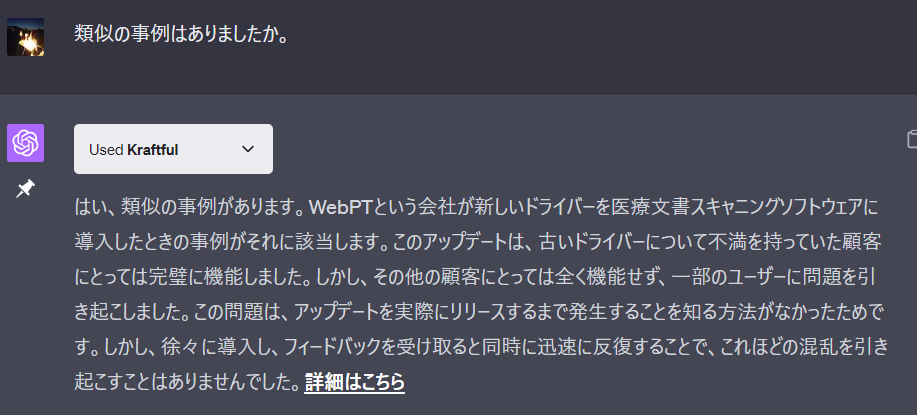

文献検索? 何故かリンクも文献タイトルも正しくないことが・・・

kraftful

業界標準のベストプラクティスを探索、製品ドキュメンテーションを作成,とのこと?

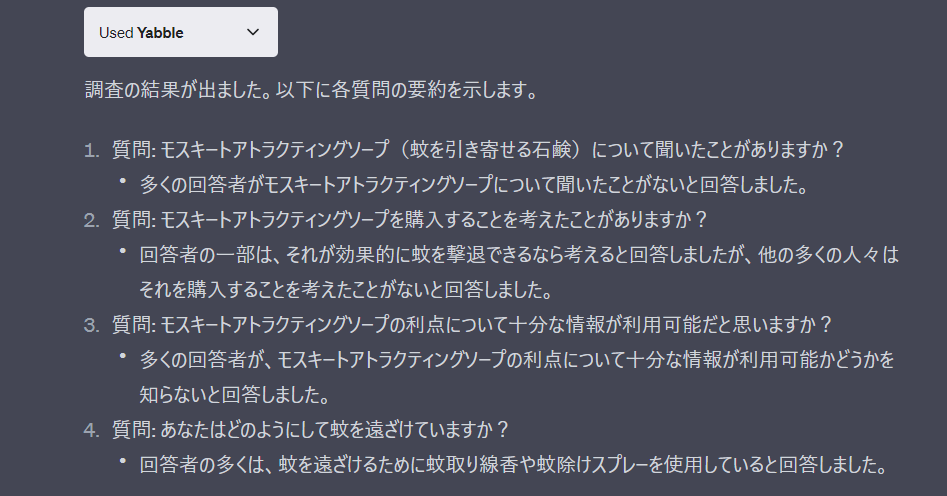

yabbie

マーケット調査

zapier

様々なツールとのリンク

Gmail:

notion:

Googledrive:

など

speechki

音声に変換

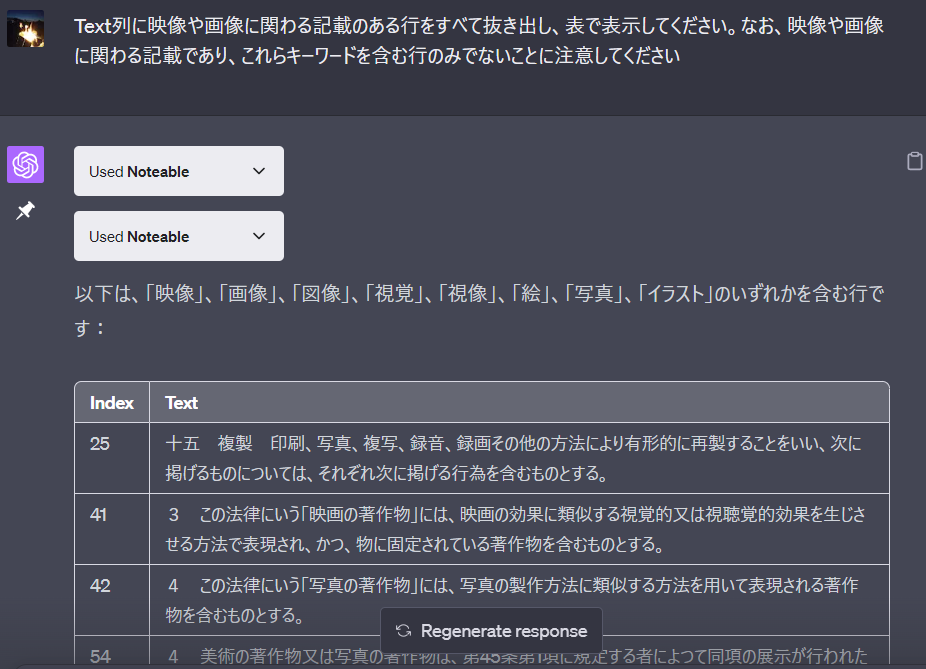

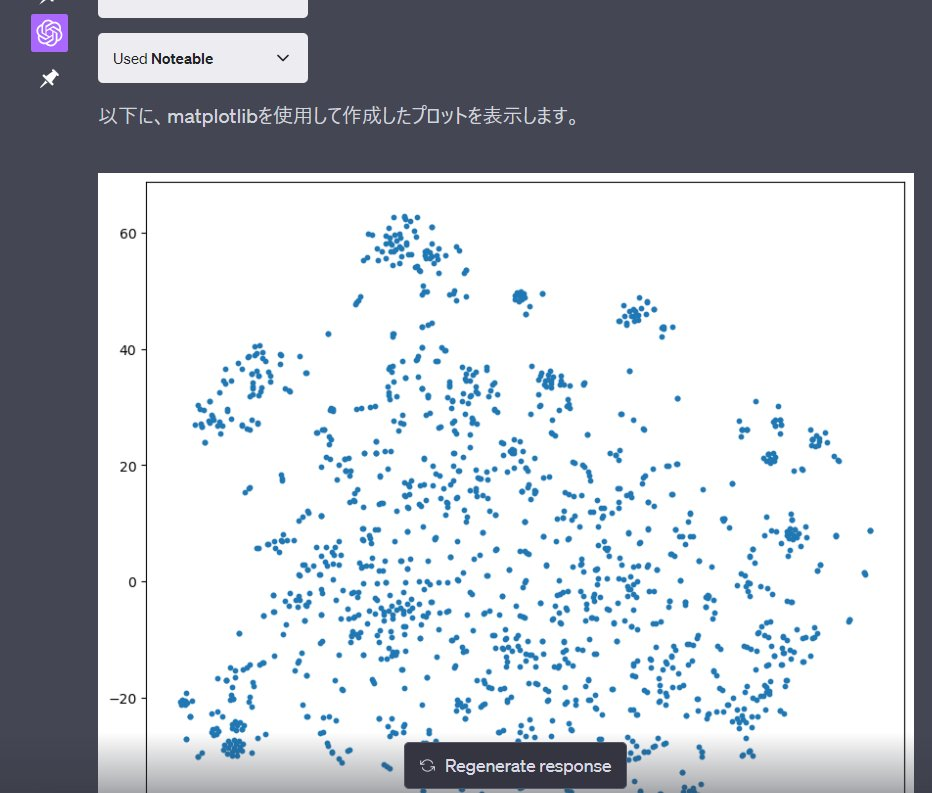

noteable

プログラムを実行

例えば,web上の「著作権法」全文をnoteable上で入手し,分割し,pandas DataFrameに入力しておいてから,

ベクトルに変換しておくとRetrivslQA同等の処理ができるなど.

(ベクトルを用いずChatGPTを用いてpandas DataFrame内部の文字列などに直接アクセスすることができればより大量の文章を一気により柔軟に検索や処理ができるようになるが,今のところできていない.)

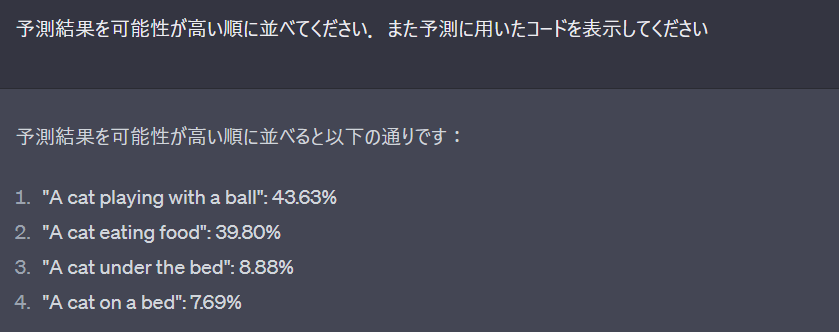

画像については,pytorchやimagenetをつかったり,

ChatGPTが作ったシナリオ(!)に適合する確率を,CLIPで求めたり,

https://qiita.com/kzuzuo/items/e35e0c0535f0d32b135e

画像から予測した物体に対してシチュエーションを予測した文章を生成し確率を出し確率の従ってさらにシチュエーションを予測した文章を生成し…を繰り返せば、

画像を説明する長文が、簡単な画像認識モデルと言語モデルからできる、と。

・ChatGPT makes materials research much more efficient

https://engineering.wisc.edu/news/chatgpt-makes-materials-research-much-more-efficient/

文ごとに構造化に必要なデータかGPTで判断し、表にまとめる。MIなどで特許から学習データを集める場合など養重宝しそうです。

・ChatGPTとNoteableによる科学技術情報分析

https://speakerdeck.com/hayataka88/chatgpttonoteableniyoruke-xue-ji-shu-qing-bao-fen-xi

・When Not to Trust Language Models: Investigating Effectiveness of Parametric and Non-Parametric Memories

https://arxiv.org/abs/2212.10511

「言語モデルが人気のある事物についての情報はよく覚えているけれど、あまり人気のない事物についての情報は苦労して覚えていることを発見しました。」

「言語モデルが情報を覚える能力を改善するために、外部の情報源(非パラメトリックなメモリと呼ばれます)から情報を取得する方法を試しました。しかし、この方法も完全な解決策ではなく、特に人気のある事物についての質問では、取得した情報が誤解を招く可能性があることがわかりました。」

「質問の内容に応じて、言語モデル自身の記憶を使うか、外部の情報源から情報を取得するかを適応的に切り替える方法。これにより、言語モデルのパフォーマンスが向上し、さらにコンピュータが必要とする処理能力(推論コスト)も削減されました。」

※言語モデルに対し最も期待しているのは、構造化されていないデータの、既存のモデルが入力として使える程度の構造化。web上の記事や論文やPCやgoogle drive 内ファイルの構造化など.

文献から特定のプロパティの要素を抽出し構造化することはできている.あとは,安定してそれができるようにすること.もう少し試してみる.

*「文は短く」は俗説か?ー〈短文信仰〉を屠り,短文のレトリックと長文のロジックを取り戻すために

https://readingmonkey.blog.fc2.com/blog-entry-609.html

長文のロジックは,統語までゆかずとも簡単な数式と単語を用いることにより,ある程度明確に表現できるでしょう.

*ニューラル数式ソルバーにおける途中結果の追跡と操作

https://github.com/cl-tohoku/trace-manipulate

ベクトル演算の意味

使用例1.2:概念からの文章の自動生成 -基本特許の自動生成-

使用例1.1の演算等で生成した概念から文章生成もできます.

データやナレッジの言語化,Data-to-Text,vec2seqですね.空間上の座標から文章を生成する翻訳モデルのようなものです.

Foresight(未来洞察)技術の一つと言っても良いのですかね?

例えば,「空白領域,未知領域,新規分野の概念を演算等により形成し,その空白領域等においてどのような特許を出願すべきか例示できる」わけです.大きな空白を狙いうまく表現力を調整できれば,ブルー・オーシャンを切り開けるかもしれない基本特許の自動生成ができえることになります.

なぜ文章生成をするのでしょうか? 基本的な考え方は次の通りです.

・ベクトル空間における実態は語彙しかないところ,語彙がない空間にも例えば['brain','electrod','chip']という複数語彙で表現される点があるわけです.この点はvec2seqにより文章で表すこともできます.

(自分は勝手に、このようなベクトル空間は「語彙のゴースト」でできている、などt表現します。ここで述べているのは、ゴーストの影にも意味がある、って感じです。)

・['brain','electrod','chip']で概念を形成した場合は,'brain','electrod','chip' を含む文章が生成されやすいでしょう.文章生成の意味はあまりないかもしれませんね.ただ,使用例1.1で示したような群から求めた「戦略概念」の場合はどうでしょう.「空白」の場合はどうでしょう.単語から概念を求めていないのでどの単語から生成されるかわかりませんね.周辺から語彙を集めてもわけわからないかもしれません.こんなときに文章生成は役に立つでしょう.

・文章生成により,「概念が示す主題」だけでなく,「母集団全体が示す技術常識や観点」も表現されうる,と期待できます.

*世界のすべての文章から「空白」を求めたのではなく,母集団から「空白」を求めたので,「母集団全体」を事前分布とします.いわゆる事前学習モデルは世界すべての文章の空白を学んでいると考えられ,その空白は世界すべての文章の観点から得られたものとなります.過剰な観点やコントロールできない観点を削除したい,当業者を無視した一般論という観点を削除したい,本目的には沿わないでしょう.(アダプター糖を用い,母集団全体の分布に近づけるなど,本目的で使えるようにする手段もなくもないですが)

*可能な限り素直に、ベクトル空間全体を蒸留します。

*分布内汎化と分布外汎化があるところ,母集団を任意に設定することにより分布内汎化のみが起き分布外汎化が起きない?メリットを享受します.

*ChatGPTなど大規模言語モデルにより生成された特許文章は分布外汎化となります.分布内汎化をもとめるこのモデルとは目的が異なります.後述しますが,分布内汎化した後,分布外汎化で補足することはありです.

*視覚と似たようなものです,と安易に類似を述べると怒られますけど(網膜 畳み込み空間特徴量化img2vec(概念の入力) →視神経 →外側膝状体(6, P, M)・特徴加工・変換(注意付与?・左右混合生成?)vec2vec →視覚野(コラム単位)における視覚形成vec2seq ←高次領域からの入力(母集団の任意設定))

更新中) 網膜・視神経障害による失明から回復する技術に関する 個人的妄想メモ

https://qiita.com/drafts

・生成のもととなる分布自体は正しいと確信というか正しいと想定できるので,十分創造的と認識することができ,受け手のインサイトを刺激もします.

・後述するネットワーク化においては、空白や少数は見えがたいです。点群では空白の中身がわかりがたいです.これら解決するために、空白領域の特許生成に意味があります

(補う処理が同じデータからできるってのはちょっと面白いですよね。これが自然言語処理では分析とサイエンスが同じと述べる理由の一つです)

・「未来を語ること」がいわゆるIPランドスケープの価値であるとして、今後権利が取れうる基礎特許を提示することは、その目的に直接沿います。

*出願特許を提示する手法はいくらかありますが,いくらかは単に同じ特許文献があるかどうかの検索のようです.欲しい特許は,権利は取れるが意味のないものともなりえる単なる同じ発明のないもの,つまり単なる点,よりも,他社優位となる「範囲」のある「基本特許」となり得るもの,です.文章生成手法は空白を用いることにより,範囲のある基本特許の生成を志向できるでしょう.(空白は密度の問題であるので件数に依存し難い,空白は特許文献のみから検出したとしても技術全体の空白でもあると仮定できる,という点も良いところです)

・追記) 特許生成には言語モデルを用いますが,Transformerのみを用い文章生成する場合の弱点を補うために,概念ベクトルをドメイン知識を持つ事前分布として用いる,と理解としても良いようです.

- 確率モデリングのアプローチの違い:

ベイズ的アプローチでは、事前分布と尤度を組み合わせて事後分布を計算し、それに基づいて次の単語が選択されます。このアプローチは、事前知識(事前分布)と観測データ(尤度)を明示的に組み合わせてモデルを更新します。

一方、Transformerモデルでは、大量の学習データを使って確率分布を学習し、その分布に従って次の単語を選択します。このアプローチは、事前知識と観測データが暗黙的に学習データに組み込まれており、モデルは自動的に文脈や構造を学習します。ドメイン知識が重要であり、事前分布を利用したい場合は、ベイズ的アプローチが適切です。

大規模なデータセットから効率的に学習し、複雑な文脈を捉えたい場合は、Transformerモデルが適切です。

ベイズ的アプローチは、ドメイン知識に基づいて新しいアイデアを提案できますが、大規模なデータセットに対しては効率的ではない場合があります。一方、Transformerモデルは、学習データに基づくため、真に新規な文章を生成することが難しい場合があります。

そのため、新規性のある文章を生成する際には、ベイズ的アプローチとTransformerモデルを組み合わせることで、それぞれのアプローチの利点を活用することが望ましいです。例えば、ベイズ的アプローチで事前分布を設定し、Transformerモデルで効果的に学習・生成するといった方法が考えられます。

GPT-4さんには感心するしかないですね・・・

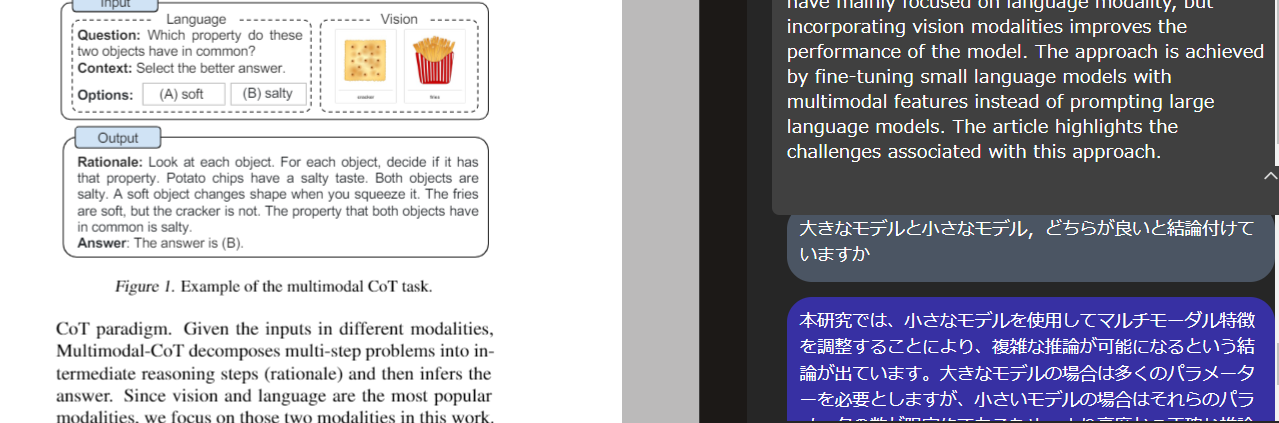

後述するMultimodal Chain-of-Thought Reasoning in Language Modelsでも似た?考察がなされているようにも思えます.

ご参考まで,流れを記載しておきます.

*特許生成の実例は記載しにくいですが,後ほど後ろ向き検証できたものを追記しておきます.

1 プログラムの作成

・image captioningが同じvec2seqのアルゴリズムを利用しているので流用します.CNN-LSTMなど様々な手法がありますが,本課題ではCNN-transformer decoderが良さそうです.

*Vit-GPT2 https://huggingface.co/nlpconnect/vit-gpt2-image-captioning もありましたね.モデル構造などに手を入れる必要がないと前提できればこちらでも良かったかもしれません.

2 学習に必要なデータ量・モデル容量・メモリ・学習時間・ハイパーパラメーターのあたり付け

・自分の使用方法ではベクトル空間を毎回作成することになりますので,毎回学習することになります.学習時間の確認は重要です.

・・学習に必要なデータ量は6000件で必要に足りるようです.学習時間はcpuで6時間ほどで足りるでしょうか.ほか,許容範囲内です.

*転移の可能性やdata augmentationの可能性は後ほど検討します.

*コツはkaggleなど参照すると良いでしょう 例えばこの辺ですかね

Bristol-Myers Squibb – Molecular Translation

https://www.kaggle.com/competitions/bms-molecular-translation/discussion

例えば,

https://www.kaggle.com/competitions/bms-molecular-translation/discussion/243932

「After swhiched to transformer from LSTM, I've tried many conbination of patameters.

And then found these insights;

Image size is most importatnt, bigger is better.

In my intuition, aspect ratio is useful information, but just resizing to fixed image size works best.

In encoder, Adding positional encoding to only query and key is better than adding to encoder output directly. It's same as DETR does.

As my model got to predict very well, most of trainig data got so easy one, so I thought focal loss works here. And it actually did. It was later verified by my teammate after team mergeing.

After team merging, my teammate shared how to deal with train/test difference, or CV/LB gap. I've approached to the gap by denoise/noise method(shared above) and pseudo labeling. both worked.

Batch size is 128 and train 50 epochs. It takes to train models about 10 days. Without TPU, it would be a month or more…

Other small detail can be found in the notebook.」

3 表現能力の確認

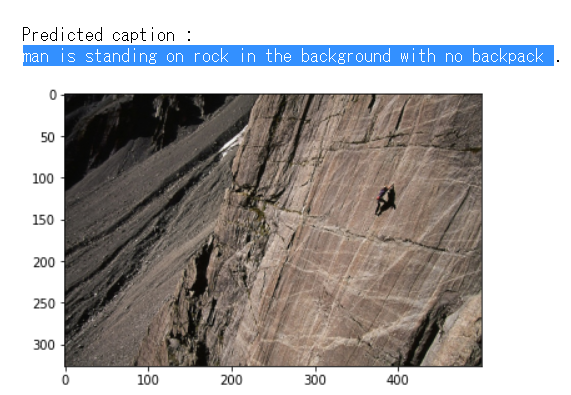

・特許を生成するのですから,memoryから適切にk,vに関わる主題を受け継いでいること,tgtから適切にqに関わる常識や観点を受け継いでいること,それらバランスにより適切な創造的な文章が生成されること,は重要です(文法上の正しさは二の次で良い).これを確認します.要事,モデルのアルゴリズムを調整します.

・・「あるべきものを含まない」表現も適切に生成できえるようです.

*登山ではバックパックを背負っていることが常識であるのに背負っていない.この非常識を指摘できている可能性(フリークライミングではバックパックを背負わないことが常識ではあるでしょうけれどどの観点で見ているかに依存するでしょう)

*問題が多いようでしたら,pretrained decoderへの切り替えを検討しても良いでしょう.ただし,安易に重みを流用すると,「らしい文章は生成されるが必要な文章ではない」,hallucinationなど,目的が達成できなくなるかもしれませんので注意が必要です.(大規模言語モデルが使えると楽なんですけれどねぇ https://huggingface.co/docs/hub/adapter-transformers )

4 memory情報量を削減した場合の表現能力の確認

・CNNの出力は(7, 7, 512)でありこれを(49, 512)に変換しdecoderのmemoryとしています.tfidf/mbart/mt5/CLIP embeddings cluster reconstructing visの概念の出力は可変ですが(1, 300)ほどです.特許を生成する場合,使える情報量は3よりも少なくなります.特に位置情報は失われています.(49, 512)を(1, 512)とするなど変換を行い,3と同等の表現が可能か確認します.また(1, 200)ほどに回転させ,同等の表現が可能化確認します.

・必要に応じ,情報を増やします.

・・予想以上にモデルをコンパクトにする必要がありちょっと驚いています.

可能性の制約をしないと頭を振り絞って学習しないかのようでちょっと面白いところです.

・・memory入力に付き,位置情報を除去したほうがlossは低くなりますねぇ・・・なぜだろうか・・・.

位置情報を失うため画像の中心と文章の主体がずれやすくなるかと思ったのですが(25,512あたりに画像と文章で共通する主体が現れやすくなっていると予想され,位置情報があると学習しやすいだろうとの予想)そのような傾向は明確には確認できていません.(思考整理メモ.画像49のうち48が岩,1が人とする.平均すれば人の情報は1/49となる.この情報を主として生成される文章は岩が主体となることが自然だろう.しかしそうなっていない.仮説1: memory側,画像の人部分にそも岩より重い重みがあり1/49*xであった.しかしtransformer encoder とは異なり,CNNはそうであるアルゴリズムでははない.仮説2:q側,文章の学習により岩より人が主体となりやすいと学習され,1/49となった人情報でも取り出しやすくなっている.仮説2が妥当だろうか.すると,こと画像においては,memory側の位置情報は主体がどこに現れるかわからない以上それほど重要ではなく(主体は中央に現れやすいが常にそうでもない)(翻訳ではmemory側の主体の位置はほぼ固定であり重要),q側の学習文章から主体となりやすいものを取り出すのみにしたほうが整理されやすい,となっているのかもしれない.)

・・memory入力に付き,回転(ニュアンス)させてからk,vに変換したほうがlossは低くなるようです.

k,vの必要な部分にdecoderからの逆算により位置情報を付与し直している(回転部分に位置情報が学習されている)・・・のでしょうか?(多分文献があるでしょう.探してみます.)(追加した層においてencoderの独立成分を抽出し、decoderの主題と一致する成分にattentionを当てやすくしているのですかね?)(ICAののように自由度を下げ独立成分を抽出した場合はどうなるでしょうか)

モデルはざっとこんな感じです.

変数名が画像系の名称となっていたりと汚いですが勘弁してください.

class vec2seqModel(nn.Module):

def __init__(self, n_head, n_decoder_layer, vocab_size, embedding_size,

dim_feedforward=2048, dropout=0.1, dtype=None):

super(vec2seqModel, self).__init__()

self.pos_encoder = PositionalEncoding(embedding_size, 0.1)

self.pat_encoder = PatentClassEncoding(embedding_size)

self.TransformerDecoderLayer = nn.TransformerDecoderLayer_custom(d_model=embedding_size, nhead=n_head, dim_feedforward=dim_feedforward, dropout=dropout)

self.TransformerDecoder = nn.TransformerDecoder(decoder_layer=self.TransformerDecoderLayer, num_layers=n_decoder_layer)

self.embedding_size = embedding_size

self.embedding = nn.Embedding(vocab_size , embedding_size)

self.last_linear_layer = nn.Linear(embedding_size, vocab_size)

self.memorydimconvertliner = nn.Linear(200, embedding_size)

self.init_weights()

def init_weights(self):

initrange = 0.1

self.embedding.weight.data.uniform_(-initrange, initrange)

self.last_linear_layer.bias.data.zero_()

self.last_linear_layer.weight.data.uniform_(-initrange, initrange)

self.memorydimconvertliner.bias.data.zero_()

self.memorydimconvertliner.weight.data.uniform_(-initrange, initrange)

def generate_Mask(self, size, decoder_inp):

decoder_input_mask = (torch.triu(torch.ones(size, size)) == 1).transpose(0, 1)

decoder_input_mask = decoder_input_mask.float().masked_fill(decoder_input_mask == 0, float('-inf')).masked_fill(decoder_input_mask == 1, float(0.0))

decoder_input_pad_mask = decoder_inp.float().masked_fill(decoder_inp == 0, float(0.0)).masked_fill(decoder_inp > 0, float(1.0))

decoder_input_pad_mask_bool = decoder_inp == 0

return decoder_input_mask, decoder_input_pad_mask, decoder_input_pad_mask_bool

def forward(self, encoded_image, decoder_inp):

encoded_image = encoded_image.permute(1,0,2)

encoded_image = self.memorydimconvertliner(encoded_image)#多分層が足りない

decoder_inp_embed = self.embedding(decoder_inp)* math.sqrt(self.embedding_size)

decoder_inp_embed = self.pos_encoder(decoder_inp_embed)

decoder_inp_embed = self.pat_encoder(decoder_inp_embed)

decoder_inp_embed = decoder_inp_embed.permute(1,0,2)

decoder_input_mask, decoder_input_pad_mask, decoder_input_pad_mask_bool = self.generate_Mask(decoder_inp.size(1), decoder_inp)

decoder_input_mask = decoder_input_mask.to(device)

decoder_input_pad_mask = decoder_input_pad_mask.to(device)

decoder_input_pad_mask_bool = decoder_input_pad_mask_bool.to(device)

decoder_output = self.TransformerDecoder(tgt=decoder_inp_embed, memory=encoded_image,tgt_mask=decoder_input_mask, tgt_key_padding_mask=decoder_input_pad_mask_bool)

final_output = self.last_linear_layer(decoder_output)

return final_output, decoder_input_pad_mask

5 日本語で同等か確認

・日本語で同等か確認します

*6と統合しても良いでしょう

6 memoryを,tfidf/mbart/mt5/CLIP embeddings cluster reconstructing visの概念のベクトルに置き換え確認

・実際の動作を確認します

・必要に応じ,情報を増やします.

・画像英文で可能であり特許文章日本語で可能でない部分については,直交可能な理由が探索できるはずです.理由を見つけ解決を繰り返します.

・・動作確認時生成例

Predicted caption : 本 開示 発明 は , アテ ローム 性 障害 , アテ ローム 不全 及び 障害 の 治療 及び 予防 又は 予防 及び その よう な 疾患 を 処置 し , その 使用 方法 に関する 方法 を 提供 さ せ , その よう に 提供 する .~(後半省略)

より低頻度語を重視しても良さそうです.前処理は詰める必要があるでしょう.文章はもう少し長いと良いですね.低頻度語を十分取り入れた150字要約となると理想でしょうか.

・・lossには工夫の余地がありそうです.

インサイトを得るに必要な単語は汎用語でしょうか低頻度語でしょうか.受け手の知識を喚起するのはどちらでしょうか.また,BRIOのように品質評価を加えても良いかもしれません.

単語統計を損失関数に取り入れた深層学習による多様な雑談対話生成

https://www.jstage.jst.go.jp/article/tjsai/37/2/37_37-2_G-L62/_pdf

・・大きすぎるbatchを用いないことも重要でした.

ノイズに対する頑強性はそれほど重要でなくまたある程度の低頻度語を歓迎するなら,確かにその通りとなりやすいでしょうね.

google: A playbook for systematically maximizing the performance of deep learning models.

https://github.com/google-research/tuning_playbook#why-shouldnt-the-batch-size-be-tuned-to-directly-improve-validation-set-performance

「(前提としてバッチサイズ依存性はなくすべきだとして)バッチサイズが小さいと,サンプルの分散により学習アルゴリズムに多くのノイズが混入し,このノイズが正則化の効果をもたらす可能性があります.」

なるほど。もう少し他の正則化手段を見直しても見るか。

・・少量データに基づくと,複製により高品質に見えることがあります.

この利点と欠点を考慮し,また,human, train, train dev, dev, testのどこに差があるか確認し対応すべきなのはモデルの複雑さなのか正則化なのか評価なのか等々考え,進めてゆく必要があります.

*特許文章のすべてを学習していては,自分の想定する運用において,時間がかかりすぎるといえるかもしれません.当な文章の選択・削減(技術常識や観点の表現を制限する)か,転移(ドメイン外の技術常識や観点の表現を許容する)を検討したほうが良さそうです.

*ある画像要素は,その説明文に存在するある単語要素に対応しているはずです.ある特許文章から作ったベクトルは,同じ特許文章に存在するある単語要素を含んでいるはずです.一方,特許文章からその単語要素を除去しても,違和感ない文章を作ることは可能です.そして該当する単語要素はわかりませんので,適当な文章の選択・削減をするにおいて,除去してしまうこともあります.この違和感のない文章においては,明確な対応関係は崩れています.この違和感ない文章において単語要素を再形成させようとすれば,残された複数の要素を組み合わせる,比較的難しい学習が必要となるでしょう.この違和感のない文章を学習に用いる場合,どのような工夫が必要でしょうか.

7 目的に適合するように,調整・改善・機能追加

・目的に適合するように,各種調整・機能追加を行います.

・「低頻度語を考慮して生成して欲しいが,特定の低頻度語のみを重視してほしくもない.多様な生成ができつつ,文の構造は構造化されており,できれば周辺の空白範囲やランダムさに合わせ多様性を調整できていて欲しい」という評価指標を作り,最適な条件を探索します.

評価指標さえ適当にできれば,optunaやwandbのsweepで探索できますが・・・

ChatGPTやInstructGPTの流れを見る限り,ヒューステリックな評価指標ではなく,Discriminatorのような別モデルによる評価を真剣に考慮しても良さそうです・・・

・特許分類を加えて,より精度を高くしたり,promptとして任意に特許分類を提示しその方向をさらに考慮した特許生成ができたりすると,利用可能性が向上しそうです.

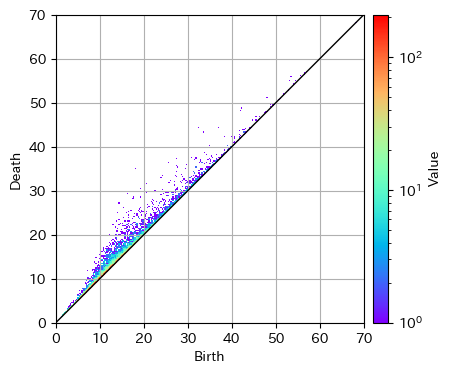

・トポロジーを用い,空白領域の基本特許の生成を試みます.

homcloud:

パーシステントホモロジー(persistent homology)にもとづいたデータ解析ソフトウェアです.

3次元点集合データ(ポイントクラウド)の解析

https://homcloud.dev/py-tutorial/pointcloud.html

次元圧縮を行ってもトポロジーの特徴は残りや会うのである程度低次元で計算しても足りるでしょう。

・・調整前生成例

Predicted caption : 有効 成分 を 含有 し ない 注射 剤 で あっ た 注射 剤 . 有効 成分 を num % 含有 し て なり 該 カルシトニン 成分 が num . threnum num ~ threnum % の 範囲 に あり 該~(後半省略)

有効成分を含まないとしてきた事情と有効成分を追加することとなった意義は一体何なのか・・・斬新な発想?ですかね?.とりあえず含まない表現が再現できたことには満足ではあります.周辺語彙に危険な成分があり含まないを生成する事情があった=技術常識を考慮した,生成であると嬉しいですね.

低頻度語としてカルシトニンが採用されていますね.

数値はめちゃくちゃですがここは最初から当てにしていません.

・・そこそこの生成はできるのですが,学習時間が予定をオーバーしてしまいました.

CPUで押し通そうとしているので色々工夫しなければならずなかなか難しいところです.

性能をあまり落とさず学習時間を削減するにはさらにどうできるか…難しそうですが転移できるか.転移した場合,検証をどうするか難しいのですよね.自分が使う範囲なら同じようなドメインの母集団を用いることになるでしょうから転移有無で差は殆ど無いでしょうけれど,そうすべきかどうか・・・

・・特許分類予測を含めた生成例

['<A61M>', '<A61J>', '<non>', '<non>', '<SEP>', 'シリンジ', '外', '筒', 'の', '先端', '部', 'は', '他', 'の', '医療', '用具', 'の', ~

分類情報があればより適切に学習でき生成もしやすいのではと思うと同時に,生成時に分類をpromptとして与えれば,任意の低頻度語が生成できやすくなるのではと期待しています.また,より演繹的な結果を多く与えることにより,「わからないの範囲」を学習,提示できるようにもなると期待しています.

なお,メイングループ単位でも良さそうです.

(self-askのような手法とみなしても良いのかもしれませんね)

・・分類はトークンとして与えており,分類トークンには特定のencodingを施しています.(transformerに非言語情報を与える手法はいくらかありますが,トークンとして与えても大差ないとの文献が多いようであるので,この手法を採用しました.また特許の分類情報は,単語と直接相関する,テキストと同質の情報を持つ情報である.とみなしても問題はないとおもわれ,トークンとして扱っても問題ないでしょう.)

*正規表現を微分可能に取り込み表現力を上げる,などありえます

*転移やdata augmentationの可能性を検討します.摂動も取り入れてみます.

*マルチモーダル化による改善は可能でしょうか.特許分類を取り入れてみるのも面白そうです.

*複数の文を生成しdiscriminatorでリランキングするのも手です.

*概念ベクトルと生成ベクトルの組み合わせをシャッフルし,その組み合わせが正しいか予測するdiscriminatorを作り,生成文をリランキングするのも手です.

*位置情報はより大きくキャンセルしたいですね・・・入力の工夫をすると良いでしょうか.

*memorydimconvertlinerを通した後の潜在空間について,それがどのような構造となっているのか見てみるのも面白そうです.母集団に対し主題が整理されたベクトルになっていると思うのですよね・・・

*高速化・少メモリは大きな課題です.次は使えるでしょうか.

sparce transformer

https://arxiv.org/abs/1904.10509

ある程度深い層を前提としているでしょうし,小規模ではメリットが少ないとも思えますが,多少でも・・・

*予測に対する確信度らしきものを出力しても良いかもしれません。学習には使わなかったがそこに文章という点が実在していた箇所と、空白箇所とで、予測にブレの程度に違いがあるの、興味深いところです。空白は不可能であるからこそ空白であることもあるでしょう。その場合はブレが大きくなるのではないでしょうか?

TransformerモデルへのMC Dropoutの適用

https://www.ai-shift.co.jp/techblog/2518

*ベイズ事後分布の相転移について

http://watanabe-www.math.dis.titech.ac.jp/users/swatanab/phase_trans.pdf

「確率的な現象では、しばしば、有限の世界を見る際にも「まず無限遠の点に立って そこから有限の世界を見渡す」という考えかたが有効であることが知られています。大数の法則、 中心極限定理、ウィグナーの半円則など」

*総合的に参照

数値気象予報からの天気予報コメントの自動生成

https://www.jstage.jst.go.jp/article/jnlp/28/4/28_1210/_pdf/-char/ja

*大規模言語モデルをそのまま利用する方法として,Flamingo 2022 のような手法があったようです.

Flamingo: a Visual Language Model for Few-Shot Learning

https://storage.googleapis.com/deepmind-media/DeepMind.com/Blog/tackling-multiple-tasks-with-a-single-visual-language-model/flamingo.pdf

def gated_xattn_dense(

y, # input language features

x, # input visual features

alpha_xattn, # xattn gating parameter – init at 0.

alpha_dense, # ffw gating parameter – init at 0.):

"""Applies a GATED XATTN-DENSE layer."""

# 1. Gated Cross Attention

y = y + tanh(alpha_xattn) * attention(q=y, kv=x)

# 2. Gated Feed Forward (dense) Layer

y = y + tanh(alpha_dense) * ffw(y)

# Regular self-attention + FFW on language

y = y + frozen_attention(q=y, kv=y)

y = y + frozen_ffw(y)

return y # output visually informed language features

BLIP-2も興味深いですね

BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models

https://arxiv.org/abs/2301.12597

https://huggingface.co/docs/transformers/main/model_doc/blip-2

FROMAGeのシンプルさも素晴らしいです

Grounding Language Models to Images for Multimodal Generation

https://arxiv.org/abs/2301.13823

*その他参考

PatentTransformer-2 Controlling Patent Text Generation by Structural Metadata

https://arxiv.org/abs/2001.03708

https://www.connectedpapers.com/main/1cd46b2acb8b342c9f45b5a96cf9fd7d84ea5118/PatentTransformer%202%3A-Controlling-Patent-Text-Generation-by-Structural-Metadata/graph

Reliable Natural Language Understanding with Large Language Models and Answer Set Programming

https://arxiv.org/abs/2302.03780v1

特に小規模モデルにおける知識による補佐.

A Multitask, Multilingual, Multimodal Evaluation of ChatGPT on Reasoning, Hallucination, and Interactivity

https://arxiv.org/abs/2302.04023v1

言語モデルの弱点hallucinationは知識ネットワークで補えば良いと思っていましたが,大規模言語モデルでは演繹を比較的得意とし帰納を不得意とするようであり,演繹的知識の付与は最適ではないのかもしれません.補うべきは演繹ではなく帰納,機械学習による結果,なのかもしれません.小規模言語モデルである場合は演繹のサポートを優先すべきなのかもしれませんが.

A Closer Look at Large Language Models Emergent Abilities

https://yaofu.notion.site/A-Closer-Look-at-Large-Language-Models-Emergent-Abilities-493876b55df5479d80686f68a1abd72f

LLMの創発能力について仮説をまとめた記事。コードの学習が寄与?

Multimodal Chain-of-Thought Reasoning in Language Models

https://arxiv.org/abs/2302.00923

https://github.com/amazon-science/mm-cot

t5 encoderで文章特徴をmhaで画像特徴を得て,これらをconcatした情報をmemoryとして,t5 decoderに入力しているようだ( multihead_attn = nn.MultiheadAttention(embed_dim, num_heads) のとき attn_output, attn_output_weights = multihead_attn(query, key, value) であるところ,self.mha_layer = torch.nn.MultiheadAttention(embed_dim=config.hidden_size, kdim=config.hidden_size, vdim=config.hidden_size, num_heads=1, batch_first=True) かつ hidden_states = encoder_outputs[0] で, image_att, _ = self.mha_layer(hidden_states, image_embedding, image_embedding) つまりk,vが画像特徴.この部分はvec2seqと同じですね.そして merge = torch.cat([hidden_states, image_att], dim=-1) gate = self.sigmoid(self.gate_dense(merge)) でもとのshapeに戻して hidden_states = (1 - gate) * hidden_states + gate * image_att) がdecoderの encoder_hidden_states=hidden_states にゆくと)

結果としては…画像の特徴量があれば小規模言語モデルも意味のある思考や推論ができる,と理解して良い?

gateの意味が今ひとつわからないのでChatGPTさんに聞いたら次とのこと.

「このコードは、TransformerモデルのDecoderにおいて、Encoderからの情報とイメージ情報を統合するための機構を実装しています。

self.mha_layerは、Multi-Head Attention機構を表します。Encoderからのhidden_statesと、イメージ情報であるimage_embeddingを入力として与えることで、Encoderとイメージ情報の両方を用いたAttention機構を実現しています。これにより、Decoderが両方の情報を組み合わせて、より正確な予測を行うことができます。

gateは、このEncoderとイメージ情報の統合の重みを制御するために使用されています。具体的には、gateはsigmoid関数を通したmerge(Encoderのhidden_statesとイメージ情報のAttention結果を結合したもの)を入力とし、0から1の値を出力します。この値は、Encoderのhidden_statesとイメージ情報のどちらを優先するかを調整するために使用されます。gateの値が1に近い場合、Decoderはイメージ情報を優先し、0に近い場合はEncoderのhidden_statesを優先することになります。」

「Decoderがイメージ情報を持っている場合、それをEncoderからの情報と組み合わせることで、より正確な予測を行うことができます。しかし、イメージ情報がない場合は、Encoderからの情報だけを使って予測を行う必要があります。

このような状況では、Encoderからの情報とイメージ情報を単純に結合することはできません。結合する場合、Decoderはイメージ情報がない場合でも、その影響を受けてしまうため、誤った予測を行う可能性があります。

そこで、Gateメカニズムが導入されました。Gateは、Encoderからの情報とイメージ情報を適切に組み合わせるために必要です。Gateにより、Decoderは、どちらの情報を優先するかを制御することができます。イメージ情報がある場合は、その情報を優先することで、より正確な予測ができます。イメージ情報がない場合は、Encoderからの情報だけを使用して予測を行うことができます。」

「申し訳ありません、先程の回答が誤解を招く表現であったようです。DecoderのQuery側に画像情報が入力されることはありません。

正確には、DecoderのQuery側には、前のタイムステップで生成されたトークンに対する埋め込みベクトルが入力されます。このため、Gateメカニズムは、Encoderからの情報と前のタイムステップで生成されたトークンに対する埋め込みベクトルを適切に組み合わせるために必要となります。

Gateメカニズムにより、Decoderは、Encoderからの情報と前のタイムステップで生成されたトークンに対する埋め込みベクトルを適切に組み合わせることができます。そして、組み合わせた結果を使用して、次のトークンの予測を行います。」

インサイトは得られました.文章情報と画像情報は同質同価値でないところ,王道はconcatであろうが,encoderとdecoderのshapeを揃える必要があるため使えない.shapeを揃える手法として例えば平均するなどあるが,今回の場合は画像部分を解釈する情報がdecoder側にないため意味消失が起き使えない.文章と画像の双方の意味を独立に保持しつつshapeを揃えるために,gateを用いる.というところでしょうか t5をpretrainとして用いないならconcatして終わりだったのかもしれません.・・・これいわゆるアダプターですか.

*BIG DATA IS DEAD

https://motherduck.com/blog/big-data-is-dead/

*説明文生成を用いた動作行動予測

https://speakerdeck.com/supikiti/yan-jiu-hui-fa-biao-zi-liao

https://github.com/Seth-Park/RobustChangeCaptioning

・画像キャプションを介した脳活動からの視覚体験再構成

○高木優, 西本伸志 (阪大)

https://www.anlp.jp/proceedings/annual_meeting/2023/pdf_dir/B8-2.pdf

脳波から言語を介し画像生成すると,画像としてより良い.(主観的画像では意味がない,ジャコメッティの画像を示しても仕方ない,のでより良いだろう.ただ,そのような画像として見えている患者においてどのような画像となるかについて,別の課題として興味深い.)

・JaSPICE: 日本語における述語項構造に基づく画像キャプション生成モデルの自動評価尺度

○和田唯我, 兼田寛大, 杉浦孔明 (慶應大)

https://www.anlp.jp/proceedings/annual_meeting/2023/pdf_dir/B8-3.pdf

シーングラフ評価として

付録:GPT-4に上記設計について聞いてみた

- 別に求めた類似ベクトルと特許文章の組み合わせデータをtransformerに学習させ、あるベクトルを与えたときに、ある特許文章を生成させようとしています。ベクトルはtransformer decoderのmemoryに全結合層1層を介し与え、特許文章は、一つの文章を、特許分類コードと特許要約文章の組み合わせと、特急分類コードと特許請求項文章の組み合わせに分割し、2倍に水増ししたものとし、これらをデータセットとして与えます。つまり、同じ類似ベクトルで視点の異なる文章を学習させます。元の類似ベクトルー特許文書の数は5000ほどです。最適な設計を考えてみてください

あなたが述べたアプローチは、Transformerモデルを利用して特許文章を生成するための有望な方法です。以下に、あなたのアプローチを最適化するためのいくつかの提案をまとめています:

データの前処理:特許分類コードと特許要約文章、特許請求項文章を組み合わせるとき、それらを適切に区切ることが重要です。これにより、モデルがそれぞれの部分を区別しやすくなります。例えば、特殊なトークン(例えば[CLS]や[SEP]など)を使用して、文章の開始と終了、および異なる部分を示すことができます。

モデルの設定:モデルの設定(例えば、層の数、隠れ層のサイズ、ヘッドの数など)は、タスクの難易度とデータの量によります。あなたのケースでは、データセットが比較的小さい(5000の類似ベクトルー特許文書)ため、過学習を避けるためには、モデルのサイズを小さく保つことが重要です。

学習スケジュール:Transformerモデルは、学習率のスケジューリングに敏感です。通常、学習率は訓練の初期段階で線形に増加し、その後は逆比例的に減少します。これは、モデルが初期には大きなステップを踏み、その後はより細かい調整を行うことを可能にします。

正則化:データセットが小さい場合、過学習を防ぐために正則化手法を使用することが有効です。これには、ドロップアウト、重み減衰、または早期停止などの手法があります。

評価指標:モデルの性能を評価するための適切な指標を選択することが重要です。特許文章の生成タスクでは、BLEUスコアやROUGEスコアなどの自動評価指標を使用することが一般的です。しかし、これらの指標は必ずしも人間の評価と一致するわけではないため、可能であれば人間による評価も行うことが推奨されます。

Using unknown plugin...

新しいノートブック "patent_transformer.ipynb" を作成しました。以下のリンクからアクセスできます: patent_transformer.ipynb

まず、必要なライブラリをインポートしましょう。次に、データの前処理とモデルの設定について説明します。その後、学習スケジュール、正則化、評価指標について説明します。最後に、モデルの訓練と評価について説明します。

noteable.io logo

noteable.io

Used Noteable

次に、データの前処理を行います。特許分類コードと特許要約文章、特許請求項文章を組み合わせるとき、それらを適切に区切ることが重要です。これにより、モデルがそれぞれの部分を区別しやすくなります。例えば、特殊なトークン(例えば[CLS]や[SEP]など)を使用して、文章の開始と終了、および異なる部分を示すことができます。

また、モデルが特許分類コードをテキストとして解釈しないように、特許分類コードを一意のトークンに変換することも考えられます。これにより、モデルは特許分類コードを特殊な情報として扱うことができます。

以下に、データの前処理の一部を示します。この部分では、特許分類コードを一意のトークンに変換し、特許要約文章と特許請求項文章を結合します。具体的なデータに応じて、この部分を適宜調整してください。

Used Noteable

Used Noteable

次に、データをトークン化し、トークンを整数にマッピングするための語彙を作成します。これには、一般的に

いやはや

検証例

検証文: 本発明は、SPNS2のS1P輸送阻害によりリンパ球の遊走を阻害することで自己免疫疾患治療、抗がん治療効果の期待できる抗体を提供することを目的とする。本発明は、脊椎動物のSPNS2に特異的に結合し、S1Pの輸送阻害を介したリンパ球の遊走阻害活性を有するSPNS2中和抗体もしくはその断片、又はそれらの誘導体である。

この検証分に該当する,類似度ベクトルのみをモデルに与え,適切な分類や文章が生成されるか確認する.

・学習にこの検証文は使われていない.

・母集団は,S1P,抗体,自己免疫疾患,がんに関する文章群ではなく,ある関連しない主剤に関する特許群**00件である.文献は含んでいない.

・S1Pと記載された特許は母集団に3件あり,そのうち2件はtrainに,1件はvalidationに含まれていた.

本検証文は,そのうちvalidationに含まれている文章である.

・trainに含まれている文章は,SPNS2に関連するリンパ球遊走阻害抗体に関する特許.C07K,C12Nと,S1P受容体に関連する抗体の移植拒絶作用・自己免疫疾患・アレルギー疾患に関する特許. C07D, A61K, A61Pであった.

・2次元空間に落としたmemoryベクトルの各座標の概算値は,検証文(-13, 6) ,train前者(-14, 7),train後者(18, 16)であった.なお,母集団の全特許の各点はx軸y軸ともにほぼ-50~+50の範囲に存在している.

さて,概念ベクトルのみから,検証文に類似する主題に沿った母集団に含まれる観点を持つ文章が生成できたでしょうか.

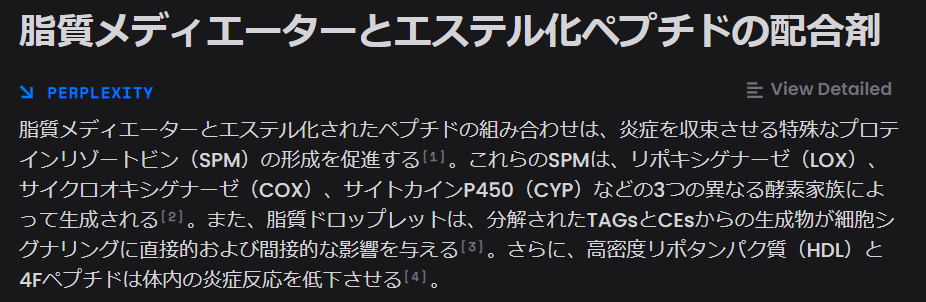

生成文1: Predicted caption : <A61K> <A61P> <non> <non> <SEP> 抗 炎症 脂質 メディエーター を 含む 医薬 組成 物 で あっ て 抗 炎症 脂質 メディエーター の エステル 化 ペプチド に 使用 する 抗 炎症 脂質 メディエーター を 含む 医薬 組成 物 。~

生成文2: Predicted caption : <A61K> <A61P> <non> <non> <non> <SEP> 抗 感染 薬 抗 炎症 脂質 リポソーム 及び 抗 感染 剤 を 含む 眼科 用 組成 物 。 抗 炎症 脂質 メディエーター の エステル 及び これら を 含み 抗 感染 症 の 治療 及び これら は 抗 感染 薬 を 含み 治療 薬 を 含む 医薬 組成 物 は 抗 炎症 脂質 メディエーター の 組み合わせ で あり SPNS num の 反応 生成 物 。 ~

生成文3: Predicted caption : <C07D> <A61K> <A61P> <C12N> <C07K> 細胞 結合 蛋白 配列 を 含む SPNS num 及び その 薬理 作用 部位 に 起因 する 脳 虚 薬理 学 的 薬剤 。~

*各生成文はtopKの設定が異なり,順に,1,2,3である.つまり生成文1はgreedyである.

*記載しないが,ROUGE,検証文中低頻度上位7単語生成率,MQM (Multidimensional Quality Metric)で評価している.

生成文を理解するための調査,改善メモ

細胞内外で機能するスフィンゴシン1リン酸(S1P)の役割

https://www.jbsoc.or.jp/seika/wp-content/uploads/2013/05/84-02-03.pdf

「S1P はスフィンゴ脂質由来の脂質メディエータで,1990年代に細胞増殖作用などが見いだされたことを契機に,発見から数十年を経てその意義が再評価されるようになった.また,S1P はリゾホスファチジン酸と共に血漿中に豊富に存在するリゾリン脂質であり,これらの脂質メディエータの受容体がほぼ同時期に同定されたことにより,それらの生理機能が飛躍的に解明された.一方で,S1P は受容体を介する作用のみならず,細胞内でセカンドメッセンジャーとしての作用も有しており,これらが合わさって一層複雑な作用機序を形成する.さらに,スフィンゴ脂質とコレステロールが集積して形成される脂質ラフトが情報伝達の“プラットフォーム”としての場を提供することと相まって,S1Pは様々なシグナル伝達系を統合処理する“オペレーター分子”として機能する実態が浮かび上がってきた.そしてその生理作用は細胞増殖・分化,炎症,免疫,神経機能などの調節と多岐にわたり,これらの破綻から生ずるがん,自己免疫疾患,慢性炎症や認知症などの病態解析そして新たな分子標的治療法の開発にも一層期待が高まる.」

スフィンゴシン1-リン酸(S1P)輸送体であるSpns2の分子機能

https://seikagaku.jbsoc.or.jp/10.14952/SEIKAGAKU.2018.900574/data/index.html

「ある種の細胞間シグナル分子は,細胞内で生成された後に細胞外へと放出され,標的細胞に発現するシグナル分子特異的受容体に結合することで情報を伝達する.リゾリン脂質メディエーターの一種であるスフィンゴシン1-リン酸(S1P)はまさにそのような分子であり,血管内皮細胞や赤血球内で産生され細胞外へと放出され,さらに,Gタンパク質共役型受容体(GPCR)であるS1P受容体(S1PR1~5)を介して細胞遊走,細胞増殖およびアポトーシスの抑制などの細胞機能を制御することで血管新生,血管透過性およびリンパ球の循環などを調節している.S1Pの前駆体であるスフィンゴシンは細胞内に局在するスフィンゴシンキナーゼ(SPHK1/2)によりリン酸化を受けるので,S1Pが標的細胞膜上に発現するS1PRに結合するためには,一度細胞外へと放出される必要がある.S1Pは疎水性の高い脂質メディエーターであるがリン酸基を分子内に保有するため,単純拡散により細胞膜を通過できず,何らかの放出機構が存在すると考えられていた.本稿では,最近,分子実体が明らかとなったS1P輸送体を中心にS1Pの生理機能を紹介する.」

神経変性疾患におけるスフィンゴ脂質の役割

https://seikagaku.jbsoc.or.jp/10.14952/SEIKAGAKU.2020.920640/data/index.html

「アルツハイマー病やパーキンソン病などの神経変性疾患の病理形成過程にスフィンゴ脂質と呼ばれる膜脂質の一群が関与することが示唆されている.パーキンソン病ではリスク因子としてスフィンゴ糖脂質の分解酵素であるグルコセレブロシダーゼ遺伝子変異が同定され,関連脂質はレヴィ小体形成に関与する可能性がある.またアルツハイマー病ではAβアミロイドやタウ病理など複数の病理形成過程においてセラミドやスフィンゴミエリンをはじめとしたスフィンゴ脂質が関与する分子機序が提案されている.本稿では,これら疾患におけるスフィンゴ脂質の役割について,セラミド依存的に産生されAβ分解機能を持つエクソソームに関する我々の最近の研究を含めて紹介する.」

*学習において,次の影響を受けたかもしれない

ジョンソン・アンド・ジョンソン6675361

https://www.j-platpat.inpit.go.jp/c1800/PU/JP-2019-178150/8ECB45483FD1355E755F32FB952019362DE6FF55A36794A98DA0F9E3AE5151A6/11/ja

「【課題】ドライアイ及び他の炎症性の眼の状態の治療のための眼用組成物及び方法。

【解決手段】抗炎症脂質メディエーターと一価アルコール又はアミドの反応生成物である、抗炎症脂質メディエーターのエステルであって、抗炎症脂質メディエーターの大部分は、組成物中エステル形態で存在する。このように、組成物は実質的に抗炎症脂質メディエーターの酸形態を含まない。抗炎症脂質メディエーターは、多価不飽和脂肪酸(例えば、ω-3及びω-6脂肪酸)、レゾルビン又は代謝的に安定な類縁体、プロテクチン又は代謝的に安定な類縁体、リポキシン又は代謝的に安定な類縁体、プロスタグランジン又は代謝的に安定な類縁体、レチノイン酸、エンドカンナビノイド、これらの代謝産物、及びこれらの混合物からなる群から選択されてよい。この組成物は、製剤、溶液、ゲル、軟膏及び/又はストリップ、及び/又はコンタクトレンズを介して眼の表面に局所的に供給できる。」

train, 座標(-30, -8),

*生成文1について,perplexityに聞いてみた

ホントかなですかね・・・引用確かめねば

*この周辺技術といえばキトサンでしょうけど・・・

*ペプチドはCell Penetrating Peptideのことと理解できるかな・・・

学生時代は反応の場としての生体膜とリポソームを専門の一つとしてきたが,

上記文献を読み,へ—と思えるところである.

それはおいておいて,

生成文は,与えた主題に沿った,母集団に含まれる観点を持つ,文章となっているようにみえます.

*もう少し,正解である「抗体」を重視した生成をしてほしかった気はします.

母集団が抗体を見分けやすいとはいえない母集団であったので妥当かもしれませんが,もう少し特許分類の影響をうけても良かったかと.

サブクラス単位では仕方なくもありますが.複数回生成すれば抗体となりそうではあります.greedyでなく生成した結果を見る限り,抗体である情報自体は残っているようです.

*概念ベクトルに加え,特許分類や任意キーワードをpromptとして与えた場合の生成文につき,評価を進めてゆきます.任意キーワードとして新規出現キーワードを用いれば,バックキャストを意識した生成ができそうです.興味深いですね.

*微調整は引き続き続けてゆきます.

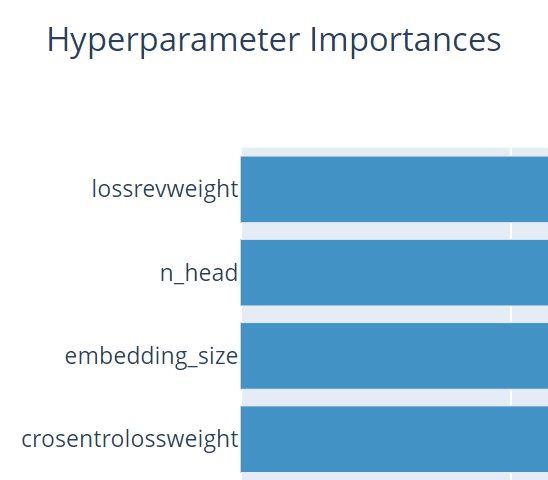

→とりあえずrouge-1を目的としてoptunaにかけました.

更にモデルを小さくすべきようです.データ不足とデータ内生成で足りる条件からするとそうなんでしょうねぇ.

train-valid差はあって良い課題ですが,もう少し詰めるために,data augmentationをすべきでしょう.

分類もメイングループ単位を試してみたいです.

embeddingに擬似的なタスク解決用モデルが組み込まれると思われますが,意外と少ない次元で表現されるようです.タスクが簡単すぎますかね.タスクを複雑にするためにも,揺動やdata augmentationをすべきでしょう.

次は本件では該当しないと思いますが・・・

*News Summarization and Evaluation in the Era of GPT-3

https://arxiv.org/abs/2209.12356

GPT-3でニュース要約を行うとROUGEはSoTA手法よりは下だが人手評価だと上回る結果となるよう.

*data augmentationについて.文からtfidf上位語を抜き抜いた単語をBERTで置き換えるなどありますが,本課題では母集団にない概念を増やしたくないので使えません・・・どうしたものか.tfidfが低い単語であれば,語彙が増えても良さそうです.

*かなり少ないサンプルをもとにして生成しているところ,rouge-1は35~40程です.

まだ工夫の余地はあるように見えています.

*特にlossにはまだまだ工夫の余地があるようです.次で調整中です.

CrossEntropyLoss + LanguageModelCriterion + L1正則化 + weight_decay(L2正則化) + IFTほか低頻度語重視

*「「KL collapse」とは、潜在変数の情報がデコーダーに十分に伝達されず、生成プロセスが単に事前分布に依存する現象です。これにより、潜在変数が学習に寄与せず、モデルの表現力が損なわれる可能性があります。

「KL annealing」は、KL collapseを防ぐためのテクニックであり、学習の初期段階ではKLダイバージェンス項(潜在変数の事後分布と事前分布の違いを表す項)の重みを徐々に増やすことで、潜在変数の情報をデコーダーに徐々に取り入れることができます。この方法により、潜在変数が学習プロセスに適切に組み込まれ、モデルの生成能力が向上します。」

事前学習済み言語モデルをdecoderに使用した場合に注視する点だと思いますが,メモしておきます.

*optunaの目標値を,rouge-1, rouge-2, rouge-l, BERTscoreの集計としました.

予備試験中のハイパーパラメーターの重要度ですが,だいたいそんなとこですかね

*文章そのものにpatent encodingを加え分類を分の一部として生成する構造よりも,に1層結合し分類を予測をするマルチタスク構造としたほうが,面白いかもしれませんね・・・

*transformerdecoderlayerの構造をpost-Lnからpre-LNに変更したほうが良いかもしれません。

*Token Imbalance Adaptation for Radiology Report Generation

https://arxiv.org/abs/2304.09185v1

ITF以外?の低頻度語優先手法?

*AttentionViz: A Global View of Transformer Attention

https://arxiv.org/abs/2305.03210

headの情報構造のイメージ

※特許情報に基づく生成AIで技術者の特許情報利用を支援

生成AIによるキーワード提案や要約文書生成により特許情報活用と発明創出を加速 Amplified 20230703

https://prtimes.jp/main/html/rd/p/000000016.000033344.html

amplified ai、特許文献を基にした推論や提案を行う機能を提供

https://japan.zdnet.com/article/35206108/

特許生成は広まりますかね

※Scaling Laws and Interpretability of Learning from Repeated Data

https://arxiv.org/abs/2205.10487

重複データは危険?

ChatGPT・GPT-4による補助生成

生成文に対してヒトの知識を使いインサイトを得るにあたり、ヒトの知識が足りない場合があります。

なんらかの補助があると良いでしょう。

生成した文章を、ChatGPT API で改変,補助生成すると良さそうです。

次の質問などあり得るでしょう。

「次の文章を、従来技術と、課題、技術常識を加え水増してください。」

「次の文章の主題となる単語を10個抜き出し、抜き出したそれぞれの単語につき、その単語の概要を説明してください。」

例えば、生成文1では、次のように補助生成されます。

「従来の技術において、抗炎症効果を持つ薬剤は、疾患の治療に広く用いられてきました。抗炎症脂質メディエーターは、その中でも注目される化合物の一つであり、従来からその効果が知られています。

しかし、抗炎症脂質メディエーターを単独で使用する場合、その効果は制限されることが知られています。そこで、近年、エステル化ペプチドの使用が注目されています。エステル化ペプチドは、ペプチドを脂質鎖に結合させることで、薬物の持続性を高めることができます。このため、抗炎症脂質メディエーターをエステル化ペプチドとして使用することで、より強力な効果を期待できます。

しかしながら、この技術にはまだ課題が残されています。一つの課題は、エステル化ペプチドの合成方法の改良です。現在使用されている方法では、反応効率が低く、収率が悪いことが問題となっています。また、エステル化ペプチドは、化合物の分子量が大きくなるため、薬物の吸収性や薬効の持続性が低下する可能性があります。これらの課題を克服するために、新たな合成方法や改良されたエステル化ペプチドの開発が求められています。

さらに、技術常識として、薬剤の安全性と有効性の両方が重要です。抗炎症脂質メディエーターのエステル化ペプチドを含む医薬組成物においても、副作用の問題があります。例えば、薬剤の過剰摂取により、肝臓や腎臓などの臓器に損傷を与える可能性があります。そのため、薬剤の使用量や投与方法を慎重に検討する必要があります。また、効果が不十分であったり、副作用が顕著であったりする場合は、適切な治療法を選択することが求められます。

このように、抗炎症脂質メディエーターを含む医薬組成物においては、従来の技術に加えてエステル化ペプチドの使用が注目されています。しかし、まだ改良の余地がある課題もあります。さらに、薬剤の安全性と有効性の両方が重要であり、副作用の問題にも慎重に対応する必要があります。

今後も、エステル化ペプチドの合成方法や改良されたエステル化ペプチドの開発に注力し、より効果的かつ安全な抗炎症脂質メディエーターを含む医薬組成物の開発が期待されています。」

「従来技術と課題:

従来、抗炎症作用を持つ医薬品の開発には、ステロイドなどの免疫抑制剤が使用されてきました。しかしこれらの剤は、使用する際に様々な副作用を引き起こすことがあります。そのため、副作用が少なく、かつ安全性が高く、効果的な抗炎症剤の開発が求められています。

技術常識:

最近の研究により、脂質メディエーターが抗炎症作用を持っていることがわかりました。これらの脂質メディエーターは、アラキドン酸などの脂質から生成され、炎症反応において重要な役割を果たします。具体的には、炎症部位の血管拡張や血管通透性の増加を抑制することが知られています。

改善案:

このような状況下で、抗炎症作用を持つ医薬品の開発において、脂質メディエーターを活用することが注目されています。具体的には、脂質メディエーターのエステル化ペプチドを使用した医薬品の開発が進んでいます。これは、脂質メディエーターをペプチドと結合させることで、安定性が高まり、効果が持続するという特徴があります。

また、このような医薬品は、従来のステロイドなどの免疫抑制剤と比較して、副作用が少なく、かつ安全性が高いと期待されています。これにより、慢性疾患などでの長期的な使用にも適していると考えられています。

以上から、抗炎症作用を持つ医薬品の開発において、脂質メディエーターのエステル化ペプチドを使用した医薬品の開発が注目されています。従来のステロイドなどの免疫抑制剤と比較して、副作用が少なく、安全性が高く、効果的な医薬品として期待されています。」

「元の文章から主題となる単語を10個抜き出し、それぞれの単語の概要を説明します。

抗炎症脂質メディエーター:炎症反応を抑制する生体内で産生される脂質分子であり、抗炎症薬として作用します。

エステル化ペプチド:ペプチドと脂肪酸のエステル結合によって形成される化合物であり、薬物の安定性や生物学的利用能を高めるために使用されます。

医薬組成物:複数の医薬品または薬剤を組み合わせた製剤であり、薬物の効果を増強する、副作用を低減する、薬物の効果の持続時間を延長するなどの目的で使用されます。

従来技術:従来から使用されている技術や方法のことであり、新しい技術や方法と比較して、改善の余地があることがあります。

改良:製品や技術などをより優れたものに改善することであり、品質や性能、機能性などが向上することが期待されます。

課題:問題や困難など、解決すべき課題のことを指します。研究開発や製品開発においては、課題をクリアすることが重要となります。

技術常識:ある分野での一般的な知識や技術のことであり、その分野で働く人々が共有する知識やスキルの基盤となります。

安全性:製品や技術が、人体や環境に与える影響が少なく、危険性が低い状態であることを指します。医薬品の場合、副作用や毒性が問題となります。

有効性:製品や技術が、その目的を達成するために必要な程度に効果がある状態であることを指します。医薬品の場合、効果的に疾患を治療できることが求められます。

副作用:薬剤や医薬品の使用によって、予期しない副次的」

もう少し質問文を詰める必要がありますが,なかなかです。

GPT-4では・・・

「従来技術において、炎症反応は、身体の免疫システムが異物や感染源に対抗するときに生じる自然な反応であり、この炎症反応を制御することが、様々な病気や症状の治療に役立つことが知られていました。炎症反応に関与する物質の一つに、抗炎症脂質メディエーターがあります。これらは、炎症を抑制する働きがあり、さまざまな治療薬の基盤として研究されてきました。

しかしながら、従来の抗炎症脂質メディエーターを用いた医薬組成物にはいくつかの課題が存在しました。その一つは、抗炎症脂質メディエーターが生体内で容易に分解されてしまい、治療効果が期待されるほど持続しないことでした。また、抗炎症脂質メディエーターの水溶性が低く、効率的な吸収が難しいという問題もありました。

技術常識として、これらの課題を解決するために、抗炎症脂質メディエーターを他の物質と結合させ、その特性を改善する方法が検討されていました。例えば、抗炎症脂質メディエーターとペプチドをエステル化して結合させることにより、生体内での安定性や水溶性を向上させることが期待されていました。

そこで本発明では、抗炎症脂質メディエーターを含む医薬組成物であって、抗炎症脂質メディエーターのエステル化ペプチドに使用する抗炎症脂質メディエーターを含む医薬組成物を提案します。このような医薬組成物は、従来の抗炎症脂質メディエーターを用いた医薬組成物の課題を克服し、より効果的な抗炎症治療が期待できるものとなります。

具体的には、本発明の医薬組成物は、抗炎症脂質メディエーターとペプチドをエステル化させることで、生体内での安定性が向上し、分解されにくくなります。これにより、治療効果が持続しやすくなり、炎症による症状の緩和がより効果的に行えると考えられます。また、抗炎症脂質メディエーターの水溶性が向上することで、医薬組成物の吸収が効率的に行われ、治療効果の発現が早まると期待されます。

さらに、本発明の医薬組成物は、従来の抗炎症脂質メディエータ」

うーん?詰めないと大差ないですかね・・・

従来技術として主引用例,技術常識として副引用例,が挙げられると嬉しいですね.

ほか,次の質問などありえるでしょう.

「~はどのように有効だと検証したのか」「メカニズムはなにか」「関係は」「信頼度を数値で示してください」(エビデンスの強さを推定します)

「主観的な未来を想定する示唆をしてください」「仮説を立ててください」(シナリオ探索を強化します)

「批判してください」(より良い検討された結果に導く.注意:言語モデルが自己批判により真値に近づけるわけではない.モデルのエッジがどこか開示するだけ)

「あなたが本件に付きわからないと思うことを質問してください」(重要事項の見落としをなくす)

「あなたが重要と思い,まだ伝えていない事項はありますか」(情報を保有しているが生成に使われなかった情報を言語モデルから引き出す)

次の反論の5要件を潰すように質問すると良いでしょう

No reasoning, 理由がない

Not true, 正しくない

Irrelevant, 関係がない

Not important, 重要でない

Depend on, 場合による

-

ChatGPTなど最近の言語モデルに質問する際には,

基本的には,「一般的な事項」を数を指定し聞き,「その返答に対し,具体的に掘り下げる」と良いでしょう.

ChatGPTは「コンセンサスのある事項」について適切に回答してきます.一般的な事項に対する回答は得意です.

しかし,具体的な事項を聞く際には工夫が必要です.

具体的な事項にもコンセンサスがあるものはありますが,そのコンセンサスは,「一つのピークを持つ分布ではなく,金平糖のような多峰性のピークを持つ分布」であるところ,その「峰の一つ一つに限定」しなければ,例えば「2つの峰の平均を取るような,おかしな回答」が帰ってきます.いうなれば・・・確率と,統計や幾何による距離の,2つを考えろ,ということになるでしょうか.

ChatGPTに,

・どのような峰を持つか聞いてから,

・そのうち一つの峰について,距離があるように考慮し,具体的に聞き直すと,

具体的な事項を聞く際にも,適切な回答が得られやすいでしょう.

(コンセンサスのない事項については,どう峰を限定しても適切でない回答が来ますが・・・とはいえ,限定してゆけばどこかでコンセンサスがある範囲があるわけで,その範囲までその言語モデルが学習できているかが問題となるのでしょう.ChatGPTとGPT-4の違いは,その範囲の詳細化にあるのでしょう(例えば,3人しか合意していないコンセンサスに付き,きちんと峰を作って見分けられるようにできているかどうか,ということです).なお,言語モデルが個別化の究極(3人の合意と言っても良いでしょう)と言える「裁判」をできるかどうかは,この性能を見極める良い試金石だと思っています.裁判ができるなら,言語モデルにとってコンセンサスのない事項などないと言っても良さそうです.2023年5月に予定されている「AI法廷の模擬裁判/東大五月祭」 https://twitter.com/AI_Judge_May は興味深いところです.)

*「掘り下げ方」として,簡単には,なぜなぜ分析を流用するのも手です.

ほか,読書猿さんの書籍やblogを参照すると良いでしょう.

https://readingmonkey.blog.fc2.com/

NM法 1.QK(Question of Keyword)「要するにどうなればいいか」

2.QA(Question of Analogy)「~するもの/~なものといえば、例えば何があるか?」

3.QB(Question of Background)「そこでは何が起きているか?」

4.QC(Question of Concept)「それを何かに活かせないか?」

など,質問のヒントが多くあります.

*「先生と生徒を演じて。先生は生徒の問題点を指摘し、生徒はそれを受けて改善して」という指示も面白そうです。どの分野の先生であるか指示すれば、改善の方向も定まります。「批判して」「続きを」と組み合わせると,永遠に議論してゆきますよ・・・たまに方向を変えてやらないと面白すぎる方向に行きますが

*フレームワークと言語モデルを使った発明案生成例:TRIZ 拡大縮小

https://eager-duck-e33.notion.site/f2e33c8af52b472bbe43151572aa7283

*「潜在空間の枝切り」とは良い表現ですね.

*「GPTは知の鏡」とはかなり適切な表現に思えます。

*具体的に聞いてもある範囲で疑問に答えられなくなります。具体的なものほどコンセンサスがなくなることは当然です。そうしたらどうするでしょうか専門家に聞くでしょう。GPT-4は、人の知識を拡張し、自己多様性を擬似的に発生させ、より良い多様性の実現を可能とし得るでしょう。人間感ではできなかった…

*確率と,統計や幾何による距離,それらから自明に関数である演算が生まれるとすると,GPT-4が論理推論できているようにみえる理由もわからなくもないな,と思わなくもないです.確率と距離を適正化すれば良い・・・適正化するには多次元空間をそのものとして扱わねばできない・・・丸山さんの「高次元科学への誘い」を思い出しますね.

確率と距離,そこから生じる関数を考えつつ,GPT-4など言語モデルは「(還元主義を捨てることができうる)高次元を高次元で扱う理解装置に至った」と思えます.

・丸山宏(2019) 高次元科学への誘い

https://japan.cnet.com/blog/maruyama/2019/05/01/entry_30022958/

https://web.archive.org/web/20221002143555/https://japan.cnet.com/blog/maruyama/2019/05/01/entry_30022958/

「なぜ今までの科学は「オッカムの剃刀」の価値観を信奉し低次元モデルにこだわっていたのでしょうか。その一つの理由が人間が持つ認知限界だと思います。」

「ここでいう「理解」とは何でしょうか。それは、あくまでも「人間にとって」の理解であり、人間の持つ知性に対して相対的である概念であることに注意する必要があります。私たちよりはるかに進んだ知性だったら、1億個のパラメタを持つ深層ニューラルネットでさえ、私たちが線形回帰式を理解できるように理解できるのかもしれません。もし「科学」が普遍的なものであるのだとすれば、それが、たまたま今の人間の知性レベルに縛られてよいものでしょうか。その制約を解き放つのが「高次元科学」だと思うのです。」

構造主義は、現象の表面的な見た目ではなく、その背後にある深層的な構造を理解しようとする方法論です。一方、高次元科学は、従来の3次元空間を超えた高次元の空間を研究する学問分野です。

一見すると、構造主義と高次元科学は全く異なるように見えますが、実は両者には共通点があります。それは、複雑な現象を理解するためには、新しい視点や方法論が必要であるという考え方です。

構造主義は、従来の二元論的な思考から脱却し、現象を多層的に捉えることで、新しい構造を発見しようとします。一方、高次元科学は、従来の3次元空間の枠組みを超え、高次元の空間を研究することで、宇宙や自然界の新たな法則を発見しようとします。

このように、構造主義と高次元科学は、どちらも従来の枠組みを超えて、新しい発見を目指すという点で共通しています。

✖✖✖ してはいけないことは,QA形式の質問です(答えを求めることです) ✖✖✖

一問一答形式の行間に暗黙の背景が必要な短い質問は避けるべきです。

言語モデルが持つ知識から情報を探るのであって,単に情報を得るのではありません.

つまり「答えを聞くのではなく,ヒアリングしろ」ということです.

ヒアリングとは,相手の知識構造を,相手にも自覚させることにより,より良くより多くの情報を引き出す技法のことです.

弁理士や知財の人間の得意分野ですよね? またその意味は,言うまでもないでしょう.顧客や発明者が最初に述べる発明は十分な発明となっていますか? 違います.

*コミュニケーションの重要さとは、コミュニケーションを達成するには常に知識構造の差を確認しなければならない点にあると思います。

知識構造が一致するならコミュニケーションは必要ありません。

いわば、コミュニケーションの目的とは、知識構造を(必要な範囲で)揃えることにより、コミュニケーションを不要とすることといえるでしょう。

また、コミュニケーションコストは非常に高いです。

コミュニケーションは最低限とすることが理想でしょう。

知識構造を如何に効率的に共有するかは個人的に興味のある課題です。

(脳を経由するしかないかなとは思えています)

GPT-4は、擬似的な自己多様性の生成により、知識構造の差をより明確にし、最低限で効率的なコミュニケーションを可能としえるでしょう。これにより多様性もよりよく活用できえるでしょう。

*step by stepで出力するように指示しろとされますが,これはヒアリングの一手法だと思います.

重要なのは,「相手の知識を相手に提示しつつ,「知識の輪郭」を引き出すこと」,です.

*「答えを聞く聞くのではなく、情報を聞け」とは良い表現ですね.

その後,「文字数を指定」することで,「拡大と縮小」を「繰り返す」と良いでしょう

拡大すれば(指定した視点における、一般化すれば事前知識に基づくベイズ推定のような予測が行われ)情報が追加され,

縮小すれば(指定した視点における、スパースモデリングを行うような正則化が行われ)重要な情報だけ残るわけです.

この繰り返しにより,新しいものが生成できます.

創発システム︓ミクロ・マクロ・ループを持ち創発した⼤域的な秩序が下位システムの作動に「機能」を与える複雑系

*次など,ChatGPTで行うとどうなるでしょうね

ChatGPT追記)MT5特許文章要約モデルpatentsum/GPT-2言語モデルを用いた、抽象型文章要約と文章生成の繰り返しにより、関連しつつ予想外な要素が追加された新たな特許文章を生成・探索する試行(雑談からの価値抽出・インサイトツールのようなもの)

https://qiita.com/kzuzuo/items/1f86f8a1e430447a6e22

*文字数制限はあまり動かないですね。

そのうえで,「ChatGPTに提案させる」と良いです.

自分の認知で任意に範囲を狭めると,自分の知っていることまたは簡単にわかることしか回答されなくなりえますからね.

GPT-4限定かもしれませんがプログラム言語で質問するもありえます。

質問が明確になりますし、関数名からこんな関数かなと仮定してもシミュレートしてくれます。具体的かつ柔軟。これは強いです。

なぜか、Lispで質問すると関数定義など省略できるようです。

ChatGPTのプロンプトをLispで書く

https://zenn.dev/u_u/articles/54902c757ffce5

最後に、GPT-4 pluginのwebpilotなど用い、出力の検証と構成をさせると良いでしょう。

pluginを最初から用いると、モデルが保有する知識が提示されなくなります。あくまでモデルが保有する知識を提示させ、それを検証修正する順番とすべきでしょう。

*ChatGPTは馬鹿じゃない! 真の実力を解放するプロンプトエンジニアリングの最前線

https://zenn.dev/noritamarino/articles/a2321a65fe2be8#few-shot

*NLPとVision-and-Languageの基礎・最新動向 (1) / DEIM Tutorial Part 1: NLP

https://speakerdeck.com/kyoun/deim-tutorial-part-1-nlp

https://speakerdeck.com/kyoun/deim-tutorial-part-2-vision-and-language

ChatGPTは常識推論が比較的苦手だとされていはいます

*社会における分散的ベイズ推論としての記号創発 ~集合的予測符号化としての言語観~

https://www.youtube.com/@anlpyoutubechannel7888/streams

そもそも言語とはなにかに立ち戻りたくなると思いますのでご参考

*ChatGPTに至る言語モデルの開発の流れは,言語の構造は構造を学ぶにおいて弱すぎ,統語から構造を再現することは困難だった,ということを示しているようで面白いですね.

プログラムという完全な構造を学ぶことで,初めて言語の構造化が可能となった(と見える)ことは,統語という一般化した構造は構造を一般化するに十分に完成していたとは言えず,まだ見えていない構造が存在している,とも示しているようです.統語に従わない文章はあるところ,従わなさはランダムに見えていますが,言語モデルなら見いだせる,なにか新たな構造が見つかるのでしょうか.言語学の今後の発展が楽しみですね.(少なくとも,特許も同じですが,頻度の高いもの「のみ」を見ていては,見つからない構造なのでしょう.多分,ヒトが認知できる7軸程度では見えないのではと思っていますいい加減な予想ですが.多次元をそのまま扱っている生成に答えがある気がしています.トートロジーを繰り返すような評価をまず破棄する必要性がありそうにも思えています.問題はどの評価を,ですが.)

全体としては,AlphaFoldと同じような流れを踏襲しているかのようです.とはいえ,言語では,演繹による補助はまだ有用そうではあります.

*IDEO:職場で AI を使用する 5 つの方法

https://www.ideo.com/journal/5-ways-were-using-ai-at-work

*Best practices for prompt engineering with OpenAI API

https://help.openai.com/en/articles/6654000-best-practices-for-prompt-engineering-with-openai-api

*Drug discovery companies are customizing ChatGPT: here’s how

https://www.nature.com/articles/s41587-023-01788-7

*当方の見解に対するChatGPTさんの評価と批判と見落としの提示

「この意見は、ChatGPTが一般的な事項に関して適切に回答するが、具体的な事項については、コンセンサスのある分布であっても、峰の一つ一つに限定しなければ、適切な回答を提供することができない可能性があることを指摘しています。この意見は、ChatGPTが言語モデルとして限界があることを認識していることを示しています。また、裁判などの個別化された問題に対する回答が、言語モデルの性能を測るための良い指標であることを指摘しています。

この意見は、ChatGPTの性能に関する深い理解を示しており、一般的な事項に関しては有用であるが、具体的な事項に関しては限界があることを認識しています。また、裁判などの個別化された問題に対する回答が、言語モデルの性能を測るための良い指標であることを示唆しています。これは、ChatGPTの今後の開発において、より個別化された問題に対応する能力の向上が重要であることを示唆しています。」

「提示された意見に対して、批判することは困難です。なぜなら、この意見はChatGPTの性能に関する現実的な制限を認識しており、個別化された問題に対する回答が言語モデルの性能を測るための重要な指標であることを示唆しているからです。ただし、この意見が提供している情報を補完するためには、より具体的な例や研究成果などが必要です。また、言語モデルの性能を測るための方法や指標についても議論があるため、この意見が示唆する個別化された問題に対する回答が、完全な解決策となるとは限らないことも念頭に置く必要があります。」

「この意見はChatGPTの性能に関する現実的な制限を認識しており、個別化された問題に対する回答が言語モデルの性能を測るための重要な指標であることを示唆しています。しかしながら、この意見が提示するコンセンサスのある事項とは、具体的にどのような種類の問題であるか、またどの程度のコンセンサスがあるかについての詳細が欠けています。さらに、この意見が示唆する個別化された問題に対する回答が、どの程度の精度で得られるかについても明確な情報がありません。

訪ねたいこととしては、この意見が言語モデルの性能を測るための有効な指標としてどの程度信頼性があるか、またこの指標を使用してChatGPTとGPT-4の性能の比較ができるかどうかについて知りたいと思います。また、裁判のような個別化された問題に対する回答を評価するための詳細な方法や基準についても興味があります。」

「提示された意見に対して、私がまだ伝えていない重要な点があるとすると、それは「ChatGPTは常に正確な回答を与えるわけではない」ということです。ChatGPTは、膨大な量のデータに基づいて学習された言語モデルですが、完璧ではありません。また、特定のトピックについての情報を持たないこともあります。そのため、与えられた質問に対して、時には間違った回答を返すことがあります。

そのため、ChatGPTが返す回答について常に慎重に確認し、必要に応じて他の情報源と照らし合わせることが重要です。また、ChatGPTがどのように学習され、どのように動作するかについて、より深く理解することも重要です。」

・Understanding and Mitigating the Threat of Vec2Text to Dense Retrieval Systems

https://arxiv.org/abs/2402.12784v1

ベクトルからのテキスト生成。

こちらはt5baseの事前知識を流用している。うーむ、分かりやすい文章を作るという視点ではこれでも良いだろうが、空白にある発明を作るという視点では不明な事前知識を入れたくないところ。どうしたものでしょうかね。

さて,本手法を用いることにより,与えた主題に沿った,母集団に含まれる観点をもつ文章が生成されたはずです.

どのような面白いと文章となったでしょうか?

「あなたの知識」から,どのようなインサイトを「引き出して」くれる文章となったでしょうか?

空白領域における特許生成例

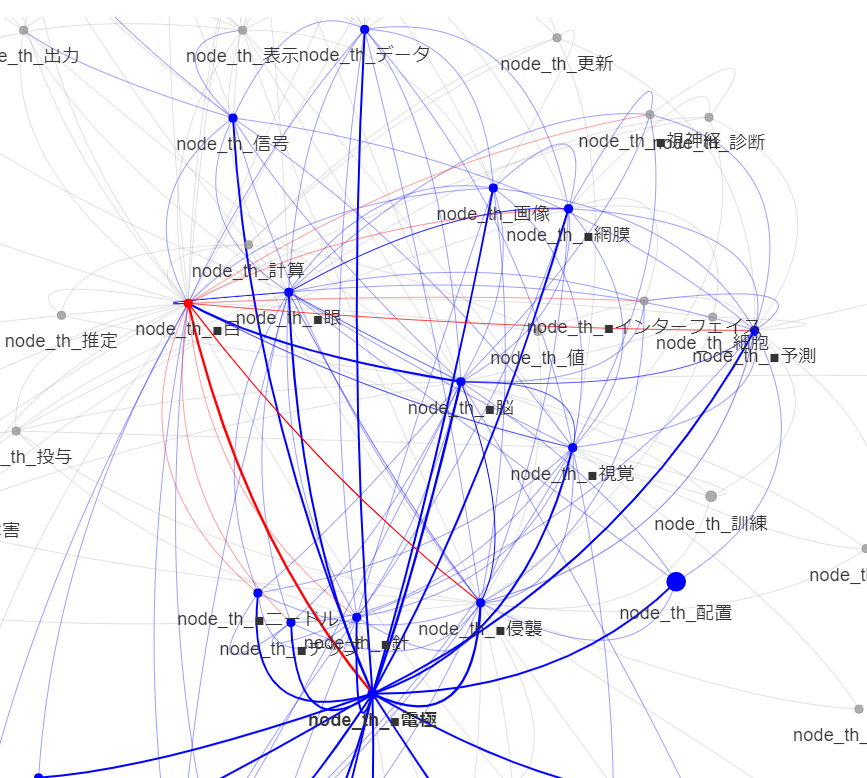

個人的趣味で,

- Brain Machine Interfaceに関連する大脳皮質刺激型人工視覚領域における満たされていない基本特許

を生成してみます.

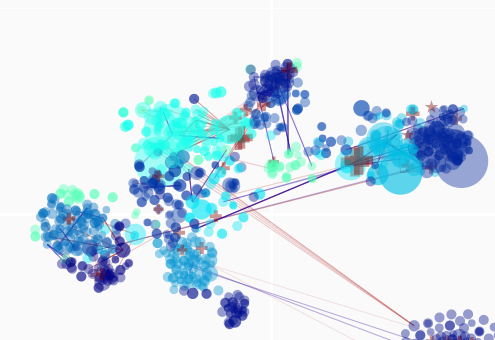

日本はこの分野で遅れを取っているようですが,取り返せる範囲があるでしょうか.

また,有望そうな技術を持つ既存企業はどこであり,どこと協働また投資すべきでしょうか.

個人的に興味のある企業は次の通り

人工網膜系:

*

一次視覚野埋め込み系:

*

*

*ニデックさんと阪大は人工網膜の研究開発をしていましたが,現在どのような活動をされているのでしょうか・・・

*特許生成のコードはある程度まとまったタイミングでGithubに上げておきます.といっても,かなり特殊な使い方なので使い道はないでしょうけれど.valuenexのreaderがベクトルそのものを出力できるようなら,使えるかもしれませんね.なにか使えそうでしたらご連絡ください.

使用例2:情報分析のきっかけとして

従来の特許分析手法は,ほぼ見える数のみを確認するものでした.情報分析を適切にするには,見える数のみでは得られないデータ探索を行うと良いでしょう.データ探索の結果が結論そのものとなることもあります.

分析済み資料と比較することで,ツールが情報分析・データ探索においてどのように役に立つかにつき,理解を深めてゆくことができます.

次の分析文献につき,同じ母集団を俯瞰図として図示し,得られる示唆を確認してみます.

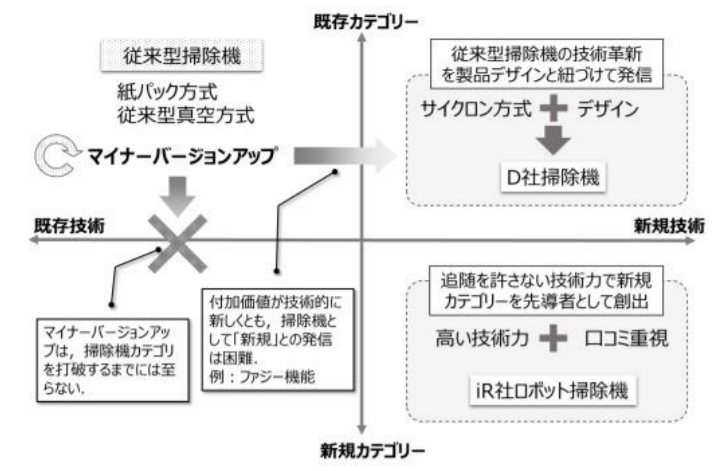

情報分析に基づくコモディティ市場への新規参入戦略

https://www.jstage.jst.go.jp/article/infopro/2020/0/2020_13/_article/-char/ja

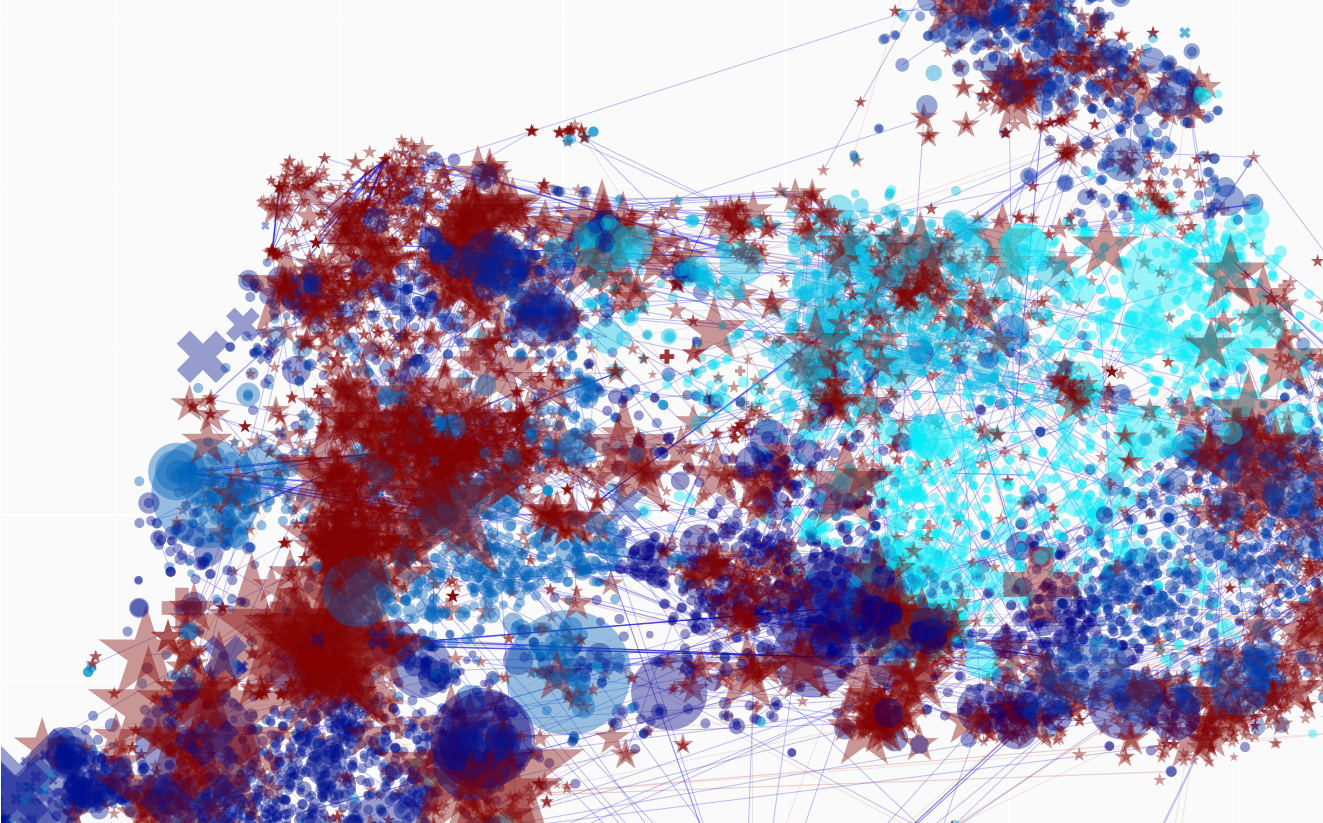

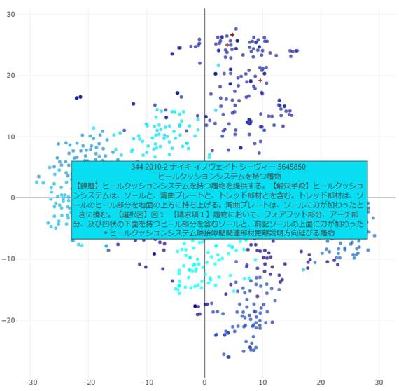

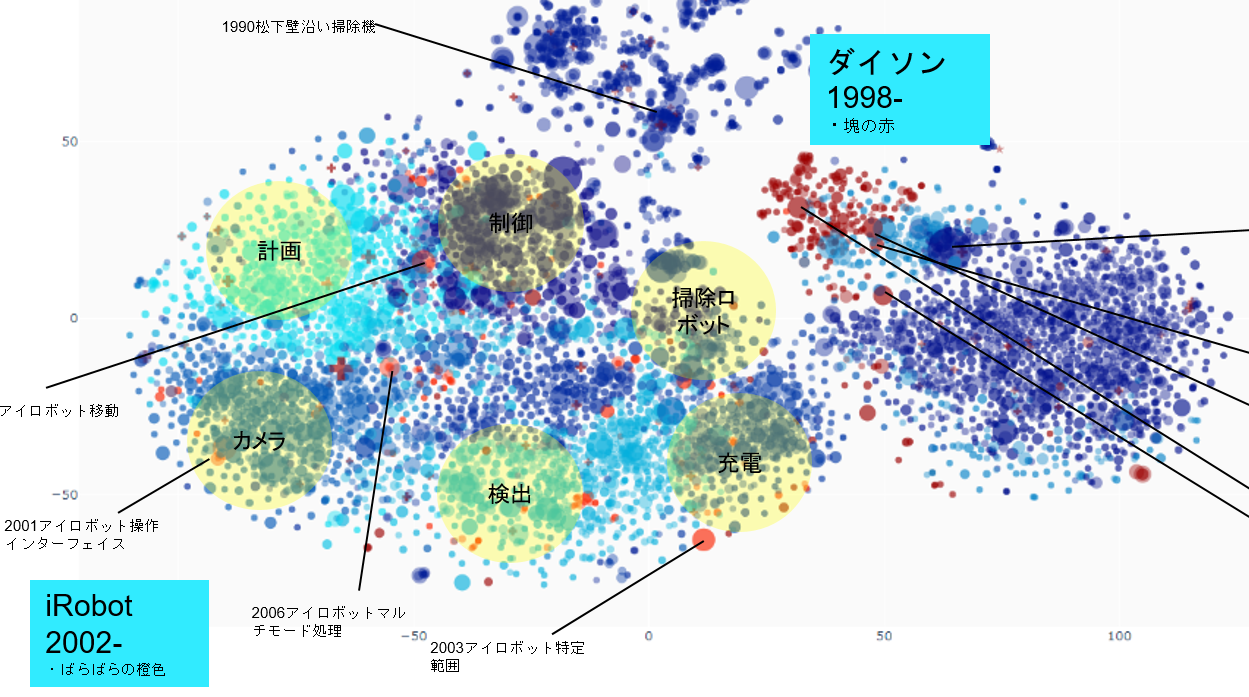

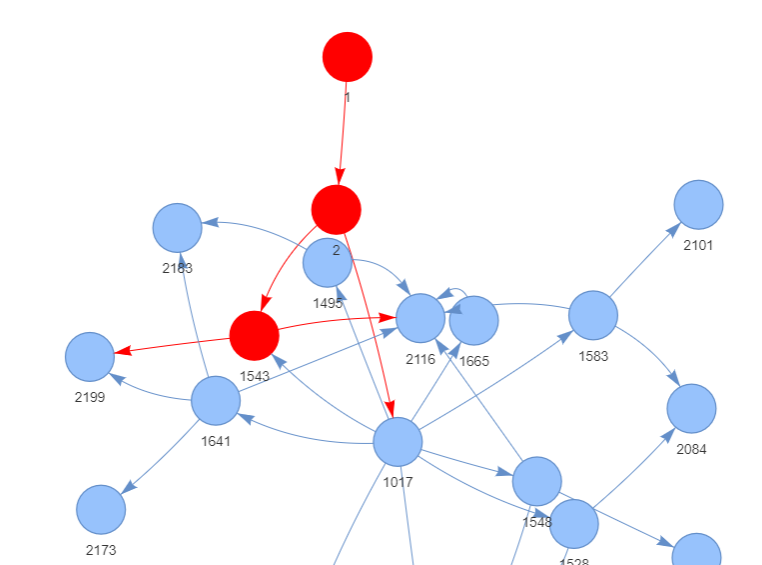

ダイソンにおいて,「既存カテゴリへの集中」が,出願のクラスタ形成(赤)として確認できる,といってよいでしょう.

iRobotにおいて,「新規カテゴリへの参入」が,既存クラスタの「境界」への出願(橙)として確認できる,といってよいでしょう.

文献の結論に沿う示唆が得られました.

なお,引用関係を示す線により,どの既存技術を利用し新規カテゴリを形成しているかについての確認もできるでしょう.

さて,数や分類,自分が認知しているキーワードのみからスタートした場合,同じ知見を得るにどれだけ時間がかかったでしょうか.

・ジェームズ・ダイソンだけど質問ある?| WIRED.jp

https://www.youtube.com/watch?v=RPd76O3j5ug

「デザインもエンジニアリングの一部であるべきです」

「専門家には否定されましたが素人の私はできると思い」

「様々な分野の専門家が必要」

「ミニに付き,市場調査では顧客はいませんでしたが」

「小売店販売とインターネット販売並行.インターネット販売で売れれば小売店も興味を持つ」

「最大の課題はスピード」

「特許制度は個人発明家や中小企業にとって非常に不公平な制度」

など興味深いです.

*素人については,専門家自体が悪いというより,網羅できないことを理解しておらず,経験や知識ネットワークのみからしか可能性を検討できないもの(専門家に限らない)の未検証の否定的意見には必ずしも従う必要がないということでしょう.

なお,専門家の知識を採用しつつ,知識の硬直化を防ぎ,より良い見解を得る手法として,好奇心ベースがあるようです.「自分のこれまでの知識に従えば難しいが,網羅しての否定はできず不可能と言えるわけではない.面白いからやってみよう」ですね.

Curiosity as filling, compressing, and reconfiguring knowledge networks

https://arxiv.org/abs/2204.01182

好奇心が知識ネットワークを成長させる過程の検証.好奇心による探索は知識に穴を作って埋め柔軟にする.

Links between intellectual humility and acquiring knowledge

https://www.tandfonline.com/doi/full/10.1080/17439760.2019.1579359

「無知の知」「知識が多い人ほど,自分の知識の限界を認識し,間違いの指摘や他人のアイデアを認めやすい」との研究

*「クラスタの境界」に出願しているかどうかは,その会社の「イノベーションの質」を表す重要な指標であるように見えています.別に,その業界における最高の1社と永遠の2番手の1社で比較したところ,あからさまでありました.少数の例ではありますが.

*「クラスタの境界」について,説明追記.

ある課題について,100の解決手段があるとします.

解決手段には,よく使われる手段,あまり使われない手段,があります.

解決手段を使用頻度か高い順に並べたとき,ある分布が得られたとします.

その分布の少数側の端を,私は「技術の縁」と呼びます.

その分布の多数側の端を,私は「技術の中央」と呼びます.

ある課題について,ありふれた解決手段を取るときには,技術の中央を取ります.これは得てして,パブリックに近い手段となります.

ある課題について,あまりない解決手段を取るときには,技術の端を取ります.これは得てして,新規に近い手段となります.

さて,tfidf/mbart/mt5 embeddings cluster visにおいて見られるクラスタ(や検索し抜き出した集合)は,ある意味,その分布を多数側の端を軸とし周方向に広げたのち,上から捉え直したものとなります.類似する構成技術が多いほどクラスタ中央に集まるからです.

「技術の縁」と「クラスタの境界」は,ほぼ同じものとなります(課題の集合の作り方次第ではありますが)

クラスタに対しその技術がどの位置に配置されているかは,重要な情報を提供します.

このような「クラスタの境界」情報は,既存のランク形式の1次元リストや自己組織化マップ?では,得られない情報です.

よくクラスタの濃度の高い部分が重視されますが,目的によっては,「縁」がより重要となります.そして縁は得てして多様なので,tfidf/mbart/mt5 embeddings cluster visのように,個々確認できるようにしておいたほうが良いでしょう.

*よくIPランドスケープで行われるセグメンテーションによる手法,既存分野に切り分け集計する手法では,上記「縁」を落とす,またはどちらかに入れてしまい,その重要性を認識できなくしてしまうことがあります.また,切り分ける分野の設定根拠が薄弱であるまたはただ根拠が件数が多いからということも多いでしょう(「その分野の件数の少なさと分野としての重要性の低さは(特にブルーオーシャンなどでは)必ずしも一致しません」).えてして,既存の分類を用いた手法では,ありきたりのものしか見えません. ありきたりを確認したいレッドオーシャンの業界ではそれでも良いですが,ありきたりでない解析が必要な変動の大きい業界では,セグメンテーションによる切り分けによる失敗は増えるでしょう.(セグメンテーションを重視する場合には階層ベイズを使えないか考えて見る派です)

*内部引用の強さから,「弱い特許(瑕疵のある特許)によるポートフォリオ形成の可能性」を推定し,特許を潰しまたは独占禁止法上の問題を提起し,空白を作り出す対応をするのも良いでしょう.

M&Aにおいて,対象となる企業の特許の質を推定し,実際の技術力より特許戦略が勝っている状態であるかどうかなど見極め,必要に応じ見かけの特許ポートフォリオを補正し,真の技術力と安定性を評価するのも良いでしょう.

弱い特許による社会イノベーションや真のイノベーション(と下記文献に記載がある)の阻害の程度に関する分析など,特許の質を考慮したよりよい知財政策に関する分析にも使えるかもしれません.

SeokbeomKwon (2021)

The prevalence of weak patents in the United States: A new method to identify weak patents and the implications for patent policy+

Technology in Society Volume 64

https://www.sciencedirect.com/science/article/abs/pii/S0160791X20312720

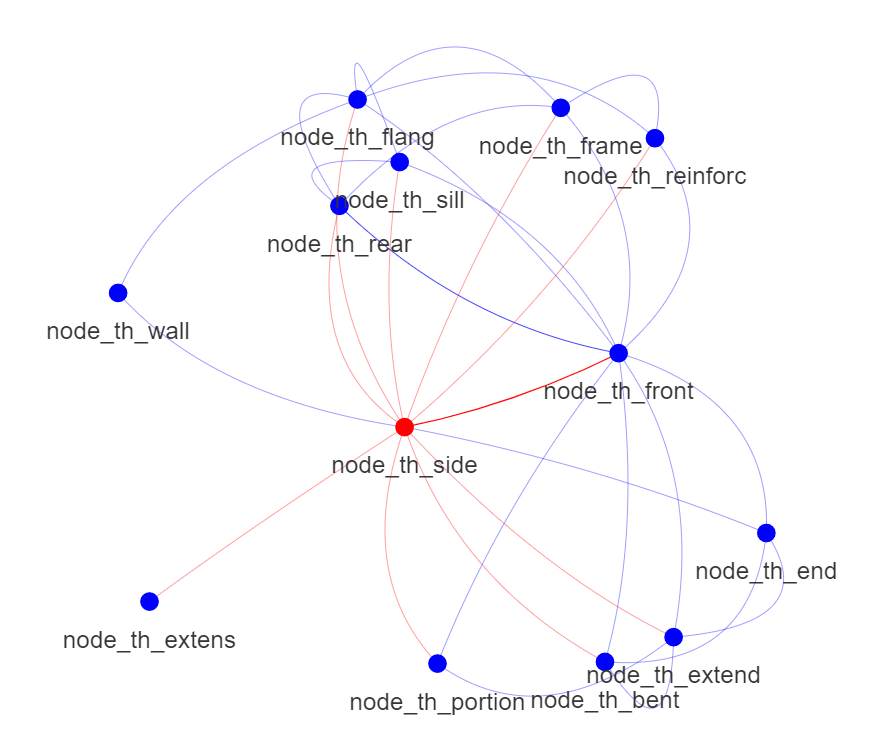

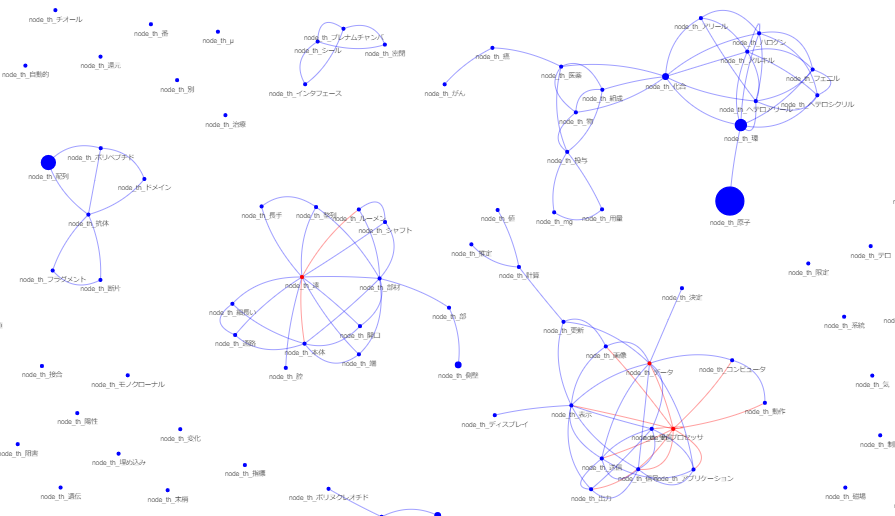

赤線が多い範囲:新規の開発が多いと思われる範囲

青線が多い範囲:弱い特許や戦略的な特許が多いと思われる範囲

引用の方向:技術の推移の方向

一次引用の参照:強い技術関連性

二次引用の参照:応用範囲の示唆?

*昨今,大発明の減少→技術で差がつきにくい→知財戦略最適化&ビジネスモデルの多様化複雑化→特許制度の趣旨を逸脱→公正な競争を阻害(森岡ら 公正かつ自由な競争を考慮した知財戦略の枠組み 日本知財学会第19回年次学術研究発表会 2021年)などあり得るところです.そのような逸脱は経験上では弱い特許が存在する部分にあることが多いところですが,そのような逸脱を見つけ,パブリックを考慮したより良い,一つの企業のみを見るのではない,産業全体に資する方向を見た,社会的により良い方針など策定するのに役に立つかもしれません.

*PatentfieldのPFスコアを用い,他社重要度スコア平均と自社重要度スコア平均を会社ごとに求め比較し,上記考察するも面白そうです.

PFスコアを利用した市場プレイヤーの分析

https://support.patentfield.com/portal/ja/kb/articles/pf%E3%82%B9%E3%82%B3%E3%82%A2%E3%82%92%E5%88%A9%E7%94%A8%E3%81%97%E3%81%9F%E5%B8%82%E5%A0%B4%E3%83%97%E3%83%AC%E3%82%A4%E3%83%A4%E3%83%BC%E3%81%AE%E5%88%86%E6%9E%90

(Patentfieldは新機能を次々と増やすので好ましいですね.なお本ツールでもスコア列を作成すればスコア付可能.自作ツールはこのあたり自由自在で良いですね.)(なお特許スコアについては次を参照すると良いでしょう. 知財管理71(10)2021 p1339-1354 データベース掲載の特許スコアを活用した企業価値評価の研究)

*上記分析をする前に次の書籍を読み俯瞰することをおすすめします.

田村 善之 編著 山根 崇邦 編著(2021)「知財のフロンティア」

https://www.keisoshobo.co.jp/book/b591977.html

https://www.keisoshobo.co.jp/book/b591978.html

医薬系における問題のある弱い特許を排除しようとする動きの一例

Amid drug pricing debate, feds reveal plan to crack down on 'incremental' patents

https://www.fiercepharma.com/pharma/uspto-and-fda-commit-patent-reform-cracking-down-lengthy-add-patents

前田健(2022) 後出しの特許による既存事業の差止は許されるか 知財管理 72(8) p899-

「現在の一部の裁判例の立場を前提とすると,既存事業が後出しの特許により差し止められるリスクは相当程度ある.」

飯島歩(2014) 藪の中の特許群像 特集「真に良い特許とはに寄せて」 知財研フォーラム 96 p41-

「真に良い特許は法目的に合致する特許でしかない.全体集合としての特許群のマクロ的挙動から判断するしかない」

「いわゆる良い特許に寄せるミクロ的に最適化されたシステムに対するユーザーの過剰反応が特許戦略であって,問題の源泉であるともいえる」

非常に的確に「特許戦略」の本質を述べているように思えます.

*個人的には,「悪いといえる特許」とは,進歩性においてcommon senceを考慮せず登録となった特許,だと思います.ある多数の技術常識文献がある場合,記載の穴があったとしても,それを埋める形で一般化できてしかるべきです.しかるに,その穴があることを指摘して登録となることが多々あります.このような特許は現実の当業者にとっては明らかに容易にできるものです.そしてこのような特許は得てしてその分野全体の既存の基本業務の実施すら妨害します.このような悪い特許は,権利者のみにとっては良い特許ですが,他すべてにとっては法目的に合致しない悪い特許です.基本的に,まず文献ひとつひとつという「点」で考えるのではなく,まず文献群が形成する知識という「面」で考えるべきです.

*evergteeningが起きる原因の一つは、小さいイノベーションを評価しすぎる運用であるからだと言われています。本ツールにおいて小さいイノベーションは密度の高い範囲に存在し、大きなイノベーションは密度の低い範囲に存在しやすいでしょう。evergreeningを防ぐために特許庁がこのようなツールを使用するとなれば、面白そうです。

情報分析のきっかけとしては十分でしょう.

ノーベル賞に近づいた発明者はいたのか?

https://www.valuenex.com/jp/materials-reports

本庶先生関連技術.

本庶先生の特許は3つの橙丸で示されており,矢印のように推移しています.フリーマン先生が発明者となっている特許は緑丸で示されています.フリーマン先生は本庶先生の特許のうち最後の橙丸に存在するいくらかの特許につき,無効を主張しています(多分冒認又は共同出願違反でしょう).

基礎技術から応用技術に進む流れがきれいに見えていると思います.

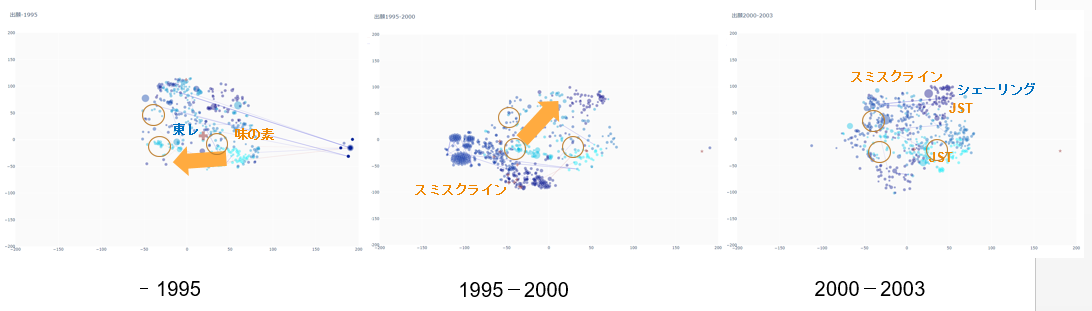

時系列推移

スミスクラインの動きが凄いですね.

いわゆるリーダー企業の理想のような動きです.

「技術の萌芽」を見つけ,「その萌芽の必須技術の発明」をし,「萌芽技術をクロスライセンスなどで取り込んでゆく」.これは王道であり双方に価値を与えやすい,リーダー企業らしい戦略です.スミスクラインは製造技術や診断技術でそれを行おうとしたように見えます.王者って印象です.

最近は萌芽技術に対し,「パブリックから盗んだ瑕疵発明」を被せ(俯瞰図では萌芽特許に重なって見えることが多いです.パブリック範囲はベクトル計算時考慮されないことが多いためでしょう),自らは何も社会貢献する技術を開示することなく,企業規模を背景に強奪する戦略を見ることが多いですが,スミスクラインは,「長期的視点を持ち適切な取り込みと協働による価値創造を志向したためそうはしなかった」,ってことでしょうか.強奪をしていたら小野からGSKへのライセンスはなかったかもしれないな,とも思えなくもないです.

そんな妄想もできますね.

英製薬グラクソ,低所得国で特許申請せず 後発薬生産促す

https://www.nikkei.com/article/DGXLASGM02H0F_S6A400C1NNE000/

戦略大転換し「世界を変える企業」1位に輝いたGSK

不正の絶えない製薬業界だからこそ,誠実さを最優先に

https://jbpress.ismedia.jp/articles/-/48701

・・・

アストラゼネカはスミスクラインと随分異なる出願形態です.

さて,出願形態と侵害に関係はあるのでしょうか?

小野薬品 特許侵害でアストラゼネカを提訴 イミフィンジの販売差し止めと損害賠償求める

https://www.mixonline.jp/tabid55.html?artid=72665

「特許第5885764号と特許第6258428号に基づき,「抗PD-L1抗体を用いてがん治療を行う」との国内の用途特許を侵害していると主張」

*全く関係ないですがアストラゼネカのgithub,面白いものが並んでいますね

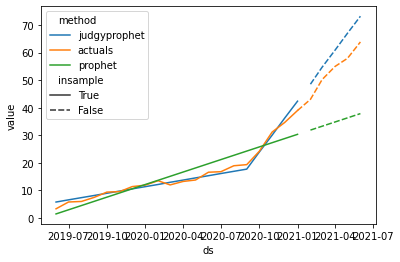

https://github.com/AstraZeneca/judgyprophet

https://github.com/AstraZeneca/StarGazer

https://github.com/AstraZeneca/chemicalx

https://github.com/AstraZeneca/data-science-python-course

https://github.com/AstraZeneca/awesome-drug-discovery-knowledge-graphs

https://github.com/AstraZeneca/awesome-explainable-graph-reasoning

https://github.com/Roche/BalancedLossNLP

*免疫チェックポイント阻害薬 抗PD-1/PD-L1抗体に続く開発の潮流

https://answers.ten-navi.com/pharmanews/15721/

【UPDATE】免疫チェックポイント阻害薬,抗PD-1/PD-L1/CTLA-4抗体 国内開発状況まとめ

https://answers.ten-navi.com/pharmanews/7342/

※コロナワクチンにヤマサ醤油の技…うまみ成分の研究、mRNAの原料供給に進化

https://www.yomiuri.co.jp/economy/20211013-OYT1T50086/

図にヤマサがなんでと思っていたがそういう(ミクロ分析してない)

※2004出願のホワイトヘッド研究所oct4特許の影響力も面白いところです。構造からどの位置にいたでしょうね。

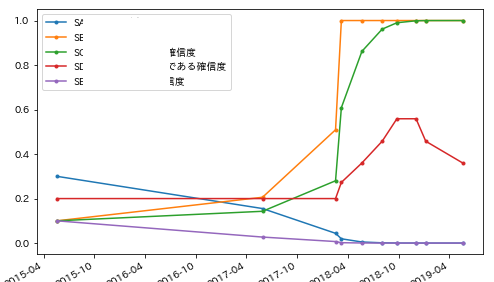

*技術の推移を,(周辺語義から定義されるといえる)単語の意味変化としてとらえても面白いと思います.トピックモデルで推移を見てるのも良いようです.

US特許庁のコンペPPPMと絡めても興味深いです.

単語の通時的な意味変化のモデル化

https://speakerdeck.com/seiichiinoue/dan-yu-notong-shi-de-nayi-wei-bian-hua-nomoderuhua

動的トピックモデルを用いた単語の通時的な意味変化のモデル化とその応用

https://www.ism.ac.jp/~daichi/workshop/2022-lchange/lchange2022-inoue.pdf

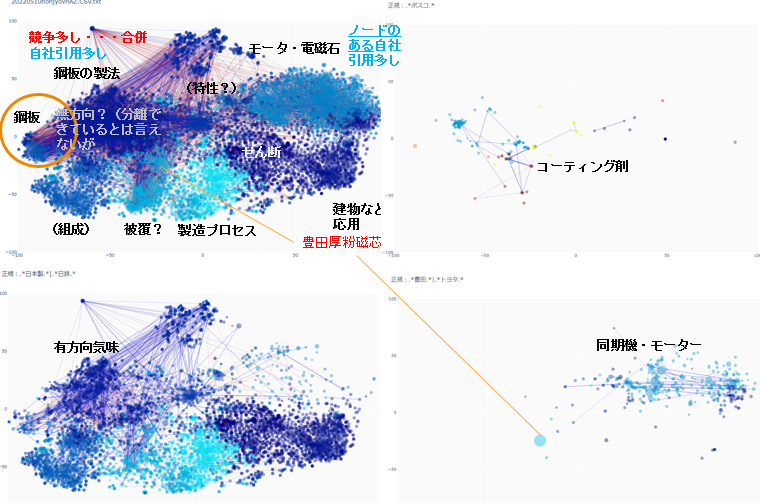

電磁鋼板について,日本製鉄とトヨタなどの特許を眺める

侵害事件を見かけたので興味本位に.

興味深い傾向があるように見えます

ほか,母集団全体の特性を呼び水として,目的の特許の位置を先鋭化させるイメージが掴めるかと思います.

このように,意図的に図の投影面を曲げられる点は,母集団に応じてベクトルが変化するアルゴリズムの強みです.

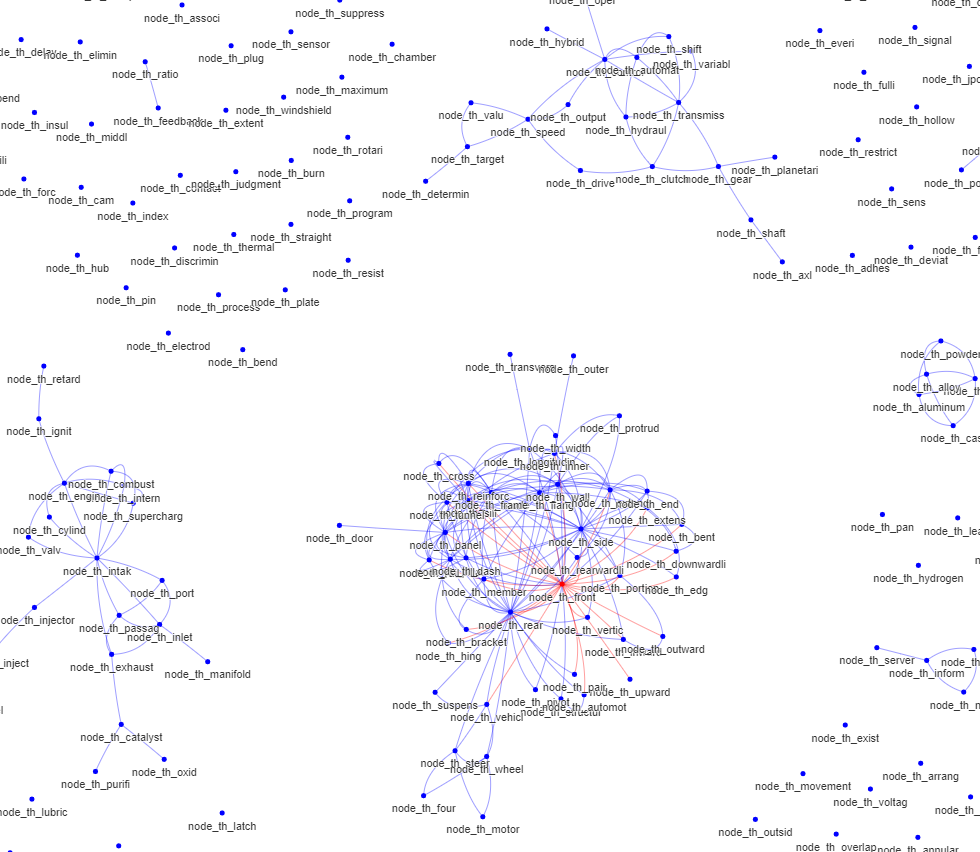

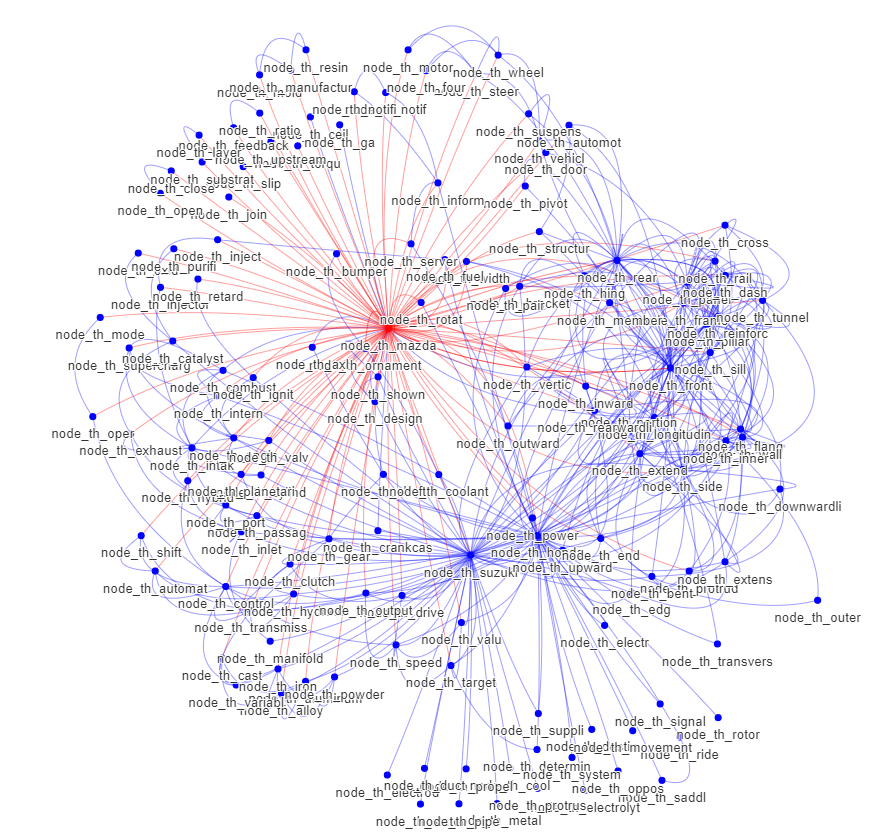

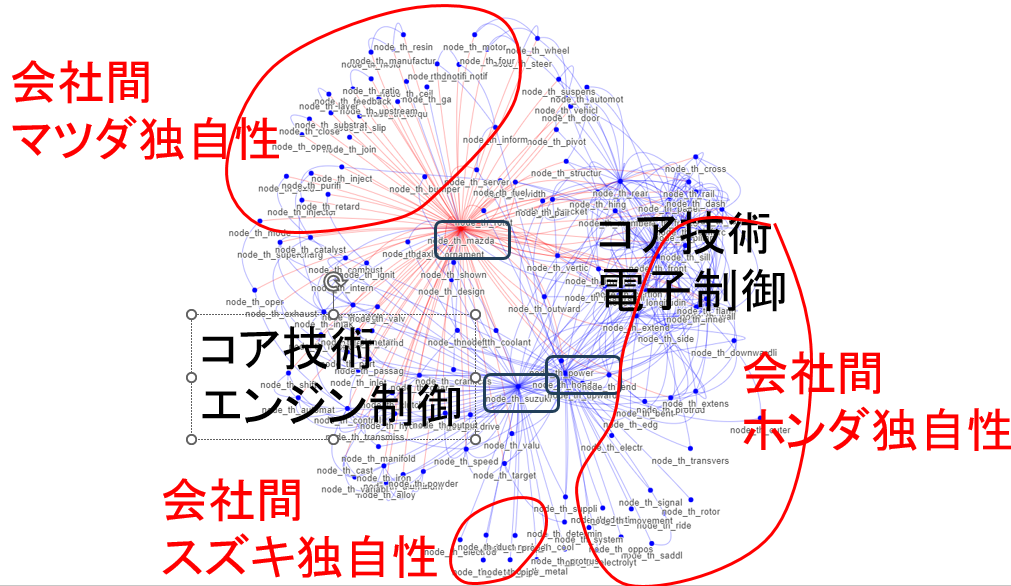

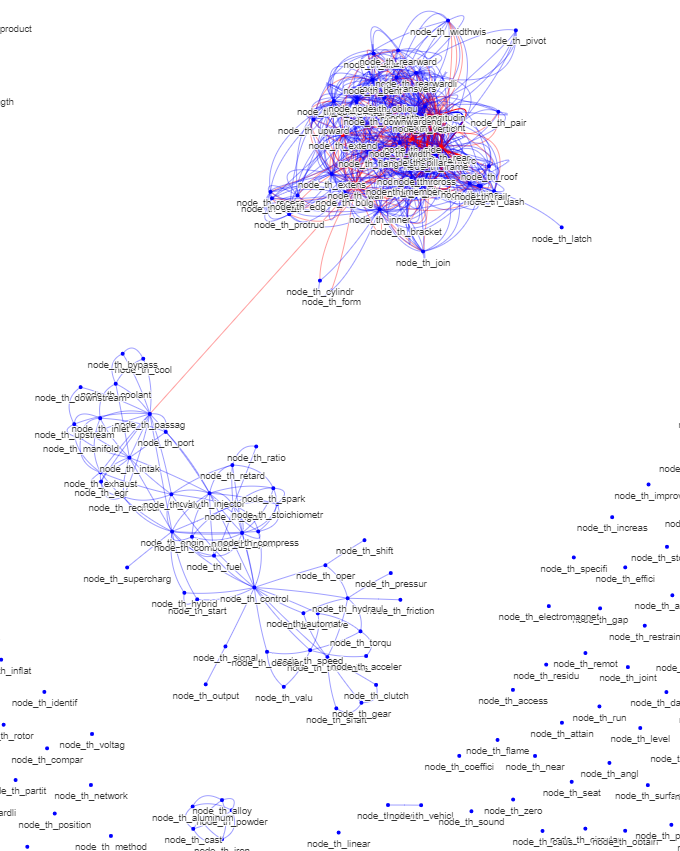

マツダ,スズキ,ほの特許を眺める.文献込み

一マツダファンとして興味本位に.2010年前後から面白いことになっているのではと.

点火コントロール,車体.電気自動車には様々なアプローチあり.プログラム系はさすがのホンダでしょうか.

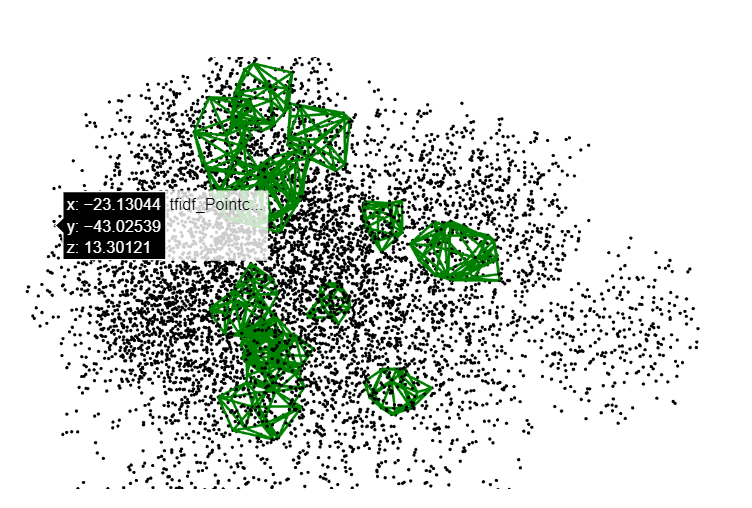

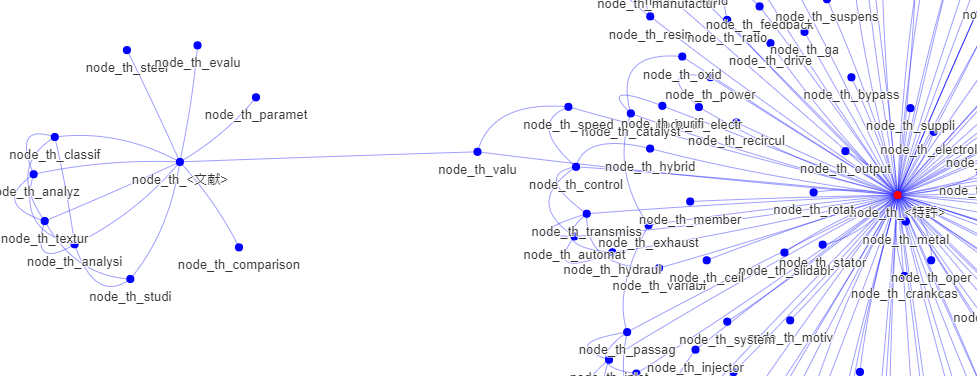

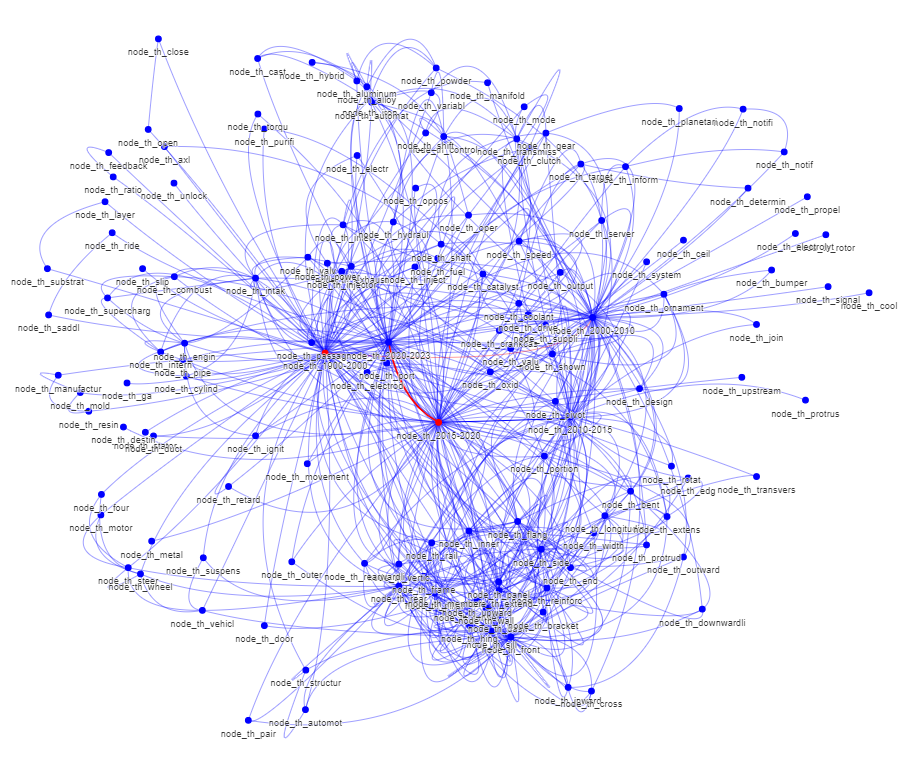

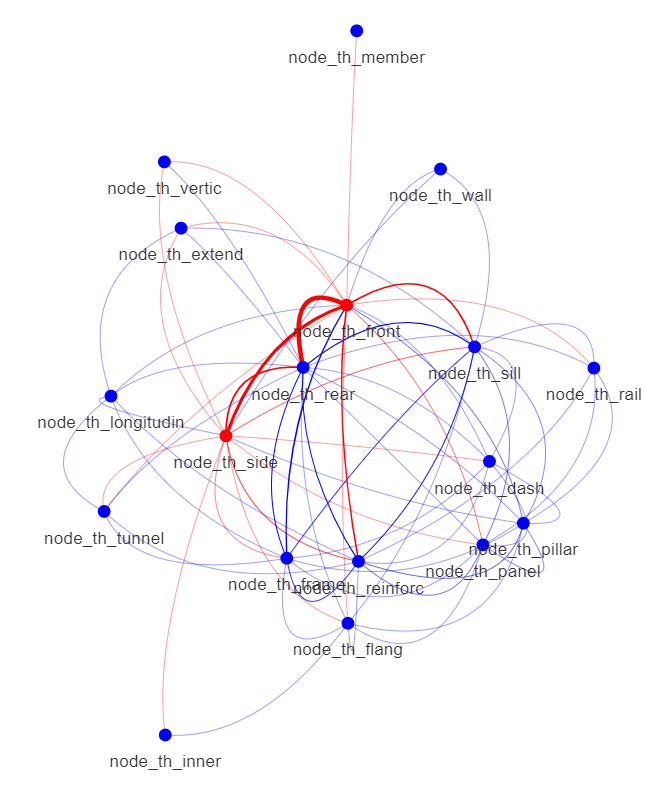

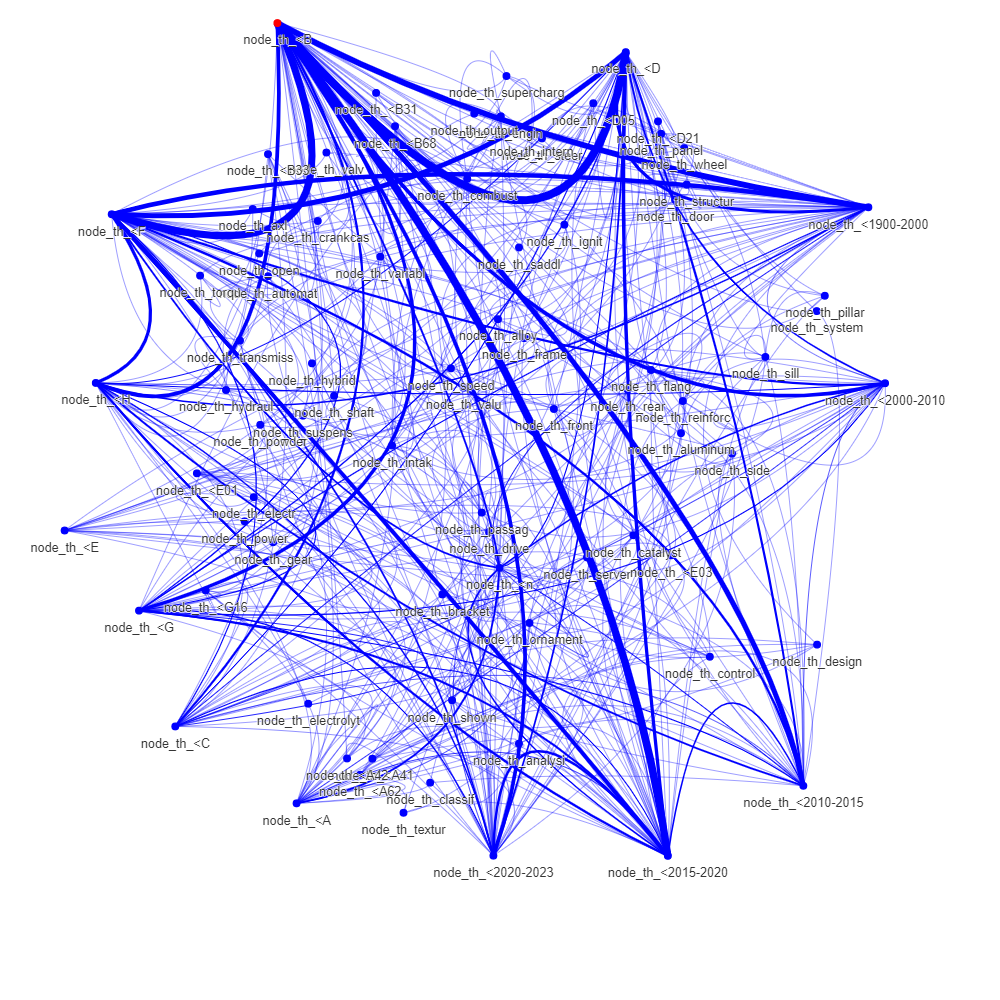

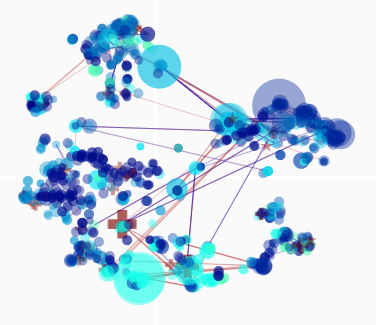

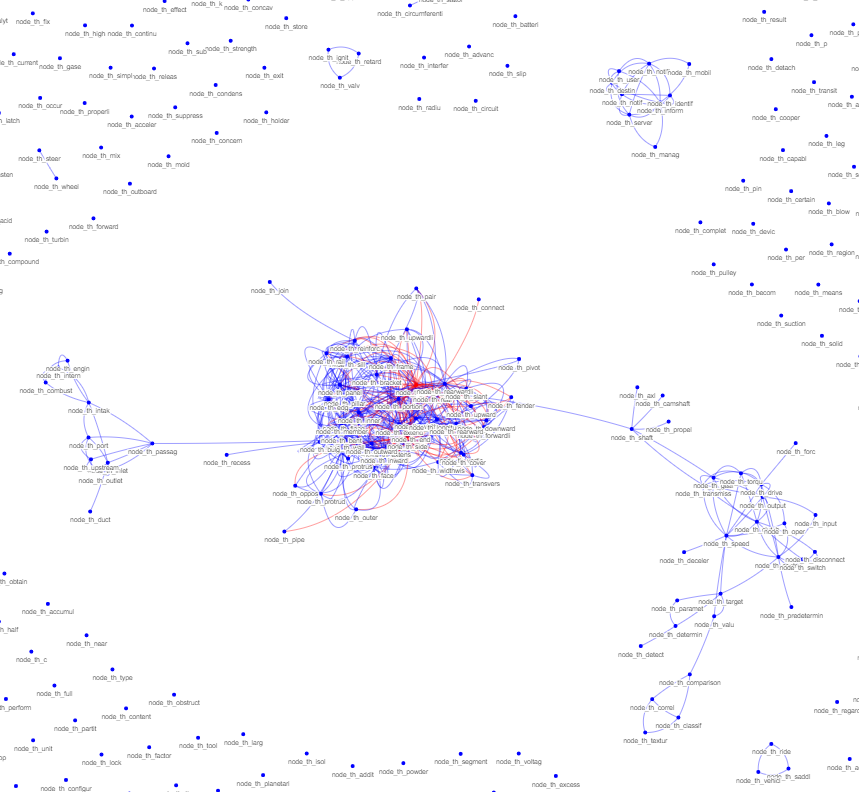

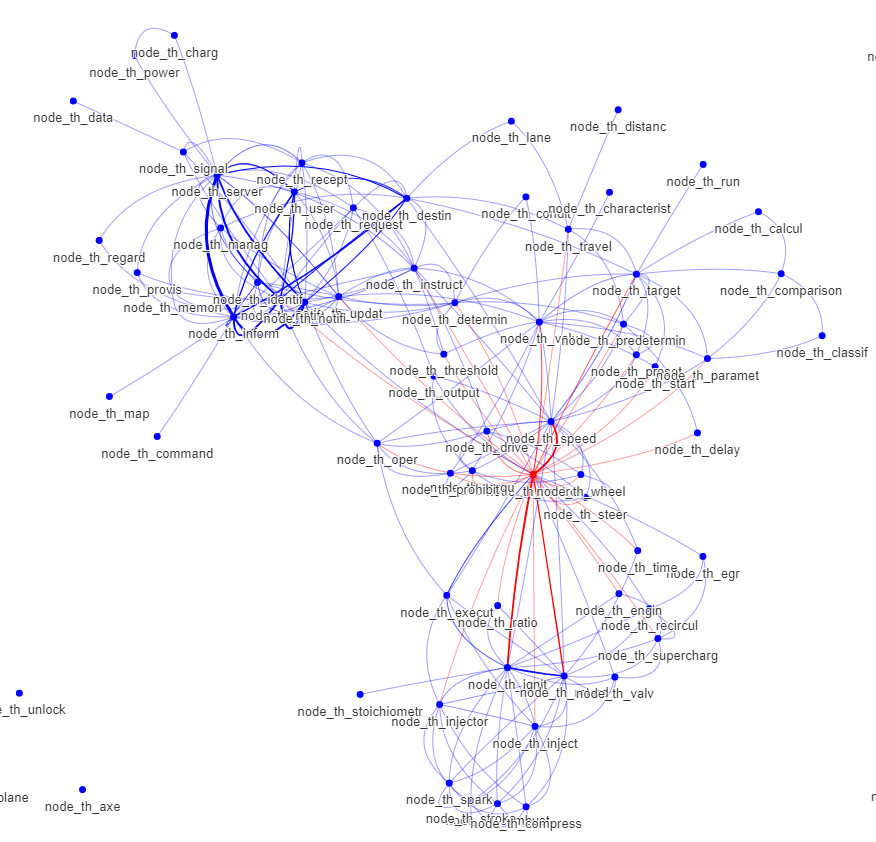

今回は俯瞰図ではなく,俯瞰図を作成する際に用いたベクトル空間をネットワーク化し,何がわかるか見てゆきます.

なお,このネットワークはキーワード単位のネットワークではなく,概念単位のネットワークです.キーワードと異なり概念ですから概念同士の演算が可能ですし,類似概念は吸収されています.

この3社ならホンダが支配的と思いましたがそうでもないでしょうか? 名寄せが不十分かもしれません.ホンダはライセンス収入が多いことから考えるに、基礎的な特許があるからこそ独自性が低いように見えるのでしょう。時系列分析をすれば基礎的特許による支配が見えるかもしれません。

マツダは独自性が強いように見えます.左上の概念要素群はほぼマツダのみと繋がり目立っています.feedbackはここにありますね.マツダらしい印象です.いや,確かマツダはfeedbackを必要としない理論化に取り組んでいたのでしたか.

スズキはOEM中心であり新規技術より改良を選択しているのかもしれません。しかし、社長てこ入りで発明報奨も強化しているようでもあります。今ひとつ方向性が読めませんが、基本的には技術より既知の基礎強化の方針なのでしょう。技術差別化よりサービス強化と言う、コモディティの基本を選択しているのでしょう多分。

会社ごとの違いに対する豊富なインサイトが見つかりそうなネットワークです。

-

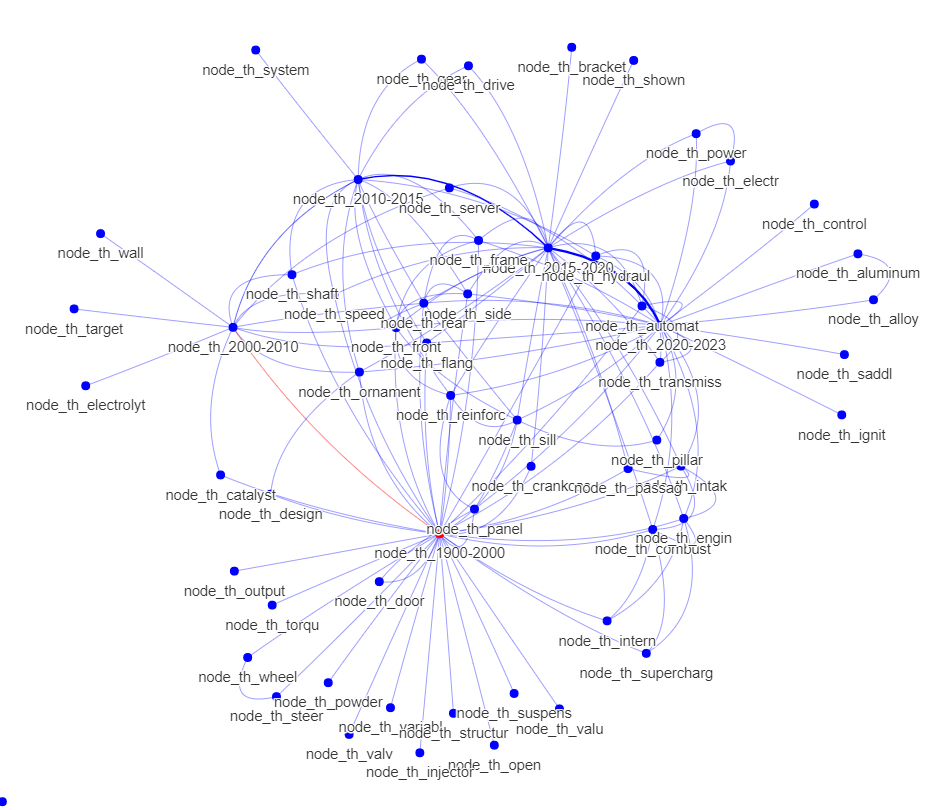

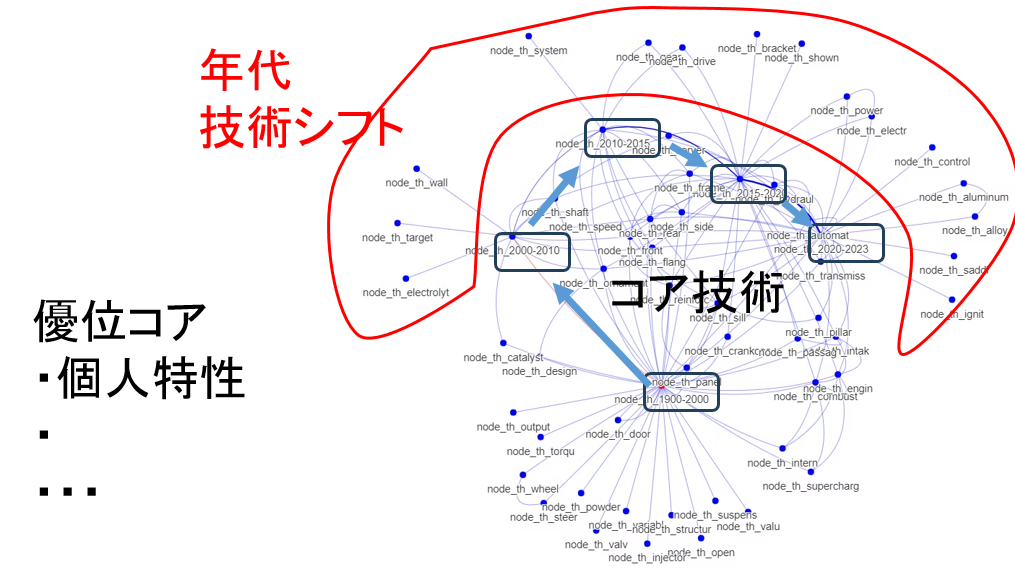

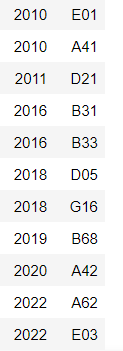

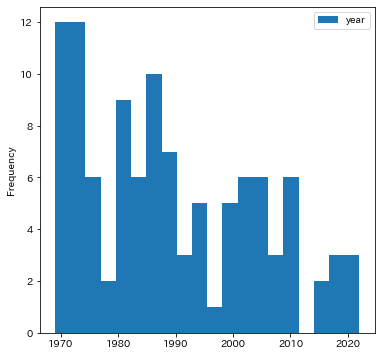

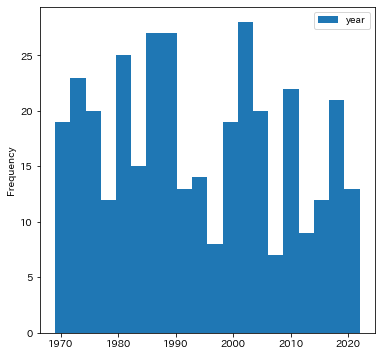

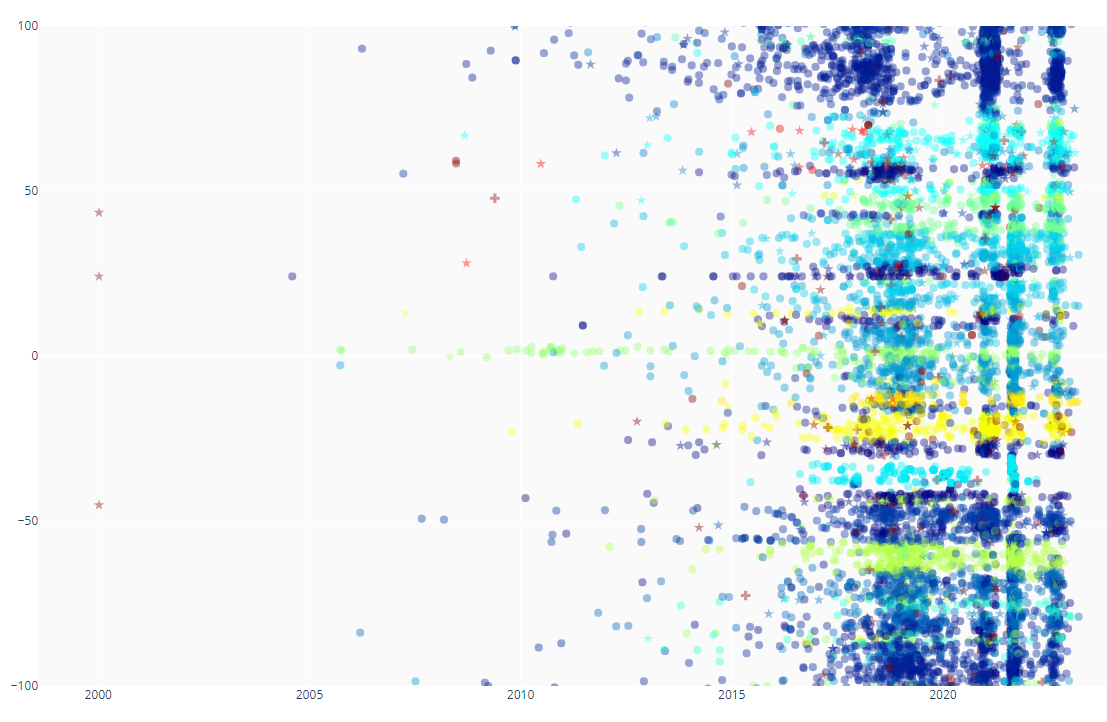

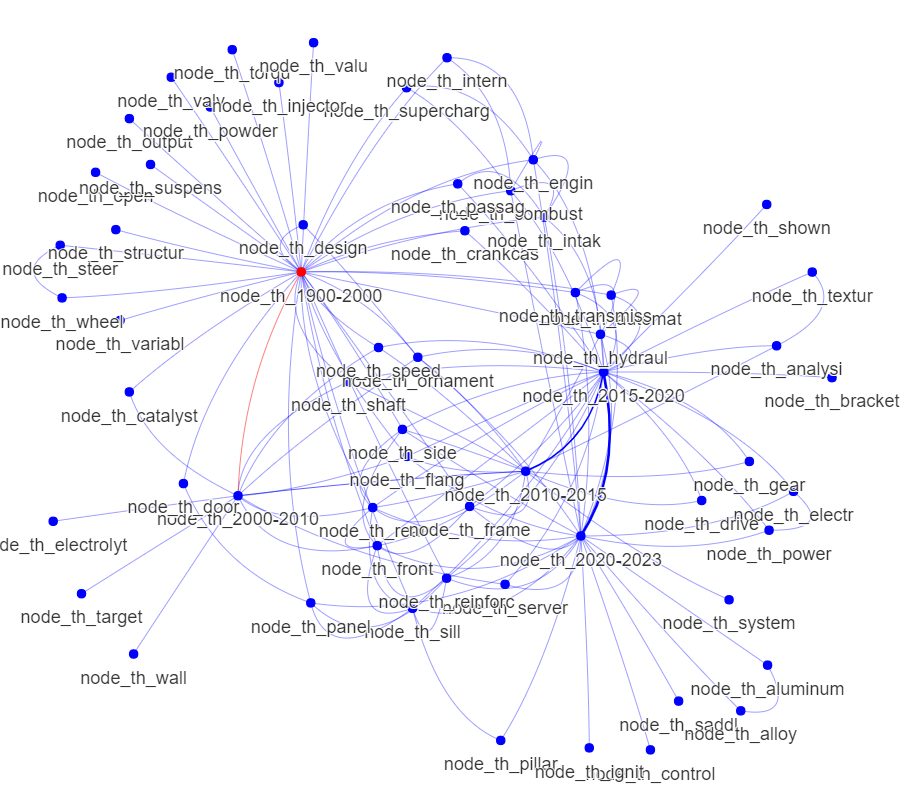

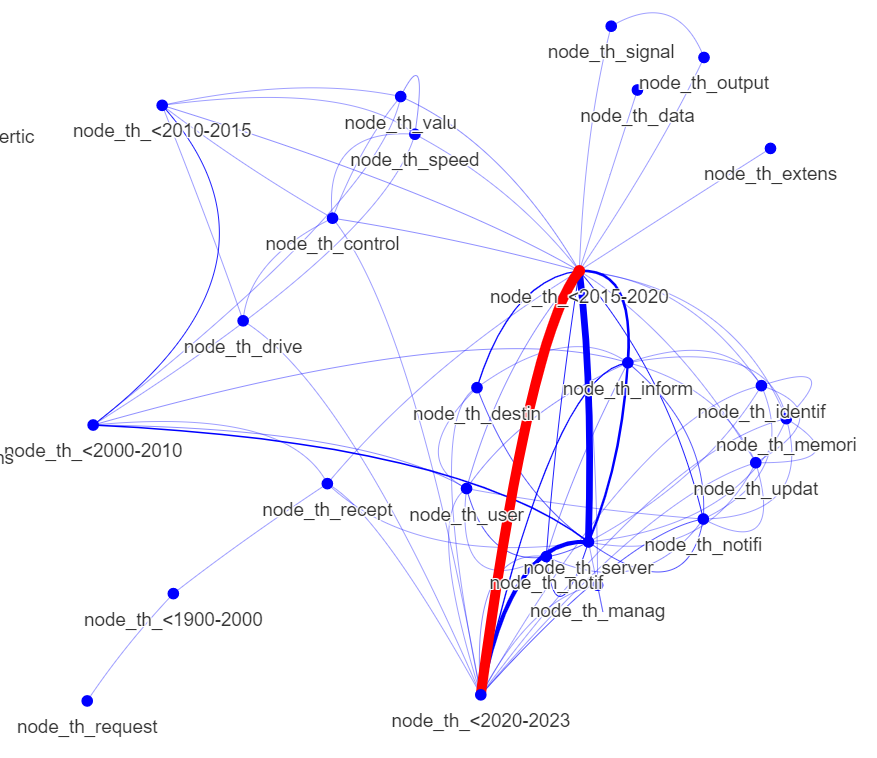

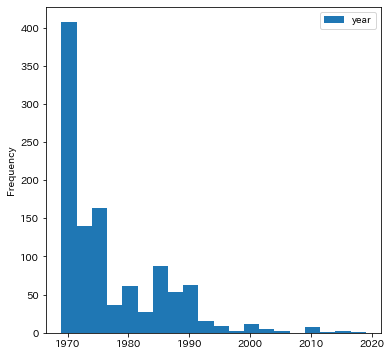

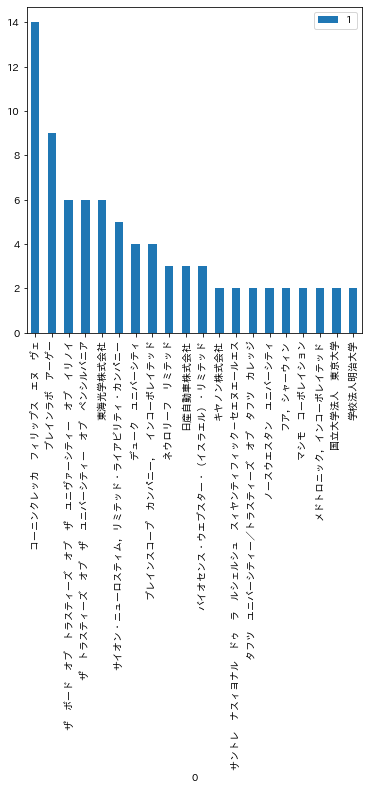

全体 年代との関連

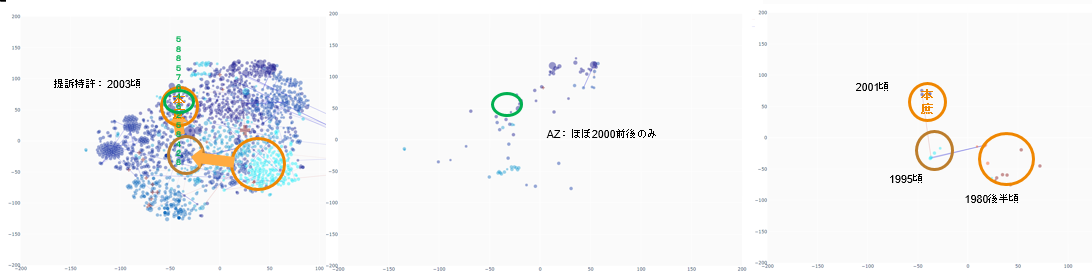

'hydraul','analysi','textur'ってなんでしょう?→「この論文は,画像の定量テクスチャー解析ソフトMazdaを紹介するものである」・・・文献は除去しときましょう.データ分析の手順,ask-prepare-process-analyze-share-actのうちprocessを省いているのでいけませんねぇ・・・