*移動・再投稿(元 https://qiita.com/kzuzuo/items/9a149e69642ee7b3221e )

*20211003,502 bad gateway対策として,前,中,後へ分割

前 https://qiita.com/kzuzuo/items/4670b5ff7526319680f4

中 https://qiita.com/kzuzuo/items/237b9f5192464817aa40

後 https://qiita.com/kzuzuo/items/756470e6e17c54aa5e2e

2018年4月頃より余暇業務外で,知財関連AI,SDIと連動して教師類似特許抽出・スコア順並び替えを行う点眼分野専用自動化AI,の実装・実データでの試行と検証を行ってきた.

2018年10月頃完成,2019年4月現在は試行しつつの改良・検証段階.

モデルの個性が見られ続けている.

何に起因するどのような個性であるのか知りたくも,本業が忙しくなり余暇においても優先として時間配分できなくなっている.

しかし知りたい.個性があるならそれをコントロールすることで,様々に活用ができるはずだ.

いっそのこと公開してみる.

どなたか協力,またはこれらから課題発見し検討・公開してくれることを願って・・・

*以下,随時更新追記します.区切りを見つけてまとめ直す予定.

*以下,*と()はメモ(*と()だらけのネタ帳と化している.)

*思いつき即なぐり書きしており穴だらけ.考えが変わり矛盾している箇所も多々.

*繰り返される追記により話が前後している部分が多くある.

*複数の言語を混ぜると検索し難くなるため基本的に日本語に統一。google翻訳そのものを貼り付けたりもする。

*専門が異なり固有名詞が出てこない.自分の考えはP.インクベルセンの「情報検索研究一認知的アプローチ」にほぼ記載されていたのでこれに使用されている用語に書き直してゆく.

*2019年4月に提唱のあったMachine behaviorが,本件における該当分野となってゆくのだろう.

*実装しながら論文読みついで基礎を学び忘れ学び過去の通説は覆され,適切な知識形成がおっつかないよ!と泣き言を書いてみる.

*未だに自分が既存の技術のうち何に該当することをしているのか,どの部分が既存ではないのか,理解していない.この理解は実装においては近視的にはあまり重要ではないのだが,わかっていないことがわかっていない状態が維持されれば,必ずどこかで失敗の道に迷い込むことになる.知らねば.

*用語「AI」について.複数のモデルを扱いまた組み合わせ組み替えてゆくに当たり,深層でないモデルやニューラルと言えないモデル,機械学習とも言えない知識グラフなども扱ってゆく.end2endでない場合,表現が難しい.モデルをまとめて表すときには,用語「AI」と広い定義で記載することとする.

・202105時点において最新である、同じような疑問に向き合っている内容を持つまとまった記事は、次であろうと思われます。

Three mysteries in deep learning: Ensemble, knowledge distillation, and self-distillation

Published January 19, 2021

By Zeyuan Allen-Zhu , Senior Researcher Yuanzhi Li , Assistant Professor, Carnegie Mellon University

https://www.microsoft.com/en-us/research/blog/three-mysteries-in-deep-learning-ensemble-knowledge-distillation-and-self-distillation/

Towards Understanding Ensemble, Knowledge Distillation and Self-Distillation in Deep Learning

https://arxiv.org/abs/2012.09816

Are Pre-trained Convolutions Better than Pre-trained Transformers?

arXiv:2105.03322

(cs)[Submitted on 7 May 2021]

やっと、やっと、引用を追えば良いと言える文献が現れた・・・

メモ

202302追記 chatGPTに聞いてみた

- モデル自体の創造性とは何ですか

- モデルの示す創造性とは、新しいアイデアや概念を提案し、既存のものとは異なる方法で問題を解決することができることを指します。モデルの創造性を評価するためには、以下のような指標が考えられます。

新規性:モデルが提案する解決方法や概念が、既存のものと比べて新しいものであるかどうか。これは、例えば、専門家や一般の人々が、その提案についてどの程度知っているかを調査し、それが新規かどうかを評価することで測定することができます。

有用性:モデルが提案する解決方法や概念が、問題を解決するために実用的であるかどうか。これは、例えば、実際にその提案を実装し、その効果を評価することで測定することができます。

意外性:モデルが提案する解決方法や概念が、その問題を解決するための予想外の方法であるかどうか。これは、既存の方法と比べて異なる解決方法が提案されたかどうかを評価することで測定することができます。

一般性:モデルが提案する解決方法や概念が、その問題を解決するだけでなく、他の問題にも適用可能であるかどうか。これは、例えば、提案された解決方法や概念が、他の問題にも適用可能であるかどうかを評価することで測定することができます。

以上のような指標を総合的に評価し、モデルの創造性を評価することができます。

・Evolutionary Optimization of Model Merging Recipes

https://arxiv.org/abs/2403.13187

SakanaAIのモデル多様性混合。知恵のモデル。

いやパラメータの混合でできるのか…凄いな

日時: 日本時間 04/17 (水) 12:00-13:00 (トーク20分程度+QA)

タイトル: Evolutionary Optimization of Model Merging Recipes

スピーカー: 秋葉拓哉 (Sakana AI)

経歴: Sakana AI リサーチサイエンティスト。東京大学大学院情報理工学系研究科で博士号を取得後、国立情報学研究所、Preferred Networks、Stability AIを経て、現職。現在は生成基盤モデルに関連する複数の研究プロジェクトを手掛ける。共著書に『Kaggleに挑む深層学習プログラミングの極意』(講談社)などがある。

概要: 進化的アルゴリズムを用いて多様なオープンソースモデルを融合することで新しい基盤モデルを効率的に開発する手法「進化的モデルマージ」を提案します。我々のアプローチは、既存のオープンモデルの膨大な集合知を活用するため、モデルを非常に効率的に作成できます。進化的モデルマージは、「非英語言語と数学的推論」「非英語言語と画像」といった、これまでは困難と思われていた全く異なる領域のモデルをマージする方法すらも自動的に発見できることが分かりました。

案内: https://nlp-colloquium-jp.github.io/schedule/2024-04-17_takuya-akiba/

・モデルマージは未だ謎の技術なのだな。

・線形のマージはうまくいくと思えないのにうまくゆく理由、自分も知りたい。うまくいってしまっているので。

異なるアーキテクチャーの出口でもうまくゆき、同じアーキテクチャーの重みマージでもうまくゆくのだろうか。

・レイヤーマージはtransformerがレイヤーごとに空間を出力し空間自体を微調整し続けるのでうまくゆくのだろうか。

・個人的には、知識は同じように形成される傾向があり、予想以上に空間内で知識が圧縮されており、切り貼りしても知識が傷つかず、よって切り貼り可能なのかな、と思ったりもする。これなら重みマージもレイヤーマージもうまくゆく理由になるのではないだろうか(妄想)

・kaggleで有効に使われている理論的に理解不能なテクニックの重要性、は同感。自分もそれが知りたくてコンペに参加している。

・この空間は自由回転しても豪華であるはずでその回転のための重みや追加レイヤは必要だとは思う…fine tuningによりあっさりと吸収できるのかもしれないけど。違うか。tokenizerを統一しているから同じ時期から見た空間になるのか?

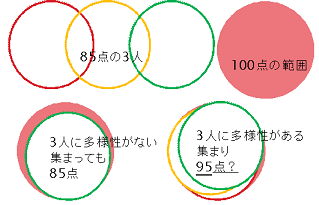

・多数決の効果は精度の向上に効き再現率の向上には効きにくいと思われるところ、実測では再現率の向上に効いている。多分だが、ノイズをより多く落とすことにより、再現率の向上として見えるのだろう。良いでなく悪いを排除しやすいのだろう。してみるに、外れ値の除去という形でモデルマージは効くのかもしれない。

・モデルパラメータの算術

https://joisino.hatenablog.com/entry/2024/01/09/174517

- GPT4: モデルの不確実性とバイアス・バリアンスのトレードオフを理解するには、まずこれらの概念がどのように相互作用するかを考えることが重要です。

-

モデルの不確実性:

モデルの不確実性は、利用可能なデータに基づいてモデルがどの程度正確に未知のデータを予測できるか、その信頼性に関連しています。特に経済学などの分野では、多様な理論や仮説が存在するため、単一のモデルでは現実を完全に捉えることが困難です。このため、複数のモデルを考慮に入れることで、より広範な視点からデータを解析し、現実の複雑さをより良く反映させることが可能になります【18†source】。 -

バイアスとバリアンスのトレードオフ:

- バイアスはモデルが訓練データに対してどれだけ偏った予測をするかを示します。バイアスが高いモデルは、データの真のパターンを過小評価し、単純化しすぎる傾向があります。

-

バリアンスはモデルが訓練データの小さな変動にどれだけ敏感に反応するかを示します。バリアンスが高いモデルは、訓練データに対して非常によくフィットしますが、新しいデータに対しては過剰に適応するため、一般化が困難になります。

モデル平均化は、これらのトレードオフを緩和する方法の一つです。複数のモデルの予測を組み合わせることで、各モデルのバイアスを相殺し、全体としてのバリアンスを減少させることができます。これにより、単一モデルよりも堅牢で一般化能力の高い予測が可能になります【15†source】【16†source】。

この理論的背景は、特にモデルが直面する不確かさが高い状況下での意思決定において非常に重要です。複数のモデルからの情報を統合することで、単一の視点に依存するリスクを軽減し、より信頼性の高い予測や分析が可能になるため、モデル平均化は有効な戦略とされています【17†source】【18†source】。

https://www.cambridge.org/core/services/aop-cambridge-core/content/view/11866974EE2888D4A2988309FC6B602F/S1047198700013838a.pdf/improving-predictions-using-ensemble-bayesian-model-averaging.pdf#:~:text=URL%3A%20https%3A%2F%2Fwww.cambridge.org%2Fcore%2Fservices%2Faop

「知恵」という用語を、複数の知識モデルから最も適切なものを選択する能力として定義する場合、上記のモデル平均化の議論に基づいて次のように説明できます:

知恵は、単一のモデルや視点に依存することなく、複数のモデルを評価し、それぞれの長所と短所を比較検討することによって、最も信頼性が高く有用な知識を抽出するプロセスです。この選択プロセスには、異なるモデルが提供する情報の相互作用を理解し、各モデルのバイアスやバリアンスの影響を評価する洞察が含まれます。

さらに、知恵は複数のモデルから得られる情報を統合することで、個々のモデルの限界を超えた解を導き出す能力も指します。これにより、モデルの不確実性を管理し、より広範なデータや状況に対する適応性を高めることができます。具体的には、モデル平均化のアプローチを用いて、複数のモデルが予測する結果を平均化することで、より精度の高い予測や一般化能力の強化を図ることができます【15†source】【16†source】。

結果として、知恵は、単なる知識の蓄積やモデルの適用にとどまらず、複数の情報源から最適な解を導出するための戦略的な思考プロセスと言えます。これは、特に情報が豊富で複雑な問題解決や意思決定が求められる場面で重要です【17†source】【18†source】。

・知恵の正体は、「3つのバイアスの高いモデルの多数決では、正しくとも2つのモデルと異なる1つのモデルの答えは無視されるが、3つのモデルのバリアンスを考慮すれば、2つのモデルのバリアンスが1つのモデルのバイアスにたされ、無視されなくなる。」というイメージで良いのかな。そうすると適切なモデル設計は…

・モデル出力後半の「バリアンスがほぼない状態」での多様性評価は、比較的よろしくないのかもしれない。結果は良好に出てはいるが。

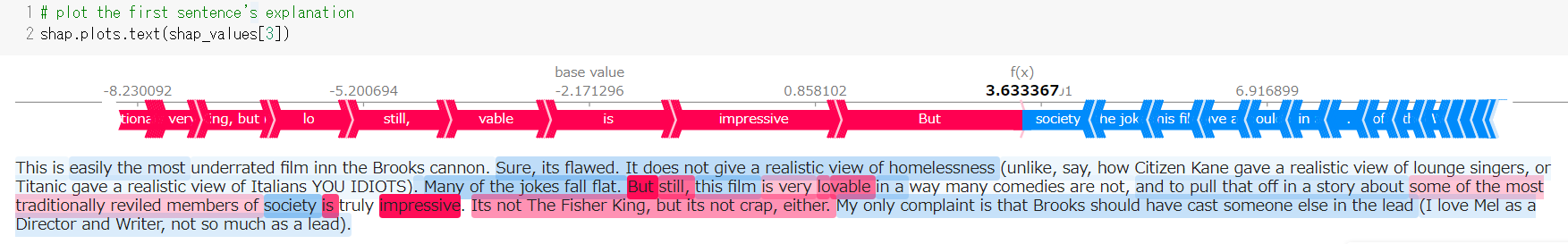

・SHAPの判断要素のプラマイを示すグラフが示しているように、プラスの根拠の割合は正答・誤答ともに大差なく、プマイナスの根拠の割合は誤答において大きい。**知恵とは、正答を出すまたは選択することではなく、明らかな誤答を除去することなのかもしれない。**これは多様性評価により何故か再現率が良くなる傾向と整合する。ノイズ除去しているのだ。

・The Topos of Transformer Networks

https://arxiv.org/abs/2403.18415

モデルの個性。

CNNなどとtransformerの違い

- GPT4: 文書の内容を基にすると、CNNとトランスフォーマーは、異なる概念であり互いに補い合う関係にあるという結論になります。トポス理論を用いた分析から、これら二つのアーキテクチャが異なる種類の問題解決に適していることが示唆されています。

CNNは局所的な特徴抽出に非常に優れており、画像処理や時系列データ分析など、局所的なパターンが重要な役割を果たすタスクで効果を発揮します。これは一階の論理構造で表現される比較的単純な関係を捉えることに適しています。

トランスフォーマーは、文脈全体を通じてデータの関係性を捉え、長距離の依存関係を扱うことができるため、自然言語処理や複雑な推論タスクに適しています。これは高階の論理構造を扱うことができるという特性を示しています。

したがって、上位概念と下位概念の関係ではなく、CNNとトランスフォーマーは異なる機能と特性を持つ独立した概念として捉えるべきです。それぞれが特定のタイプの問題に対して最適化されており、互いに補完し合うことで、より広範な問題領域をカバーすることができます。

この観点から、異なるタスクやデータに対して、どちらのアーキテクチャを使用するかを選択する際には、その特性と適性を理解し、タスクの要件に合わせて適切に選択することが重要です。一般化により、これらのネットワークがどのように互いに補い合うか、そして特定のタスクでどのように連携して使用できるかについての洞察が得られます。

・Understanding and Mitigating the Threat of Vec2Text to Dense Retrieval Systems

https://arxiv.org/abs/2402.12784v1

論文概要

タイトル:"Understanding and Mitigating the Threat of Vec2Text to Dense Retrieval Systems"

著者:Shengyao Zhuang 他

この論文は、Vec2Textという手法が密な検索(Dense Retrieval)システムに対して持つ潜在的なプライバシーリスクを解明し、対策方法を検討しています。Vec2Textは、テキスト埋め込み(テキストをベクトル表現に変換したもの)から元のテキストを再構成する技術で、特にプライバシー情報が含まれる場面で悪用の可能性が指摘されています。また、本手法は密な検索システムのコーパス汚染(Corpus Poisoning)攻撃にも応用される恐れがあります。

主な内容と貢献

-

Vec2Text再現と課題特定

- Vec2Textの再現実験を行い、GTR-base埋め込みモデルでの不具合を修正。正確な評価を可能にし、検索効果と再構成能力を高めました。

-

Vec2Textが再構成に影響を及ぼす要因の特定

- 埋め込みモデルでの距離メトリクスやプール方式(平均やCLSトークンなど)、事前訓練方法(ボトルネック訓練など)がVec2Textの再構成能力にどのように影響するかを調査。特に平均プールとボトルネック訓練が再構成リスクを高めることが確認されました。

-

対策手法の提案

- ノイズを埋め込みに追加する方法と、新たに提案した埋め込み変換方法の2つの対策手法を評価。特に、変換方法は検索性能を維持しながら再構成リスクを完全に抑制するもので、実用的な解決策と考えられます。

-

コーパス汚染(Corpus Poisoning)への脅威としてのVec2Textの適用

- Vec2Textがコーパス汚染攻撃において、他の手法と比べて効率的に多数の悪意ある文章を生成しやすく、特定の検索システムに対して深刻なリスクをもたらす可能性があることを示しました。

研究成果

この研究は、Vec2Textが持つ脅威と、それに対する有効な対策方法を広範に調査し、Vec2Textが密な検索システムのプライバシーとセキュリティに与える影響についての包括的な理解を提供しています。

- Vec2Textがコーパス汚染攻撃において、他の手法と比べて効率的に多数の悪意ある文章を生成しやすく、特定の検索システムに対して深刻なリスクをもたらす可能性があることを示しました。

ふーむ…

やってきた:

複数の深層学習モデルを組み合わせた自然言語AI実装の一例と

モデルの多様性に注目した展望(概報)

2018年12月提出

http://patentsearch.punyu.jp/asia/2018hayashi.pdf

https://sapi.kaisei1992.com/wp-content/uploads/2019/03/2018hayashi.pdf

- 複数のモデルの個性とその多様性を評価するシンプルな手法.

- モデルCの市販AIは、201903にBERTに置き換えている.

- recall,AUCを評価基準として良好な結果が出ている.必要性はあり実現可能であり再現もある.ただし,実効性は不明. (評価データセットが十分でないので数値評価はしていない.→9ヶ月実データ試用結果は下記の通り.実効性があると言ってよいだろう.→val460検証結果の一部は下記の通り.目的に対し十分だろう.)

- 今後,認知的観点と解釈学的概念から実用をふまえた理解を深める必要があるだろう. (自然言語に真値は存在しない,正しい答えに見えるためには個別の認知に適合することが重要,と前提.)(「情報検索研究一認知的アプローチ」p32参照。今後,テンプレートマッチング,特徴・統語分析,および文脈解析の観点を超えた理解を,認知的観点から進める必要があり,そうして初めて「実用」といえる段階になるだろう.)(認知検討→各モデルとヒト認知との比較実施.期待通り→検討中…)(創造性検討→創造性発揮例ありしかし満足できるものではない→改良中…)

*このAI使用の前提は,ヒトが補完をすること.この種のAIには,今のところ,ヒトの代替をできるほどの能力はない.すでに人手が足りているならその代替にはならない.不可能を可能にしてくれるが可能をより良い可能にはしてくれない.その理解の上で,ヒト代替に近づくAIにできないか,個人用アシスタントAIとできるか,試してみたい.

(「情報検索研究一認知的アプローチ」p201参照。AIには従来のような概念知識を持たない「情報検索専門家」でなく、概念知識を持つ「専門家」となることを期待している.)

*AIを用いた実データによるSDI確認試行を9ヶ月続けた.その期間内において重要な特許を見落としたと言える案件は(再確認中だが見つかっているものは)多様性評価で上位15%(BERTモデルで48%とBERTが足を引っ張った)となった1件のみ.この1件もヒトが救済している.

人手が足りない会社における実用として,個人用アシスタントAIとして,十分ではないだろうか.

(判別しにくい分野の特許群ではこうはならないと思うけれど.難しいタスクを簡単なタスクに変換することも重要。)(それぞれのモデル(ヒト含める)の不得意分野が明確になれば,さらに性能をあげられるだろう.)(特許調査に100%はない,というのはその通り.母集団の外の特許は見つけられない.人が調査する際には確認可能な件数に母集団を限定する必要があるが,AIの場合その制限は少ない.この母集団を広く取ることができるという点においては,人よりAIの方が確実に優れていると言える.)(AIとヒトとで比較したとき,ヒトがすべての範囲で優れているということはない.例えば……先日ある調査会社にクリアランス調査を依頼し評価十分と言える方(この方の調査能力が低いと言う人は多分いないし,この方の調査能力が低いなら調査能力が高いと客観的に言えるヒトはほぼいないとなるだろう)に調査していただいたのだが,見事に最重要特許2件落としてだなぁ……この最重要特許はAIが拾い上げた.ここで言いたいのは,ヒトも完璧ではないようにAIも完璧ではない,AIが完璧でないようにヒトも完璧でない.ヒトをAIに置き換えることが難しいのと同じように,AIをヒトに置き換えることも難しい.ただ,ヒトとAIはお互いに補えうる,ということだ.AIが100%見分けたかどうかは結果に過ぎず最重要ではない.まず重要な問題は,ヒトとAIにつき,互いが間違える部分を再現性を持って補ってゆくことができるか,である.つまりアシスタントできるか,だ.)(ヒトとAIの協働には可能性を感じている.協働にはAIの個性を理解する必要があると感じている.個人用アシスタントAIがベストと,今も感じている.))(創造を組み入れた未来予測型の個人用AIが可能だと考えているし,まだ不可能を網羅していない(というか,創造性の部分にはまだほぼ手を付けていない.))

*現在,100カ国語+から日本語への翻訳機能を実装している.これはSDIで重要となる迅速な読解,ひいてはROIの向上に,大きく寄与する.

*分散表現モデルの学習に用いるコーパスを変化させる手法は従来から行われているが,その視点は多くが「意味」の範囲内・文脈レベルである(分野ごとの語彙や文型の違いなど)(のように見えているが,統計をとったわけでも最適なサーベイを見つけて確認したわけでもない).自分は意味を超えた「情報」・価値観レベルの視点で検討している.

(コーパスで何でもできると考えているわけではない.コーパスに基づく分散表現は必須,構造も必須,それらを如何に統合するかが課題だろう.)

*自分の勝手な思い込みは十分集まった.そろそろ基礎を進める時期か.課題認識してゆるく柔軟な概念をつくってから学ばないと右から左なのだよね.

(何かを知らないという飢餓感がモチベーションの源なのだが,多くのインプットに基づく課題の知が,何かを知らないという飢餓感の源泉となっている.)(固有名詞のような知識は飢餓感の源泉にはならないし,逆に無知の知を失い間違った安心感により飢餓感を失いうる.人によるだろうけれど.)

→coursera Deeplearning.ai Natural language processing 16週講義修了。T5、Reformer含むattention modelまでの講義。ちっとはマシになったかね。

→coursera How to Win a Data Science Competition: Learn from Top Kaggler 5週講義修了。一通りは撫でられたかな.

→Control and Robotics 多様体論へのいざない 基礎数学 大阪大学大学院

https://www.youtube.com/watch?v=6npSJdMQqVY

下記*()コメントへの修正をはじめよう。

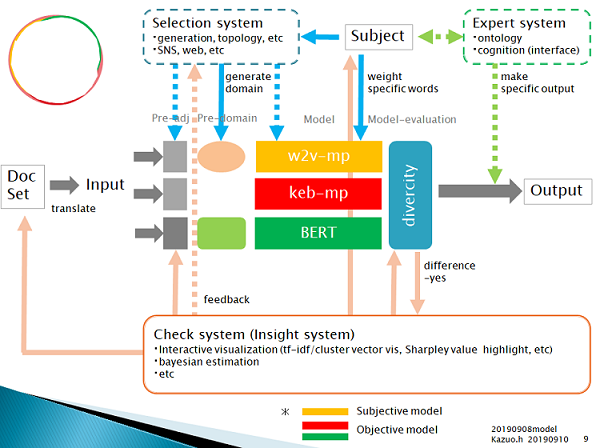

・201909現在のシステム構成

Doc set(xlsx)をメールに添付して送信すると,output(xlsx)がメールに添付され返される.

・model 知識レイヤ: モデル

w2v-mp: word2vec pretrained maxpooling model. This like CNN.

keb-mp: keras embedding maxpooling model. This like CNN.

BERT: Bidirectional Encoder Representations

w2vkeb-mp: w2v-mpモデルのみがその個性を示したサンプルをkeb-mpモデルの正解教師に加え再学習するモデル(自己教師の一種?data augumentation?)。上位概念下位概念の発散収束コントロールテスト、創造性テスト用。並列でなく直列とした場合の理解を深めるために試行。

congnitive-w2v-mp:w2v-mpに対し任意にattentionを適用させるモデル。再事前学習不要にどこまでドメインの変化をコントロールできるかテストするために試用。

mbart、またはmT5追加予定

なお教師データは、正解教師データ約100件、不正解教師データ約100件としており、いずれのモデルにおいても同じ教師データを用いている。(少ない教師量から必要十分かつ最大の結果を得ることを目的の一つとしている。)(また教師データが頻繁に変わると意図しない特性となり得ることが明らかなので、教師データは最低限のみ変更することとする。)

・pre-adj: 前処理

入力テキストの前処理を行う.前処理方法はモデルにより異なる。oov処理含む。

*やっと事前知識分散表現において使わない語彙もそのベクトル空間を適切に作るには重要という考えに至った。oov処理はpre-domainにおいて主に行うこととする。

・pre-domain: モデルに与える事前知識

・Subject: 認知ベース.

・diversity 知恵レイヤ :

どの知識を用いるかの重み付けと選択を行う。知恵。

多分最も重要。

・Check system(insight system, alert system, school system, knowledge distillation system): 学習・評価結果の理論化、作成された理論や任意の教師無しモデルなどを利用したフィードバック補正、創造? 類似を提示することによる説明

Expert systemの逆.

知識構造があることが明確であり、構造がシンプルであり、構造が未知ならば、構造をシンプルに取り出し適用させましょうってこと。

tfidf embeddings/cluster vis: tfidf-word2vec-clustering visualization 目視確認と自動母集団検証・修正。さらに、高スコア結果それぞれに近似する特定範囲を抽出して教師データをaugmentationし再学習してもよいし、好スコア結果から重要な特徴を抽出してexpert systemに渡してもよい。検証中。

Bayesian estimation: Bayesian Designと記載すべきか.自動仮説最適化データ作成・修正.自動概念追加.(expert systemに渡す、決定木とベイジアンネットワークを組み合わせた特徴量エンジニアリングシステムも作成中)

SHAP highlight: 目視確認と事前知識と比較した自動仮説最適化データ作成・修正

mbart: 検証中

mT5: 検証中

多様性評価手法は2年間特に問題ない結果を出力してきた。2年間の全データを使用して、一つの蒸留モデルを組み、検討に入れる予定。

・Expert system: 外部から持ち込んだ理論の適用

巨人の肩、メタ構造、構造、human in the loop 含む。外部足場scaffolding?

check systemの逆.外部から持ち込んだ理論とは,check systemが作り上げた理論も含む(けれど,いまのところ吟味して適用したいので図の中ではつなげていない.) メタ構造も含む。

関連を因果に変換.専門的認知と検索者認知に適合させる.

知識構造が明確であり、構造が既知ならば、その構造を優先させましょうってこと。

分散表現により失われた離散的情報を再度補っていると表現しても良いかもしれない。(多量の事前学習でも補えうるが、そちらでは個性、個別性、一貫性を失うきらいがある。)

time seriesの予測をする際,過去データからのみ学習すると,イベントに対応できなくなる予測となる.これを避けるために,より多くの知識から総合判断されている情報と言える専門家のヒューステリックやあり得る幅のシナリオ設定を用いて,シナリオごとの予測として示すことがある.Expert systemはこれに近いかもしれない.

時系列とシナリオの例

https://www.env.go.jp/earth/ondanka/rc_eff-adp/c02/mat05.pdf

特定のメールアドレスに単語を入力して送信すると、その後、モデルがその単語を自動的に重視するようにしてある。気になった出来事があればメール送信しておくだけ。自分の認知との適合性向上についてもっと簡略化したいが現状ここまで。

(現状,簡易的なオントロジーと,単語重視,特定分類重視による.)(この部分で文章検索の利点と単語検索の利点が融合するハイブリッドとしている.)(このexpert systemは過去にあったそれと異なり,支配的影響力を持たず,多様性を持つ個性の一部として不足を補うように働く.)(データに含まれる差別(データのバイアス)を素直に抽出してしまう点で、AIは子供だ。差別とは社会的に生み出された必然性のない概念であり、子供には基本的にわからない。必要な差別と不要な差別を見分ける必要があり,そのため、AIには大人のバイアス(モデルのバイアス:モデルの個性により与えられるバイアス.バイアスを加えられ形成された事前確率や構造といってもよい?)を与えておかないといけないと思う.(データのバイアスは無くすことができないのだから(check systemで手を入れているけれど),適切と思われるモデルのバイアスをかけて補正することは健全だと思う.ヒトではこれを教育と呼んでいるはず.様々な教育(真値のない複数の適切と思われるモデルの個性による関与)は多様性を提供する.これは歓迎されることだろう?(きちんと評価する能力があれば,だが).)。損失関数などにより方向性を与えデータから自発的に学ばせることにより教育がなされるが,それだけでは不要な差別も採用されてしまう.不要な差別を除き適切な差別を採用「されやすく」するためのモデルの個性であり,その個性の一つ(比較的まっとうで限定的な知識を持つ個性)としてのexpert systemと言っても良い?.)(データのバイアスと不足、情報のバイアスと要約、知識のバイアスとエッジの間違い、知恵のバイアス。色々ごっちゃになっていることが多くの問題を生み出している気がする。)(ある画像分類モデルが学習により2通りの正答ルートを作り上げたとする。Aルートは犬の顔を認識して犬と分類した。Bルートは背景の芝生を認識して犬と分類した。さて、どちらが正解だろうか?。実は双方正解だ、またはどちらが正解とは言えないというのが正解だ。教師は、犬自体を認識させたかったのかもしれず、芝生にいる犬を全体として認識させたかったのかもしれない。これが与えられていないときに不正解は問えない。このように、結果は結局、教師の認識に依存してしまう。(そして結果は結局、教師でない受け手が自ら仮定した認知において判断される)(画像では絶対的な答えを与えられうるだろうとしても、自然言語では絶対性はよりあいまいになり絶対的な答えを与えがたくなる)。

我々は常に、質の良いデータを利用した、質の良いルートに導く、優秀な教師となれるだろうか?。なれない。この花何?と聞かれたら名前を答える。このような教師であって疑問に思わない程度の教師がほとんどだろう。そこで過去の優れた教師による結果、巨人の肩を利用することになる。これが、ここに記載したExpert systemの役割となる。)(一言で言えば、ルールと法律の積み重ねの違い、と言えようか?)

・Selection system: w2v-mpに対し,概念を「歪め統合」しニーズと検索者認知に適合させ,創造性を付与する.

(多分,Retrofittingと呼ばれる技術の範囲内なのだと思う.)(未知語処理含む.*BERTにおいては未知語が未知の単語が出現する確率を計算するため汎化に役立っている可能性あり?)

・divercity: 多様性評価手法

(現状,ある閾値で足切りしその範囲内でFP件数を考慮した重み付けをを行う評価基準を用いており,認知・正解両面において,良好な結果が得られている.)(引き続き,安定性があるかどうか,理由がわかるかどうか,最適なエキスパートシステムは何か考慮しつつ、新たな評価基準の設定を進めている.)(モデルの個性に基本特性があるようなので、メタモデル化する予定。メタモデルの評価は弱く考慮する。)

*現在のAI分野において最高に面白いと思っていることは、帰納的でブラックボックスな予測から、演繹的な仮説を生み出し、データを追加した後それを再度帰納的予測にかけ仮説深化してゆくループだ。

このような事が計算機上で可能となった時代に生きていることに興奮するし、これができるのと出来ないのとでは明確な差が出るだろうことに危機感も感じている.

*「言葉の集合と分布と概念の外縁とそしてエッジの動的平衡を扱う理系」という意味で、自然言語処理と知財は、かなり類似していると思う。外縁の作り方は課題によるとして、知財の皆がそれぞれ自らの課題に沿った自然言語処理を始めると面白いと思う。

「知財言語処理」という分野を作っても良いのではないだろうか.

*法律分野ではエッジ,概念の領域範囲の明確化,が重要となる.エッジを明確化するには曖昧さがないほうが良い.曖昧さをなくすには,Bowやルールベースを用いると良いだろう.法律分野のうち,例えば契約文章は重要語の多様性があまりないが,特許文章は重要語の多様性が大きく,類義語が多く表現の解像度が異なりもする.契約文章では相性通りのBoWやルールベースを当てはめやすいが,特許文章ではそれでは限界がある.

特許文章は特殊で,エッジの重要性を保ったまま,文章の多様性にも対応させる,という,衝突しかねない概念を両立させないといけない.

特許文章処理は,自然言語処理において,かなり面白い分野,チャレンジするに値する分野となると思う.

*特許分野において様々にAIが利用できるであろうが,SDIでのAI利用は,前述のエッジと多様性に加え,適切に結果を出すには創造性が必要であろうことさらに受け手の認知を無視できないことから,基礎でありつつ難解で応用範囲が広い分野であると考えている.

まあつまり,面白いってこった.

やっている:

1. 本当にモデルに個性があるのか?

2. モデルに個性を作るには?

3. 多様性を評価しより良い結果を得るには?

4. モデルに創造性をもたせることはできるのか?

現状:

本業優先かつ基礎が成ってないためなかなか進まない.しかし結果は知りたい.

得られている結果:

1. 本当にモデルに個性があるのか?

あるようだ.

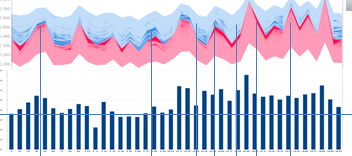

A.3つのモデルにおいてn=3の予測結果を比較してゆく過程で、正答不正答において,モデルに依存した個性らしき差が見られている.確率的多様性では無いようであった.

B.SHAP (SHapley Additive exPlanations) https://github.com/slundberg/shap を自然言語に適用し検討したところ,正答不正答において,モデル間に個性らしき差が見られている.

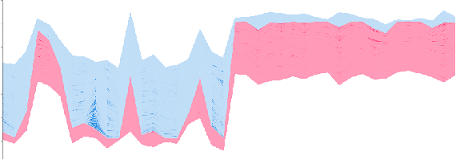

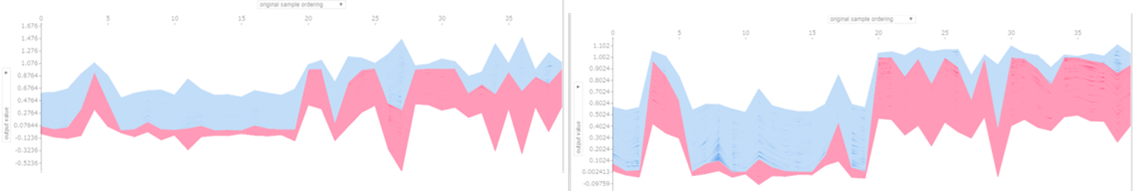

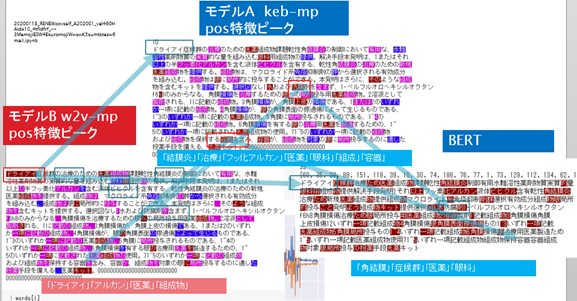

図1)force_plot.pre-trained word2vecベースのmaxpoolingモデル(左).keras embedベースのmaxpoolingモデル(右).

(横軸:バリデーション用特許文章40サンプル.左半分が不正解候補20件.右半分が正解候補20件.縦軸:赤帯青帯の境界は正解予測値.基本的に,赤帯は正解特徴の強さを表し,青帯は不正解特徴の強さを表す.)

・複数回試行したが,波形のパターンは安定.

乱数固定はしていない.左のモデルは学習のたびに予測値が変動しやすいのだが,それでも波形は安定.

*SHAP実例

Explainable machine-learning predictions for the prevention of hypoxaemia during surgery

https://www.nature.com/articles/s41551-018-0304-0

*次の資料はわかり易い。

How to use in R model-agnostic data explanation with DALEX & iml

https://www.slideshare.net/kato_kohaku/how-to-use-in-r-modelagnostic-data-explanation-with-dalex-iml

p116- SHAP

*SHAP を用いて機械学習モデルを説明する

https://www.datarobot.com/jp/blog/explain-machine-learning-models-using-shap/

*モデルにより波形が異なる.差があるということは価値があるということ.

=>あるモデルのみが正解できる部分を抽出してゆけば,総合性能は向上するはず.

*あるモデルのみが正解できる部分を抽出してゆくとは、モデルごとの集合を重ね合わせてゆくことと同じ。

適切な集合を重ね合わせることは、精度高くかつ再現率の高い結果、最終的に得た母集団の総合性能の高さ、を得るために、情報検索者が当然に行っていること(単一集合では不可能な精度再現率の両立を精度の高い集合に細分化して足し合わせることでカバーする)。

それぞれのモデルが汎用性の高い個性を持って精度の高い集合を作っているならば、モデルを組み合わせるとは情報検索者と同じことをしていると言える。

汎化された総合性能を考えるに、モデルの個性把握は重要。

(上記は交差エントロピーを前提としている)

双方ともに,他のモデルと個性が異なっているとは言える.しかし,正解候補の評価値と不正解候補の評価値の差が小さすぎ使いづらい.(分離を良くすることは容易だと思うのだがどのような設計思想なのだろう.)(市販AIはランダムフォレストではなかったはずだがなぜこれほど似たのか.)(再確認するも,変わらず.)(個人的には、決定木から得られる集合に関するルールを良いモデルの個性として使えるか疑問に思っている。単体で使う場合は問題ないのだろうけれど。)

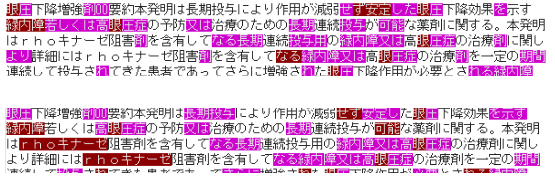

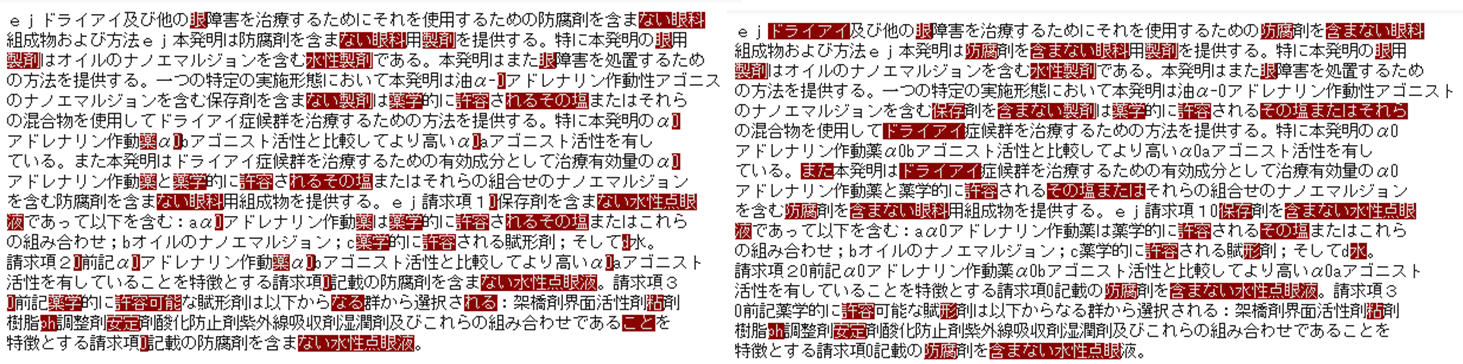

C.SHAP値を用い重要語にハイライトをつけたが・・・単語ベースでは明確なモデル間差は見られていない.=>見られた.

図2)pre-trained word2vecベースのmaxpoolingモデル(左)とkeras embedベースのmaxpoolingモデル(右)でSHAP値上位となる単語を比較(個性差が見られなかった特許の場合の1)

code

・正答不正答における個性差が見られなかった特許(図2)において,ハイライトされた単語に大差はないように見える.再現性もある.(あえていえば右のモデルのほうがtfidf的か.)(いや異なると判断すべきだろう→個性比較へ)

・正答不正答における個性差が見られた特許において,ハイライトされた単語に明確な差があった.(左のモデルでは期待通りの「価値観に基づく類義・関連語の統合」が起きているようだ.調査方針が丸わかりになるため公開せず.)

*正答不正答における個性差が見られなかった特許のうち不正解と正答されない傾向にあった特許において,ハイライトされた単語は明らかなノイズであった.SHAPはノイズ発見の役にも立ちそうか.

・同じ単語でもSHAP値が異なることがある.(図のモデルでは前後数単語poolしている.)

*少なくとも,記号系が得意なモデルと得意でないモデルがある.(これはモデルのアルゴリズムから予測できた.ただし,記号が付されていない特許でも差が現れているので,他にも差の原因があるのは確か.)(ウインドウサイズが個性に影響していないのだが,アルゴリズムからするとそうなる理由がわからない.)

*LIME https://github.com/marcotcr/lime も試用した.傾向はSHAPと似ていたが,再現性が低く機能語に当たりやすい傾向があった.

*主題と異なるが,ここから特徴語を取り出している.(特許と実製品とのリンクは重要である.特徴語からの実製品抽出を試行中.)

・BERT名詞限定におけるハイライト一例.

SHAPではない破壊手法.収束確認していない.再現性確認していない.

名詞限定としてもある程度妥当な語がハイライトされる.面白い.

(queryとkeyから得られるattentionにマルコフ性があるとして、queryの名詞に対し重みが大きいといえるkeyの単語は助詞ではないであろうから当然か?。一応attentionの重み付けをしたベクトルかattention自体と比較しておこう。)

*なぜその特許を正答としたのか擬人化した各モデルに尋ねればこんな回答が返ってくるだろうか.

・・w2v-mp:教えられた意味に基づけば異なるが私が思うに検索者は製剤特許という構造を持つものを情報として得たいのではないかと考えたため(うむ.実際はそうでもないが好ましい意見だ).

・・keb-mp:与えられた教師とデータを総合したところこれらが特徴と言えたから(真面目だ).

・・BERT:文脈から分類すると関連する単語はこれだったから.概念?因果?何それ(ファインマンに謝れ).

・・BERTm:肝と言える関連名詞がこれだったから.概念?因果?何それ(うむう).

・個性比較(正答不正答における個性差が見られなかった特許)

*w2v-mpではwswによりドライアイを強調していることに注意。wswを抜いて比較するのを忘れていた)

すべて,特徴らしい単語にハイライトがついており,モデルごとに異なっている.

単語における個性が確認できる.

どのモデルも正答している.そしてモデルごとに注目した単語が異なっている。正答とすべき根拠となる単語が複数あるところ,モデルごとに異なる視点で,ルートで,正答にたどり着いたように見える.

多様性評価において価値があるといえる個性となっているようだ.

(多様性評価において価値のある個性となっているかどうかについては,偶然そう見える結果のみ観ている,認知バイアスがある,可能性を否定しきれない.ある程度の検証と理論的考察がやはり必要だ。しかし,理論的背景がどのようであるか,考えもつかない(分布で表現することになるのだろうか.シンプルに単語の出現頻度で表現するか.).どうしたものか.手持ちのデータ全てを確認し,全てそう見える,とまとめてしまおうか・・・)

・後述するように,ヒト認知との適合にモデルごとに差が,ヒト認知における個性の存在が,観られている.

(この部分を突き詰めることにより、視点の違いが何故生まれるのか理解できるのではないか。)

*今更だが,個性の定義を明確にしておいたほうが良さそうだ.

個性とは,

・goo国語辞書によると「個人または個体・個物に備わった、そのもの特有の性質。個人性。パーソナリティー」.

・wikipediaによると「個人や個体の持つ、それ特有の性質・特徴。特に個人のそれに関しては、パーソナリティと呼ばれる」

はっきりしているな.

「モデル間に違いがあり,違いに再現性があれば,個性がある」と言っても良さそうだ.

あるモデルでしか正解できないサンプルが存在し,それに再現性があれば,そのモデルに個性があると言えるだろう.

ヒトの認知と常に近いモデルであり他のモデルよりも常に優れるのであれば,そのモデルに個性があると言えるだろう.

ヒトの認知のうちある範囲に付き,常に近いモデルであるならば,そのモデルに個性があると言えるだろう.

特有の性質はいくらでも考えられる.

モデルの個性は,「見つかった特有の性質を,他のモデルと比較し,総合的に」,表現すればよいか.比較対象には一般的なモデルも欲しいところだが・・・keb-mpのCNN版を一般的なモデルとすれば良いか.

(本文中で「個性らしき」「個性があるのでは」と書いてきたが,断言しても良さそうだ.)

疑問点・課題:

A. SHAPを正しく使用できているか

できているはず。

SHAPがいつの間にかテキストにもHuggingFace transformersにも正式に対応していた。比較確認する。

SHAPにおいて赤帯青帯の境界に示される正解予測値は予測値そのものと同じである.この出力ができている点については,SHAPを正しく使用できているはず.赤帯青帯の幅についても,SHAPを正しく使用できているはず.

個別の単語に対するハイライト強度については,SHAPを正しく使用できているはずだが,コードを追いきれておらずまたSHAPの自然言語への適用が少なく,確証がない.結果としては,妥当にハイライトされているように見える.

(特定の文章内における単語ハイライト妥当性、WSW実施時の単語ハイライト強度と予測値変動。)

*Keras LSTM for IMDB Sentiment Classification

https://slundberg.github.io/shap/notebooks/deep_explainer/Keras%20LSTM%20for%20IMDB%20Sentiment%20Classification.html

*モデルの個性を理解してゆくにあたり,理解に必要な手法が共通しているに越したことはない.SHAPは汎用性がありそうなのでできるだけ使ってゆきたいのだが.

(モデル限定となるがattentionからの理解が流行している.しかし疑問もあるそうだ.Attention is not Explanation https://arxiv.org/abs/1902.10186 )

*p26~モデルの解釈性(201908)

https://speakerdeck.com/mimihub/20190827-aws-mlloft-lt5?slide=29

*GoogleのExplainable AIはsharpley valueを計算しているとのこと.GoogleのExplainable AIが自然言語にどう対応してゆくか確認してゆくこと.

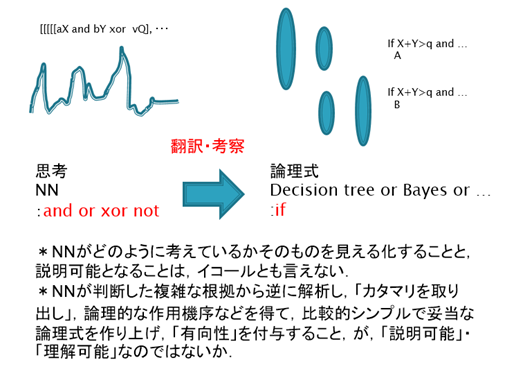

*説明と理解。

NNが判断した複雑な根拠から逆に解析し,「カタマリとなるクラスタを取り出し」,論理的な作用機序などを得て,比較的シンプルで妥当な論理式を作り上げ,「有向性を付与」すること,が,「説明可能」,ひいては「理解可能」につながるのではないだろうか.

(ヒトは思考の末に直感に反しさえもする理論を作り上げ説明し理解するのであって、

直感を複雑なままとらえ説明し理解するのではない.少なくともヒトへの説明には,単純化が必須であると思う.理解自体には単純化が必須とは言えないが.)

(さらに,多様性の立場に立つと,一つのNNが判断した根拠は正答を導く唯一の道ではない,として,多様な道のすり合わせによりより良い理論が形成される,と考えたいところ.耳に注目して動物を見分けても良いし,眼に注目して見分けても良いし,他でも良い.正しい答えを導くそれら組み合わせはまた多くあるだろう.その多くの組み合わせをまとめて,論理式を作るべき,という考え方. 一つのNNでその論理式の形成までたどり着くかと言われると,多分,一つのNN,一つの伝播範囲?,では,それほど大きな多様性は生まれないのではないかな・・・分布がある程度近似してしまい,例えば眼は必ず考慮する,などとなってしまうのでは.)

SHAPは「カタマリ」を取り出すに妥当と思う。問題は「有向性」だ。これは「理解」に含めてCで扱うことにする。

(「ヒトによる理解」には有向性が必要でありその派生として「説明」にも有向性が必要となるが、本質的には説明に有向性は不要だと思う。ヒトによる理解に有向性が必要である理由は、ヒトは7つほどしか「根拠」を把握できないところ、有向性を付与することにより7つの「根拠」からでも、より多くの理解が得られるようになるから、ではないかな。とするなら、「複雑な根拠を7つほどのカタマリに圧縮するクラスタリング」と有向性付与が、ヒトへの説明における答えとなるのだろう。)(カタマリを抽出することをローカルな説明と呼び、カタマリに有向性を足したものを抽出することをグローバルな説明と呼ぶ、と分けたほうが良いか。本手法では、ローカルな説明はSHAP、グローバルな説明はcheck system全体?、となろうか。)(多分,説明を受けるものと説明するものの間で,「ドメイン(分布)のすり合わせ」ができて初めて,「説明」が「理解」となるのだろう.(最初からすり合わせておいたほうが良いと思うが,最後にすり合わせることも可能だろう.))

*SHAPハイライトに加えて単語間の共起性を示すようにすれば、現状使用しているモデルにおいて必要な「検索者に対する」「説明」は充分かな。さらに加えるとしても、ほかのモデルを参照したり自分で見直すインサイトを与えるため、そのモデルが重視しやすい単語・構造と重視しにくい単語・構造を示す(check system全体で補正してしまうが補正したと示すほうが良いだろう)程度か。(「モデル個性の評価のために行う」「理解」は別。)

*次の用語に統一し整理すべき?.

・Data(データ)… 整理されていない情報。いわゆる「ローデータ」 =「データ」

・Information(情報)… データを何らかの基準で整理(カテゴライズ)したもの =「カタマリ」(セグメンテーションとクラスタリングが混ざるかな・・・)

・Knowledge(知識)… Informationから導き出される、規則性、傾向、知見 =「有向性付与」(各クラスタに対する要約付与,だけでもよいか?)

・Wisdom(知恵)… 「人が」Knowledgeを活用して判断する力 =「理解」

*今ひとつ「説明」の行き場がないかな・・・

*産総研人工知能研究センター【第40回AIセミナー】機械学習モデルの判断根拠の説明(Ver.2)(202001)

https://www.slideshare.net/SatoshiHara3/ver2-225753735

*tidymodels+DALEXによる解釈可能な機械学習 / Tokyo.R83(202001)

https://speakerdeck.com/dropout009/tokyo-dot-r83

*以降、説明可能は下記Cに記載することとする。

*SHAPがいつの間にかテキストにもHuggingFace transformersにも正式に対応していた。

ドキュメントも豊富に。これで前例がほぼ無いなか掻き分けないで済む。ありがたい。そんな能力ないんだよ・・・

https://shap.readthedocs.io/en/latest/example_notebooks/api_examples/plots/text.html

機械学習モデルを解釈する指標SHAPを自然言語処理に対して使ってみた

https://qiita.com/m__k/items/87cf3e4acf414408bfed

B. モデルの個性をどう作るか.

正答不正答において,モデル間に個性がみられている.

正答不正答における個性のみからでは,モデルの個性をどう作ればよいのか,定かになっていない.

w2v-mpモデルの個性を恣意的に調整するために,wswを追加した.

ヒト認知を示す個性として,Expert system,eswを追加した.

ヒト認知との適合において,モデル間に個性がみられた.(keb-mpとBERTは(なぜか)ヒト認知との適合においてほぼ互い重複しない結果を示した.)

ヒト認知における個性において,その個性が発揮される理由とアルゴリズムが理解できれば,モデルの個性をどう作ればよいのか,理解できるだろう.

w2v-mpは文章を上位概念で、keb-mpは文章を下位概念で認識しているように見える。

上位概念下位概念で捉えていることが確認でき、その要因がつかめたならば、モデルの個性をどう作ればよいのか,理解できるだろう.

SHAPを正しく使用できているとして,

・ハイパーパラメータを変えてみたが,今のところ,個性の変化は見られていない.

(赤帯青帯の幅が全体的に変化する程度.波形のパターンは変化せず.local minimumが少なくなるようにモデルを作っているがその影響か.)(window sizeが個性に影響しない点が意外であった.averagepoolingでなくmaxpoolingとしたためか.window sizeが大きいとリークが云々という文献を読んだ気がするがメモをするのを忘れてしまった・・・)(すべてのパラメータについて確認しきれているわけではない.)(少なくとも,正則化が個性を明確にするだろう.)

・keras embedベースのmaxpoolingモデルと,keras embedベースのCNNモデルで比較した場合でも,個性の変化は見られていない.(転移学習でも個性の変化までは望み薄であろうか.)

・ランダムフォレストも試したがacc0.75と低すぎたため検討できなかった.

・文字レベルの前処理や,品詞限定の前処理によって,個性が表れるかもしれない.

(特許では,名詞重視で形容詞副詞が少ないという特徴がある?(形容詞を書くぐらいならそれを表すデータを書く)ため機能語を削ることができそれにより個性が際立つのでは.)(結果として,名詞限定により正解がより上位に集中する結果となった経験がある.FNが増えてしまったが.)(契約書コーパスと法律コーパスの品詞比較など https://speakerdeck.com/mimihub/20190827-aws-mlloft-lt5?slide=18 )(既知の知識に従い前処理を過剰にしてゆけばその結果は古典的な統計手法による結果に近づく.それなら最初から古典的な統計手法を用いたほうが良い.深層学習においては,前処理は最低限にするか,慎重に見極めないといけない.)

・分散表現のpre-train学習に用いるコーパスが個性に大きく影響を与えるのではないか,と思っている.

(個性をもたせるには,コーパスには偏りが必要でありかつコーパスが大きすぎてもいけない,とすべきだろう.すると未知語oovが増加しやすいので,未知語処理が重要となる.ベクトル平均は次善の策とわかっていたのでより適切になるよう一応の対応済み.magnitude https://github.com/plasticityai/magnitude に期待している.)(未知語処理も個性に寄与しているようだ.)(201909時点の未知語処理実装は,transformerを分散表現メインに書き直したような構造となっている。)

・ホットリンク日本語大規模SNS+Webコーパス

https://www.hottolink.co.jp/blog/20190304-2.

・BERTは個性がないが高性能,という意味で外せない個性だろう.

(実装すれば多分市販AI不要となるだろう(今でも不要といえば不要だが,個性解析できてないことに加えて今後の改良に期待して残している.)

→201903BERT実装

*標準のmultilingual modelでfine-tuning BERT試行.入力サイズ1/3で epo16 acc0.9 4min.入力サイズ1/2で epo16 acc0.9 6min.=>記事の最後にBERTの結果を追加する.

・Juman++&BPE 黒川河原研BERT日本語Pretrainedモデル

http://nlp.ist.i.kyoto-u.ac.jp/index.php?BERT日本語Pretrainedモデル

・SentencePiece hottoSNS-BERT

https://www.hottolink.co.jp/blog/20190311-2

・MeCab StockMark日本語ビジネスニュースコーパスBERT事前学習済モデル

https://qiita.com/mkt3/items/3c1278339ff1bcc0187f

*英語では,

BioBERT

https://arxiv.org/abs/1901.08746

SciBERT

https://arxiv.org/abs/1903.10676

などもあるようです.PatBERTは見当たらないな・・・

→Jieh-Sheng Lee and Jieh Hsiang.

PatentBERT: Patent clas-

sification with fine-tuning a pre-trained BERT model.

arXiv

preprint arXiv:1906.02124, 2019.

・BERT以降のSoTA:

MTDNN

https://arxiv.org/abs/1901.11504

Improving Language Understanding by Generative Pre-Training(transformers and unsupervised pre-training)

https://openai.com/blog/language-unsupervised/

Unified Language Model Pre-training for Natural Language Understanding and Generation (Microsoft)

https://arxiv.org/abs/1905.03197

XLNet: Generalized Autoregressive Pretraining for Language Understanding

https://arxiv.org/abs/1906.08237

RoBERTa

https://arxiv.org/abs/1907.11692

ALBERT: A Lite BERT for Self-supervised Learning of Language Representations

https://openreview.net/forum?id=H1eA7AEtvS

https://github.com/google-research/google-research/tree/master/albert

RACEでみた進歩.

http://www.qizhexie.com/data/RACE_leaderboard

・・・

*Unsupervised Data Augmentation

https://arxiv.org/abs/1904.12848

「教師なしに用いる」データを作る手法.これは使えそうか.

*Making Convolutional Networks Shift-Invariant Again

https://arxiv.org/abs/1904.11486

*Predictive Uncertainty Estimation via Prior Networks.

http://arxiv.org/abs/1802.10501

*一般形は特殊形の代わりにはならない.

・個性の調整について.

上記システムのweight specific words(wsw)と記載した箇所では,w2v-mpの個性の調整を行っている.

下図(上)から(下)への変化は,w2v-mpモデルに単語「rhoキナーゼ」を重視させることをwswにより試み,その結果「rhoキナーゼ」に期待通りハイライトが当たったことを示している.

(このような柔軟な調整が可能とできるのは自作ならではといえようか.)(モデル内部をいじっている.モデルの理解とメタ知識を利用している.)(ちょっとした事で使いやすくなるのだが,自作でなく市販ツールを用いているとそのちょっとした事ができないのだよね.ベンダーに注文つけてもこのような機能つけてくれたりしないか時間がかかる.AIではこのようなユーザー特化が重要と思っているのでできないというのは致命的ではないだろうか.)(教師データは基本的に過去からしか得られないため,このようなプロアクティブな手法も重要.)(この単語重視により,本特許の順位は164位から84位に上昇.上位100位までの変動を確認するも本特許以外は+-12位内で変わらず.個性を大きく変更せずに,特定の単語を重視させることができたと言って良いだろう.様々な条件が考えられ十分に検証できているとは言えないが.(上記単語を含んでいても,すでに順位が高い場合はほぼ順位に変動なし,など.))(言うまでもないが,何らかの教師が本筋.ただ,安易な教師変更は意図しない性能悪化を招くため,教師変更をした場合には,必ず,全体の検証をし直さないといけない.上記手法はその毎回の詳細な検証をほぼ不要とできるだろう.)

*上図は教師を追加した場合のkeb-mp.図(右)のように,教師データを追加すれば正解候補に正答することは簡単.しかし,ただ単に教師データを追加したのみの場合,図(左)が示唆するようにFPが増えるなど,全体のバランスが崩れうる.

(そも改善用の良い教師データが得られるのは事後であるのであるから,教師データでの改良は,常に手遅れである,と言える.)(data augumentationには基本的に反対.注意深く行ったときのみ可,と考えている.)(自然言語分野において,大量に教師データを追加した場合でも全体のバランスを崩さないといえる深層学習モデルは,今のところ,BERTなどTransformer系モデルぐらいではないだろうか?.)

*Two models of double descent for weak features

https://arxiv.org/abs/1903.07571

過学習のリスクは特徴より教師が小さい場合には低下する?

*ヒトは対象物がある特定の範囲に入るか否かを決めるとき,次のような類別をしていると言われる.

1カテゴリの「ルール」に適合するか

2カテゴリ内の「ある特定の対象と類似」するか

3カテゴリの「基本形」に類似するか

さて,現状のモデルはどこまでできているだろうか.

ルールベースの文構造では担保しきれないことは,文章表現の多様性から見て明らかに思える.n-gramも限界があるだろう.transformerに期待はできるが十分でなく,さらに「構造を抽出する蒸留」が必要となるのだろう.下記,Unsupervised Distillation of Syntactic Information from Contextualized Word Representationsのような.

*Hyperparameter Tuning and Implicit Regularization in Minibatch SGD

Anonymous

26 Sep 2019 (modified: 26 Sep 2019)ICLR 2020 Conference

https://openreview.net/forum?id=ryGWhJBtDB

バッチサイズとノイズ支配,精度.ああ,なるほど.

・ヒト認知との適合についてはC参照.

*Document Scanner using Computer Vision

https://towardsdatascience.com/document-scanner-using-computer-vision-opencv-and-python-20b87b1cbb06

昔々pdfをpyocrだったか?を使って6000件ほど処理させたことがあったが、まともに認識されたのは5割ほどだったかな。そろそろやり直してみるか。

C. モデルの個性をどう理解・評価するか.理解するためのモデルによる自己説明を含めて

D. モデルに創造性をもたせることはできるのか.

展望:

*BERT: 201903~

*20211003,502 bad gateway対策として,前,中,後へ分割

前 https://qiita.com/kzuzuo/items/4670b5ff7526319680f4

中 https://qiita.com/kzuzuo/items/237b9f5192464817aa40

後 https://qiita.com/kzuzuo/items/756470e6e17c54aa5e2e