先日「IBM Cloud PLUS - #3 IBM PowerVS 入門と最新情報」という Web セミナーを開催しました。

リンク先に資料や Replay を掲載しましたので、ご覧いただければ幸いです。

その準備で久しぶりに PowerVS のインスタンスを構築しましたが、GUI がすっかり変わっていて驚きました。

そこで、新しいポータル GUI でのデプロイ手順と、そのオプションを改めて解説したいと思います。

全部で 8回のシリーズです。

前回の「ワークスペースの作成」ではインスタンスと、その附随資源を管理する「ワークスペース」を作成しました。

今回は、インスタンスの作成開始と「一般」の指定です。

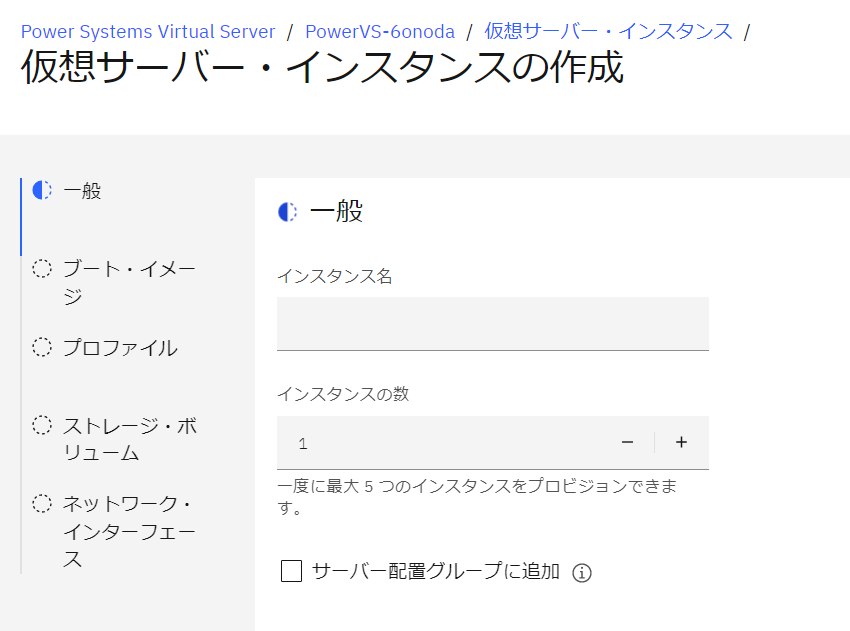

インスタンスの作成

「仮想サーバー・インスタンス」の「インスタンスの作成」をクリックします。

インスタンス作成の 5 つのステップ

左側のナビゲーションでインスタンス作成には下記の 5 つのステップがあるのが分かります。

- 一般

- ブート・イメージ

- プロファイル

- ストレージ・ボリューム

- ネットワーク・インターフェース

今回は、このうち「一般」のステップを検討しましょう。

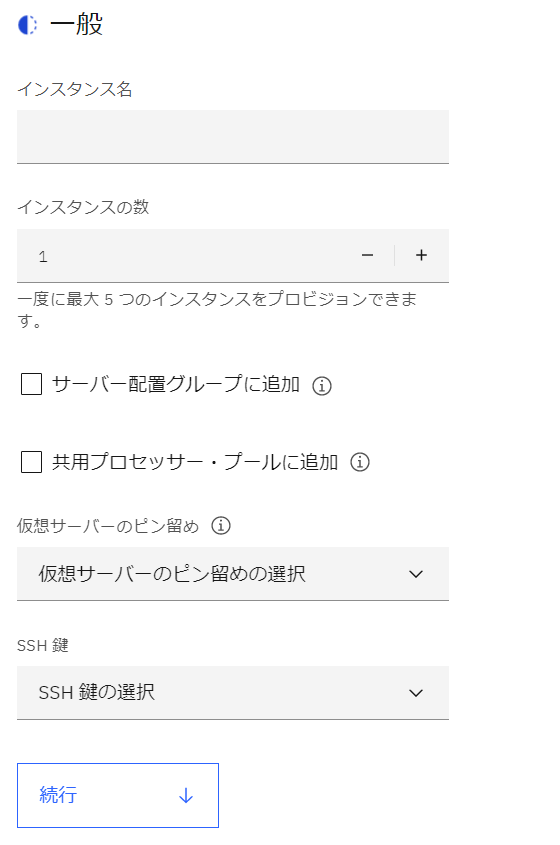

「一般」の設定項目

「一般」の設定項目は下記になります。

インスタンス名

「インスタンス名」は、インスタンスに付ける名前そのものです。

インスタンスの数

「インスタンスの数」が「1」の時と「2 以上」場合で GUI が変化します。

インスタンスの数が「1」の場合

インスタンスの数が「1」の場合「サーバー配置グループに追加」と「共用プロセッサー・プールに追加」がチェックで選べるようになっています。

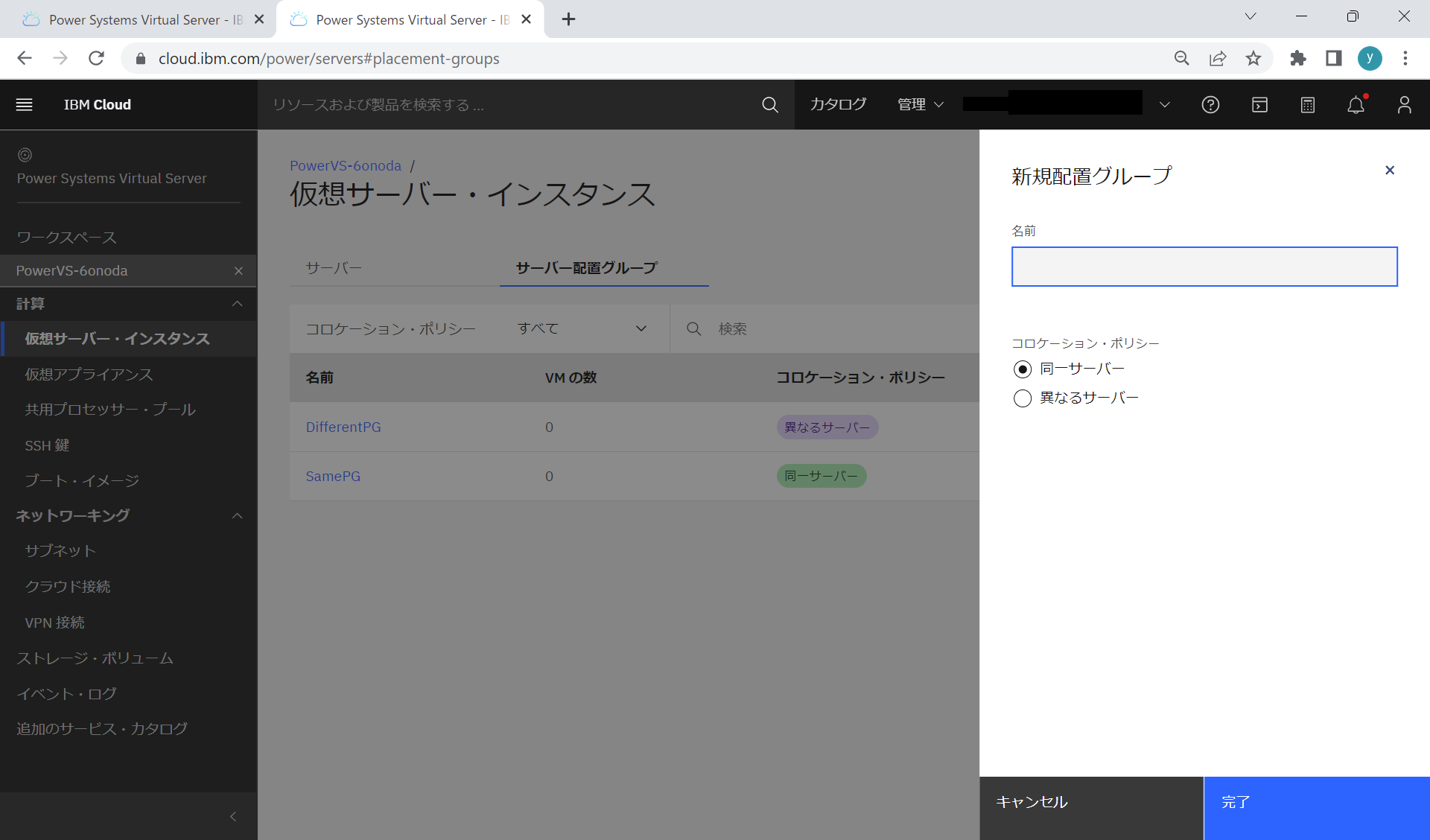

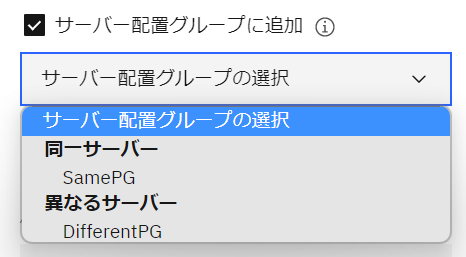

サーバー配置グループ

「サーバー配置グループ」は、インスタンスを同一の物理サーバーにデプロイするのか、異なる物理サーバーにデプロイするのかを決定する機能です。

インスタンスの数が「1」の場合で、サーバー配置グループの機能を使いたい場合は、サーバー配置グループの事前作成が必要です。

サーバー配置グループは「https://cloud.ibm.com/power/servers#placement-groups」で作成・管理を行います。

配置グループのコロケーションポリシーには「同一サーバー」と「異なるサーバー」が選択可能です。

「同一サーバー」を選んだ場合、同じ物理サーバーに配置されるため、高速な内部通信が期待できます。ただし、サーバー障害時には当時にその影響を受けます。

「異なるサーバー」を選んだ場合、異なる物理サーバーに配置されるため障害対策に有利になります。

利用する場合は「サーバー配置グループ」にチェックをいれて、事前定義したサーバー配置グループから選択します。

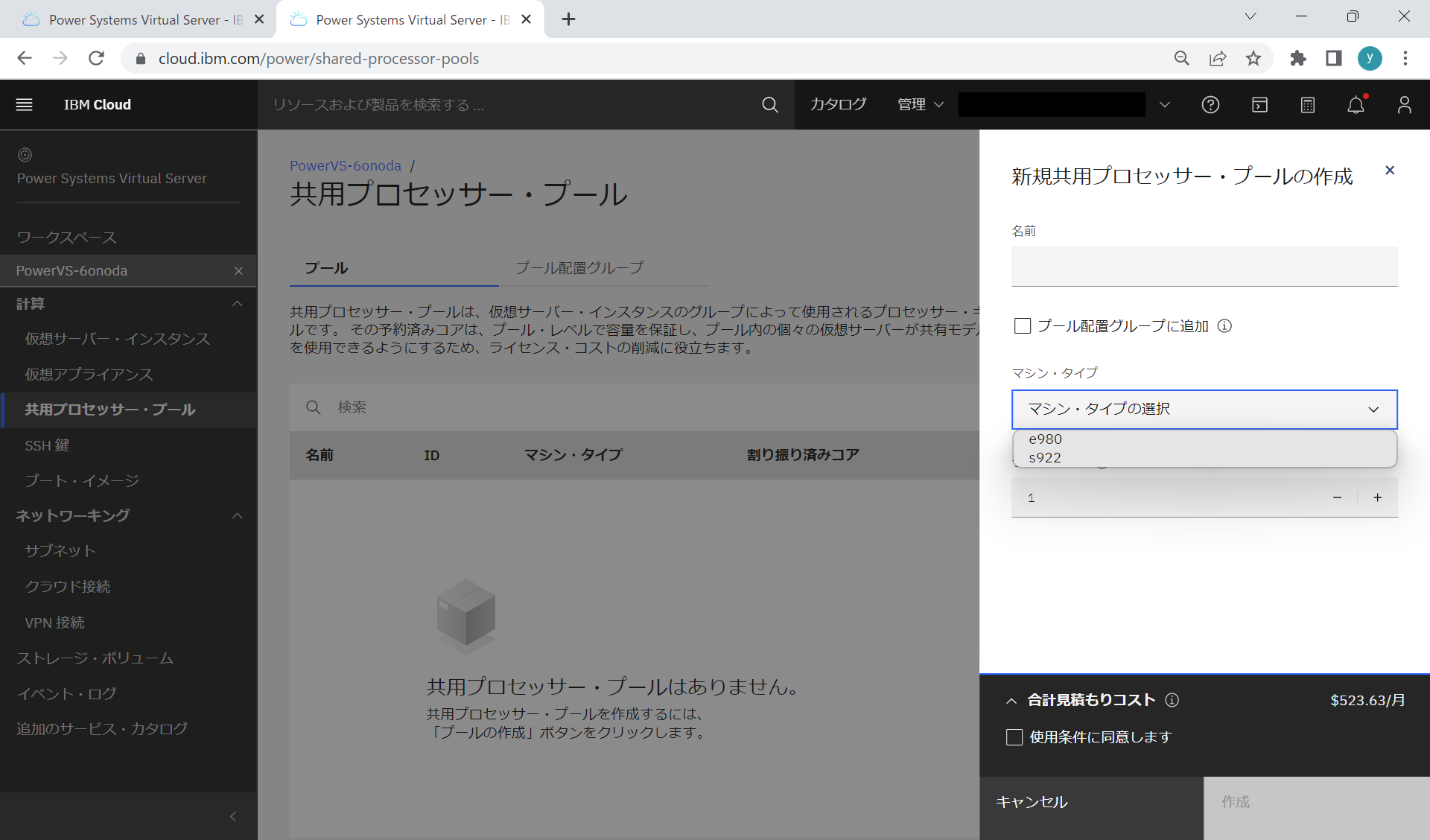

共用プロセッサー・プール

「共用プロセッサー・プール」は、プロセッサー資源をコア単位で予約し、インスタンス間で共有する仕組みです。

共用プロセッサー・プールの機能を使いたい場合は、インスタンスの数を「1」にして事前作成したものから選択します。

共用プロセッサー・プールは「https://cloud.ibm.com/power/shared-processor-pools](https://cloud.ibm.com/power/shared-processor-pools)」で作成管理を行います。

共用プロセッサー・プールは、単一のサーバー内での CPU コアを複数インスタンスで共有するものです。

そのため、同じ共用プロセッサー・プールに配置されたインスタンスは、同じ物理サーバーに配置されます。

作成時にはマシン・タイプと予約するコア数の指定が必要です。

共用プロセッサー・プールに配置しなくても、インスタンスを作成する時に「コア・タイプ」で「上限なし共有」を選択すれば、指定した以上のプロセッサー能力が利用できる可能性がありますが、利用できるかどうかは、その時の状況次第です。

一方、共用プロセッサー・プールに配置されたインスタンス群は、共用プロセッサー・プールで指定したコアの利用が保証されています。プール内でプロセッサー能力の共有は、必ず実現することが可能です。

共用プロセッサー・プールにも「プール配置グループ」という配置グループがあります。

これは、各々の「プール配置グループ」を同一サーバーに配置するのか異なるサーバーに配置するのかの指定です。

共用プロセッサー・プールついては、こちらで詳しく解説されています。

- Power Virtual Server (PowerVS)のShared Processor Pool機能を使ってみる

- Power Virtual Server (PowerVS)のshared processor pool placement group (SPP PG) について

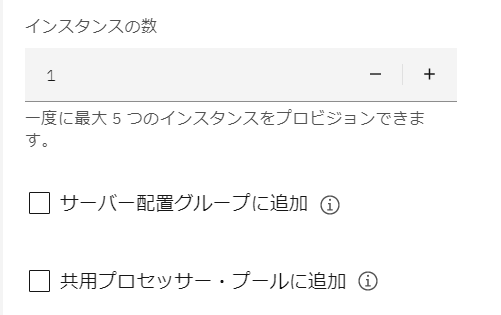

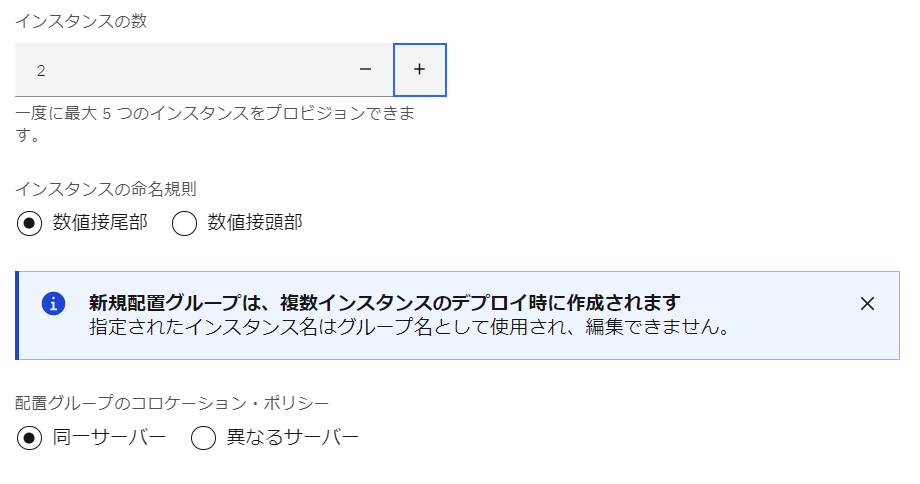

インスタンスの数が「2 以上」の場合

5つまでのインスタンスを同時に作成することが可能です。

インスタンスの数が「2 以上」の場合の指定項目は下記になります。

インスタンスの命名規則

「インスタンスの命名規則」は、複数インスタンスの名前を区別するために、名前の終わりか先頭かどちらに連番をつかるのかの指定です。

「数値接尾部」であれば終わりに「数値接頭部」であれば先頭に連番が付記されます。

配置グループは自動作成

複数インスタンスを一括作成する場合、必ず配置グループに配置されます。

ただし、既存の配置グループを指定することはできません。

代わりに、新規の配置グループが自動作成されます。

なお、後からインスタンスの数を「1」にしてデプロイ時に自動作成された配置グループに、インスタンスを追加することは可能です。

共用プロセッサー・プールは指定できない

複数インスタンスを一括作成する場合、共用プロセッサー・プールは指定できません。

共用プロセッサー・プールを利用する場合は 1 台ずつインスタンスを作成してください。

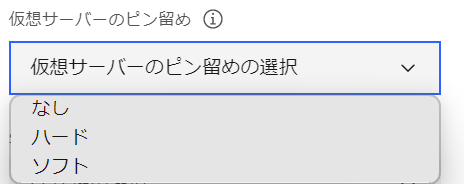

仮想サーバーのピン留め

「仮想サーバーのピン留め」は「なし」「ハード」「ソフト」から選択するすることができます。

これは、配置されている物理サーバーの障害時のインスタンスの起動先を制御するものです。

仮想サーバーのピン留め-なし

仮想サーバーは物理サーバーに紐づいていません。

物理サーバーの障害時、別の物理サーバーで起動します。

もともとの物理サーバーが回復しても、移動先のサーバーで稼働し続けます。

仮想サーバーのピン留め-ハード

仮想サーバーは物理サーバーに強く紐づいています。

物理サーバーの障害時、別の物理サーバーで起動せず、物理サーバーの回復を待ちます。

サードパーティのライセンスが、物理サーバーのシリアルに強く紐づいている/指定したシリアル以外では稼働しない場合などに利用されます。

仮想サーバーのピン留め-ソフト

仮想サーバーは物理サーバーに弱く紐づいています。

物理サーバーの障害時、別の物理サーバーで起動します。

もともとの物理サーバーが回復した場合、もともとのサーバーに戻ってきます。

サードパーティのライセンスが、異なるシリアルであっても一定の猶予期間なら稼働を許可する場合などに利用されます。

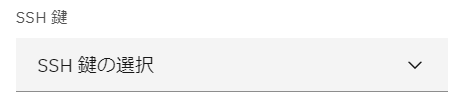

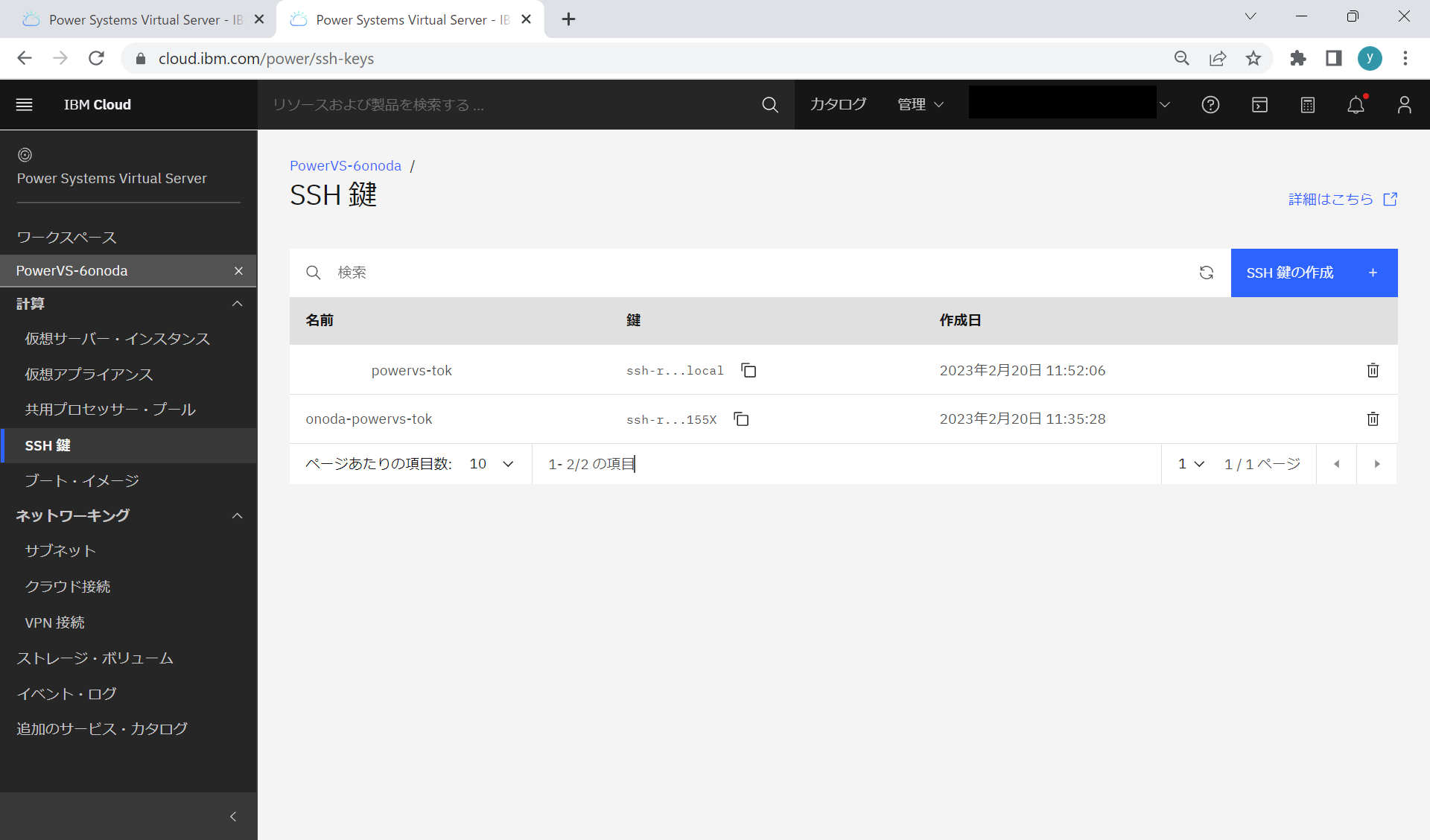

SSH 鍵

事前に登録した「SSH 鍵」がリストから選択可能です。

SSH 鍵は「https://cloud.ibm.com/power/ssh-keys」で作成・管理を行います。

AIX や Linux の場合 sshd での ログインが自動構成されるためキーの事前作成と選択が重要ですが、IBM i の場合は、sshd での ログインは自動構成されません。

そのため「SSH 鍵の選択」には意味がありません。

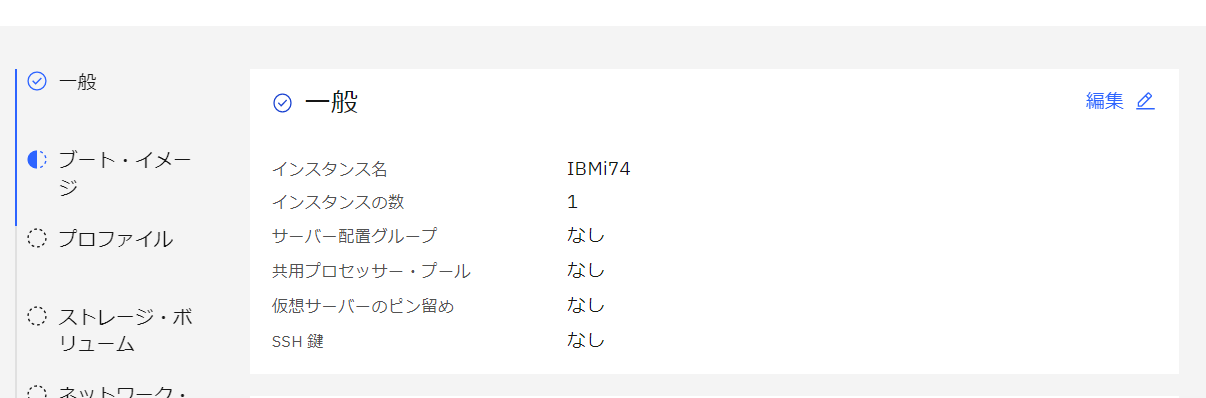

「続行」で確定

「続行」をクリックすると「一般」の設定が確定し次の「ブート・イメージ」の指定が可能になります。

「一般」の設定を変更したい場合は「編集」をクリックします。

次回は「ブート・イメージ」を指定します。

次回の記事はこちらです。

当日記のIndexはこちらです。

許可の無い転載を禁じます。

この記事は筆者の個人的な責任で無保証で提供しています。

当記事に関してIBMやビジネスパートナーに問い合わせることは、固くお断りします。