<科目> 機械学習

目次リンク

目次

第一章:線形回帰モデル

[第二章:非線形回帰モデル]

(https://qiita.com/matsukura04583/items/baa3f2269537036abc57)

[第三章:ロジスティク回帰モデル]

(https://qiita.com/matsukura04583/items/0fb73183e4a7a6f06aa5)

[第四章:主成分分析]

(https://qiita.com/matsukura04583/items/b3b5d2d22189afc9c81c)

[第五章:アルゴリズム1(k近傍法(kNN))]

(https://qiita.com/matsukura04583/items/543719b44159322221ed)

[第六章:アルゴリズム2(k-means)]

(https://qiita.com/matsukura04583/items/050c98c7bb1c9e91be71)

[第七章:サポートベクターマシン]

(https://qiita.com/matsukura04583/items/6b718642bcbf97ae2ca8)

はじめに

機械学習の基本的な手法を理解し実装する

- 線形回帰

- ロジスティック回帰

- 主成分分析

- K平均法など

機械学習モデリングの流れ

1.問題設定->2.データ選定->3.データの前処理->4.機械学習モデルの選定

->5.モデルの学習(パラメータ推定)->6.モデルの評価

機械学習の分類と代表的なモデルと特徴

| 学習分類 | タスク |機械学習モデル|パラメータの

推定問題|モデル

選択・評価|

|----| ---- |---- | ---- |---- | ---- |

| 教師あり学習 | 予測 |線形回帰・非線形回帰 | 最小2乗法・尤度最大化 |ホールドアウト法・交差検証法 |

| 同上 | 分類|ロジスティック回帰 | 尤度最大化(最尤法) |同上|

| 同上 |同上 |最近傍・K近傍-アルゴリズム |最近傍・K近傍-アルゴリズム |同上 |

| 同上 |同上 |サポートベクターマシン | マージン最大化|同上 |

| 教師なし学習 | クラスタリング |K-meansアルゴリズム |K-meansアルゴリズム- |なし |

| 同上 | 次元削減 |主成分分析 | 分散最大化 |なし| ---- |

第一章:線形回帰モデル

回帰問題とは

- ある入力(離散あるいは連続値)から出力(連続値)を予測する問題

- 直線で予測→線形回帰

- 曲線で予測→非線形回帰

回帰で扱うデータ

- 入力(各要素を**説明変数または特徴量**と呼ぶ) ⇒ m次元のベクトル(m=1はスカラ)

- 出力(目的変数) ⇒ スカラ値

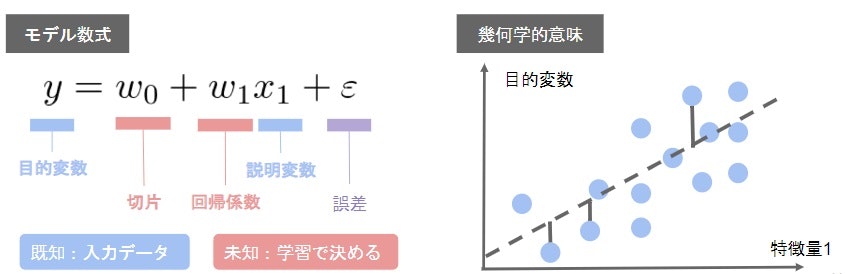

線形回帰モデル

| 項目 | 説明 |

|---|---|

| 学習分類 | 教師あり学習 |

| タスク | 予測 |

| 機械学習モデル | 線形回帰・ |

| パラメータの 推定問題 |

最小2乗法・尤度最大化 |

| モデル選択・評価 | ホールドアウト法 交差検証法 |

- 入力とm次元パラメータの線形結合を出力するモデル

- <<慣例表記の注意>>予測値にはハット(^)を付ける(正解データとは異なる意味を持つ)

- 教師データ

{(x_i,y_i):i=1,・・・,n}

- パラメータ

w=(w_1,w_2,・・・,w_m)^T \in R^m

- 線形結合(予測値はハットを付ける慣習)

\hat{y}=w^Tx+w_0 = \sum_{j=1}^{m} w_jx_j+w_0

- (トピック)最尤法による回帰係数の推定

- 誤差を正規分布に従う確率変数を仮定し、尤度関数の最大化を利用した推定も可能

- 回帰の場合には、最尤法による解は最小二乗法の階と一致する。

線形回帰モデル (Linear Regression) とは、以下のような回帰式を用いて、説明変数の値から目的変数の値を予測するモデルです。

特に、説明変数が 1 つの場合「単回帰分析」、説明変数が 2 変数以上で構成される場合「重回帰分析」と呼ばれます。

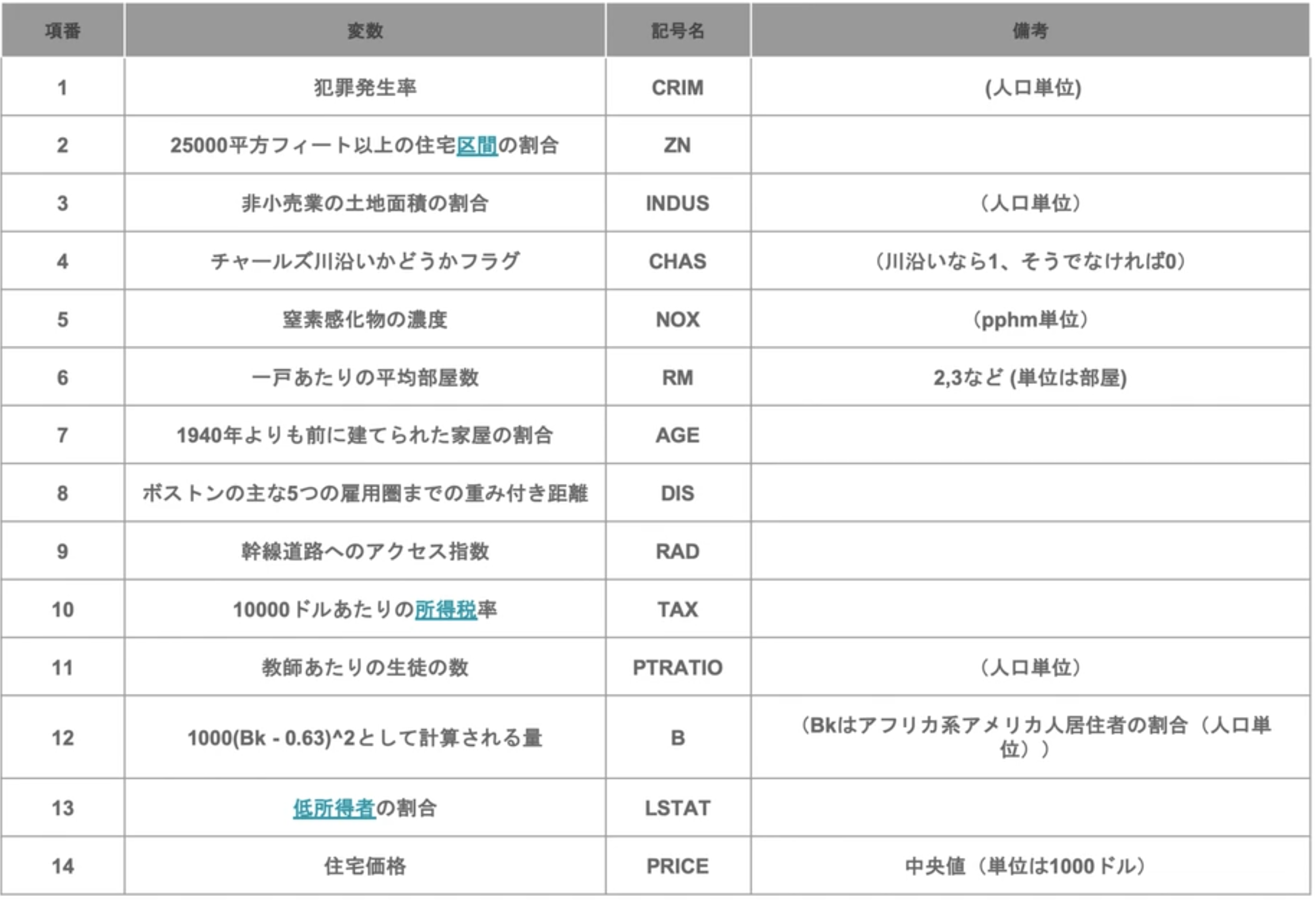

(演習1)scikit-learn を用いた線形回帰モデル-Boston Hausing Data-

やること

- 設定

- ぼすとんの住宅データセットを線形モデルで分析

- 適切な査定結果が必要

- 高過ぎても安過ぎても会社に損害がある

- 課題

- 部屋数が4で犯罪率が0.3の物件はいくらになるか?

- 必要モジュールとデータのインポート

# from モジュール名 import クラス名(もしくは関数名や変数名)

from sklearn.datasets import load_boston

from pandas import DataFrame

import numpy as np

# ボストンデータを"boston"というインスタンスにインポート

boston = load_boston()

# インポートしたデータを確認(data / target / feature_names / DESCR)

print(boston)

bostonの内容を表示

{'data': array([[6.3200e-03, 1.8000e+01, 2.3100e+00, ..., 1.5300e+01, 3.9690e+02,

4.9800e+00],

[2.7310e-02, 0.0000e+00, 7.0700e+00, ..., 1.7800e+01, 3.9690e+02,

9.1400e+00],

[2.7290e-02, 0.0000e+00, 7.0700e+00, ..., 1.7800e+01, 3.9283e+02,

4.0300e+00],

...,

[6.0760e-02, 0.0000e+00, 1.1930e+01, ..., 2.1000e+01, 3.9690e+02,

5.6400e+00],

[1.0959e-01, 0.0000e+00, 1.1930e+01, ..., 2.1000e+01, 3.9345e+02,

6.4800e+00],

[4.7410e-02, 0.0000e+00, 1.1930e+01, ..., 2.1000e+01, 3.9690e+02,

7.8800e+00]]), 'target': array([24. , 21.6, 34.7, 33.4, 36.2, 28.7, 22.9, 27.1, 16.5, 18.9, 15. ,

18.9, 21.7, 20.4, 18.2, 19.9, 23.1, 17.5, 20.2, 18.2, 13.6, 19.6,

15.2, 14.5, 15.6, 13.9, 16.6, 14.8, 18.4, 21. , 12.7, 14.5, 13.2,

13.1, 13.5, 18.9, 20. , 21. , 24.7, 30.8, 34.9, 26.6, 25.3, 24.7,

21.2, 19.3, 20. , 16.6, 14.4, 19.4, 19.7, 20.5, 25. , 23.4, 18.9,

35.4, 24.7, 31.6, 23.3, 19.6, 18.7, 16. , 22.2, 25. , 33. , 23.5,

19.4, 22. , 17.4, 20.9, 24.2, 21.7, 22.8, 23.4, 24.1, 21.4, 20. ,

20.8, 21.2, 20.3, 28. , 23.9, 24.8, 22.9, 23.9, 26.6, 22.5, 22.2,

23.6, 28.7, 22.6, 22. , 22.9, 25. , 20.6, 28.4, 21.4, 38.7, 43.8,

33.2, 27.5, 26.5, 18.6, 19.3, 20.1, 19.5, 19.5, 20.4, 19.8, 19.4,

21.7, 22.8, 18.8, 18.7, 18.5, 18.3, 21.2, 19.2, 20.4, 19.3, 22. ,

20.3, 20.5, 17.3, 18.8, 21.4, 15.7, 16.2, 18. , 14.3, 19.2, 19.6,

23. , 18.4, 15.6, 18.1, 17.4, 17.1, 13.3, 17.8, 14. , 14.4, 13.4,

15.6, 11.8, 13.8, 15.6, 14.6, 17.8, 15.4, 21.5, 19.6, 15.3, 19.4,

17. , 15.6, 13.1, 41.3, 24.3, 23.3, 27. , 50. , 50. , 50. , 22.7,

25. , 50. , 23.8, 23.8, 22.3, 17.4, 19.1, 23.1, 23.6, 22.6, 29.4,

23.2, 24.6, 29.9, 37.2, 39.8, 36.2, 37.9, 32.5, 26.4, 29.6, 50. ,

32. , 29.8, 34.9, 37. , 30.5, 36.4, 31.1, 29.1, 50. , 33.3, 30.3,

34.6, 34.9, 32.9, 24.1, 42.3, 48.5, 50. , 22.6, 24.4, 22.5, 24.4,

20. , 21.7, 19.3, 22.4, 28.1, 23.7, 25. , 23.3, 28.7, 21.5, 23. ,

26.7, 21.7, 27.5, 30.1, 44.8, 50. , 37.6, 31.6, 46.7, 31.5, 24.3,

31.7, 41.7, 48.3, 29. , 24. , 25.1, 31.5, 23.7, 23.3, 22. , 20.1,

22.2, 23.7, 17.6, 18.5, 24.3, 20.5, 24.5, 26.2, 24.4, 24.8, 29.6,

42.8, 21.9, 20.9, 44. , 50. , 36. , 30.1, 33.8, 43.1, 48.8, 31. ,

36.5, 22.8, 30.7, 50. , 43.5, 20.7, 21.1, 25.2, 24.4, 35.2, 32.4,

32. , 33.2, 33.1, 29.1, 35.1, 45.4, 35.4, 46. , 50. , 32.2, 22. ,

20.1, 23.2, 22.3, 24.8, 28.5, 37.3, 27.9, 23.9, 21.7, 28.6, 27.1,

20.3, 22.5, 29. , 24.8, 22. , 26.4, 33.1, 36.1, 28.4, 33.4, 28.2,

22.8, 20.3, 16.1, 22.1, 19.4, 21.6, 23.8, 16.2, 17.8, 19.8, 23.1,

21. , 23.8, 23.1, 20.4, 18.5, 25. , 24.6, 23. , 22.2, 19.3, 22.6,

19.8, 17.1, 19.4, 22.2, 20.7, 21.1, 19.5, 18.5, 20.6, 19. , 18.7,

32.7, 16.5, 23.9, 31.2, 17.5, 17.2, 23.1, 24.5, 26.6, 22.9, 24.1,

18.6, 30.1, 18.2, 20.6, 17.8, 21.7, 22.7, 22.6, 25. , 19.9, 20.8,

16.8, 21.9, 27.5, 21.9, 23.1, 50. , 50. , 50. , 50. , 50. , 13.8,

13.8, 15. , 13.9, 13.3, 13.1, 10.2, 10.4, 10.9, 11.3, 12.3, 8.8,

7.2, 10.5, 7.4, 10.2, 11.5, 15.1, 23.2, 9.7, 13.8, 12.7, 13.1,

12.5, 8.5, 5. , 6.3, 5.6, 7.2, 12.1, 8.3, 8.5, 5. , 11.9,

27.9, 17.2, 27.5, 15. , 17.2, 17.9, 16.3, 7. , 7.2, 7.5, 10.4,

8.8, 8.4, 16.7, 14.2, 20.8, 13.4, 11.7, 8.3, 10.2, 10.9, 11. ,

9.5, 14.5, 14.1, 16.1, 14.3, 11.7, 13.4, 9.6, 8.7, 8.4, 12.8,

10.5, 17.1, 18.4, 15.4, 10.8, 11.8, 14.9, 12.6, 14.1, 13. , 13.4,

15.2, 16.1, 17.8, 14.9, 14.1, 12.7, 13.5, 14.9, 20. , 16.4, 17.7,

19.5, 20.2, 21.4, 19.9, 19. , 19.1, 19.1, 20.1, 19.9, 19.6, 23.2,

29.8, 13.8, 13.3, 16.7, 12. , 14.6, 21.4, 23. , 23.7, 25. , 21.8,

20.6, 21.2, 19.1, 20.6, 15.2, 7. , 8.1, 13.6, 20.1, 21.8, 24.5,

23.1, 19.7, 18.3, 21.2, 17.5, 16.8, 22.4, 20.6, 23.9, 22. , 11.9]), 'feature_names': array(['CRIM', 'ZN', 'INDUS', 'CHAS', 'NOX', 'RM', 'AGE', 'DIS', 'RAD',

'TAX', 'PTRATIO', 'B', 'LSTAT'], dtype='<U7'), 'DESCR': ".. _boston_dataset:\n\nBoston house prices dataset\n---------------------------\n\n**Data Set Characteristics:** \n\n :Number of Instances: 506 \n\n :Number of Attributes: 13 numeric/categorical predictive. Median Value (attribute 14) is usually the target.\n\n :Attribute Information (in order):\n - CRIM per capita crime rate by town\n - ZN proportion of residential land zoned for lots over 25,000 sq.ft.\n - INDUS proportion of non-retail business acres per town\n - CHAS Charles River dummy variable (= 1 if tract bounds river; 0 otherwise)\n - NOX nitric oxides concentration (parts per 10 million)\n - RM average number of rooms per dwelling\n - AGE proportion of owner-occupied units built prior to 1940\n - DIS weighted distances to five Boston employment centres\n - RAD index of accessibility to radial highways\n - TAX full-value property-tax rate per $10,000\n - PTRATIO pupil-teacher ratio by town\n - B 1000(Bk - 0.63)^2 where Bk is the proportion of blacks by town\n - LSTAT % lower status of the population\n - MEDV Median value of owner-occupied homes in $1000's\n\n :Missing Attribute Values: None\n\n :Creator: Harrison, D. and Rubinfeld, D.L.\n\nThis is a copy of UCI ML housing dataset.\nhttps://archive.ics.uci.edu/ml/machine-learning-databases/housing/\n\n\nThis dataset was taken from the StatLib library which is maintained at Carnegie Mellon University.\n\nThe Boston house-price data of Harrison, D. and Rubinfeld, D.L. 'Hedonic\nprices and the demand for clean air', J. Environ. Economics & Management,\nvol.5, 81-102, 1978. Used in Belsley, Kuh & Welsch, 'Regression diagnostics\n...', Wiley, 1980. N.B. Various transformations are used in the table on\npages 244-261 of the latter.\n\nThe Boston house-price data has been used in many machine learning papers that address regression\nproblems. \n \n.. topic:: References\n\n - Belsley, Kuh & Welsch, 'Regression diagnostics: Identifying Influential Data and Sources of Collinearity', Wiley, 1980. 244-261.\n - Quinlan,R. (1993). Combining Instance-Based and Model-Based Learning. In Proceedings on the Tenth International Conference of Machine Learning, 236-243, University of Massachusetts, Amherst. Morgan Kaufmann.\n", 'filename': '/usr/local/lib/python3.6/dist-packages/sklearn/datasets/data/boston_house_prices.csv'}

# DESCR変数の中身を確認

print(boston['DESCR'])

.. _boston_dataset:

Boston house prices dataset

---------------------------

**Data Set Characteristics:**

:Number of Instances: 506

:Number of Attributes: 13 numeric/categorical predictive. Median Value (attribute 14) is usually the target.

:Attribute Information (in order):

- CRIM per capita crime rate by town

- ZN proportion of residential land zoned for lots over 25,000 sq.ft.

- INDUS proportion of non-retail business acres per town

- CHAS Charles River dummy variable (= 1 if tract bounds river; 0 otherwise)

- NOX nitric oxides concentration (parts per 10 million)

- RM average number of rooms per dwelling

- AGE proportion of owner-occupied units built prior to 1940

- DIS weighted distances to five Boston employment centres

- RAD index of accessibility to radial highways

- TAX full-value property-tax rate per $10,000

- PTRATIO pupil-teacher ratio by town

- B 1000(Bk - 0.63)^2 where Bk is the proportion of blacks by town

- LSTAT % lower status of the population

- MEDV Median value of owner-occupied homes in $1000's

:Missing Attribute Values: None

:Creator: Harrison, D. and Rubinfeld, D.L.

This is a copy of UCI ML housing dataset.

https://archive.ics.uci.edu/ml/machine-learning-databases/housing/

This dataset was taken from the StatLib library which is maintained at Carnegie Mellon University.

The Boston house-price data of Harrison, D. and Rubinfeld, D.L. 'Hedonic

prices and the demand for clean air', J. Environ. Economics & Management,

vol.5, 81-102, 1978. Used in Belsley, Kuh & Welsch, 'Regression diagnostics

...', Wiley, 1980. N.B. Various transformations are used in the table on

pages 244-261 of the latter.

The Boston house-price data has been used in many machine learning papers that address regression

problems.

.. topic:: References

- Belsley, Kuh & Welsch, 'Regression diagnostics: Identifying Influential Data and Sources of Collinearity', Wiley, 1980. 244-261.

- Quinlan,R. (1993). Combining Instance-Based and Model-Based Learning. In Proceedings on the Tenth International Conference of Machine Learning, 236-243, University of Massachusetts, Amherst. Morgan Kaufmann.

# feature_names変数の中身を確認

# カラム名

print(boston['feature_names'])

['CRIM' 'ZN' 'INDUS' 'CHAS' 'NOX' 'RM' 'AGE' 'DIS' 'RAD' 'TAX' 'PTRATIO'

'B' 'LSTAT']

# data変数(説明変数)の中身を確認

print(boston['data'])

[[6.3200e-03 1.8000e+01 2.3100e+00 ... 1.5300e+01 3.9690e+02 4.9800e+00]

[2.7310e-02 0.0000e+00 7.0700e+00 ... 1.7800e+01 3.9690e+02 9.1400e+00]

[2.7290e-02 0.0000e+00 7.0700e+00 ... 1.7800e+01 3.9283e+02 4.0300e+00]

...

[6.0760e-02 0.0000e+00 1.1930e+01 ... 2.1000e+01 3.9690e+02 5.6400e+00]

[1.0959e-01 0.0000e+00 1.1930e+01 ... 2.1000e+01 3.9345e+02 6.4800e+00]

[4.7410e-02 0.0000e+00 1.1930e+01 ... 2.1000e+01 3.9690e+02 7.8800e+00]]

# target変数(目的変数)の中身を確認

print(boston['target'])

[24. 21.6 34.7 33.4 36.2 28.7 22.9 27.1 16.5 18.9 15. 18.9 21.7 20.4

18.2 19.9 23.1 17.5 20.2 18.2 13.6 19.6 15.2 14.5 15.6 13.9 16.6 14.8

18.4 21. 12.7 14.5 13.2 13.1 13.5 18.9 20. 21. 24.7 30.8 34.9 26.6

25.3 24.7 21.2 19.3 20. 16.6 14.4 19.4 19.7 20.5 25. 23.4 18.9 35.4

24.7 31.6 23.3 19.6 18.7 16. 22.2 25. 33. 23.5 19.4 22. 17.4 20.9

24.2 21.7 22.8 23.4 24.1 21.4 20. 20.8 21.2 20.3 28. 23.9 24.8 22.9

23.9 26.6 22.5 22.2 23.6 28.7 22.6 22. 22.9 25. 20.6 28.4 21.4 38.7

43.8 33.2 27.5 26.5 18.6 19.3 20.1 19.5 19.5 20.4 19.8 19.4 21.7 22.8

18.8 18.7 18.5 18.3 21.2 19.2 20.4 19.3 22. 20.3 20.5 17.3 18.8 21.4

15.7 16.2 18. 14.3 19.2 19.6 23. 18.4 15.6 18.1 17.4 17.1 13.3 17.8

14. 14.4 13.4 15.6 11.8 13.8 15.6 14.6 17.8 15.4 21.5 19.6 15.3 19.4

17. 15.6 13.1 41.3 24.3 23.3 27. 50. 50. 50. 22.7 25. 50. 23.8

23.8 22.3 17.4 19.1 23.1 23.6 22.6 29.4 23.2 24.6 29.9 37.2 39.8 36.2

37.9 32.5 26.4 29.6 50. 32. 29.8 34.9 37. 30.5 36.4 31.1 29.1 50.

33.3 30.3 34.6 34.9 32.9 24.1 42.3 48.5 50. 22.6 24.4 22.5 24.4 20.

21.7 19.3 22.4 28.1 23.7 25. 23.3 28.7 21.5 23. 26.7 21.7 27.5 30.1

44.8 50. 37.6 31.6 46.7 31.5 24.3 31.7 41.7 48.3 29. 24. 25.1 31.5

23.7 23.3 22. 20.1 22.2 23.7 17.6 18.5 24.3 20.5 24.5 26.2 24.4 24.8

29.6 42.8 21.9 20.9 44. 50. 36. 30.1 33.8 43.1 48.8 31. 36.5 22.8

30.7 50. 43.5 20.7 21.1 25.2 24.4 35.2 32.4 32. 33.2 33.1 29.1 35.1

45.4 35.4 46. 50. 32.2 22. 20.1 23.2 22.3 24.8 28.5 37.3 27.9 23.9

21.7 28.6 27.1 20.3 22.5 29. 24.8 22. 26.4 33.1 36.1 28.4 33.4 28.2

22.8 20.3 16.1 22.1 19.4 21.6 23.8 16.2 17.8 19.8 23.1 21. 23.8 23.1

20.4 18.5 25. 24.6 23. 22.2 19.3 22.6 19.8 17.1 19.4 22.2 20.7 21.1

19.5 18.5 20.6 19. 18.7 32.7 16.5 23.9 31.2 17.5 17.2 23.1 24.5 26.6

22.9 24.1 18.6 30.1 18.2 20.6 17.8 21.7 22.7 22.6 25. 19.9 20.8 16.8

21.9 27.5 21.9 23.1 50. 50. 50. 50. 50. 13.8 13.8 15. 13.9 13.3

13.1 10.2 10.4 10.9 11.3 12.3 8.8 7.2 10.5 7.4 10.2 11.5 15.1 23.2

9.7 13.8 12.7 13.1 12.5 8.5 5. 6.3 5.6 7.2 12.1 8.3 8.5 5.

11.9 27.9 17.2 27.5 15. 17.2 17.9 16.3 7. 7.2 7.5 10.4 8.8 8.4

16.7 14.2 20.8 13.4 11.7 8.3 10.2 10.9 11. 9.5 14.5 14.1 16.1 14.3

11.7 13.4 9.6 8.7 8.4 12.8 10.5 17.1 18.4 15.4 10.8 11.8 14.9 12.6

14.1 13. 13.4 15.2 16.1 17.8 14.9 14.1 12.7 13.5 14.9 20. 16.4 17.7

19.5 20.2 21.4 19.9 19. 19.1 19.1 20.1 19.9 19.6 23.2 29.8 13.8 13.3

16.7 12. 14.6 21.4 23. 23.7 25. 21.8 20.6 21.2 19.1 20.6 15.2 7.

8.1 13.6 20.1 21.8 24.5 23.1 19.7 18.3 21.2 17.5 16.8 22.4 20.6 23.9

22. 11.9]

データフレームの作成

# 説明変数らをDataFrameへ変換

df = DataFrame(data=boston.data, columns = boston.feature_names)

# 目的変数をDataFrameへ追加

df['PRICE'] = np.array(boston.target)

# 最初の5行を表示

df.head(5)

線形単回帰分析

まずは、部屋の数から価格を予測する単回帰分析をやってみましょう。ルームナンバー(RM)のある場所からデータを取ってくる。

# カラムを指定してデータを表示

df[['RM']].head()

(参考:df.headを調べる):pandasのDataFrameのデータ操作

# 説明変数

data = df.loc[:, ['RM']].values

# dataリストの表示(1-5)

data[0:5]

array([[6.575],

[6.421],

[7.185],

[6.998],

[7.147]])

(参考)pandasで任意の位置の値を取得・変更するat, iat, loc, iloc

# 目的変数

target = df.loc[:, 'PRICE'].values

target[0:5]

※スライシングで全部のPRICEをtargetに持ってくる

array([24. , 21.6, 34.7, 33.4, 36.2])

(参考)sklearn の LinearRegression クラス

## sklearnモジュールからLinearRegressionをインポート

from sklearn.linear_model import LinearRegression

# オブジェクト生成

model = LinearRegression()

# model.get_params()

# model = LinearRegression(fit_intercept = True, normalize = False, copy_X = True, n_jobs = 1)

# fit関数でパラメータ推定

model.fit(data, target)

クラスからインスタンスを作ってあげて(sklearnのお作法)、作られた

インスタンスがメソッドを持っている。

※fit関数は学習させるためのメソッドです。

fit(x, y)

線形回帰モデルの当てはめを実行。訓練の開始。

xが対象データで、yが正解データ ※教師あり学習が前提。

渡すと裏で線形回帰を行ってくれる。

LinearRegression(copy_X=True, fit_intercept=True, n_jobs=None, normalize=False)

これでもう予測を見ることが出来る。predict(x)で作成したモデルを利用して予測を実行。

# 予測

model.predict([[1]])

array([-25.5685118])

(参考):sklearn.linear_model.LinearRegression クラスの使い方

重回帰分析(2変数)

df[['CRIM', 'RM']].head()

# 説明変数

data2 = df.loc[:, ['CRIM', 'RM']].values

# 目的変数

target2 = df.loc[:, 'PRICE'].values

# オブジェクト生成

model2 = LinearRegression()

# fit関数でパラメータ推定

model2.fit(data2, target2)

LinearRegression(copy_X=True, fit_intercept=True, n_jobs=None, normalize=False)

model2.predict([[0.3, 4]])

array([4.24007956])

部屋数が4で犯罪率が0.3の物件はいくらになるか?

答えは4.24である。

回帰係数と切片の値を確認

単回帰の回帰係数と切片を出力

fit関数は平均二乗補佐を最小にする点を見つけに行くことをやっている。そのことを理解して関数を使う事が大切。wの予測値(wハット)を理解するためのコマンドが以下である。

print('推定された回帰係数: %.3f, 推定された切片 : %.3f' % (model.coef_, model.intercept_))

推定された回帰係数: 9.236, 推定された切片 : -35.481

犯罪率が上がれば安くなり、部屋数が広くなれば高くなる。

# 重回帰の回帰係数と切片を出力

print(model.coef_)

print(model.intercept_)

[9.23560156]

-35.48090633823544

モデルの検証

- 決定係数

# 決定係数

print('単回帰決定係数: %.3f, 重回帰決定係数 : %.3f' % (model.score(data,target), model2.score(data2,target2)))

単回帰決定係数: 0.483, 重回帰決定係数 : 0.542

# train_test_splitをインポート

from sklearn.model_selection import train_test_split

# 70%を学習用、30%を検証用データにするよう分割

X_train, X_test, y_train, y_test = train_test_split(data, target,

test_size = 0.3, random_state = 666)

# 学習用データでパラメータ推定

model.fit(X_train, y_train)

# 作成したモデルから予測(学習用、検証用モデル使用)

y_train_pred = model.predict(X_train)

y_test_pred = model.predict(X_test)

# matplotlibをインポート

import matplotlib.pyplot as plt

# Jupyterを利用していたら、以下のおまじないを書くとnotebook上に図が表示

%matplotlib inline

# 学習用、検証用それぞれで残差をプロット

plt.scatter(y_train_pred, y_train_pred - y_train, c = 'blue', marker = 'o', label = 'Train Data')

plt.scatter(y_test_pred, y_test_pred - y_test, c = 'lightgreen', marker = 's', label = 'Test Data')

plt.xlabel('Predicted Values')

plt.ylabel('Residuals')

# 凡例を左上に表示

plt.legend(loc = 'upper left')

# y = 0に直線を引く

plt.hlines(y = 0, xmin = -10, xmax = 50, lw = 2, color = 'red')

plt.xlim([10, 50])

plt.show()

考察

- sklearnを用いるとプログラムがとてもにシンプルになる。学習には他のモデルも試したほうが良い。

- 今回のケースでは単回帰決定係数: 0.483, 重回帰決定係数 : 0.542と重回帰の方が精度が良い。

関連リンク

目次

第一章:線形回帰モデル

[第二章:非線形回帰モデル]

(https://qiita.com/matsukura04583/items/baa3f2269537036abc57)

[第三章:ロジスティク回帰モデル]

(https://qiita.com/matsukura04583/items/0fb73183e4a7a6f06aa5)

[第四章:主成分分析]

(https://qiita.com/matsukura04583/items/b3b5d2d22189afc9c81c)

[第五章:アルゴリズム1(k近傍法(kNN))]

(https://qiita.com/matsukura04583/items/543719b44159322221ed)

[第六章:アルゴリズム2(k-means)]

(https://qiita.com/matsukura04583/items/050c98c7bb1c9e91be71)

[第七章:サポートベクターマシン]

(https://qiita.com/matsukura04583/items/6b718642bcbf97ae2ca8)