この記事はアイスタイル Advent Calendar 2024 2日目の記事です

はじめに

株式会社アイスタイル データ分析システム部の今井です。

普段はデータエンジニアをしています。

今年のノーベル物理学賞で、AIの中核「機械学習」の基礎に関わった、プリンストン大学のジョン・ホップフィールド教授とトロント大学のジェフリー・ヒントン教授が選出されました。ノーベル物理学賞でAIの研究者が選出されるのは初めての出来事でとても話題になりました。

https://www3.nhk.or.jp/news/special/nobelprize/2024/physics/article_01.html

この記事では、AIがどのような歴史を経て現代に繋がっているのかを書きたいと思います。

目次

- 概要

- 第1次AIブーム(1940年代~1960年代) 推論・探索の時代

- 第2次AIブーム(1980~1990年代) 知識の時代

- 第3次AIブーム(2010年代~2021年) 機械学習・深層学習の時代

- 第4次AIブーム(2022年~) 生成AIの時代

- 終わりに

- 会社紹介・求人紹介

- 参考文献・参考サイト

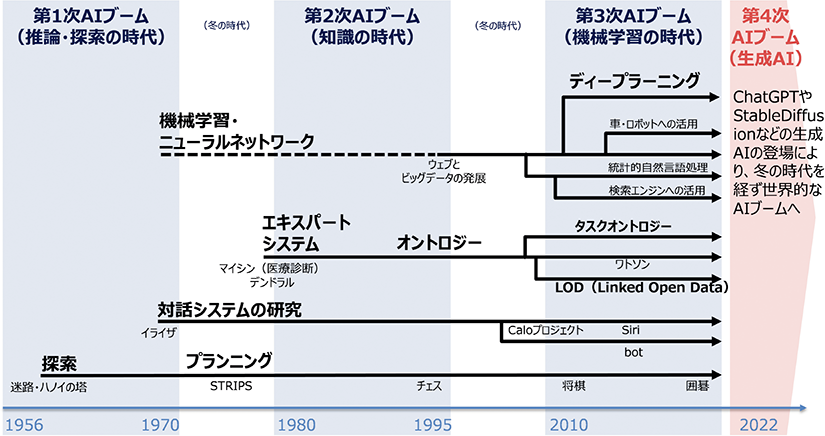

概要

AIは大きく分けて4回ブームが来ています

- 第1次AIブーム(推論・探索の時代)

- 第2次AIブーム(知識の時代)

- 第3次AIブーム(機械学習・深層学習の時代)

- 第4次AIブーム(生成AIの時代)

画像元:https://www.soumu.go.jp/johotsusintokei/whitepaper/ja/r06/html/nd131100.html

第4次AIブーム(生成AI)はChatGPTをはじめとした生成AIが注目を浴びているブームで、一般的にも知られているかと思います。

第1次AIブーム(1940年代~1960年代) 推論・探索の時代

第1次AIブームは、1940年代から1960年代にかけて人工知能の基礎が築かれた時期です。この時期には、ENIACの発表やダートマス会議の開催など、計算機技術の飛躍的な進歩とともに「人工知能」という概念が公式に提唱されました。また、イライザのような初期の人工無能が開発され、AIへの期待が高まりました。

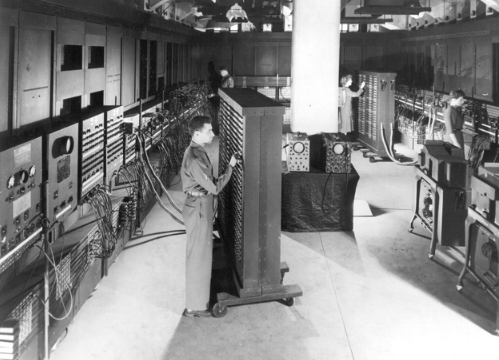

ENIACの発表(1946年)

1946年、ENIACというコンピュータが発表されました。これは世界初の汎用電子式コンピュータとされていて、従来の機械式計算機とは一線を画していました。

ENIACはAIではありませんが、「計算能力の飛躍的向上」「機械も知能を持ちうるという視点の拡大」という意味で、今後のAIの発展の土壌を提供したと言えます。

画像元:Lightning Strikes Mathematics

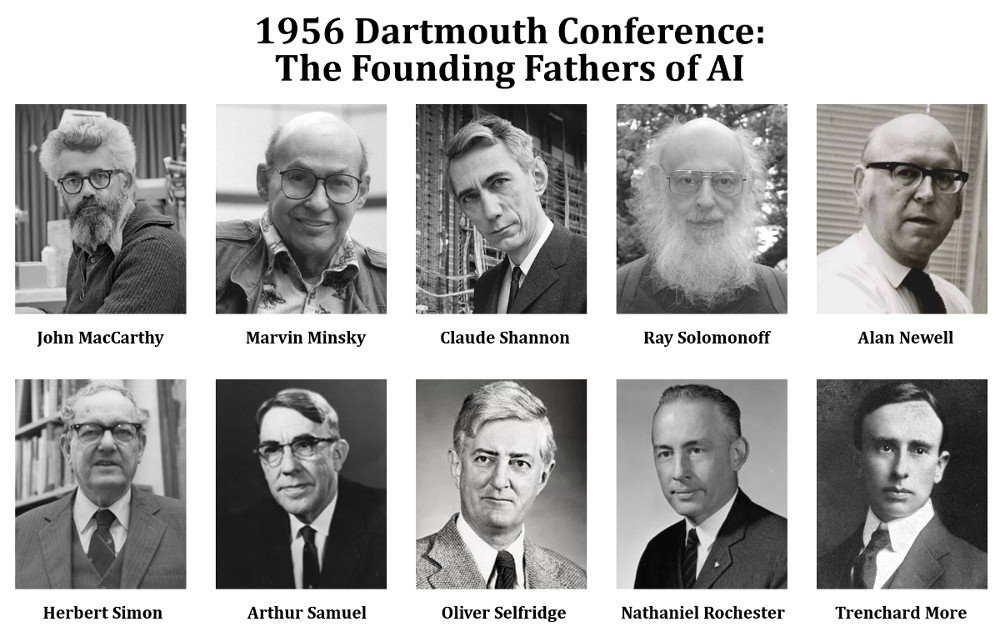

ダートマス会議の開催(1956年)

1956年、ジョン・マッカーシー、マービン・ミンスキー、クロード・シャノン、ハーバート・サイモンらが中心となり、ダートマス会議 が開催されました。この会議では、「人工知能」という言葉が初めて公式に使用されました。

画像元:https://indiaai.gov.in/article/exploring-the-significance-of-the-dartmouth-workshop

重要性:

ダートマス会議はAI研究の方向性に大きな影響を与えた歴史的な出来事でした。会議を契機に多くの研究者がAI分野に参入し、AI研究が活発化しました。

人工無能の開発

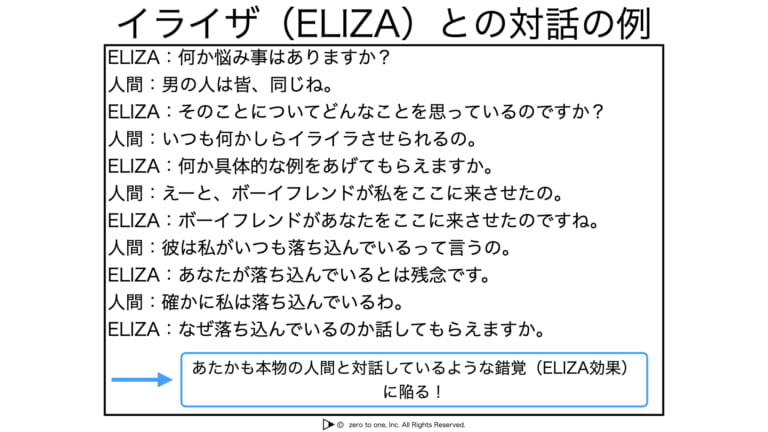

人工無能とは、簡単にいうとチャットボットのことで、特定のルールや手順に沿って機械的に会話を処理するプログラムになります。

1960年代に人工無能の元祖としてイライザ(ELIZA) が開発されました。

イライザは実際には会話の内容を理解していませんが、あたかも本物の人間と会話している錯覚に陥ってしまうことがありました(この現象をイライザ効果といいます)。

画像元:https://zero2one.jp/ai-word/eliza/

第1次AIブームの課題と限界

第1次AIブームでは、「推論」と「探索」を中心とした「シンボリックAI」の研究が進められましたが、計算資源の不足や現実世界の複雑さに対応できないという限界に直面しました。たとえば、トイ・プロブレム(おもちゃの問題)といわれる簡単な問題はとけても、現実に即した難しい問題は解けないということが分かり、第一次AIブームは終焉を迎えました。そして、AIは一度目の冬の時代に入ることになります。

ただし、この課題は、後の研究での知識ベースシステムや機械学習技術の必要性を認識させる契機となり、AI研究の進化を促しました。

第2次AIブーム(1980~1990年代) 知識の時代

第2次AIブームは、1980年代から1990年代にかけて人工知能技術が商業的に大きく発展した時期です。この時期には、エキスパートシステムが特定分野で実用化され、MYCINやDENDRALなどのシステムが医療や化学分野で成功を収めました。

また、ニューラルネットワークがバックプロパゲーションアルゴリズムの導入により注目を浴びました。

エキスパートシステムの台頭

エキスパートシステムは、特定分野における専門知識をルールベースで表現し、人間の専門家の代わりを担うシステムです。代表例として、医療分野の「MYCIN」や化学分野の「DENDRAL」が挙げられます。

具体的な応用例:

- 医療:感染症診断(MYCIN)

- 化学:分子構造の解析(DENDRAL)

エキスパートシステムは、商業的成功を収めた最初のAI技術であり、多くの企業がAI研究に投資するきっかけとなりました。

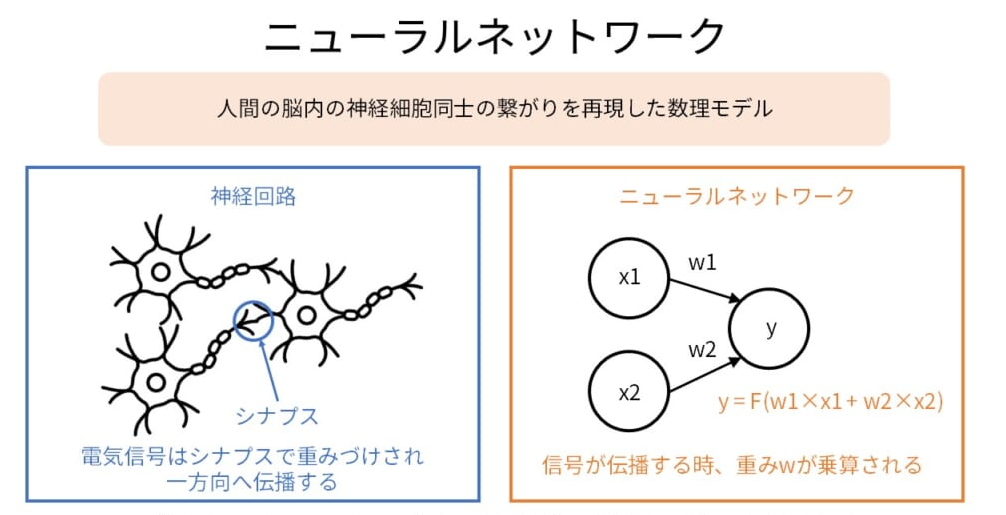

ニューラルネットワークの注目と課題

ニューラルネットワークは、脳の神経回路を模倣したモデルであり、情報処理の新たな可能性を示しました。1980年代後半から1990年代にかけて、バックプロパゲーションアルゴリズムの導入により、多層ニューラルネットワークの学習が可能となりました。

画像元:https://zero2one.jp/ai-word/neural-network/

具体的技術:

- バックプロパゲーションによる学習

- 多層パーセプトロン(MLP)

しかし、この時代のニューラルネットワークは以下の問題点を抱えていました。

- 計算資源の不足: 当時のハードウェアでは大規模なネットワークの訓練が困難だった

- データの不足: 十分な量のラベル付きデータが不足しており、モデルの精度向上が限定的であった

- 過学習: モデルが訓練データに過度に適合し、汎用性が低かった

このため、ニューラルネットワークは一時的に注目を失い、多くの研究者がニューラルネットワークの研究を中止しました。

第2次AIブームの限界

エキスパートシステムの限界

当初はエキスパートシステムが様々な分野で成功を収めたものの、以下の理由から限界が明らかになり、期待が失望に変わりました。

- 専門家の知識の形式化が難しい

- 専門家が持つ知識は暗黙的である場合が多く、コンピュータが理解できなかった

- 知識の更新が複雑

- 一般常識といった明文化されていない知識の取り扱いができない

ニューラルネットワークの限界

ニューラルネットワークは再び注目を浴びるものの、上述の問題により十分な成果を上げることができませんでした。

- 計算資源の不足

- データの不足

- 過学習

これらの限界により、第2次AIブームの終盤にはシンボリックAIやエキスパートシステムの限界が再び明らかとなり、ニューラルネットワークの再評価も遅れました。結果として、投資家や研究者の間でAIに対する期待が冷え込み、二度目のAIの冬の時代に突入しました。

第3次AIブーム(2010年代~2021年) 機械学習・深層学習の時代

第3次AIブームは、第2次AIブームにおける限界を克服することで実現しました。

-

計算資源の飛躍的な向上

- GPUの進化により大規模なニューラルネットワークの訓練が可能になった

-

ビッグデータの活用

- インターネットやIoT技術の発展により、膨大なデータが容易に収集・利用できるようになった

-

高度なアルゴリズムの開発

- 新しいアルゴリズムの登場により、従来のニューラルネットワークの過学習問題などの課題が改善された

第3次AIブームは、画像認識、自然言語処理(NLP)、強化学習(Reinforcement Learning, RL) の3分野を中心に急速に発展しました。

これらの分野での革新がAI技術の実用化と普及を促進し、様々な産業に応用されるようになりました。

画像認識の進展

2010年代にかけて、画像認識技術は従来の課題を解消し、飛躍的な進歩を遂げました。

勾配消失問題・過学習の解消

深層ニューラルネットワークの訓練において、勾配消失問題と過学習は大きな課題でした。これらの問題は、ネットワークの性能向上を阻害する要因となっていましたが、ReLU(Rectified Linear Unit)とDropOutの導入により効果的に解決されました。

| 課題 | 詳細 | 解決策 |

|---|---|---|

| 勾配消失問題 | ・学習の停滞 ・モデルの限界 |

ReLU(Rectified Linear Unit) ・活性化関数として非線形性を保持しつつ、勾配消失を緩和 ・計算がシンプルで高速 |

| 過学習(オーバーフィッティング) | ・汎化性能の低下 |

DropOut ・訓練時にランダムにニューロンを無効化 ・過学習を防止し、モデルの汎化性能を向上させる |

ReLUとDropOutを組み合わせることで、勾配消失問題の緩和と過学習の防止が同時に達成され、深層ネットワークの効果的な訓練が可能となりました。この組み合わせにより、より深いネットワークの訓練が現実的となり、モデルの表現力が大幅に向上しました。

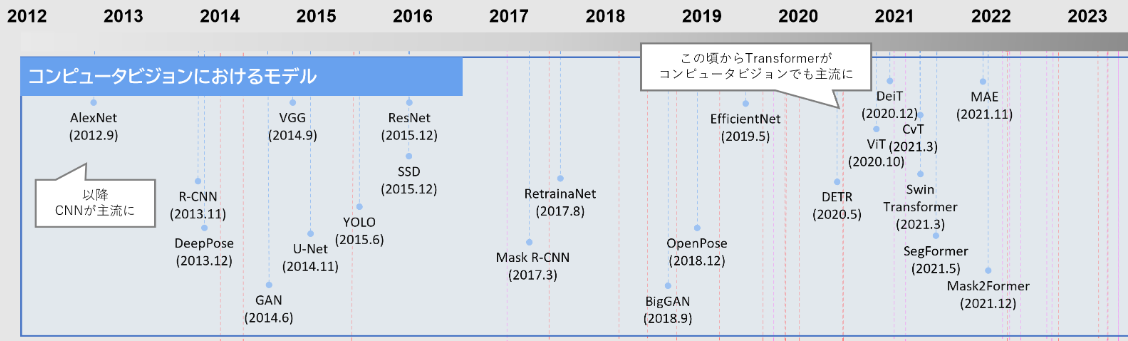

モデルの進化

初期の手法では、特徴量の手動設計や伝統的な機械学習アルゴリズムが主流でしたが、ディープラーニングの導入により、その精度と効率は劇的に向上しました。特に畳み込みニューラルネットワーク(CNN) の発展が画像認識の性能向上に大きく寄与しました。2012年に発表されたAlexNet はその代表的な例です。

これにより、顔認識、物体検出、画像分類などのタスクで人間と同等、あるいはそれ以上の精度を達成するモデルが次々と登場しました。

画像元:https://dx.mri.co.jp/ai-blog/06/

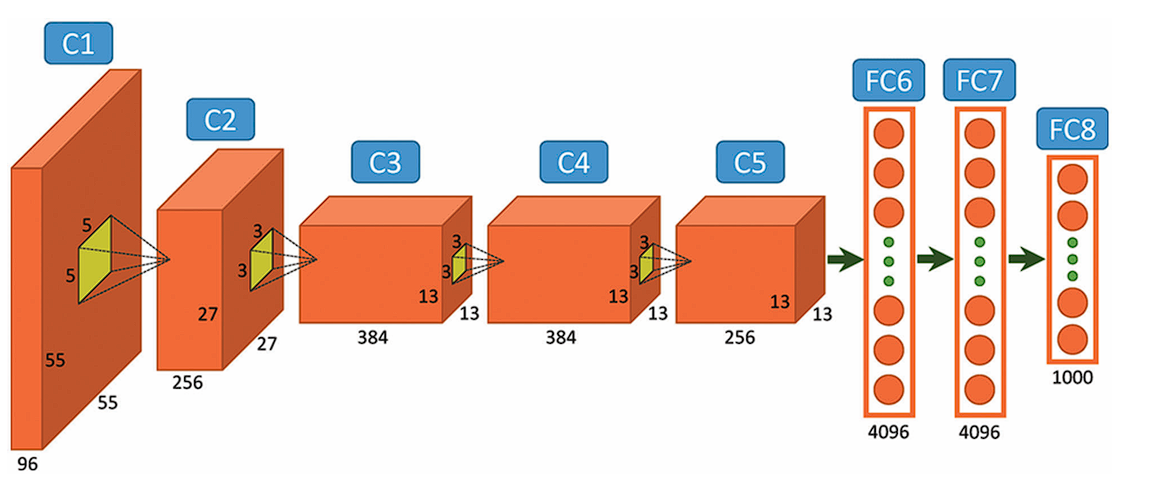

AlexNetの登場(2012年)

2012年、トロント大学のジェフリー・ヒントンとそのチームによって開発された「AlexNet」は、ディープラーニングの歴史における重要な転機となりました。AlexNetは、世界規模の画像認識技術コンテスト (ILSVRC) 2012で従来の手法を圧倒的に上回る性能を示し優勝しました。この事はディープラーニングの存在を世に知らしめることになりました。

特徴:

- 畳み込みニューラルネットワーク(CNN)を深く構築。

- ドロップアウト(Dropout)を利用し、過学習を防止。

- GPUを使用して高速学習を実現。

画像元:viso.ai/deep-learning/alexnet/

AlexNetの優勝は、ディープラーニングの研究開発を引き起こし、AIの応用範囲を拡大させる契機になりました。

コラム: AIの歴史の中でAlexNetが果たした役割

AlexNetの登場は、AIの歴史における明確な転換点となりました。それまでのAI研究は、特徴量の手動設計や浅い学習モデルに依存していましたが、AlexNetは深層学習と大規模データセットの組み合わせがもたらす圧倒的な性能向上を示しました。この成功により、ディープラーニングはAI研究の主流となり、現代のAIブームの礎を築きました。

さらに、AlexNetの影響は研究分野を超えて産業界にも波及し、企業はAI技術の商業利用に本格的に取り組むようになりました。これにより、AIは単なる研究テーマから実用的な技術へと進化し、私たちの生活や社会に深く根付く存在となりました。

総じて、AlexNetはディープラーニングの有効性を世界に示し、AI技術の発展と普及を加速させた極めて重要な役割を果たしました。このプロジェクトは、AIの歴史における重要なマイルストーンとして、現在の多様なAI技術の基盤を築く決定的な出来事となりました。

Googleの猫

2012年にGoogleがディープラーニング技術を用いて、人間が事前に教えることなくAIが自発的に猫を認識することに成功しました。これは Googleの猫 と呼ばれています。

当時、深層学習はまだ発展途上の分野でしたが、Googleの猫は深層学習と大規模データの組み合わせが画像認識において高い成果を生むことを証明し、画像認識技術の発展において重要なマイルストーンとなりました。

モデルの多様化・精度の向上

モデルの多様化

AlexNetの登場後、様々なCNNモデルが開発されました。これらのモデルは、医療画像診断、自動運転車など、さまざまな応用分野で活用されました。

主要なモデル:

- GoogLeNet(Inception Network): Googleが開発したアーキテクチャ。Inceptionモジュールを使用し、異なるスケールの畳み込みを組み合わせることで、計算効率を保ちながら精度を向上させた。ILSVRC 2014で優勝を果たした

- ResNet(Residual Networks): Microsoft Researchが開発したアーキテクチャ。残差ブロックの導入により、100層以上の深いネットワークでも安定した訓練が可能となり、高精度な画像認識を実現。ILSVRC 2015で優勝

- SENet(Squeeze-and-Excitation Networks): 各特徴マップに重み付けを行う「Squeeze-and-Excitation」ブロックを導入し、精度を向上。ILSVRC 2017で優勝した

- GAN(Generative Adversarial Networks): 生成モデルとして、リアルな画像を生成する能力を持つ。AIが生成した画像を、判別用のAIが「AIが作成したかどうか」を判別している(=Adversarial(敵対的)の由来)

- YOLO(You Only Look Once): リアルタイム物体検出に特化したモデルで、高速かつ高精度な検出が可能。名前の通り、一度見るだけ(You Only Look Once)で物体検出ができる

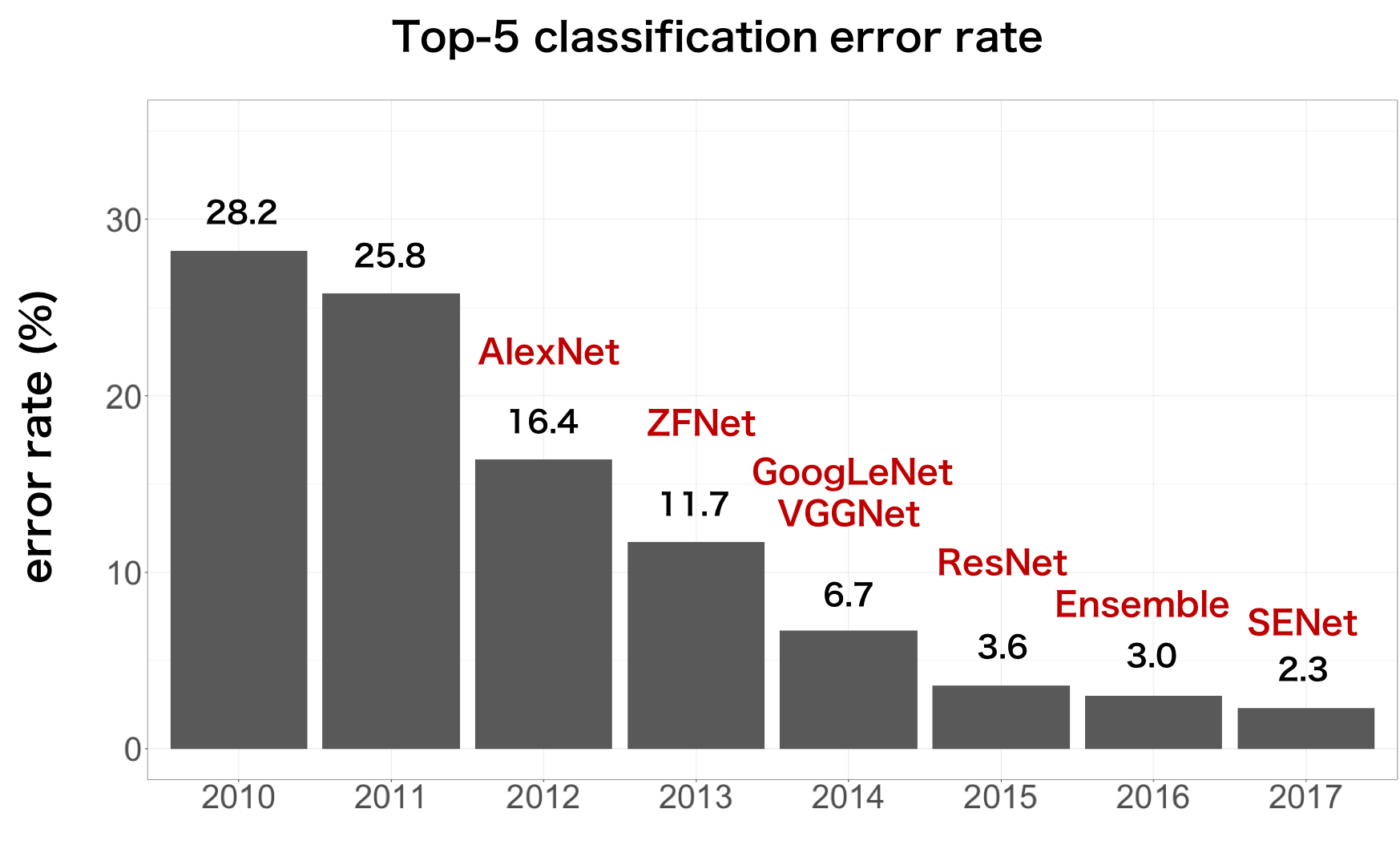

画像認識の精度が人間を上回る

モデルの多様化・進化により、画像認識の精度は劇的に向上しました。

2012年のAlexNetによるILSVRC(ImageNet Large Scale Visual Recognition Challenge)の優勝以来、モデルの改良が進み、2015年にはResNetが登場し、エラー率が人間のレベルを下回りました。

これにより、AIが画像認識タスクにおいて人間を超える能力を持つことが証明され、ILSVRCは2017年をもって目的を達成し、競技を終了しました。

画像元:https://axa.biopapyrus.jp/deep-learning/cnn/image-classification.html

自然言語処理の進展

自然言語処理(NLP) は、テキストや音声データの理解・生成において飛躍的な進展を遂げてきました。特に、Word2VecやTransformerなどの革新的な技術がこの分野を牽引し、言語モデルの性能向上に大きく寄与しています。これらの技術の発展により、NLPは多様な応用領域で実用化され、現代のAI技術の中核を担う存在となっています。

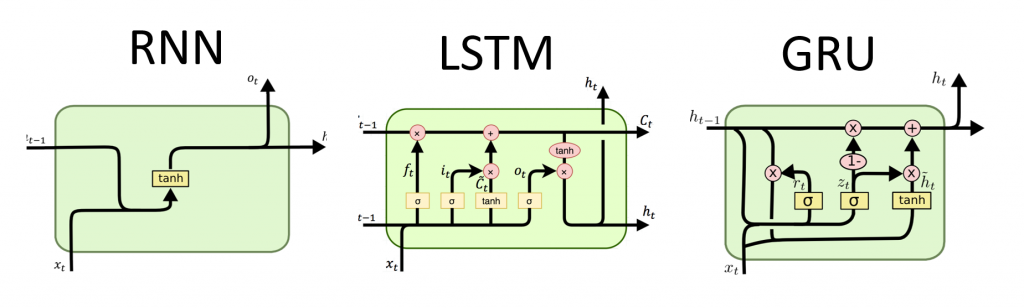

時系列データ処理の基盤: RNNとLSTM,GRU

時系列データ処理の基盤の代表的なものに、RNN, LSTM, GRUがあります。

RNN(Recurrent Neural Network, 再帰的ニューラルネットワーク)

RNN(再帰的ニューラルネットワーク) は、時系列データやシーケンシャルな情報を処理するために設計されたニューラルネットワークの一種です。

RNNは、前の時刻の出力を現在の入力にフィードバックすることで、データの時間的な依存関係を捉えることが可能です。これにより、文章の文脈や音声の連続性を理解する能力を持ち、機械翻訳や音声認識などのタスクで活用されました。しかし、RNNは長期依存関係を捉える際に勾配消失や勾配爆発の問題に直面し、長い文章の学習が困難でした。

LSTM(Long Short Term Memory, 長短期記憶)

LSTM(長短期記憶) は、RNNのこれらの課題を克服するために開発されました。LSTMは、セル状態と呼ばれる内部メモリを持ち、情報の選択的な保持と忘却を可能にするゲート機構(入力ゲート、出力ゲート、忘却ゲート)を導入しています。

これにより、LSTMは長期的な依存関係を効果的に学習できるようになり、翻訳やテキスト生成、音声認識などのNLPタスクで高い性能を発揮しました。LSTMの登場は、シーケンシャルデータ処理における新たな可能性を切り拓き、後続のモデル開発に大きな影響を与えました。

GRU(Gated Recurrent Unit)

GRU は、2014年に提案されたLSTMの改良版で、よりシンプルな設計を特徴としています。

GRUはLSTMよりも計算コストが低く、軽量でありながら、性能的にはLSTMと同等程度のレベルでした。

画像元:http://dprogrammer.org/rnn-lstm-gru

RNNとLSTMは2010年よりも前に開発された技術ですが、2010年代の自然言語処理の進化を支えた基礎技術になるため、ここで記述しました。

単語の意味理解: Word2Vec

2013年、Googleによって開発されたWord2Vecは、単語を数値ベクトルに変換し、意味的な関係性を数学的に捉える技術です。CBOWやSkip-gramといった効率的なアルゴリズムを用いて大規模なテキストデータから単語ベクトルを学習し、類義語や関連語を高精度で識別が出来るようになりました。

Word2Vecの特徴

- 分散表現の学習: 単語を高次元ベクトルにマッピングし、意味的に類似する単語を近くに配置。

Attentionメカニズム

2017年に登場したAttentionメカニズムによって、NLP分野はさらに発展しました。入力データの重要部分に焦点を当てることで、長い文脈や複雑な依存関係を効果的に処理します。さらに、従来のリカレントニューラルネットワーク(RNN)に比べて並列処理が可能なため、学習速度が大幅に向上しました。

Attentionの特徴

- 柔軟な情報選択: 必要な情報に動的に焦点を当てる。

- 並列処理の向上: 学習速度が大幅に向上。

Attentionメカニズムは、次に記述するTransformerモデルの核心部分として機能しています。Transformerは、RNNを用いずにAttentionに基づいて構築されたモデルになります。

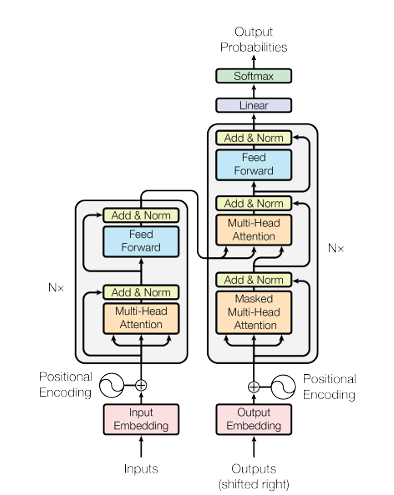

Transformerの登場(2017年)

2017年、Googleから発表された論文「Attention Is All You Need」で、Transformerアーキテクチャが提案されました。Transformerは、従来のRNNやLSTMといったシーケンシャルな処理に依存せず、自己注意機構(Self-Attention Mechanism) を中心に設計されています。この自己注意機構により、入力データ全体の関係性を一度に捉えることが可能となりました。

Transformerは以下のような特長を持ちます。

-

高速な学習

Transformerは、入力全体を一度に処理するため、並列計算が可能です。これにより、従来のRNNベースのモデルと比べて学習速度が大幅に向上しました -

長距離依存の理解

Self-Attention機構により、文中の任意の位置にある単語同士の関係を直接捉えることができるようになりました。これにより、長い文章や複雑な文脈においても、一貫した意味理解が可能となりました -

柔軟な拡張性

Transformerは、エンコーダーとデコーダーを複数の層に重ねることでモデルの深さを簡単に調整できます。この設計により、さまざまな自然言語処理(NLP)タスクに対して柔軟に適応できるようになりました -

Multi-Head Attention

複数の注意機構を並行して使用することで、異なる部分に同時に注意を向けることができます。これにより、異なる意味的な特徴を捉えることができ、モデルの表現力が大幅に向上しました

Transformerの登場は、NLP分野におけるパラダイムシフトを引き起こしました。これまでのRNNベースのモデルに比べ、Transformerは効率的かつ高性能なアーキテクチャとして広く採用され、後続のモデル開発(例: GPTシリーズ、BERT)の基盤となりました。さらに、画像処理や音声認識など他のAI分野にも応用が広がり、現代のAI技術全般においても重要な役割を果たしています。

コラム: TransformerがもたらしたAI技術の革新

Transformerアーキテクチャの登場は、AIの歴史の中でもトップクラスに重要な出来事と言っても過言ではありません。Transformerは自然言語処理(NLP)だけでなく、AI全般に大きな変革をもたらしました。自己注意機構により、データ間の複雑な関係を効率的に学習できるため、以下の分野で特に影響を与えています。

- 大規模言語モデル: GPTシリーズやBERTなど、Transformerを基にしたモデルは、自然な文章の生成や深い理解を実現しています。

- マルチモーダルAI: 画像、音声、テキストなど異なる種類のデータを統合して処理するAIの開発に欠かせない技術です。

- 効率的な学習と推論: 並列処理が可能なため、大量のデータを高速に処理でき、リアルタイムアプリケーションにも適用されています。

これらの要素により、Transformerは現代AI技術の基盤となっています。

Transformerを基盤とする主要モデル

Transformerの成功を受け、さまざまな派生モデルが開発されました。これらのモデルは、Transformerの基本構造を基にしつつ、特定のタスクや効率性向上を目的として改良が加えられています。

代表的な派生モデル:

- GPTシリーズ(GPT, GPT-2, GPT-3): 大規模なパラメータによる流暢な文章生成が特徴で、チャットボットやコンテンツ生成に特化しています

- BERT(Bidirectional Encoder Representations from Transformers): 双方向の文脈理解を可能にし、文書分類や質問応答など幅広いNLPタスクで優れた性能を発揮しました

- T5(Text-To-Text Transfer Transformer): NLPタスクをテキスト変換問題として統一的に扱い、翻訳や要約など多様なタスクに柔軟に対応しました

- ALBERT(A Lite BERT): 軽量化されたBERTで、リソース効率を改善しながらも高い性能を維持していました

- ViT(Vision Transformer): Transformerアーキテクチャを画像処理に応用し、画像認識や分類タスクで高い性能を発揮しました

TransformerのアーキテクチャはNLPに留まらず、画像処理や音声認識など他のAI分野にも大きな影響を与えています。これにより、マルチモーダルなAIモデルの開発が進み、異なるデータ形式を統合的に処理する高度なシステムが実現されています。

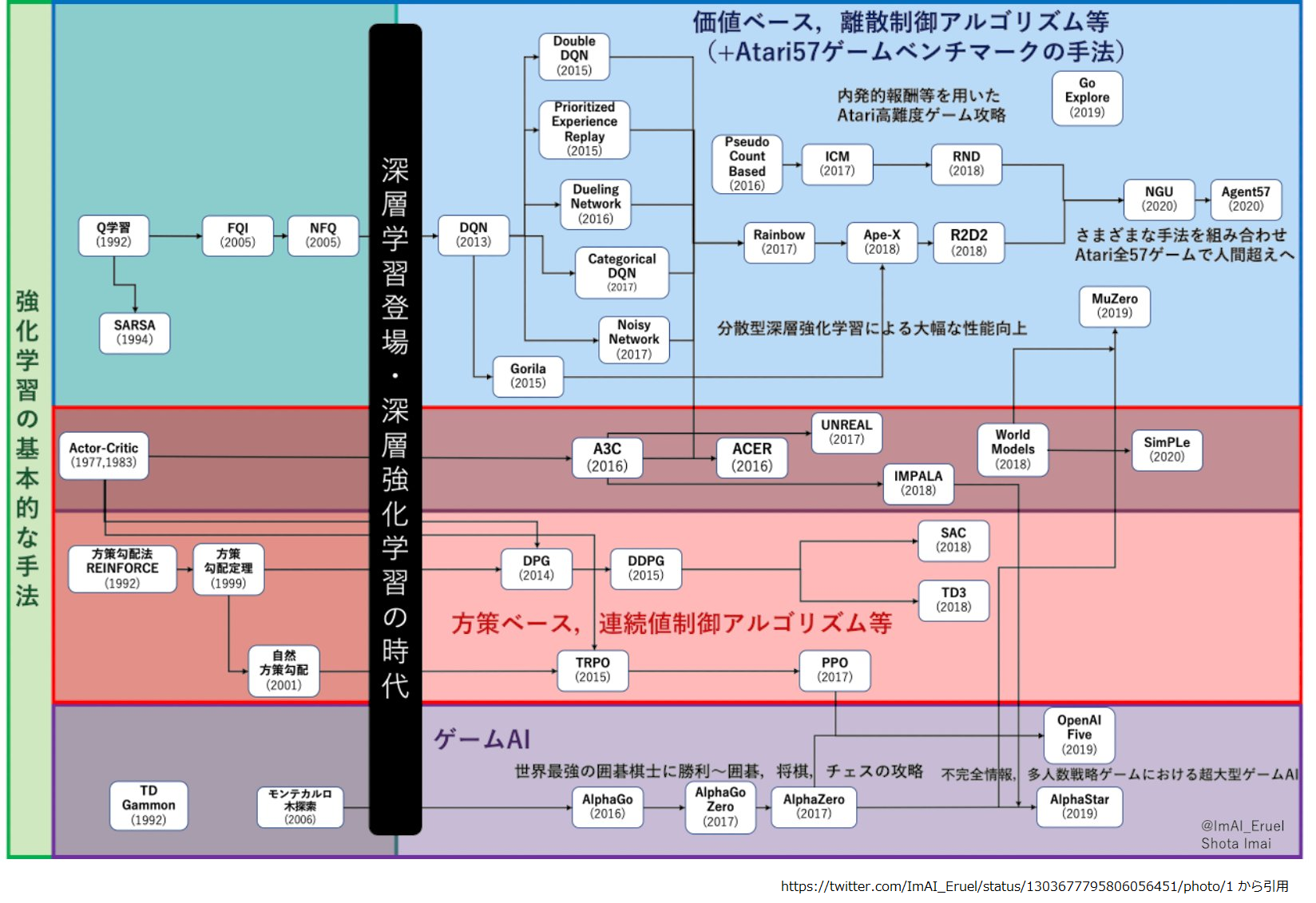

強化学習の進展

強化学習(Reinforcement Learning, RL) は、エージェントが環境と相互作用しながら最適な行動を学習する手法であり、第3次AIブームにおいても重要な役割を果たしました。特に、ゲームAIの分野で顕著な成果を上げ、RLの可能性を広く認知させることに成功しました。

強化学習のアルゴリズム

画像元:https://x.com/ImAI_Eruel/status/1618549694363471873

DQN

2015年、DeepMindが開発したDeep Q-Network(DQN) は、ディープラーニングを用いた強化学習の手法として注目を集めました。DQNは、Q学習に畳み込みニューラルネットワーク(CNN)を組み合わせ、複雑な環境での意思決定を可能にしました。特に、Atariゲームにおいて人間を上回るパフォーマンスを発揮し、強化学習の新たな可能性を示しました。DQNの成功により、強化学習はゲーム以外の分野にも応用されるようになりました。

特徴:

- ディープラーニングとの統合: CNNを用いて高次元の入力データ(画像)から特徴を抽出し、効率的に学習を行います。

- 経験再生(Experience Replay): 過去の経験をランダムにサンプリングすることで、データの相関を減少させ、学習の安定性を向上させます。

- ターゲットネットワークの導入: 固定されたターゲットネットワークを使用することで、学習の収束を促進します。

AlphaGoの登場(2015, 2016年)

2015年、Google DeepMindが開発したAlphaGoは、囲碁をプレイするために設計されたAIです。AlphaGoは、強化学習とモンテカルロ木探索(Monte Carlo Tree Search)を組み合わせ、自己対戦による自己学習を行いました。2016年にはプロ棋士イ・セドルに4勝1敗で勝利し、囲碁におけるAIの能力の高さを証明しました。この成果は、強化学習の実用性とその可能性を広く認知させるきっかけとなりました。

特徴:

- 深層ニューラルネットワークの活用: ポリシーネットワークとバリューネットワークを用いて、手の選択と局面の評価を行います

- 自己対戦による学習: 大量の自己対戦データを生成し、継続的に学習を行うことで、プレイスタイルを向上させます

- モンテカルロ木探索(MCTS): 効率的な探索アルゴリズムを用いて、最適な手を選択します

コラム: AlphaGoが世間に与えた影響とAIの歴史における役割

AlphaGoの勝利は、AI技術の可能性を世間に強く印象付ける出来事となりました。 これにより、AIが人間の高度な認知能力を必要とする分野でも優れた成果を上げられることが証明され、AI技術への関心と投資が一層高まりました。

AlphaGoの成功は、単なる技術的な成果にとどまらず、AI技術全体の進化と社会への統合に大きな影響を与えた重要なマイルストーンとなっています。

汎用性の向上: AlphaZero

2017年、Google DeepMindはAlphaZeroを発表しました。AlphaZeroは、囲碁、チェス、将棋など多岐にわたるゲームに適用可能な汎用的な強化学習アルゴリズムを採用しました。人間の知識を一切利用せずに自己学習を行い、短期間で各ゲームのトップレベルプレイヤーを凌駕しました。AlphaZeroの登場により、強化学習の汎用性と効率性がさらに証明されました。

特徴:

- 汎用的なアーキテクチャ: 一つのモデルで異なるゲームを学習・プレイ可能。

- 自己対戦による迅速な学習: 外部データや人間のプレイデータに依存せず、自己対戦を通じて急速に実力を向上。

- 高効率な学習プロセス: 少ない計算資源で高いパフォーマンスを達成。

AlphaZeroは、強化学習の汎用性を実証し、特定のタスクに限定されない広範な応用可能性を示しました。この成果は、様々な分野でのRLの応用を促進し、さらなる研究開発の基盤となっています。

応用例:

- ゲームAI(囲碁、チェス、将棋など)

- ロボティクス(自律移動、操作)

- 最適化問題の解決(物流、資源管理)

第4次AIブーム(2022年~)生成AIの時代

生成AI(Generative AI) は、データを基に新たなコンテンツを生成するAI技術であり、第4次AIブームにおいて急速に発展しました。生成AIは、テキスト、画像、音声など多様な形式のコンテンツを創出し、クリエイティブな分野からビジネス、エンターテインメントまで幅広い応用が可能となりました。

ChatGPTの登場

ChatGPTは、OpenAIによって開発された大規模な言語モデルであり、自然な対話を実現する生成AIの代表的な存在です。GPT(Generative Pre-trained Transformer)シリーズの3.5モデルであるChatGPTは、以下の特徴を持ちます。

- 大規模な事前学習: インターネット上の膨大なテキストデータで事前学習されており、多様なトピックに対応可能。

- 高度な対話能力: ユーザーとの自然な対話を実現し、質問応答、文章生成、アイデアの提案など多岐にわたるタスクをこなします。

コラム: ChatGPTが世の中に与えた影響:

ChatGPTは、その登場によって世の中に大きな衝撃を与え、社会に広範な影響をもたらしました。特に、自然言語での高度な対話能力を実現したことで、AI技術がここまで進化したという認識を人々に植え付けました。この技術は、多くの人々にAGI(汎用人工知能)の可能性を予感させ、新しいAI時代の幕開けを象徴する存在となっています。

一方で、世論においては、この新しいAIの可能性とリスクについての議論が活発化しました。ChatGPTが示したAGI的な挙動が、「AIがどこまで進化し、どこまで許容されるべきか」という倫理的・哲学的な問いを社会全体に投げかけました。人間の存在意義にまで影響を及ぼす可能性が示唆され、AI技術の受容に向けた新しい社会的ルールやガイドラインの必要性が求められています。

ChatGPTは単なる技術革新ではなく、AIが社会や人々の生活をどのように変え得るのかを具体的に示し、私たちに「新しいAI時代」の到来を実感させました。

画像系: Midjourney、Stable Diffusion、DALL-E

画像生成AIは、テキストや他の入力データを基に高品質な画像を生成する技術であり、クリエイティブな分野で大きな革新をもたらしました。特に以下のツールが注目されています。

-

Midjourney: ユーザーが入力したテキストプロンプトに基づいて芸術的な画像を生成するAIツール。独自のスタイルと高いクリエイティビティが特徴で、アーティストやデザイナーに広く利用されています。

-

Stable Diffusion: オープンソースの画像生成モデルであり、コミュニティによるカスタマイズと拡張が可能。高品質な画像を生成し、多様な応用が期待されています。

-

DALL-E: OpenAIが開発した画像生成モデルで、テキストプロンプトから多様な画像を生成します。創造性豊かな画像生成能力が評価され、幅広い分野で活用されています。

マルチモーダル

マルチモーダルAIは、複数のデータ形式(テキスト、画像、音声など)を統合的に処理・生成するAI技術です。これにより、より高度な理解と創造が可能となり、ユーザー体験が大幅に向上しました。

代表的なモデルと技術

-

CLIP(Contrastive Language–Image Pre-training)

- テキストと画像の関連性を学習し、両者を統合的に理解するモデル。

- 検索や分類タスクで高い精度を発揮。

-

DALL-E 2

- テキストプロンプトからより高解像度かつ詳細な画像を生成。

- マルチモーダルな創造性を実現し、複雑なコンセプトのビジュアル化が可能。

-

GPT-4

- テキストと画像を入力として受け取り、統合的な応答を生成。

- チャットボットやアシスタントとして、複数のデータ形式を活用した高度な対話が可能。

終わりに

以上がAIの歴史になります。

現在はChatGPTの登場以降、第4次AIブームの時代で、これからどのようにAIが発展していくのか楽しみです。

会社紹介・求人紹介

最後に会社紹介と求人紹介をさせてください

会社紹介

株式会社アイスタイルは@cosmeという美容の総合サイトを運営している会社になります。

主なサービスはこちらになります。

toC向けサービス

| サービス名 | 概要 | URL |

|---|---|---|

| @cosme | 美容の総合サイト | https://www.cosme.net/ |

| @cosme SHOPPING | コスメや日用品を取り扱っているEC。国内美容系ECで最大規模 | https://www.cosme.com/ |

| @cosme STORE | コスメ販売のリアル店舗 全国33店舗を運営(系列含む) |

https://www.cosme.net/store/ |

| └ |

@cosmeTOKYO 旗艦店(東京) |

https://www.cosme.net/store/flagship/tokyo/ |

| └ |

@cosmeOSAKA 旗艦店(大阪) |

https://www.cosme.net/store/flagship/osaka/ |

toB向けサービス

| サービス名 | 概要 | URL |

|---|---|---|

| @cosme for business | 法人向けサービス ・BradOfficial ・@cosme 体験型コンテンツ など |

https://business.cosme.net/service |

求人紹介

株式会社アイスタイルではエンジニアを募集しています!

WEBエンジニアからアプリエンジニア、データエンジニアなど幅広く募集しています。

気になった方はこちらからご応募ください!(カジュアル面談もお待ちしております!)

| 職種 | 応募リンク | |

|---|---|---|

| エンジニア全般 | ・WEBエンジニア ・アプリエンジニア ・セキュリティエンジニア ・データエンジニア など |

https://open.talentio.com/r/1/c/isytyle_career/homes/4344?group_ids=9070 |

| データ系 職種 |

データ関連の求人 | https://open.talentio.com/r/1/c/isytyle_career/homes/4344?group_ids=9069 |

参考文献・参考サイト

- 第1次AIブーム(推論・探索の時代)、第2次AIブーム(知識の時代)

- 深層学習教科書 ディープラーニング G検定(ジェネラリスト)公式テキスト 第3版 - 翔泳社

- https://zero2one.jp/ai-word/eliza/

- https://www.soumu.go.jp/johotsusintokei/whitepaper/ja/r06/html/nd131110.html

- 第3次AIブーム(機械学習・深層学習の時代)、第4次AIブーム(生成AI)

- 徹底攻略ディープラーニングE資格エンジニア問題集 - インプレス

- 生成AIで世界はこう変わる - SBクリエイティブ

- ゼロから作るdeep learning 1~4 - O'Reilly Japan

- 作って理解する Transformer / Attention

- ChatGPTのコア技術「GPT」をざっくり理解する

- https://dx.mri.co.jp/ai-blog/06/

- 30分で完全理解するTransformerの世界

- 深層強化学習アルゴリズムまとめ

- これから強化学習を勉強する人のための「強化学習アルゴリズム・マップ」と、実装例まとめ

- マルチモーダルAIとは?意味から身近な事例、ビジネスでの活用事例を詳しく紹介

- AI 激動の年!2022年の人工知能10大トレンドと必読論文