Azure Percept記事一覧

- Azure Perceptってどんなもの?

- Azure Perceptデバイスのセットアップ

- Azure Perceptデバイスのセットアップ・ツアー

- Azure Percept Visionのサンプルコード+サンプルAIモデルを動かす

- Azure Percept Visionのサンプルコード+カスタムAIモデルを動かす

- Azure Perceptデバイスを初期化

Azure Perceptは、プログラマ目線で言うと、次の3段階に分かれています。

- サンプルコード+サンプルAIモデルを動かす

- サンプルコード+カスタムAIモデルを動かす

- カスタムコード+カスタムAIモデルを動かす

今回は、1.のVision系のサンプルコード+サンプルAIモデル(sample vision model)を動かしてみました。

「サンプルコード+サンプルAIモデル」を動かすには?

サンプルコード+サンプルAIモデルをAzure Perceptデバイスへインストール(デプロイ)する操作になります。

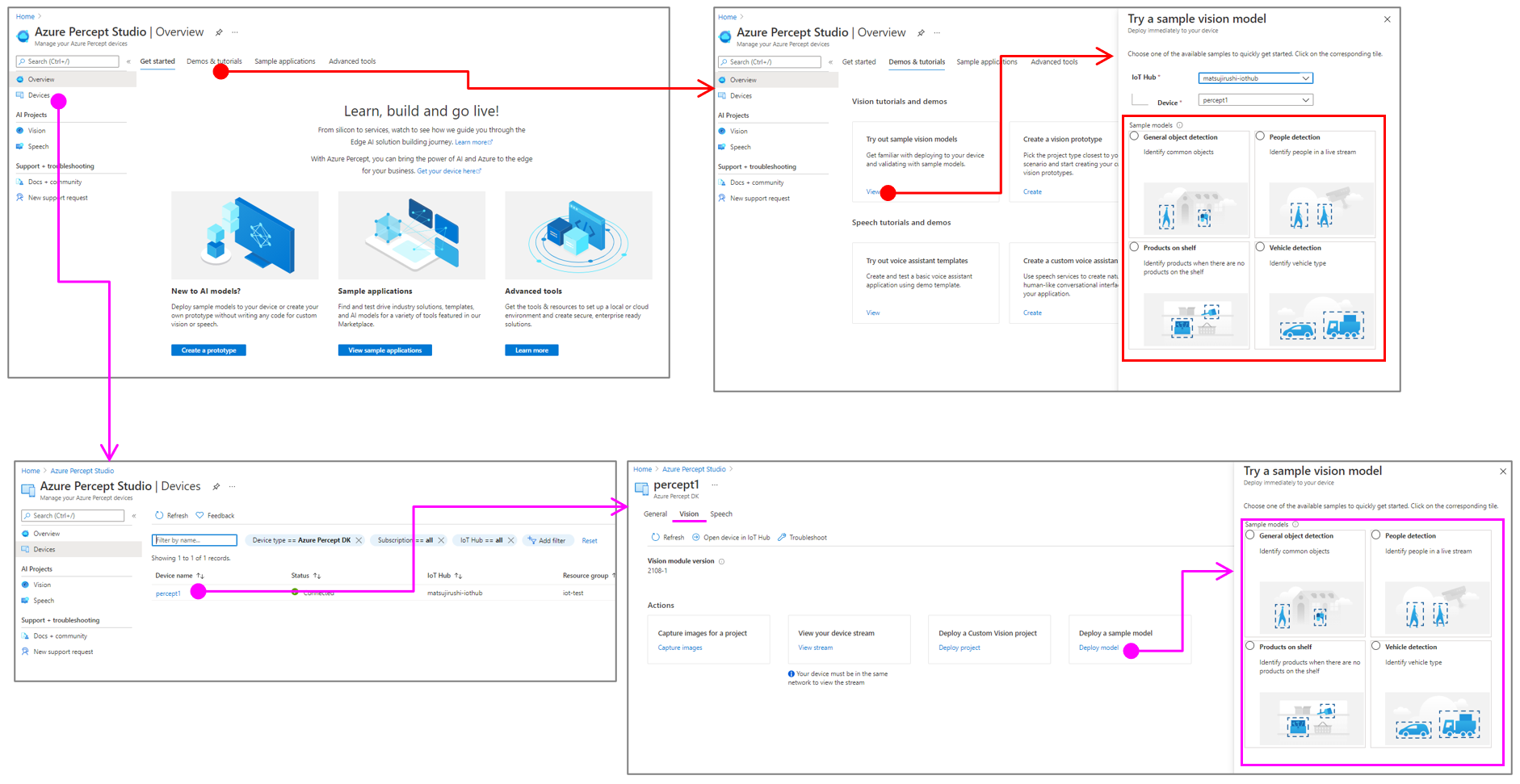

Azure Percept Studioに機能があるので、そこをポチすればOKです。

どこにあるかというと、

- Demos & tutorials -> Try out sample vision models

- Devices -> Vision -> Deploy a sample model

の2箇所です。どちらを使っても同じ操作になります。

現在は、

- General object detection

- People detection

- Products on shelf

- Vehicle detection

の4つを選択することができます。

絵が貼ってあるので、、、なんとなく雰囲気でどういうものか分かりますねw

General object detectionをデプロイ

General object detectionを選んで、下方にあるDeploy to deviceボタンをクリックすると、デプロイが開始されます。

Azureポータルの通知で、デプロイ成功!なメッセージが表示されますが、実際にAzure Perceptへデプロイが完了しているわけではありません。

View streamすると、静止画になっていて、画像の上部に「Loading Model」と書かれています。

このまましばらく待って(2~5分程度)デプロイが完了すると、自動的に動画に切り替わります。

General object detectionが動き出しました!!!

みかん(のおもちゃ)は認識されていますが、自動車(のおもちゃ)は認識されていません。😢

Vehicle detectionをデプロイ

この状態でVehicle detectionをデプロイしてみました。

待つこと数分。

自動車(のおもちゃ)だけが認識されるようになりました!!

Azure IoT HubへのJSON送信

このサンプルコードは、認識した物体の情報をJSON形式でAzure IoT Hubへ送信する機能があります。

Azure IoT Explorerを使って、Azure IoT Hubに送信されているデータを見てみました。

{

"body": {

"NEURAL_NETWORK": [

{

"bbox": [

0.298,

0.602,

0.364,

0.657

],

"label": "Car",

"confidence": "0.860823",

"timestamp": "1632227040940053075"

},

{

"bbox": [

0.179,

0.714,

0.297,

0.81

],

"label": "Car",

"confidence": "0.825626",

"timestamp": "1632227040940053075"

},

{

"bbox": [

0.472,

0.666,

0.549,

0.753

],

"label": "Car",

"confidence": "0.794633",

"timestamp": "1632227040940053075"

}

]

},

"enqueuedTime": "Tue Sep 21 2021 21:24:01 GMT+0900 (日本標準時)"

}

認識したラベルと確率、位置(bbox)がJSON形式で送られていますね。

まとめ

Vision系のサンプルコード+サンプルAIモデル(sample vision model)を動かしてみました。

- 試せるVision系のサンプルコード+サンプルAIモデルは4種類

- Azure Percept Studioでポチするだけ簡単

- 認識した情報はAzure IoT HubへJSON送信