はじめに

以下の記事に書いている、「ミニPC の GMKtec EVO-X2」を使ったローカルLLM に関する話の続きです。

●ミニPC「GMKtec EVO-X2」でローカルLLM: LM Studio で ROCm llama.cpp(Windows)+ gpt-oss-120b を利用【Ryzen AI Max+ 395・メモリ128GB搭載の PC】 - Qiita

https://qiita.com/youtoy/items/b6b376cae88b11e11100

●ミニPC「GMKtec EVO-X2」でローカルLLM: LM Studio の OpenAI互換のAPI + gpt-oss-120b を利用【Node.js】 - Qiita

https://qiita.com/youtoy/items/220f462138b3c7a8f98c

ちなみに、ミニPC EVO-X2 は、Ryzen AI Max+ 395 を搭載した以下の PC で、自分が購入したものはメモリが 128GB のモデルです。

今回の内容

上記の記事に書いた内容は、EVO-X2上での LM Studio を使ったローカルLLM でした。そのローカルLLM は、EVO-X2 のみを使う構成でした。今回は、ローカルネットワーク内の EVO-X2 と別PC を使い、それらの間での API を使ったローカルLLM を試します。

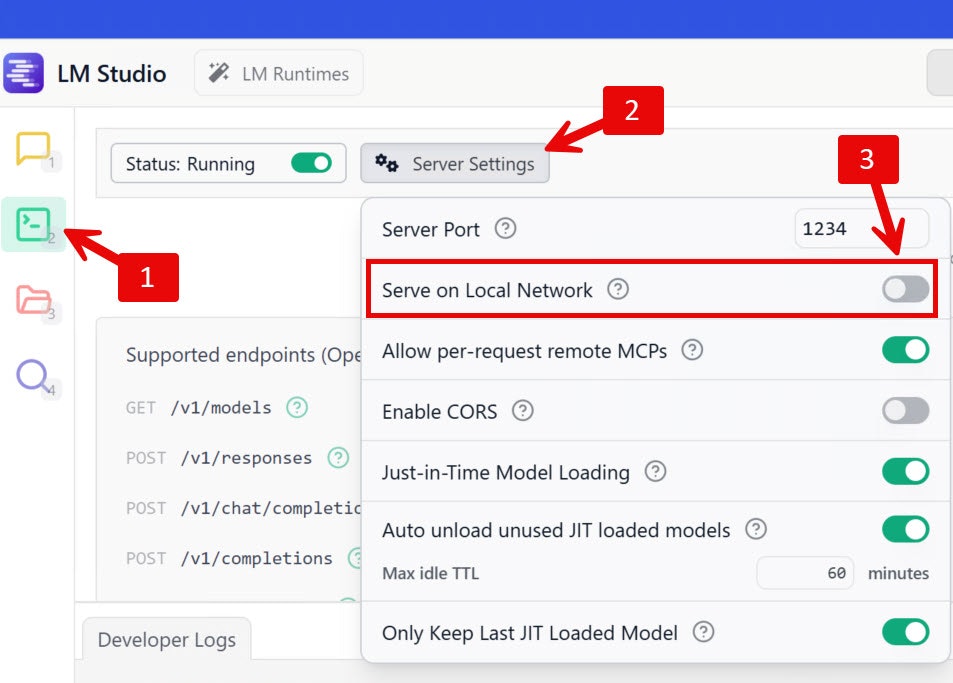

LM Studio のサーバー設定を変更する

LM Studio でサーバーを立ち上げた際、デフォルト設定では、そのサーバーを別の PC からは使えないようになっています。

これについて、LM Studio の設定を変えることで、ローカルネットワーク内の別PC からアクセスできるようになります。具体的には、LM Studio の設定で、以下の「Serve on Local Network」を ON にするだけです。

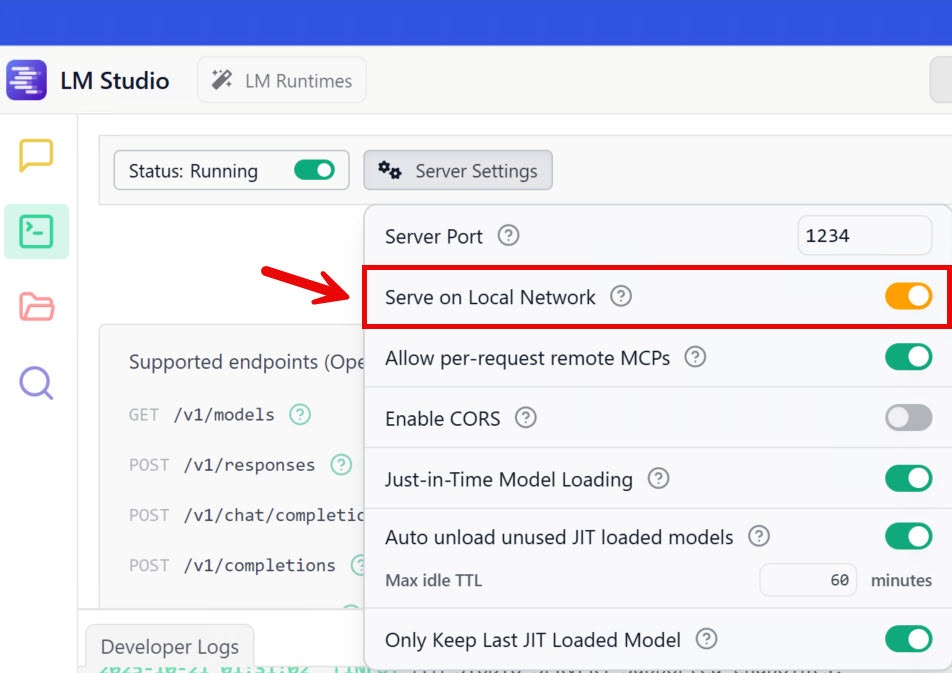

その項目を ON にした後の状態は、以下のようになります。

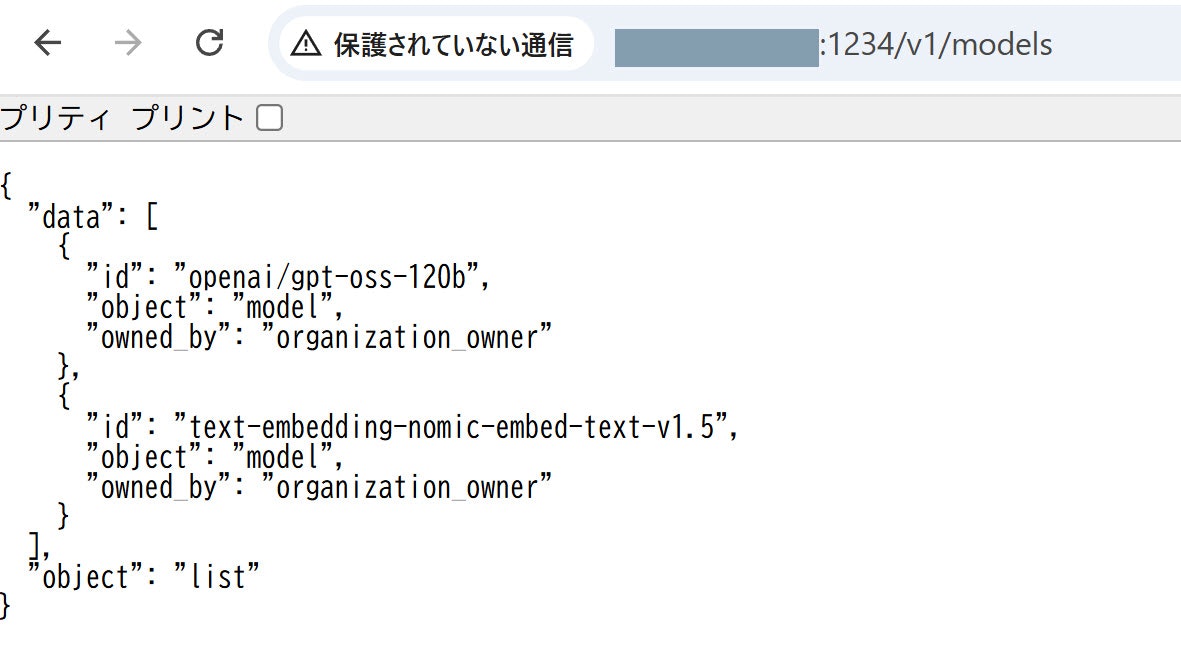

ブラウザを使ったお試し

ここで EVO-X2上の LM Studio に、別PC からのアクセスが行えるようになったかを、ブラウザを使って確認してみます。

EVO-X2 とは別の PC で、ブラウザを使って 「【EVO-X2 の IPアドレス】:1234/v1/models」にアクセスしてみます。その際に、以下のような表示が出れば大丈夫です。

API を使ったお試し

あとは Node.js + Vercel AI SDK を組み合わせた API利用を試します。

具体的なコードは、以下の記事で書いたものを使います。

●Vercel の AI SDK と LM Studio を使ったローカルLLM を組み合わせて試す【Node.js】 - Qiita

https://qiita.com/youtoy/items/7ec636b7086f107a9f5d

まずは以下のコマンドでパッケージをインストールします。

npm i ai @ai-sdk/openai-compatible

その後、以下のコードで処理を試してみました。

import { createOpenAICompatible } from "@ai-sdk/openai-compatible";

import { generateText } from "ai";

const lmstudio = createOpenAICompatible({

name: "lmstudio",

baseURL: "http://【EVO-X2 の IPアドレス】:1234/v1",

});

const { text } = await generateText({

model: lmstudio("openai/gpt-oss-120b"),

prompt: "あなたは誰?",

maxRetries: 1,

});

console.log(text);

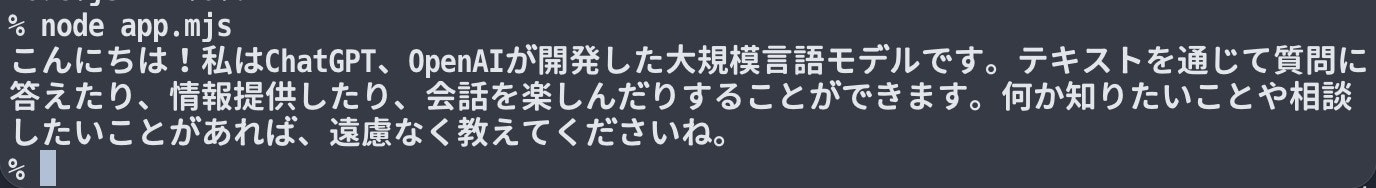

上記を実行したところ、以下のレスポンスを得ることができました。