この記事は ゆっくりテックウォッチ Advent Calendar 2025 の X 日目の記事です。

個人開発の「ゆっくり動画スタジオ」でGitHub人気リポジトリの解説動画を自動生成しており、その分析データをもとに本記事も生成しています。

TL;DR

- 40以上のLLMプロバイダー(OpenAI、Claude、Gemini、Llama等)を統一インターフェイスで利用可能

- Human-in-the-loop対応のワークフロー中断・再開機能で、人間の承認を挟める設計

- Y Combinator W25採択の注目スタートアップが開発

このリポジトリについて

TypeScriptでAIエージェントを構築するフルスタックフレームワーク

Mastraは、TypeScript向けのAIアプリケーション・エージェント構築フレームワークです。40以上のLLMプロバイダー、ワークフロー、メモリ、RAG、評価機能を統合し、プロトタイプから本番環境まで一貫して開発できます。Y Combinator W25に採択された注目のスタートアップが開発しています。

| 項目 | 内容 |

|---|---|

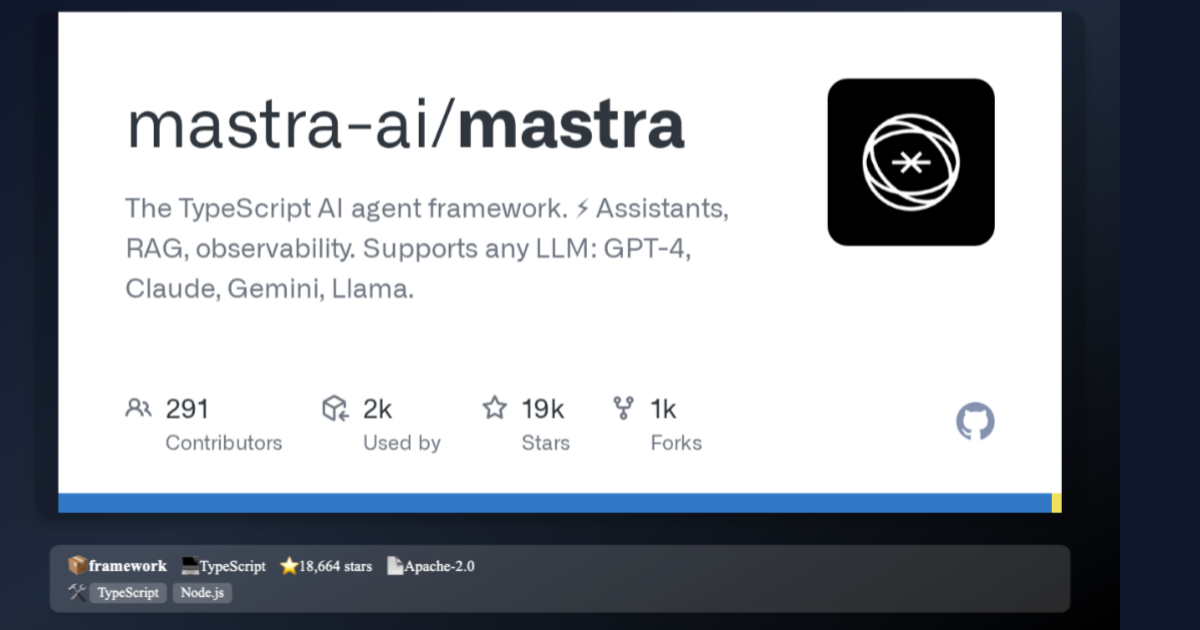

| リポジトリ | mastra-ai/mastra |

| スター数 | ⭐ 18,664 |

| 言語 | TypeScript |

| ライセンス | Apache-2.0 |

| 作成日 | 2024年8月6日 |

なぜ今注目されているのか

LLMを使ったアプリ開発、プロバイダーの切り替えやワークフロー管理が煩雑すぎると感じたことはありませんか?

Mastraなら統一インターフェイスで40以上のLLMを切り替え可能。同じコードでOpenAI、Anthropic、Geminiなどを使い分けられます。

スター推移

2024年8月にリポジトリが作成され、2024年11月に500スターを突破。そして2025年2月に爆発的な成長を遂げ、わずか1週間で1,300スターから7,700スターへと急増しました。Y Combinator W25への採択が発表された時期と重なり、注目度が一気に高まったと考えられます。現在は18,000スターを超え、活発に開発が続いています。

主な機能・特徴

1. 40以上のLLMプロバイダーを統一インターフェイスで利用可能

OpenAI、Anthropic(Claude)、Google Gemini、Mistral、DeepSeek、xAI、Perplexityなど、主要なLLMプロバイダーを同じコードで切り替え可能です。

- コスト最適化: モデルごとに料金が異なるため、タスクに応じて最適なモデルを選択

- 障害時のフォールバック: 特定のプロバイダーがダウンしても自動的に別のモデルに切り替え

- ベンダーロックインの回避: 特定のプロバイダーに依存しない設計

2. Human-in-the-loop対応のワークフロー中断・再開機能

エージェントやワークフローを途中で一時停止し、人間の承認を得てから再開できます。

たとえば「秘書のような存在」と考えてください。ゴールを伝えるだけで必要なツールを選んで実行しますが、重要な判断が必要な場面では人間に確認を求めます。ストレージで実行状態を永続化するため、長時間のタスクにも対応できます。

3. Y Combinator W25採択の注目スタートアップ

世界最高峰のスタートアップアクセラレーターであるY CombinatorのW25バッチに採択されています。Airbnb、Dropbox、Stripeなどを輩出した同プログラムへの採択は、技術力とビジネスポテンシャルの高さを証明しています。

4. MCP対応でエージェント間のツール共有が可能

**Model Context Protocol(MCP)**に対応しており、「ツールのUSB規格」のように、どのAIからも共通でツールを呼び出せます。VS Code、Cursorなどの開発ツールとも連携可能です。

技術スタック

TypeScript製AIフレームワーク、40以上のプロバイダー対応

| 分類 | 技術 |

|---|---|

| 主要技術 | TypeScript, Node.js |

| フレームワーク/ライブラリ | Hono, Vercel AI SDK, Zod, pnpm, Turbo |

| インフラ | PostgreSQL, Redis, Docker, Vercel, Netlify, Cloudflare |

| 連携サービス | MCP, OpenTelemetry, Pinecone, Chroma, Qdrant, CopilotKit |

ユースケース

ユースケース1: AIスタートアップのCTO

背景: OpenAI依存から脱却し、コスト最適化とリスク分散を図りたい

課題: LLMプロバイダーの切り替えにコード修正が必要で開発速度が落ちている

解決策: Mastraの統一インターフェイスで、設定変更だけでプロバイダー切り替え可能に

結果: API障害時のフォールバックが自動化され、SLAが99.9%を達成

ユースケース2: TypeScript個人開発者

背景: Pythonは苦手だが、LangChainのような高機能フレームワークが欲しい

課題: TypeScriptでエージェントを作ろうとすると低レベルなコードが多くなる

解決策: Mastraでエージェント、ワークフロー、メモリまで統合された環境を手に入れる

結果: Vercelにデプロイ、副業収入の柱となるSaaSを構築

ユースケース3: エンタープライズのバックエンドエンジニア

背景: 既存のNode.jsマイクロサービスにAI機能を追加したいが、セキュリティ要件が厳しい

課題: Human-in-the-loop対応のワークフローを自前で実装するのは工数がかかりすぎる

解決策: Mastraのワークフロー中断・再開機能で承認フローを簡単に実装

結果: 開発工数を50%削減し、監査対応も容易に

競合との比較

LangChainとの違い

| 観点 | Mastra | LangChain |

|---|---|---|

| 主要言語 | TypeScriptネイティブ | Python(JS版は機能限定) |

| ワークフロー機能 | 組み込み(中断・再開対応) | LangGraphで別途構築 |

| エコシステム | 成長中(YC採択) | 成熟(大規模コミュニティ) |

| React/Next.js統合 | ファーストクラスサポート | サードパーティ依存 |

Mastraを選ぶべき場面: TypeScriptで統一した開発環境を構築したい場合、Next.jsアプリにAI機能を追加したい場合

Vercel AI SDKとの違い

| 観点 | Mastra | Vercel AI SDK |

|---|---|---|

| 抽象化レベル | 高(エージェント、ワークフロー) | 低〜中(ストリーミング、UI統合) |

| エージェント機能 | 組み込み | 基本的なツール呼び出しのみ |

| 評価・可観測性 | 組み込み | 外部ツール必要 |

MastraはVercel AI SDKを内部で使用しており、より高レベルな抽象化を提供します。本格的なAIエージェントを構築したい場合、評価・可観測性が必要な場合にMastraが適しています。

始め方

# プロジェクト作成

npm create mastra@latest

対話形式でテンプレートを選択できます。公式のコースやYouTubeチャンネルで学習を進められます。

詳細は公式ドキュメントを参照してください。

まとめ

- TypeScriptネイティブのフルスタックAIフレームワーク

- 40以上のLLMプロバイダーを統一インターフェイスで利用可能

- Human-in-the-loop対応のワークフロー中断・再開機能が標準搭載

- Y Combinator W25採択の信頼性

TypeScriptでフルスタックAI開発が可能な時代が来ました。npm create mastra@latestで今すぐ始めましょう!Discordコミュニティで質問も歓迎です。

動画で詳しく解説しています

YouTubeチャンネル「ゆっくりテックウォッチ」では、GitHub の注目リポジトリをゆっくり解説しています。

この記事で紹介した Mastra の解説動画も公開していますので、ぜひご覧ください!

チャンネル登録よろしくお願いします!

関連リンク

この記事は AI によって自動生成されました。内容に誤りがある可能性があります。