最初の回答

不勉強で、wgetについて存じないのですが、もしかしてWebコンテンツ(HTMLファイルなど)をダウンロードするツールではないでしょうか?

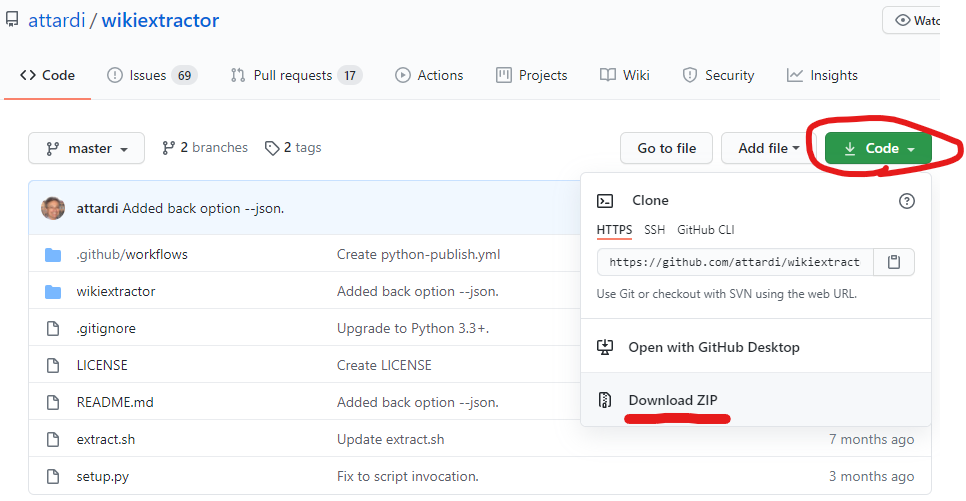

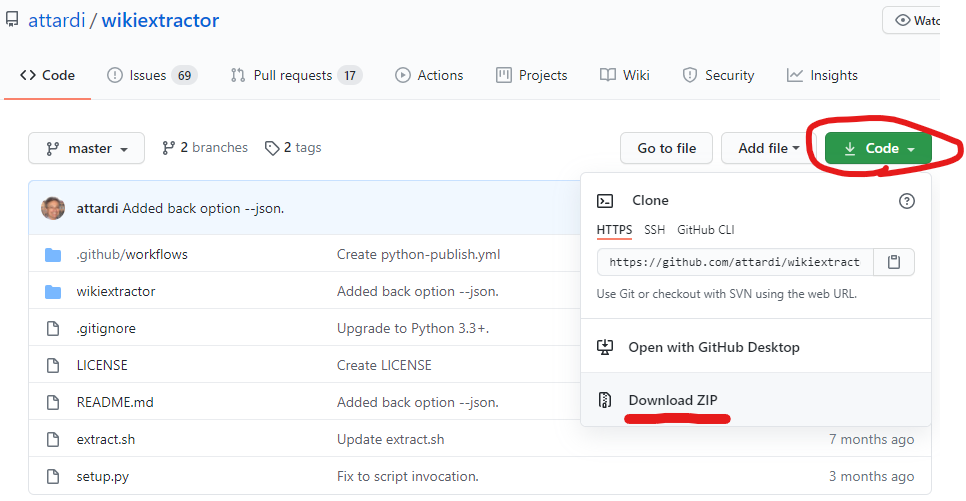

GitHubからソースファイルをダウンロードするのでしたら、ページにある「zipでダウンロード」(下図)や、GitHub Desktopなどのツールを使うのが良いと思います。

追記

実際に試してみました。

環境

- Python 3.8.5

- conda 4.9.2

- Windows 10 (20H2)

モジュールのダウンロードと展開

前述のリンクからダウンロードしたzipを以下のように展開しました。

wikiextractor-master

│ .gitignore

│ extract.sh

│ jawiki-latest-abstract.xml

│ LICENSE

│ README.md

│ setup.py

│ tree.txt

│

├─.github

│ └─workflows

│ python-publish.yml

│

├─text

│ └─AA

│ wiki_00

│

└─wikiextractor

│ cirrus-extract.py

│ clean.py

│ extract.py

│ extractPage.py

│ WikiExtractor.py

│ __init__.py

│

└─__pycache__

extract.cpython-38.pyc

WikiExtractor.cpython-38.pyc

__init__.cpython-38.pyc

ダンプファイルの取得

よく分からないままに、「ウィキペディア日本語版のダンプ」から適当にファイルを1個だけダウンロードして展開しました。

ダウンロードしたファイル: jawiki-latest-abstract.xml.gz

展開して得たファイル: jawiki-latest-abstract.xml

実行

Anaconda Promptを開き、カレントディレクトリを前述の展開先フォルダwikiextractor-masterにして、README.mdの「Usage」に「The script is invoked with a Wikipedia dump file as an argument:」と書かれている通りに実行してみました。

wikiextractor-master>python -m wikiextractor.WikiExtractor jawiki-latest-abstract.xml

すると、以下のような出力が始まりました。

INFO: Preprocessing 'jawiki-latest-abstract.xml' to collect template definitions: this may take some time.

INFO: Loaded 0 templates in 0.0s

INFO: Starting page extraction from jawiki-latest-abstract.xml.

~

読む限り、少なくとも、抽出処理は開始できているようです。