この記事は、Elixir Advent Calendar 2023 シリーズ8 の17日目です

piacere です、ご覧いただいてありがとございます ![]()

2023年の世界における生成AI発展には、凄まじいものがありましたね

その内容を紐解き、そこから2024年のElixir AI・LLM(Large Language Models)を占うコラムです

Elixir自体に、まだあまり興味がそこまで湧いていない方でも、序盤の「2023年末までの世間のAI・LLMムーブメント」を読んだら現在のAI・LLMシーンをそれなりに把握できるのでオススメです(その後の続きを読んでいただけたら、もっとワクワクすることはお約束します)

ひさしぶりに厨二病な内容も多めで、AI・LLMの知識に詳しくなくても楽しめる内容にチューニングしていますので、ワクワクしながらお読みください 💁♂️

2023年末までの世間のAI・LLMムーブメント

まず、今年のAI・LLMムーブメントそのものについて整理してみます

最初に、私の個人的なAI使いの日常をお伝えし、ユーザーとしての体験を共有することを通じて、今年を振り返ります

次に、AI・LLMの技術面について、開発者 or 事業オーナー視点での見解をまとめつつ、最新技術とトレンドの紹介をすることで、今年を振り返ります

その後の続く3つのトピックは、タダの与太話ですw

① 私が「実際に使っている」LLM活用領域

プレゼンテーションは人が前半を作ればかなり有用

私は昨年末頃から、顧客向けプレゼンテーションの前半(前提、課題定義、環境のロジック説明)を自身で組み立て、後半(課題解決案、応用例、注意点など)はLLMに自動生成させ、その内容を目検で精査・裏付けすることで、資料作成速度は2~3倍くらいスピードアップしています

前半が高精度な課題提起や顧客心理理解で構成されており、その予測精度も高いため、それを読み込んで作られる後半が外れることも、まずありません(ここはかなり重要なポイントです)ので、AIは効率アップにかなり寄与しています

ちなみに、プレゼンテーションした数回後のMTGで「このプレゼンテーションの展開を最初から予見していたのですか?」と言われますが、そのような予測は顧客ポジションに立った思考と技術知識、そして、ごく普通のロジックで導き出せるもので、AIはこういった処理が極端に不得意です … とは言え、今後は後述する「マルチモーダルAI」をMTGの場に置けたら、人を越える可能性はあるかも知れません

経営会議やマーケティング戦略立案でも有用

また、他の使い方としては、経営会議やマーケティング戦略立案などにおける語彙の創発や、人が書いた文章の整合性・統一性チェックのダブルチェッカーとしても使っています

全体の整合性や統一性を問うたり、要約するタスクにおいては、人間以上の信頼性・精度・性能を発揮すると捉えており、後述するBingのところで解説するような「主観」や「判断基準」を持たせたら、この領域は人間が不要になる予感はしています

プログラミングはまぁまぁダメかも

逆に、プログラミングに関しては、お決まりのタスクにはめっぽう強い一方、嘘をつかれるダメージの方が大きく、コード量を下手に増やす原因にもなるので、プロダクション利用には全く適さず、現在はお試し程度しか使っていません

しかし、それも利用目的次第かなと考えており、来年計画しているプロダクトローンチ速度を4倍速に高める際には、プロダクトを3ヶ月以内にリリースさせ、PMF(Product Market Fit)してからリファクタリングする(もしくは次期バージョン開発チームを組成する)という際の初期バージョンを作る目的で、もっと積極利用するかも知れませんので、来年には、もっと興味深いレポートを出せるかも知れません

… とか言いながら、そもそもコード補完も邪魔だからオフってるようなオールドプログラマだし、それで充分な開発速度も出てるから、考え方のちょいとした切り替えだけすれば手動コーディングで充分 … となってしまう可能性も否定できないので、早々にサヨナラしちゃうかも?

なお、新規事業のアイデア出しやブレインストーミングのような、アイデア飛躍を期待する活動では、全く使い物になりません … それはさながら「企画配属1年生」を相手にしているかのような、誰でも考えつく低レベルのアイデアしか出て来ないし、むしろプロンプトのお守りの分、正直お荷物です

コーディングにおけるAI支援も、そうなる可能性はそれなりにあると考えています(その根拠はこの後、述べます)

こんな感じで、わりかし日常利用して1年ちょいくらい経ち、普段の業務に領域を限定するもののガッツリ活用しています

未だLLMのビルドまでは手を付けられていませんが、来年はそこにも踏み込んでみようと思っています

なお私は、生成AIの利用だけで無く、AI・LLMのアーキテクチャやモデルに関する講義と登壇、企業・自治体研修、スクール運営も2018年から行っていますので、利用面だけで無い部分も下記スライドで感じてもらえたら幸いです

② 今年1年に進化した技術面

さて今度は、今年1年に進化したAI・LLMの技術面について触れていきましょう

a)さまざまな企業がLLMをリリースした

ChatGPTのブレイクスルーがきっかけで、GAFAMやOpenAIを中心として、さまざまな企業がチャットボット型LLMをリリースしました(実際は、2018年頃からLLM自体はBERT等を皮切りに地味にリリースされ続けていた)

海外産のメジャーモデルは、下記が代表例です … 少し古いコラムなので、最近だと「Gemini」「Claude」などのニューカマーが現れています

https://www.promptingguide.ai/jp/models/collection

その中でも、「ChatGPT」がやはり別格で、リリースから約1年近く経った今でも、トップランナーとしての優位性はOpenAI共々、揺らいでいる感じがあまりしません

ChatGPTに接続できるツールも増え、今後しばらくもChatGPTの一人勝ち状態が続くように思われます

私も、上述した活用の中の大半はChatGPTで、ピンと来ないときやネット上の新着情報も踏まえたいときだけBingやBardを使う感じです

b)自前でLLMをビルドする企業/個人が現れた

GAFAMやNVIDIA、OpenAPIといったメジャー企業だけに限らず、自前でLLMをビルドする企業/個人が現れました

その代表例が、日本語特化LLMへのニーズを担いだ「国内産モデル」です

国内産のモデルは下記の通りです

こうした状況に対し、AWSは国内企業17社に対するLLM事前学習環境と技術支援を提供しています

自前でビルドするためのノウハウも共有され始めました

「KerasCV」と「KerasNLP」の発表も、こうした流れの中から生まれた気がします

ただし、1つのGPUでは学習し切れないことや、ビルド自体に数億円級がかかるなど、個人ないしは小規模企業の手には余る状況下ではあり(これはLLMが流行る前のBERT時点から分かっていたことですが)、クラウドGPU/TPUを有償で利用することが前提になります

【2024/3/9追記】

LLMをGPU無しでローカル実行できる「localllm」がGoogleからリリースされ、ビルド不要なローカルLLM利用も可能になってきました

c)AI基盤技術も様変わりし始めている

今年の技術面におけるスマッシュヒットは、「マルチモーダルAI」の出現でしょう

マルチモーダルAIは、文章や画像、音声などの複数入力から学習を行い、たとえば人の表情と声色を組み合わせ、「あぁ、この人は喜んでいるんだな」「怒っているんだな」ということを総合的に判別できるようになり始めました

上記したGoogleの「Gemini」が、このマルチモーダルAIの代表格です

これはクラシックなディープラーニングに例えれば、「アンサンブル学習」である勾配ブースティングやランダムフォレストが、さほどマシンパワーをかけずに高精度な予測を行った状況に似ています

より人間的な判断も高まっていくでしょう

このGeminiを搭載したメモアプリである「NotebookLM」に自身の考えやふとした写真、動画をアップしたら、自分の活動の役に立てるヒントをアレコレもらえそうです

【2024/3/9追記】

Gemini以外にも、下図のような数々のマルチモーダルAIが存在します(下記論文より引用)

https://arxiv.org/abs/2401.13601

あと、つい先日、第5世代の後継である「v5p」がリリースされた「TPU(Tensor Processing Unit)」が、このGeminiの学習にも使われているのですが、TPUは2017年にリリースされた第2世代の頃から、その存在感と8bit CPUのメモリレスアレイで構成するというアーキテクチャに個人的に惚れ込み、ずっとファンで、前身たる「v5e」の効率性よりも速度重視に振ったスタンスも、これまた好ましいです(GX観点ではNGなんですけどねw)

Google以外にも、Apple M2やIntel Core Ultraと言った、AI機能搭載CPUの出現も見逃せません

アルゴリズム面で言えば、「Model Parallel」や「Data Parallel」と呼ばれる、いわゆる「分散学習」が、LLMの台頭に呼応して注目され始めています

これまでは、AI・LLMの潮流に、あまり「分散」というキーワードが出てくることは無く、どちらかと言えば、CNN/RNNからTransformerへの移行といった面で、「1台のGPUを並行駆動させる」というフォーカスでしたが、今後はマルチクラスタでのAI学習とその途中過程ないしは最終過程のデータ共有にてMapReduceに近いコンセプトが、重要な位置付けを占めていくこととなるでしょう

つまり、「分散学習」と「データ集約」がキーワードとなる訳です

たとえば、TensorFlowに搭載された「DTensor」と言う新たな並行化技術も、「Data Parallel」の一種です

一方、データは共有せず、AIによって得られた予測結果を統合することで予測を行う「フェデレーテッドラーニング」も今年のトレンドです

これまでは、オープン型AIが主流でしたが、企業内の機密情報や工場などでのAI利用には向いていません

そこで、データは共有せず、AIの予測結果群を統合する、このフェデレーテッドラーニングが、これまでLLMを活用し切れなかったtoB需要を満たしていくことでしょう

無論、フェデレーテッドラーニングの実現は、「分散」と「データ集約」そのものです

その他、下記のような技術にも注目が集まっています

- 自己教師付き学習

- 教師データ(ラベル)が付いていないデータから特徴抽出し、教師あり学習化する

- メタラーニング

- 特定のタスクに特化せず、多様なタスクに対応できるモデルを生成する

- 転移学習で大量データで叶えていたことを小さなデータセットで済ませられる

- 特定のタスクに特化せず、多様なタスクに対応できるモデルを生成する

- リアルタイム分析AI

- センサーデータやストリーミングデータに対してAI処理を行う

d)LLMを取り込む実用的アプリが出てきた

LLMが流行ったことにより、LLMを活用するアプリもずいぶん増えました

最初のうちは、ホビィユースなものが多かったのですが、今年後半からは、本格派の実用アプリも出始めています

たとえば、RPAにLLMを統合したUiPathは、いわゆる「RPA 3.0」と呼ばれ、toBへの大きなインパクトをもたらしそうです

UiPathのインパクトよりは、だいぶミニマムになりますが、NotionやJira、Trello、Asana、Wrike、Zeno、Jasperあたりのエンジニアには馴染みのアプリも実用的アプリと言えるでしょう

e)エッジコンピューティングがAI・LLMの主戦場になりつつある

これまでは優先度が決して高くは無かった「エッジコンピューティング」に、AI・LLM側面から注目が集まり始めています

従来であれば、AI・LLMを動かす場所は、クラウド上と決まっていたかのようでしたが、費用負担や通信途絶下でのコンピューティング、もしくは遊休資産活用などの都合から、上図にも示す通り、その位置付けは、じょじょにエッジサーバやエッジ側にオフロードされ始めています

特に上述した「分散学習」の必要性がLLM台頭により生まれたことと、「フェデレーテッドラーニング」のクローズドLLM利用の需要が生まれたことのダブルで、クラウドには叶えられない需要として、急速にエッジコンピューティングの重要性が高まっています

コア技術で言えば、NVIDIAの「仮想コンピュートサーバー(vCS)」なんかは、シームレスなGPUクラスタを構成できるので、リッチなソリューションにおける代表技術となりそうです … NVIDIA株が現在、急激に上昇しており、世界時価総額ランキングも6位まで上昇していますが、この方面がブレイクしたら、トップ3に追いつく可能性すらありそうです

そうそう私も、ちょうど1年前にこの分散学習とクラウドレンダリングを、高価なGPU無しで叶える技術に言及したコラムを下記で書いています(今年、この続編もまもなく書きます)

さて、技術パートの最後として、これら凄まじい技術革新を提供する企業は、軒並み時価総額ランキングトップ企業である点を示しておきます

彼らが「世界をより良いものへと進化させている」ことへの尽力には、尊敬と感謝しかありません

③ 「生成AI」と「LLM」に湧き、そして「飽きた」?

ここまではマジメな話でしたが、ここからは与太話も多分に含みつつ、ある種の核心めいたものにアプローチしてみます

エンジニアだけに限らず「生成AI」と「LLM」に対する期待に湧いた2023年でしたが、現在は、やや幻滅期の入り口に立ったような様相を呈しているように思われます

そこには、あまり合理的な理由は無く、当初ほどの発展が感じられず、単に「飽きた」、もしくは「食傷気味になった」だけだと思われます

そもそもが、2018年から続いたTransformer/AttentionによるAI・LLM自体のエポックメイキングを、世間のほとんどの人は知らない状態です

そこから、いきなり昨年末にStable Diffusion(とその手前のMidjourney)やChatGPTで脚光を浴びたスナップショットを見た訳で、自ずと凄まじい進化速度を期待した訳ですが、そんな都合良く進む訳も無く、停滞したかのように感じ、期待を裏切られたと勝手に思い込んだのかも知れません

もしくは、純粋に1つのことが続くことに飽きたのでしょう … 特に、自身でAI・LLM開発していない層は、サクッと離れたのでしょう

人の「飽き」「期待」というものは1年も持たないのですね … いやはや恐ろしい … ![]()

【ここから、私の独り言です】

そういえば、「プロンプトエンジニア」とか、息、してるんでしょうか?

単に、「AIが無くても仕事できる人」がますます強化され、「AIしか知らない人/AIの述べることを鵜呑みにする人/正解を知らない人」の多くは露頭に迷うか、間違いをそこら中にバラまきまくって信頼失墜しているという、ちょっと考えれば分かる一過性のブームも終焉を迎えているように思えます

結局は、調査力が無い人や裏取りをする習慣の無い人、本質的な物事が分かっていない人がAIでどうにかなるなんてバラ色の状況を妄想すること自体が誤りです

このあたりについて、もし違う考え方があって、私が知らないだけであれば、ぜひコメントいただけたり、教えていただけたら幸いです(私も途中から、未学習者のAI支援による成立の領域を追うことに興味を失ってしまいまして…)

④ 合理的なマイナス面も顔を出し始めている

仮に、次の波が来て期待が続いたとしても、下記コラムの通り、現実的なコストと倫理的観点の問題に直面せざるを得なくなっています

あと電力と環境の問題も … たとえばMicrosoftは、最近ニュースになっていた OpenAIサム・アルトマン+スタッフをリクルートできなかった問題 以前に、核融合に振っていた電力供給課題解消を、目の前の原発に振らざるを得ない直近感が増しています

これらダブルトレンドが意味するものは何か?

これは私の個人的見解(実は2017年頃から主張している)ですが、結局は、核融合はじめとする「無限エネルギーの成立」、つまり「惑星文明タイプ1(≒地球のエネルギー埋蔵量に依存しない文明)」への到達が前段に無ければ、AIのパワーも出し切れない … ということです

人のネット上知性を束ねて学習したAIによる「プレシンギュラリティ」で「無限エネルギーの成立」を叶えるという方向性もありますが、恐らくは卵鶏論争で、そのフォアキャスティングは概ねハズレのように思われます(これは、地球資源に依存しないために宇宙にロケットを飛ばしたいけど、地球にそれだけロケットを飛ばすエネルギー量が埋蔵されていない「崩壊学」のノリに近い)

⑤ そもそも今のAIは「人並み」に信じて良いのか?

「生成AI」や「LLM」の出現は、「強いAI」もしくは「AGI(Artificial General Intelligence:汎用人工知能)」の到来と噂されています

毎年、さまざまな企業/機関で講演するスライドの今年バージョンでもココに触れており、「生成AI」「LLM」がもたらす「強いAI」の実現は、人類がコンピュータとAIを発明する70年の歴史における悲願と言えるでしょう

しかし、「生成AI」や「LLM」は、本当に「強いAI」と言えるのでしょうか?

その発端となったブレイクスルーである「Attention」は、確かに人間の直感的な思考パターンに近いものを表現してはいます

しかし、転移学習無に稼働し続けられる程、汎用目的に耐えられる仕組みではありません

そもそも、LLMの土台となっているディープラーニング/Transformer自体は、あくまで相関を自動解決できるボトムアップメカニズムに過ぎず、Attention含めて「嘘をつく」確率の高さは当然と言えば当然で、「AGI」「汎用人工知能」と言う概念に果たして適合していると言えるかは、だいぶ怪しいと考えます

また、「自意識」や「自我」、「感情の解釈」も付与されない点も、「AGI」や「強いAI」の条件は満たしていないと考えており、自律性からは程遠いというのが、LLMの正体・本質でしょう

恐らく、自律性の獲得には主観や感情、もしくは社会的立場や人生観/寿命を源泉とする「偏り」が必要で、これらはディープラーニング/Transformerは供給してくれません … そもそも根本的なメカニズムが存在しないと言うことです

では、人間は何故、自律的な判断/意思決定が出来るかと言うと、分かりやすいところだと、「寿命が100年」と言う寿命から来る制約によって、仕事や投資、プライベートの多くが確定されてることが多いです(人間でも無意識な方は多いですが)

なお、Bingにいわゆる「小泉構文」の整合性を解かせた際は、Bing自身が感情や態度を適度に表現することで、ChatGPTには出来ない主観を伴った妥当な回答を返し、その論拠も下図の通り述べていました(とは言え、Bingが自身をそう主張する根拠の裏取りは出来ないため、「それっぽいこと」を言ってるだけに過ぎないかも知れませんがw)

とは言え、「強いAI」の定義の一部である「人と同等の知的処理を持つ知的処理」という面に関しては、「GLUE」という自然言語処理を用いる知能のレベルを判定できるベンチマークでは、2019年段階で人間の平均知性を上回っています

このことが何を意味するかと言うと、

「平均的な人間よりは、AIの方がマシ」

と言う、ちょっとワロエナイ事実でしょうか ![]()

まぁ、そこまでは言い過ぎとしても、「チーム内であまり仕事が出来ない人よりは仕事出来る」くらいは普通に実現していそうです

同時に、学習サンプルが多い課題に対しては、「正解を知らない人」が骨抜きにされるほど正解に迫れるが故に、たとえばCopilotでのプログラミングに慣れ過ぎた場合、未知の課題やレアケース、着手人口が少ない課題を解けないエンジニアが激増することも予測されます

つまり、上述したディープラーニングの弱点だけで無く、「教師あり学習」であることの弱点も持ち合わせており、AIを「人並み」に信じてはならない背景はあります(少なくとも現在時点では)

要は、使いどころを間違えると、とんでもない社会問題になり兼ねない … そんなとこでしょうね

2023年末時点でElixir AI・LLMが出来ること

今年のAI・LLMのトレンド(と与太話)について洗ったので、今度は現時点のElixir AI・LLMが出来ることを洗っていきましょう

下記①~⑥のポイントにまとめてみました

全体像としては、1年前のAdvent Calendarで書いたコラムで述べた技術面の不足は、予想通り、ほとんど解消されました

私のAdvent Calendarコラムを「DEATH NOTE」だと言う方もいとらっしゃいますが、まぁ元々、「実現する厨二病」ですしね … 自身以外の活動に関しても、そこそこの予測くらい出来ますわい(つか、それが出来なければ、自身の企画も当てることは出来ない) ![]()

① 普通にプロダクション開発可能(というかソレ以上)

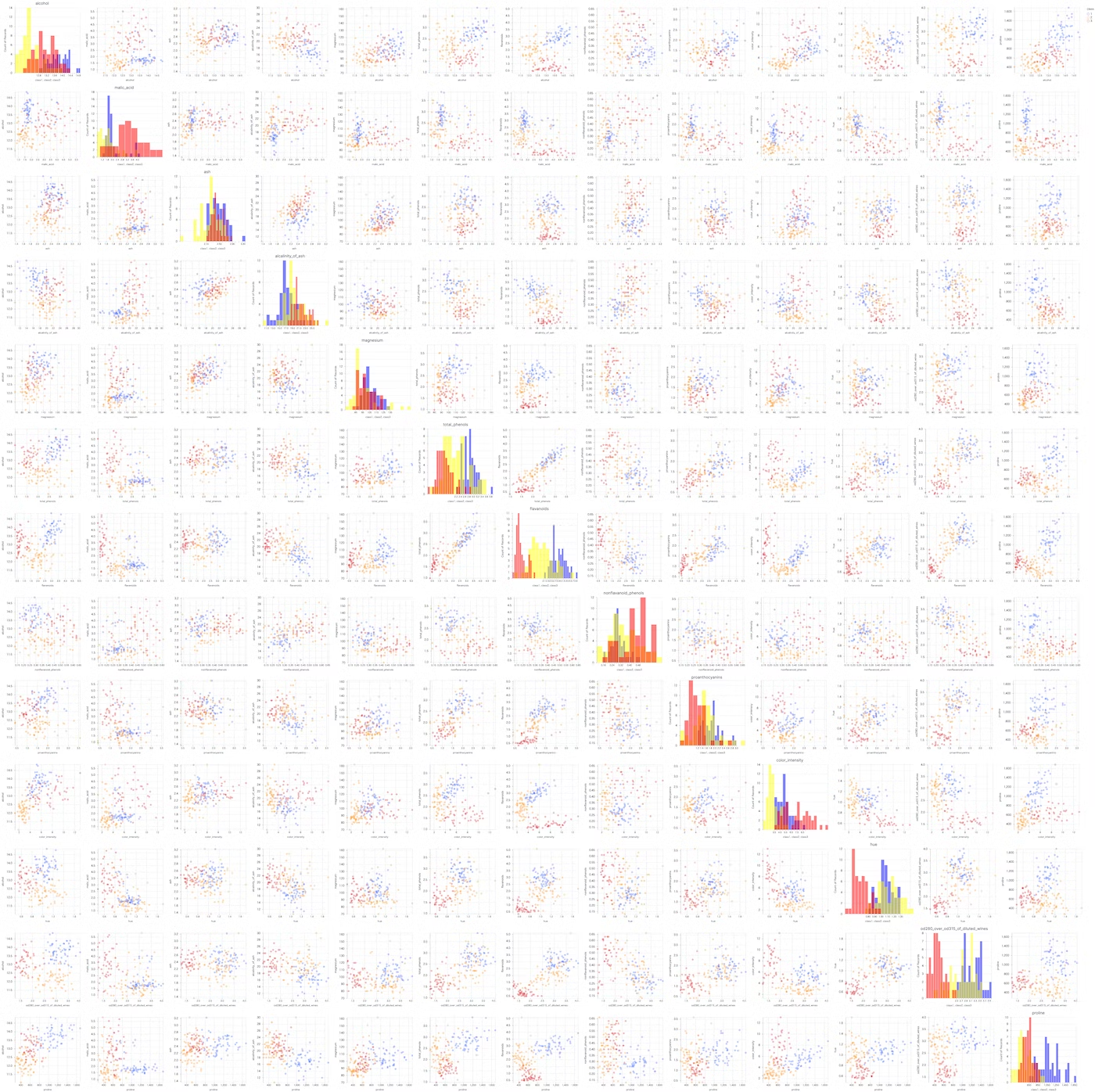

TensorFlow/KerasやPyTorch相当のディープラーニング開発は、「Nx/Axon/AxonOnnx」の出来がとても良く、普通にプロダクションレベルの開発が可能です

… という表現はだいぶ控えめで、モデルやデータ前処理を作るフィーリングは以下の通りで、Pythonで書いたときよりも書き味が良く、「素のElixirが持つ良さ・強み」と「TensorFlow・KerasやPyTorchでこなれたディープラーニングFWのエッセンス」を組み合わせて使えます

- Enumとパイプによる直感的で高度なデータ処理の感覚はテンソルに対しても同様

- 関数パターンマッチでデータ処理関数のパターンを書き分けやすい

- 学習結果がモデルに梱包されず、ステートとして返るので複数モデル操作が扱いやすい

- パイプラインはscikit-learnのような別実装にする必要が無い

- PythonのようにC++で組まれたAI・LLM部分以外がスローダウンしない

- 過去、何度その手のリプレイス案件に振り回されたことか…

- PythonのAI・LLM部分以外のメモリ爆食いも無く、異常時も安全に部分再起動できる

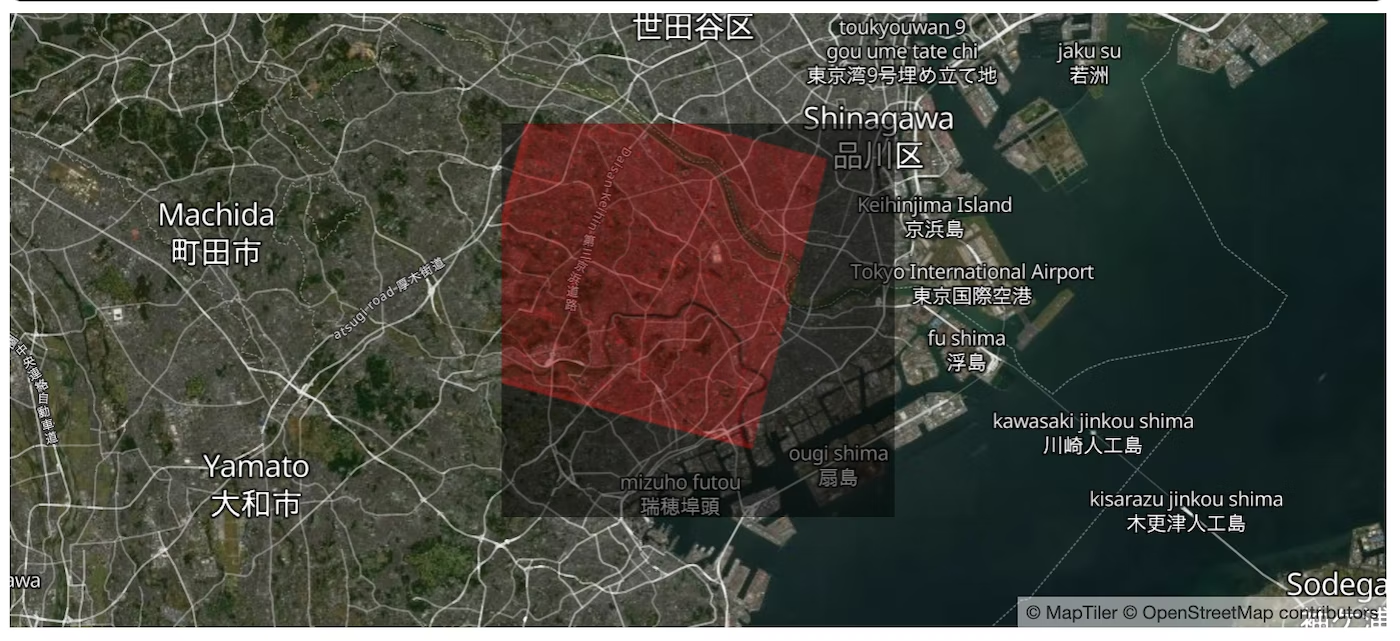

- Elixirの強みである並行・並列/分散/エッジサーバの恩恵でAI・LLMも容易に分散化

- センサーデータの前処理をエッジ、大量データはエッジサーバ/クラウドの株分け

- BigQueryやsnowflakeとの接続もイイ感じに

- 後発として、KerasやPyTorch等の「いいとこどり」をしている

- なんなら、Pythonで構築されたONNXモデルも扱える

-

「Bumblebee」のおかげで、Hugging Face最新生成AIモデルも利用可能

- Llama 2やMistral等のLLMが利用可能

- Stable DiffusionやWhisper等のLLM以外の生成AIも利用可能

- Safetensorsモデルも利用可能

- PandasやOpenCV、scikit-learn相当も使えるようになった

- これら全てをノーコードで扱える「Livebook」のUXは、JupyterNotebookを超えている

- その上、Livebook同士や、Livebookをコントローラとした分散すら可能

- Phoenixのサーバレス機能「FRAME」で関数単位の分散も今後、可能となる

実際にどこまで出来るかを知りたい方は、下記の本シリーズ過去コラムと、生成AIについて追記した今年のAI・LLM新作コラムをお読みください

② ディープラーニング以外も充実

ニューラルネットワークを使わない、もっとベーシックな機械学習も、「Scholar」とEXGBoostの出現により、Scikit-learnやPython関連の半分くらいは再現できるようになりました

Pandas/Tidyverse(R言語)相当の「Explorer」によって、前処理もより簡単になりました(元々、前処理を含むデータ処理に強いElixirですが)

cv2相当の「Evision」と、pyvips相当の「Image」の恩恵で、画像加工も充実し、やはりPython無しで困らなくなりました

③ ノーコードAI・LLMのLiveView化+スマホ/エッジ移動

別の方面では、Python Mercuryと同様のアプリ化機能である「デプロイ」がLivebookに標準搭載され、ここにAI・LLMすらノーコードで済むパワーが組み合わさると、「ノーコードAI・LLMのLiveViewアプリ化」という恐ろしいカテゴリが生まれる様を、下記3本の動画から感じ取ってください

さらに、ElixirDesktopやNervesとの組み合わせで、「ノーコードAI・LLMのエッジ化」や「ノーコードAI・LLMのエッジ/エッジサーバ/クラウド間移動」という凄まじく厨二病心をくすぐられる概念すら生まれます … ここは今年最後の下記イベントで、その片鱗をお話できたらと思います

④ 強力過ぎるLivebookプラグイン群がヤバい

Livebookのプラグイン群も強力で、代表的なのはグラフ描画を提供する「VegaLite」で、センサーデータのリアルタイム表示などもお手のもので、やはりノーコードで全てが済みます

そして、今年もっとも進化したのは、ChatGPT copilot利用や動画配信、diff表示、シェル実行、果てはLiveViewをLivebook上ですら動かせる「kino」シリーズで、Elixirの凄さが霞んでしまう位(笑)のインパクトでした

⑤ LLMビルドは … まだナイショ

LLM実行自体は、上記通り、既に幾つかのモデルがElixir環境でも動いている一方、LLMのビルド自体は、未だ試していないので何とも言えない(近いうちに考察してみたい)ですが、その実現も思ったより近い未来でしょう

あまり詳しいことは述べられないのが残念ではありますが、Elixir界隈に国家予算級が入ったとか入らないとか ![]()

来年は、このあたりについて公開情報がオープンにされることをお楽しみにッ

もし年末ギリギリに駆け込んできたら、いの一番に私はElixirでLLMをビルドし、コラム化します

⑥ Elixir AI・LLMの実践例が公開されるようになった

下記の動画を始めとする、Elixir AI・LLMの実践例が公開されるようになりました

Nxの初登場から2年弱で、こうした活動が表に出てきたことは、とても喜ばしく思えます

上記以外にも、AxonでのHugging FaceモデルのファインチューニングやNxで構成する決定木、チェス盤面の画像識別など、技術面にフォーカスした動画も今年のElixirConf 2023には沢山あったので、下記からご覧ください

ElixirConf EU 2023でも幾つかAI・LLM関連動画がアップされていたので、こちらも探してみてください

2024年、Elixirで攻略するAI・LLM領域

さて、こうした諸々を踏まえ、いかにElixirがAI・LLM領域で優位性を持っているかを盛大にアピールしようと思っていましたが、もうここまでの内容で120%おなか一杯だと思います(笑)し、察しの良い方であれば、これからのElixirこそがAI・LLMの本丸であることを、もう充分に予感・体感していただけたのでは無いかと思います

なので、上述したキーワード群にElixirの強みをバインドするだけに留め、具体的なアイデアは、別の誌面やイベントLTに預けることとしましょう

| キーワード | 紐付くElixirの強み |

|---|---|

| 分散学習 | Elixir自体が分散のエキスパート+NxのPython級AI・LLM https://qiita.com/piacerex/items/f6a73a8252a3f6093b1a https://qiita.com/piacerex/items/645939c537f24e68f514 |

| データ集約 | Elixir自体がデータ処理のエキスパート https://qiita.com/piacerex/items/a40c5d24190d59f68610 |

| 並行学習 | Elixir自体が並行・並列のエキスパート |

| エッジコンピューティング | クラウド無でも分散可 → エッジコンピューティング特化 https://qiita.com/piacerex/items/5c6db095f4c567c36f69 https://qiita.com/piacerex/items/a3cb9156a7166039a5a2 https://youtu.be/Olr9Kzpqacc?t=2177 サーバ/エッジ(スマホ、IoT)開発はElixirだけで賄える |

| リアルタイム分析AI | ストリーミングデータのリアルタイム処理も得意技 |

| AIを梱包したアプリ開発 | サーバ/エッジとNxはシームレスに統合でき、高性能 |

| AIそのもの | 序盤で書いた通り、プロダクション開発に何の遜色も無い (むしろ有利ですらある) |

| プロダクト提供面 | 性能劣化無く、低保守コストなので、スタートアップ向き 大手の新規事業プロダクトにも適合度は高い |

それと、実は1年前に、今回の軸に沿うAdvent Calendarコラムをすでに書いてたりします

幾らかのアップデート情報はあるものの、未来志向な文脈で書かれているため、1年経った今でも内容は新しく(むしろ新し過ぎて、世間の方が数年単位でぜんぜん追いついていないかも?)、大半はそのままでも充分に通用するかと … こういう面でも、私のAdvent Calendarコラムは「DEATH NOTE」であり、数年先を普通に当てにいってるので、全然「あてずっぽう」で書いていません ![]()

そして、世間を置いてけぼりにする位、もっと先へと歩を進めたくもあり、それは、

「経営や意思決定、果ては『人の育成』のAI化」

です

昨年末に、総務省の依頼を受け、下記スライドで登壇しましたが、企業そのものの姿もITネイティブなものへと変えていけたらいいなぁ … くらいは普通に考えています

これまでも、私はコロナでリモートワークが当たり前となる2年前からフルリモートワークで回るチーム/企業を叶えてきたり、他企業/エンジニアが「アジャイル」を言い出す10年前からeXtreme Programmingに取り組み、エキスパートとして開発と経営を率いてきたし、何ならプログラマがメインストリームになることも40年前から予期していたので、この件も、それらと大差無いものだと捉えています

また、これを下支えするためのプロダクトとして、エンジニア/インフラ/デザイナー/マーケターを高い解像度/深度で評価・採用できることで、PMと人事を支援するSaaSである「Bright」を今年リリースしました(これも昨年Advent Calendarコラムで宣言したので、やはり「DEATH NOTE」ですw)

あなたのBright(輝き)とRight(正しさ)を引き出すプロダクト「Bright」

これまで人材評価や育成は、データ化されてきませんでしたが、それは単にデータ化をサボっていただけ/定式化し切れずにいただけ/現場では当たり前のスキルを「細かいこと」と無知な人が切り捨ててきただけ … と捉え、正しい方向に評価し、データサイエンスし、「職業」や「働き方」そのものをITネイティブにアップデートするのが、Brightの狙いです

当然、生成AIやLLMは、こうしたデータにおける主戦場でもあり、たとえば下記のような機能を叶えます

- 案件情報からチームメンバー候補の自動組成

- メンバーのスキルアップ傾向から最適PJをレコメンド

- 案件獲得の自動化

Brightの今年の体験談と、来年の展望は、下記に別途コラムをまとめています

終わりに

ひさしぶりに「実現する厨二病」としての濃厚なAI・LLMの現在と未来について書きました

書いていて、「アレ?…これ終わらない?…」と何度か感じさせる位、大作になってしまい、イヤ本当は、このボリュームの1/8くらいで済ませるつもりだったんですが …

人は、ワクワクが乗っかると、とんでもない想定外やらかしますね … いやはや恐ろしい ![]()

そうそう、昨年段階の私では、恐らくこのコラムの30%くらいしか書けなかったように思われます

この1年で、ChatGPTはじめとする生成AIを活用したことにより、私自身の思考速度/スケーラビリティも上昇しているんでは無いかと思います

来年は50歳を迎える私(その直前でメイドアバターコスプレに目覚めてしまった私)ですが、むしろ楽しくてエキサイティングな学びやイベントは、これからが「本番」であり、これまでの人生は「リハーサル」に過ぎなかったと実感します