Semantic Kernel (SK) は Microsoft が OSS として発表した、大規模言語モデル (LLM) をアプリにすばやく簡単に統合できる SDK です。SK は従来のプログラミング言語と最新のLLM AI "プロンプト" を簡単に組み合わせることができ、テンプレート化、チェーン化、埋め込みベースのメモリー、およびプランニング機能を備えています。

機能的には、LangChain や LlamaIndex に似たような機能を持っているライブラリです。現状は C# 向けにリリースされています。4/17 に Python 版 もリリースとなりました。ただし機能は部分的な実装である点にご注意ください。(FEATURE MATRIX)

6/23 Semantic Kernel が Copilot stack との連携を明確化しプラグインエコシステムと統合

Semantic Kernel

GPT-3 や ChatGPT でアプリ開発していると、プロンプトという 1 つの入力インターフェースで様々なタスクができてしまうという自由度の高さを感じると思います。最初は問題ないかもしれませんが次第にやることが増えてくると、解決したいタスクごとに関数として分離して、それぞれを既存の関数と同様に扱いたいというニーズが自然と出てきます。このようなニーズに応えるために開発されたのが SK です。

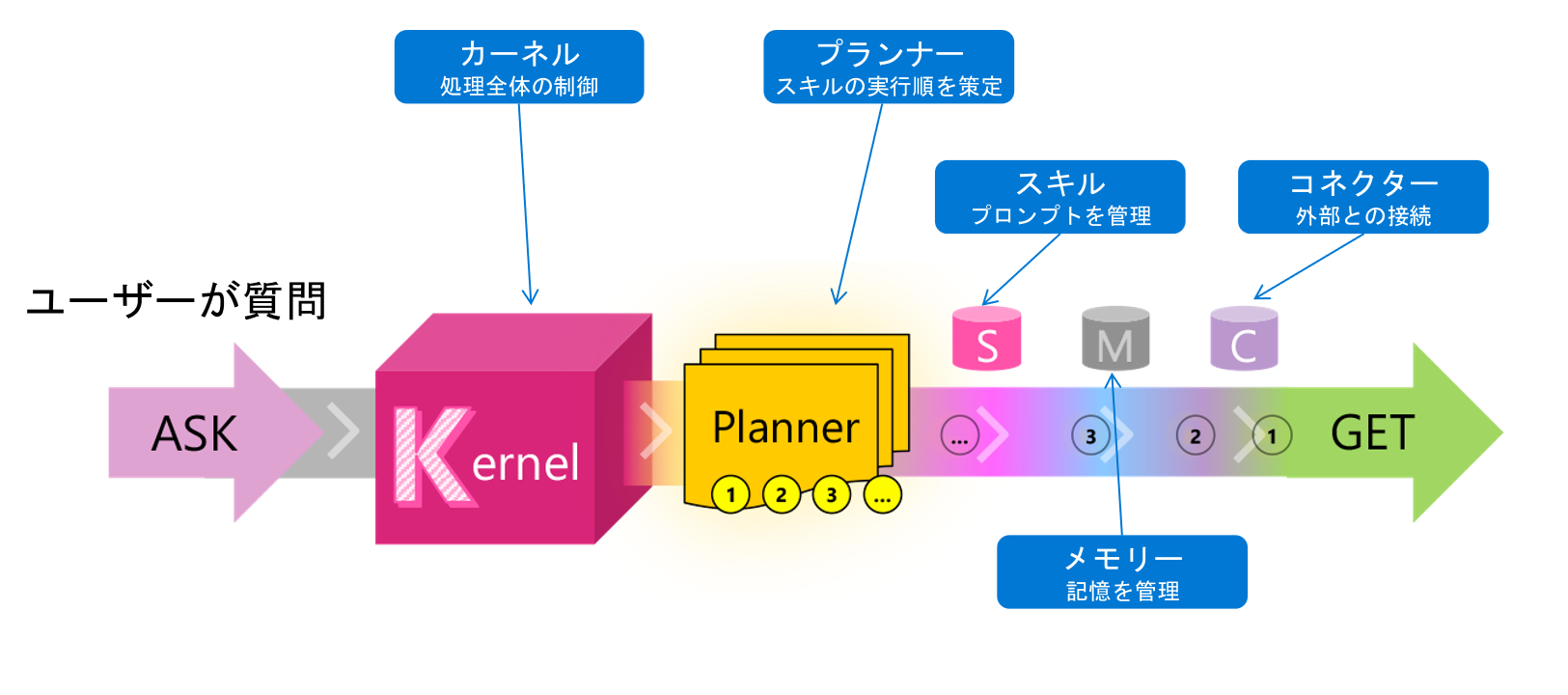

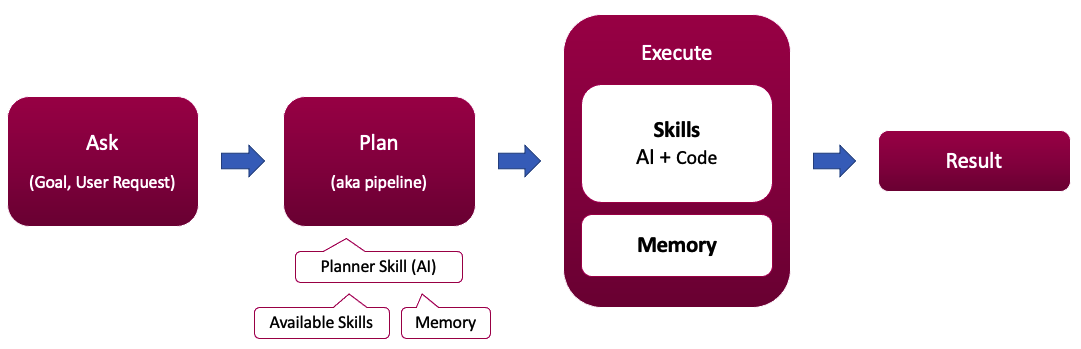

Semantic Kernel (SK) は、次の概念に基づいて構築されています。

| コンセプト | 簡単な説明 |

|---|---|

| カーネル | システムのコアで全体の処理をオーケストレーションします |

| プランナー | 利用可能なスキルに基づいてステップに分割します |

| スキル | LLM AI プロンプトとネイティブ コードから構築されたカスタマイズ可能なリソースです |

| メモリー | コンテキスト情報を保持するカスタマイズ可能なリソースです |

| コネクター | 外部データへのアクセスを可能にするカスタマイズ可能なリソースです |

カーネル

カーネルは全体の処理をオーケストレーションします。そして利用可能なスキル、メモリ、およびコネクタを使用して、ユーザーの質問や目的を達成します。

カーネルは Function composition(関数合成)を促進するように設計されており、ユーザーは複数の関数 (ネイティブおよびセマンティック) を 1 つのパイプラインに結合できます。あぁ…やはりパイプライン… パイプラインがすべてを解決するんや… Azure Cognitive Search も Azure Machine Learning も Azure Synapse も行きつくところはパイプラインなんや… しかもそのパイプラインを LLM AI が自動的に作ってくれたとしたら・・・?

プランナー

プランナーはカーネルに登録されたスキルのコレクションを利用し、AI を用いて、与えられた依頼を実行するための計画を策定します。複数のスキルを実行していくというのは前回の記事で紹介した、LangChain による Read-Retrive-Read や Read-Decompose-Ask のような仕組みに似ているのではと推測していますが、現状サンプルコードなどがまともに動かないため、もう少し調査が必要です。。。

プランナーに使用するスキルを指示

サンプルのスキルセットは、/samples/skills に用意されています。

var skillsDirectory = Path.Combine(System.IO.Directory.GetCurrentDirectory(), "..", "..", "skills");

kernel.ImportSemanticSkillFromDirectory(skillsDirectory, "QASkill");

質問を投げてスキルの実行計画を生成

var ask = "I want to go to Microsoft HQ from Tokyo.";

var originalPlan = await kernel.RunAsync(ask, planner["CreatePlan"]);

実行計画が XML 形式で生成される

AI がどの関数を呼び出すかを決定しています。(要調査)実行計画の各ステップの出力は setContextVariable として設定され、次のスキルの input として利用できるようになります。

Original plan:

<goal>

I want to go to Microsoft HQ from Tokyo.

</goal>

<plan>

<function.QASkill.Question input="Where is Microsoft HQ?" setContextVariable="QUESTION_RESULT"/>

<function.QASkill.QNA input="$QUESTION_RESULT" setContextVariable="QNA_RESULT"/>

<function.QASkill.AssistantResults api="Microsoft" results="$QNA_RESULT" resultsContext="Microsoft HQ" setContextVariable="ASSISTANT_RESULT"/>

<function.QASkill.ContextQuery firstname="John" lastname="Doe" city="Tokyo" state="Tokyo" country="Japan" input="$ASSISTANT_RESULT" setContextVariable="CONTEXT_QUERY_RESULT"/>

<function.QASkill.Form promptName="Microsoft HQ" input="$CONTEXT_QUERY_RESULT" setContextVariable="FORM_RESULT"/>

<function._GLOBAL_FUNCTIONS_.BucketOutputs input="$FORM_RESULT" bucketCount="3" bucketLabelPrefix="Result" />

</plan>

QASkill に含まれている複数のセマンティック関数の実行順と引数が自動的にセットされていることが分かります。これを上から滝のように実行して結果を引き継ぎながら最終的に回答を求めます。

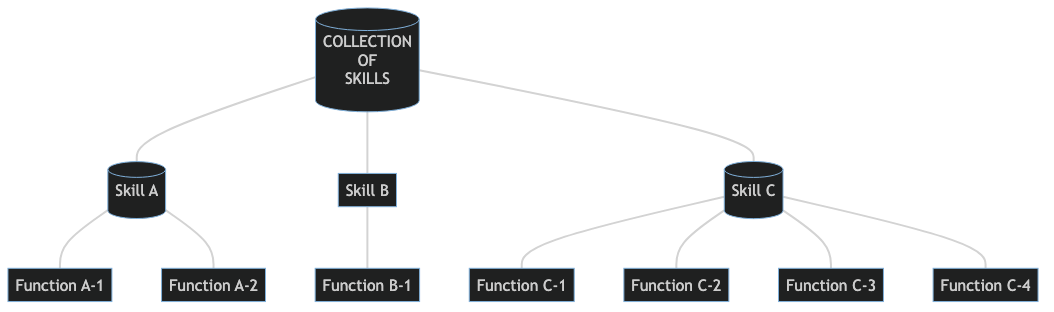

スキル

スキルは細かく分けるとセマンティック関数とネイティブ関数の2種類で構成されており、これらを組み合わせてスキルを構成することができます。

-

セマンティック関数

実体はプロンプトを記載したテキストファイル(skprompt.txt)と Completition API のパラメータを記載した設定ファイル(config.json)です。以下は要約を行うシンプルなセマンティック関数の例で、プロンプト内のコンテキスト変数{{$input}}へデータを渡すことができます。コンテキスト変数はカスタムできます。sk_prompt = """ {{$input}} 上記の内容を3つのポイントに要約してください。 """ -

ネイティブ関数

既存の開発言語で記述されたコード。セマンティック関数と組み合わせてハイブリッド開発ができる。

関数はチェーンのように連鎖させることができ、より高度なプロンプトパイプラインを内包するスキルを構築することが可能です。要約スキルや分類スキル、質問応答スキルなどのタスクに分割して定義して管理することで、開発者はスキルの再利用が可能になり、可読性、再現性など MLOps 的なベネフィットも得られることでしょう。

メモリー

Azure OpenAI Service の Completion API はステートレスであり、基本的に情報が保持されません。ChatGPT のようにコンテキストにチャット履歴を残していくタイプの開発では、トークン制限以内になるように過去の情報を忘却する必要があります。この課題に対処するには "記憶" をどこかに持つ必要があります。SK はこれをメモリーという機能を使って 3 種類の方法で保持することが可能です。

- Key-Value ペアによる Lookup

- ローカル ストレージへ保存しファイル名でアクセス

- セマンティック メモリ検索:テキストを Embeddings というベクトルに変換し、セマンティック検索を行います。

例えばあるユーザーの過去の会話履歴を一時的なインメモリストレージであるVolatileMemoryStore(短期記憶)にセットすると、以下のようにコンテキストに過去の対話履歴やユーザーの属性を挿入することが簡単にできるようになります。もちろん外部のデータソースを用意し、長期記憶として履歴を永続化することも可能になります。

sk_prompt = """

このチャットボットは、どんな話題でもあなたと会話することができます。

以前の会話から得られた、私に関する情報:

- {{$fact1}} {{recall $fact1}}

- {{$fact2}} {{recall $fact2}}

Chat:

{{$chat_history}}

User: {{$human_input}}

ChatBot: """

TextMemorySkill がユーザーからの質問をメモリー内からセマンティック検索し、類似度の高い回答をコンテキスト変数に代入します。その後、LLM が情報を統合して回答します。

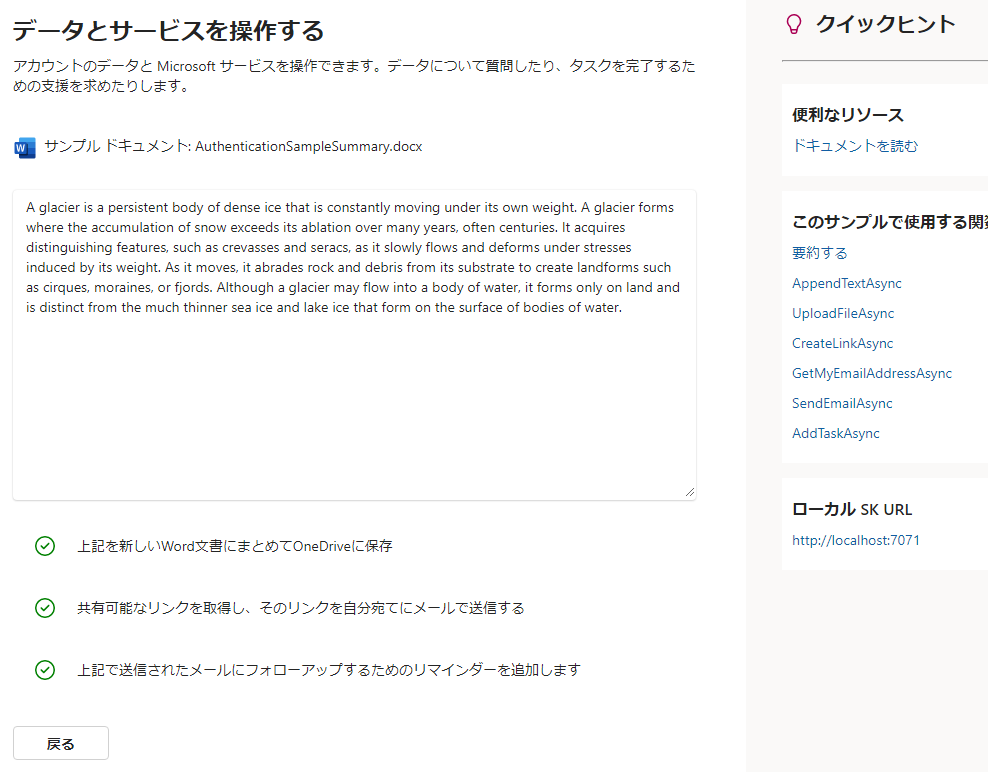

コネクター

コネクターを使用すると、スキルの外にある外部 API など、あらゆるものにアクセスできます。これによって無限の可能性を持った LLM AI アプリケーションが開発できます。例えば MS Graph コネクタ キットを使うとメールを送ったり、OneDrive にファイルを追加したり、カレンダーにイベントを追加したりできます。

現在ビルトインされているコネクターは以下のようなものがあります。

- Skills.Document: OpenXML ストリームの読み取り

- Skills.Memory.Sqlite: SQLite をメモリーとして利用

- Skills.MsGraph:

- MicrosoftToDoConnector

- OneDriveConnector

- OrganizationHierarchyConnector

- OutlookCalendarConnector

- OutlookMailConnector

- Skills.Web

- BingConnector: Bing 検索クエリを発行

今後ベクトルデータベースとの接続を行うようなコネクターも出てくることが予想されます。

GPT-3 によるドキュメント解析結果を MS Graph を使って各サービスと連携する例。

Semantic Kernel について学ぶ

Semantic Kernel 日本語解説

おわりに

先日 ChatGPT × Azure Cognitive Search を使ったエンタープライズサーチの記事を書きましたが、こちらのコードも SK を使って高度化できるような気がしました。。。が全然時間が無く、技術の進化に追いついてない状況です。