導入

huggingface/transformersが便利すぎるので、この波に乗ってAttentionで注目ワードを可視化できないかと思い検討したもの。

可視化方法

BERTの可視化方法は様々公開されている様子。

- 自然言語処理で使われるAttentionのWeightを可視化する - INOUE-KOBO.COM

- [Python - BERTの学習で用いられるattentionの可視化](teratail https://teratail.com/questions/217728)

- BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

- 汎用言語表現モデルBERTの内部動作を解明してみる

- A Visual Guide to Using BERT for the First Time – Jay Alammar – Visualizing machine learning one concept at a time

- ・・・

結局huggingface/transformersを流用可能という以下のライブラリを使ってColab上で可視化してみることに。

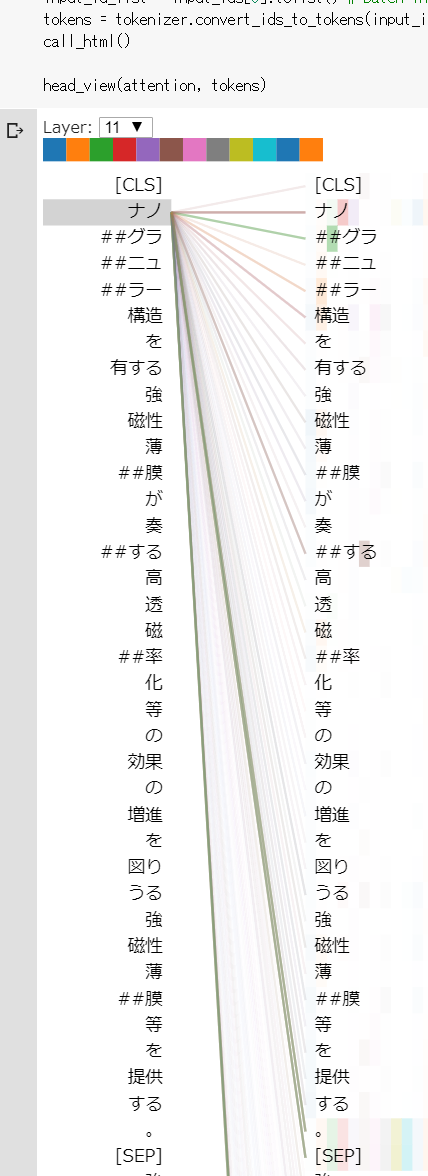

BertViz

BertViz is a tool for visualizing attention in the Transformer model, supporting all models from the transformers library (BERT, GPT-2, XLNet, RoBERTa, XLM, CTRL, etc.). It extends the Tensor2Tensor visualization tool by Llion Jones and the transformers library from HuggingFace.

公式には以下の3つ可視化の種類が書かれている。

| ビュー | 説明 | G翻訳! |

|---|---|---|

| Attention-head view | The attention-head view visualizes the attention patterns produced by one or more attention heads in a given transformer layer. | 特定のトランスフォーマレイヤーの1つ以上のアテンションヘッドによって生成されたアテンションパターンを視覚化します。 |

| Model view | The model view provides a birds-eye view of attention across all of the model’s layers and heads. | モデルのすべてのレイヤーと頭全体の注意の鳥瞰図を提供します。 |

| Neuron view | The neuron view visualizes the individual neurons in the query and key vectors and shows how they are used to compute attention. | クエリおよびキーベクトル内の個々のニューロンを視覚化し、それらを使用して注意を計算する方法を示します。 |

使い方

githubに載っているColabでのスクリプトをほぼそのまま。

ただし、日本語を扱うので下記の部分を変更。

- MeCabをインストールしとく。

- 日本語BERTに対応するため、

from transformers import BertTokenizer, AutoTokenizer,BertModel

のように「AutoTokenizer」を追加。

- 上記に対応して、

tokenizer = BertTokenizer.from_pretrained(model_version, do_lower_case=do_lower_case)

を

tokenizer = AutoTokenizer.from_pretrained(model_version)

に変更。

その他は下記のnotebook参照(上記変更以外は公式と同じ)。

長文だと重いのと、キーワードの切り方がなんか嫌なのと、解釈を勉強しないといけないと思う。

しかし、特許調査時のスクリーニングなどに応用できれば、膨大な文章のどこから読めばわからないような孤独な調査業務も、

今回のライブラリが「ココ見てここ!」のような感じで指摘してくれるので、心安らぐ(かも)。

Attentionを疑う論文や記事もちらほら見たことがあるけれど、それでも使えるかのか試してみたい。

参照

公式:BertViz

論文:A Multiscale Visualization of Attention in the Transformer Model

日本語での記事あった:BERTメモ(BertViz)その1 - ichou1のブログ