はじめに

こんにちは。jiangと申します。

皆さん、Azure Machine LearningにAzure NetApp Files をマウントできること知っておられますか?

既にAzure Machine Learningを使って、ML/DLワークロードに興味があって利用している方も多いと思いますが、もっと高性能なストレージを利用したいと思っている方も多くいらっしゃるかと想像しています。

今回は、意外に知られていない、Azure Machine LearningにAzure NetApp Files をマウントして、最適なML/DL基盤を構築できることをお伝えします。

どうぞ、宜しくお願いします!

Azure Machine Learning (Azure ML) とは

Azure Machine Learning (以下 Azure ML)とはAzureのサービスの一つで、Azureで機械学習モデルを構築、運用できるプラットフォームです。

Azure上でノートブック(Python)を用いたモデル構築だけでなく、データを投入するだけで自動的に最適なモデル・パラメータ探索を行ってくれるAutoMLやGUIベースでパイプラインを構築できるデザイナー機能もあり、幅広いユーザにとって活用場面のあるサービスです。

Azure NetApp Files (ANF) とは

Azure NetApp Files (以下 ANF)とはAzureのフルマネージドのPaaS型ストレージサービスです。

設定と管理は、Azureコンソールに統合されており、Azureネイティブサービスとして提供されています。またONTAP(NetApp社のストレージ専用OS)ならではの、大容量ファイルの格納性、アクセス高速性、SnapshotやSnapRestore,Cloneを利用したデータ保護性においてそれぞれ優位性があります。

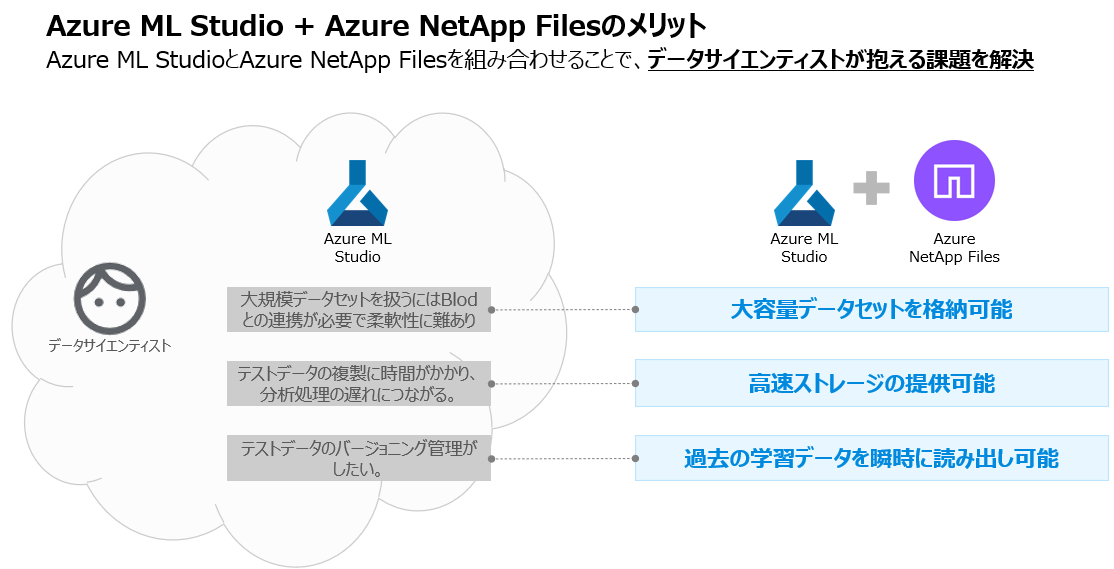

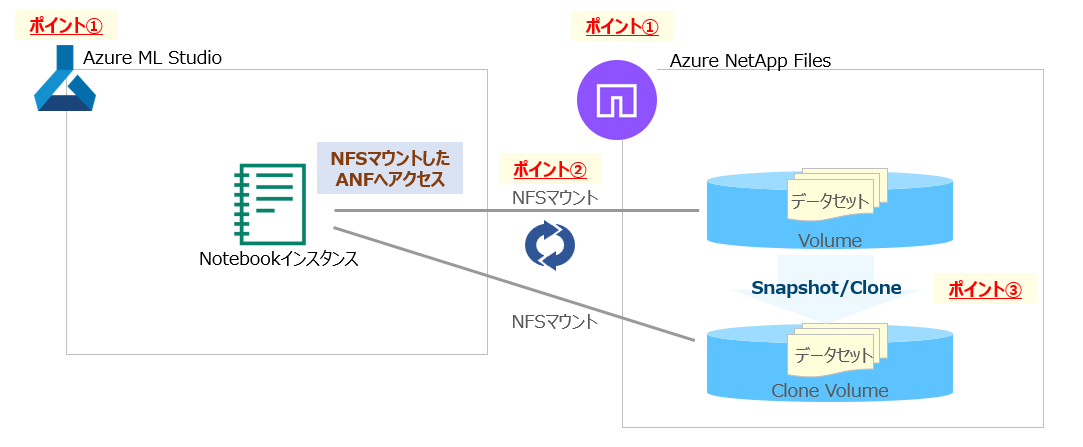

Azure MLとANFを組み合わせると何がうれしいのか?

- Azure MLのノートブックインスタンスにANFのNFSボリュームをマウントすることで、大容量のデータセットに対応できます。

- 高速なストレージアクセスを提供することでAIの分析処理に必要な時間を短縮できます。

- SnapshotおよびClone技術により、データセットのコピー操作やバージョン管理が容易になります。

まとめますと、データサイエンティストが課題や悩みを解決できる、より便利で効率的な機械学習基盤を利用することができます。(以下は、イメージ図です)

やってみた(概要説明)

以下内容をやってみました!

①. Azure MLおよびANFの作成および環境構築を実施

②. ANFをAzure ML StudioのNotebookインスタンスにマウントし、高速、大容量のストレージ環境を提供

③. ANFのSnapshot/Clone機能でデータセットの複製やSnapshotによるバージョニングを可能に

作業準備

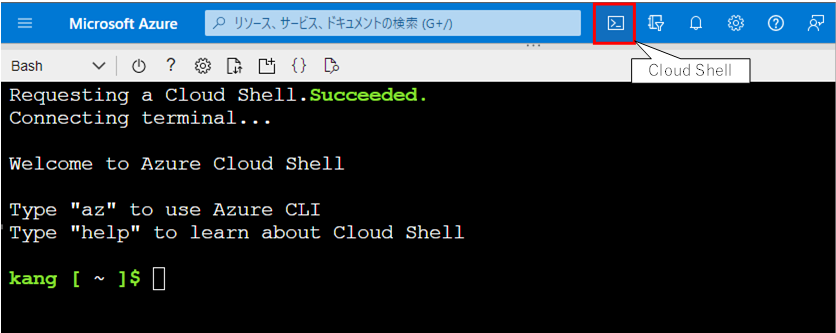

GUIからも構築可能ですが、作業効率化の観点から、今回はなるべくCloud Shellを使って進めたいと思います。

実際の出力画面を記載しておりますが、スペースの都合上、一部省力をしております。またコマンド内容も皆様の環境におきまして、必要な部分はご調整をいただければと思いますので、予めご留意いただけると幸いです。

Azure クラウド シェルと拡張機能

-

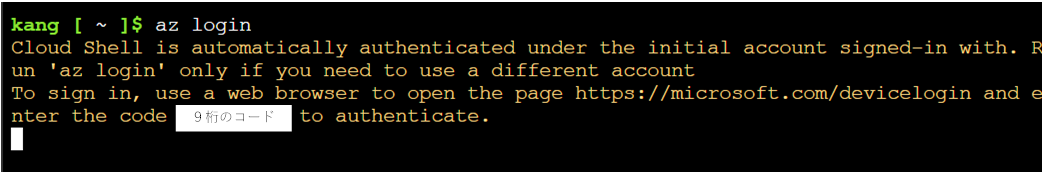

サインインするには、Web ブラウザーを使用してページ https://microsoft.com/devicelogin を開き、コード「セキュアコード」を入力して認証します。

-

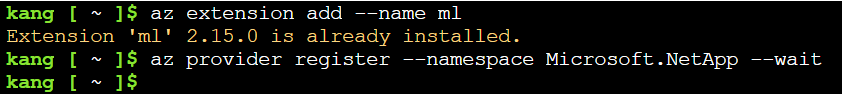

Cloud Shell から ANF と Azure ML をプロビジョニングするには、次の CLI 拡張機能をインストールする必要があります。

コマンド: az extension add --name ml

コマンド: az provider register --namespace Microsoft.NetApp --wait

変数設定

構築に必要となる設定変数を以下のように定義します。

皆様の環境で構築される際は、設定値をご調整ください。

# リソース グループ名

rg='aml-anf-test'

location='japaneast'

# VNET

vnet_name='vnet'

vnet_address_range='10.16.0.0/16'

vnet_aml_subnet='10.0.1.0/24'

vnet_anf_subnet='10.0.2.0 /24'

# AML

workspace_name='aml-anf'

# ANF

anf_name=anf

pool_name=pool1

①. Azure MLおよびANFの作成および環境構築を実施

サービスのプロビジョニング

-

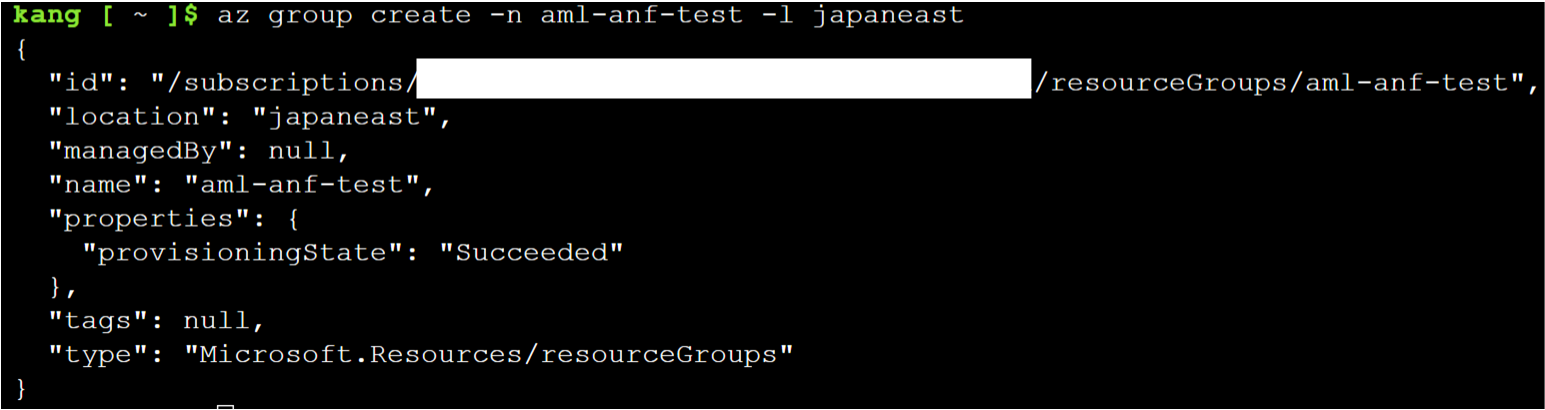

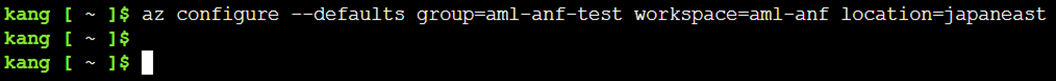

変数を決定したら、必要なサービスとネットワークをプロビジョニングする必要があります。まず、リソース グループを作成し、作業環境の既定値を定義します。

コマンド: az group create -n (リソースグループ名) -l (ロケーション名)

-

デフォルトのリソースグループ、ワークスペース、ロケーションを設定します。

コマンド:az configure --defaults group=(リソースグループ名) workspace=(ワークスペース名) location=(ロケーション名)

-

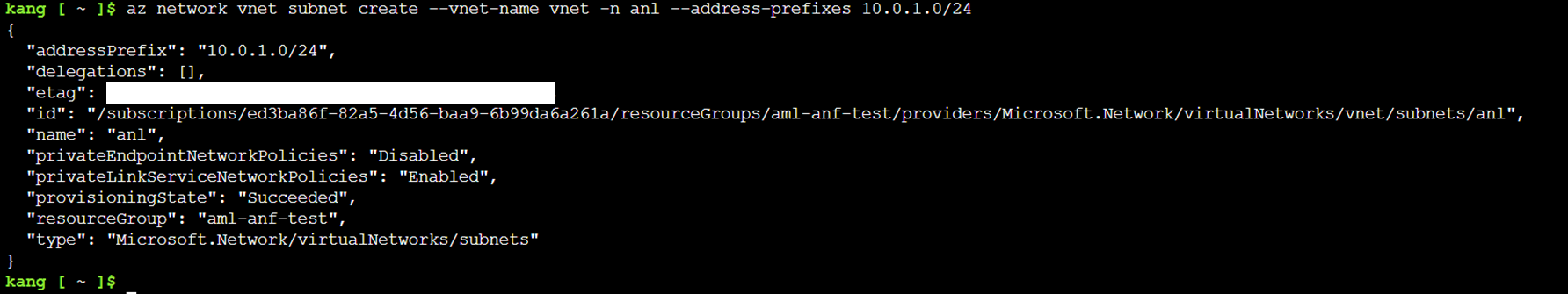

続いて、VNet とサブネットを作成します。

コマンド:az network vnet create -n (vnet名) --address-prefix (対象のネットワークアドレス)

コマンド:az network vnet subnet create --vnet-name (vnet名) -n (AMLサブネット名)--address-prefixes (対象のネットワークアドレス)

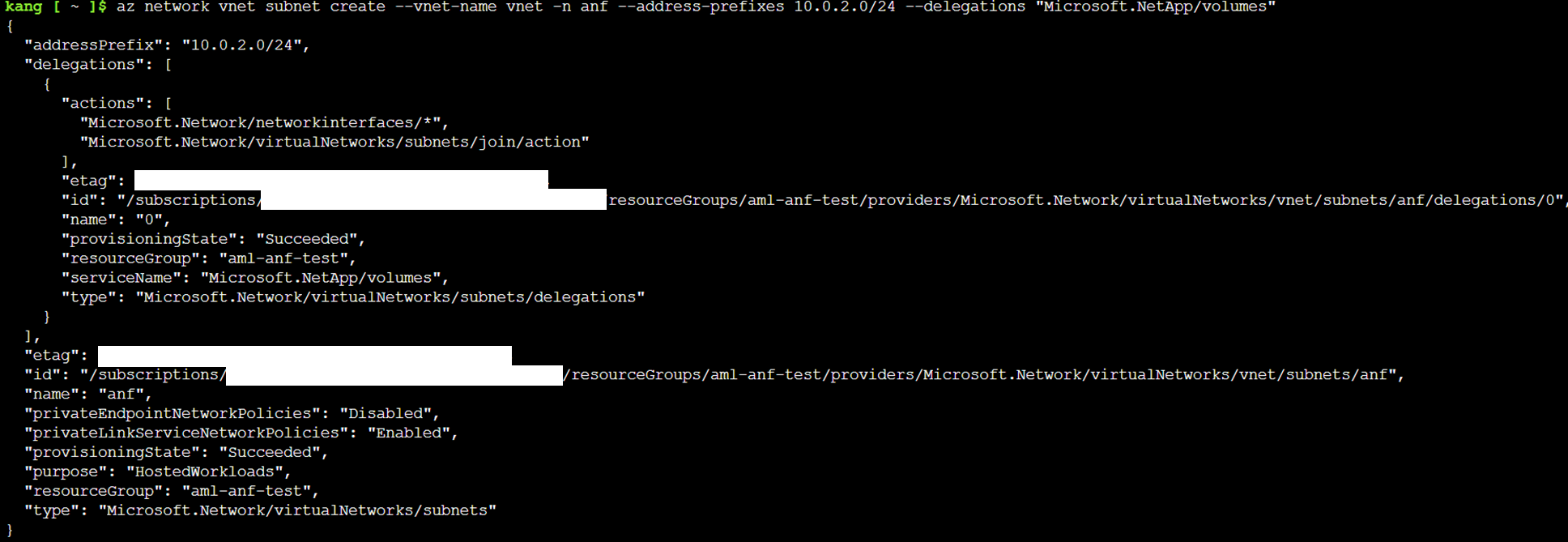

コマンド:az network vnet subnet create --vnet-name (vnet名) -n (ANFサブネット名) --address-prefixes (対象のネットワークアドレス) --delegations "Microsoft.NetApp/volumes"

Azure NetApp Files サブネットは、Azure Machine Learning スタジオ サブネットとは別にする必要があり、Azure NetApp Files に明示的に委任(delegations)する必要があります。

-

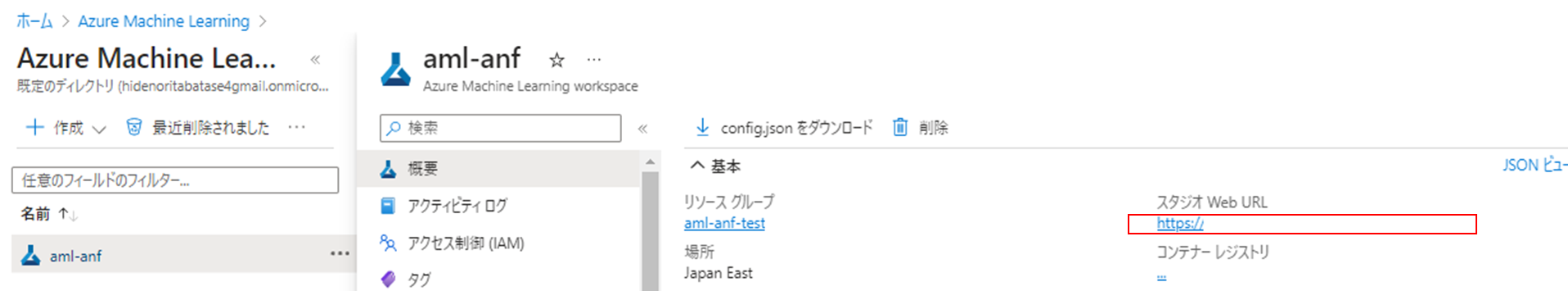

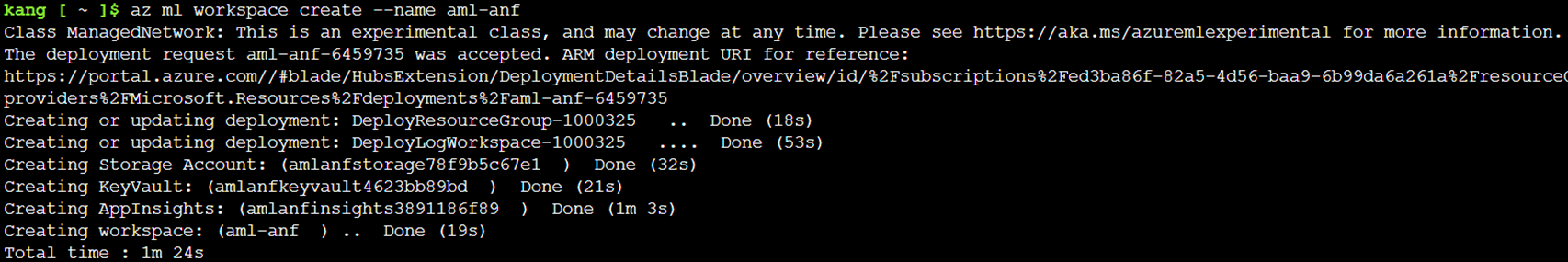

次に、Azure Machine Learning ワークスペースをプロビジョニングします。

コマンド:az ml workspace create --name (ワークスペース名)

-

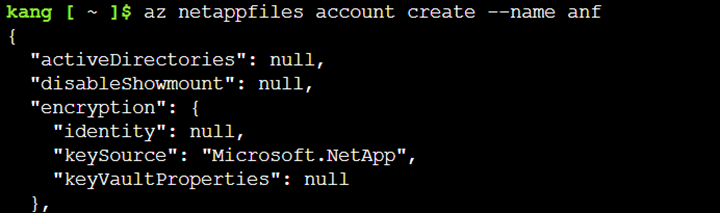

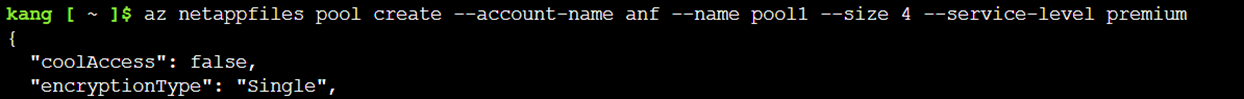

ANF アカウント、容量プール、およびボリュームをそれぞれ作成します。

(ANFアカウント)

コマンド:az netappfiles account create --name (anfアカウント名)

(容量プール)

コマンド:az netappfiles pool create --account-name (anfアカウント名) --name (プール名) --size 4 --service-level standard

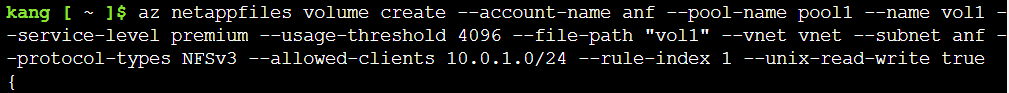

(ボリューム)

コマンド:az netappfiles volume create --account-name (anf名) --pool-name (pool名) --name vol1 --service-level standard --usage-threshold 4096 --file-path "vol1" --vnet (vnet名) --subnet (anfdサブネット名) --protocol-types NFSv3 --allowed-clients (amlサブネットアドレス) --rule-index 1 --unix-read-write true

本例では、サイズを4TiB、サービスレベルをStandardとして、選択していますが、適切なサービスレベルに応じてご選択をお願いします。

②. ANFをAzure ML StudioのNotebookインスタンスにマウントし、高速、大容量のストレージ環境を提供

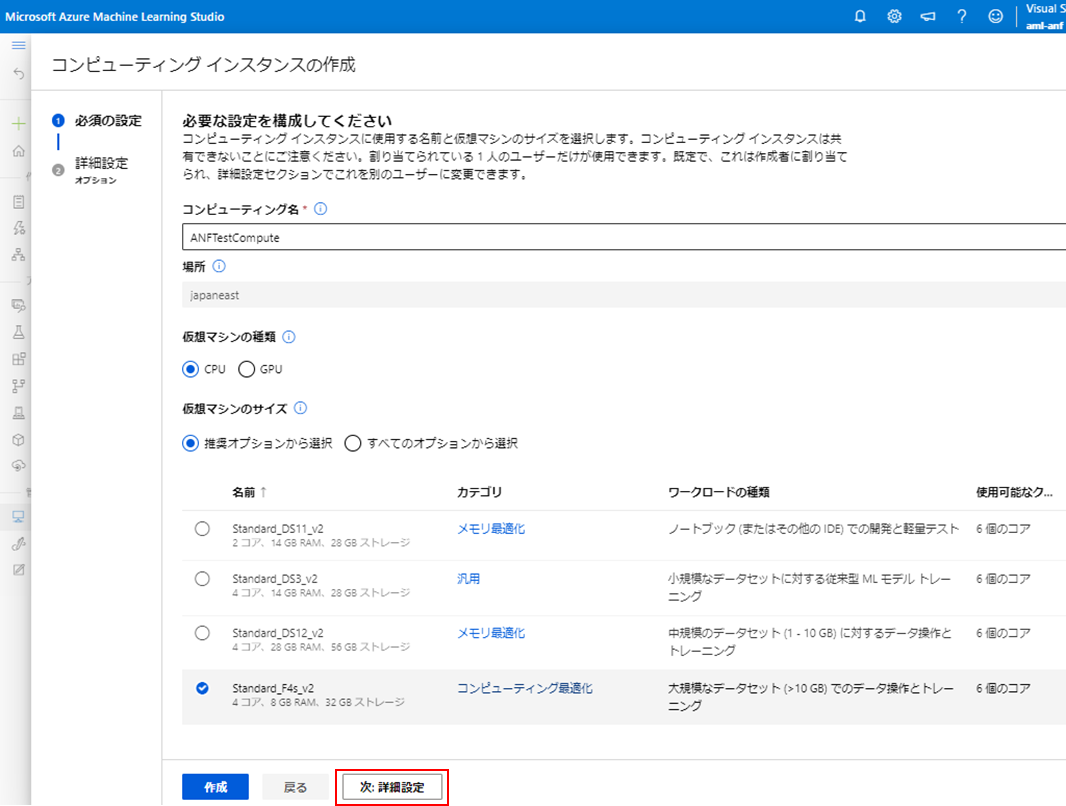

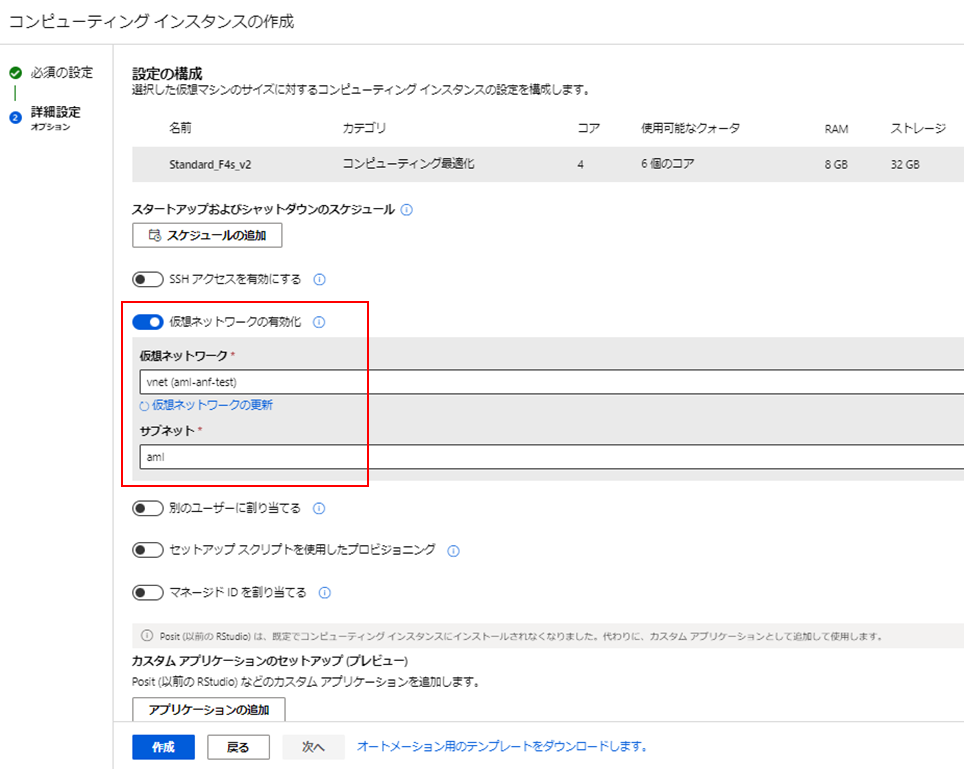

[コンピューティング インスタンス]、[+ 新規] を選択します 。

コンピューティング インスタンスに任意の名前を付けます。この記事ではこれを「ANFTestCompute」と呼び、仮想マシンのサイズを選択します。このデモでは、最も安価なインスタンスで十分です。

「作成」はまだクリックせず、「次へ: 詳細設定」を選択します!!

「詳細設定」タブで、「仮想ネットワークを有効にする」を有効にし、先ほど作成した VNet を選択します。記事に従った場合、VNet は「vnet (aml-anf-test)」、サブネット「aml」を選択する。

コンピューティング インスタンスのプロビジョニングには数分かかります。インスタンスの「状態」が「実行中」に切り替わるまで待ちます。

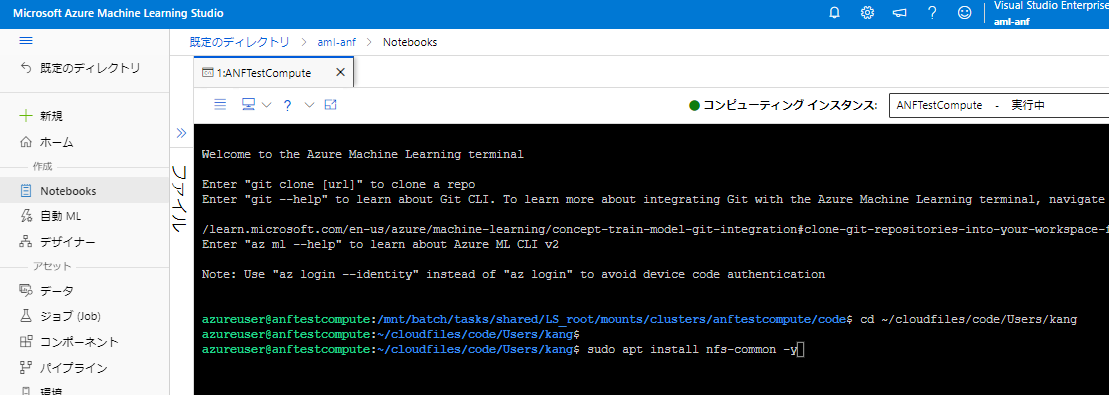

- コンピュート インスタンスのANFマウント

最初に「アプリケーション」の下の「コンピュートインスタンス」タブで、「ターミナル」をクリックしてコンピュートインスタンスに接続して、nfs-common をインストールする必要があります。

コマンド:sudo apt install nfs-common -y

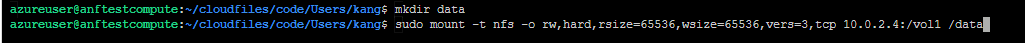

新しいフォルダを作成し、Azure NetApp Files ボリュームをマウントします。

コマンド:mkdir data

コマンド:sudo mount -t nfs -o rw,hard,rsize=65536,wsize=65536,vers=3,tcp (パス名:本例では10.0.2.4:/vol1) /data

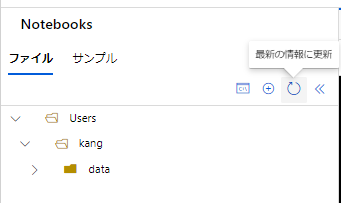

左側に「データ」フォルダがまだ表示されていない場合は、「更新」ボタンをクリックしてください。

- Notebook からANFにアクセスする

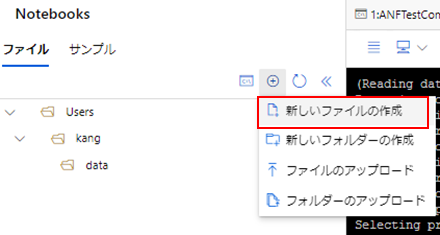

新しい Jupyter/Azure Machine Learning スタジオ ノートブックを作成します。左側の「プラスボタン」をクリックして、[新規ファイルを作成」を選択します。

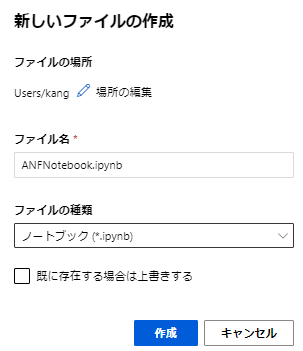

このドキュメントでは、ノートブックを「ANFNotebook」として、「作成」をクリックします。

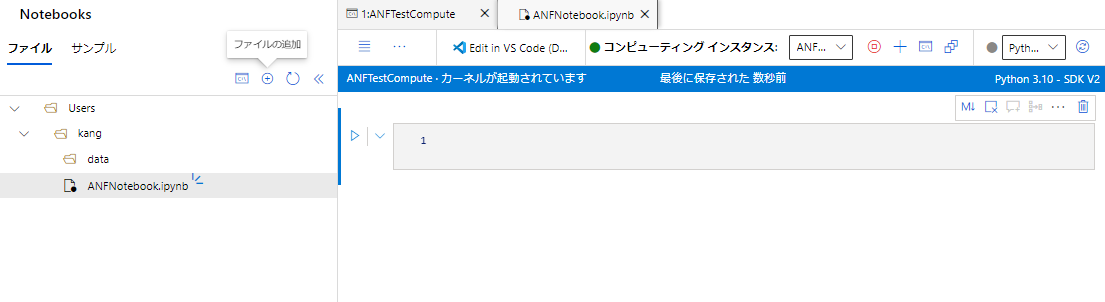

Notebook から ANFボリューム上のファイルにアクセスし、それに基づいてモデルを構築できるようになります。

③. ANFのSnapshot/Clone機能でデータセットの複製やSnapshotによるバージョニングを可能に

スナップショットは、データ サイエンス タスクにとって貴重なツールです。

NetApp DataOps Toolkit は、残念ながら現時点でANFをサポートしていません。

本構成でスナップショットを利用する場合は、以下の方法が可能です。

- GUIを使用

- Azure Cloud Shellを使用

- REST APIを使用

- Pythonを使用

この記事では、2.のAzure Cloud Shell を使用してスナップショットを作成および復元します。

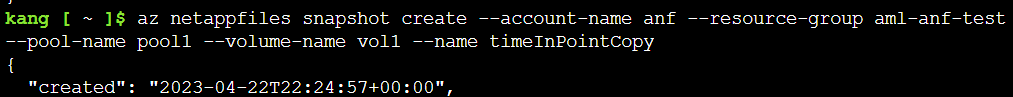

- Azure Cloud Shell を使用してスナップショットを作成する

コマンド:az netappfiles snapshot create --account-name (anfアカウント名) --resource-group (リソースグループ名)--pool-name (プール名) --volume-name (ボリューム名)--name (スナップショットボリューム名)

このコマンドでは、NetApp アカウント名、リソース グループ、容量プール名、スナップショットを作成するボリュームの名前、およびスナップショットの名前を指定する必要があります

Azureコンソールからも取得できていることを確認できます。

- Azure Cloud Shell を使用したスナップショットのリストア

スナップショットを復元する場合、次の 3 つのオプションがあります。

- スナップショットからボリュームを戻す

- スナップショットを新しいボリュームに復元する

- スナップショットからの単一ファイルの復元

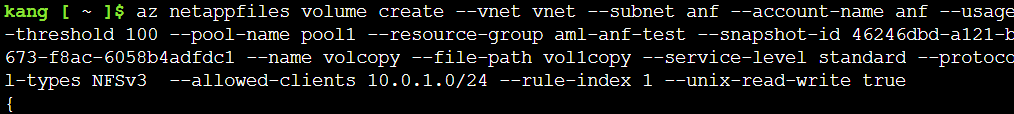

この例では、2 番目のオプションを選択します。これは、選択したスナップショットに基づいて新しい名前の新しいボリュームが作成され、ボリュームデータがこのボリュームに自動的に復元されることを意味します。

コマンド:az netappfiles volume create --vnet (vnet名) --subnet (サブネット名)--account-name (anfアカウント名) --usage-threshold 100 --pool-name (プール名) --resource-group (リソースグループ名) --snapshot-id (snapshot作成時に表示されたID) --name (新しいボリューム名) --file-path vol(ファイルパス) --service-level (サービスレベル)--protocol-types NFSv3 --allowed-clients (対象ネットワークアドレス)--rule-index 1 --unix-read-write true

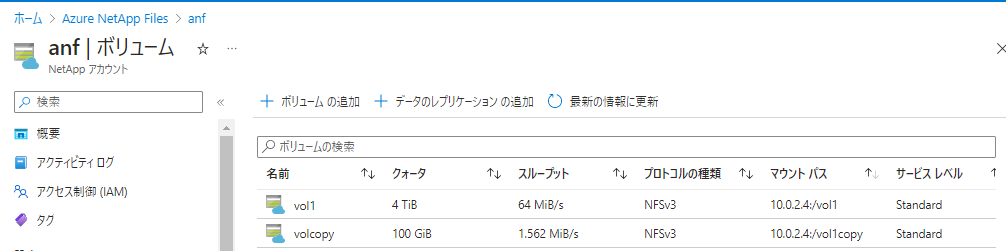

Azureコンソールからも取得できていることを確認できます。

まとめ

この記事では、高アクセス性、高機能なANFをAzure MLで使用する方法について、ご説明しました。Azure MLの機能性向上に貢献できるソリューションになりますので、是非積極的にご利用をご検討ください。

今後もAzure ML on ANF を利用したAI/ML ワークロードをご紹介でれきばと考えております。

最後まで、読んでいただき、ありがとうございました!!

ご紹介(AWS SageMaker on AWS)

本記事では、AzureML on ANFのご紹介でしたが、AWSでも同様にAI/MLサービスとNetAppストレージサービスの組み合わせソリューションがございますので、以下にてご紹介させていただきます。

こちらも是非、ご参照いただければ幸いです。

- Amazon SageMakerとAmazon FSx for NetApp ONTAPで実現する機械学習基盤 第1回

- Amazon SageMakerとAmazon FSx for NetApp ONTAPで実現する機械学習基盤 第2回

- Amazon SageMakerとAmazon FSx for NetApp ONTAPで実現する機械学習基盤 第3回

- Amazon SageMakerとAmazon FSx for NetApp ONTAPで実現する機械学習基盤 第4回