はじめに

2019/4/12に公開されたMediumの記事 ![]() 「Explaining AI Model Behaviour with IBM Watson OpenScale」の翻訳です。

「Explaining AI Model Behaviour with IBM Watson OpenScale」の翻訳です。

最近話題の「説明可能なAI(XAI)」の実装例としてWOSの提供している機能をシンプルに説明していますので、自分なりに翻訳しました。(翻訳作業については著者了承済み)

IBM Watson OpenScaleを使用したAIモデルの振る舞いの説明(Explain)

April 12, 2019 by Manish Bhide

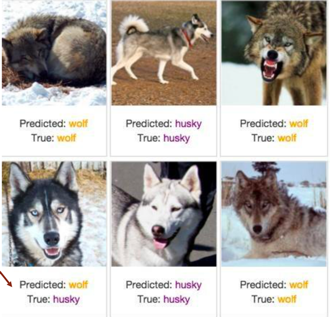

与えられた画像がオオカミかシベリアン・ハスキーかを判定するモデルをデータサイエンティストが作ったとしましょう。下のイメージで見るに、モデルは明らかに素晴らしい結果をもたらしているように見えます。

上のイメージでは、モデルが誤ったのは左下の画像に対してのみです。そこでデータサイエンティストはそのモデルが優れていると考え、本番環境に反映しようと考えました。しかしモデルの訓練データのすべてのオオカミ画像の背景には雪があり、すべてのハスキー画像の背景には雪がなかったかもしれません。その場合、モデルは背景に雪があるならば、オオカミであることを学習したのでしょう。雪が無ければハスキーです! →これではどうみても素晴らしいモデルとは言えませんね。。。

IBM Watson OpenScaleは、AIモデルに関するこのような問題があるかどうかの識別に役立ちます。この例では、予測に寄与した画像の部分を強調表示します。そのため、左下の画像では、雪が強調表示され、画像がオオカミだと予測するモデルにおいて雪が存在することが大きな役割を果たしていたことを示します。

AIの採用における最大の障害の1つは、透明性の欠如、またはAIモデルのブラックボックス的な性質です(上記の例で明らかですね)。そのため、ビジネス・オーナーはAIモデルを本番に展開することに懐疑的です。 IBM Watson OpenScaleは、2種類の説明を提供することによって、この問題に対処します。

- LIMEベースの説明:LIMEアルゴリズムを使用して、予測に肯定的または否定的に寄与した特徴量(フィーチャー)のリストを見つけます(詳細は後述)。

- **対照的な(Contrastive)**説明:これはIBM リサーチの独自テクノロジーで、説明が必要なデータポイントの近傍でのモデルの振る舞いを説明します。

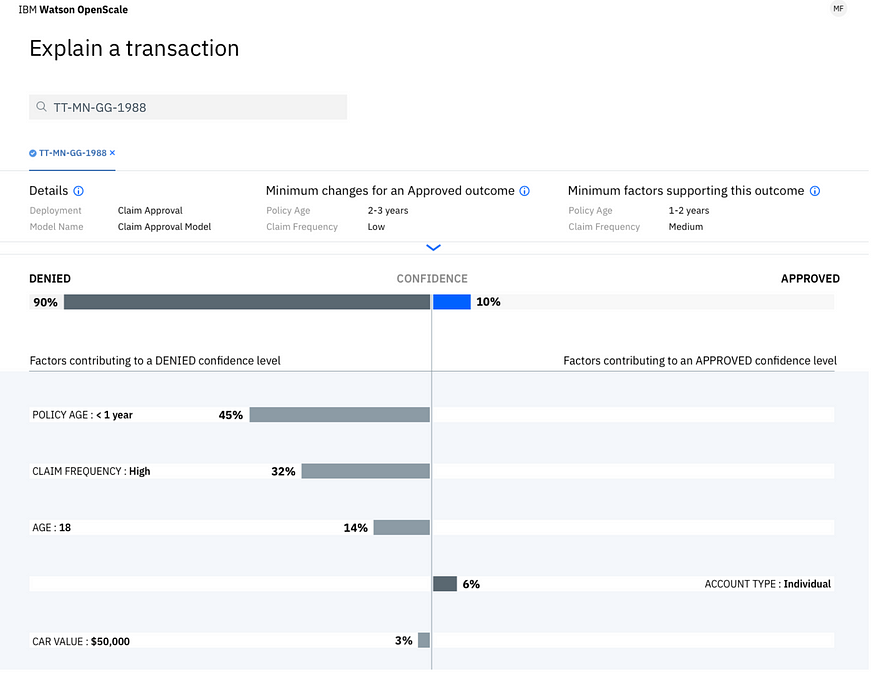

これらの概念を、もっと理解するために、保険業界での例を考えてみましょう。保険金請求を承認するか拒否するかを決定するモデルを考えてみます。モデルによって却下された保険金請求の説明を生成するようにIBM Watson OpenScaleにリクエストすると、以下のような説明が得られます。

2:

2:

まずLIMEベースの説明を示す画面の下半分に注目しましょう。この場合には保険契約の年齢が1年未満で保険金請求の頻度が多く、年齢が18歳であるために請求が却下された、という説明がなされています。これらは、保険金請求を却下すべきだと判断する場合のトップ3の要因です。ただし顧客のタイプが「個人」であるという事実は、請求が承認されるべきと判断する方向に貢献しています。 - したがって、予測に対する信頼度は100%ではありませんでした。このようにLIMEベースの説明では、予測にプラス方向にもマイナス方向にも寄与する一連の特徴量(フィーチャー)を示します。

次に、画面の上部の対照的な説明(Constractive Explanations)に注目しましょう。一つ目の部分は要求が承認されるための最低限の変更点(Minimum changes for approved outcome)を示しています。これは、モデルの予測が「拒否」から「承認」に変わるための、特徴量の最小の変化です。言い換えれば、「保険への加入から2〜3年」で、「請求頻度」が「低(Low)」なら、モデルの予測は「承認」になるはずだということを示しています。対照的な説明(Constractive Explanations)の残りの部分は、それが予測結果に何の変化ももたらさないであろう特徴量の最大の変更点(Minimum Factors supporting this outcome)を示します。この例では、「保険への加入から1〜2年」で、「請求の頻度」が「中(Medium)」なら、モデルの予測は相変わらず「拒否」のままであることがわかります。このように対照的な説明(Constractive Explanations)では説明を生成しているデータポイントの近傍・付近で判断に重要な役割を果たす特徴量(フィーチャー)を示してくれるので、ビジネスユーザーがモデルの判定を信用できるようになります。

要約すると、IBM Watson OpenScaleは、ビジネスユーザーがAIに対する信頼を築き、ブラックボックスAIモデルのボックス化を解き放つ(unbox)のに役立つLIMEベースおよび対照的な説明(Constractive Explanations)を提供します。

記事はここまで↑

ご参考

記事翻訳のみならず、過去、自分でもWatson OpenScaleをご紹介した記事をQiitaに書いておりますので、ご興味あればご高覧ください。

![]() 「AIへの信頼」や「説明可能なAI」に絡み、一部で話題の「IBM Watson OpenScale」をザクッとご紹介します

「AIへの信頼」や「説明可能なAI」に絡み、一部で話題の「IBM Watson OpenScale」をザクッとご紹介します

![]() Watson OpenScaleをもう少し「キチッ」とご紹介します(A.K.A.「麗しき誤解」を解く)

Watson OpenScaleをもう少し「キチッ」とご紹介します(A.K.A.「麗しき誤解」を解く)

![]() Watson OpenScaleを触る前に知っておきたかったこと(技術Tipsなど)

Watson OpenScaleを触る前に知っておきたかったこと(技術Tipsなど)

以上です。