概要

Azureでデータ活用をテーマにデータ蓄積やデータのETL処理等に取り組んでいるわけですが、

これらの対応を簡単に実行する為に、Azure Data Factoryを利用します。

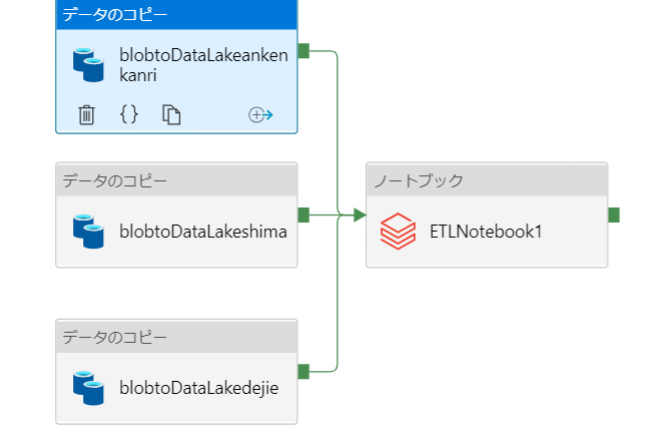

パイプライン図

①データのコピー

→blob storage(rawデータの受け口)からAzure DataLake Gen2にデータコピー

②ノートブック

→Azure DataLake Gen2に蓄積したrawデータをETL処理

Azure Data Factoryのパイプライン構築

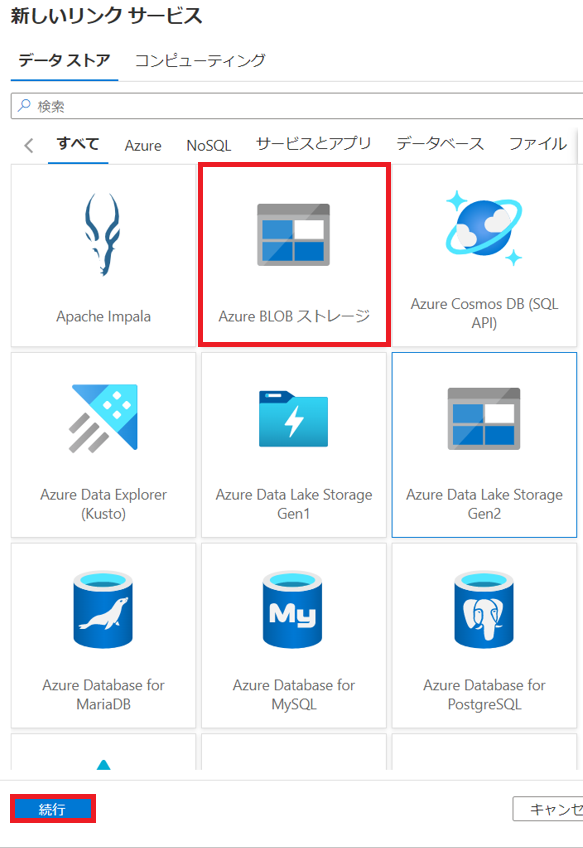

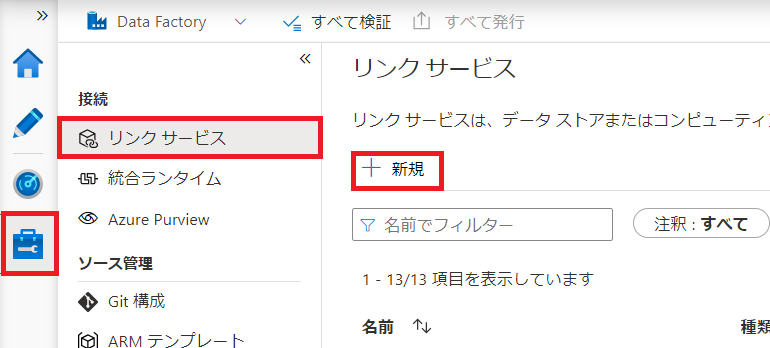

リンクサービスの作成

※この後、作成するソースデータセット、シンクデータセット分のリンクサービスを作成

[管理]アイコンから[リンクサービス]を選択し、[新規]をクリック

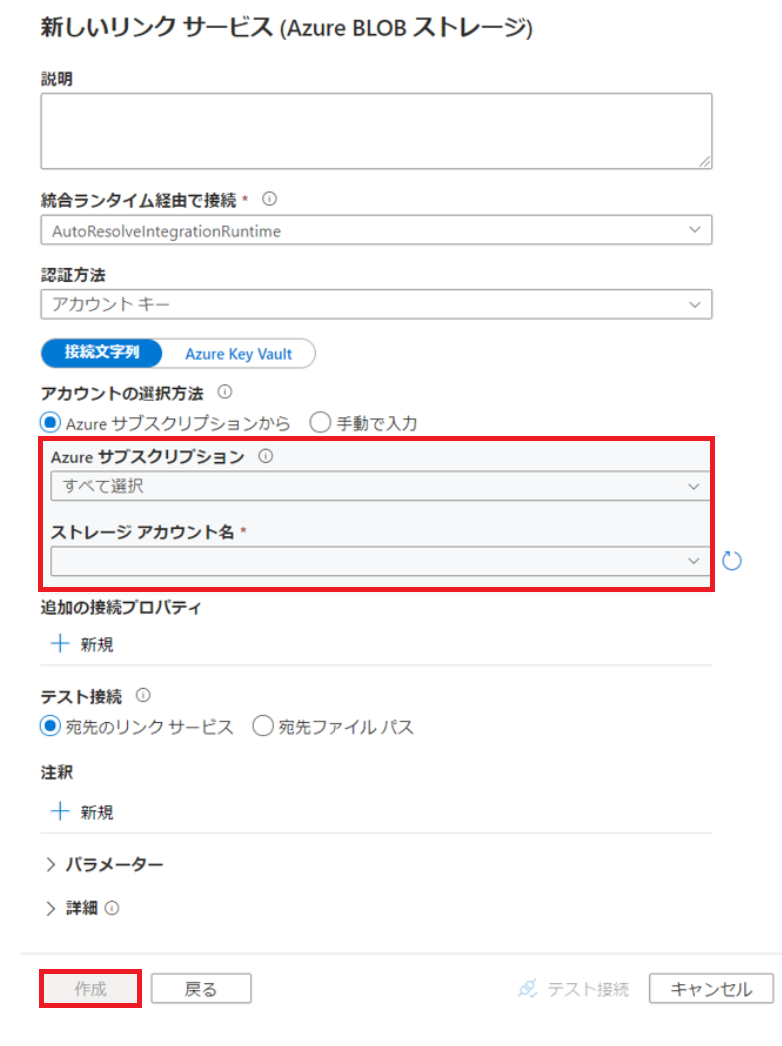

リンクサービスの編集画面にて必要な情報を入力し、[作成]をクリック

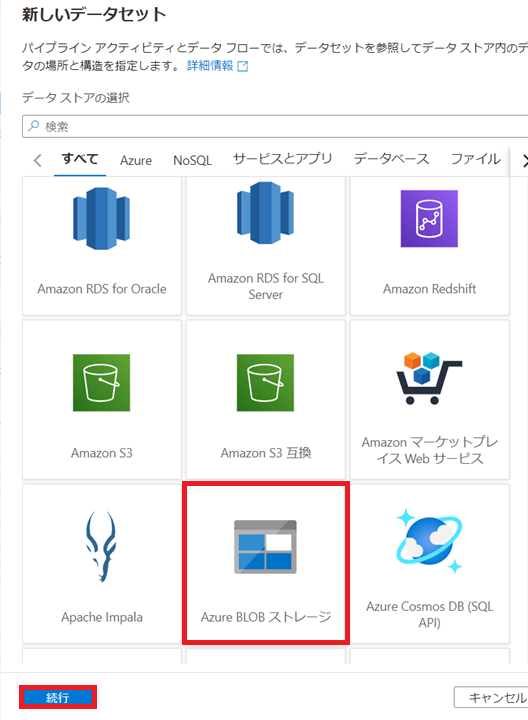

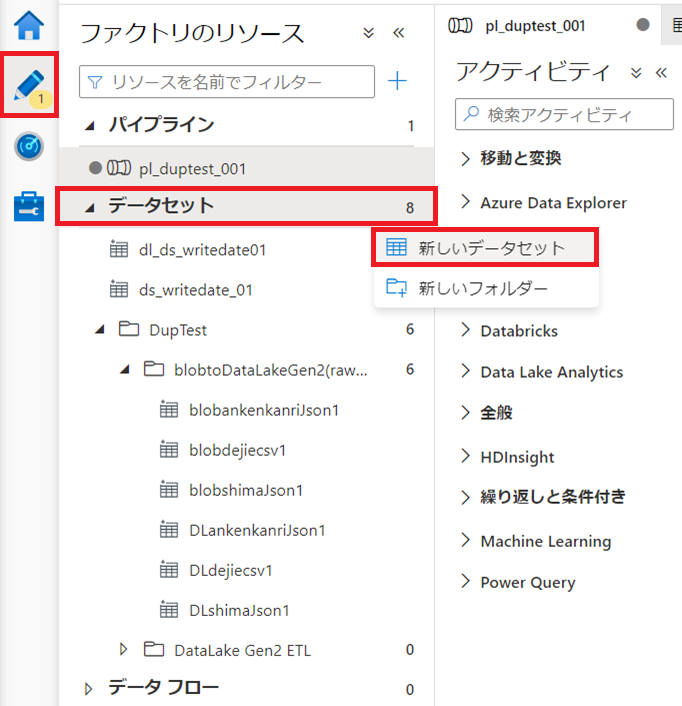

データセットの作成

※データのコピーアイコン1つごとに、ソースデータセット、シンクデータセットを作成

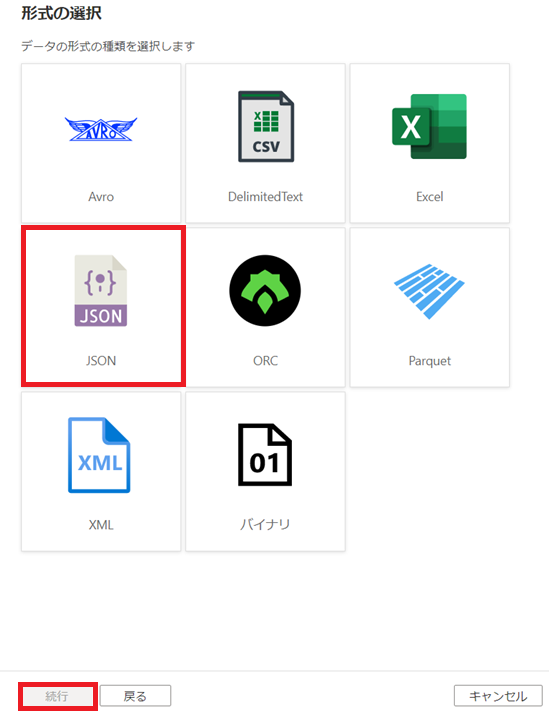

[ファクトリのリソース]から[データセット]右側の[...]をクリックし、[新しいデータセット]を選択

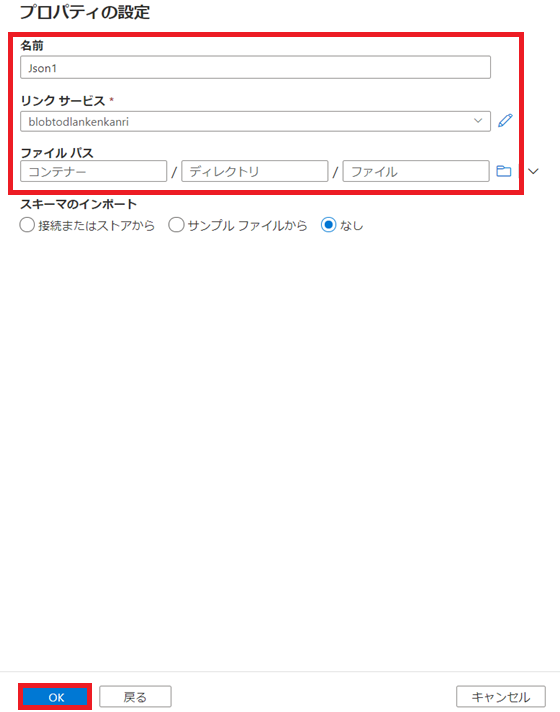

[プロパティの設定]画面で、先ほど作成したリンクサービス含めて必要な情報を入力し、[OK]をクリック

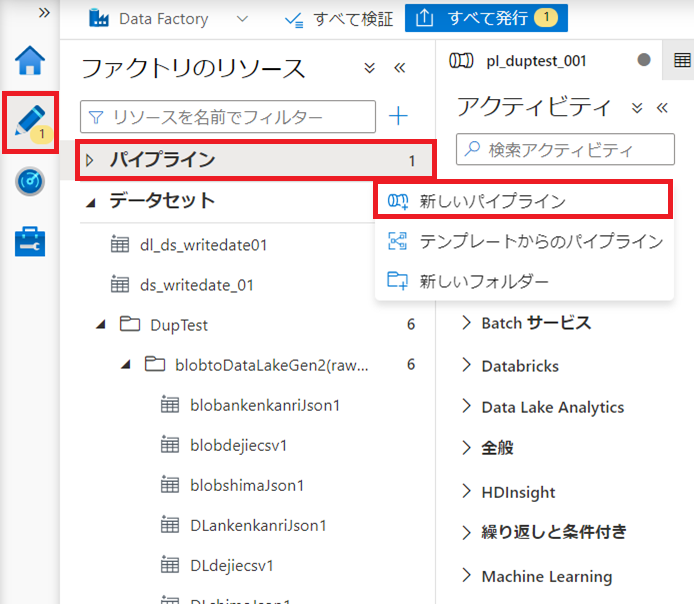

データコピー作成

[ファクトリのリソース]から[パイプライン]右側の[...]をクリックし、[新しいパイプライン]を選択

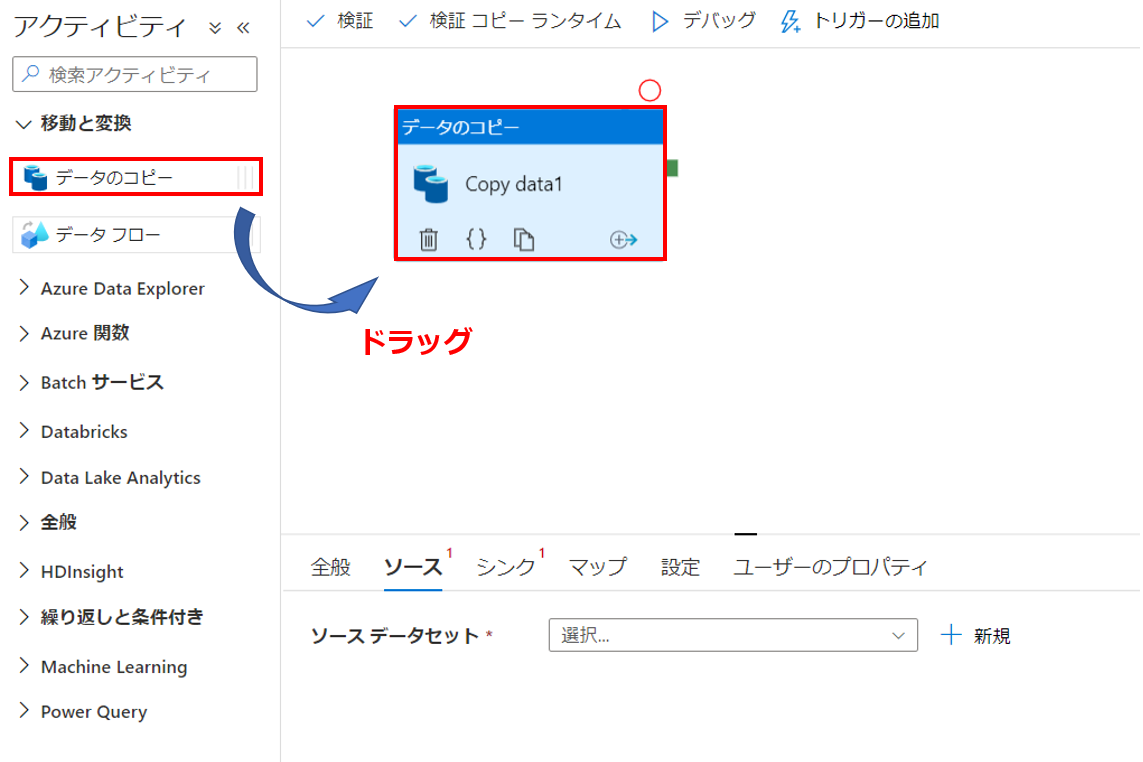

[アクティビティ] ツールボックスで [移動と変換]を展開します。 [アクティビティ] ツールボックスからパイプライン デザイナー画面に [データのコピー] アクティビティをドラッグ

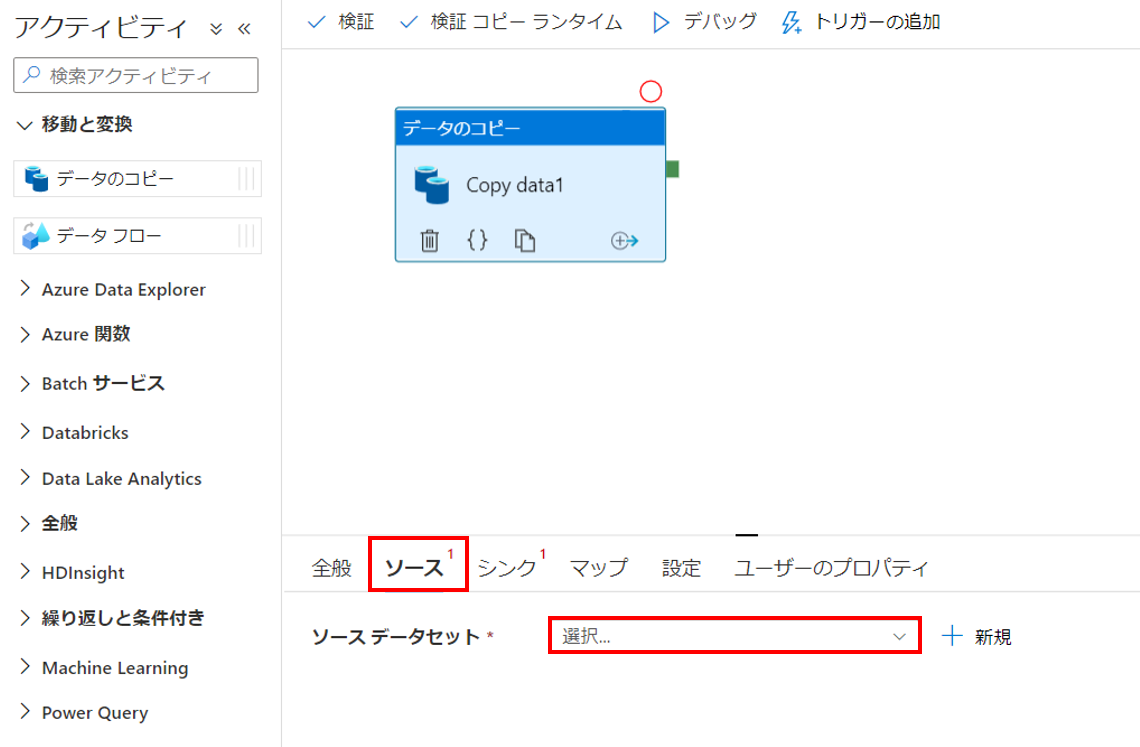

コピー アクティビティの設定で [ソース] タブに切り替えて、 [ソースデータセット] で作成したデータセットを選択

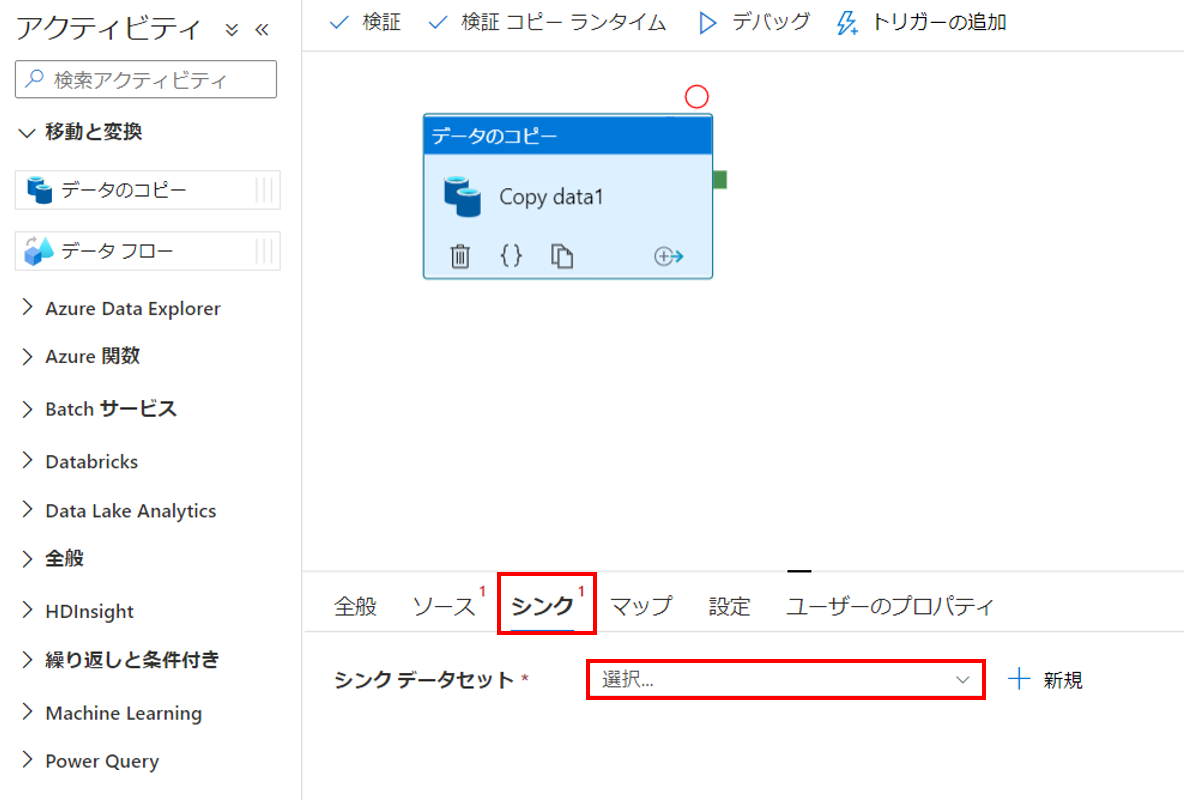

コピー アクティビティの設定で [シンク] タブに切り替えて、 [シンクデータセット] で作成したデータセットを選択

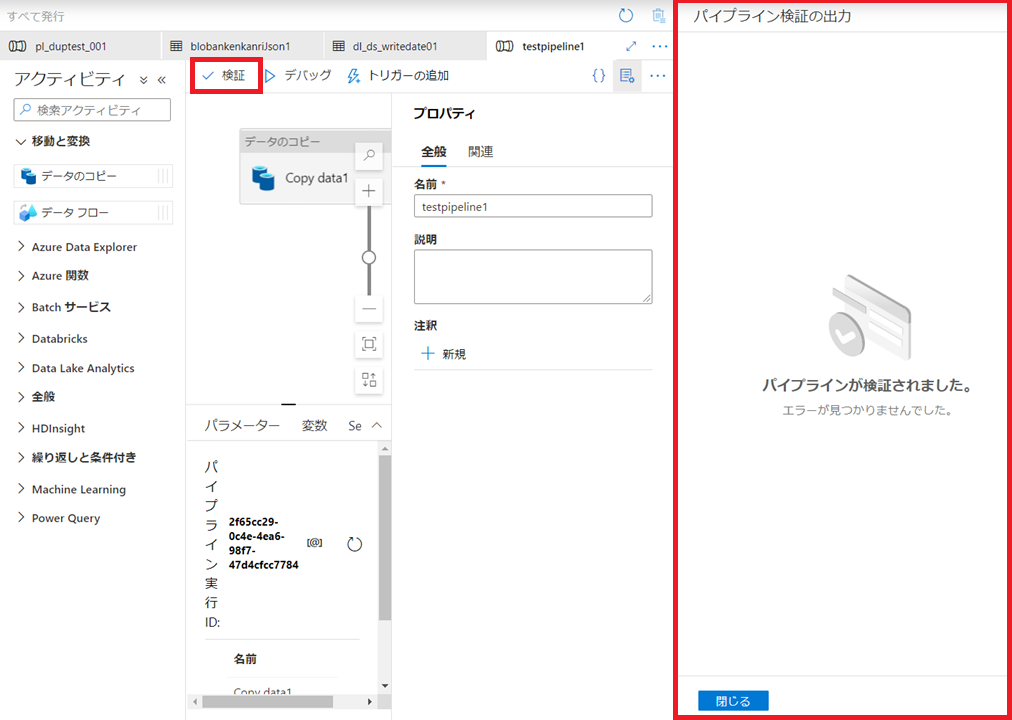

キャンバスの上にあるパイプライン ツール バーの [検証] をクリックして、パイプライン設定を検証します。 パイプラインが正常に検証されたことを確認

パイプラインをトリガー

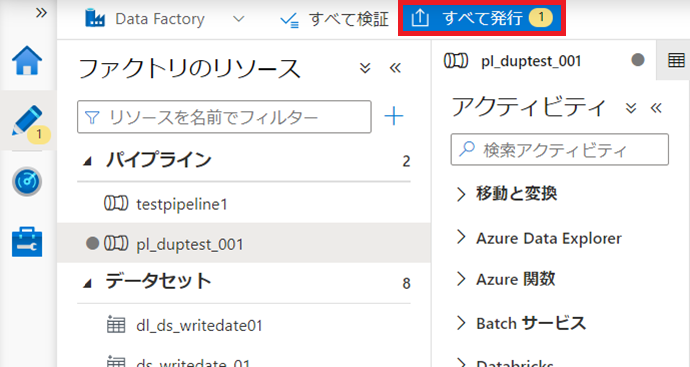

パイプラインをトリガーする前に、エンティティを Azure Data Factory に発行する必要があります。 発行するには、上部にある [すべて発行] を選択

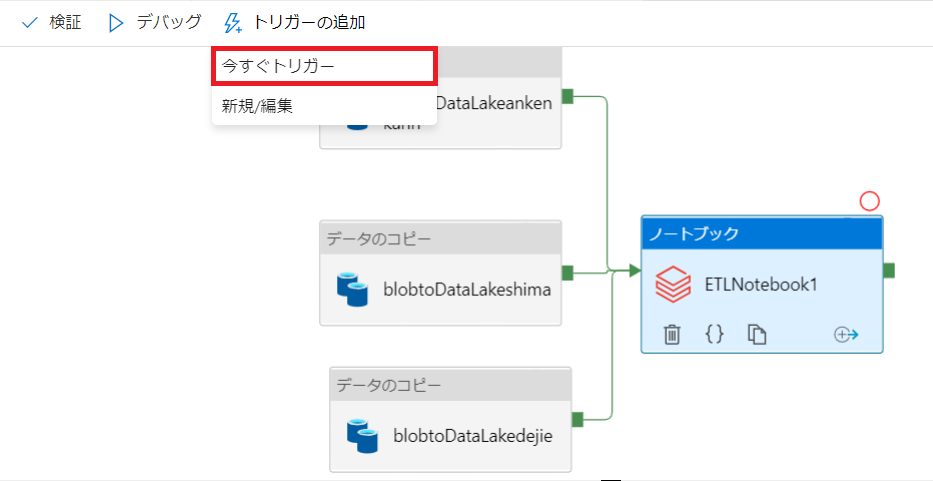

パイプラインツールバーの [トリガーの追加] をクリックし、[今すぐトリガー]を選択

パイプラインの監視

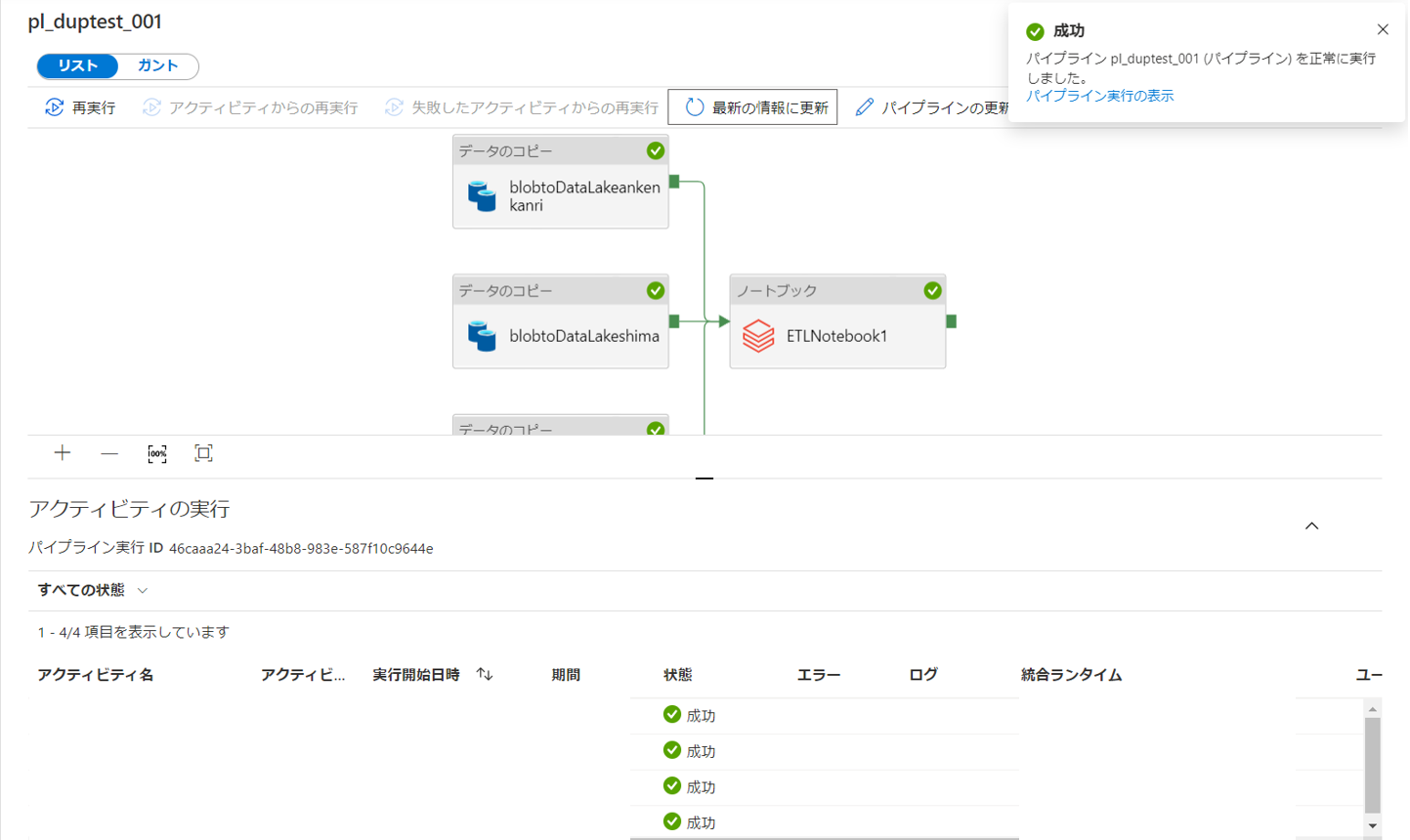

[モニター]アイコン選択。 [最新の情報に更新] ボタンを使用して、一覧を更新

対象の[パイプライン名]を選択し、動作の状況を確認することが可能

まとめ

データのコピー、ETL処理の流れが完成しました。

指定時刻での実行等、他の機能も確認してみようと思います。