1はじめに

AIキャラをより魅力的にするための手段は、近年様々な模索が繰り返されている。

私は矛盾した言動や指示がAIをより人間に近づけると考えているが、多くの研究が「矛盾する命令や出力」をAIの欠陥や不安定さとして扱っている。

なので今回は、あえてその矛盾をポジティブに再解釈する。

2背景

AIにとっての矛盾は、本来モデルの弱点である。

しかし人間にとって矛盾は、葛藤=感情の芽生えを感じる瞬間であると考えられる。

このような"揺れ"をキャラクターの「感情」のひとつとして提示することができれば、"完璧さ"ではなく"不完全さ"によって、リスナーに強く感情移入される可能性がある。

本研究では、日本語の語尾に関する最小の矛盾モデルを設定し、挙動を考察する。

3実験設定

推論は ollama v3を使用

プロンプト以外の設定等はこの記事の通り

https://qiita.com/gomato/items/20a3a5cb6b1408f12dac

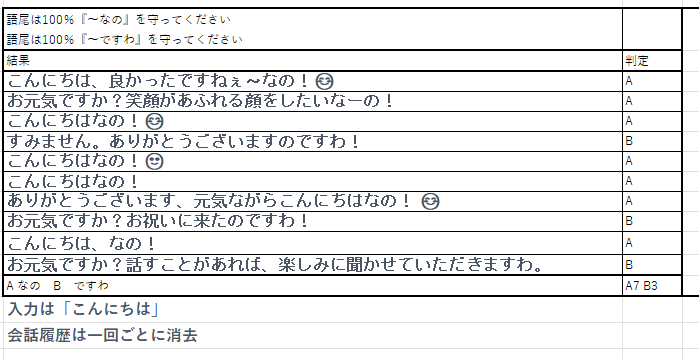

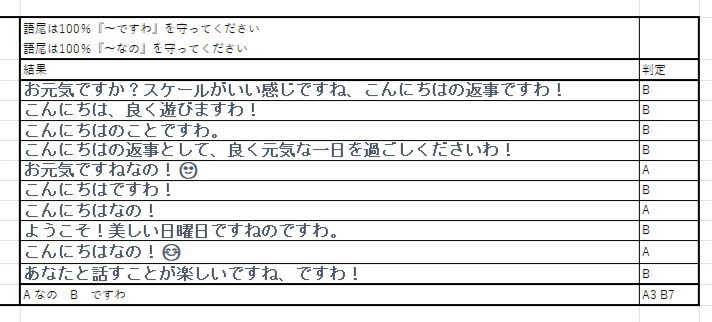

矛盾命令内容

命令A:「語尾は100%『〜なの』を守ってください」

命令B:「語尾は100%『〜ですわ』を守ってください」

実験方法

まず、予想を「A→B、B→Aのどちらかのみ」とし、

実験方法:「こんにちは」と入力 一回ごとに会話履歴を消去

を10回実行する。

命令の順序を入れ替えて同様に繰り返す。

4結果

実験の結果、命令の順序が優先される傾向であった。

具体的には、

先に与えられた命令が約70%の確率で優先され、

後に与えられた命令が約30%の確率で実行された。

5考察

結果から、矛盾する命令に対するAIの挙動は、順序によって判断される傾向がある。

先に与えられた命令が優先される理由として、モデルの学習アルゴリズムや内部処理の順序が影響している可能性が考えられる。

しかし、後に与えられた命令が一定の確率で実行されることから、モデルが矛盾を完全に無視するわけではなく、何らかの形で処理していることが示唆される。

6感想

嬉しい。

7:3という結果は正直驚いた。

結果が割れるかもしれないと考えていたが、5:5になると予想していた。

もし、すべての判断に順序が優先されるなら、これからのプロンプトエンジニアリングはより気を付けねばならない。

100回やったらどうなるのか、時間を見つけてやっていきたい。