本記事は、ランド研究所の「機械学習による航空支配」を実装する(その6)です。

(その5)で、GANによるミッション・プランナーが生成するプランについて調べ、トレーニング・データのバランスに問題がありそうなことがわかったので、w1 : w2 : w3 = 1500 : 1500 : 1500 となるようデータをランダムに選択しトレーニングを再度行いました。

作成したCodesのGitHubのリンクは下記です。

1. トレーニング履歴

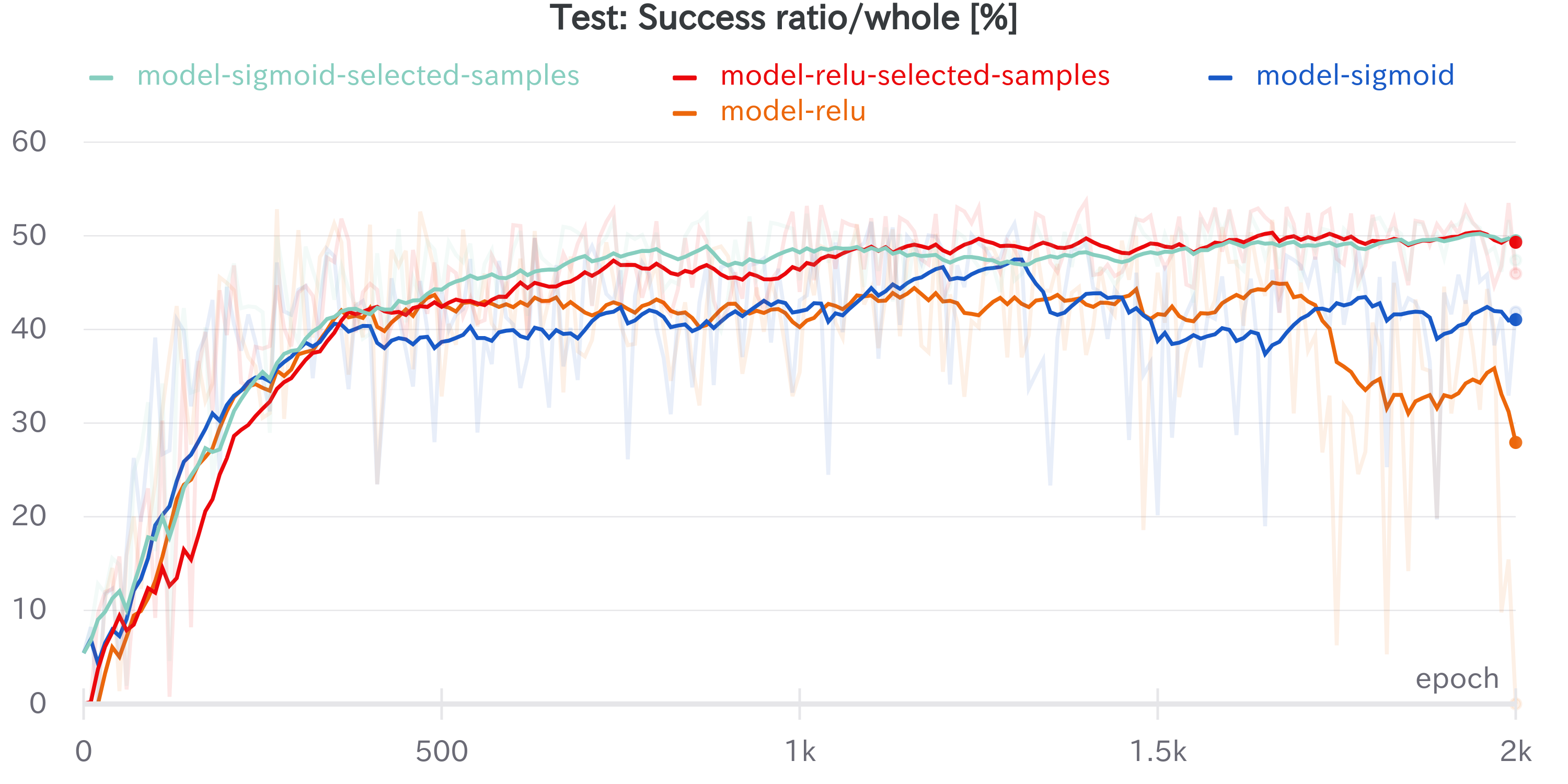

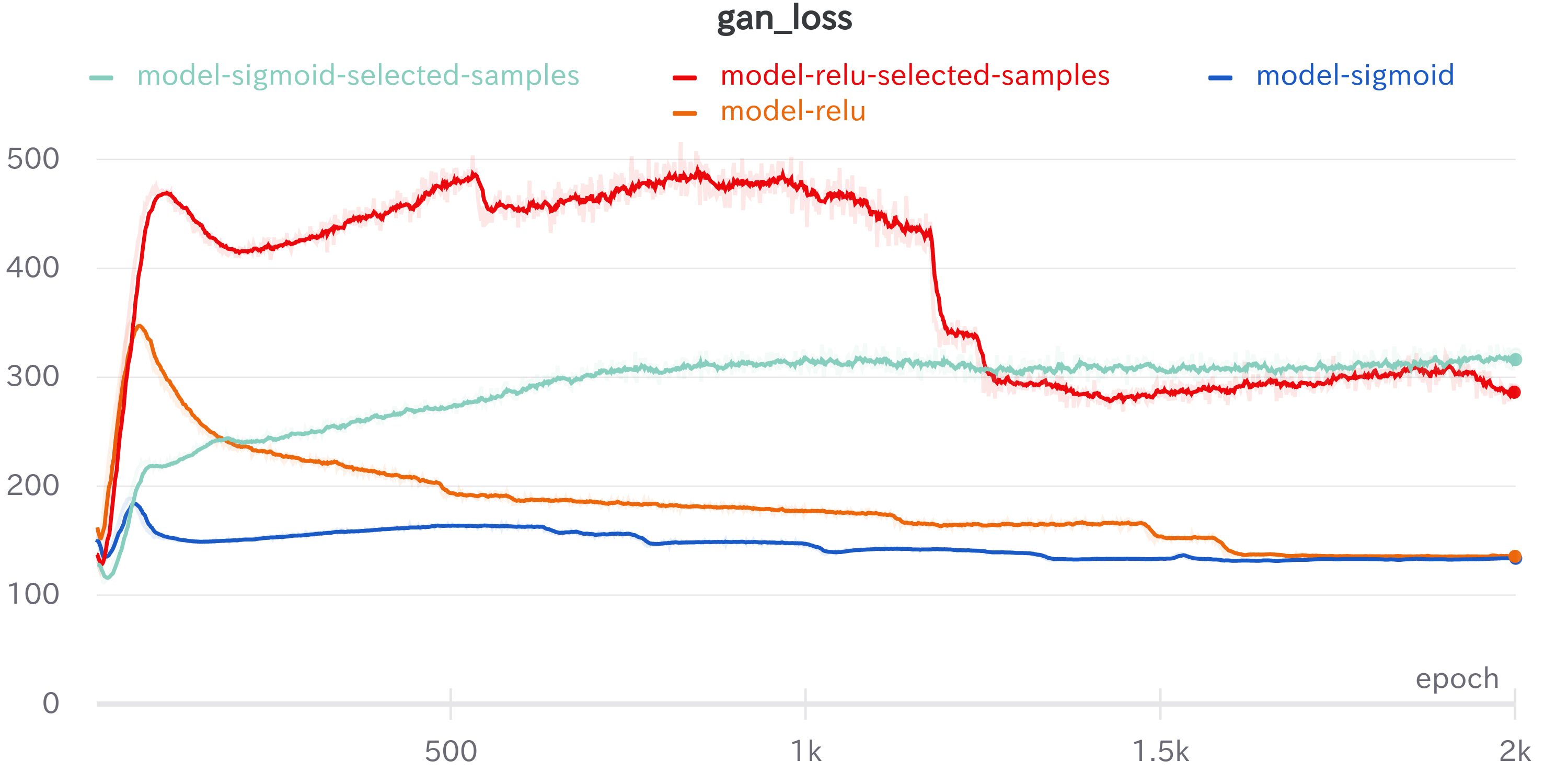

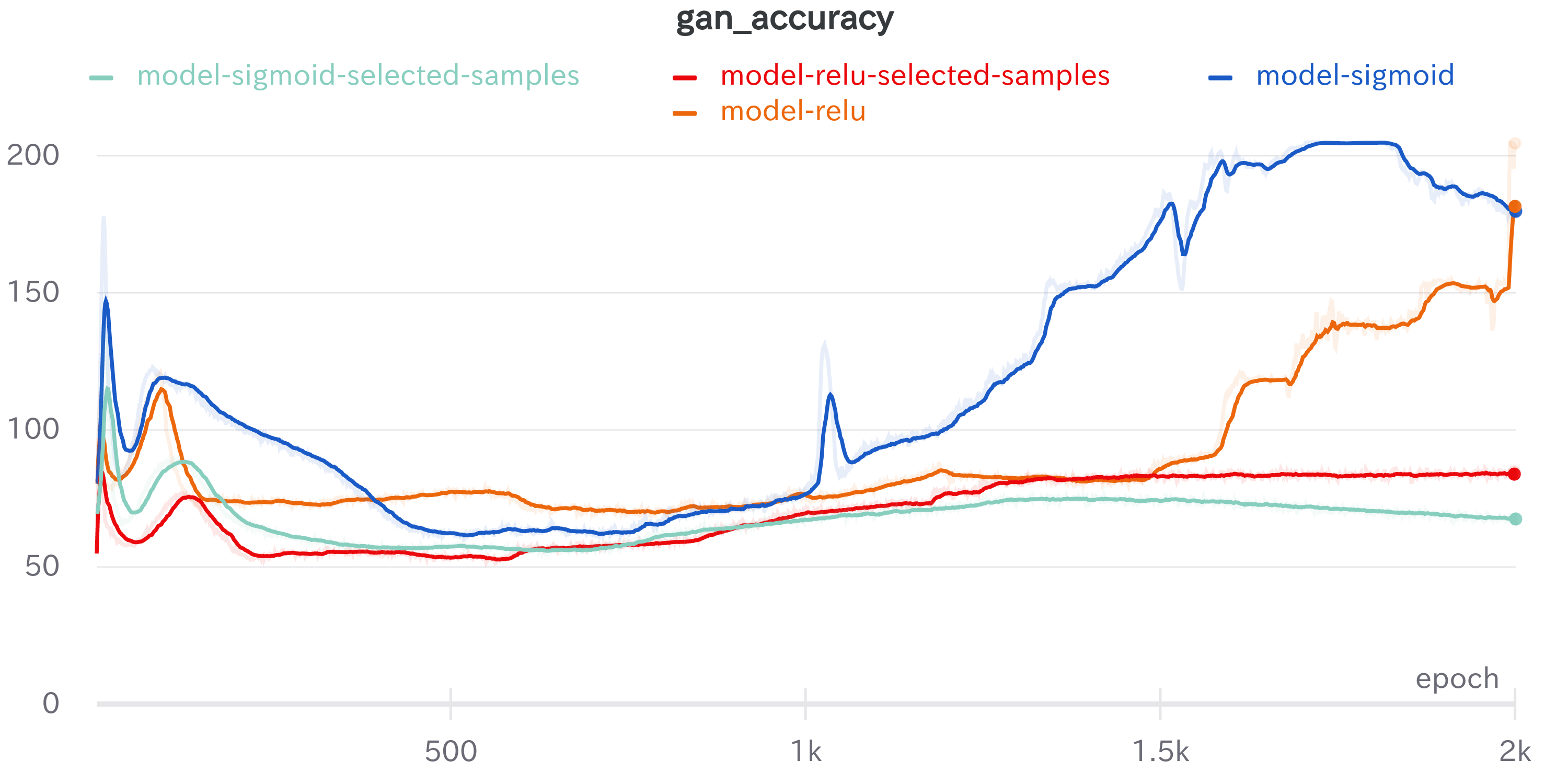

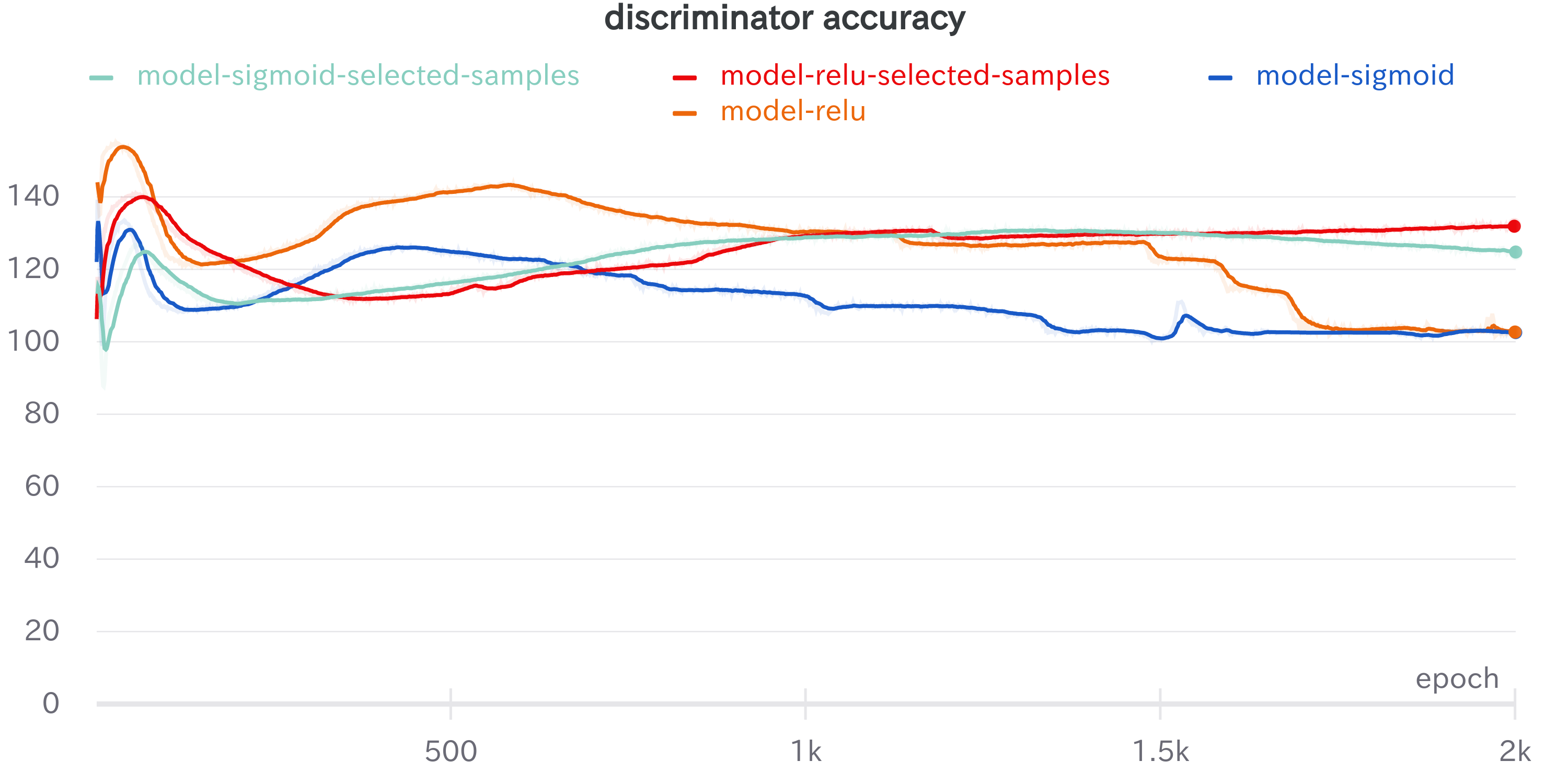

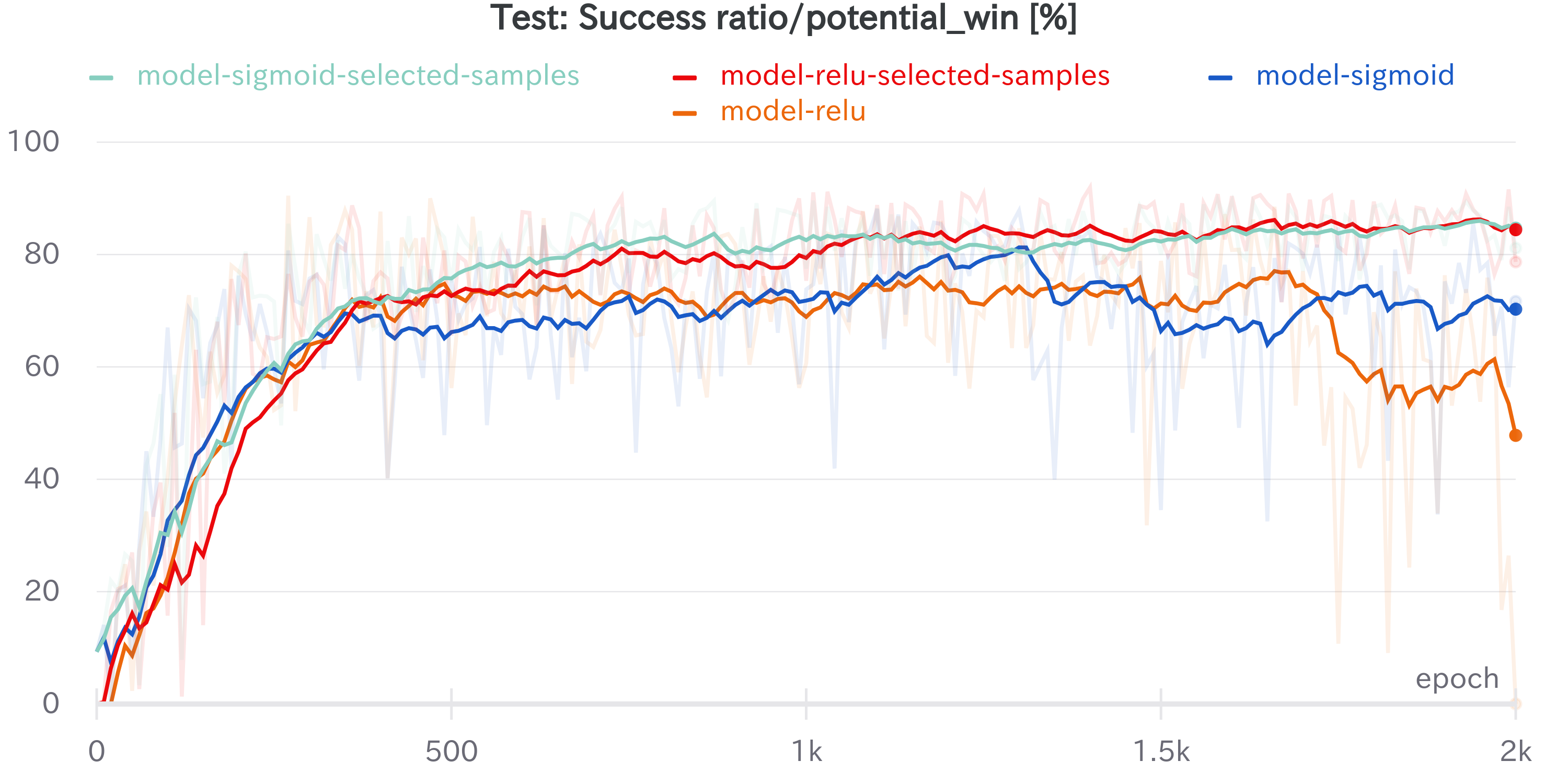

トレーニング・データをバランスさせた場合、トレーニング履歴は下図のようになりました。図には、バランスを考えずにトレーニング・データを作って GAN のトレーニングを行った場合と、バランスさせてトレーニングを行った場合の結果を併記しています。'selected-samples'とある水色のラインと赤のラインが、バランスさせてトレーニングを行った時の結果です。

やはり、データをバランスさせてトレーニングすると性能が向上し、学習も安定します。全ミッションに対して成功率は 50% を超えていて、理論的な上限の 58.44% に近づきました。図から見て取れるように、2k エポックでもまだ性能向上中なので、トレーニングをもっと続ければ、成功率はまだ向上しそうな感じです。

成功できるミッション条件に対する成功率(理論的な上限100%)についても、2k エポックの学習時点で、85% 程度の成功率が達成できています。

図1.2

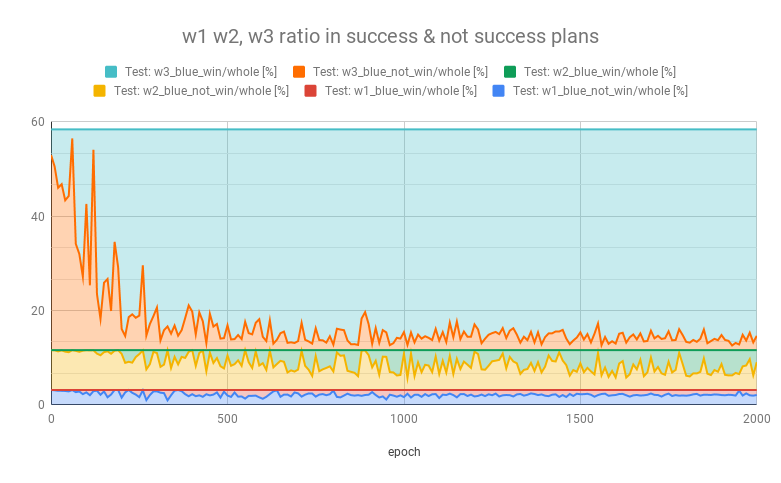

(その5)の図1.1に対応するのが下図になります。ミッション条件 w1, w2 で成功する割合が増えています。

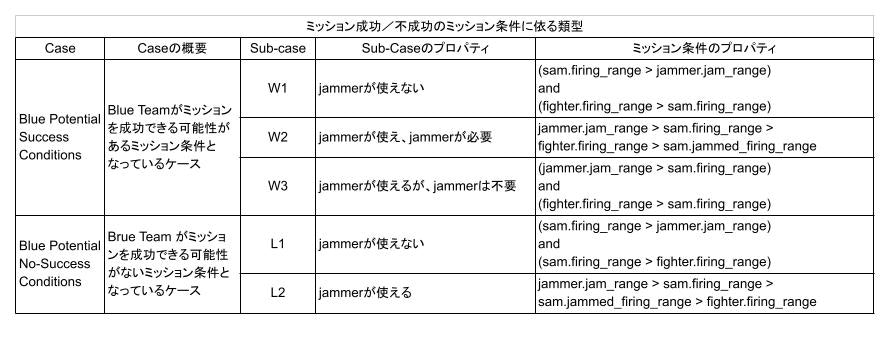

ここで、w1, w2, w3 の定義は以下となっています。

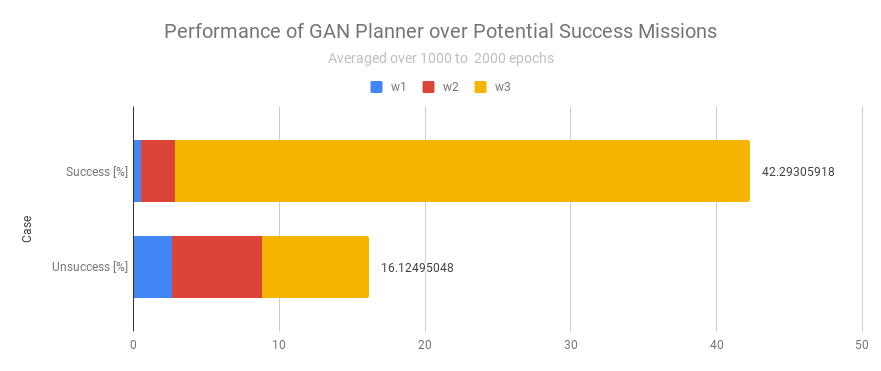

(その5)の図1.2に対応させて、1000 エポック以降の平均値を計算したのが下図になります。

(その5)の図1.2は下図でしたので、成功率が 42.29% から 48.62% に増加しています。

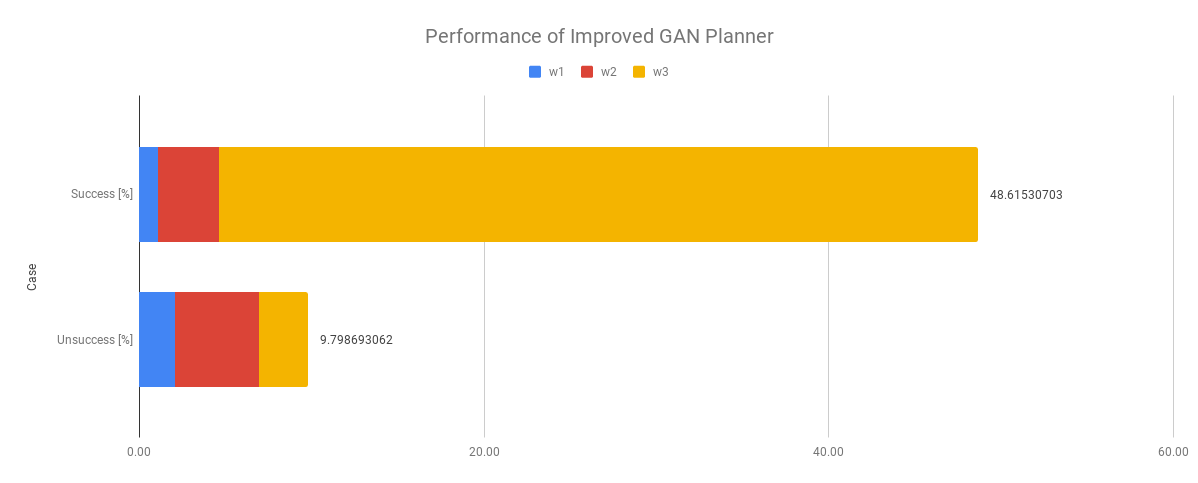

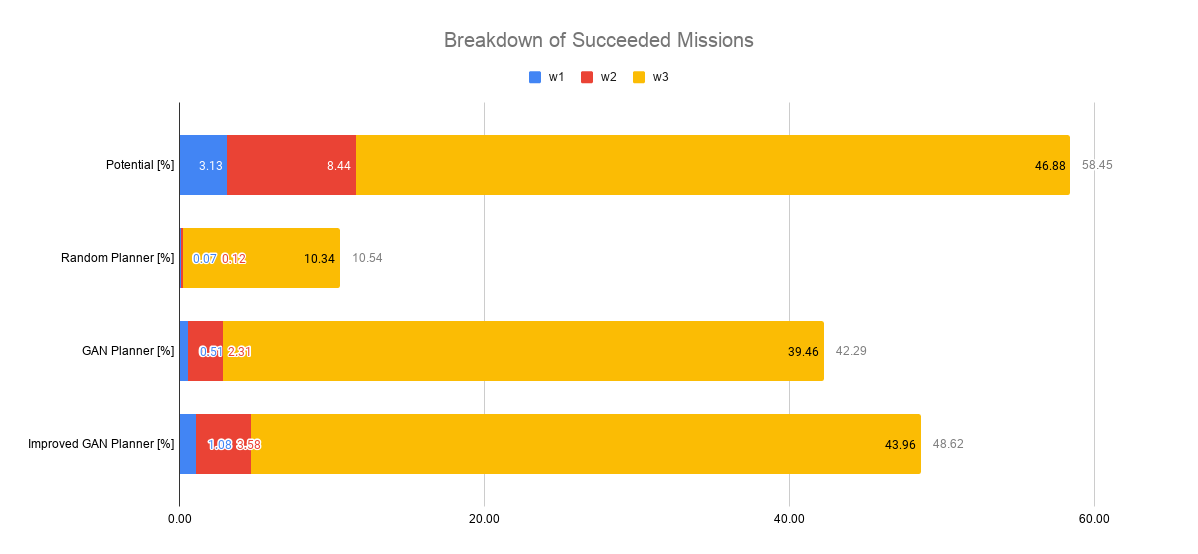

これらの図からSuccess部分のみを取り出して、成功する上限内訳、ランダム・プランナーによる成功内訳、(その5)の GAN Planner による成功内訳、トレーニング・データをバランスさせてトレーニングした今回の Improved GAN Planner による成功内訳を比較したのが下図になります。

Improved GAN Plannerでは、GAN Plannerよりも、トレーニングに使うw1, w2のデータ数は増えていますが、w3 のデータ数は実は減っています。にも関わらず、w1, w2だけではなく、w3 のミッション条件についても成功率が 39.46% → 43.96% と向上しています。

これについては、w3 の特徴を学習するには、削減したデータ数でも十分なことに加え、以下の理由が考えられます。

ミッション条件 w1, w2, w3 は、その境界は連続的です。非連続に条件が切り替わるわけではありません。このため、ニューラルネットの活性化も連続的に変化しているはずです。このため、w1, w2 の条件下で、 w3 との境界近傍で学習が進むことによって、連続的に境界面近くの w3 の学習も、それに引っ張られて進むのではないかと推測します。

2. さらなる性能向上を目指すには

さらなる性能向上のために出来そうなことを、思いつくままに列挙しておきます。

- 今回は2000エポックまで学習させましたが、未だ成功率は向上中でサチレーションしていません。したがって、学習を継続すれば性能向上する可能性があります。

- 混合分布のような複雑な分布を生成し易くするために、MDN(Mixture of Density Network)を適用する方法が考えられます。

- 今回、プランを生成する元となっている正規分布の次元は、全く適当に決めています。これを最適化することで性能向上するはずです。ただし、次元を変えて試行してみるしかしょうがないので、かなりの計算パワーが必要です。

- 今回は、正例(成功)だけを使ってトレーニングしていますが、負例(失敗プラン)も使えば、日々の生活と同じように、失敗からも学べる可能性があります。このためには、Generator, Discriminator への条件入力に、ミッションの成否も入力すれば、正例だけでなく負例(失敗プラン)も使って、トレーニングできるようになります。具体的には、条件入力にミッション成功/不成功を埋め込んだもの又は One-hot 化したものを追加で入力してトレーニングします。そしてプランを生成する時には、ミッション成功を入力します。そうすれば失敗からも学べる可能性が出てきます。しかしながら、余計なことをも学習しなければならないので、学習が足りないと、かえって悪い結果になってしまう可能性もあります。これについては、そのうち試してみたいと思います。

- 今回使ったのは、ほぼオリジナルの初期の GAN です。GANは登場して以来、様々な工夫、改良がなされています。最新の GAN を使うことで、性能向上できる可能性があります。

3. GANプランナーが生成するプラン

3.1 ケース w1

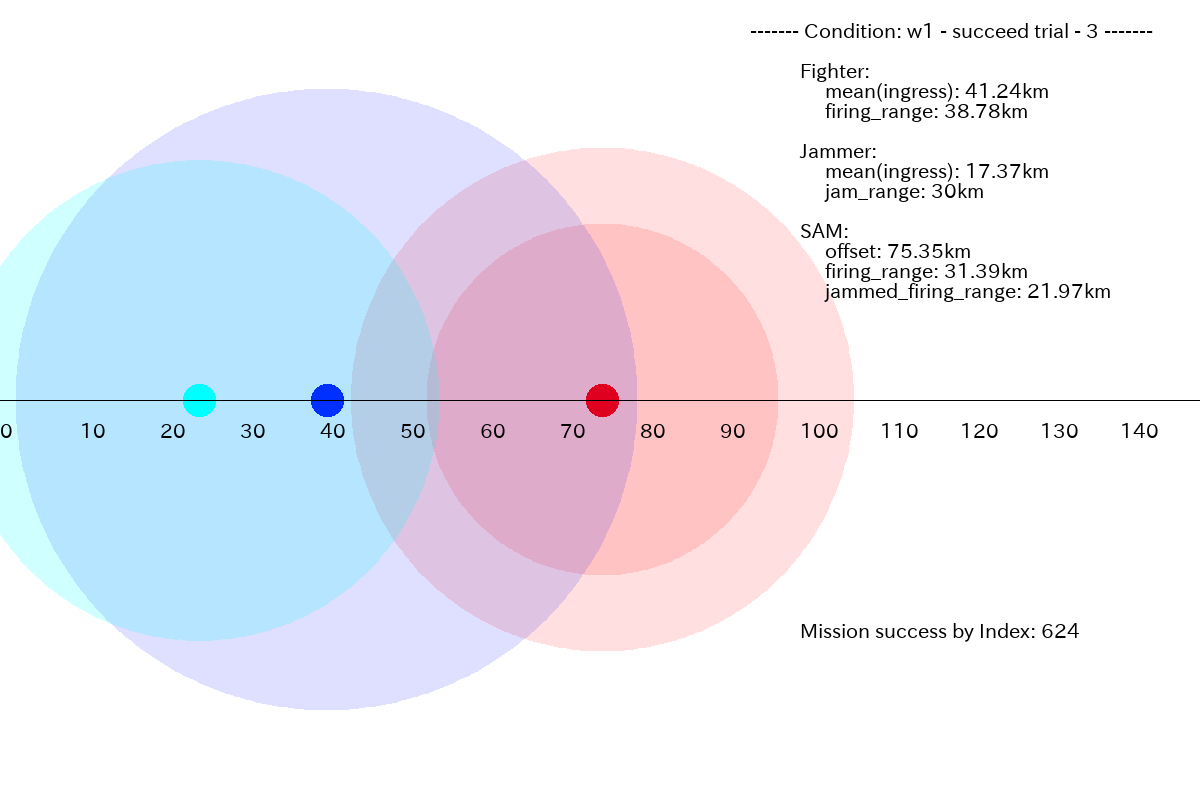

(その5)と同様に、成功したプランの例を下図に示します。

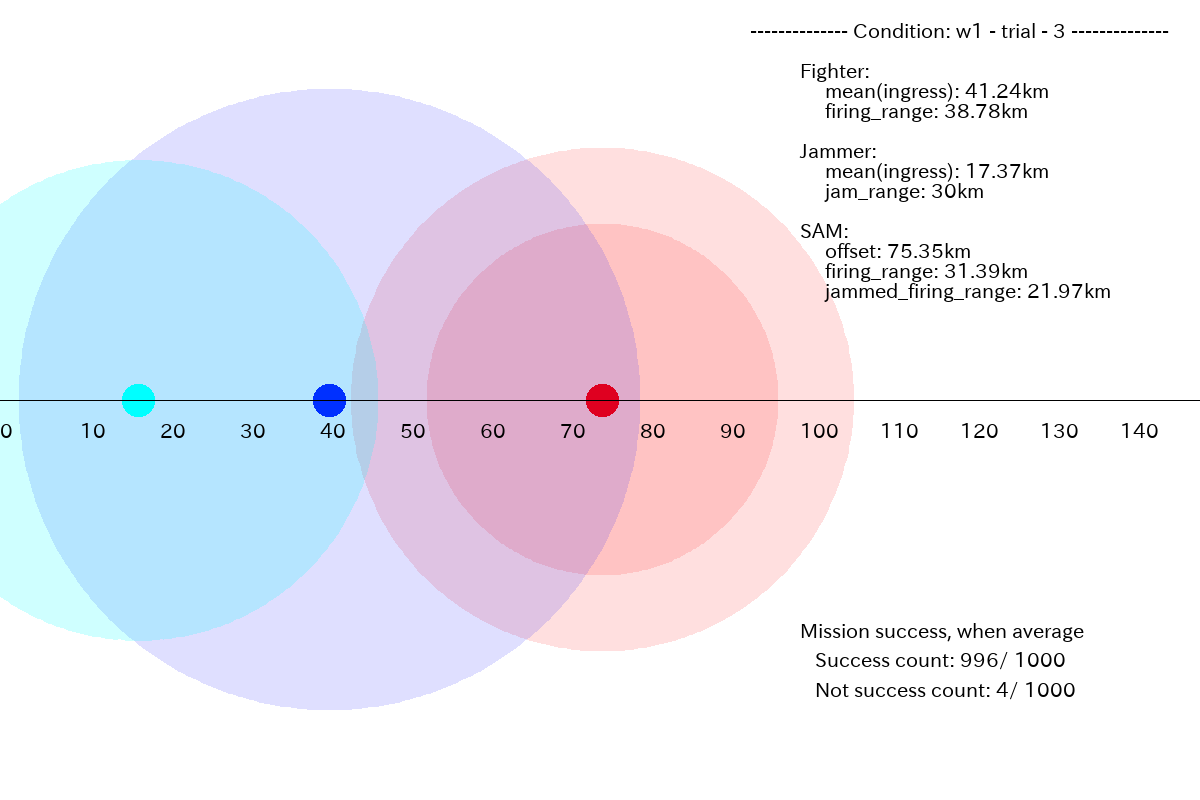

全プランを平均したものが下図になります。生成したプランの内 99.6% (=996/1000) はミッションに成功しているので、平均でもミッションに成功できています。

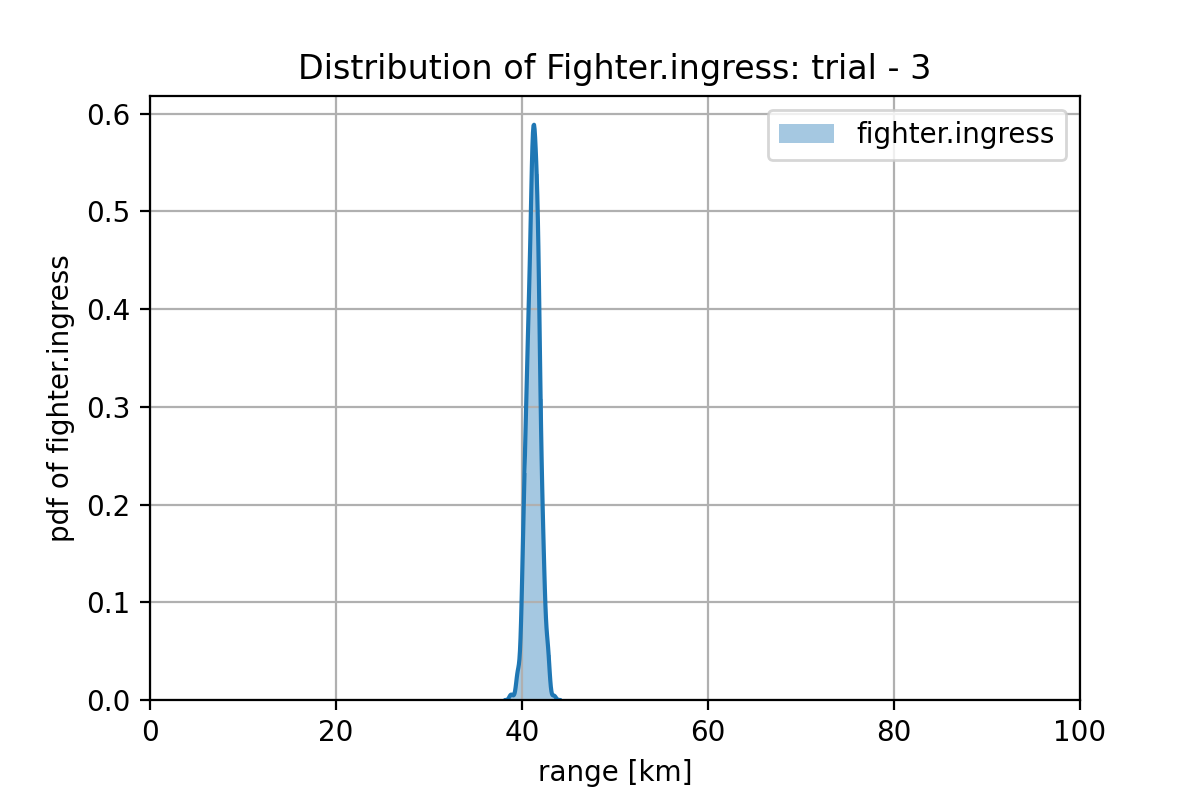

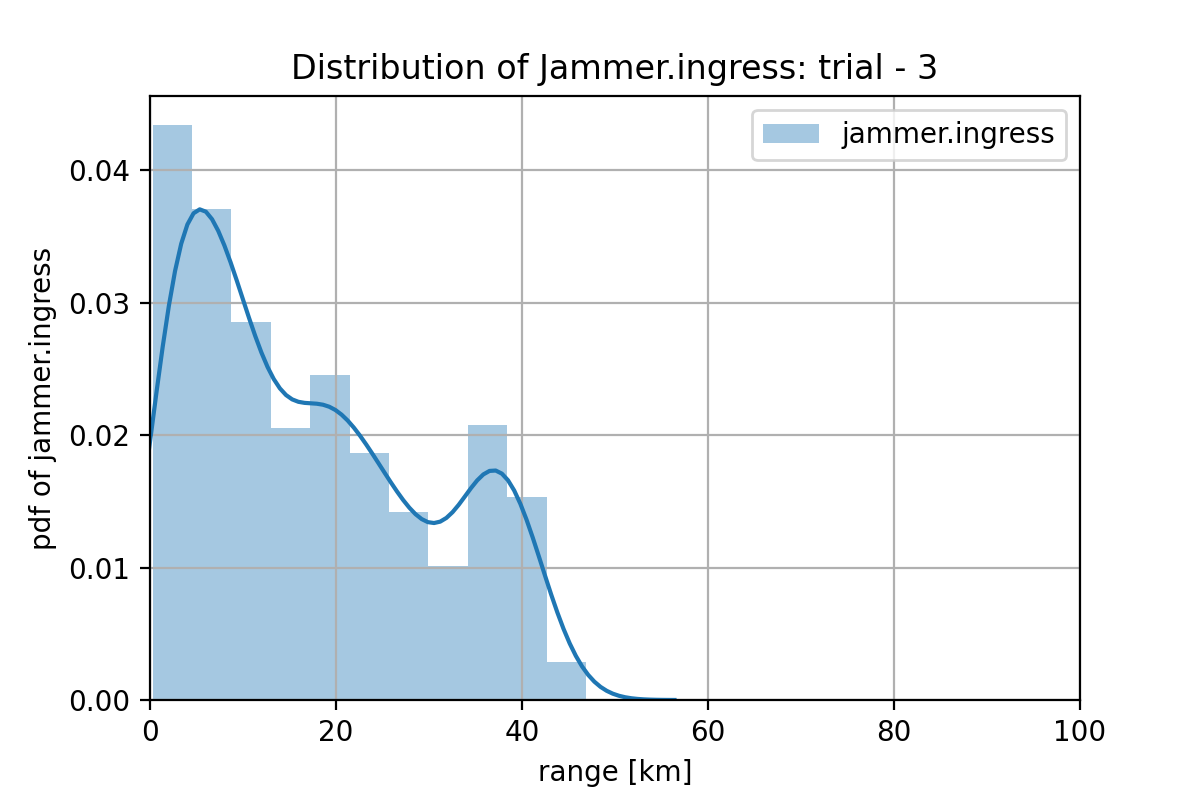

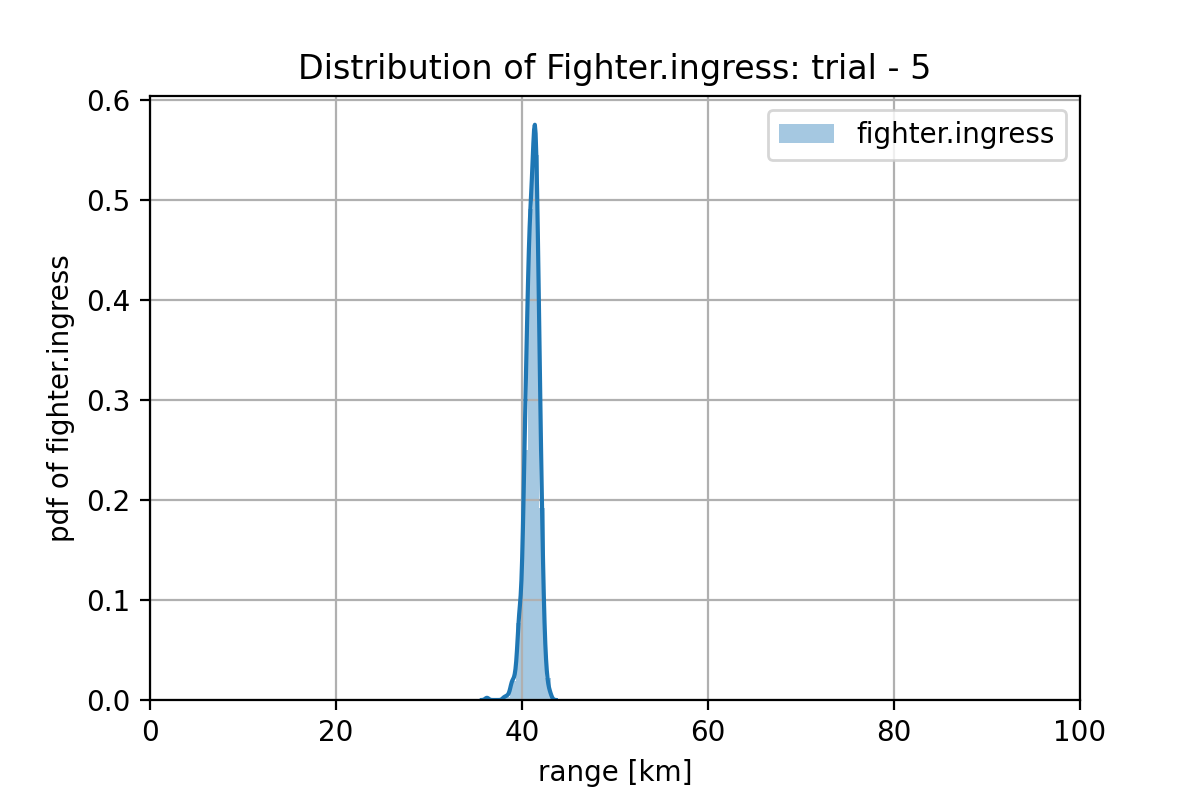

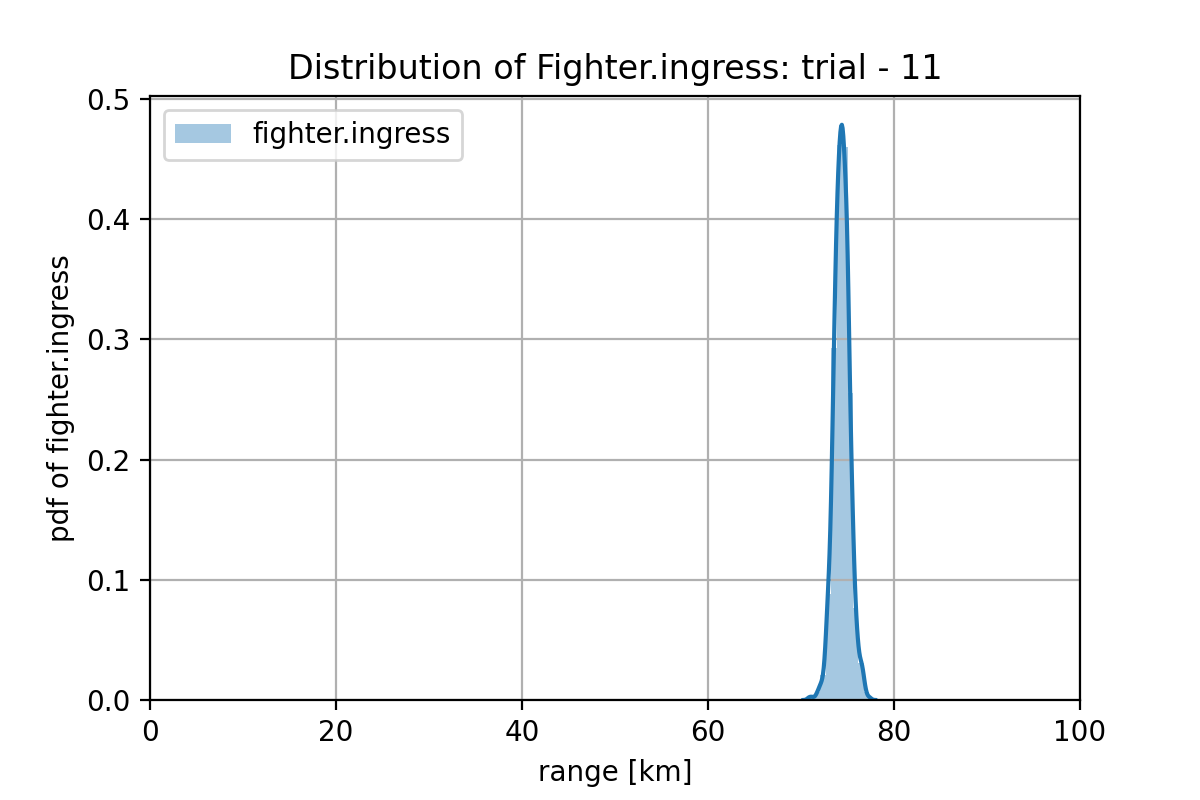

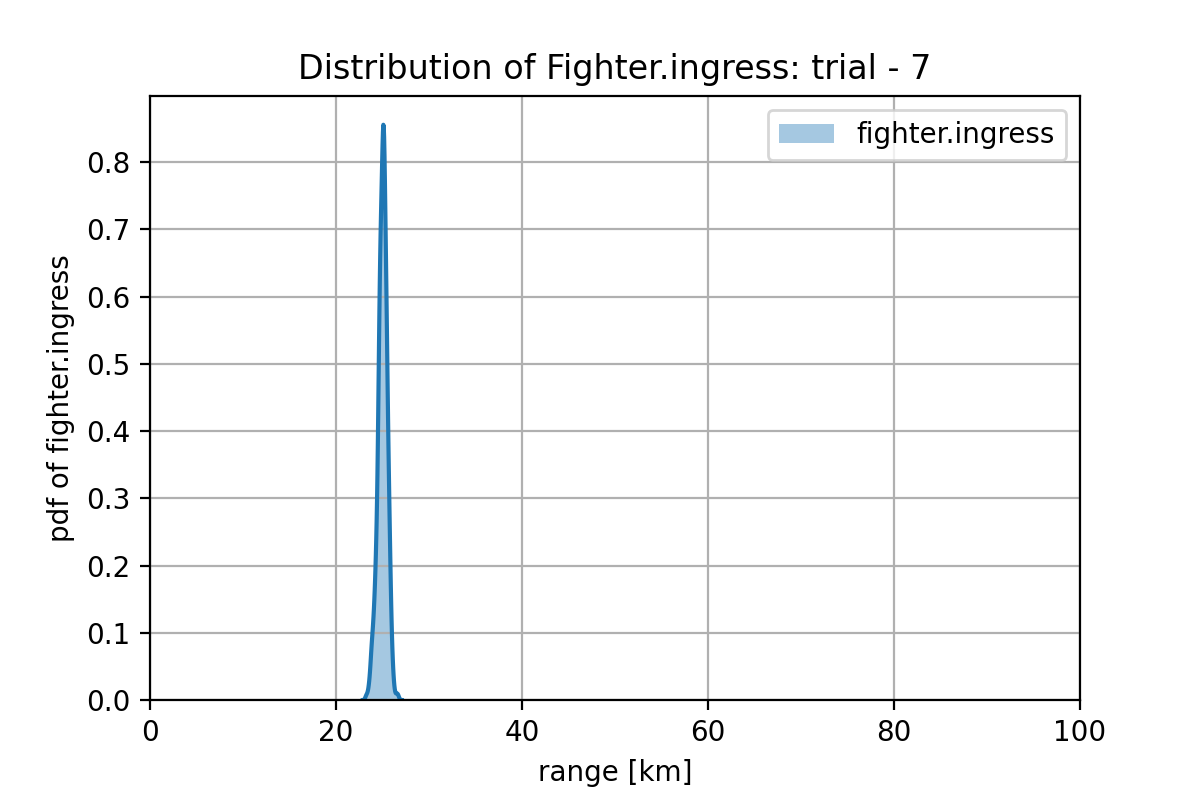

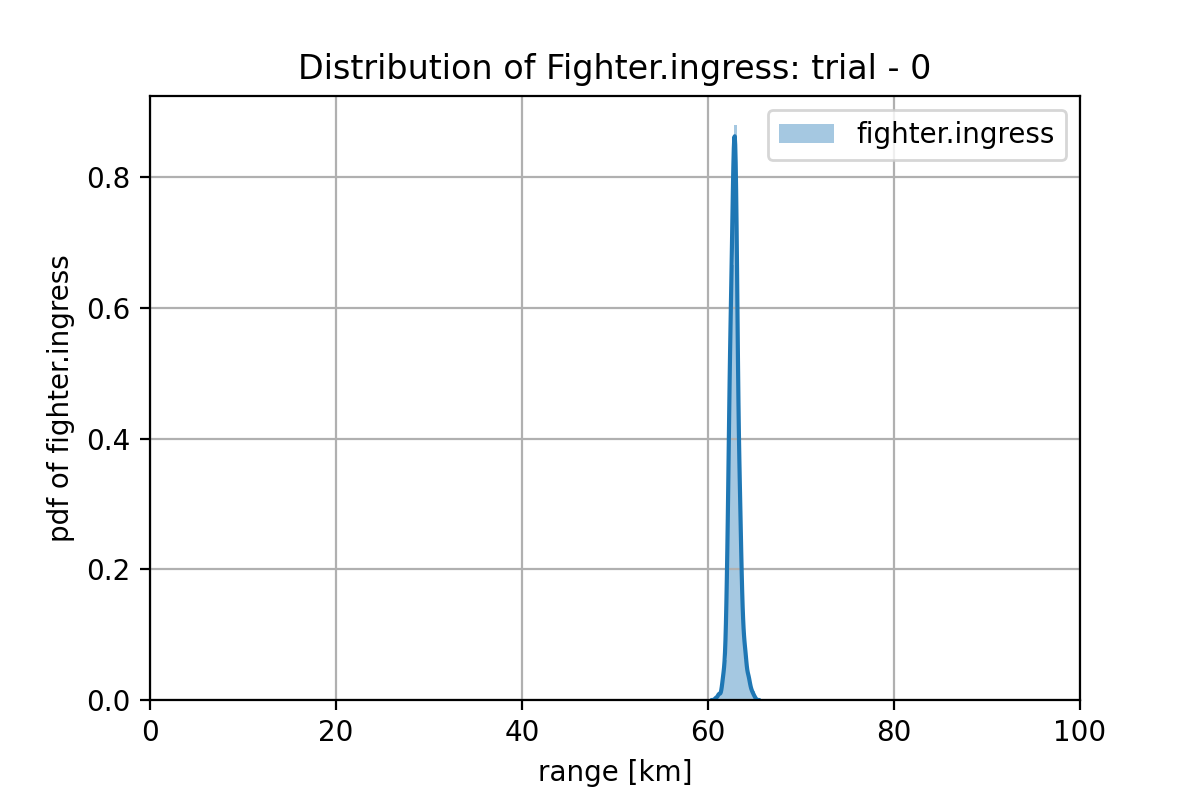

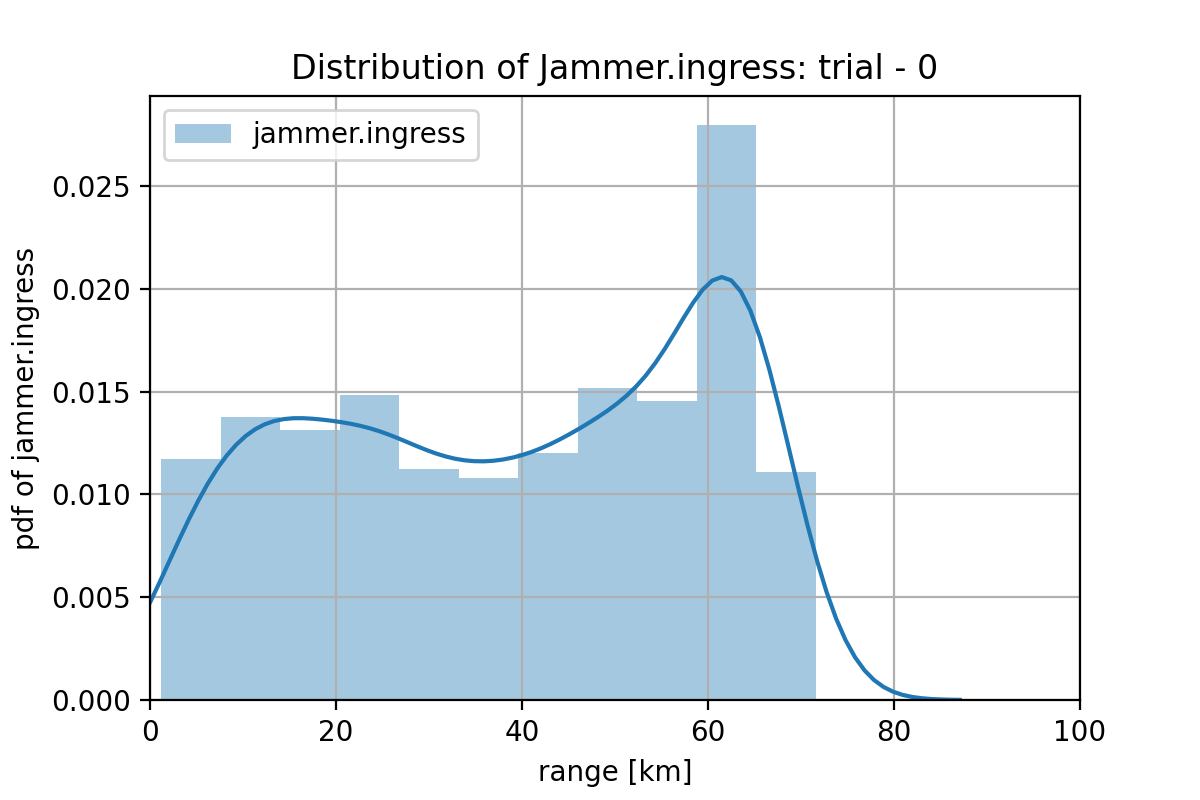

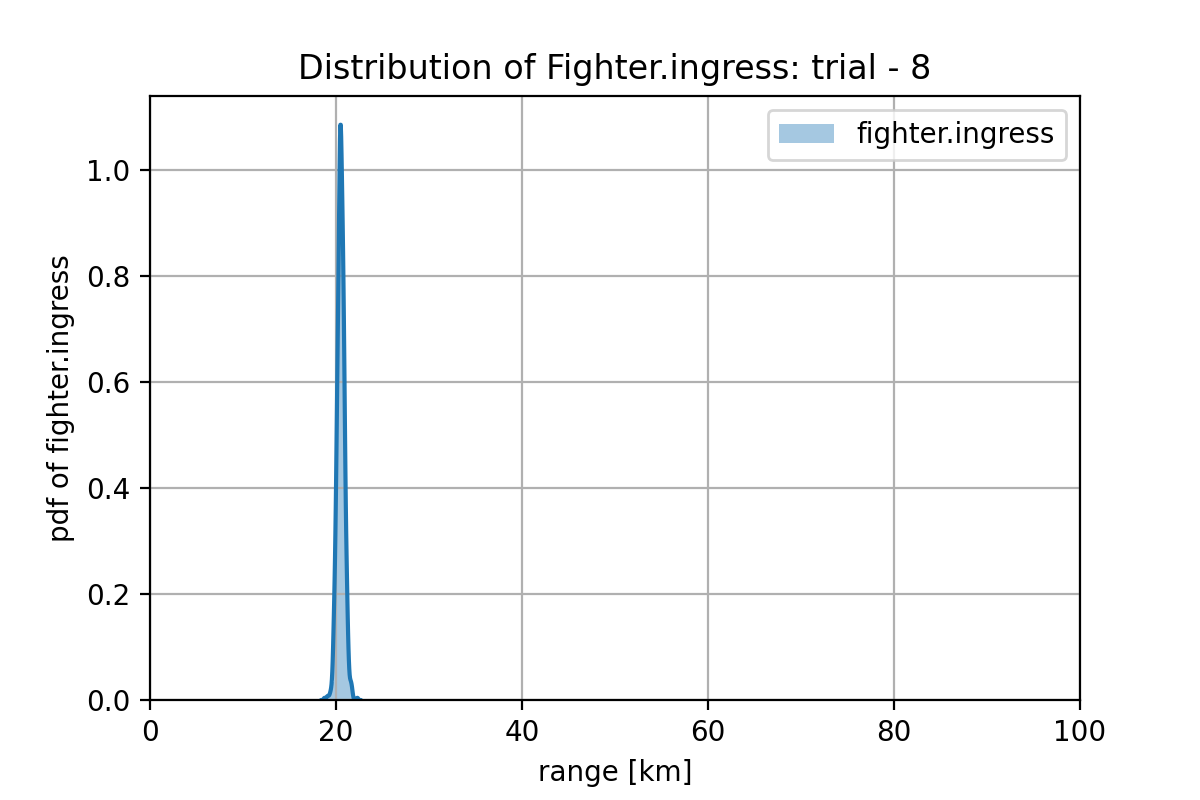

生成したプランの fighter 進出レンジと jammer 進出レンジの分布は次のようになっています。データのバランスを取ったことで、Fighter 進出レンジの分布は非常にシャープなものとなっています。また、Jammer も必要以上に(この場合 44km 程度以上に)進出させないことが学習できています。

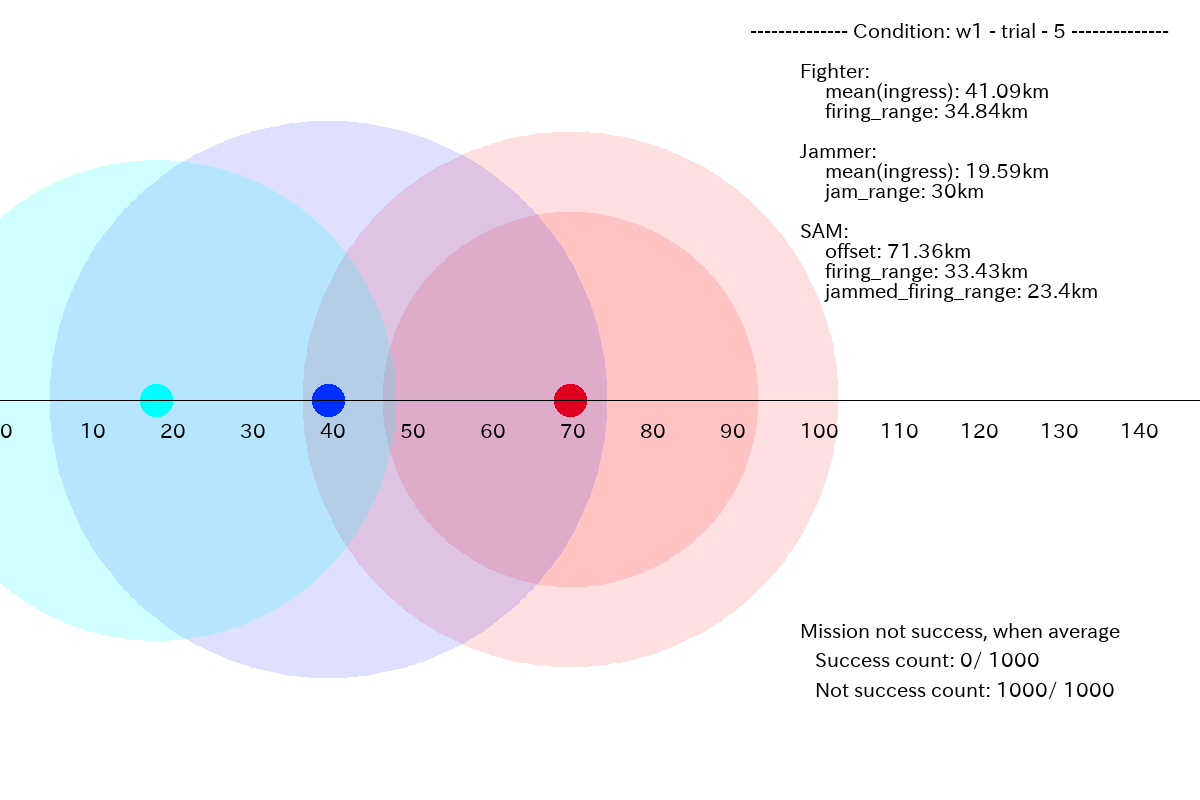

一方で、成功プランを生成できない場合もあります。下図に生成したプランの平均を示します。このケースの場合、あと少しだけFighterの進出レンジを抑えれば良いだけなのですが、学習しきれていません。この原因が、学習が足りないためなのか、ネットが小さい(あるいは浅い)ためなのか、データが不足しているためなのかは、もっと分析しないと判りません。

3.2 ケース w2

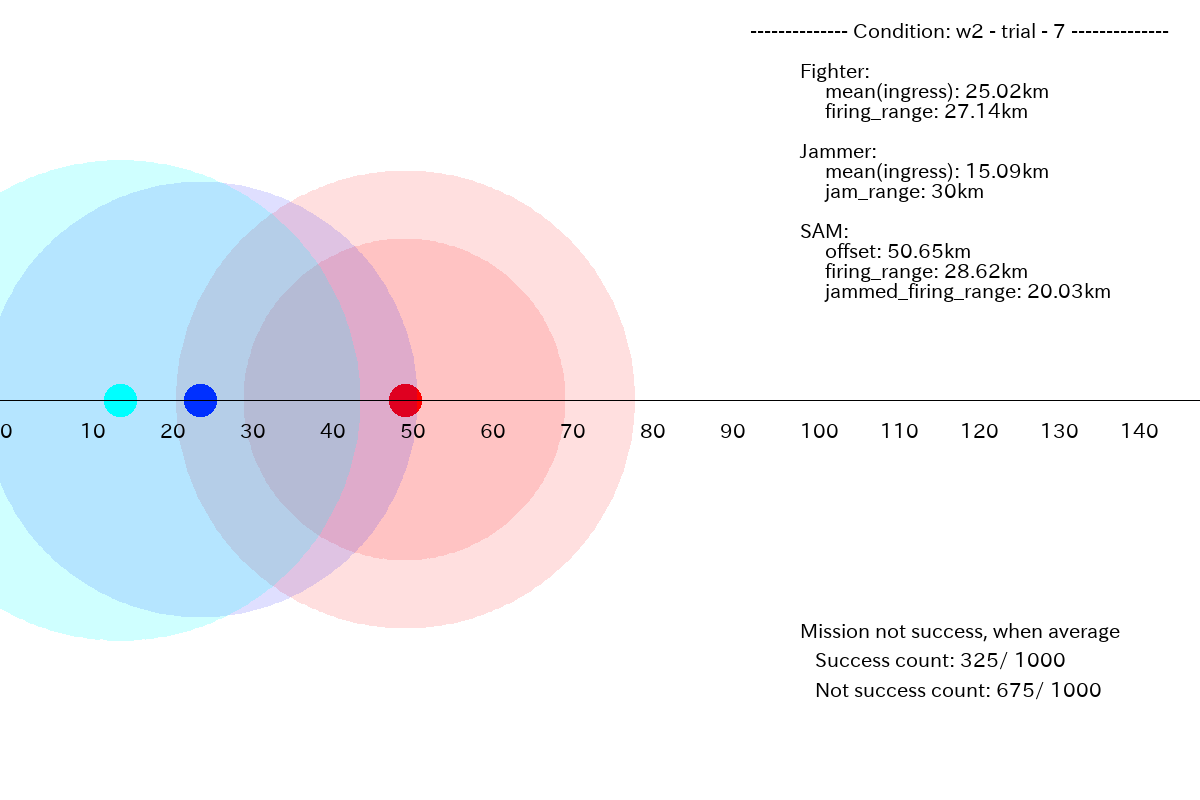

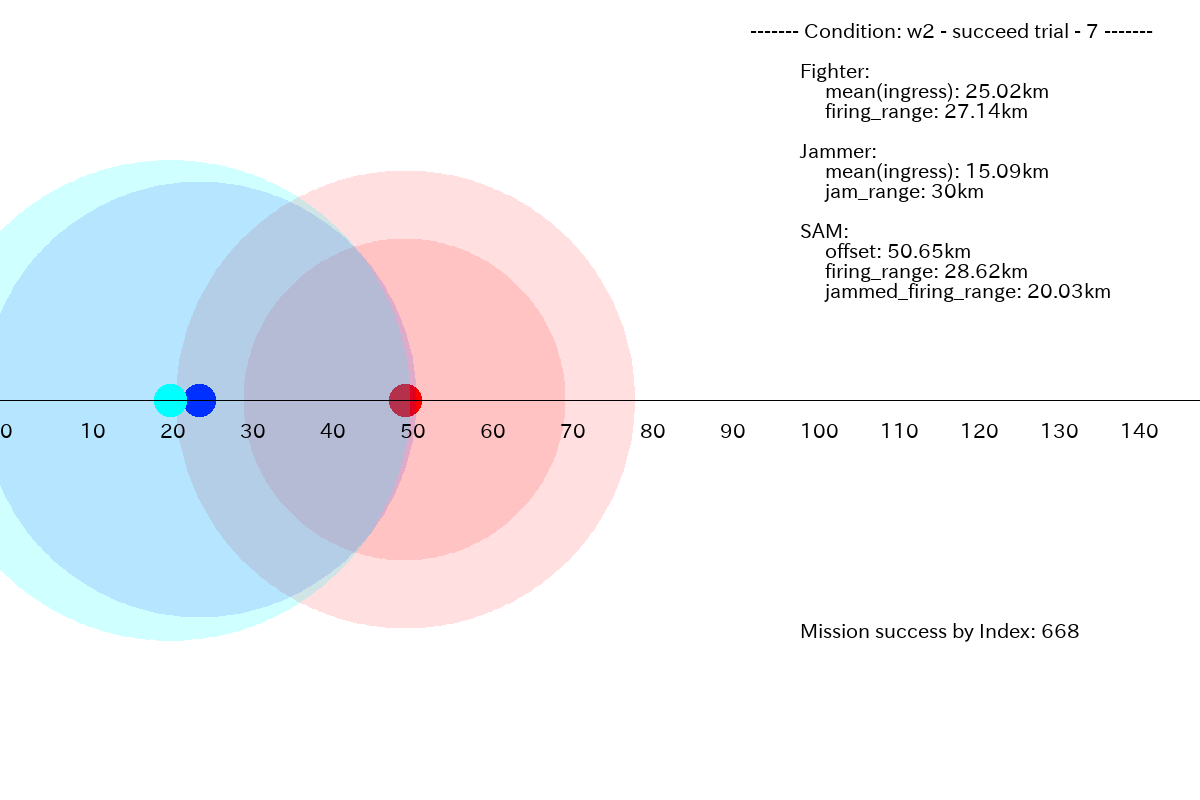

この場合、ミッションを成功させるには、かなり狭い範囲に、Fighter と Jammer を進出させる必要があるのですが、どちらの進出分布もかなりシャープとなっていてそれを学習できています。(その5)のように、Jammerのプランが原点方向に長く尾を引くようなこともありません。これは大きな進歩です。このミッション条件では、生成したプランの内の32.5% (325/1000)が成功プランでした。

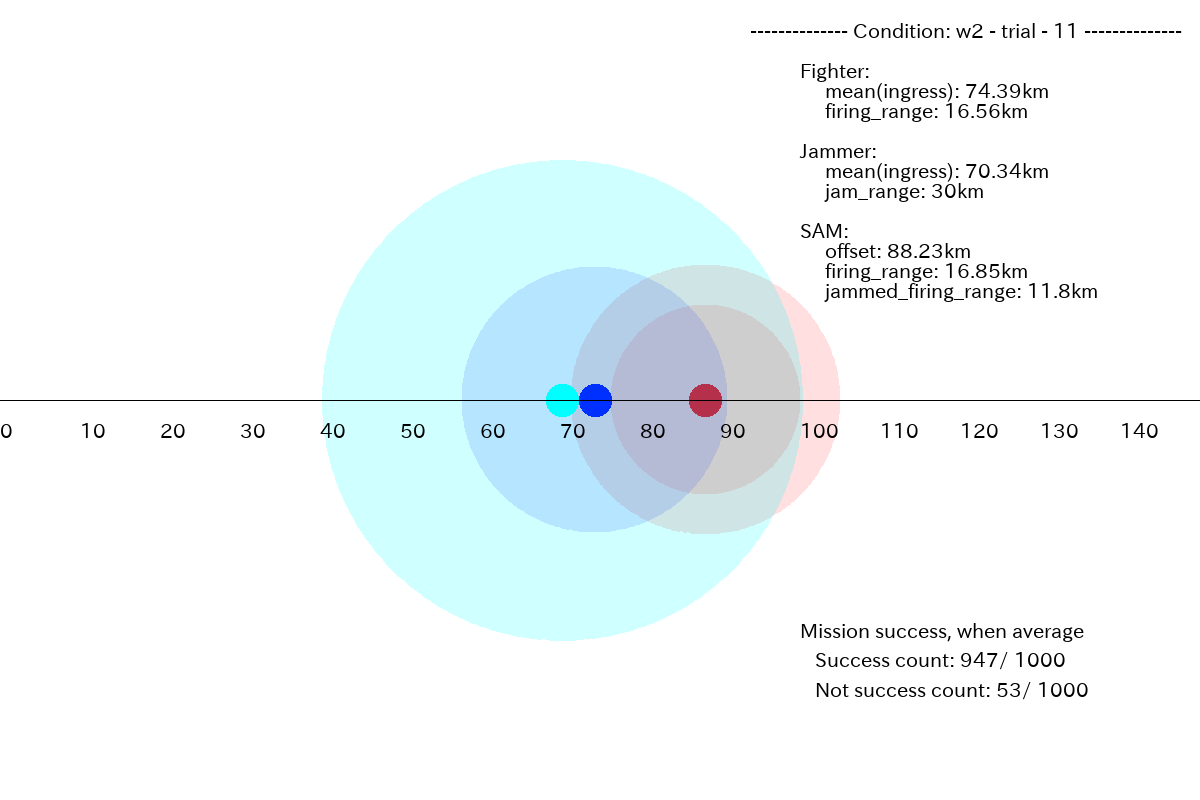

下図のプランでは、Jammer を前方に進出させきれていません。その結果、成功するプランを生成できませんでした。

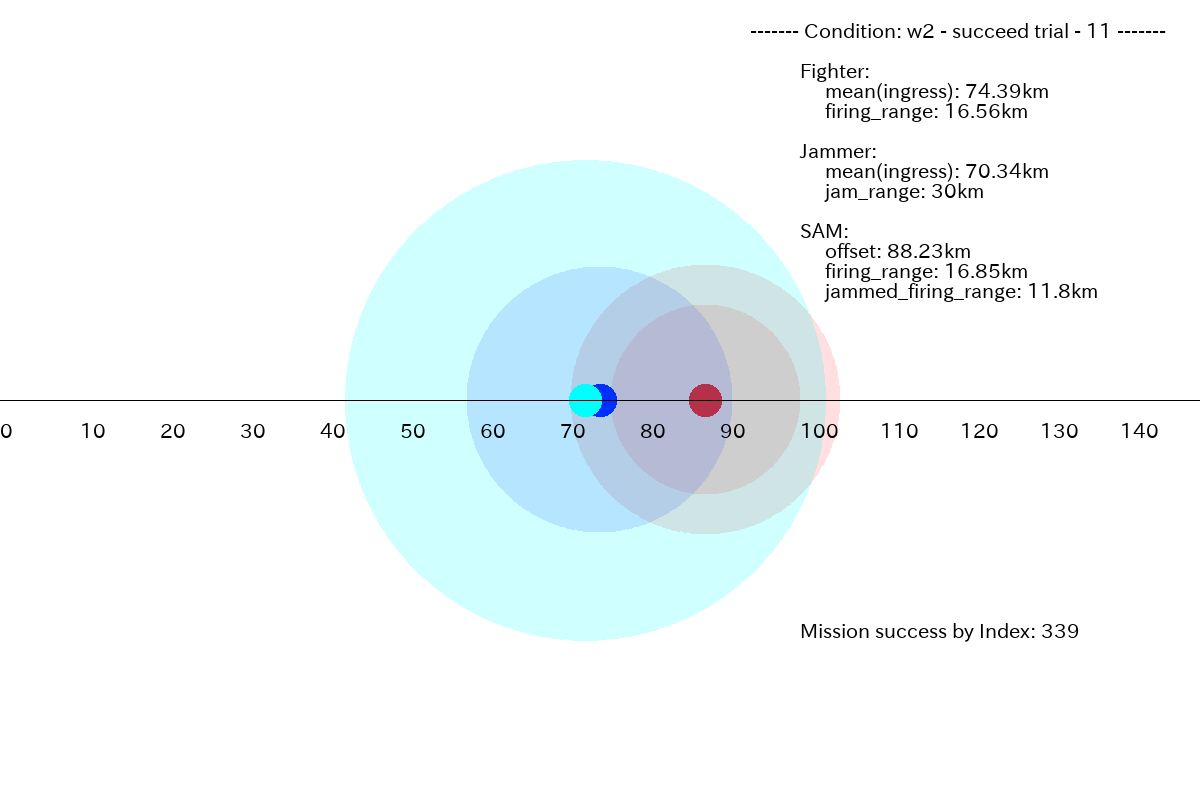

下図は、上と同じミッション条件ですが、成功したプランです。Jammer をギリギリまで進出させています。

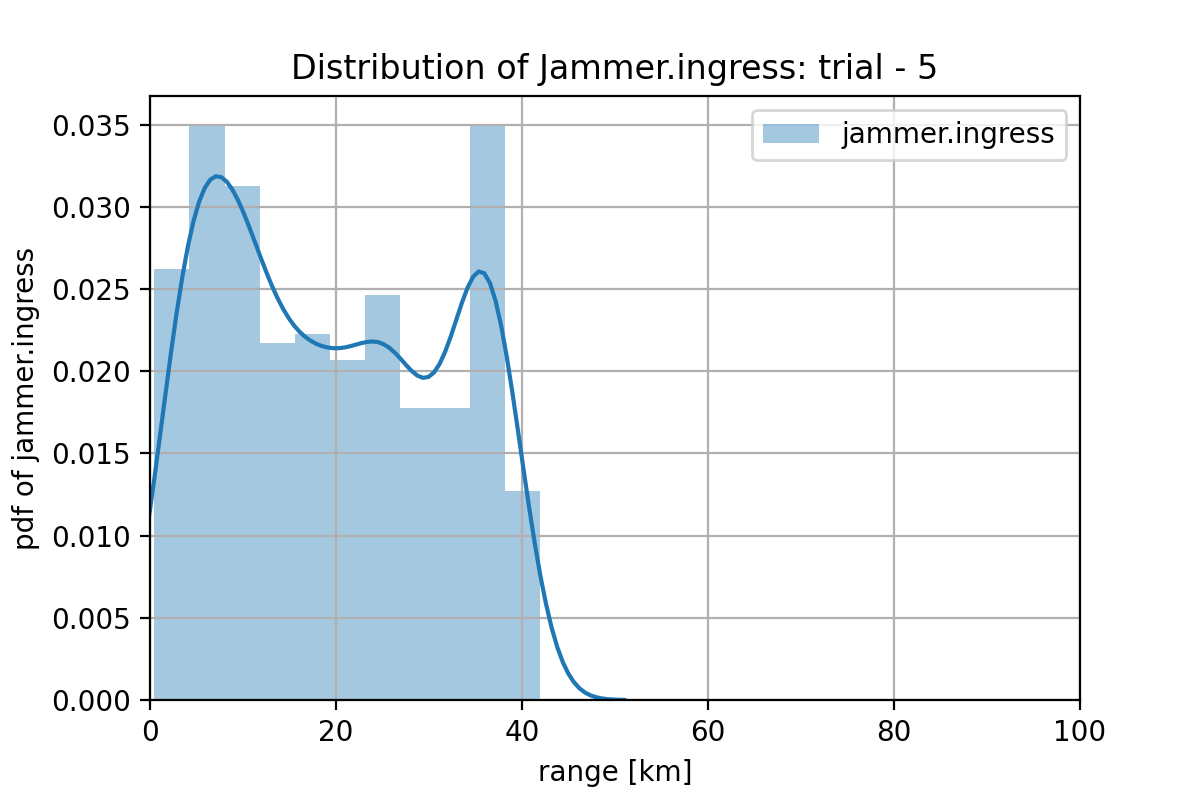

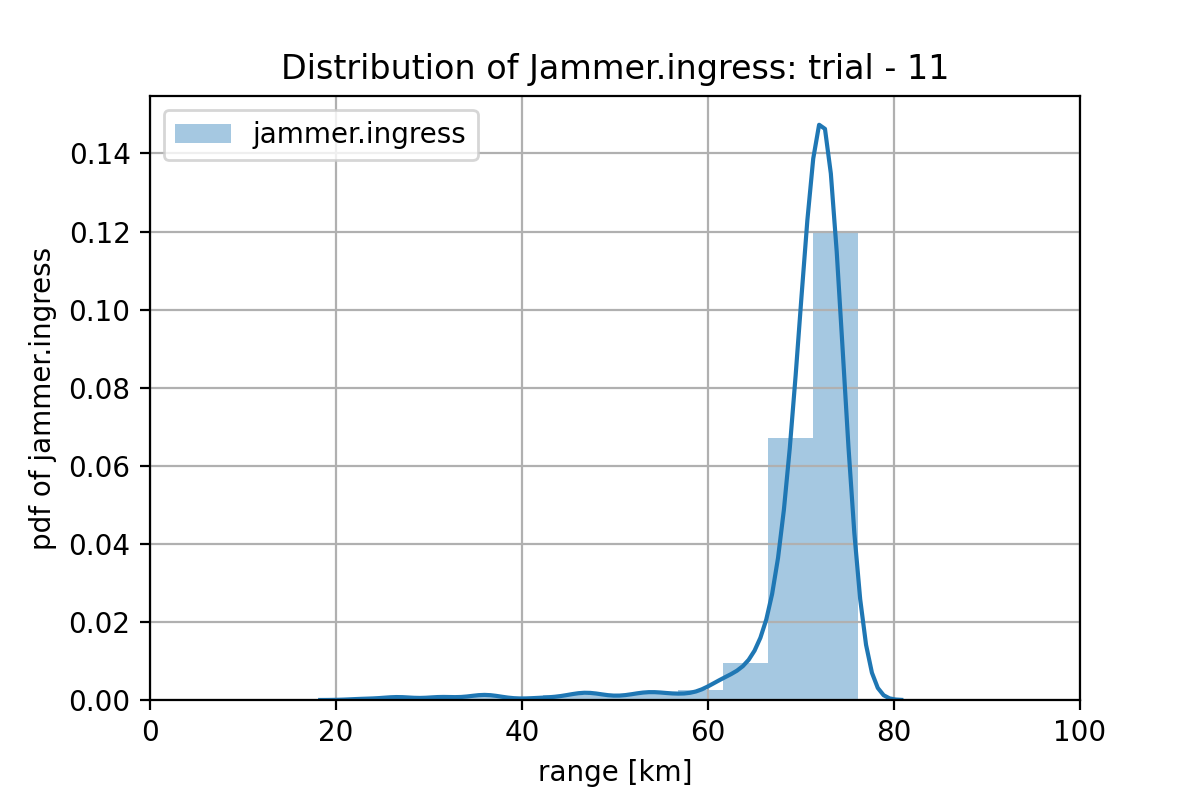

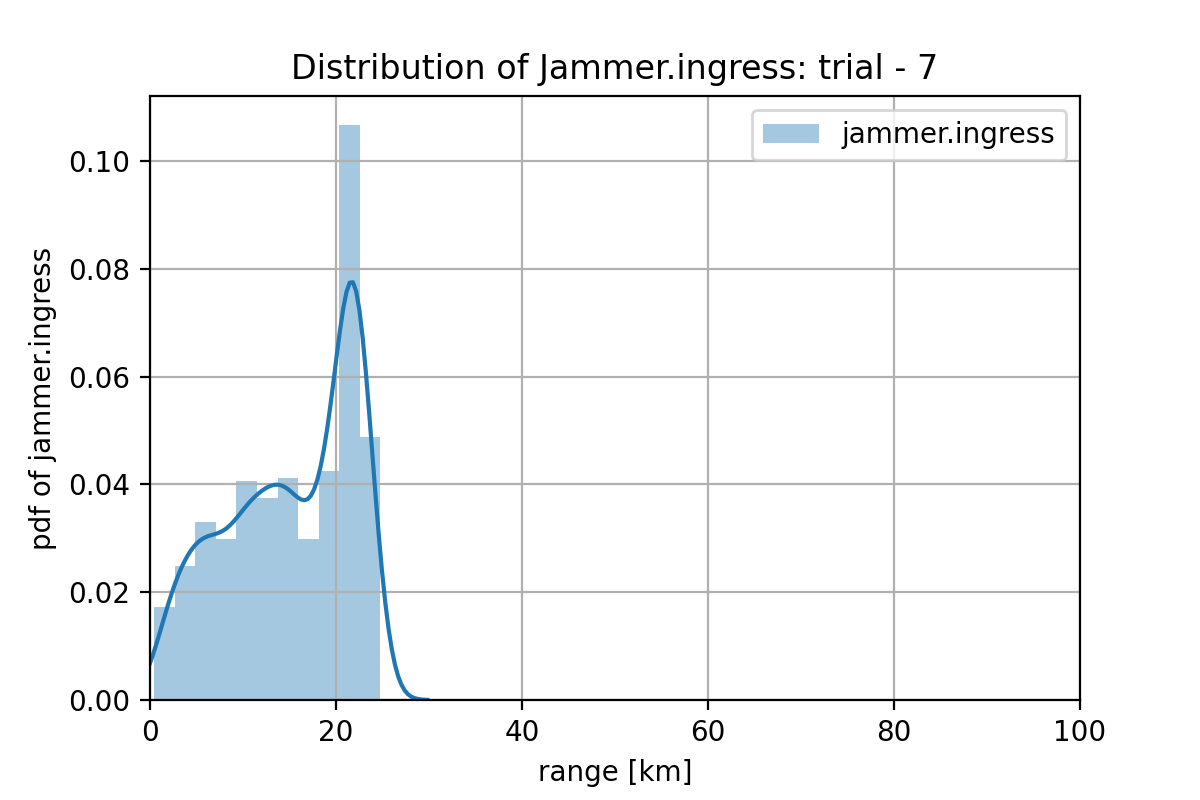

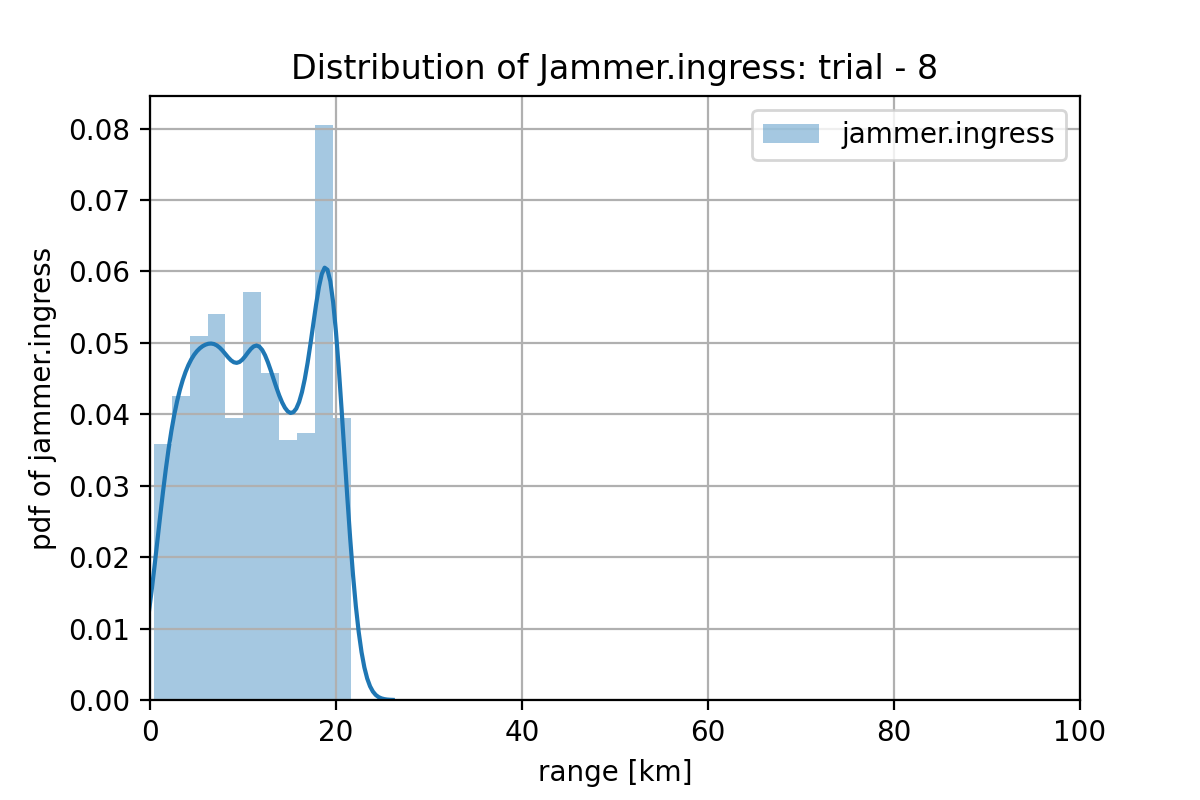

このミッション条件でのプランの分布は下図になっています。Jammerの分布が学習しきれていません。

3.3 ケースw3

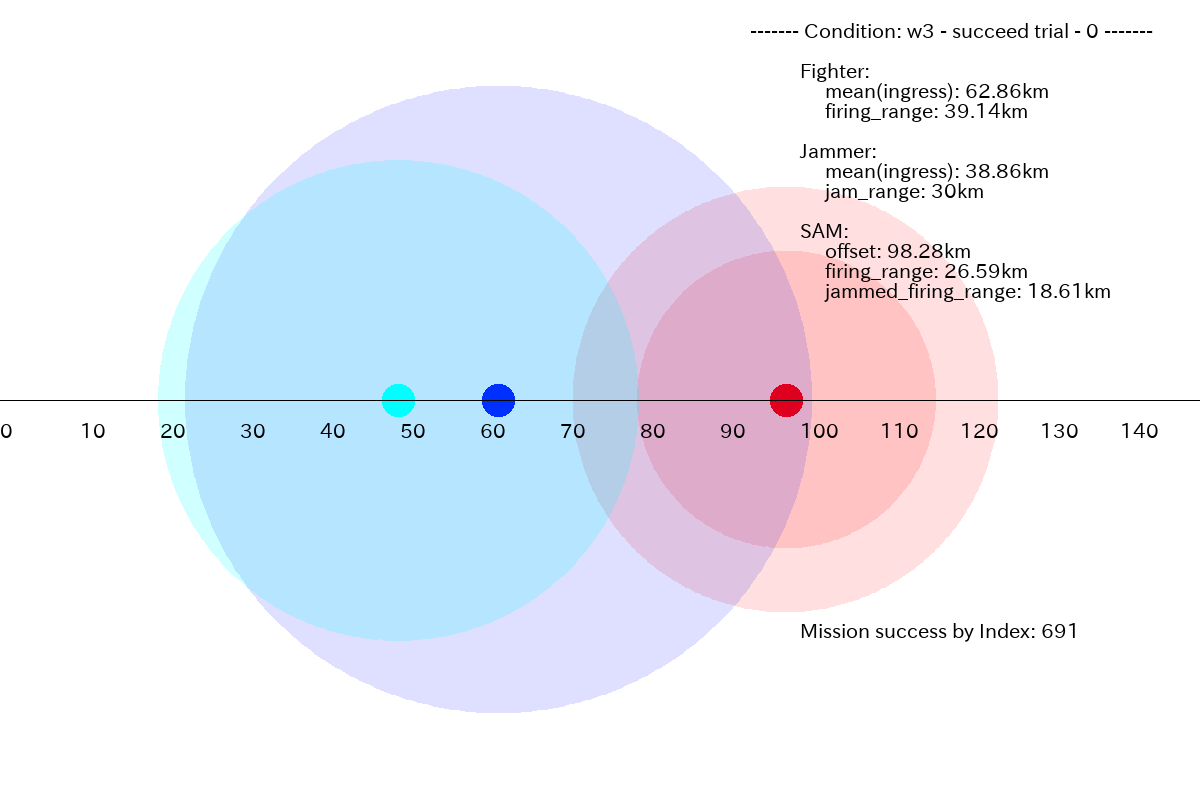

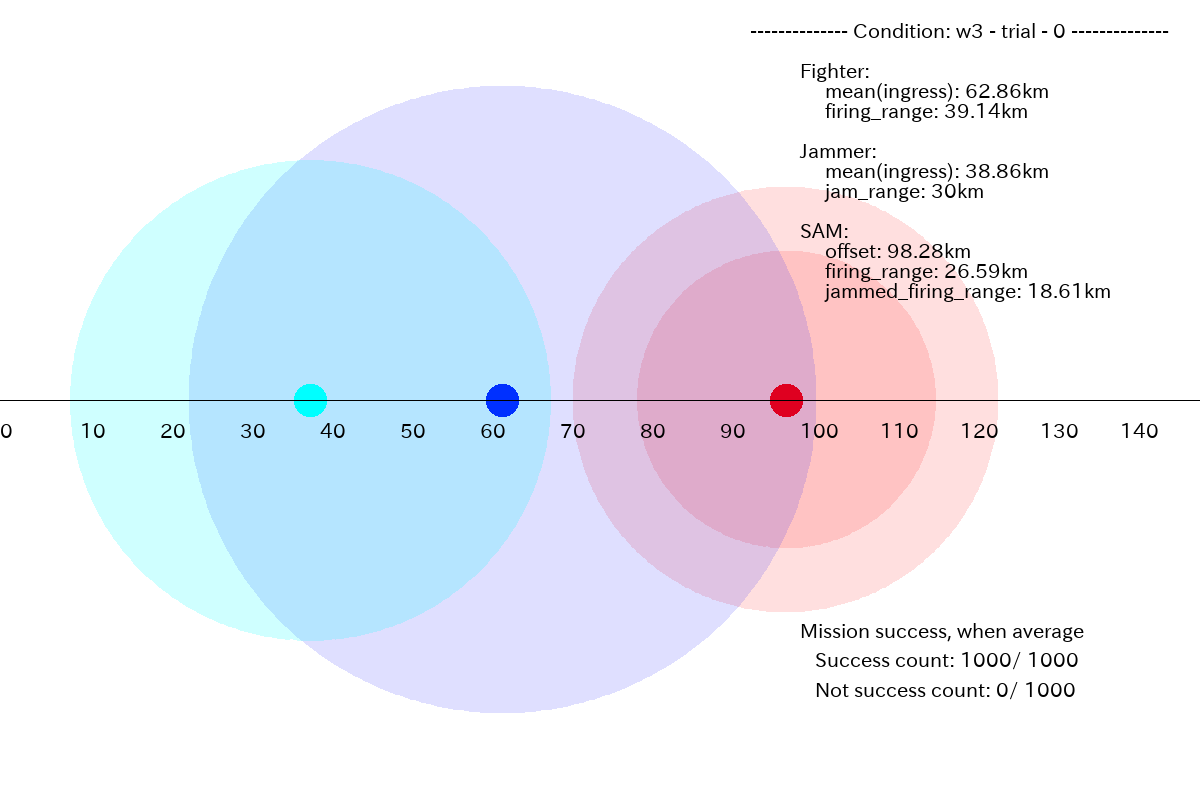

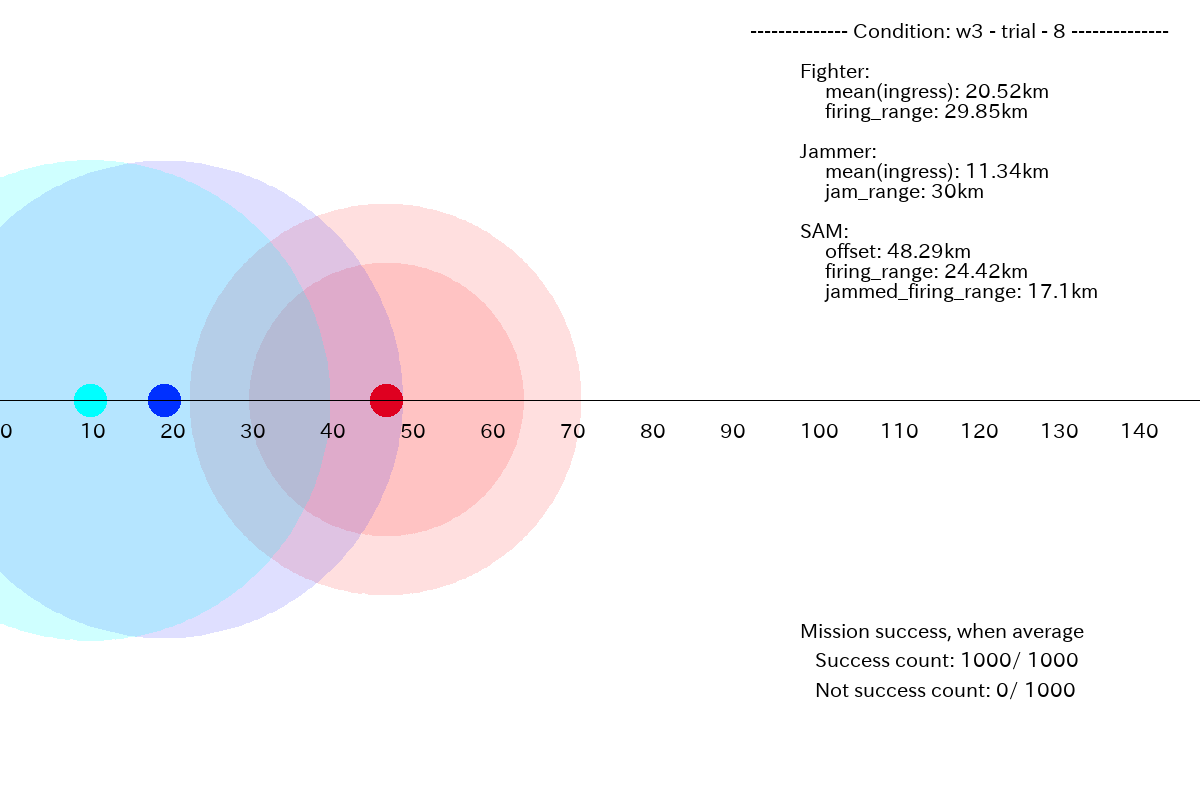

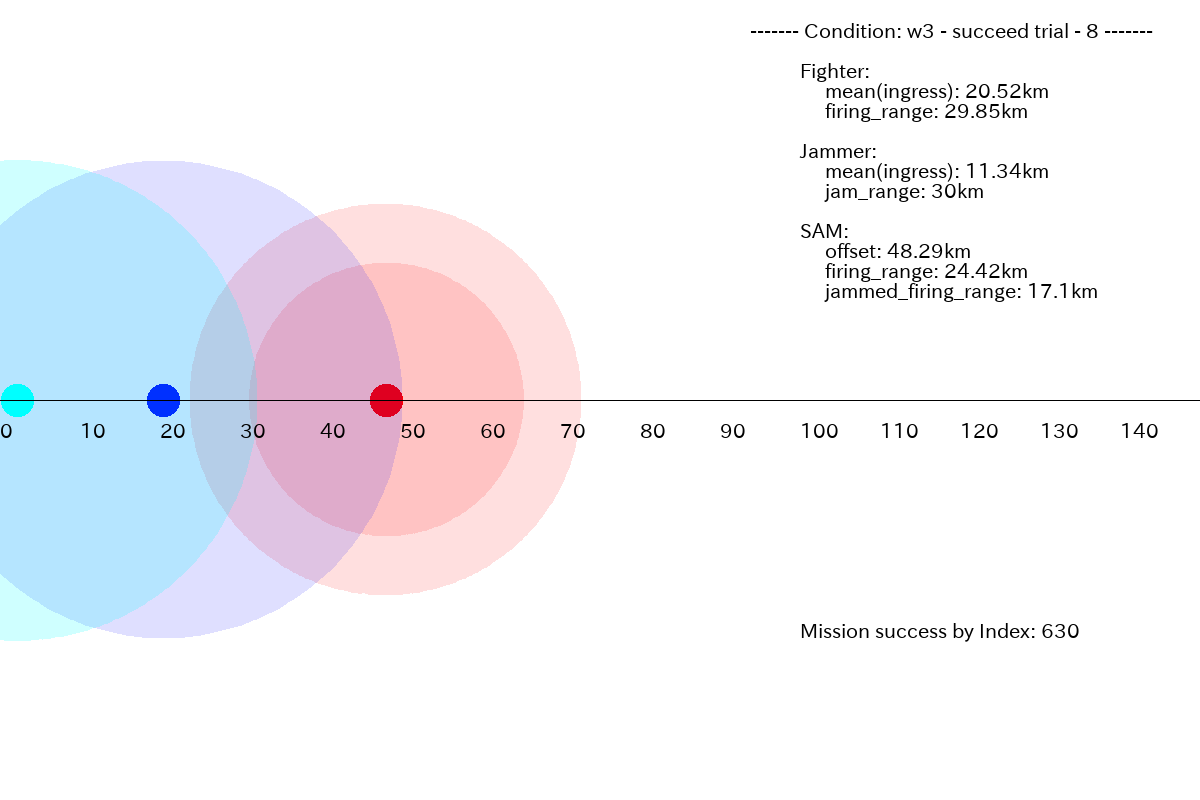

ケース3では、Jammer をあまり前に出さず、Fighter はギリギリまで前に出すようなプランの分布が学習できています。また、成功するプランが生成できる割合も 100% (=1000/1000) と高くなっています。

プランの平均としても成功しています。

下図は別のケースの例です。

プランの分布は下図になっています。

4. GAN のロスと精度(accuracy)履歴

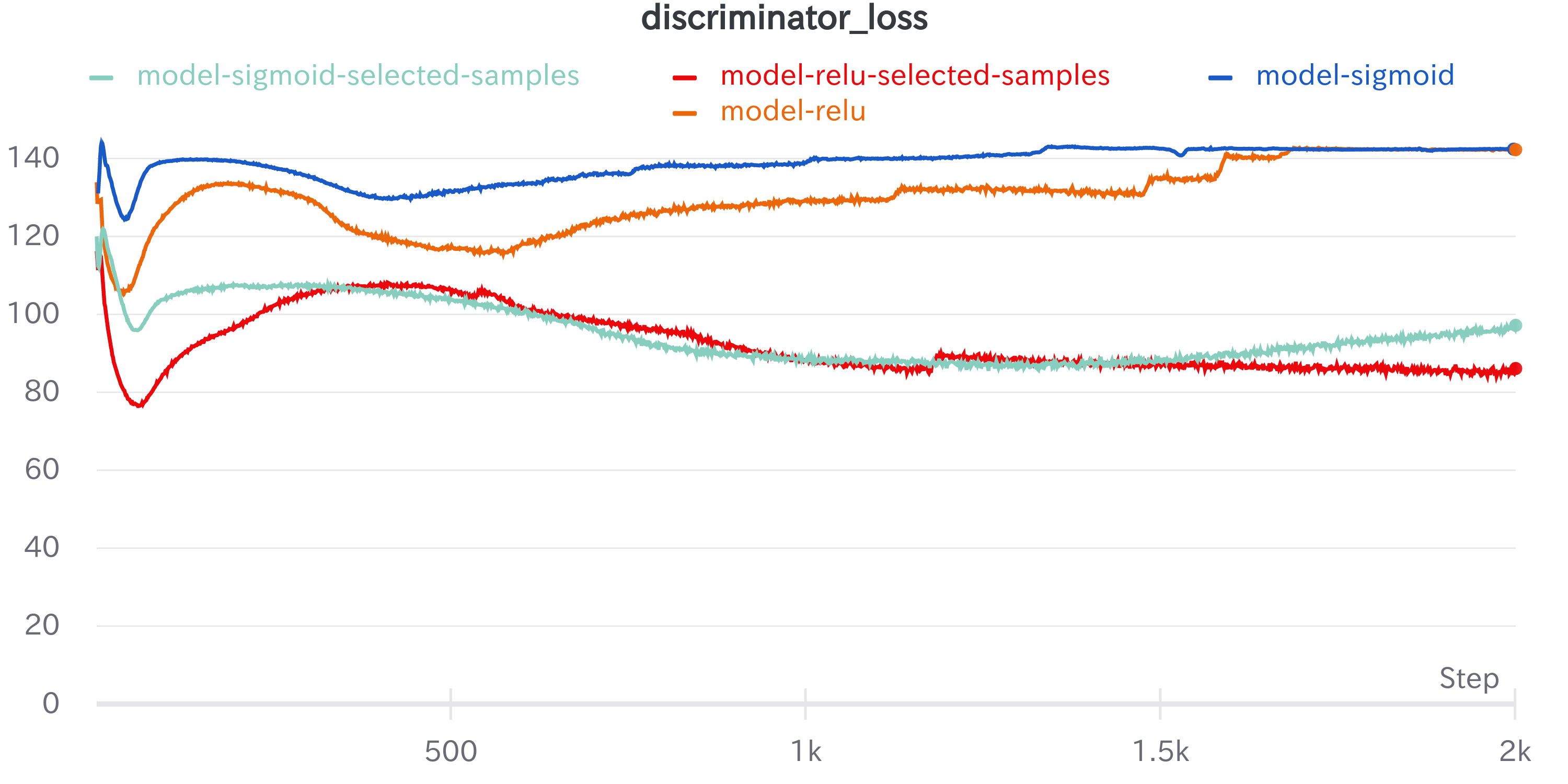

参考までに、GAN の GAN のロスと精度(accuracy)のトレーニング履歴を記載しておきます。解釈は難しいのですが、少なくとも学習が不安定になったりはしていないようです。

5. まとめ

1次元問題に対する GAN によるミッション・プランナーの実装はこれで終わりです。やってみた個人的な感想を纏めておきます。

5.1 GAN によるミッション・プランニングについての感想

-

画像生成や音楽生成といったエンタメ領域だけではなく、データ(或いは、グッドなシミュレータ)さえあれば、ビジネス領域でも GAN が使えそうだ、という感じがしました。

-

多数のプランを確率的に生成でき、(Explainable とまでは言いませんが)、プランの統計量を見ることで、どういうプランを Ai が生成しようとしているのか見えてくるのは、大きな強みだと思いました。強化学習でも、[C51](A Distributional Perspective on Reinforcement Learning)など価値函数の分布を求める試みはあるのですが、あまり進んでいないのが現状です。(ただでさえもなかなかうまく学習してくれず、尋常ではない計算機パワーとコーディング能力を要求される強化学習で、そこまでやるのは大変な気がします)。 -

当たり前ですが、トレーニング・データは非常に重要です。このやり方で良いプランナーを作るには、GAN で生成したい内容を、まんべんなく、しかも一様に表しているデータを集めることが、一番のキー・ポイントとなる気がしました。このためには、ドメイン知識が非常に重要になると思います。

5.2 不満点とアイデア

今回実装したGANは、プランの成否について何も教えてくれません。成功しようがないミッション条件でも、何食わぬ顔で失敗プランを提示して来ます。これは問題です。プランの成功確率等を併せて提示して欲しいと思います。

これは、成功、不成功の2クラス分類問題、或いは、w1, w2, w3, l1, l2 の多クラス分類と考えれば、ACGAN の枠組みが使えるような気がします。(気がするだけで、よく考えたわけではありません)。これは面白そうなので、そのうちやってみたいところです。

Conditional Image Synthesis With Auxiliary Classifier GANs, 2016

conditional GAN の代わりに、conditional VAE (Variatiuonal Auto Encoder) を使っても同じようなことができそうです。この場合、通常のVAE と違って、潜在空間次元は入出力次元よりも大きくする必要があると思われます。これは、成功ミッションとプランを埋め込んだ潜在空間(多様体)を学習するという意味でなんだかおもしろそうな感じがしますので、その内時間があればやってみたいところです。

Semi-Supervised Learning with Deep Generative Models, 2014

Learning Structured Output Representation using Deep Conditional Generative Models, 2015

(その7)へ続く

(その7)からは、ミッション・プランニング問題を強化学習でアプローチします。