PUI PUI モルカー

毎週火曜に数分のショートアニメが放送されている”PUI PUI モルカー”.

パペットキャラ・アニメとして,愛らしいモルモットの姿をした車『モルカー』の愛嬌と,その裏に存在する人間の愚かさを見事に表現した作品です.

2月14日は #バレンタインデー 💞

— PUI PUI モルカー【公式】 (@molcar_anime) February 12, 2021

チョコ🍫ポテト🥔シロモ🥬のバレンタインカードをプレゼント!

チョコレートに沿えるもよし、メッセージを書き込むもよし。ぜひ、週末のバレンタインにご活用ください💌

#モルカー pic.twitter.com/qXMjUs90Oa

今回,このモルカーと現実の車の画風を入れ替えるとおもしろそうなのでは?と思ったのと,またちょうど試してみたいGANもあったので実験してみました.

CycleGAN

今回使用したのはCycleGANです.

このGANは,ある入力領域(ソースドメイン)$X$から別の領域(ターゲットドメイン)$Y$に画像の変換を行います.

ICCV 2017 ["Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks"](https://arxiv.org/abs/1703.10593) Jun-Yan Zhu, Taesung Park, Phillip Isola, Alexei A. Efros Berkeley AI Research (BAIR) laboratory, UC Berkeley

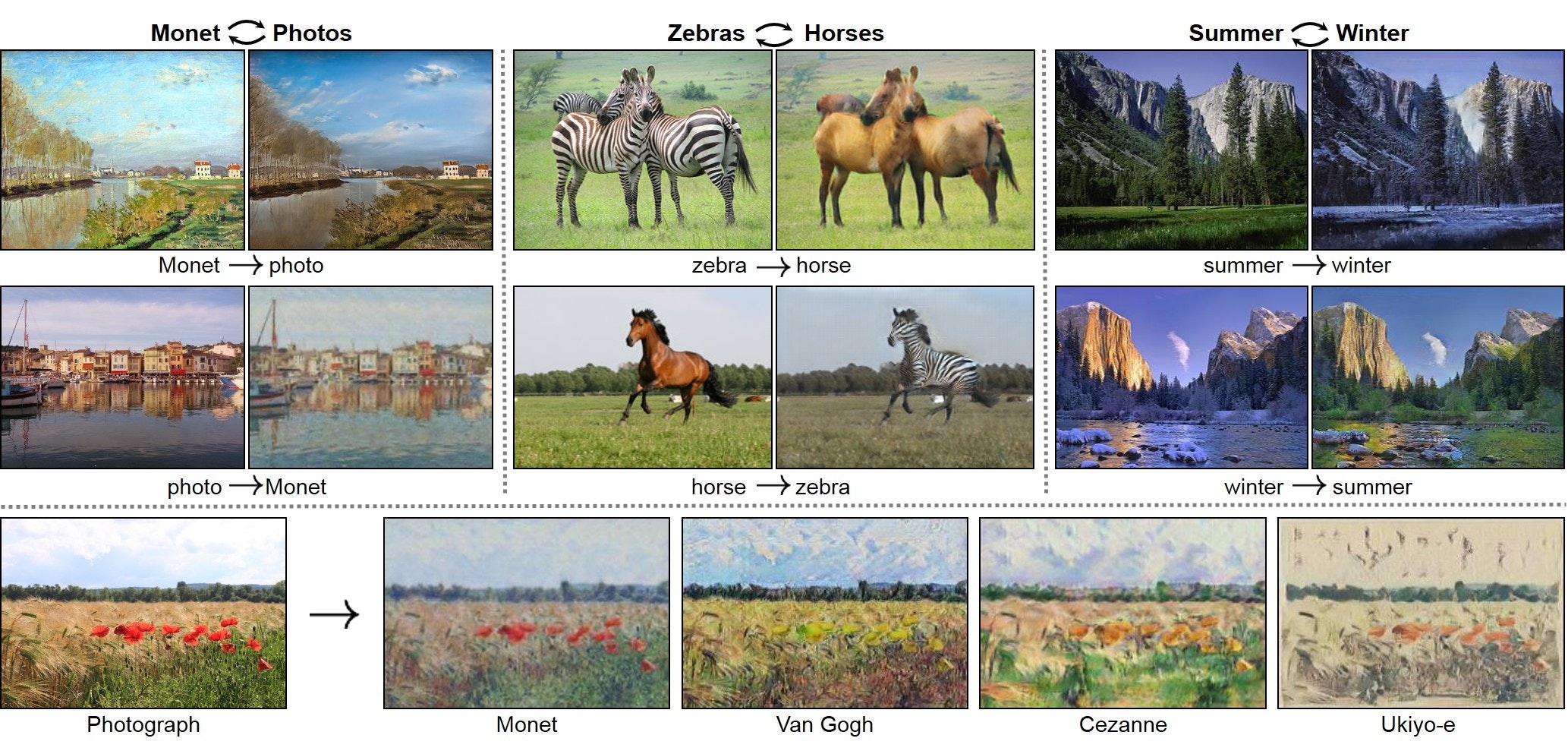

図のように,シマウマの画像をウマに変換したり,モネの絵を実写風に変換したり,その逆変換だったり...と,『画像特有の特徴』を学習し,自動的に変換を行います.

そもそもGANとは?ですが,簡潔に述べると2つの学習モデルがお互いに競い合いながら学習を進めあう,**敵対的生成ネットワーク(Generative Adversarial Networks)**と呼ばれるニューラルネットワークの一種です.

詳しい説明は省かせていただきます.ググったらわんさか記事が出てくるのでお許しください.

上図のように,入力された画像を別の領域に変換するGenerater(図ではG)と,入力された画像がGeneraterが生成した画像か,本当の学習用データかを分類するDiscriminator(図ではD)とが,お互いの出力,評価を基準に学習を進めていく構造となっています.

では,どのように画像の特徴だけをとらえきれるのか?には通常のGANには存在しない三つの評価基準が存在するためです.初学者向けに数式をあまり使わずにシンプルに説明しますが,詳しくは本論文や他の記事を参照してみてください.

評価関数

CycleGANは,3つの損失関数をもち,この損失関数を減らす方向に学習を進めていきます.

1つが妥当性損失(validity).これは通常のGANにもあるように,Generatorが生成した画像がどれくらいDiscriminatorを欺いたか?によって定義されます.

次に復元性損失(reconstruction).これは領域Aから領域Bに変換するGenerator($G_{AB}$)と,それとは逆方向に変換するGenerator($G_{BA}$)を順に適用したとき,どれくらい元の画像に近づくか,によって定義されます.$A$➡$B$➡$A$となるため元の画像の特徴に戻るのは当たり前ですよね.

最後に同一性損失(identity).これは領域Aの画像をGenerator $G_{BA}$に適用したとき,画像がどれだけ変化しないか?によって定義されます.

余談ですが,同一性損失これがなくてもCycleGAN自体は作用するよ~と書いてる記事を多く散見するんですが,これがあるとないとでは生成される画像の質が全然違います.これがないとリンゴとミカン変換するモデルで葉っぱが赤,オレンジ色に変わったりします.

これらの損失関数をもとに,画像の領域変換を行っています.数式で説明してくれ~って方はこちらの記事を参考にしてみてください.

準備

データセットを集めます.今回は車とモルカーの変換ですので,車の画像とモルカーの画像を集めます.

車画像

スタンフォードAI研究所から提供されている自動運転AI学習用の車の外面画像を使わせていただきました.今から君たちにはモルカーになってもらいます.

モルカー画像

アニメ1~3話までのyoutube見逃し配信から,モルカーが大きく映っている画面をトリミングしてデータセットとし,画像をおよそ100枚ほど集めました.1~3話を50回以上繰り返して視聴して集めたのでその日の夜シロモが夢に出てきました.

また,データオーグメンテーションとして画像の反転処理を施しています.

学習

今回のデータセットの内訳は次のようになっています.

| Real Car | MarCar | |

|---|---|---|

| Training Images | 140枚 | 138枚 |

| Test Images | 27枚 | 36枚 |

| 全て256*256にリサイズ処理を施しています. |

CycleGANの元コードはGithubからクローンし,モルカー変換用に少し変更します.

CycleGAN-tensorflow-2

パラメータは以下の通り.

バッチサイズ...1

epoch数...150

epoch_decay...100

Adamオプティマイザ学習係数…0.0002

$β$...0.5

cycle_loss_weight=10.0

identity_loss_weight=5.0

ほぼデフォルトと変わりませんが,時間の関係上すこしepoch数を減らしての学習となっています.画像枚数が極端に少ないためこの程度でも十分学習は進むとの考えでした.

あとデフォルトでidentity_loss_weightが0に設定されているので,これを5.0に設定.これで同一性も保たれるはずです.

結果

2000iteration.図は左:元画像 真ん中:CycleGANが領域を変換した画像 右:もう一度変換し元の領域に戻したもの となっています.

Real Carのほうはすでにかなりモルカーの世界観に近づいています.

10000iteration.色味も大きく変換されています.ただReal Carの背景色も大きく変換されており,車本体以外のところからも特徴を抽出していることがわかります.現に,MarCar画像の背景は現実に即した灰色に変化しています.

まとめ

学習画像が極端に少なかったですがモルカーと現実の変換がうまくできているように感じました.

もう少しアニメの話数が追加されたらその分データセットも追加できるので今後に期待です.

みんなもモルカーを見よう!!(宣伝)