こんにちは。12/11〜12の二日間、オンラインで開催された Snowflake BUILD Japan 2025 を聴講しました。

本稿では、イベント全体を通じて見えてきた「AI時代のデータ基盤」に関するトレンドを、私自身の視点を交えながらまとめます。

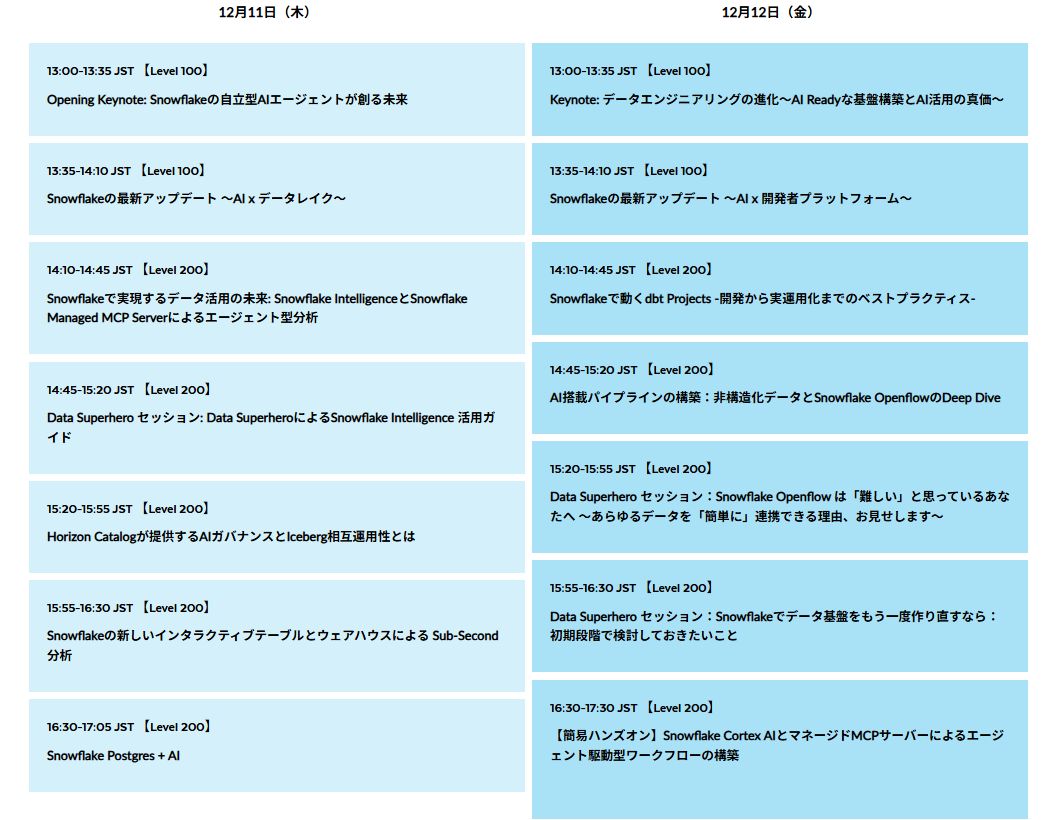

2日間で計14セッションが用意され、登壇者の立場もテーマも多様でした。重複して見える論点でも切り口が異なるため、Snowflakeに限らずAI時代のデータ基盤の潮流を多角的に捉えることができた、非常に有意義なイベントでした。

本イベントで学べる事

引用元:https://www.snowflake.com/build-japan-online/

セッション一覧

引用元:https://www.snowflake.com/build-japan-online/

トレンドまとめ

イベント全体を通して、Snowflakeが取り組む最新トレンドを整理すると、次の7点が特に印象的でした。

1. AI‑Ready

まず強く共感したのは、AI活用の要はデータにあるという点です。AIを使いこなすための前提条件は、質の高い大量データを収集し、それをAIに適した形で提供できる仕組みが整っていることと私は考えています。AI時代にはデータ収集・提供の基盤が一層重要になりますが、Snowflakeはこの考えを 「AI‑Ready」 という言葉で端的に表現していました。今回の各セッションの説明は、このAI‑Readyというキーワードに全て通じるものだと感じました。

2. データの民主化

「データの民主化」は近年頻繁に耳にする言葉ですが、示唆に富んでいると思います。裏を返せば、従来のデータ活用がエンジニアによって独裁化(!?)されていたとも言えます。私の理解では、「必要なデータを誰もが活用できるよう、ITスキル面のハードルを可能な限り下げること」 です。

この観点で印象に残ったのが、自然言語でのデータ分析 と dbt連携強化 です。前者はプログラムやSQLを書かずに、自然言語でSnowflakeへ問いかけるだけで、グラフや表、説明文を含む回答が返ってくるようになります。(導入には Snowflake Cortex AI とマネージド MCP サーバの知識が必要です。ハンズオンは2日目に紹介され、日本語解説の後、英語版が公開されています:https://github.com/tsho/MCP-HOL-BUILD-2025-JA)。後者のdbtはELTのT(変換)工程をSELECT文中心で構築できるため、従来のプログラミング実装に比べて敷居を下げる取り組みとして位置づけられるでしょう。

dbtとは

https://www.getdbt.com/product/what-is-dbt

3. リアルタイム

AIの意思決定やエージェントの次アクションは「5分前の情報」より「今」の情報に基づく方が高付加価値である場合が多いのは明らかだと思います。Snowflakeは リアルタイム性の向上 に向け、Interactive Table と Snowpipe の組み合わせでSub-Second応答(概ね1秒以内の応答)を目指しています。従来は列志向テーブルとSnowpipeの組み合わせにより、マイクロバッチで増分取り込みを行うアプローチが中心でした。対してInteractive Tableは行志向で、イベント駆動のイベントデータ取り込みに適した性質を持ち、真にリアルタイムなストリーミング分析 を実現することが可能になったと理解しました。

4. ゼロETL

「ゼロETL」は、その言葉の印象だけで「ETLが不要になる」と捉えられがちですが、実態は ETLパイプラインの構築・運用負荷を最小化し、データ移動を可能な限り減らすための統合アプローチ と捉えるのが妥当でしょう。Snowflakeの説明では、クラウドやリージョンを横断して、アプリやAIモデル、エージェントを含めたデータ共有をセキュアかつ即時に実現し、AI‑Readyを維持する目的が示されていました。AWSの定義も、従来の複雑なETLを排し、ポイントツーポイントのデータ移動や、データを移動せずにサイロ間でクエリ可能にする統合という趣旨で一致しているようです。

ゼロETLの説明

SnowflakeにおけるゼロETLを支える主要機能として Openflow が紹介されました。GUIでフローを描く感覚でパイプラインを設計でき、ローコード的に導入・改変しやすいのが特長です。

Openflowを使ったELT処理開発のイメージ

5. 非構造化データへの取り込み

AI‑Readyなデータを揃えるうえで、非構造化データの取り込み は避けて通れません。世界のデータの大半が非構造化だとされるなか、Cortex AIのOCRで画像からテキストを抽出したり、SharePoint内のドキュメントから取り込むといったユースケースが紹介されました。これらは、分析や検索、生成系AIの前処理としても有効なアプローチだと思いました。

6. ガバナンス強化

データ基盤の利用が拡大するほど、ガバナンス(可視化・統制・コンプライアンス) が重要性を増します。Snowflakeは Horizon Catalog により、Snowflakeのリソースのみならず、Icebergを介したサードパーティのリソースも含めたメタデータ管理・発見性の強化を図っています。ガバナンスをプラットフォームレベルで支援する姿勢が、企業全体でのデータ活用を後押ししている印象です。

7. Iceberg連携

Apache Icebergは、オープンなテーブルフォーマットとして、ベンダーロックインを抑制します。構造化データだけでなく、非構造化データをRDBMSテーブルのように扱うための仕様であり、「オープンなレイクハウス」の要となると位置づけられます。Snowflakeクラウドからデータレイク上の資産をRDBMS的な操作感で取り扱える点は、運用の一貫性や可搬性の観点でもインパクトが大きいと感じました。

Apache IcebergとSnowflakke

https://www.snowflake.com/ja/blog/apache-iceberg-data-lakehouse-architecture/

参考になったセッション

PostgreSQLでのOLTP対応 の話は個人的にとても大きなインパクトがありました。トランザクション系のOLTPワークロードをPostgreSQLで賄いつつ、従来のDWH分析と同一クラウド内で取り扱えるようになることで、Snowflakeクラウド上で多様なワークロードを一気通貫に設計できる可能性 が広がるからです。

また、AI導入以前の普遍的・重要な考慮事項 に関する二つのセッションも印象的でした。

小宮山紘平さん(Data Superhero)の「Snowflake Intelligence 活用ガイド」では、AI導入の前提として 業務フローの整理と適用領域の明確化 の重要性が改めて強調されました。AIは手段であり目的ではない——この原則に立ち返る姿勢は、実務において極めて重要です。

近森淳平さんの「Snowflakeでデータ基盤をもう一度作り直すなら:初期段階で検討しておきたいこと」では、Snowflake設計の初期段階で押さえるべき論点が、実務経験に基づき丁寧に解説されました。Snowflakeに留まらず、データ基盤設計のベストプラクティスとして汎用性の高い内容だと感じます。

個人的な課題感

今回の知見を踏まえ、今後さらに深掘りしたいテーマが二つあります。

一つ目は、ゼロETLに伴う密結合の懸念 です。ゼロETLが「ETLパイプラインの構築必要性を排除・最小化する統合」であればあるほど、連携への依存が高まり、設計次第では結合度が上がる懸念があります。Kafka等のメッセージングPF を介したイベント駆動の疎結合化や、Icebergのようなオープンテーブルフォーマット を用いたベンダーニュートラルな運用による疎結合化が、どこまで有効に機能するのかを考察していきたいと思います。

二つ目は、Spark・Kafka連携の要否と使いどころ の整理です。データ界隈のベンダのエコシステム図では必ずといってよいほど登場しますが、Snowflakeの標準機能で十分なケースと、Spark・Kafka連携が有効なケースの境界はどこにあるのか。例えば Snowpipe と Kafka+Flink によるストリーミング処理の違い、Snowflake中心のアーキテクチャにおいて Spark が必要となる具体的な局面 などを比較検討し、理解を深めていきたいと考えています。

まとめ

本イベントを通じて、Snowflakeが 「AI‑Ready」「データの民主化」「リアルタイム」「ゼロETL」「非構造化データ対応」「ガバナンス強化」「Iceberg連携」 という7つの主要トレンドに積極的に取り組んでいることが印象的でした。AI時代の競争力は、データ基盤の設計と運用——すなわち 正しいデータを、正しい形で、正しいタイミングに届ける力 に直結します。改めて、データ基盤の進化こそがAI活用の鍵だと強く感じたイベントでした。

参考情報

本イベントで紹介された機能に関するチュートリアルを挙げておきます。興味のある方はぜひ手を動かしてみてください。

Openflowチュートリアル

https://www.snowflake.com/en/developers/guides/getting-started-with-openflow-for-cdc-on-sql-server/

MCPサーバーチュートリアル(自然言語によるデータ分析の導入体験。イベント参加者向けには日本語版が後日共有予定。以下は公開済みの英語版です)

https://github.com/tsho/MCP-HOL-BUILD-2025-JA