MLflowのモデルレジストリは、リアルタイムでの推論、ダッシュボード、そして、テスト、制御、自動化のためのコードスニペットを含むターンキーのモデルサービングを提供します。

DatabricksにおけるMLflowのモデルサービングは、機械学習(ML)モデルを自動的に更新されるRESTエンドポイントとしてホストするターンキーソリューションを提供します。これにより、データチームは、トレーニングから本格運用に至る、リアルタイムMLモデルのエンドツーエンドのライフサイクルを持つことができます。

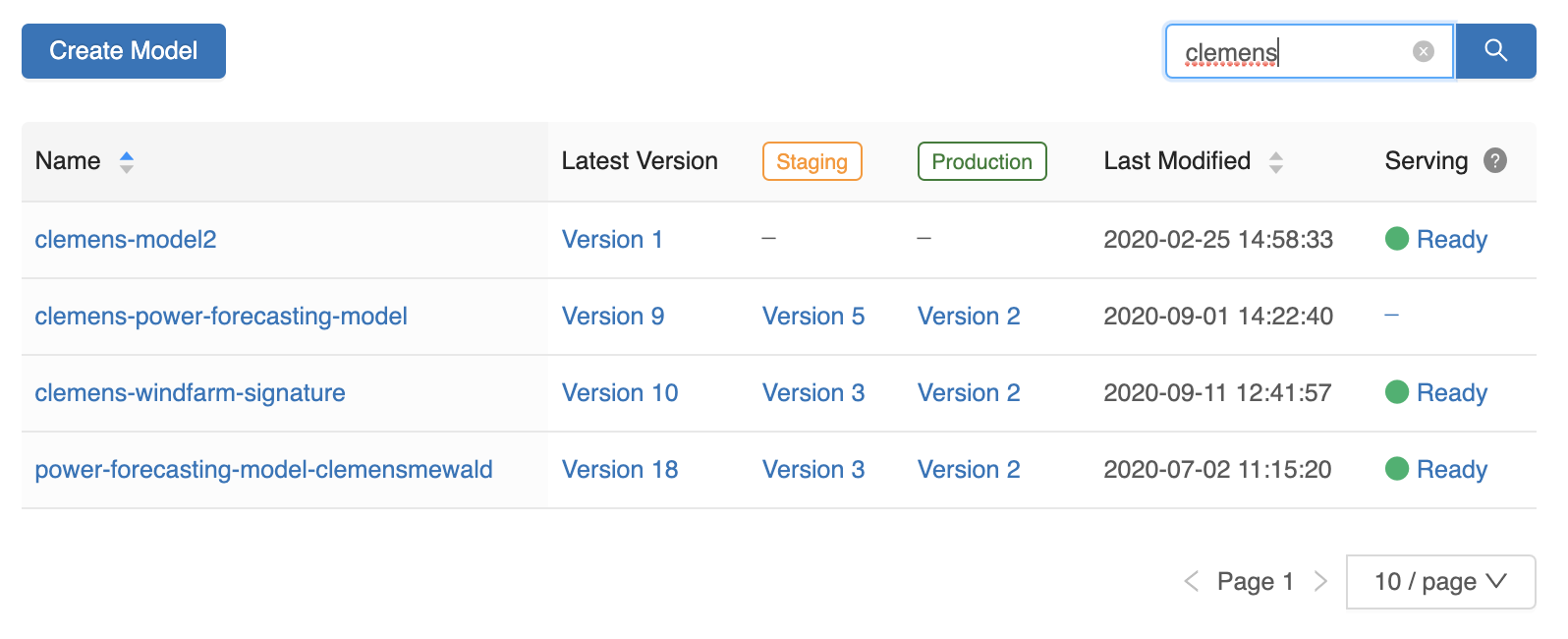

サービス提供開始以来、多くのお客様が自身で追加のインフラを持ったり、追加の設定を行うことなしに、シーミングレスにMLモデルをRESTエンドポイントとして提供することが可能となりました。さらにモデルサービングをシンプルにするために、MLflowレジストリはモデルサービングのステータスと、モデルサービングページへのリンクを表示する様になりました。

MLflowモデルの利用をさらにシンプルにするために、モデルサービングページでは、モデルをリクエストするためのcurlやPythonのスニペットを表示する様にしました。リクエストはデプロイされている最新バージョン(例: model/clemens-windfarm-signature/Production)、あるいは特定のバージョン番号のモデル(例: model/clemens-windfarm-signature/2)に対して送信できます。

Databricksのお客様は、このモデルサービングの機能を、ダッシュボードにおけるモデル予測やファイナンスチームへの予測結果の提供などいくつかのユースケースで活用されています。Freeport McMoRanは、プラントのオペレーションをシミュレートするためにTensorFlowのモデルをサービングしています:

"我々はプラントのオペレーションを最適化し、コストを削減するために、プラントにおける複数の異なるシナリオをシミュレーションし、意思決定するためのレコメンデーションをリアルタイムでレビューする必要があります。DatabricksのMLflowモデルサービングによって、エンドツーエンドのモデルライフサイクルを維持しながら、低いレイテンシーで機械学習から得られる示唆をオペレーターに対してシーミングレスに提供できる様になりました。"

DatabricksのModel Servingは現在(2020/11)パブリックプレビューです。そして、コスト効率が高く、管理容易性のためのMLflowモデルレジストリと密接に統合されており、リアルタイム予測のために、ワンクリックでのデプロイメントを可能にするものです。利用を開始する際にはこちらのドキュメントを参照ください[AWS, Azure]。本サービスは現在プレビュー中ですが、比較的ミッションクリティカルではなく、高いスループットが求められないアプリケーションで使い始められることをお勧めします。