##はじめに

2019年より思い立ってAIの勉強を始めました。その過程で、Raspberry Piカメラを

使った顔認証の仕組みを作ってみたのですが、学習の過程がイマイチ理解できません。

そんな時、SonyのNeural Network Consoleで、学習の途中出力結果を確認できるという

ことを知ったので、Pythonで作成したモデルをNNCに移行してみました。

ブラックボックスと言われるAIへの理解が進むことを祈りつつ。。。

##環境

Sony Neural Network Console Windows版 Version 1.4.0

##注意点

NNCの実行ファイルや使用する画像のパスには、全角文字や半角スペースを含めない。

##1.NNCのダウンロード

こちらよりダウンロードします(およそ1GB)。

##2.データセットの作成

####2-1.上記の注意点を考慮しつつ、画像を人物ごとのフォルダに格納しておきます。

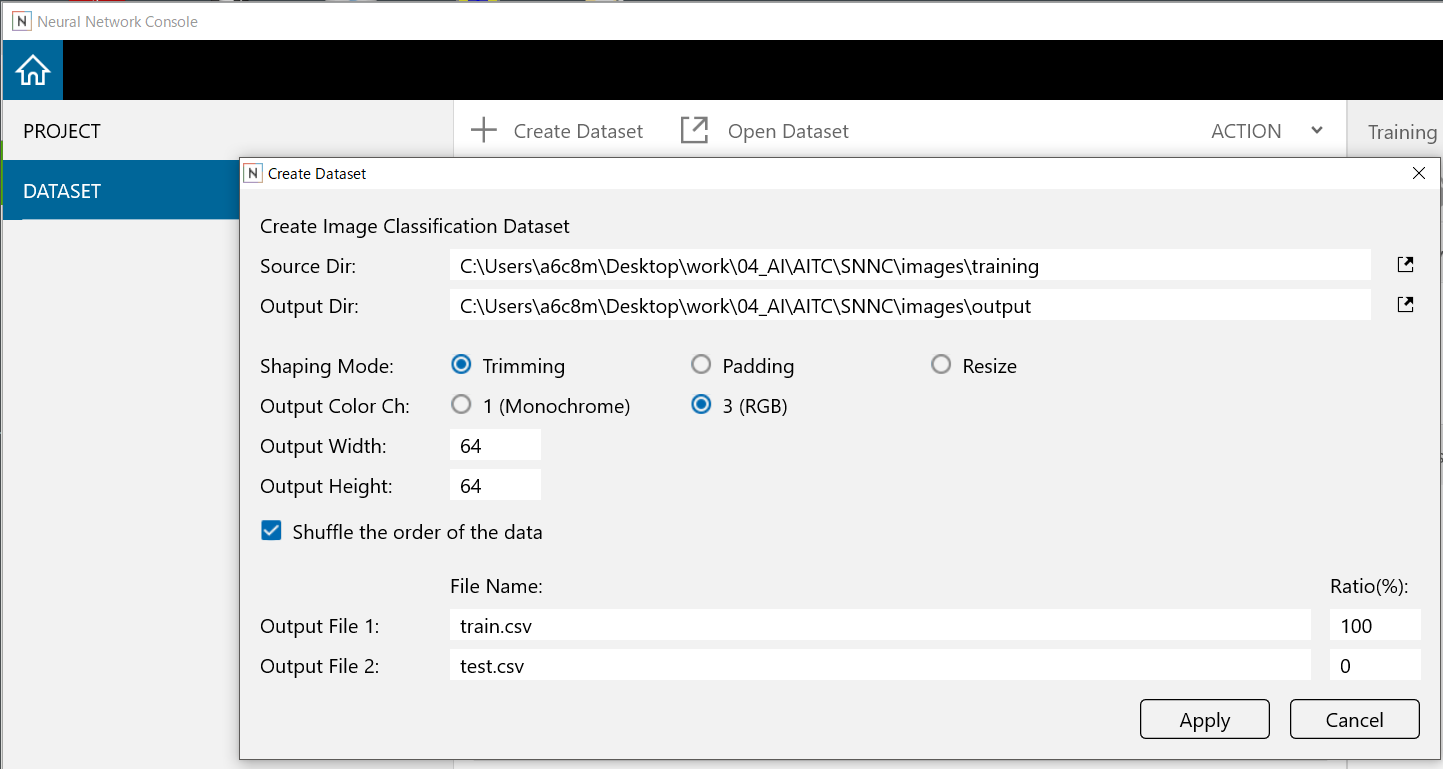

####2-2.NNCのDATASETタブからCreate Datasetをクリックし、パスや色、サイズを設定する。

##3.モデルの作成から検証まで

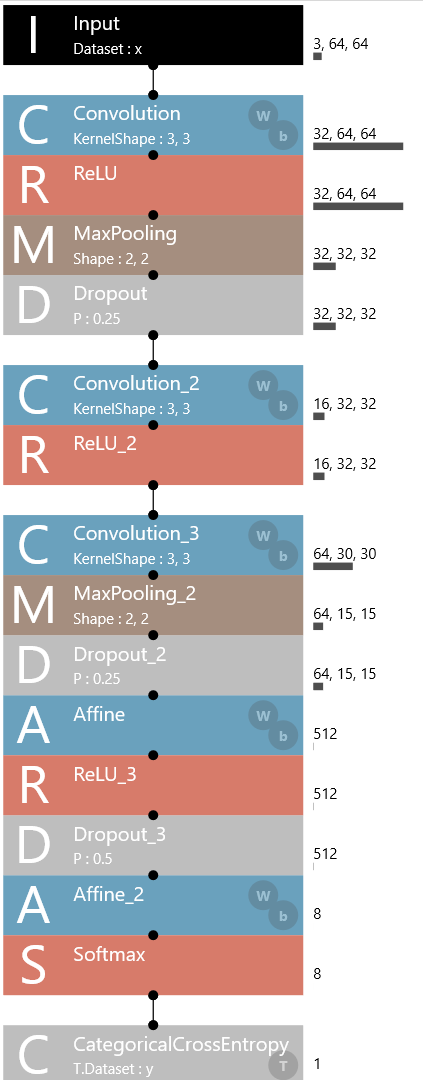

####3-1.Raspberry PiカメラでDeepLearningによるリアルタイム顔認証のモデルをNNCで再現する。

####3-2.Trainingを実行する。

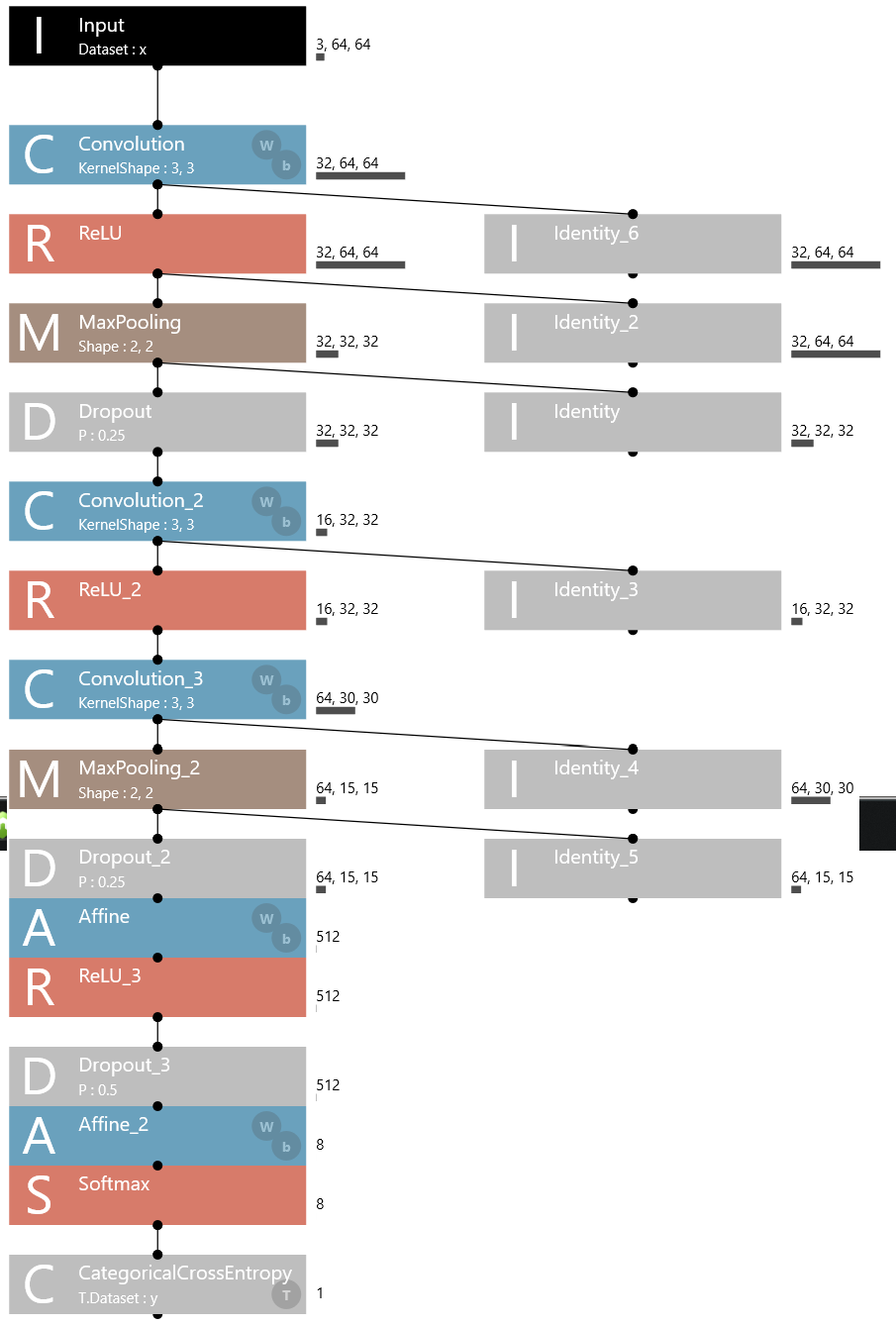

####3-3.途中出力を確認できるようモデルを追加し、Evaluationを実行する。

チュートリアルの「学習されたニューラルネットワークの途中出力を分析する」を参考に、

モデルを追加する。

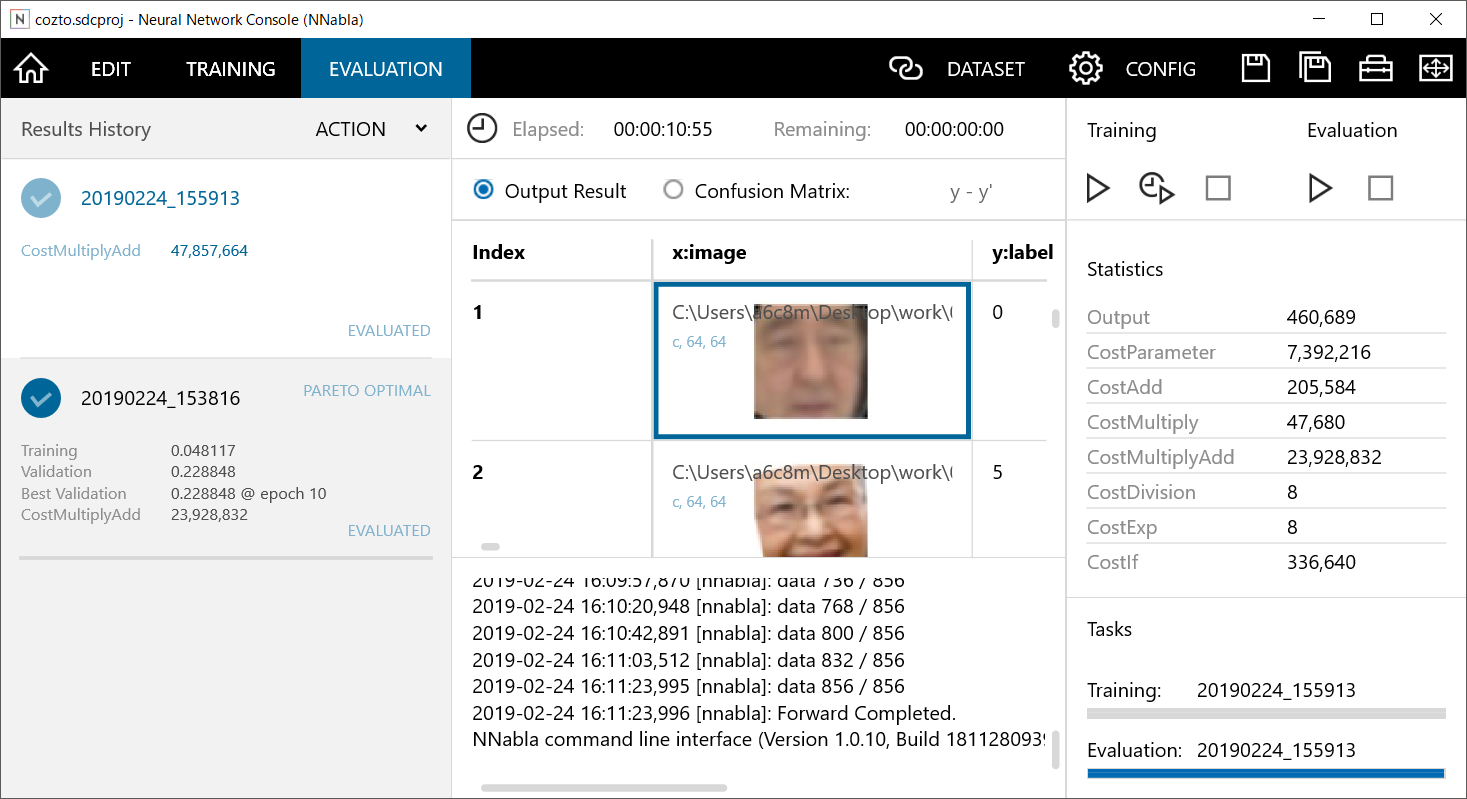

Evaluationを実行すると・・・

##4.途中出力結果の確認

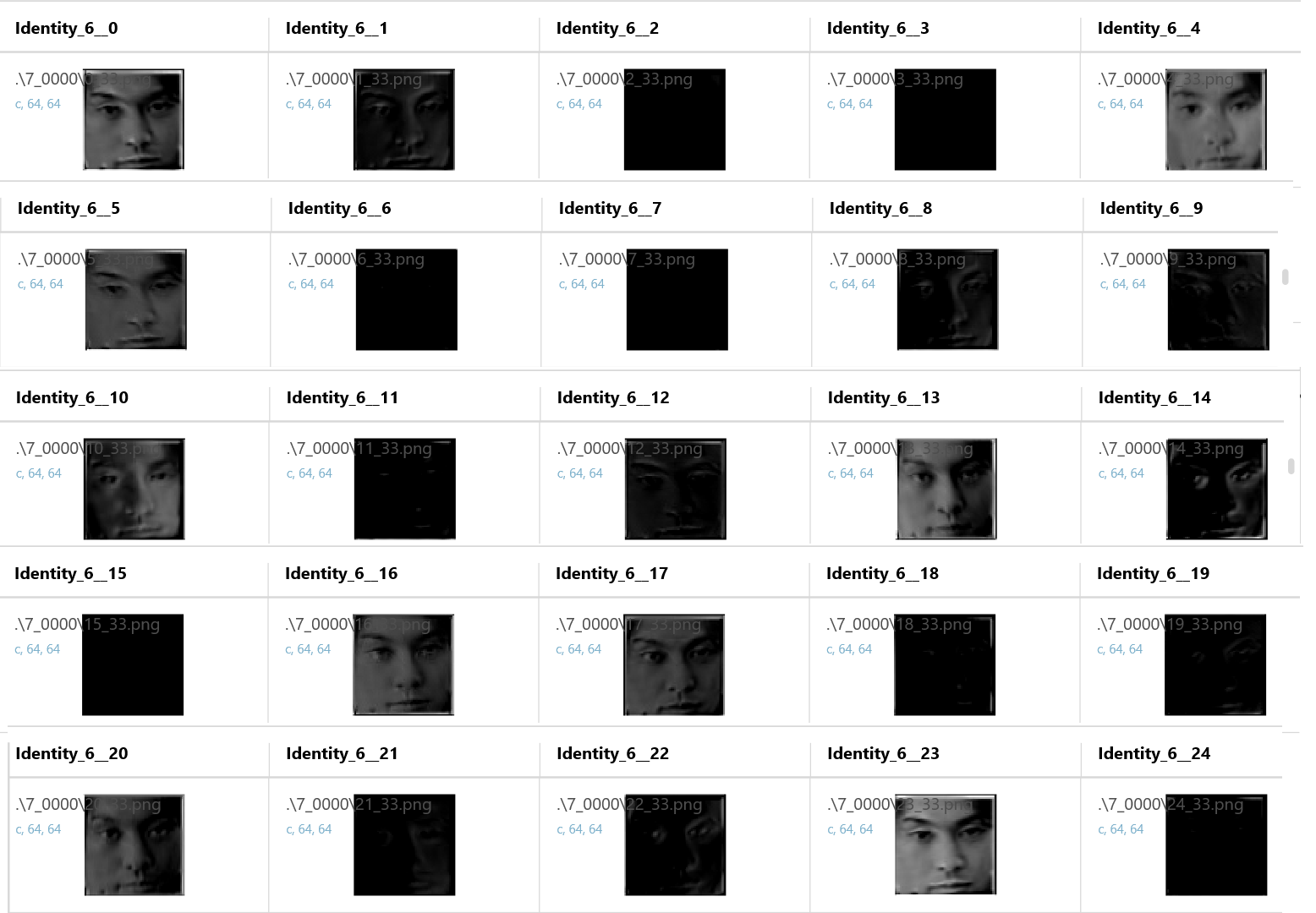

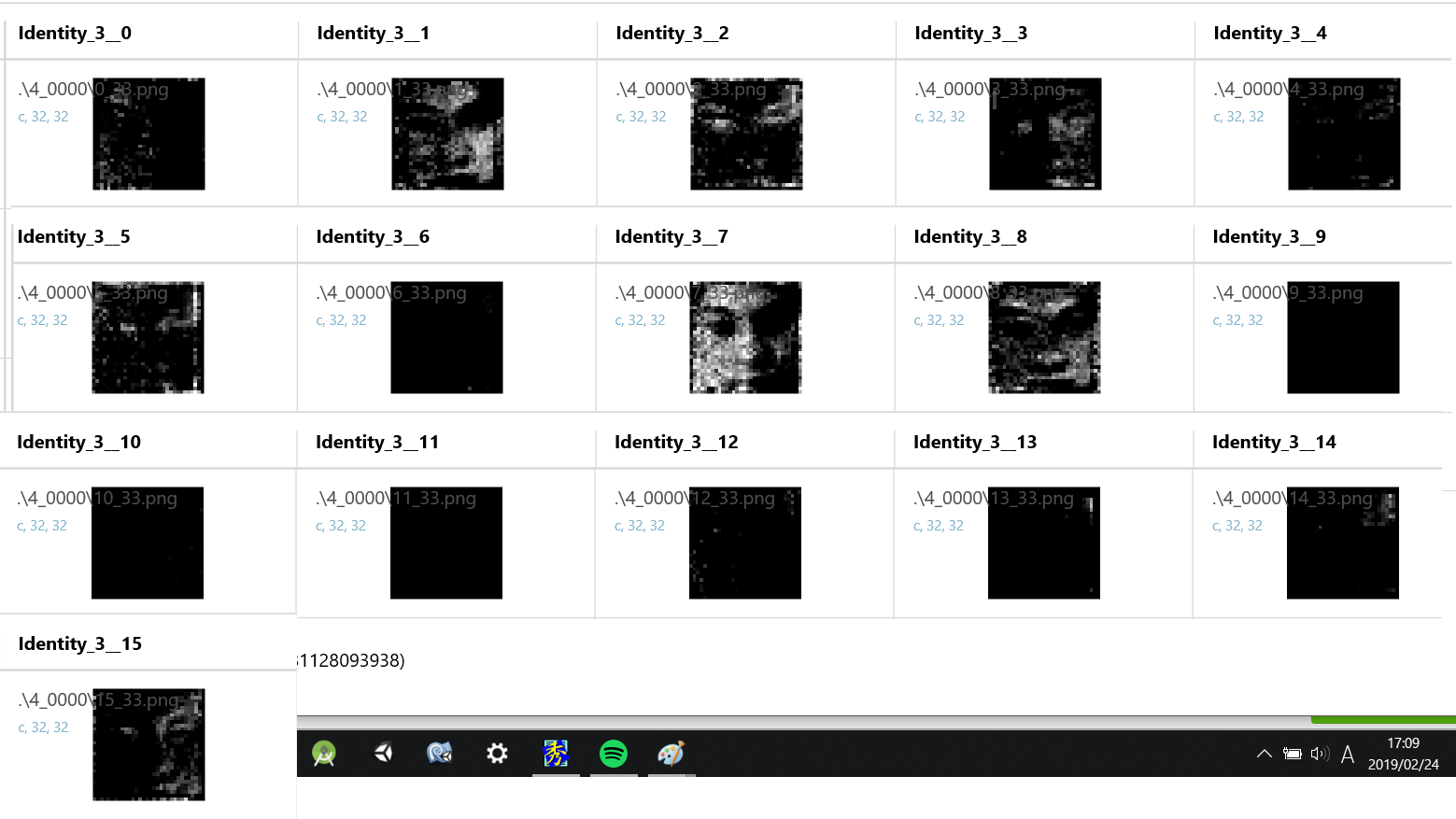

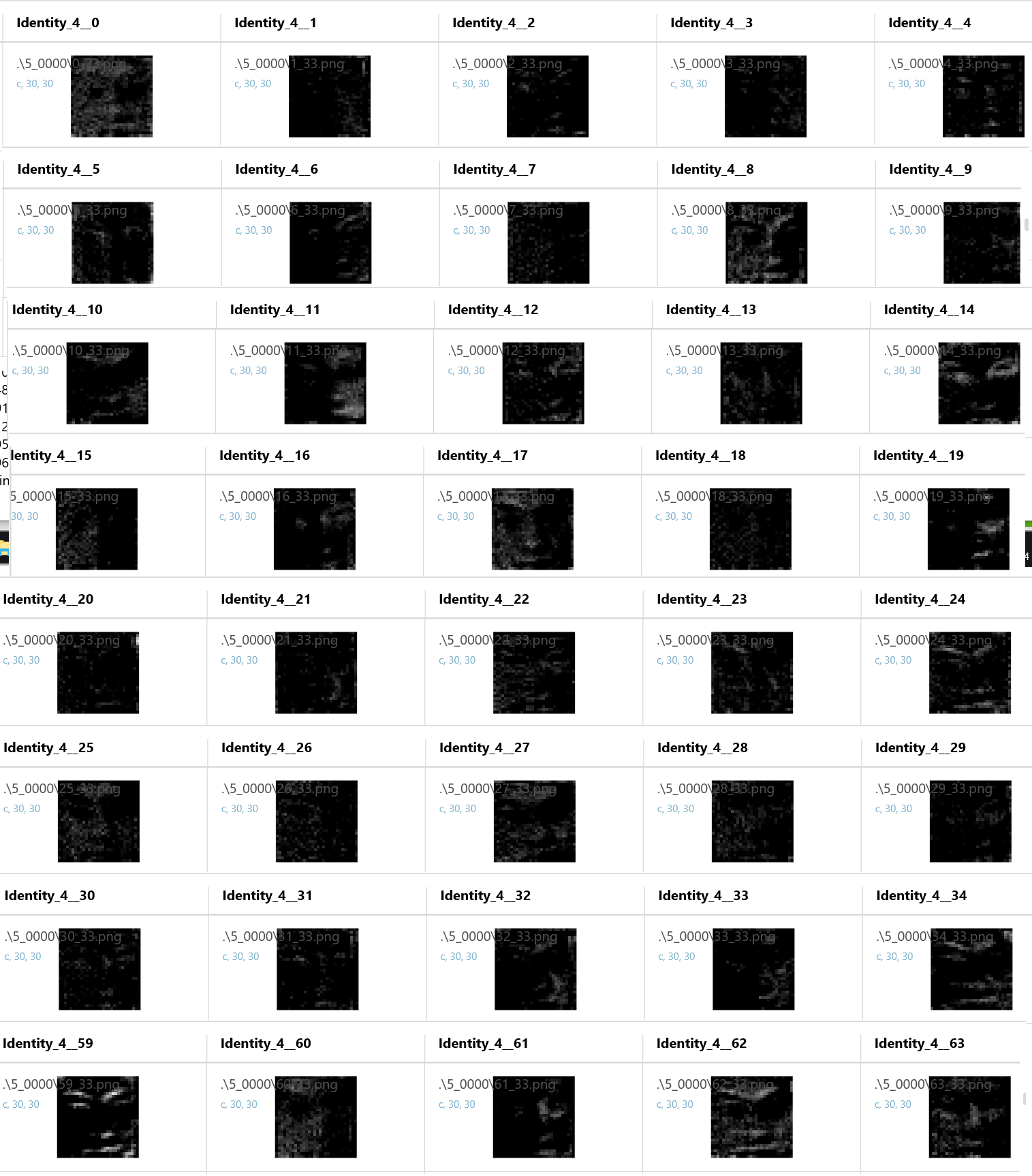

Index.34の柳楽君の画像を追いかけてみます。

最初のConvolution後

次のConvolution後

最後のConvolution後

##5.感想

学習の途中出力結果を確認したのは初めてだったので、とても面白かったです。

特徴の抽出とは、こんな感じで行われているのですね!もう少し、CNNについての知識が

あると更に多くの気づきがあるのかもしれません。

今後は、プーリング層後の途中結果の確認や、他のRNNなどのモデルにも適用したいです。

##リンク

AIエンジニアを目指してみる

Raspberry PiカメラでDeepLearningによるリアルタイム顔認証