この記事は ゆっくりテックウォッチ Advent Calendar 2025 の 15 日目の記事です。

個人開発の「ゆっくり動画スタジオ」でGitHub人気リポジトリの解説動画を自動生成しており、その分析データをもとに本記事も生成しています。

TL;DR

- ワンコマンドで最新LLM(Llama 4、DeepSeek-R1、Gemma 3など)をローカル実行可能

- Llama 4、DeepSeek-R1など100以上のモデルに対応し、選択肢が豊富

- OpenAI互換APIと450以上の統合サービスで、既存ツールとシームレスに連携

このリポジトリについて

ローカルで大規模言語モデルを簡単に実行できるツールです。

OllamaはmacOS、Windows、Linuxでllama、gemma、mistralなどさまざまなLLMをワンコマンドで実行できるツール。REST APIとCLIを提供し、開発者がローカル環境でAIアプリケーションを構築できます。

| 項目 | 内容 |

|---|---|

| リポジトリ | ollama/ollama |

| スター数 |

|

| 言語 | Go |

| ライセンス | MIT License |

| 作成日 | 2023-06-26 |

なぜ今注目されているのか

AIのAPI課金が高い、機密データを外部に送れない、オフラインで使えない…こんな悩みを抱えている開発者は多いのではないでしょうか。

Ollamaならワンコマンドで最新LLMをローカル実行できます。ChatGPTやGeminiのような体験を、完全無料・完全ローカルで実現できるのです。

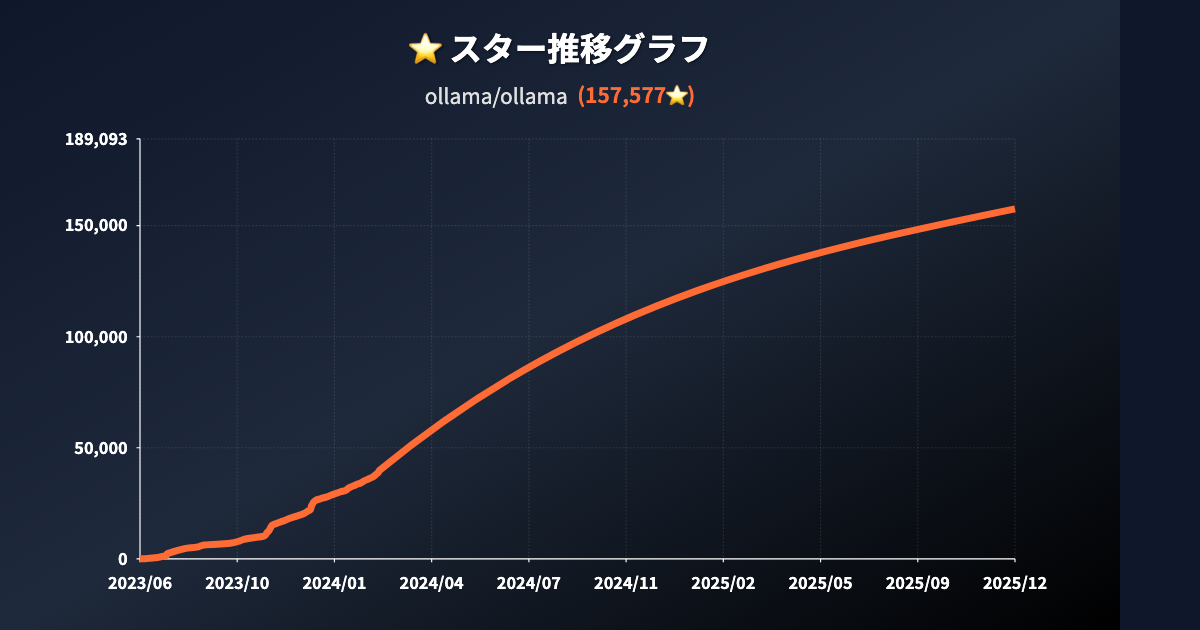

スター推移

2023年6月に公開されたOllamaは、同年11月に急成長を遂げ、わずか数日で1万スターを突破しました。その後も順調にスターを獲得し続け、2024年2月には約4万スター、2025年12月現在では15万スターを超える大人気リポジトリとなっています。1日あたり平均約160スターという驚異的なペースで成長を続けています。

主な機能・特徴

1. ワンコマンドで最新LLMをローカル実行

たった1行のコマンドで、モデルのダウンロードから実行まで完了します。たとえばGemma 3を使いたい場合:

ollama run gemma3

これだけでモデルが自動ダウンロードされ、対話を開始できます。複雑なセットアップや環境構築は一切不要です。

2. Llama 4、DeepSeek-R1など100以上のモデル対応

主要なオープンソースLLMに幅広く対応しています:

| モデル | パラメーター | サイズ | コマンド |

|---|---|---|---|

| Gemma 3 | 4B | 3.3GB | ollama run gemma3 |

| DeepSeek-R1 | 7B | 4.7GB | ollama run deepseek-r1 |

| Llama 4 | 109B | 67GB | ollama run llama4:scout |

| Phi 4 | 14B | 9.1GB | ollama run phi4 |

8GB RAMで7Bモデル、16GB RAMで13Bモデル、32GB RAMで33Bモデルが推奨です。

3. OpenAI互換API+450以上の統合サービス

OpenAI互換のREST APIを提供しているため、既存のOpenAI APIを使用しているアプリケーションをそのままOllamaに移行できます。

curl http://localhost:11434/api/chat -d '{

"model": "llama3.2",

"messages": [

{ "role": "user", "content": "why is the sky blue?" }

]

}'

LangChain、LlamaIndex、VS Code AI Toolkit、Open WebUIなど450以上のサービスと統合可能です。

4. Mac/Windows/Linux/Dockerで完全無料

すべてのプラットフォームで完全無料で利用できます:

- macOS: ダウンロード

- Windows: ダウンロード

-

Linux:

curl -fsSL https://ollama.com/install.sh | sh -

Docker:

docker pull ollama/ollama

技術スタック

Go+llama.cppでLLMをローカル実行し、REST APIを提供しています。

| 分類 | 技術 |

|---|---|

| 主要技術 | Go, llama.cpp |

| フレームワーク/ライブラリ | Gin (Web Framework), Cobra (CLI), SQLite |

| インフラ | Docker, Google Cloud, Fly.io, Koyeb |

| 連携サービス | LangChain, LlamaIndex, crewAI, Open WebUI, VS Code AI Toolkit |

ユースケース

ユースケース1: フリーランスのWebエンジニア

背景: GPT-4のAPI課金が月5,000円を超え、利益を圧迫していた

課題: クライアント案件でAIチャットボットを作るたびにAPI課金が発生する

解決策: Ollamaでローカルにllama3.3を動かし、LangChainで統合

結果: API課金がゼロになり、月5,000円以上の経費削減を実現

ユースケース2: 大企業のセキュリティエンジニア

背景: 社内ドキュメントの要約にAIを使いたいが、機密情報を外部に送れない

課題: OpenAI APIは社内規定で使用禁止、クラウドAIサービスも同様

解決策: オンプレミス環境にOllamaをデプロイし、社内専用AIアシスタントを構築

結果: 機密情報を外部に出さずにAI要約機能を実現、業務効率30%向上

ユースケース3: AIに興味がある大学生

背景: 就活でAIプロジェクトの経験をアピールしたいが、API課金する余裕がない

課題: GPT-4のAPIは高額、学生にとっては負担が大きい

解決策: Ollamaでllama3.2を使い、卒業研究のチャットボットを実装

結果: 完全無料でAIアプリを開発、ポートフォリオに掲載して就活成功

競合との比較

LM Studioとの違い

| 観点 | Ollama | LM Studio |

|---|---|---|

| インターフェイス | CLI・REST API中心 | GUI中心で視覚的 |

| 開発者向け機能 | OpenAI互換API、450+統合 | 限定的なAPI |

| 使いやすさ | コマンドライン操作が必要 | クリックだけで操作可能 |

| プラットフォーム | Mac/Win/Linux/Docker | Mac/Winのみ |

Ollamaを選ぶべき場面: API統合やサーバーデプロイが必要な開発者向けプロジェクト

OpenAI APIとの違い

| 観点 | Ollama | OpenAI API |

|---|---|---|

| コスト | 完全無料 | 従量課金 |

| プライバシー | データはローカルに保持 | データがクラウドに送信される |

| モデル性能 | ローカルモデル依存 | GPT-4等の最新モデル |

| インフラ要件 | 高性能PCが必要 | インターネット接続のみ |

Ollamaを選ぶべき場面: コスト削減、プライバシー重視、オフライン利用が必要な場合

始め方

インストール

# macOS (Homebrew)

brew install ollama

# Linux

curl -fsSL https://ollama.com/install.sh | sh

# Windows

# 公式サイトからインストーラーをダウンロード

モデルの実行

# Gemma 3を実行

ollama run gemma3

# DeepSeek-R1を実行

ollama run deepseek-r1

# Llama 3.2を実行

ollama run llama3.2

詳細は公式ドキュメントを参照してください。

まとめ

Ollamaは以下の点で、ローカルLLM実行ツールの決定版と言えます:

- 完全無料・オープンソースでローカル実行が可能

- Llama 4、DeepSeek-R1など最新モデルに対応

- OpenAI互換APIで既存ツールと統合が簡単

概要欄のリンクから今すぐインストールして、AI開発の新しい世界を体験してみてください!

ゆっくり解説動画を配信しています

ゆっくり解説動画を配信しています

YouTubeチャンネル「ゆっくりテックウォッチ」では、GitHub の注目リポジトリをゆっくり解説しています。

この記事で紹介した Ollama の解説動画も公開していますので、ぜひご覧ください!

![]() チャンネル登録 よろしくお願いします!

チャンネル登録 よろしくお願いします!

関連リンク

この記事は AI によって自動生成されました。内容に誤りがある可能性があります。