作成日:2025年8月14日(木)

1.はじめに

本記事では、2025年8月5日にOpenAIからリリースされた「gpt-oss」モデルをCPUのみの環境で実行してみた検証結果をご紹介します。クラウドサービスを利用せずローカル環境でAIを活用したいケースが増える中、オープンウェイトモデルの実用性について実際に試してみました。特にGPUを持たない環境での動作特性や制約について詳しく解説します。

2.gpt-ossとは

gpt-ossとは、2025年8月5日(現地時間)にOpenAI社がリリースした、ローカル環境で利用できるオープンウェイトの大規模言語モデルです。

一般的な企業の生成AI活用シーンでは、セキュリティ上の理由からクラウド上の大規模言語モデルの使用が禁止されているケースが多くあります。これまで、セキュリティを担保しながら大規模言語モデルを利用するには、VPN接続や企業専用のクラウド環境が必要でした。

このような背景から、ローカルで動作するLlama3、Qwen3、Gemma、DeepSeekなどの大規模言語モデルには一定の需要があります。

そんななかOpenAIがOpenAI o4-mini相当の性能のと言われるgpt-ossをリリースしたことで注目を集めています。

gpt-ossはApache License 2.0で公開されており、商用・非商用問わず自由な利用・改変・再配布が可能な大規模言語モデルです。

2.1. gpt-ossのスペック

| No | モデル | レイヤー | パラメータ合計 | トークンあたりのアクティブパラメータ数 | エキスパート合計 | トークンあたりのアクティブエキスパート数 | コンテキスト長 |

|---|---|---|---|---|---|---|---|

| 1 | gpt-oss-120b | 36 | 117b | 5.1b | 128 | 4 | 128k |

| 2 | gpt-oss-20b | 24 | 21b | 3.6b | 32 | 4 | 128k |

3.gpt-ossの性能

OpanAIが公開しているgpt-oss-120bとgpt-oss-20bを全体を通して見ると、gpt-oss-120bはほぼo4-miniに匹敵する性能を持ち、特に難解な問題では上回る場合もあります。一方、gpt-oss-20bはそのコンパクトなサイズにもかかわらず、o3-miniを上回る性能を示しています。特にSWE-benchのような実用的なタスクでは、モデルサイズの小ささを考慮すると非常に効率的な性能を発揮しています。

これらの結果から、ローカル環境での実行を目的としたオープンウェイトモデルとして、gpt-ossシリーズは非常に有望であると言えます。特にCPUのみの環境では、gpt-oss-20bが計算リソースとパフォーマンスのバランスが優れている選択肢となるでしょう。

| No | カテゴリ | 指標 | gpt-oss-120b | gpt-oss-20b | OpenAI o3 | OpenAI o4-mini | OpenAI o3-mini |

|---|---|---|---|---|---|---|---|

| 1 | Reasoning & knowledge | MMLU | 90.0 | 85.3 | 93.4 | 93.0 | 87 |

| 2 | GPQA Diamond | 80.1 | 71.5 | 83.3 | 81.4 | 77 | |

| 3 | Humanity’s Last Exam | 19.0 | 17.3 | 24.9 | 17.7 | 13.4 | |

| 4 | Software engineering | SWE-bench | 62% | 60% | 68% | 69% | 49% |

| 7 | Competition math | AIME 2024 | 96.6 | 96.0 | 95.2 | 98.7 | 87.3 |

| 8 | AIME 2025 | 97.9 | 98.7 | 98.4 | 99.5 | 86.5 |

※各指標の値はOpenAI公式の「gpt-ossが登場」から取得

※SWE-Benchの情報はOpenAI公式の「gpt-oss-120b & gpt-oss-20b Model Card」のP27の「5.2.3.1 SWE-bench Verified (N=477)」から取得

MMLU (Massive Multitask Language Understanding)

MMLUは言語モデルの幅広い知識と推論能力を測定する総合的な指標です。gpt-oss-120b(90.0)とgpt-oss-20b(85.3)の結果を比較すると、パラメータ数の違いによる性能差が約4.7ポイントあることがわかります。gpt-oss-120bはOpenAI o4-mini(93.0)に近い性能を示していますが、わずかに劣ります。一方、gpt-oss-20bはo3-mini(87)に近い性能を持っており、パラメータ数を考慮すると効率的なモデル設計がなされていると考えられます。

GPQA Diamond

GPQAは高度な科学的知識を問う指標です。ここでもgpt-oss-120b(80.1)とgpt-oss-20b(71.5)の間に8.6ポイントの差があります。これはモデルサイズが専門知識の深さに与える影響を示しています。gpt-oss-120bはo4-mini(81.4)に非常に近い性能であり、専門的な知識においても大型商用モデルに匹敵する能力を持っていることが窺えます。

Humanity's Last Exam

この指標は特に難易度の高い問題に対する性能を測定します。gpt-oss-120b(19.0)とgpt-oss-20b(17.3)の差は他の指標と比べて小さく、1.7ポイントにとどまっています。興味深いことに、gpt-oss-120bはo4-mini(17.7)よりも高いスコアを記録しています。これは、特に難解な問題に対して、gpt-ossのアーキテクチャが効果的に機能している可能性を示唆しています。

SWE-bench

ソフトウェアエンジニアリングの能力を測定するSWE-benchでは、gpt-oss-120b(62%)とgpt-oss-20b(60%)の差が2%と非常に小さくなっています。両モデルともo3-mini(49%)を大きく上回っていますが、o3(68%)やo4-mini(69%)には及びません。この結果は、コーディング能力においてモデルサイズよりもアーキテクチャやトレーニング方法の影響が大きい可能性を示唆しています。

4.gpt-oss-20bを使う方法

これまでの大規模言語モデルは推論時にGPUの計算リソースを使用するのが定石でした。しかしgpt-oss-20bはCPUのみでも動作するということで、その動作速度を試してみたいと思います。

gpt-oss-20bを試すにはいくつかの方法があります。今回はCPUのみで動作するかを確かめたいので、LM Studioで試してみます。

| No | サイト | 説明 | 費用 | 使い方 |

|---|---|---|---|---|

| 1 | LMArena | LMArenaは、カリフォルニア大学バークレー校の研究者によって設立されたAIモデル評価プラットフォームで、ユーザーが匿名でAIモデルを比較し、その性能を評価することを目的としています。このプラットフォームは、公平で中立的な評価環境を提供し、AI技術の進化を促進する役割を果たしています。 | 無料 | ①LMArenaのDirectChatにアクセス LMArena ②モデルをgpt-oss-20bに変更 ③「Ask anything」にプロンプトを入力 |

| 2 | OpenRouter | OpenRouterは、2023年に設立されたプラットフォームで、開発者が複数のAIモデルに統一されたAPIを通じてアクセスできるようにすることを目的としています。このサービスは、AIモデルの統合、コスト最適化、パフォーマンスの向上を図り、開発者が効率的にAIを活用できる環境を提供します。 | 有料 | ①OpenRouterチャットに接続 OpenRouter ②モデルをgpt-oss-20b (free)に設定 [Add Model]から「OpenAI:gpt-oss-20b(free)」を選択 ③「Start a new message」にプロンプトを入力 |

| 3 | LM Studio | LM Studioは、Element Labsによって提供されるデスクトップアプリケーションで、ユーザーがローカル環境で大規模言語モデル(LLM)を簡単に実行・管理できるように設計されています。このプラットフォームは、プライバシーを重視し、クラウドに依存せずにAIを利用できる環境を提供することを目的としています。 | 無料 | ①Windows/MacにLM Studioをインストール ②gpt-oss-20bモデルをダウンロード ③gpt-oss-20bモデルをローディング ④「Send a message to the model」にプロンプトを入力 |

※他にもあるかもしれません

5.LM Studioをインストール

5.1. LM Studioとは

LM Studioは、米国のElement Labsによって提供されるデスクトップアプリケーションで、2023年5月に公開されました。このプラットフォームは、ユーザーがローカル環境で大規模言語モデル(LLM)を簡単に実行できるように設計されており、プライバシーを重視し、クラウドに依存しない利用が可能です。2025年7月からは、個人利用だけでなく企業利用も無料で行えるようになり、特別なライセンスは不要です。

LM Studio - Download and run LLMs on your computer

5.2. LM Studioをインストール

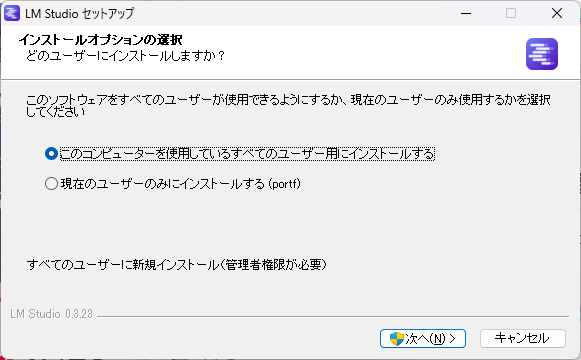

LM Studioのサイトから「Download for Windows」でインストーラ(例:LM-Studio-0.3.23-3-x64.exe)をダウンロードして一般ユーザでインストールします。

「このコンピューターを使用しているすべてのユーザー用にインストールする」を選択しインストールします。

5.3. 初期設定

起動後少し時間が経つと「Get Started」が押せるようになるので、「Get Started」を押して「Choose your level」は後でも変更できますが、「Developer」を選んでおきましょう。

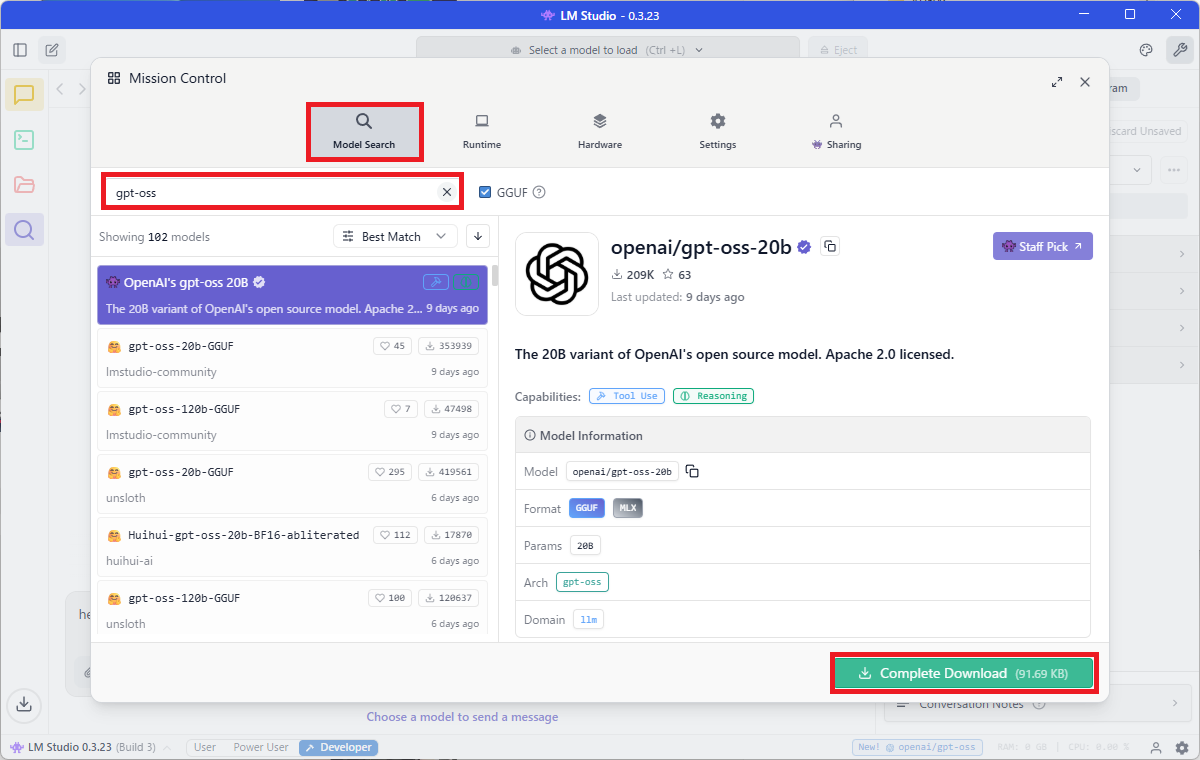

①gpt-oss-20bのダウンロード

gpt-oss-20bは虫眼鏡のサイドバーからモデルを検索(gpt-oss)してダウンロードします。

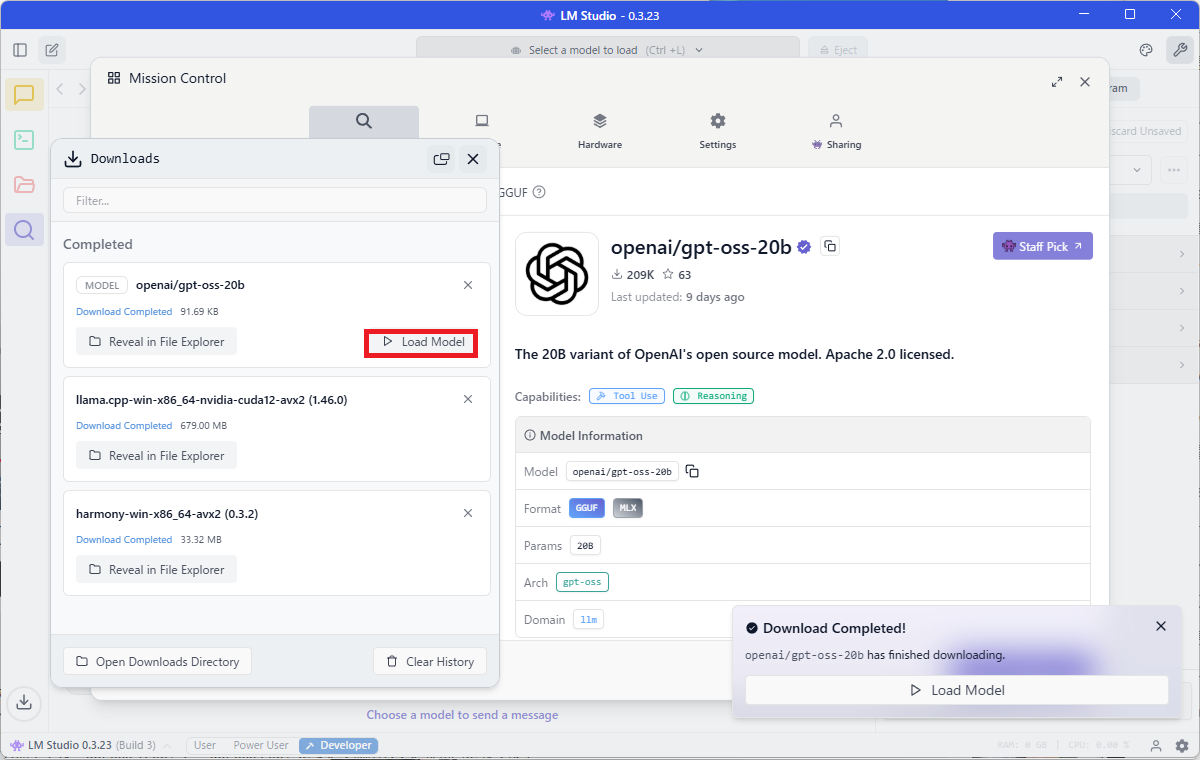

②gpt-oss-2obの読み込み

ダウンロードしたモデルはLM Studioに読み込ませる必要がありますので、「openai/gpt-oss-20b」の「Load Model」をクリックしてローディングします。

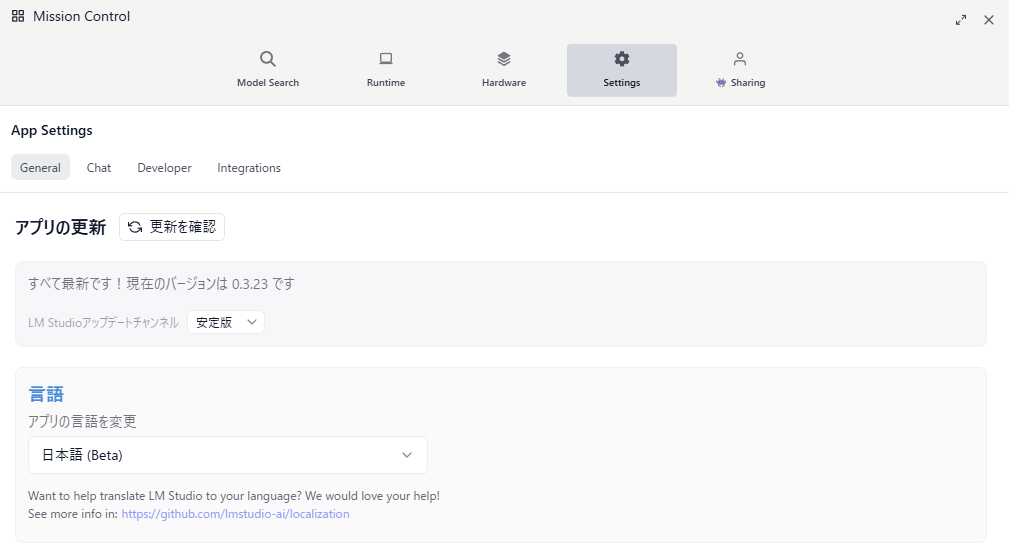

③利用言語の設定

[虫眼鏡]⇒[Setting]⇒[Language]を「日本語」に設定します。

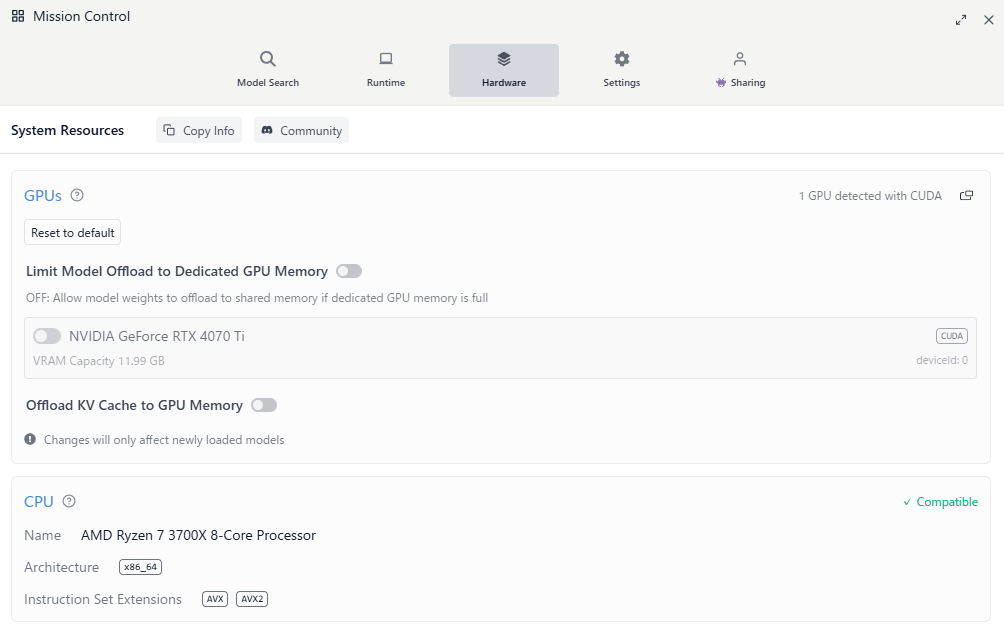

④GPUの無効化

私のPCはGPUを搭載してしまっているので、GPUを[虫眼鏡]⇒[Setting]⇒[Hardware]で無効化します。

GPCを搭載していない場合はこの作業は不要です。

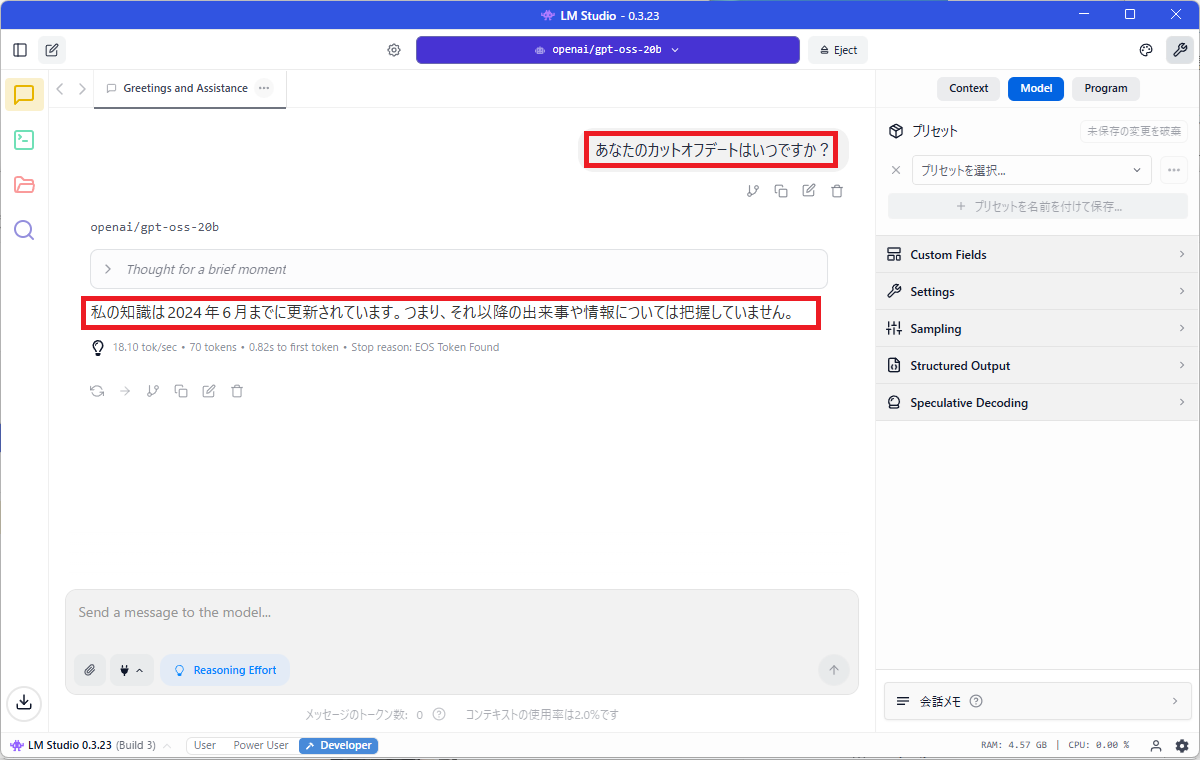

⑤カットオフデートの確認

gpt-4o以降のモデルではカットオフデート(トレーニングデータの最終日付)を応答できますので、「あなたのカットオフデートはいつですか?」

を質問してみました。

2024年6月と回答されました。

6.速度を見てみる

6.1. 制約条件を指定した概要説明

「ChatGPTで物理の問題を解くプロンプト5選」で紹介されているプロンプトを入力してみます。

#命令

あなたは物理学の専門家AIです。以下のテーマに関して、初心者にもわかりやすい概要説明を行ってください。

#制約条件

・出力は項目ごとに分けて説明(前置きやまとめ不要)

・各項目は簡潔で論理的な文章で、専門用語は可能な限り平易な言葉で解説

・説明形式:①項目名/②概要説明

・内容は高校物理レベルを基準にし、基礎から重要概念まで網羅的に触れる

・難解な内容は具体例や比喩を用いて理解を助ける

・最新の物理学理論も簡単に紹介し、現代物理学への橋渡しを行う

#入力情報(例)

力学から量子物理までの高校物理範囲の基礎概念と、現代物理学の簡単な紹介

#出力内容(例)

①力学/②物体の運動とそれを引き起こす力の関係を扱う分野。ニュートンの運動法則が基本で、速度や加速度、力の概念を中心に説明する。

②熱力学/②エネルギーの変換と物質の状態変化を扱い、熱と仕事の関係やエネルギー保存則、エントロピーの概念を紹介する。

③電磁気学/②電気と磁気の現象を扱う分野で、電場や磁場の基本的性質、マクスウェルの方程式の概要を説明する。

④波動/②音や光の性質を扱い、波の基本的な性質や干渉・回折といった現象、ドップラー効果の意味も解説する。

⑤量子力学/②極微の世界を扱い、粒子の波動性や不確定性原理など、古典物理学では説明できない現象を概説する。

⑥相対性理論/②時間や空間の概念を刷新し、高速で運動する物体の性質や重力の新たな理解を示す理論の概要を紹介する。

①GPU無し

CPUモードで試してみました。この速度ならば実用に耐えられる速度だと思いました。

②GPU使用

LM StudioのGPUモードを有効にして試してみました。私のPCのスペックが悪いせいか正直CPUのみの時と変わりません。

③OpenRouter

同じことをOpenRouterでやってみました。流石に早いですね。

https://youtu.be/fuPOSZqQqu8

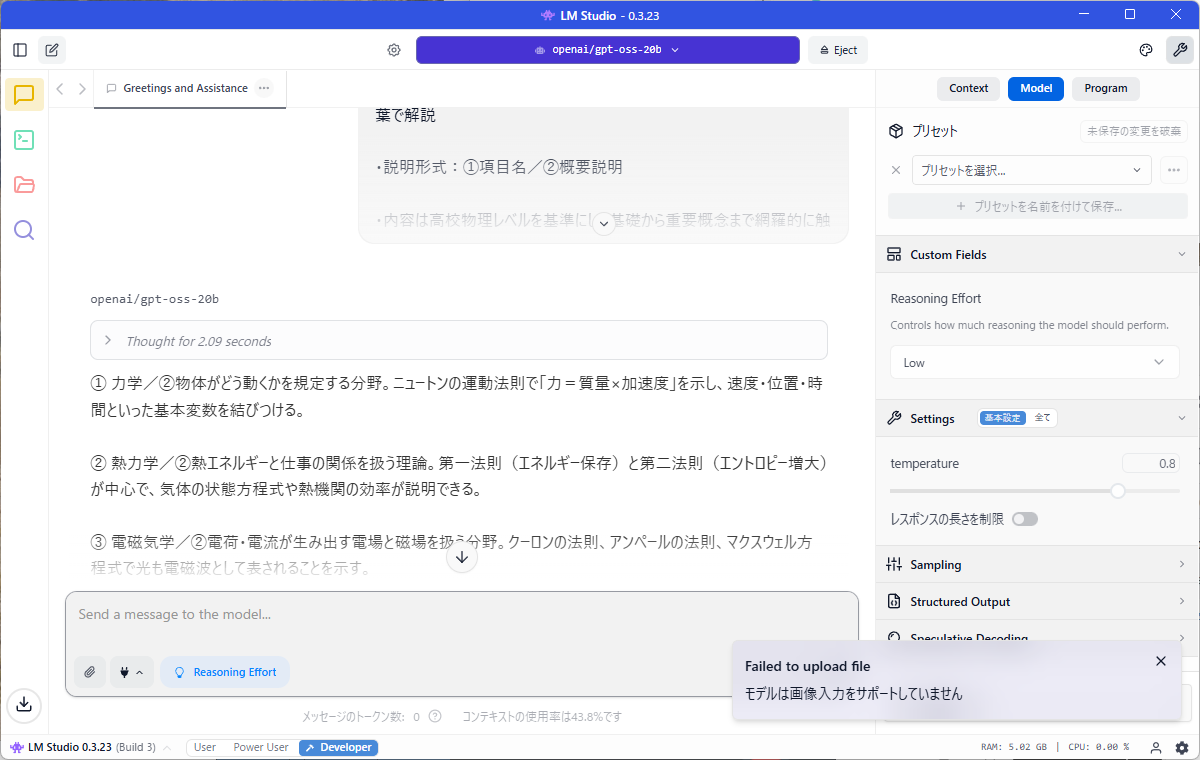

6.2. 画像認識

「Dify(ディファイ)on WSL2でgpt-4oを実験」で実行した画像解説のプロンプトと試そうとしましたが、画像アップロードでエラーになります。

マルチモーダル対応はしていないようです。

「AIアシスタントとして、この画像に描かれている内容を明確で詳細な文章で説明してください。」

6.3. PDFの要約

次にPDF文章の要約をためしてみました。

ただ、これはgpt-oss-20bがPDFを理解しているわけではなくLM StudioがPDFをテキスト化して要約しているようでした

試しにOpenRouterでも同じことをしてみましたがOpenRouterでは「No endpoints found that support image input」というエラーが出ます。

7.まとめ

今回のテストを通じて、OpenAIの「gpt-oss」モデルはCPUのみの環境でも十分に実用的なパフォーマンスを発揮することが確認できました。特にgpt-oss-20bモデルは、比較的軽量でありながら高い理解力と応答品質を維持しており、GPUを搭載していない一般的なPCでも問題なく動作します。ただし、応答速度はGPU環境と比較すると明らかに遅く、画像認識などのマルチモーダル機能には対応していない点に注意が必要です。

8.参考URL