クラウド環境での演算速度を求めたいです

解決したいこと

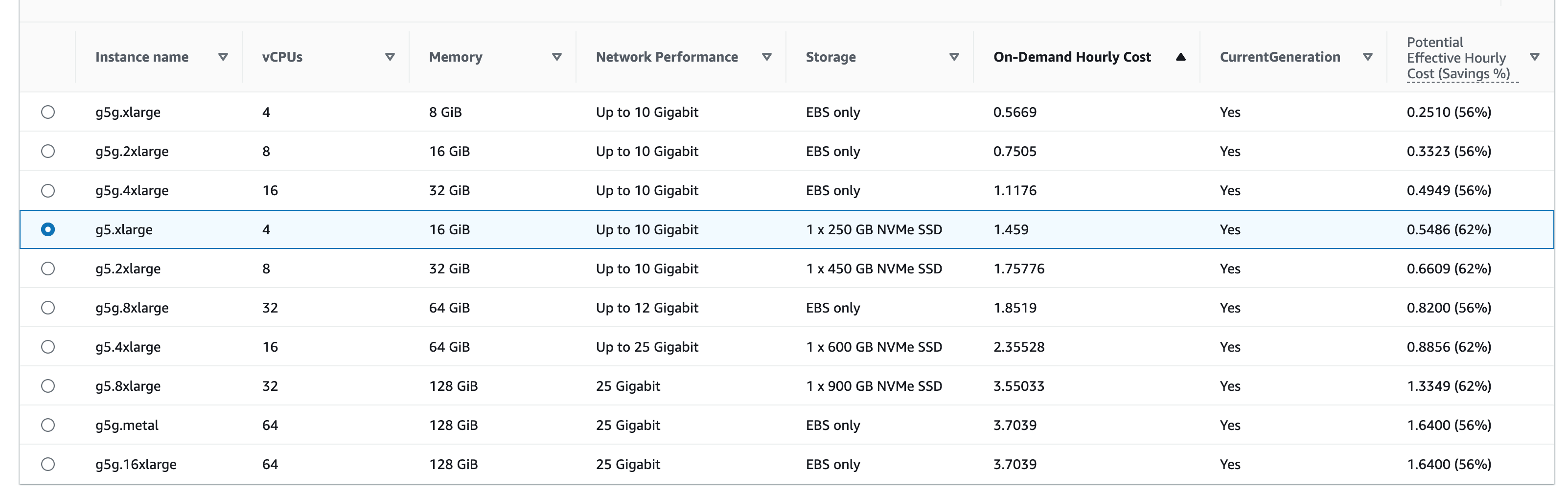

AWSの構成を考えるうえで、計算資源のEC2のスペックがどれだけコストに影響するか見積もりをしたいです。EC2はオンデマンドでの契約を考えているので、実際の計算時間がポイントになってくると思います。

EC2のインスタンスのスペックから、計算時間を求めているのですが、このような考え方は正しいのでしょうか?ご意見をお聞かせください。![]()

![]()

詳細

機械学習で予測を行うことを想定しているため、必要なインスタンスはGPU内臓のG5.Largeを選択しています。このインスタンスの内臓GPUは、NVIDIA A10G Tensor Coreであるため、計算機側のスペックはこれをベースに想定します。

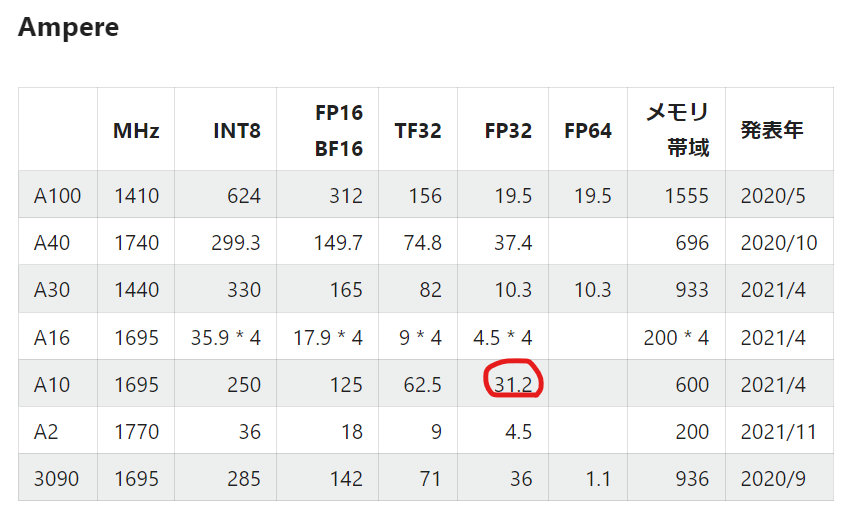

まずは、計算機側の演算能力を調べます。

上の表によると、クラウド上でのGPUの計算速度は、31.2 TFLOPSと考えます。

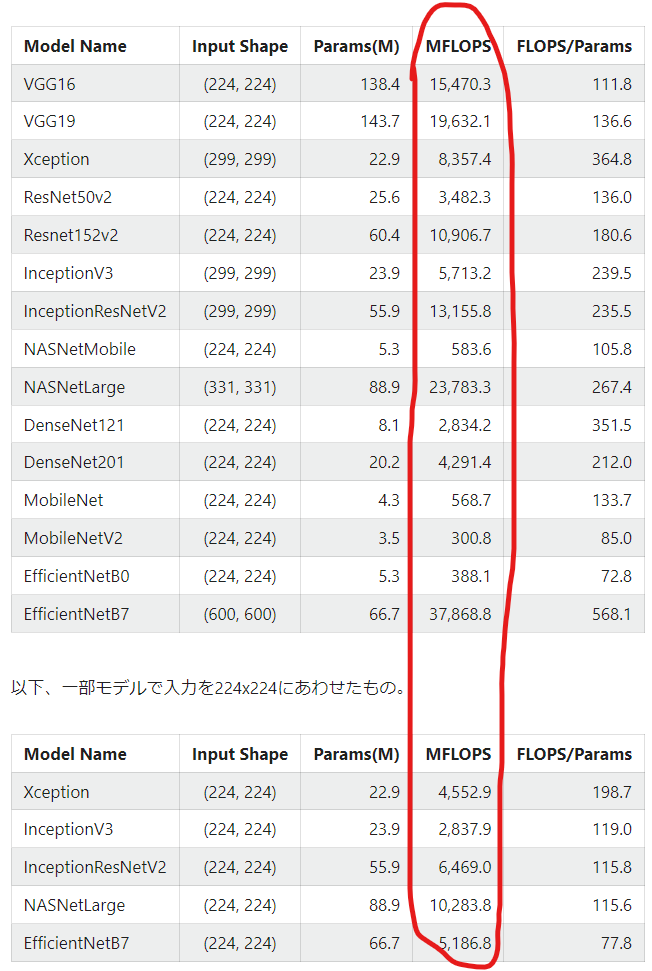

引用2より、機械学習の計算に必要な計算量を考えます。MFLOPSの平均をとり、同様の機械学習を行うのに必要な計算量は8,800 MFLOPSと考えます。(有効数時2桁)

ここから、1インプットにかかる計算時間を求めると

(必要な計算量)/(使用する計算機の演算能力)= 8,800×10^6/31.2×10^12

= 0.00028

見積もり結果

0.028+α ミリ秒

そのため、最大0.028 msecで予測値が出力され、ここに通信などにかかる時間が加わる。

このような認識は正しいでしょうか?

引用

表1:https://qiita.com/yukoba/items/10d0ba3fb1d19a6ab6a5

表2:https://qiita.com/T-STAR/items/59527f2b5484b9c22d1e