NVIDIAの「DLI」は初心者でも活用できる、生成AIやLLMを学ぶための最適ハンズオントレーニング

今やAIの進化において、特にGPUの開発で知られているNVIDIA(エヌビディア)。高性能のGPUとAI向けのソフトウェアを提供することで、ディープラーニングの爆発的な発展を支え、世界中の研究者やエンジニアにとって不可欠な存在となっています。

そのNVIDIAが、誰もがAIを学べるように無償・低価格で提供しているオンライン学習プログラム「DLI(Deep Learning Institute)」をご存じでしょうか?

DLIは単なる入門講座にとどまらず、コーディング演習やGPU環境の提供を含む実践的な内容が魅力です。また、LinkedInと連携してスキル証明も可能なため、キャリア形成にも大いに役立つそうです。この度、日本語版コンテンツもリリースされました。

今回は、NVIDIA日本法人でDLIの啓発・展開に注力する平野氏へのインタビューを通じて、DLI提供の背景や具体的な内容、今後の展望まで、詳しく伺いました。

目次

プロフィール

エンタープライズ マーケティング部

マーケティング マネージャ

創業時からこだわっている「ワン アーキテクチャ」の思想

―― DLIのお話を伺う前に、まずはNVIDIAの全体像について教えてください。

平野:NVIDIAは1993年に創業した会社で、現在はアクセラレーテッド コンピューティング*のパイオニアとして活動しています。実は、自らを半導体企業とは自称していません。

※アクセラレーテッド コンピューティング:並列処理によってAI、データ分析、シミュレーション、ビジュアライゼーションなどの要求の厳しいアプリケーションの処理を高速化する技術。詳細はこちら。

―― NVIDIAと言えばGPUの会社、と想起される方が多いと思うので、「半導体企業ではない」というのは意外に感じられる方が多いかもしれません。

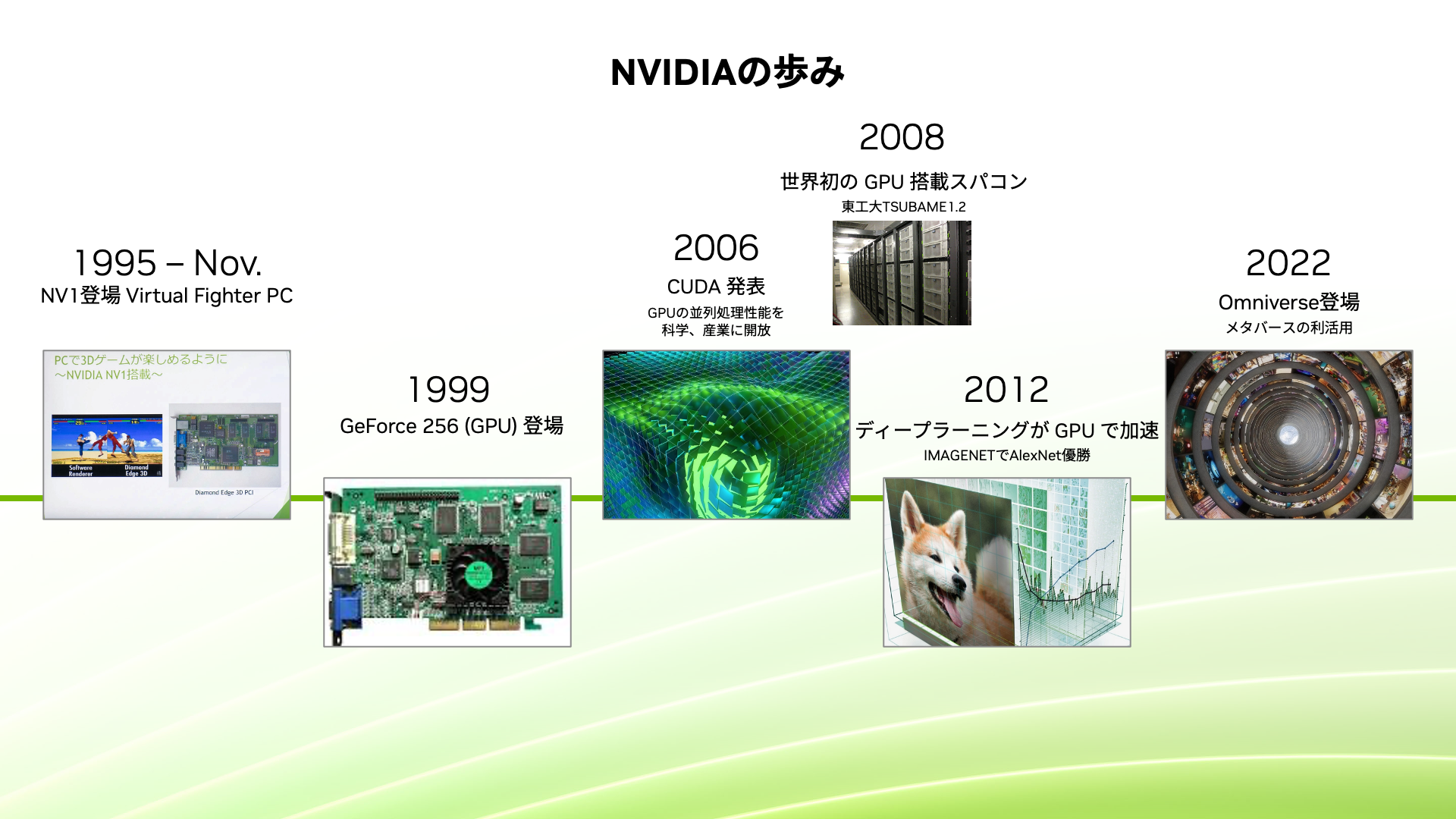

平野:弊社が1999年に発売した製品は、今のGPUの基礎となるエポックメイキングなチップ、「NVIDIA GeForce 256」でした。これは、3D 画像レンダリングの主要タスクを CPU からオフロードする初めてのチップでした。当時はまだゲームの世界での話でしたが、NVIDIAはこのチップをGPU(Graphics Processing Unit)と初めて呼び始めました。

弊社ではこれ以降、アクセラレーテッド コンピューティングに注力しつづけています。CPUが逐次処理が得意なのに対して、GPUは複数の作業を同時に行う並列処理が得意です。この特性を活かして、CPUが苦手な部分の計算をGPUにオフロードし、何かの処理を高速化するアクセラレーターとして活用するという使われ方が、科学技術計算の分野で注目されるようになりました。

2006年に発表した「NVIDIA CUDA」は、GPUの並列処理能力を汎用的に活用するためのプラットフォームとプログラミングモデルを指します。これがアクセラレーテッド コンピューティングの普及を後押しし、2008年には東京工業大学様(現・東京科学大学)でのスパコン「TSUBAME 1.2」に世界で初めてGPUが採用されました。これは非常に大きな出来事で、それ以降、世界中のスパコンにGPUが採用されるようになりました。

―― その後、2012年に画像認識コンテストでAlexNetが圧勝したことで、ディープラーニングがGPUで加速していったと。

はい、その後、AIの分野で活用され始めたというのが、ここ10年ちょっとの歴史になります。

―― 今ではGPUがAIの進化にとっても重要な役割を果たしていますよね。

平野:はい、現在はあらゆる産業に向けてAIのソリューションを展開しています。

―― このように事業領域を改めて拝見すると、本当に幅広いですよね。

平野:事業展開にあたって、弊社が創業時から特にこだわっているのが「ワンアーキテクチャ」です。ゲーミングからスパコン、AI推論、ロボティクスに至るまで、GPUの大きさや処理能力こそ違えど、基本的な構造は全て一緒です。

例えば、最新の世代のGPUアーキテクチャである「NVIDIA Blackwell」は、数万円から買えるゲーミング用の「NVIDIA GeForce RTX」から大規模なデータセンター向けの製品ラインナップまで、スケールは違ってもアーキテクチャは一緒です。さらには、世代が異なればGPUのアーキテクチャも異なりますが、CUDAを使用して開発したソフトウェアは、GPUの世代が新しくなっても動作する互換性があります。そのため、最初は手軽なコンシューマー向け製品で研究を始め、徐々に利用規模が大きくなって大規模データ向けの製品が必要になったとしても、同じソフトウェアの資産をそのまま使ってシームレスに移行できるんです。

―― 特に昨今では変化が速いので、学んだ知識や開発資産が無駄にならないのは重要ですね。

平野:まさにその通りです。これまで多くのアクセラレータが登場しては消えていってるのは、概して新製品が出るとアーキテクチャも変わって動かなくなるからです。しかし弊社では「新製品でも、基本的に過去のソフト資産がそのまま使えて、より高速に処理できる」を前提としています。

これらのソフト開発に欠かせないのがCUDAであり、CUDAを使って各種アプリ開発をするエンジニアの方々のエコシステムの育成、拡大に20年以上注力しています。

生成AIやLLMを学ぶためのハンズオントレーニング「DLI」とは?

―― 平野さんは具体的にどのようなことをされているのですか?

平野:「NVIDIA 開発者プログラム」のマーケティングを担当しています。この開発者プログラムにはいくつかの特典があります。例えば弊社のLLM関連やデジタルツイン、データサイエンス分野などのソフトウェアへのアクセス/アーリーアクセスプログラムや、開発者向けのトレーニングプログラム、開発者フォーラムへのアクセスなどです。

そのようなサービスを通じて、エンジニアや開発者の皆さまが、よりNVIDIAのハードウェア/ソフトウェア/サービスなどを有効活用していただけるように支援しています。その中でも今、私が最も注力しているのがNVIDIA Deep Learning Institute、通称「DLI」です。

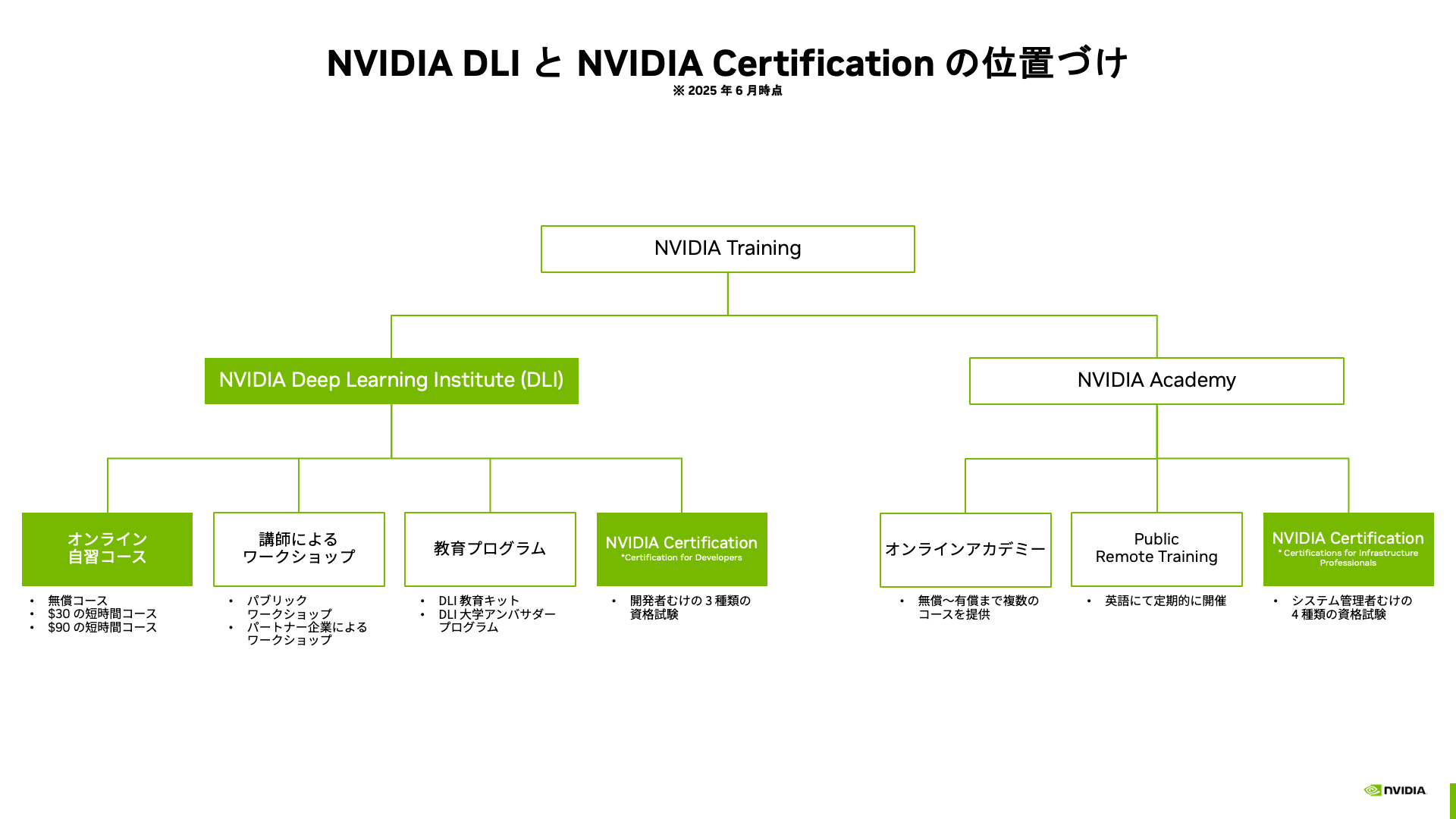

平野:NVIDIAのトレーニングプログラムには大きく2つ、NVIDIA Academy とNVIDIA DLIがあります。前者は弊社の製品トレーニングに特化していますが、後者のDLIは、可能な限りベンダーニュートラルな内容を志向しています。つまり、業界スタンダードの知識や技術を普及させるためのプラットフォームとして、オープンソースソフトウェアを中心に幅広い情報を取り扱っています。

―― 例えば一番左にある「オンライン自習コース」では、具体的にどのようなプログラムが用意されているのでしょうか?

平野:正式なカタログはこちらにあるのですが、AIやデータサイエンス、デジタルツインなどの幅広い分野をカバーしており、現時点で40以上のコースを用意しています。近年のAIブームの火付け役であるCNNを基礎から学びたい方や、ChatGPTで話題となったTransformerモデルを基礎から学べるコースもあります。世界最先端の情報を可能な限り早く提供するため、主に英語でのコンテンツですが、一部ではあるものの日本語版のコースも提供開始しています。

―― AIを学べる教材は世の中にたくさんあると思うのですが、その中でもDLIにはどのような特徴があるのでしょうか?

平野:DLIのコースには、コーディングの課題がついてきます。一般的にコーディングも含めて学習しようとすると、自分のPCで環境構築する必要がありますよね。しかしDLIでは、クラウド上にGPUインスタンスを立ち上げ、そこで実践していただけるようになっています。ボタン一つでGPUドライバーからCUDA、必要なライブラリ、SDKまでインストール済みの環境が立ち上がり、Google ColabやJupyter Notebook経由でコードを実行するため、知識だけでなく実践的なテクニックも習得できます。

特にLLMのような大規模データを扱う分野では、手元のPCでは動かないことも多いですし、NVIDIAのGPUが搭載されたノートPCを持っている方も一部のゲーマーの方や動画制作に関わる方、CADなどの3Dデータを扱う方以外まれではないでしょうか? もちろん、クラウド上に自分で環境構築することもできますが、手間も時間も、お金もかかります。DLIは、必要であればスパコンレベルの環境も提供可能で、しかも費用感も無料から比較的低価格(最大90ドル程度)で学べる点が大きなメリットだと自負しております。

―― 素晴らしいですね!ここまで体系的に用意されたオンラインカリキュラムをNVIDIAが提供していることを、全く存じておりませんでした。なぜ、NVIDIAはDLIを提供しているのでしょうか?

平野:これは弊社の「アクセラレート」という思想に繋がっています。NVIDIAではなにかと「アクセラレート」という言葉を使う文化があります。その思想・文化にもとづき、GPUなり弊社の持っているナレッジなどを使って課題解決を加速させ、その人が本来やるべきことに集中してもらいたい、という社会貢献的な使命感を持って事業に取り組んでいます。

例えば、DLIのオンライン自習コースの中には、並列処理をいかに効率よく複数のノード間で実施するかといった非常にニッチなものがあります。これも、効率よく実施すること自体が目的ではなく、いかに短い時間でAIのトレーニングを完了して、より良いモデルを最終的に作るかというのが目的と据えています。

AIの修得が大事なのに、学習環境の準備に時間がかかって遅々として進まないのであれば、準備にかかる手間を減らし、本質的な学習や開発に集中できるようにすることが重要です。日本では割と軽視されがちですが「スピードは力なり」だと考えておりまして、コンピューティングを高速化すれば解決できることはたくさんある、という考えでDLIも設計しています。

LinkedInとの連携でAI実践力の証明にもなる

―― DLIで学習したスキルは、どのように証明できるのでしょうか?

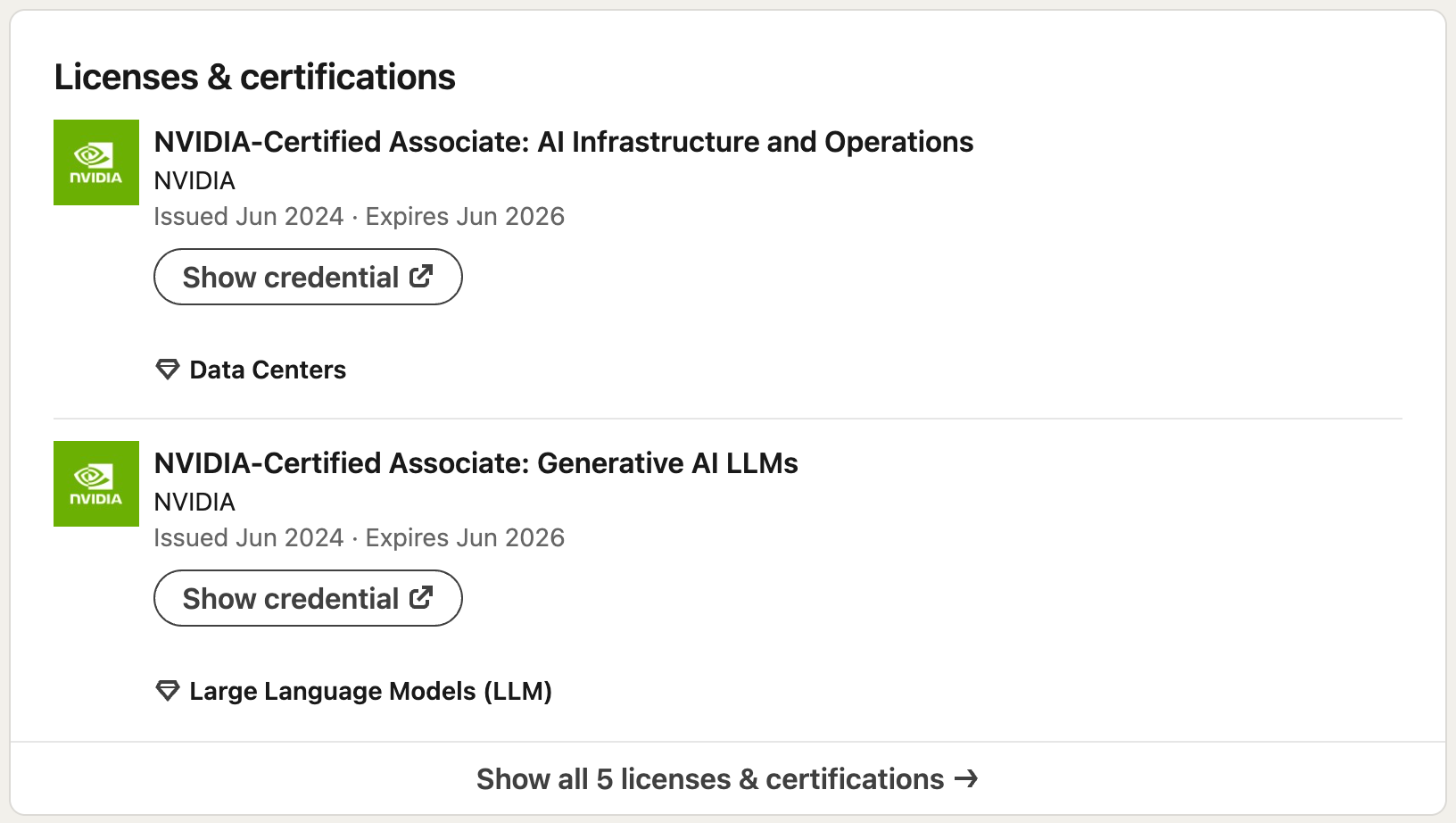

平野:コースを最後まで受講して課題をクリアすれば、コース完了証明書(Certificate of Completion)が授与されます*。これはLinkedInの資格欄(Licenses & certifications)にもボタンひとつで連携して、履歴表示されるようになります。この証明書がたくさん積み上がれば、企業の採用担当者は「この分野のアプリケーションを、自分で作れる状態になるコースを完了しているのだな」と判断できるため、実践的な実力があることの証明になります。

*対象のコースかどうかは、コース詳細に記載がございます。

―― コーディングの課題があるDLIだからこそ、実践的な実力の証明になるわけですね。

DLI のコースを受講完了すると、こちらの画像にあるようなコース完了証明書(Certificate of Completion)が授与される。偽造防止のため、通し番号も付くようになっている。

※画像左下にはぼかし加工を施しています。

平野:また、より広範なスキルセットを証明するものとして「NVDIA Certification」という資格制度も用意しています。こちらはDLIとは別のプログラムで、試験を受けて合格すると取得できます。

DLIを受講しなくても受験できますが、受講を推奨するDLIのラーニングパスも明示されており、何を学べば良いかを体系的にまとめています。

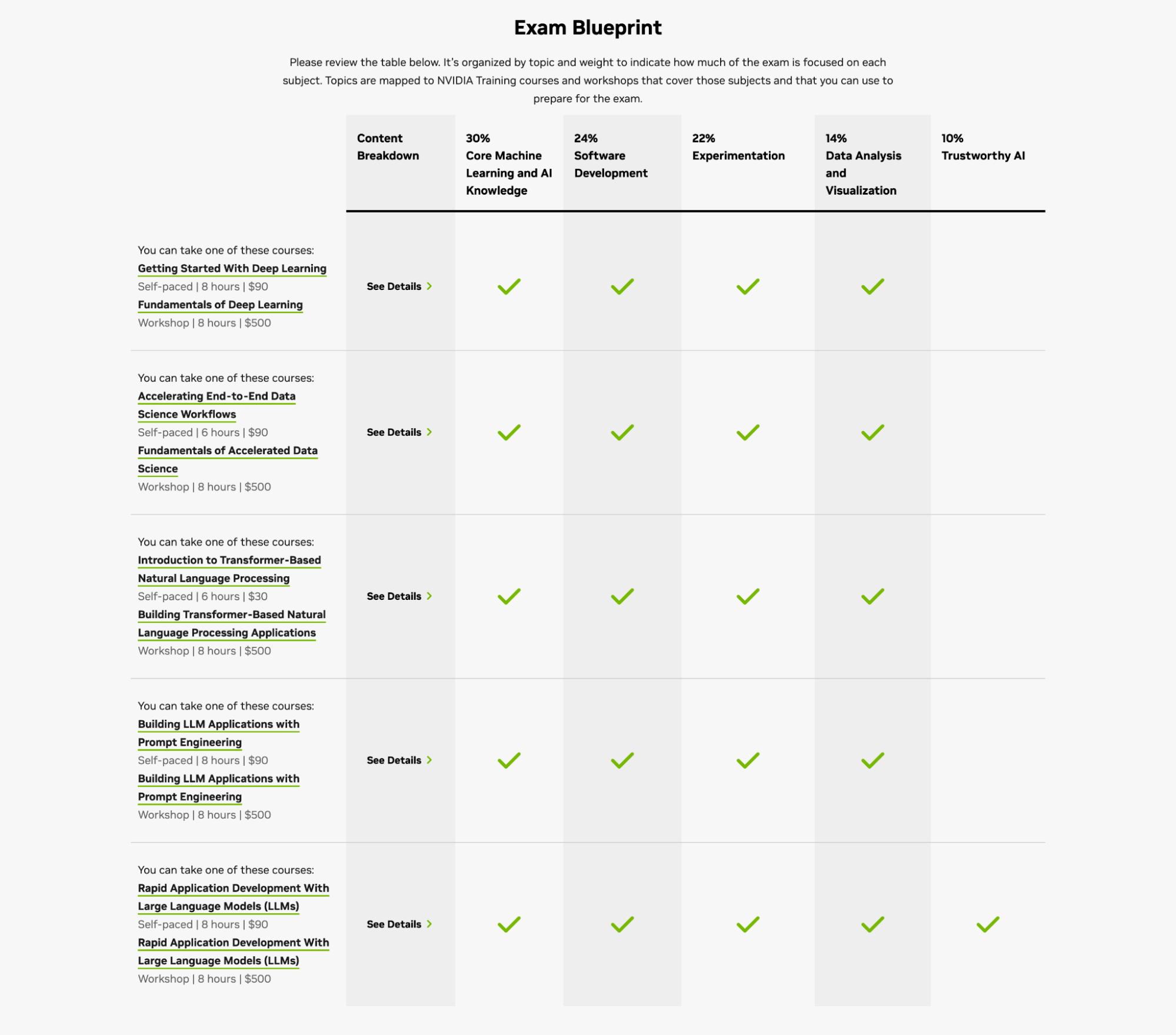

「NCA-GENL(NVIDIA-Certified Associate: Generative AI and LLMs)」という資格では、上表の行に表示されている DLI のコース(オンライン自習プログラムもしくは講師によるワークショップ)の受講が推奨されている。具体的な受験の感想はこちらのQiita記事でも言及されている

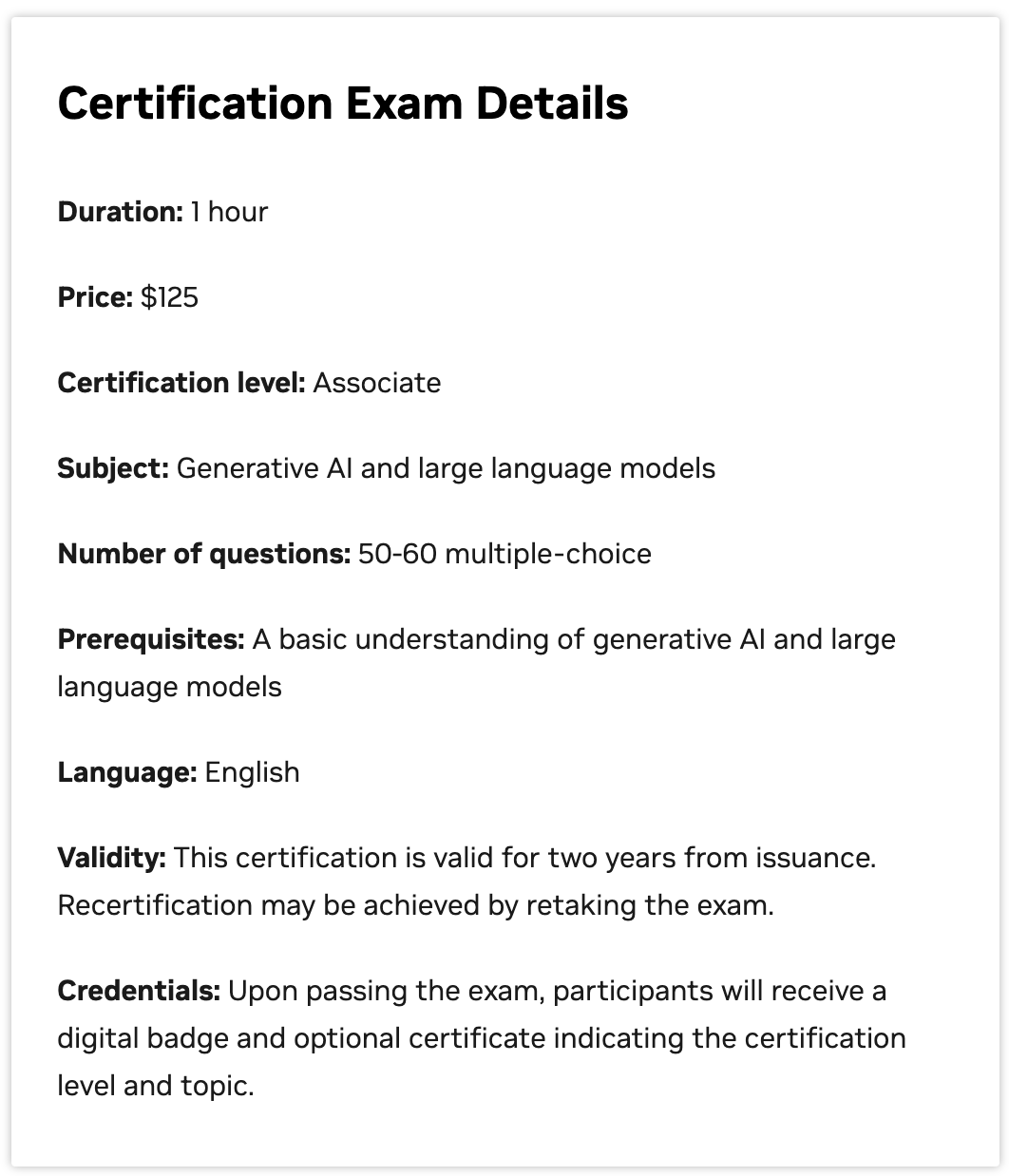

―― 例えば、NCA-GENLという資格の詳細を見ると、これは125ドルで受講できるということですね。

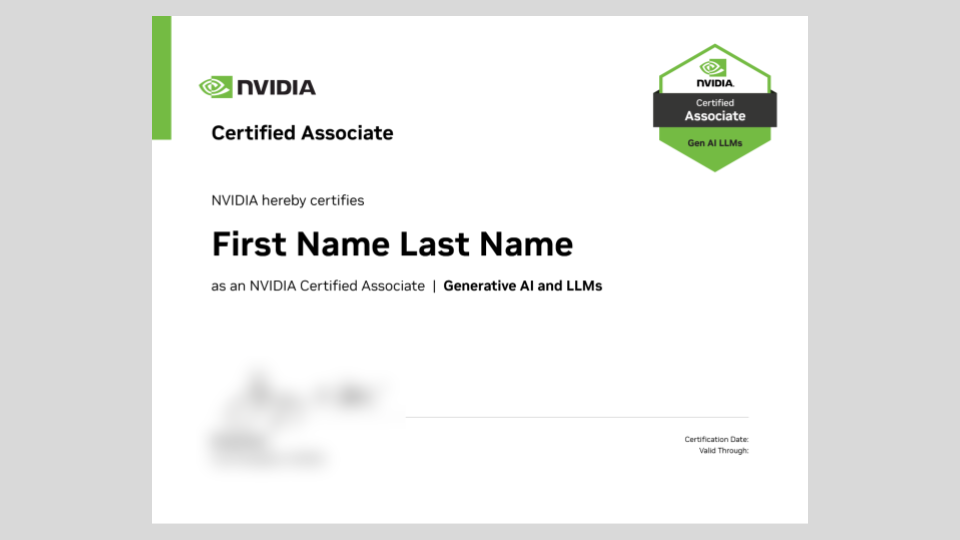

平野:はい、資格試験としては比較的少額で受験できるようになっています。また、英語のネイティブスピーカーでない人には試験時間の延長措置も設けられており、英語が苦手な方であっても受験しやすいように工夫しています。こちらも、資格取得証(Certified Associate あるいは Professional)という、先ほどのDLIコース完了証明書と似たような証明書が授与され、同様に得られた資格はLinkedInのプロフィールに追加できるようになっています。

資格試験に合格すると、こちらの画像にあるような資格取得証(Certified Associate あるいは Professional)が授与される。DLIコース完了証明書と似ているが、こちらは右上に「Certified Associate」のエンブレムマークが表示されている。

※画像左下にはぼかし加工を施しています。

LinkedIn上での、DLIコース完了証明書や資格取得証の履歴表示例

平野:弊社としては、これらを普及させることで、企業や個人のスキルギャップ、そしてキャリアミスマッチを減らしたいと考えています。例えば、欧米の採用市場を見てみると、AI導入や活用が進んでいるにも関わらず、「雇いたい人が求めるスキル」と「応募者が持つスキル」の間にギャップがあり、すり合わせに非常に時間がかかっている現状があります。面接へ複数回行ったり、企業が独自にコーディング試験を設けたりと、大変な労力がかかっているわけです。

―― 日本でも、そのようなシーンが徐々に増えていくことが想像できますね。

平野:「AIを知っている」ことと「AIを使える」こと、そして「AIを活用できる/開発できる」ことは全くベクトルが違う中で、弊社のDLIやCertificationプログラムはいずれも実践的な内容がベースとなっており、また先ほどお伝えしたワンアーキテクチャの前提も相まって、実践力の証明になると考えています。

日本語版DLIオンライン自習コースもリリース済み

―― 先ほど「日本語のオンライン自習コースも用意している」とおっしゃっていましたが、具体的にどのような内容でしょうか?

平野:直近では大きく3つ、「生成AI解説」「検索拡張生成(RAG)でLLMを強化する」「LLM による RAG エージェントの構築」のコースを日本語でリリースしています。「LLM による RAG エージェントの構築」にはしっかりとしたコーディング課題もある、上級者向けのコンテンツであるのに対して、「生成AI解説」コースは必ずしも技術者やエンジニアでない方にも受講いただける内容となっています。生成AIの基礎から応用、そして実務上の課題までを網羅しており、ぜひ幅広い方に受講していただきたいです。

―― 非エンジニアの私でも受講しやすそうです。ぜひ、具体的な構成も教えてください。

平野:大きく4つのパートから構成されています。

- 生成AIの基本概念とその仕組み

- 言語分野における生成AIのユースケース

- 他の分野における生成AIのユースケース

- 生成AIの課題と機会

「生成 AI 解説」コースの受講画面例

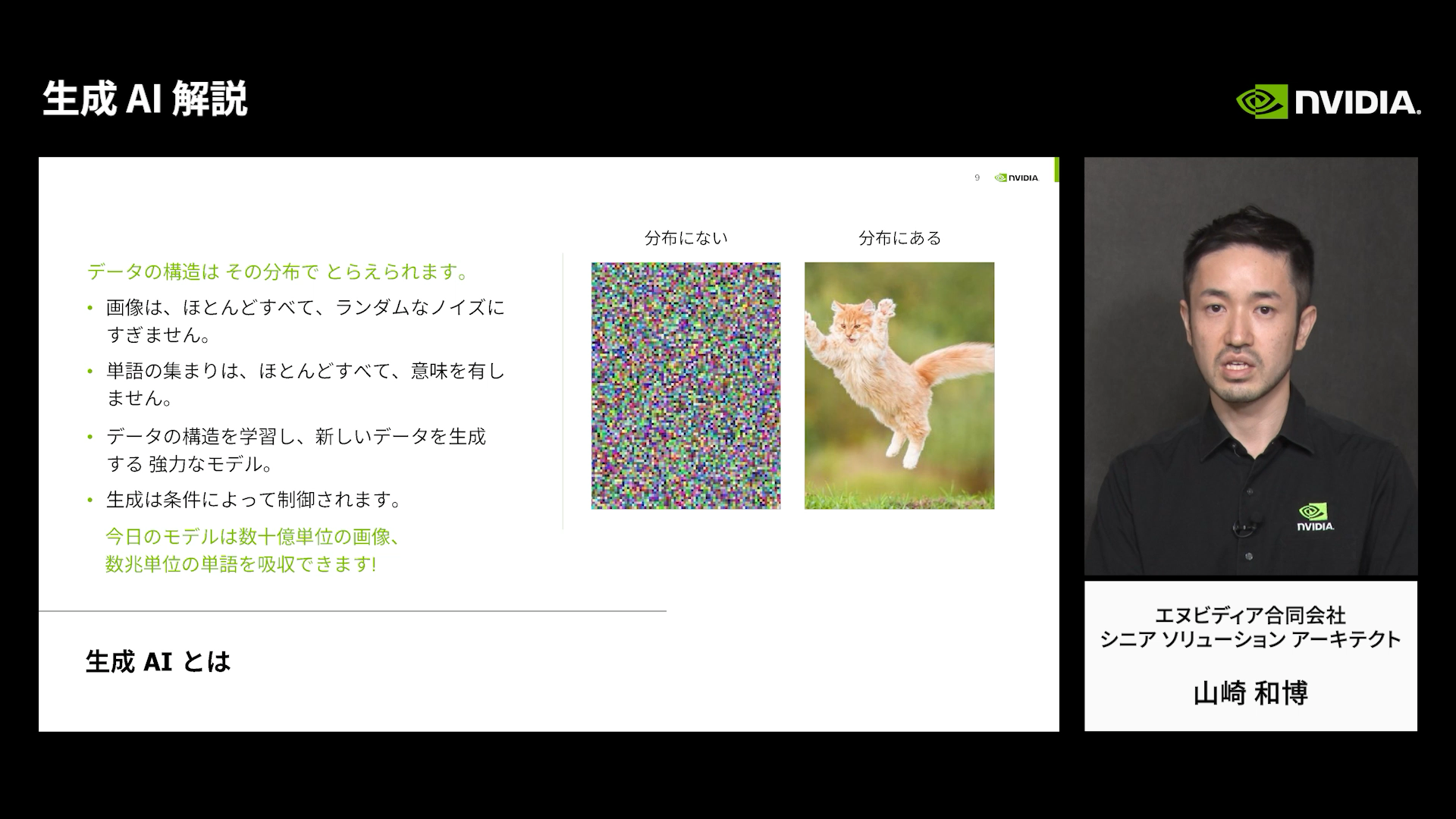

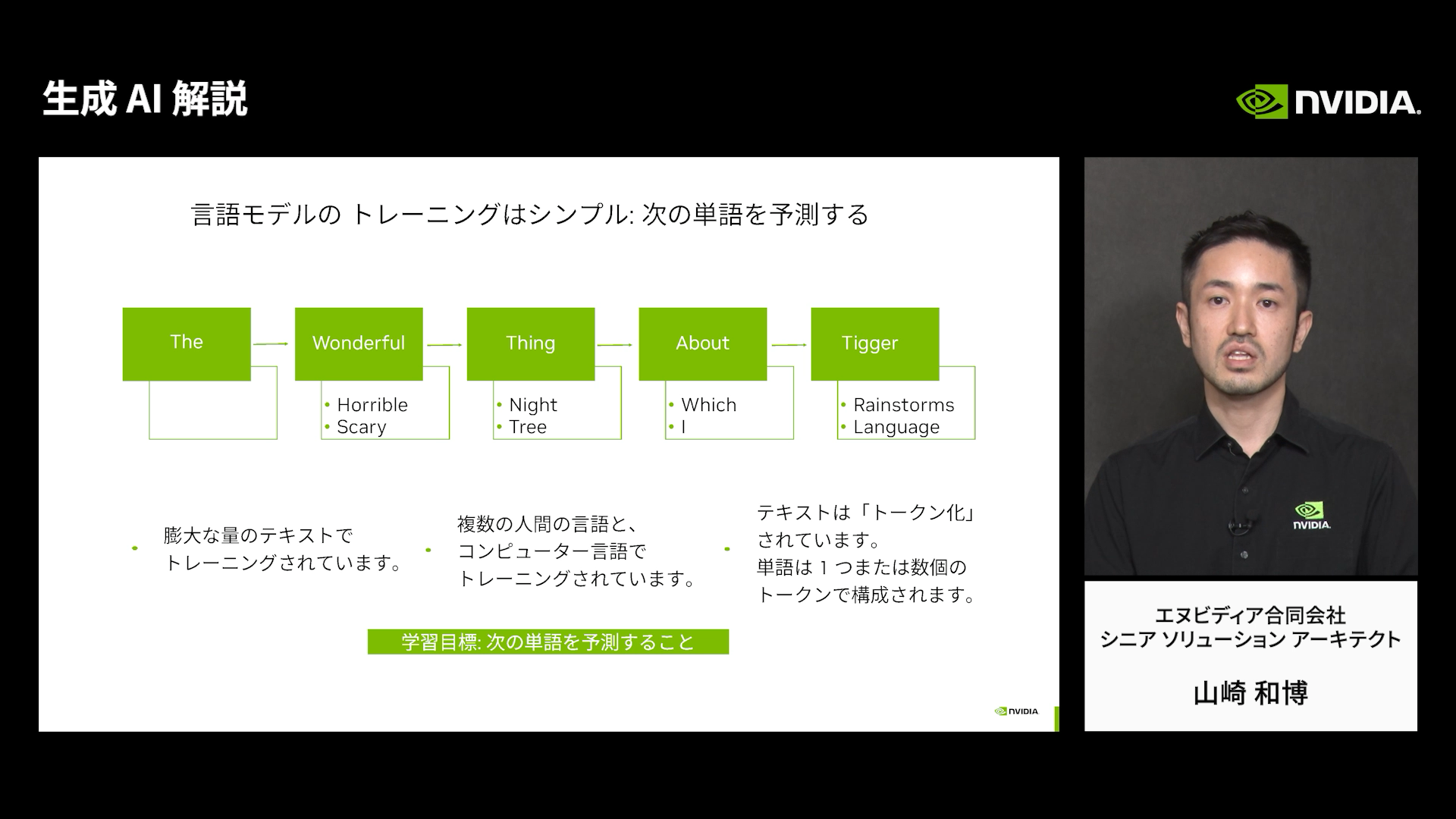

平野:最初の「生成 AI 基本概念とその仕組み」チャプターでは、生成AIとは「何か」と、生成AIの「仕組み」について、分類問題と比較しながら説明されます。生成モデルはデータが持つ構造を推定し、それを基に新しいデータを生成するアプローチであり、データ構造は、データの「分布」の推定によって行われるという概念が説明されます。

ニューラルネットワークをベースとした生成モデルとして、GAN、VAE、Transformer、Diffusion、NeRFなどが紹介され、特にTransformerをベースとするモデルは、モデル規模を大きくすることで高い能力が得られる性質があることが述べられる。これらの学習を通じて、生成AIがデータをどのように捉え、どのように新しいデータを生み出すのかという基本的な考え方と、それを支える技術の進化について学ぶことができる

平野:続く「言語分野における生成AIのユースケース」チャプターでは、主にChatGPTの背後にある仕組みや基本部分について解説しています。具体的な応用例として、ChatGPTがGTCについてうまく説明できた例や、MicrosoftのBingやEdge、Windows PCへのAI組み込み、MetaやGoogle、Appleなど各社による製品へのAI組み込みの動きが紹介されます。

質疑応答だけでなく、メール返信の自動生成やプレゼンテーション資料作成における画像自動生成といった応用も進められていることが分かる。これにより、ChatGPTに代表される言語生成AIが、どのような場面で、そしてどのように活用されているのか、また今後どのように製品やサービスに組み込まれていくのかについての具体的なイメージを得ることができる

平野:さらに、「他の分野における生成 AI のユースケース」チャプターでは、IT分野以外にも、教育やヘルスケア・生物学、農業、ロボティクス、デザインなど、非常に幅広い分野での応用が検討・実用化されている事例が紹介されます。

例えば、Microsoft Bingがチェスをプレイできた事例が示され、言語モデルが特定のタスクの知識を持たずに、言語による記述だけで複雑なゲームを進行できる能力があると示されます。NVIDIAの技術においても、テキストから3Dモデルを生成するMagic3Dや、テキストや追加画像から高品質な画像を生成するEdifyが紹介され、メタバースなどの仮想空間でのコンテンツ生成への応用可能性も示唆されます。

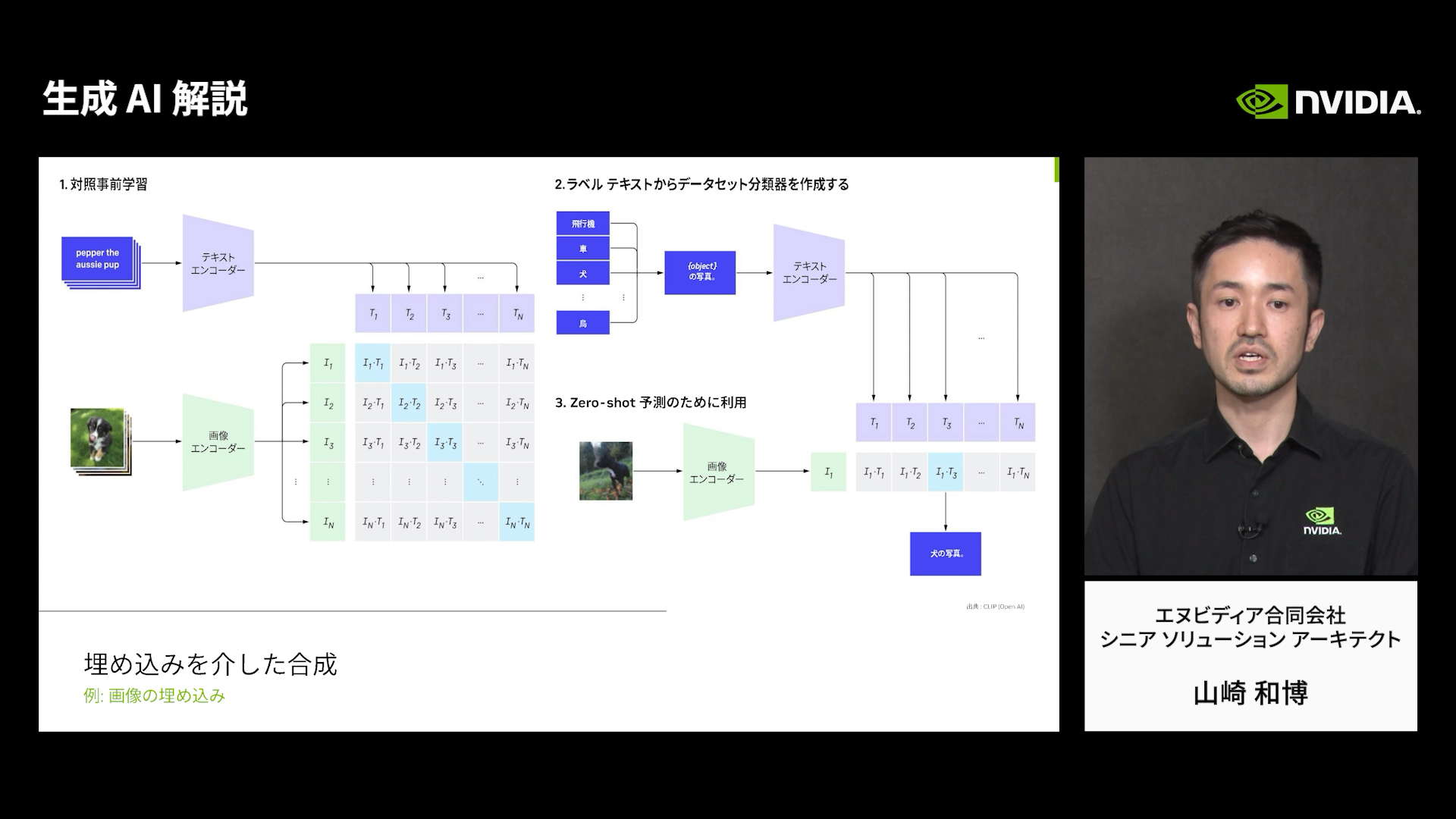

多様なモダリティ(テキスト、画像、3D、音声など)を組み合わせるアプローチとして、埋め込み(エンベディング)を利用したOpenAIのCLIPの例が紹介され、テキストから画像生成、画像からテキスト生成などが可能になる仕組みが説明される。これらの内容から、言語以外の様々な種類のデータを扱う生成AIの能力、そしてそれが多様な産業やクリエイティブ活動でどのように活用され得るかについての深い洞察が得られ、また、複数の種類のデータを組み合わせて生成を行うマルチモーダルAIの可能性についても理解が進む

平野:そして最後の「生成 AI の課題と機会」チャプターでは、出力に誤った情報が含まれるハルシネーションや、学習データに起因する問題(不適切、有害、偏り、機密性、権利侵害など)、機密性・プライバシー保護の難しさ、法規制への準拠、学習・デプロイに必要な膨大な計算資源とコストといった、生成AIにまつわる課題と、それらに対する取り組みが紹介されています。

特に、安全性向上と性能維持の両立を目指すアプローチが有益であると述べられていて、NVIDIAの取り組みとしても、大規模学習の効率化(MoLEによる数千GPU利用効率向上)や、ハードウェア・ソフトウェア全体の最適化、柔軟な開発環境の提供、そして推論(デプロイ)効率の向上への注力が紹介されています。

生成AIの課題と機会に関する議論を通じて、生成AIの現在の限界、安全かつ責任ある利用のために不可欠な取り組み、そして今後の発展のために克服すべき技術的・社会的な課題について学ぶことができる。また同時に、これらの課題に取り組むことが、生成AIのさらなる応用拡大に向けた「機会」であるとも捉えることができるようになっている

―― 1時間弱の動画を実際に拝見しましたが、テクニカルの内容が自然と頭に入ってくる内容になっていると感じました。

平野:難しく考えがちなニューラルネットワークや数学の話が一切出てこないので、高校生でも理解できる内容だと考えています。個人的に良いなと感じているのは、「これまでのAIと生成AIがどう違うのか」について、「データの構造や分布を推定できる」という一言で説明している点ですね。

これまで言語翻訳などは「日本語 A=英語 A」のようなペアを大量に学習していたのに対し、生成AIは大量の多言語データを読み込むことでデータの分布を教えてあげれば翻訳もできてしまう、という点が説明されています。これは意外と他のコンテンツでは説明されていない点かと思います。このように、自然と技術的な基礎が頭に入ってくる構成を心がけています。

より開かれた学習プラットフォームを目指したい

―― 今回ご紹介いただいたDLIオンライン自習コースですが、どのような方に受講してほしいですか?

平野:実際に生成AIを活用したいと思っている学生や企業の関係者の方。特に、将来、開発に携わりたいと考えている技術者や研究者に、ぜひとも一度受講してほしいです。

―― NVIDIAの日本法人チームとして、平野さんが考えている展望を教えてください。

平野:まずは日本の皆さまに、DLI自体を知っていただきたいと考えています。だからこそ、今回はエンジニアや技術者でない方にもおすすめのコースについてご紹介いたしました。今後はよりアドバンスなレベルの技術者のニーズにも寄り添い、本格的なAIを独自に開発したい技術を学びたい方が必要とするコースを拡充する予定です。

―― ありがとうございます。それでは最後に、Qiita 読者の皆さまにメッセージをお願いします。

平野:今後DLIは、NVIDIA Certificationのラーニングパスに重点を置いて、コースの日本語化に取り組んでいきたいと考えております。全てのコースを日本語化するのは現実的に難しいですが、できるならやりたいという気持ちはあるので、ぜひ一人でも多くの方にDLIをご活用いただきたいです。英語が苦手だと感じてらっしゃる方にも、開かれた学習プラットフォームを目指したいと思っておりますので、ぜひ楽しみにしていただければ幸いです。

編集後記

今回の取材を担当するまで、かの有名なNVIDIAさんからここまで体系的なトレーニングプログラムが提供されていることを存じておりませんでした。実際に記事中でも言及されている「生成 AI 解説」コースを受講してみましたが、非エンジニアの私でも技術的な論点がスッと頭に入ってくる内容となっており、AIの影響があらゆるシーンに波及する昨今だからこそ、多くの方に受講してもらいたい内容だと感じました。英語学習に抵抗のない方は、さらに広大なコースが用意されており、これから本格的にAIを学びたい方にとっては、これ以上ない学習環境だと感じます。ぜひ、今回リリースされた日本語コースと合わせてチェックしてみてはいかがでしょう。

取材/文:長岡 武司

撮影:伊東 祐輔