ファッションから「だるまさんがころんだ」まで。AIの民主化を目指すハッカソンに潜入 〜日立 × Intel AI Hackathonレポート

2021年6月、日立製作所 Lumada Data Science Lab.とIntel(以下、インテル)が、オープンイノベーションの創出を目的にオンラインハッカソンを実施しました。

https://hackathon.we-are-ma.jp/aihackathon2021/

コンセプトは「AIを民主化するプロダクトをハックせよ」。

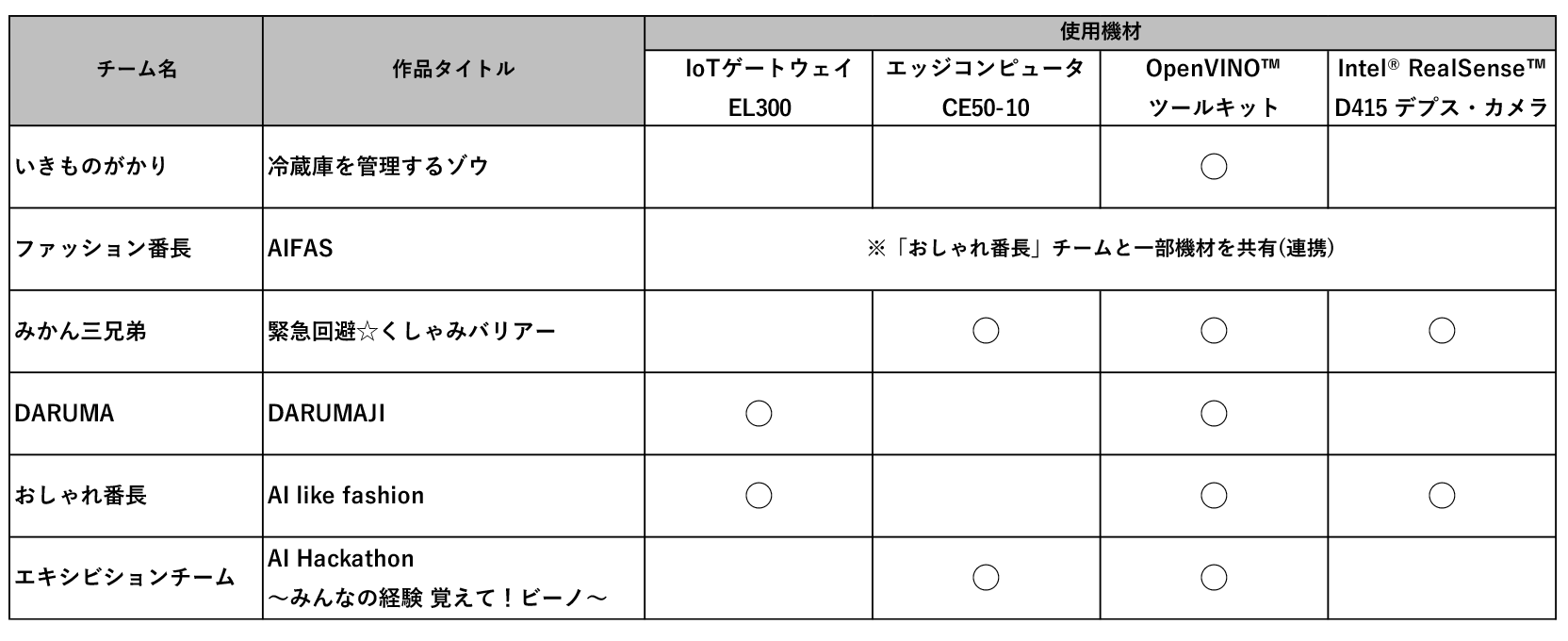

IoTゲートウェイ「EL300」やエッジコンピュータ「CE50-10」、「OpenVINO™ ツールキット 」、デプスカメラ「Intel® RealSense™ D415 デプス・カメラ」など、両社がもつ最先端技術を自由に使えるプロダクト開発環境が提供され、計6チームが“AIの民主化”に向けた様々なプロダクトを発表しました。

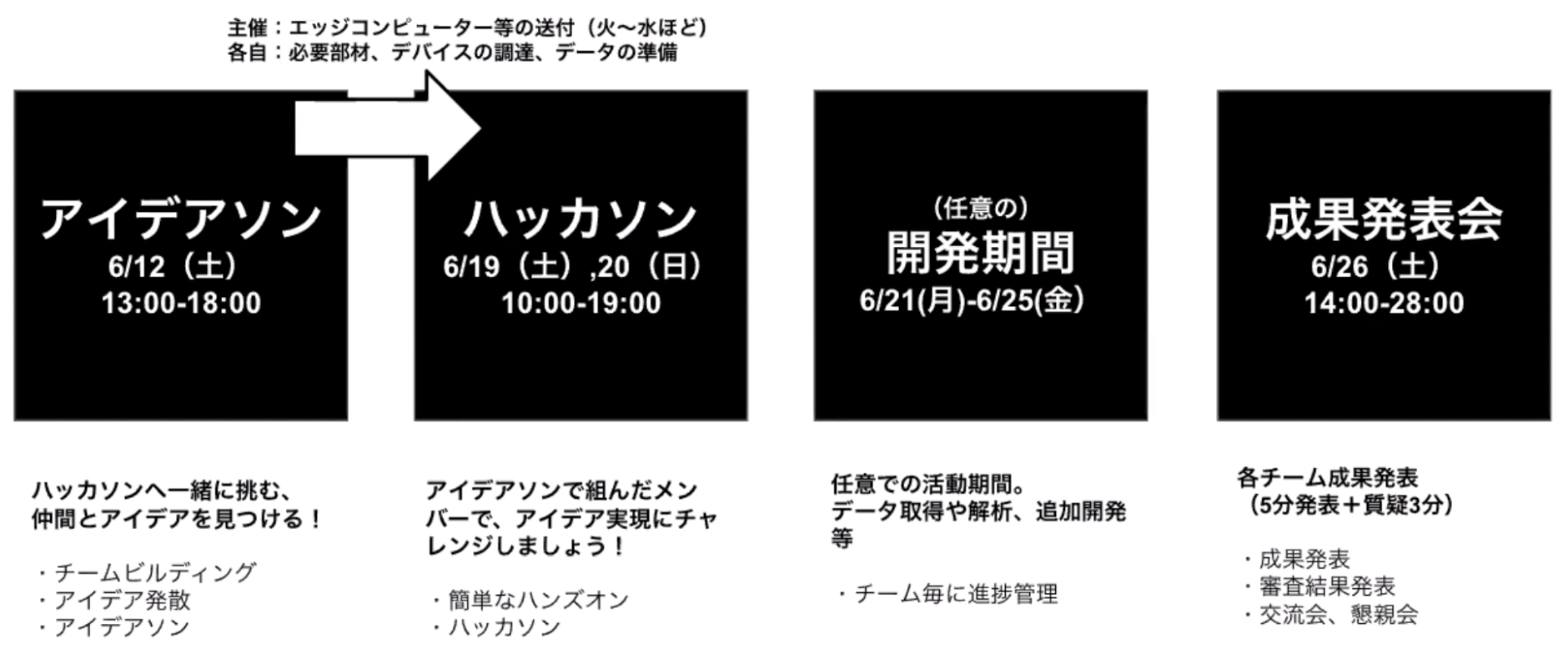

本ハッカソンは6月12日(土)のアイデアソン・チームビルディングから始まり、6月19日(土)および20日(日)のハンズオン・ハッカソンを経て、6月26日(土)に成果発表会を実施。

本レポートでは、最終日である成果発表会の様子をお伝えします。

目次

審査員の皆さま

- 砂金信一郎(LINE株式会社 執行役員 兼 AIカンパニー カンパニーCEO)

- 土岐英秋(インテル株式会社 執行役員常務 技術本部長)

- 影広達彦(株式会社日立製作所 研究開発グループ テクノロジーイノベーションセンタ統括本部 先端AIイノベーションセンタ長)

冷蔵庫を管理するゾウ(「いきものがかり」チーム)

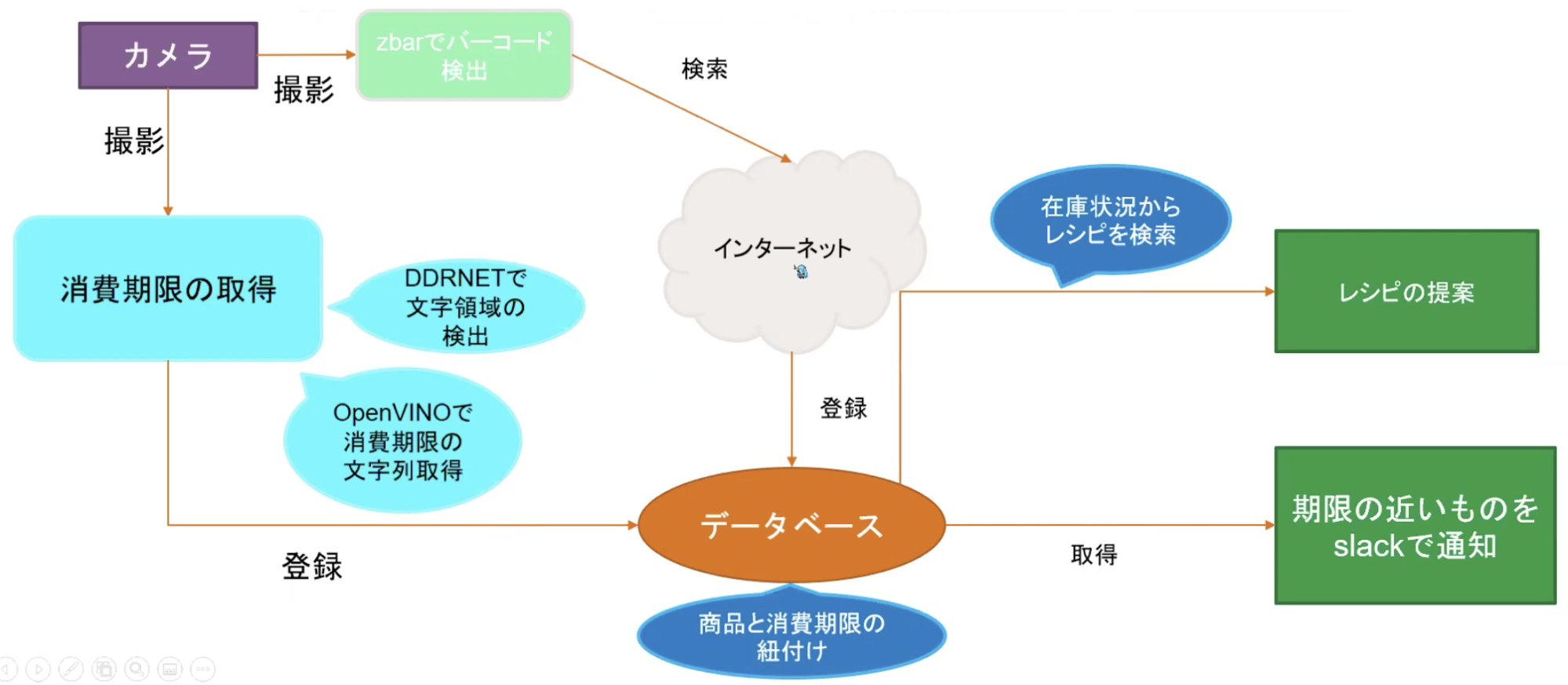

最初の発表チーム、「いきものがかり」からは、冷蔵庫管理アプリが発表されました。これは、冷蔵庫にある食品の賞味期限を覚えられない、という課題に対して、AIに管理してもらうというテーマで開発されたプロダクトです。

使い方は簡単で、アプリ内カメラで消費期限をスキャンし、次いでバーコードを読み取って商品を判別して、消費期限と一緒にデータベースに登録します。食品の期限が近くなったら、アプリサイドから消費期限が近づいている旨の通知が来るという流れです。また、おすすめのレシピも選択肢として提示されるとのことです。

こちらがシステム概要図となっており、スマホのCPUのみで動作していることがわかります。開発で使用されたツールやモデルは以下の通り。

- デバイス:Webカメラ

- アノテーションツール:Vott

- ライブラリ:PyTroch、kornia、zbar、Beautiful Soup、OpenVINO text-recognition-0012

- モデル:DDRNET

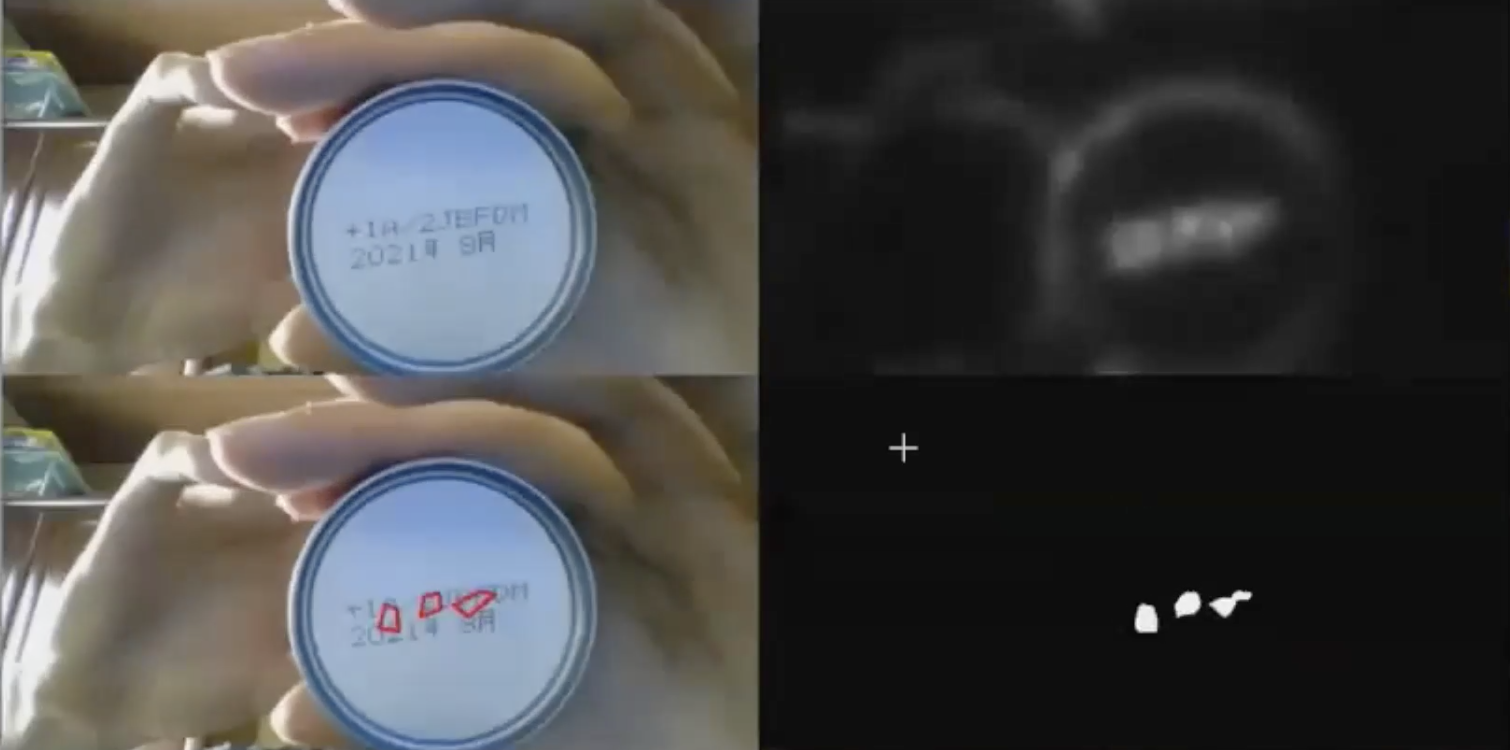

デモ映像では、左上映像が入力したカメラの情報で、右上がネットワークの出力、右下は右上映像をより表現しやすくしたもので、左下がそこから四角形を推定したものとなります。

工夫した点としては、DDRNetを使った移転学習を活用したこと、OpenVINOを使った学習済みモデルを活用したこと、そして商品名取得時にグレースケール化をすることで精度向上を実現したことなどが挙げられました。またTTA(Test Time Augmentation)により速度は落ちるものの、精度は向上するということも、進めていく中で分かったと言います。

今後の展望としては、DDRNetで文字領域の検出の精度向上を行い、学習データを追加して検出領域のセグメント向上を図りたいとしました。また、OpenVINOの消費期限検出の精度向上も目指したいとのこと。こちらについては、複数の表記パターンへの対応(例:21.6.26、21.06.26、21年6月26日)が挙げられました。いずれも画像の前処理、後処理での解決を予定したいとのことです。

なお、複数の審査員コメントを代表して、今回は以下の影広氏とのやりとりをご紹介します。

影広達彦氏(株式会社日立製作所 研究開発グループ テクノロジーイノベーションセンタ統括本部 先端AIイノベーションセンタ長)

影広:私自身、昔OCRの研究をやっていたからこそ、物体の上の文字を認識することの難しさが良くわかります。曲面の様子や光の正反射具合とかで色々と大変だったと思うのですが、その辺りはどうされましたか?

チーム:曲面については意外と認識精度が落ちなかったのですが、反射についてはまさにおっしゃる通りでした。全然認識しないという状況でした。

影広:そうですよね。難しいことにトライされたなという印象です。このアプリのターゲットを「文字じゃないとダメだよね」という部分によりフォーカスをすると、さらに突破口が見えてくる気がします。

AIFAS(「ファッション番長」チーム)

次の「ファッション番長」チームからは、「スマホの中に試着室!アプリを入れるだけで、おうちで好きな服に1秒試着」というコンセプトのアプリ「AIFAS」が発表されました。

こちらは、スマホ上でのEC体験をグッとリアルなものへと向上させるアプリ。コロナ禍によって、オンラインの販売需要が向上しているからこそ、アパレル業界のEC売り上げや顧客獲得に貢献することを目指して開発されたものとのことです。

ポイントとなるのは、GAN(敵対的生成ネットワーク。Generative Adversarial Networks。以下、GAN)モデルによるAIの活用です。従来はARで行われていた試着体験について、最新論文を用いたGANのモデルを使用することで、より違和感のないバーチャル試着を可能にしています。

具体的には、左上の黒い服を着た女性の写真に対して、その右側の青い服をシミュレーション試着させようとすると、皮膚と洋服の境がうまくいかない状況(写真左から3番目列)が、従来型のAR試着の課題でした。その課題を同チームではGANモデルを活用することで、一番右側の写真のようにキレイにフィットさせることができたというわけです。

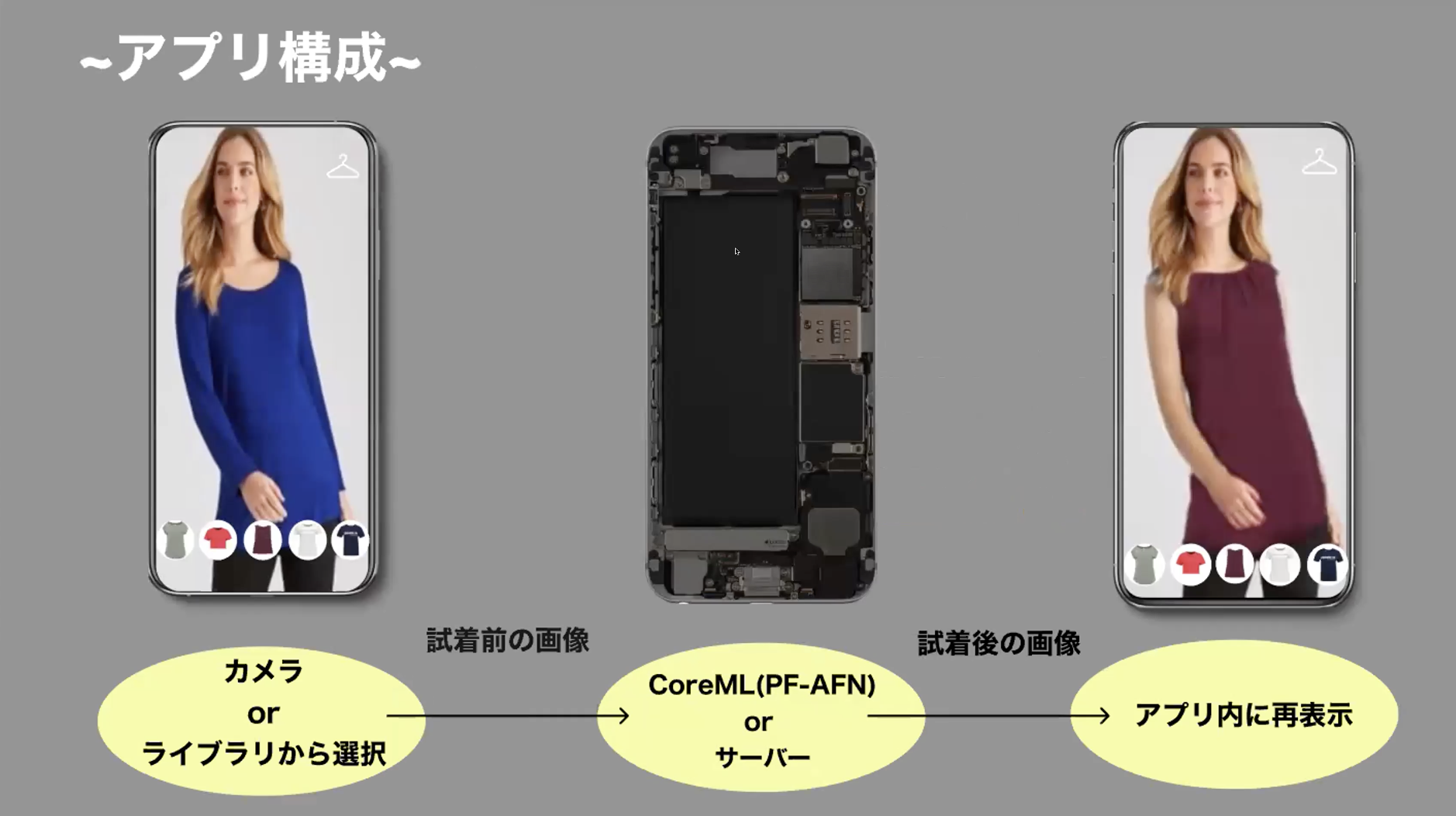

アプリ構成としては、以下の通り。カメラで撮影した写真、もしくはライブラリから選択した写真を、iPhone内にあるCoreML(PF-AFN)もしくはサーバーで画像処理をさせることで、アプリ内に再表示させるようになっています。

工夫した点としては、CPUで推論できる独自のcustom operatorで実装し、OSSで公開したことで、独自の変換を施し、ONNX変換とJIT変換がなされ、CPUでの動作を可能にしたことが挙げられました。

またチャレンジポイントとして、C++からPyTorchへの書き換え、JIT変換、ONNX変換をすることで、CPU推論を可能にし、エッジデバイスを含む幅広いデバイスでの利用を可能にしたことが挙げられました。

今後の展望としては、おうちバーチャル試着を高精度で実現することで、店舗の新規顧客獲得をサポートし、またユーザーに対しては閲覧した服のリコメンド機能やサジェスト機能を実装してユーザビリティの向上を目指すとしています。身近なファッションとAIを結びつけることで、新しいAI体験を提供し、AIの民主化につながるだろうと締め括られました。

なお、複数の審査員コメントを代表して、今回は以下の土岐氏からのコメントをご紹介します。

土岐英秋氏(インテル株式会社 執行役員常務 技術本部長)

土岐 : これは、みんながまさにやりたいことだと思います。これまでの取り組みとしては、各社フィッティングのところにすごく気を遣っていたと思いますが、ある意味でここは運用でもカバーできる部分だということが分かってきました。つまり、例えば3つのサイズをセットで郵送して、合わなかった2サイズを返送してね、というやり方などができるわけです。そのような観点から考えても、まずは自分が着た時の見え方を先にやるというところとしては、非常に面白いと思いました。

緊急回避☆くしゃみバリアー(「みかん三兄弟」チーム)

3番目の「みかん三兄弟」チームからは、ニッチではあるがユーザーのインサイトを突いたプロダクトが発表されました。

題して「緊急回避☆くしゃみバリアー」。ビデオチャットをしている際に、急にくしゃみをすることで、相手をびっくりさせてしまうことがないようにするツールです。

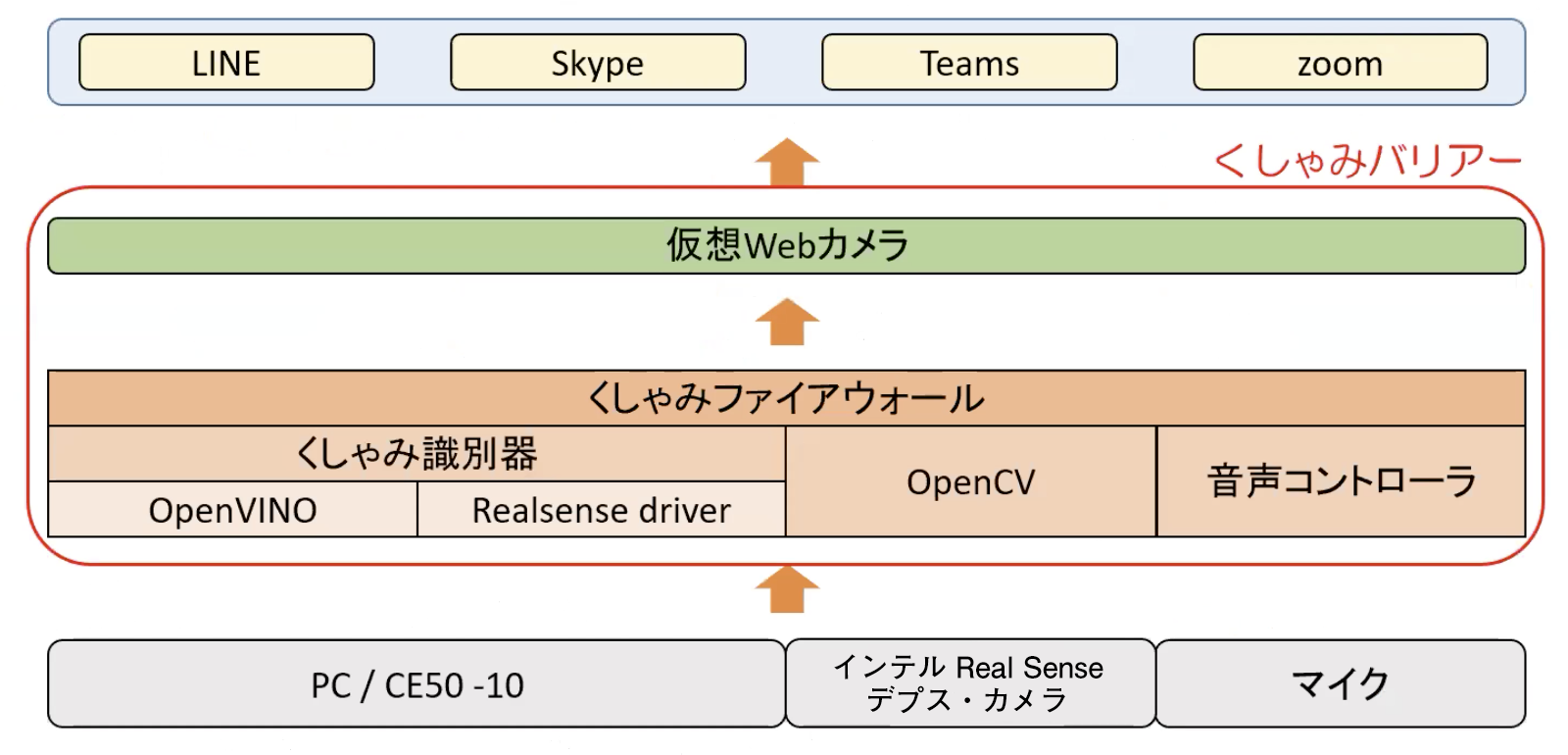

具体的には、くしゃみを出す前に「くしゃみファイアウォール」がくしゃみを予測して、事前に音声をミュートにし、映像を別の画像に差し替えてくれるというものです。

システム構成としては上図の通り。ハードから「くしゃみバリアー」を通じて、各種アプリへと橋渡しするというイメージになっています。くしゃみバリアーは、「仮想Webカメラ」と「くしゃみファイアウィール」という2層で構成されています。

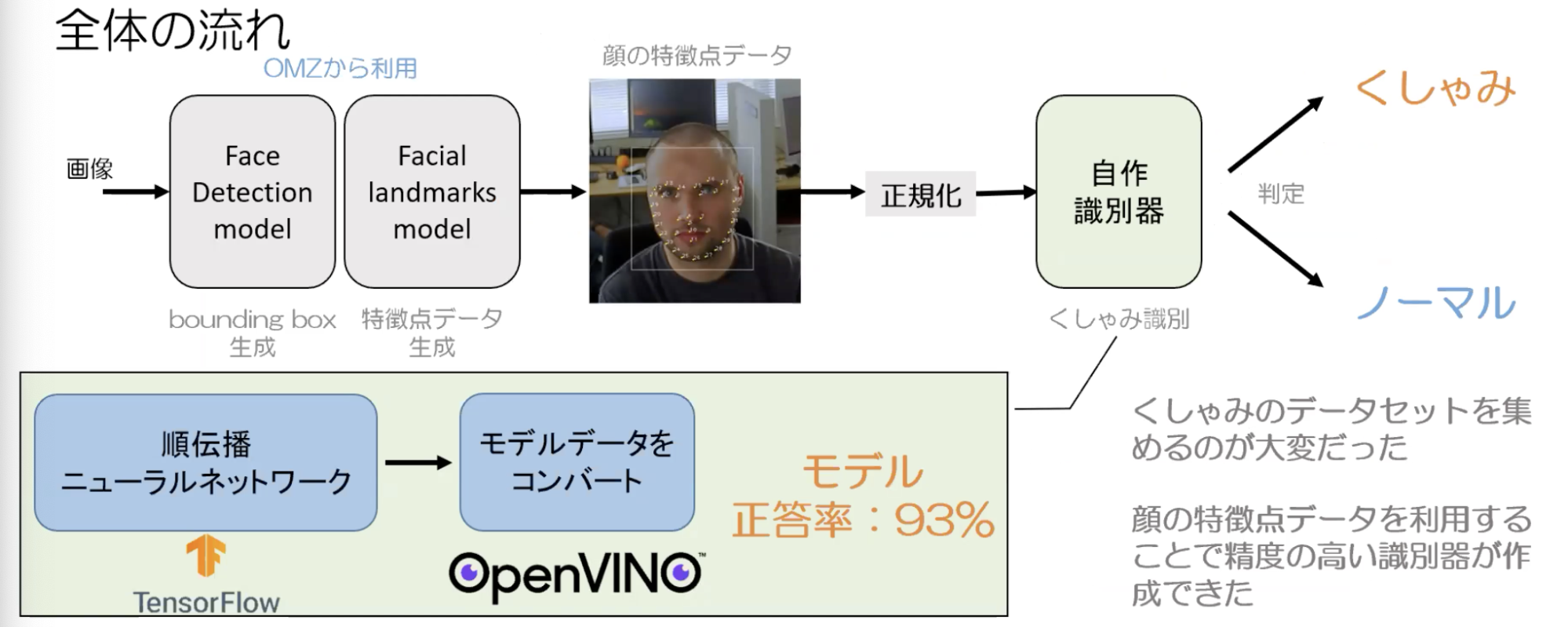

AIの活用箇所としては以下の通りで、使用したモデルは3つ、Face Detection model、Facial landmarks model、そして自作識別器です。

前者2つは、入力された画像から顔の特徴点データを抽出し、その特徴点データを正規化して、自作識別器に入力することで、くしゃみの顔か普通の顔かを判定しています。この自作識別器は、TensorFlow上で作成した順伝播ニューラルネットワークモデルから、OpenVINOのモデルへとコンバートして使用しています。

特に、くしゃみのデータセットを集めることが大変だったとのことですが、顔の特徴点データを利用することで精度の高い識別器がつくれ、結果として正答率は93%を実現できたということです。

今後の展望としては、くしゃみバリアーというアイデアから、ハードを使った新しいチャレンジも生み出していきたいとのこと。具体的には、身体を制御できないシチュエーションをサポートするアイデアに発展できないかということで、例えば生産ラインで勤務する労働者が突如行動不能になったら、CE50-10がラインを緊急停止する、といった用途を想定しているとのことです。

この、ありそうでなかった「くしゃみを事前にミュートにする」ツールに対しては、土岐氏から以下のコメントがなされました。

土岐 : とても楽しいデモでした。もしかしたら、何事もなかったかのように普通の画像に差し替えるといったこともあるかもしれませんね。あとはもう一歩進んで、感情を読み取るところまで進めることができると、例えば学校の教室などで生徒の表情をAIモニタリングして、半分くらいが眠そうだといった情報を教師などと共有することなども考えられるでしょう。応用の幅が広がりそうだなと感じました。

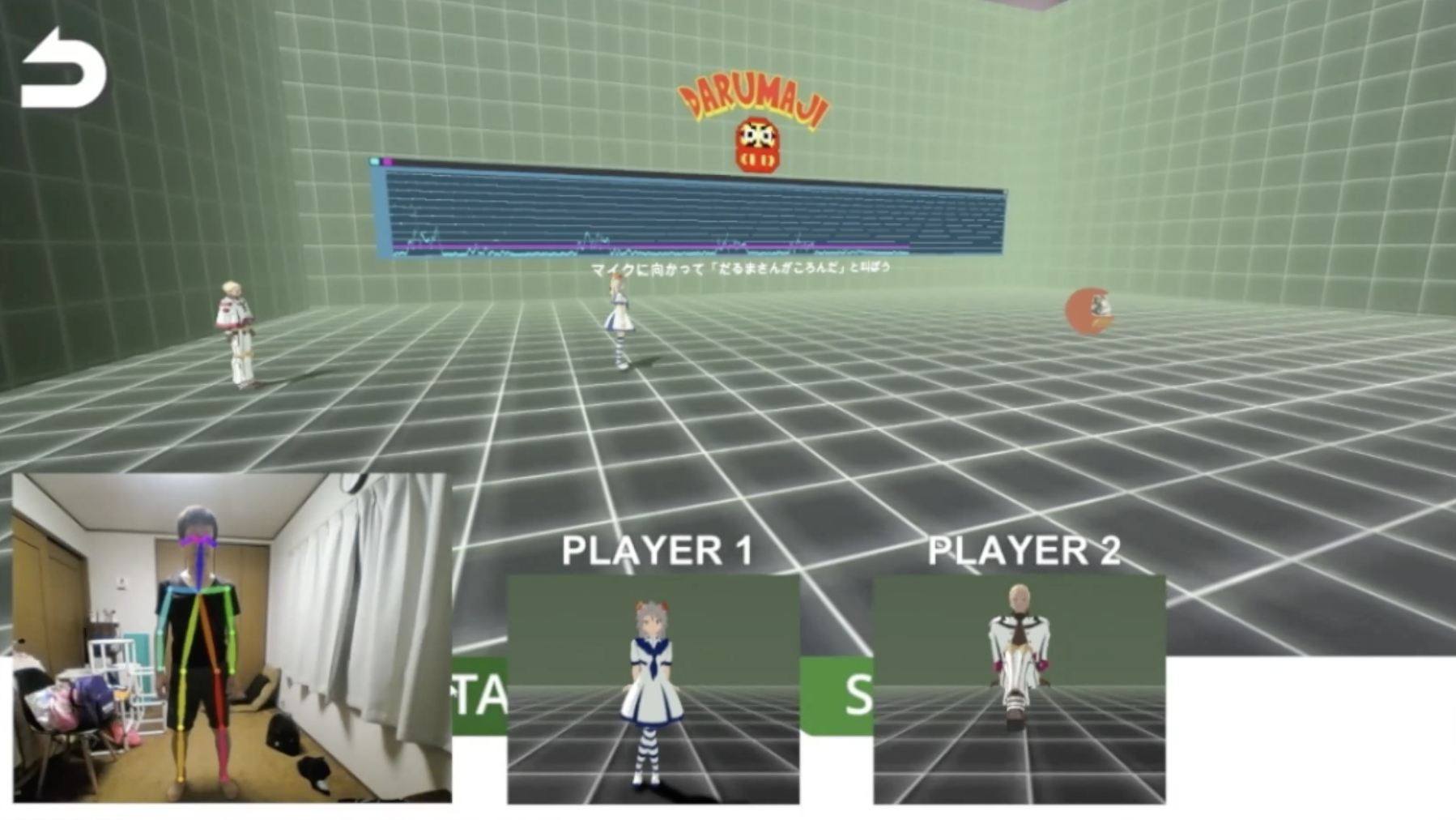

DARUMAJI(「DARUMA」チーム)

次の「DARUMA」チームからも、なんともユニークなAIプロダクトが発表されました。家の中で遊べる本気の「だるまさんがころんだ」、題して「だるまさんがころんだMAJI」、通称「DARUMAJI(ダルマジ)」です。

使い方は簡単。専用ハードとなる「DARUMAJI」に、専用のWebカメラをセットして、パソコンと接続することで準備完了。

操作画面は以下の通り。「だーるーまーさーんーがーこーろーんーだ」という掛け声が終わると、「ダルマジ様」が振り向き、そのタイミングで動いている人がいると、アウトになるという、いわゆる一般的な「だるまさんがころんだ」に準拠したルールとなっています。

AIで骨格を検出しているため、わずかにでも動くと検出されてしまいます。

ダルマジ様が振り向いたタイミングで動いていると、プレイヤーは“だるま”にされてしまい、GANで生成された“だるま顔”が表示されるようになり、仲間の助けを待つのみとなります。捕まった仲間を助け出して、こっそりとダルマジ様に近づいてタッチをすれば、ゲームクリアというわけです。

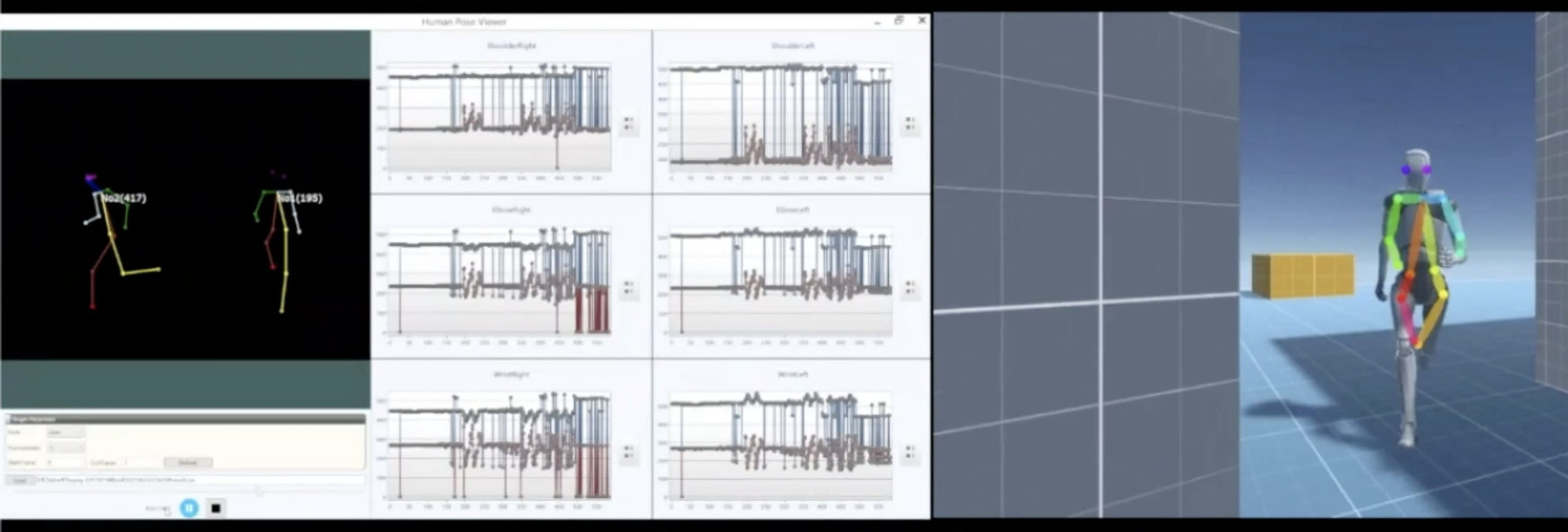

システム構成としては以下の通り。3日という短期間で、数多くのチャレンジが盛り込まれていることが分かるでしょう。

普通のWebカメラと普通のマイクから画像と音声をIoTゲートウェイへ入力し、OpenVINOが動作するIoTゲートウェイでDARUMAJIアプリをモニタへと表示。通信でだるま型ロボット・ダルマジ様を駆動しています。このダルマジ様は、サーボモーターとNeoPixelLEDをM5AtomLiteで駆動しており、Webカメラと一体化する土台は専用設計したうえで、3Dプリンタ出力しているとのことです。

また、先述した骨格検出についてはHuman Pose Estimationで実現しており、Unity上に再現することで、アバターと同期した動きを実現しています。今後は、キャラクターの動きを元に人の動きを追加学習し、精度を向上させていく予定とのことです。なお、「だーるーまーさーんーがーこーろーんーだー」という掛け声については、声の波形から独自検出していると言います。

今後の展望としては、工場での危険予知やリハビリ支援、国際的なeスポーツでの活用等を想定しているとのことです。

なお、複数の審査員コメントを代表して、今回は以下の砂金氏とのやりとりをご紹介します。

砂金信一郎氏(LINE株式会社 執行役員 兼 AIカンパニー カンパニーCEO)

砂金 : こちら、タイムラグはどれくらいシビアに判定されているのでしょうか?

チーム:骨格検出はインテル OpenVINO ヒューマン・ポーズ・エスティメーションを利用しており、それをインテル® Core™ i7 プロセッサー上で実現しています。骨格検出の速度については、第6世代 インテル® Core i7™ プロセッサーで、Unity上で実現している数値としておよそ15〜20FPS弱で動作しています。その速度での認識精度となっていて、今回は腕や足の角度が何度以上といった判定の仕方をしているので、走るなどを極端な動作でない限りは、問題なく動作している認識です。

砂金 : 結構作り込んでいますね!サードパーソン・シューティングゲームなどにミニゲームとして入っていたら、普通に流行るんじゃないかなと思いました。

AI like fashion(「おしゃれ番長」チーム)

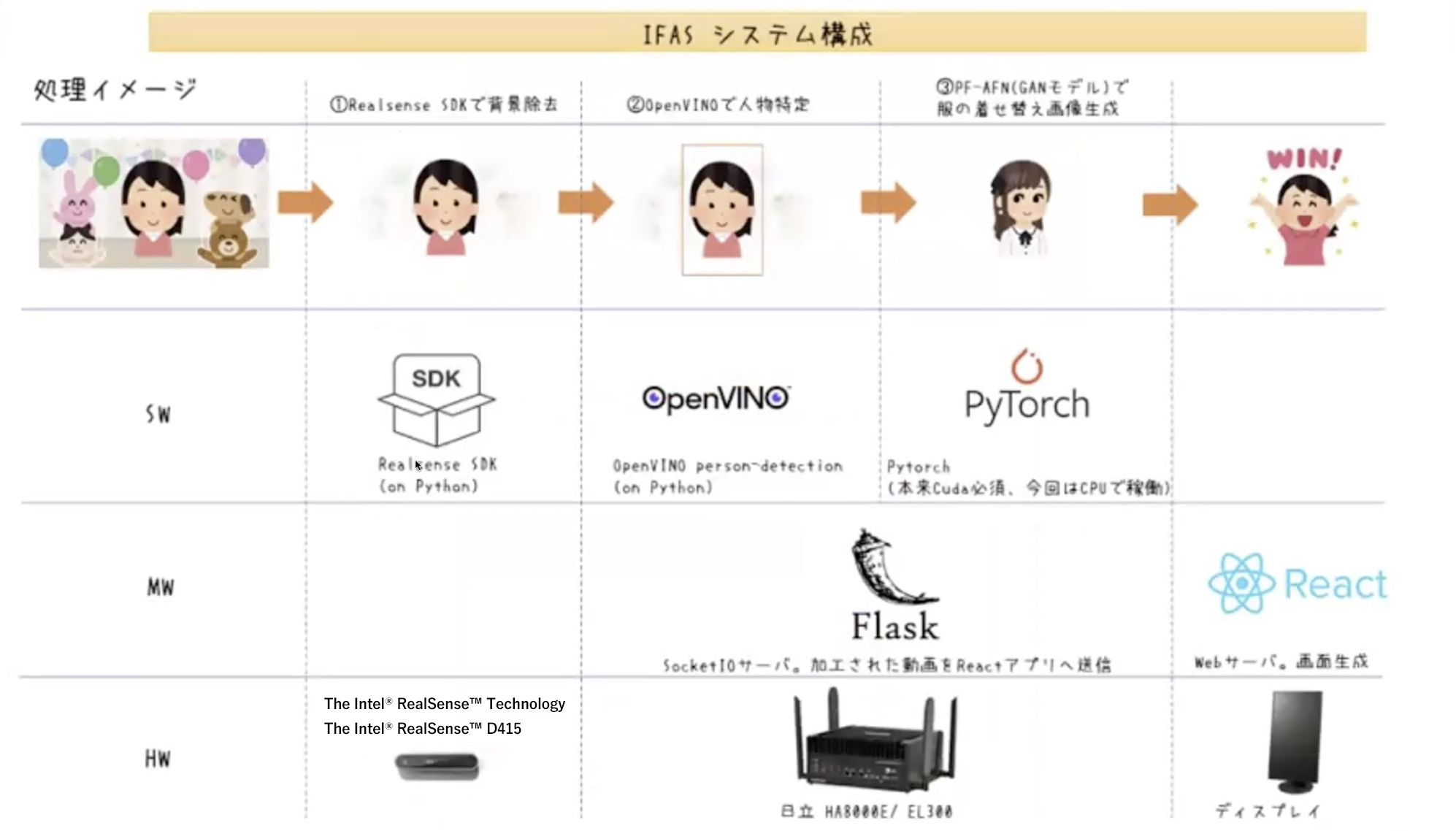

5番目となる「おしゃれ番長」チームからは、バーチャル試着を実現する「AI like fashion」が発表されました。こちら、実は先に発表された「ファッション番長」チームとの共同開発という形になっており、先ほどがiOS版だったのに対して、こちらはデバイス版としての開発を進めたとのことでした。

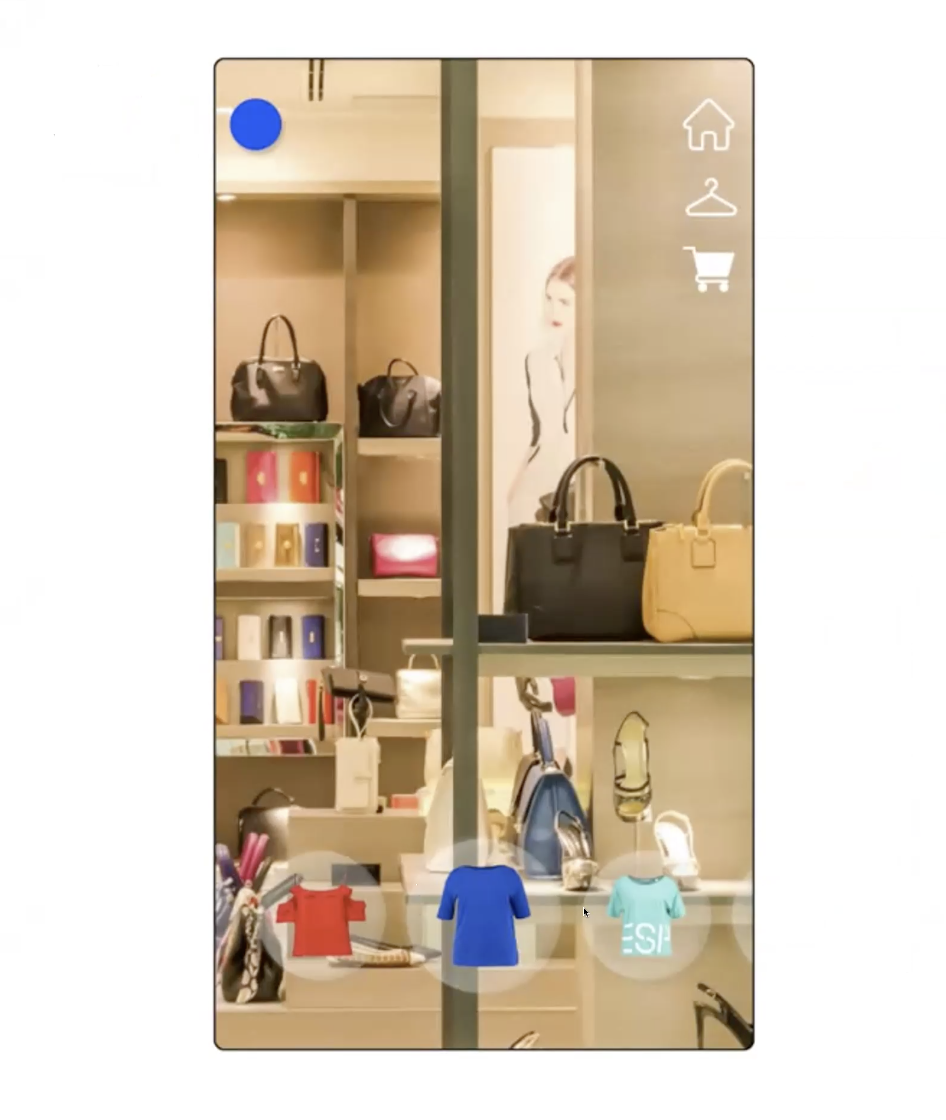

アプリ画面の「着てみる」ボタンを押すと、ユーザーの好みを学習しておすすめの洋服が複数提示され、そこから気に入った服を選んでさらに「着てみる」ボタンを押すと、服を着た様子が表示されます。一般的なバーチャル試着アプリと同様に、こちらも試着後に色を変えたり、似た服を探すことができるようになっています。

システム構成図としては以下の通り。まずはIntel® RealSense™ SDK2.0で背景を除去した上で日立のエッジコンピュータに渡し、OpenVINOで人物を特定したうえで、PF-AFN(GANモデル)で服の着せ替え画像を生成するという流れになります。

以下が実際のデモ画面です。画面下に洋服が並んでるのですが、こちらはユーザーの好み以外にも、全く違うセンスのものも混じっているとのこと。さらに右上のハンガーボタンを押すと、「これと似た服を着たい」と「全く違う服を着たい」の2択が用意されており、これによって、まだ見ぬ自分に似合う服へのセレンディピティも設計されているとのことです。

GANを使うことでリアルな試着と変わらないUXを提供できる点が新規性として挙げられました。また、CPUで動くリアルかつ軽量なバーチャル試着アプリを作成したことで、なりきりアトラクションや無店舗でも体験の高い購買が可能となるような応用の幅が効き、中小企業にもAIを活用したVirtual Try-on機能を提供できる点が、価値創造性として挙げられました。

さらに、パースフリーな学習アーキテクチャによってセグメンテーション情報を必要としなくなったことや、CPUで稼働するようにモデルを改修しJIT変換している点も、技術ポイントとして挙げられました。特に、CUDAでしか動かないコードを独自の変換を施し、JIT変換とONNX変換を可能にするのが大変だったと言います。

今後の展望としては、画像処理の精度を高めてより高いUXを実現し、また推論の時間を短縮してリアルタイムでの運用を検討していきたいとのことです。

なお、複数の審査員コメントを代表して、以下の影広氏からのコメントをご紹介します。

影広:昔、この辺りの分野の研究者とディスカッションをした際に、最高にオススメのものをリコメンドすると、人にとっては容易に類推できるものなので「当たり前だよね」ってなるという話がありました。最適じゃないけどちょっとズレていると、それはそれで「面白いね」ってなるというわけです。

こういったサービスを考える場合、もしかしたら本当のイグザクトマッチではなくて、一種の“ズラし”というものが重要なのかなと思いながら聞いていました。

AI hackathon〜みんなの経験 覚えて!ビーノ〜(エキシビションチーム)

最後は、日立とインテルの混合エキシビションチームチームです(審査対象外)。

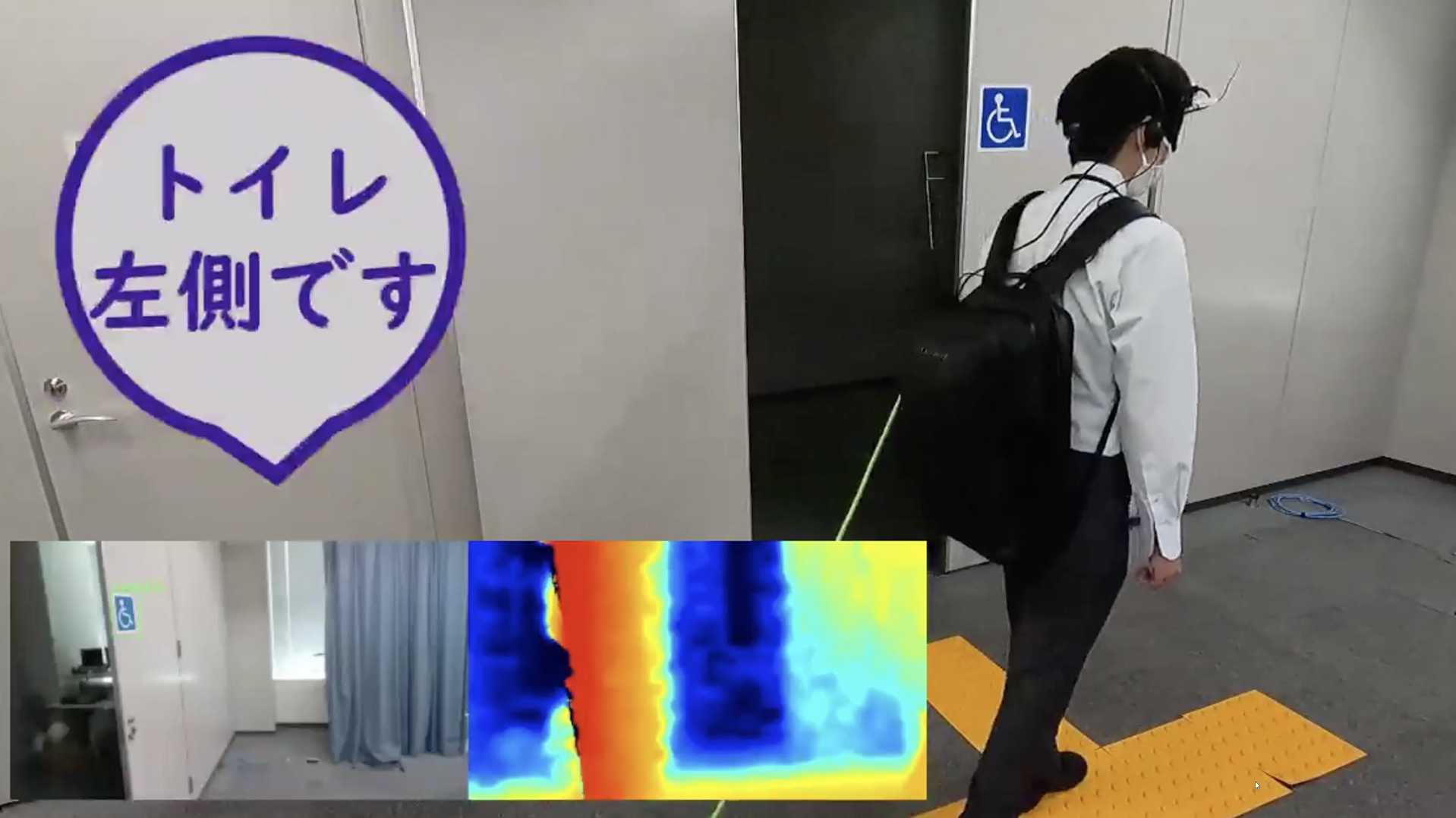

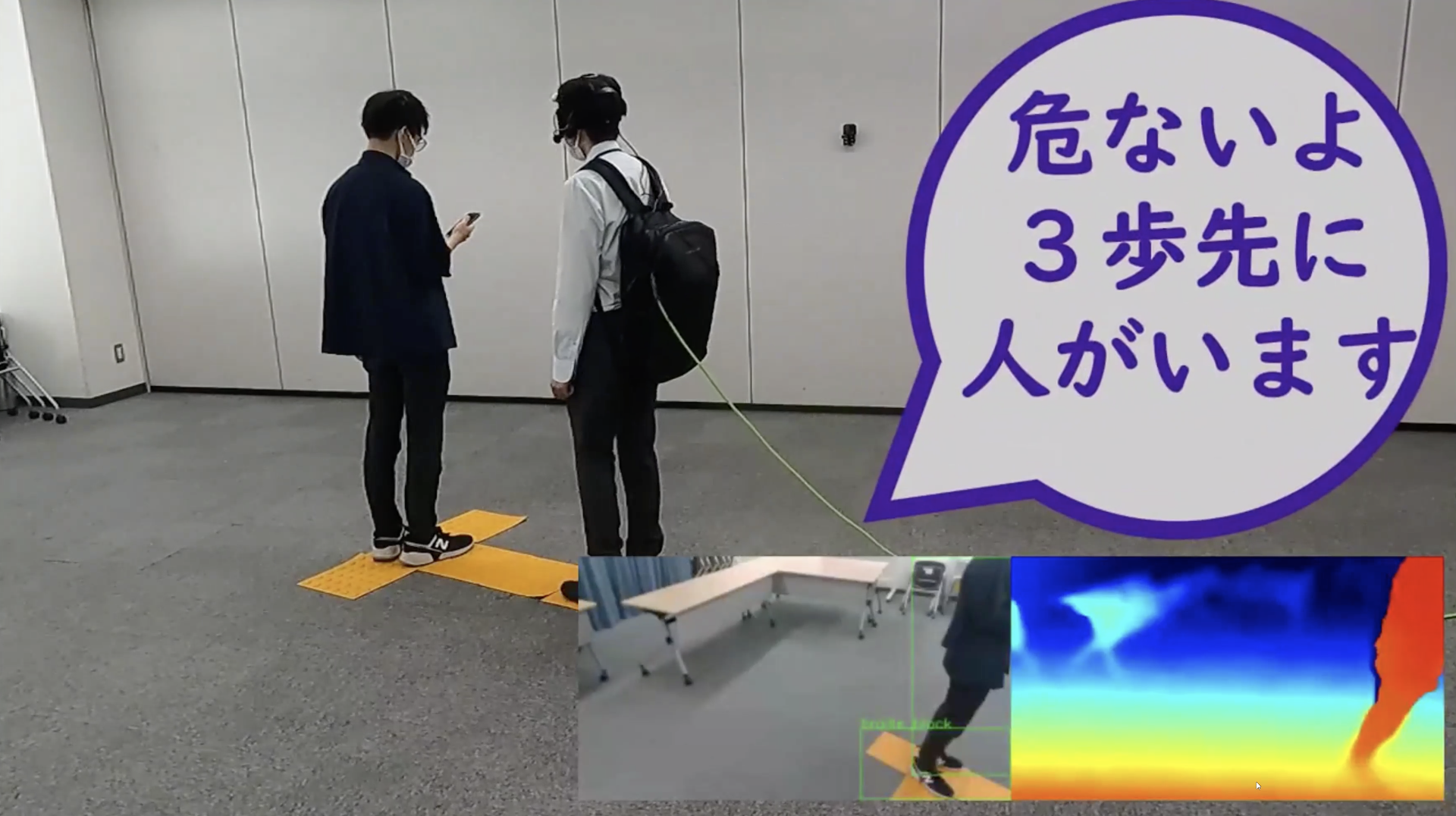

こちらのチームでは、視覚障害の方をサポートするプロダクトとして、「みんなの経験を覚えて、あなたの日常生活を声でサポート」するというコンセプトのツールを開発したとのことです。どのような場面で役に立つのか、ユースケースを2つご紹介します。

1つ目は、初めての場所でも音声でお知らせをする。例えばある場所でトイレに行く場合を想定した際に、過去のみんなの経験をOpenVINOが概念として学習し覚えることで、そこを視覚障害の方が初めて利用する場合でも、適切に道案内をしてくれるというわけです。

2つ目は、危険を察知してアラートを出す。例えば点字ブロック上の先に人が立っていた場合、先ほどと同じくOpenVINOが危ないパターンとして概念学習をしてくれているので、事前に危険である旨を通知してくれます。

このように、利用者自身の「経験」をインプット/アウトプットした「成長する集合知」を実現し、多様な環境への適用を想定したプロダクトとなっており、将来的には日常生活のみならず、工場や倉庫、建設場などの様々な作業現場の集合知を学習して教えてくれる存在になることが期待されています。

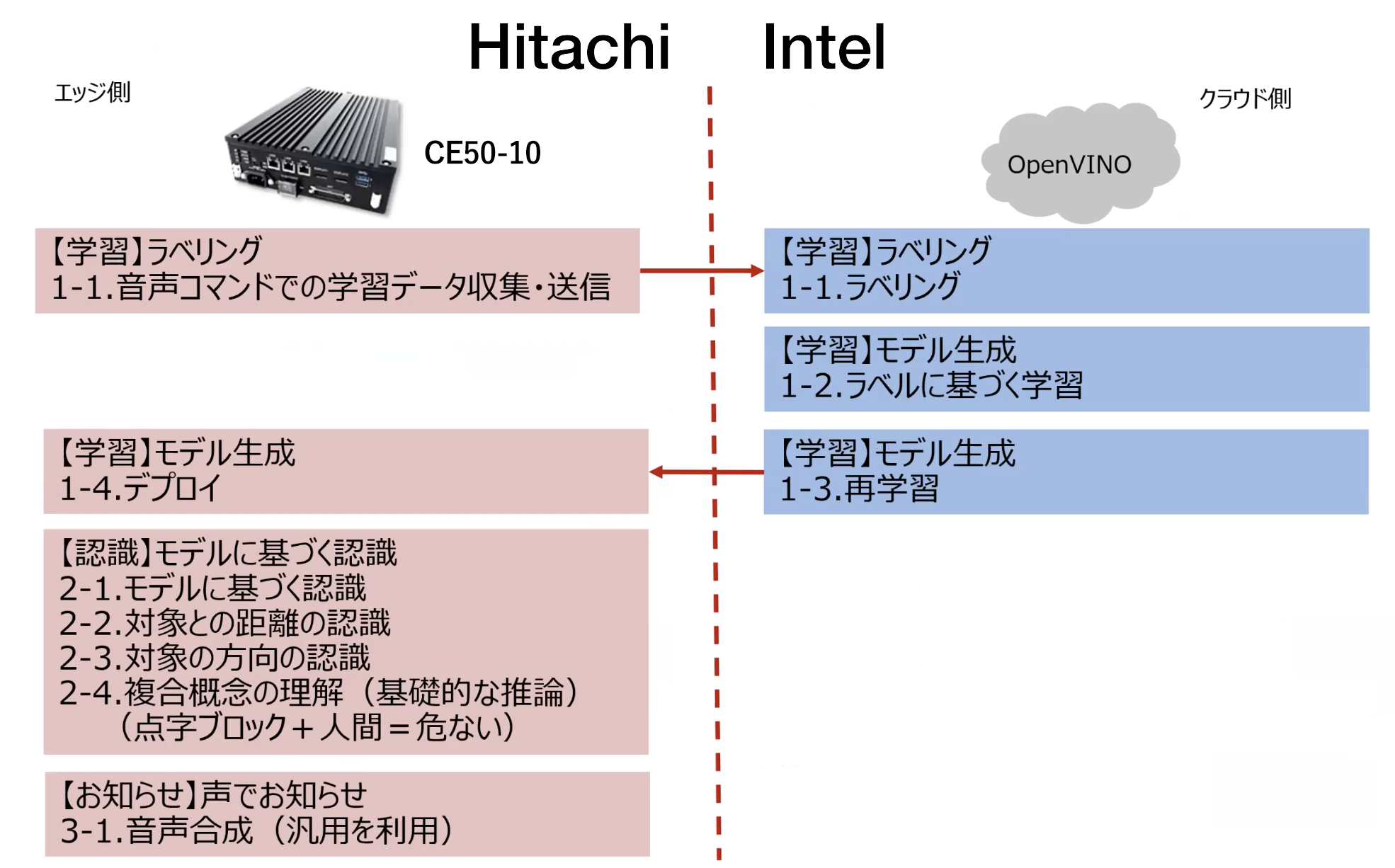

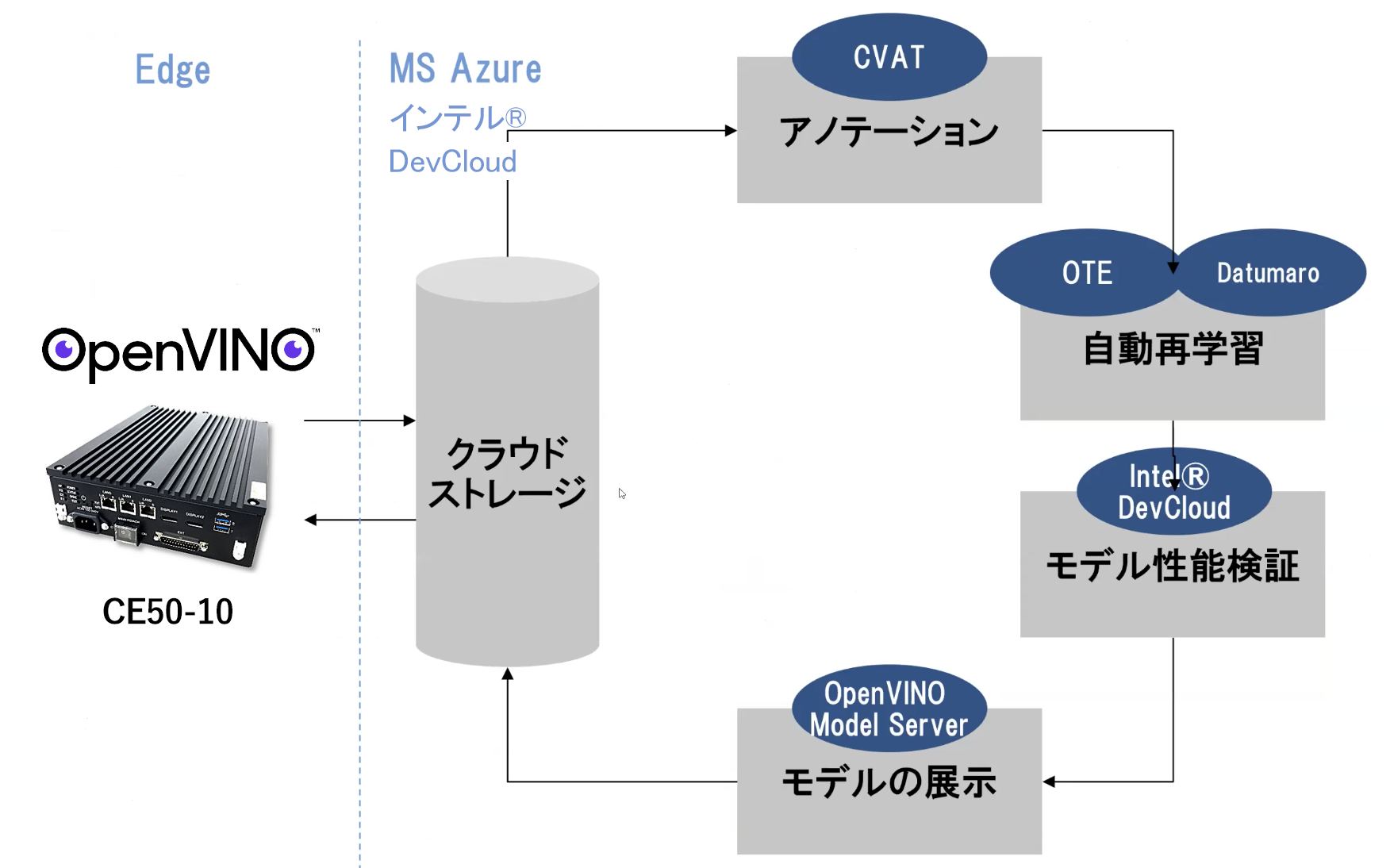

システム構成としては以下の通り。エッジ側(日立)とクラウド側(インテル)とで開発を分担したとのことです。

例えばクラウド側については、Microsoft Azureを活用してエッジ側から定期的に吸い上げた画像データを使い、ノーコードで再学習を回すというプラットフォームに仕上がっています。ちなみに、青色の丸部分はすべてインテル製品となっています。

最優秀賞は!?

以上、参加5チーム+1チームの発表が終わり、いよいよ最終審査発表です。最優秀賞1チームには「20万円分のAmazonギフト券」が、優秀賞2チームには「10万円分のAmazonギフト券」が、それぞれ渡されることになります。

厳正なる審査の結果、最優秀賞および優秀賞は以下の通りとなりました。

| 最優秀賞 | DARUMAJI(「DARUMA」チーム) |

| 優秀賞 | AIFAS(「ファッション番長」チーム) 緊急回避☆くしゃみバリアー(「みかん三兄弟」チーム) |

それぞれ、審査員の方からコメントが発表されました。

砂金 : ファッション系の共同開発については、非常にうまくできていたなと感じました。今はどちらかというとGPUをふんだんに使って、どんな環境でも精度高いものを目指そうというのが、AI方面でのメインのチャレンジになっていると思います。一方で、コンパクトにしてちゃんと実装できるようにするというのも非常に大事な観点だと思うので、特に「ファッション番長」チームは非常に頑張ったなと感じました。

くしゃみバリアーについては、アイデアそのものが非常に秀逸でした。くしゃみに限らず、これから人間の動作に対する予見の領域で、様々なことが考えられるかなと感じます。

そしてDARUMAJIについては、もはやプラットフォームとして展開しても良いかなという完成度だったので、ぜひ何らかの形で継続開発して、みんなが楽しめるプラットフォームとして発展していただけると良いかなと思いました。

土岐 : とても有意義な時間を過ごせました。

入賞にはなりませんでしたが印象に残ったものとして、最初の冷蔵庫プロダクトは、サステナビリティの文脈としてフードロスのペインポイントに近づいていくのが、非常に重要かなと思っています。みんなが困ったペインポイントにおいて、テクノロジーをどう活用できるのか。その部分に着目できているところが、非常に良いなと感じました。

それからくしゃみバリアーですが、ノイズキャンセリングの次世代バージョンは、ここから見えてくるのかなと感じました。なかなか良い着目点だと思います。

そしてDARUMAJIは、弊社の製品を盛り盛りで使っていただき、本当にありがとうございます。テクノロジーは、組み合わせることでしっかりと社会の役に立つようなものになることを、改めて感じた内容でした。社会のためになる技術とは何か、を引き続き追いかけていただき、インテルができることは、全力で支援したいと思っています。

影広:まず皆さん、しっかりとプロトタイピングして、ちゃんと実装して、demoまでしっかりともってこられたのは、非常に貴重だなと感じました。

その中でもDARUMAJIは、アイデアとしての面白さもそうですし、技術の山盛り感が、今回の期間だけでは収まりきらなかったなということを強く感じました。今後、さらに広がっていくんじゃないかなという期待が、審査員の中での一致した意見です。このまま広げていただけると、なんだか面白いことになるんじゃないかなと思います。

また、くしゃみバリアーについても、アイデアの新規性がとても素晴らしかったと思います。くしゃみのような希少データが世の中で大事になってきていると思うのですが、これを使って皆が知りたいことを提示するということを一生懸命やったという点が、とても大事なことだと思いました。

今後もぜひ、ここで築かれた関係を続けていってもらえたらなと思います。

最後に、DARUMAJIチームからもコメントがなされました。

チーム:今回、即席で作ったチームに恵まれまして、各々自由に探究させてもらいました。そこから見事に融合して、なんとか1つの形としてお見せすることができました。「だるまさんがころんだ」という、誰でも知っているコンテンツをコロナ禍で良いものにできないかなということで、私の娘も楽しんでいました。ありがとうございました。

編集後記

「AIの民主化」と聞くと、なんだか固い印象を受ける方がいるかもしれませんが、今回のハッカソンで発表されたプロダクトは、どれも一般消費者のペインポイントやインサイトをうまく突いた「生活に寄り添う」ものばかりでした。

一方で技術面としては、最新の論文をベースに構築されたものばかり。最優秀賞に輝いたDARUMAJIは、特に実装の数が素晴らしく、私自身も思わず課金してでも遊んでみたいと思えるほどのクオリティでした。

ハッカソンの醍醐味の一つは、全く異なる環境のメンバーともチームビルディングして、一緒のものを作っていくというプロセスにあります。ぜひ、今回構築された関係が継続され、より良いプロダクトの社会実装までもっていってもらえたらなと感じました。

取材/文:長岡 武司

「Qiita×HITACHI」AI/データ×社会課題解決 コラボレーションサイト公開中!

「Qiita×HITACHI」AI/データ×社会課題解決 コラボレーションサイト公開中!

日立製作所の最新技術情報や取り組み事例などを紹介しています

コラボレーションサイトへ

日立製作所の人とキャリアに関するコンテンツを発信中!

デジタルで社会の課題を解決する日立製作所の人とキャリアを知ることができます

Hitachi’s Digital Careersはこちら