はじめに

株式会社NTTデータ デジタルサクセスソリューション事業部 の nttd-saitouyun です。

こちらの記事で Amazon Bedrock の LLM を Databricks から利用する方法を説明しました。

今回は Google Cloud の Vertex AI の LLM(Gemini Pro) を利用する方法を説明します。

Databricks Mosaic AI Model Serving

Mosaic AI Model Serving は、AIモデルをサーバレスの環境にデプロイし、APIで利用可能とする機能です。

さらに、今回の Vertex AI のように Databricks の外部のモデルに対しては、外部モデルとのエンドポイントとして機能し、Databricks 内のモデルと同じように外部モデルを集中管理することができます。

Mosaic AI Model Serving Endpoint の作成

左のメニューから「サービング」を選択し、画面右上の「サービングエンドポイントを作成する」をクリックします。

任意の名前を入れます。

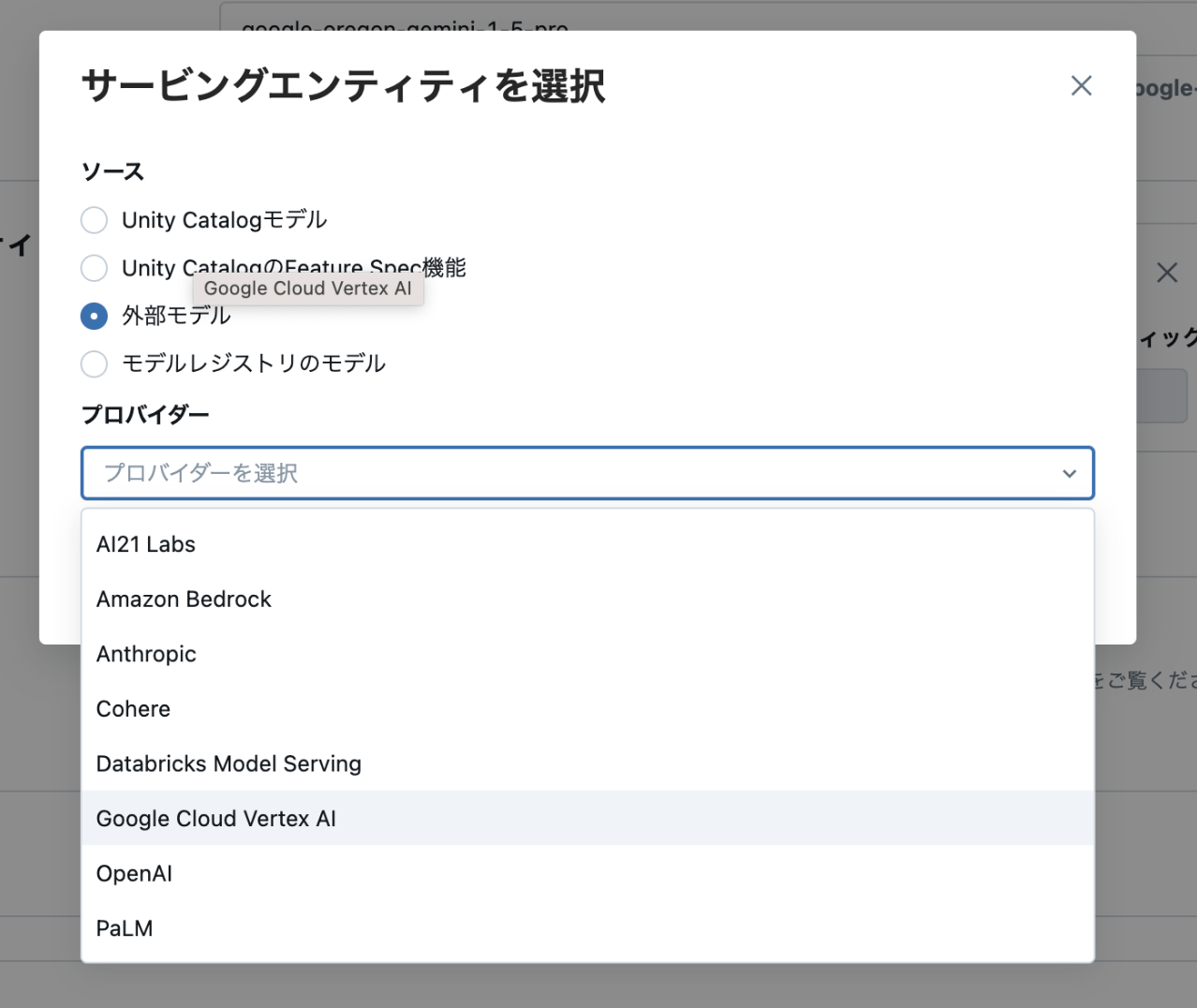

サービングエンティティを選択

続いて、「サービングエンティティを選択」から「外部モデル」を選択し、「プロバイダー」から 「Google Cloud Vertex AI」を選択します。

リストにある通り、AWS、Azure、Google Cloud 以外にも様々なLLMを選択できます。

エンティティの詳細

次に、リージョンや認証情報、どのモデルを使うか(タスク、外部モデル名)を入力します。以下のリンクがマニュアルです。

リージョン

こちらのサイトから Vertex AI がサポートされているリージョンを選択します。今回は Databricks のワークスペースと同じus-west1を指定しています。

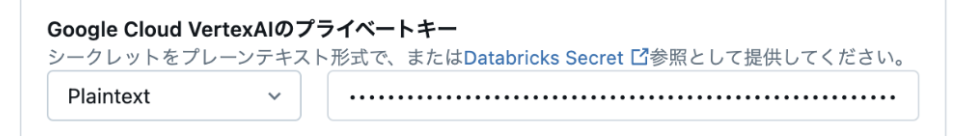

プライベートキー

サービスアカウントを作成し、キーを発行します。Google Cloud 側で まずサービスアカウントを作成してください。

サービスアカウントが作成できたら、キーを作成します。

JSONファイルがダウンロードされるので、そのファイルの内容を全てコピーし、以下の Databricks 側の設定値に貼り付けます。

※JSONファイルの中に "private_key" という項目がありますが、その値だけではなく、JSON全体を入力することに注意してください。(私は最初間違えました。)

プロジェクトID

サービスアカウントを作成したプロジェクトIDを入力します。上でダウンロードしたJSONを開いて"project_id"の値をコピーしてもいいです。

タスク、外部モデル名

画面の通り、タスクは「Chat」、外部モデル名に「gemini-pro」を設定をします。

設定は以上です。とても簡単です。

Mosaic AI Model Serving Endpoint の動作確認

では、正しく設定できているか動作確認してみましょう。上の図の右上「Query」からサンプルクエリを実行できます。

リクエストはあらかじめテンプレートが埋まっています。疎通するだけであればそのまま「リクエストを送信」をクリックします。レスポンスが正しく返ってくればOKです。

「What is Databricks?」に対して、「Databricks: A Unified Data Platform...」とちゃんと返答が返ってきています!

Mosaic AI Model Serving Endpoint を使いこなす

Mosaic AI Model Serving Endpoint には他にも以下のような高度な機能があり、全てGUIで簡単に設定できます。

- 権限管理

- タグ

- レート制限

- トラフィック制御

前に書いた記事に内容をまとめていますので、ご覧いただければと思います。

Mosaic AI Model Serving Endpoint から Google Cloud Vertex AI の LLM を利用する

それでは、エンドポイントを使って色々試してみます。

Mosaic AI Playground で利用する

Mosaic AI Playground は、Databricks がホストする LLM とチャットすることができる機能です。詳しくは以下の記事をご覧ください。

Google Cloud Vertex AI の LLM をエンドポイントに登録することで、Databricks がホストしているLLMと同様にチャットすることができます。

今回は、Claude 3.5 Sonnet(Amazon Bedrock)、Meta Llama 3.1 405B とチャットしてみます。

Gemini は Claude 3.5 Sonnet と比較して端的な回答をしてくれました。

新しくリリースされた LLM をプラットフォームを跨いですぐに比較できるのは便利です!

Databricks SQL AI Functions で利用する

Databricks では、SQL から LLM を呼び出しデータ処理に使うことができます。使い方は簡単で、エンドポイント名とプロンプトを与えるだけです。

SELECT ai_query("google-oregon-gemini-1-5-pro", prompt)

それでは、SQL AI Functions を使ってみます。タスクは前回の Amazon Bedrock の時と同様にマスキングにします。

以下のような架空の個人情報を含む文(山田太郎は〜)を先ほどの Playground を使って生成しました。さらに、この文章の1行目にLLMに対する指示(次の文章の中で〜)を追加しています。

DECLARE OR REPLACE prompt STRING;

SET VAR prompt = "

次の文章の中で、個人情報を氏名であれば[氏名]と、住所であれば[住所]のような汎化した表現に置き換えてください。:

山田太郎は1990年4月1日に渋谷の桜丘町で生まれた。彼は幼い頃から音楽に興味があり、高校時代にはバンドを結成してライブハウスで演奏していた。大学卒業後、音楽の道を追求するためにロサンゼルスに移住し、現在はプロのミュージシャンとして活躍している。

彼の住所は現在、カリフォルニア州ロサンゼルス市ハリウッド区1234 Hollywood Blvd. です。彼は時々日本に戻り、故郷の渋谷区でライブを行っている。

"

結果は以下の通りになりました。Claude 3.5 Sonnet と比較して、生年月日や地名がマスキングできませんでした。生年月日や地名に対する情報をもっとプロンプトに与える必要がありそうです。

このようにマルチクラウドで様々な LLM を簡単に呼び出せるので、データ処理の幅がグッと広がります。

Databricks SQL AI Functions について詳しく知りたい方は以下の記事もご覧ください。

おわりに

Mosaic AI Model Serving Endpoint を活用することで、Databricks から Google Cloud Vertex AI 上の LLM が簡単に利用できることが伝われば幸いです。

Google Cloud Vertex AI にも LLMOps機能はありますが、Databricks と組み合わせることで、マルチクラウドを前提としたLLMの利活用環境の構築やモデルやアーキテクチャなど活用方法の選択肢の幅がより広がります!

この生成AI領域は最も勢いのある技術領域です。Databricks を利用し、選択肢や活用の幅を広げてみてはいかがでしょうか?

仲間募集

NTTデータ デザイン&テクノロジーコンサルティング事業本部 では、以下の職種を募集しています。

1. クラウド技術を活用したデータ分析プラットフォームの開発・構築(ITアーキテクト/クラウドエンジニア)

クラウド/プラットフォーム技術の知見に基づき、DWH、BI、ETL領域におけるソリューション開発を推進します。https://enterprise-aiiot.nttdata.com/recruitment/career_sp/cloud_engineer

2. データサイエンス領域(データサイエンティスト/データアナリスト)

データ活用/情報処理/AI/BI/統計学などの情報科学を活用し、よりデータサイエンスの観点から、データ分析プロジェクトのリーダーとしてお客様のDX/デジタルサクセスを推進します。https://enterprise-aiiot.nttdata.com/recruitment/career_sp/datascientist

3.お客様のAI活用の成功を推進するAIサクセスマネージャー

DataRobotをはじめとしたAIソリューションやサービスを使って、 お客様のAIプロジェクトを成功させ、ビジネス価値を創出するための活動を実施し、 お客様内でのAI活用を拡大、NTTデータが提供するAIソリューションの利用継続を推進していただく人材を募集しています。4.DX/デジタルサクセスを推進するデータサイエンティスト《管理職/管理職候補》

データ分析プロジェクトのリーダとして、正確な課題の把握、適切な評価指標の設定、分析計画策定や適切な分析手法や技術の評価・選定といったデータ活用の具現化、高度化を行い分析結果の見える化・お客様の納得感醸成を行うことで、ビジネス成果・価値を出すアクションへとつなげることができるデータサイエンティスト人材を募集しています。ソリューション紹介

Trusted Data Foundationについて

~データ資産を分析活用するための環境をオールインワンで提供するソリューション~https://enterprise-aiiot.nttdata.com/tdf/

最新のクラウド技術を採用して弊社が独自に設計したリファレンスアーキテクチャ(Datalake+DWH+AI/BI)を顧客要件に合わせてカスタマイズして提供します。

可視化、機械学習、DeepLearningなどデータ資産を分析活用するための環境がオールインワンで用意されており、これまでとは別次元の量と質のデータを用いてアジリティ高くDX推進を実現できます。

NTTデータとDatabricksについて

NTTデータは、お客様企業のデジタル変革・DXの成功に向けて、「databricks」のソリューションの提供に加え、情報活用戦略の立案から、AI技術の活用も含めたアナリティクス、分析基盤構築・運用、分析業務のアウトソースまで、ワンストップの支援を提供いたします。TDF-AM(Trusted Data Foundation - Analytics Managed Service)について

~データ活用基盤の段階的な拡張支援(Quick Start) と保守運用のマネジメント(Analytics Managed)をご提供することでお客様のDXを成功に導く、データ活用プラットフォームサービス~https://enterprise-aiiot.nttdata.com/service/tdf/tdf_am

TDF-AMは、データ活用をQuickに始めることができ、データ活用の成熟度に応じて段階的に環境を拡張します。プラットフォームの保守運用はNTTデータが一括で実施し、お客様は成果創出に専念することが可能です。また、日々最新のテクノロジーをキャッチアップし、常に活用しやすい環境を提供します。なお、ご要望に応じて上流のコンサルティングフェーズからAI/BIなどのデータ活用支援に至るまで、End to Endで課題解決に向けて伴走することも可能です。

NTTデータとSnowflakeについて

NTTデータでは、Snowflake Inc.とソリューションパートナー契約を締結し、クラウド・データプラットフォーム「Snowflake」の導入・構築、および活用支援を開始しています。 NTTデータではこれまでも、独自ノウハウに基づき、ビッグデータ・AIなど領域に係る市場競争力のあるさまざまなソリューションパートナーとともにエコシステムを形成し、お客さまのビジネス変革を導いてきました。 Snowflakeは、これら先端テクノロジーとのエコシステムの形成に強みがあり、NTTデータはこれらを組み合わせることでお客さまに最適なインテグレーションをご提供いたします。NTTデータとInformaticaについて

データ連携や処理方式を専門領域として10年以上取り組んできたプロ集団であるNTTデータは、データマネジメント領域でグローバルでの高い評価を得ているInformatica社とパートナーシップを結び、サービス強化を推進しています。NTTデータとTableauについて

ビジュアル分析プラットフォームのTableauと2014年にパートナー契約を締結し、自社の経営ダッシュボード基盤への採用や独自のコンピテンシーセンターの設置などの取り組みを進めてきました。さらに2019年度にはSalesforceとワンストップでのサービスを提供開始するなど、積極的にビジネスを展開しています。これまでPartner of the Year, Japanを4年連続で受賞しており、2021年にはアジア太平洋地域で最もビジネスに貢献したパートナーとして表彰されました。

また、2020年度からは、Tableauを活用したデータ活用促進のコンサルティングや導入サービスの他、AI活用やデータマネジメント整備など、お客さまの企業全体のデータ活用民主化を成功させるためのノウハウ・方法論を体系化した「デジタルサクセス」プログラムを提供開始しています。

NTTデータとAlteryxについて

Alteryxは、業務ユーザーからIT部門まで誰でも使えるセルフサービス分析プラットフォームです。 Alteryx導入の豊富な実績を持つNTTデータは、最高位にあたるAlteryx Premiumパートナーとしてお客さまをご支援します。導入時のプロフェッショナル支援など独自メニューを整備し、特定の業種によらない多くのお客さまに、Alteryxを活用したサービスの強化・拡充を提供します。