はじめに

はじめまして。社内でデータサイエンティストを務めております @nttd-okadak です。

NTTデータ テクノロジーコンサルティング事業本部では、お客様企業のAI・データ活用を、コンサルティングから基盤構築、実行支援を通じた成果創出までワンストップで創出しており、その支援テクノロジーの一つとして DataRobot を提供しております。

今回は、2025年2月に開催した効果検証に基づき施策を正しく評価セミナーでご紹介させていただいた内容を元に、なぜ効果検証が必要かといった基本的な概念や、代表的な手法とその考え方を中心にご紹介します。

主に効果検証の初学者や、実際に分析は行わないビジネスサイドの方を対象として想定した内容にしており、数学的な記述や詳細な前提条件等の専門的内容にはあまり触れないのでご了承ください。

またセミナーは期間限定でオンデマンド配信中です。

DataRobotについて

DataRobot社は、人工知能(AI)に対するユニークなコラボレーション型のアプローチであるバリュー・ドリブン AIのリーダーです。

DataRobot社の製品であるDataRobotは、自動機械学習(AutoML)プラットフォームであり、機械学習モデルの構築、トレーニング、評価、デプロイメントを自動化することができます。複雑なデータ分析を迅速かつ簡単に実行し、優れた予測モデルの作成をサポートすることが可能です。

近年では生成AI機能も強化し、予測AIとのコラボレーションによってさらなるAIサクセスの実現を加速させています。

本記事の主な想定読者

- 顧客に対し施策を行っているが、コストに見合う結果かが検証できていない方

- 既に行われた施策のデータを検証したいが、どのように検証したらよいか分からない方

- データ活用がPoCで止まってしまい、施策実行等の業務適用に至れていない

目次

1.効果検証の概略

効果とは

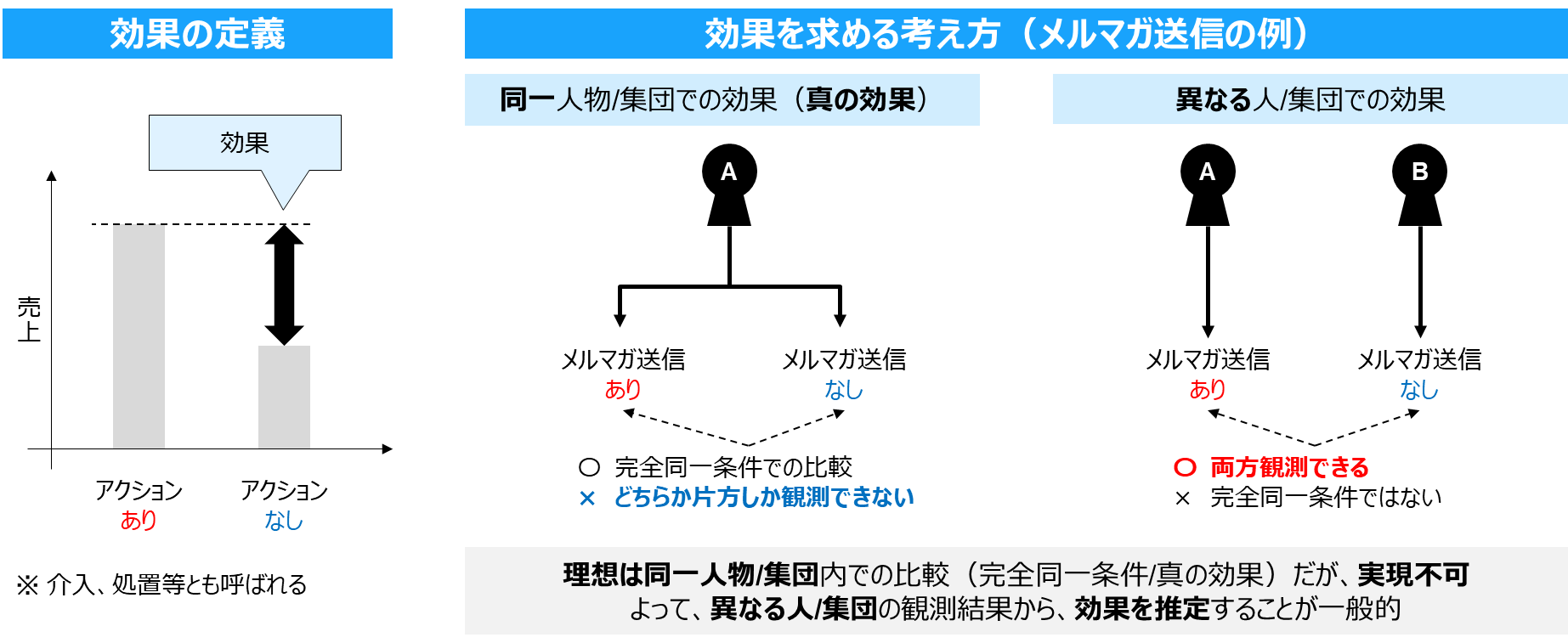

本記事では、ビジネスにおいて、何らかのアクションを取ったときに、取らなかったときと比較して売上等のビジネス上重要なKPIに与えた影響を効果と考えます。(以下図の左)

効果は、基本的に同一人物/集団に対しては観測不可(=因果推論の根本問題と呼ばれる)なため、異なる人/集団の観測結果から推定することがほとんどです。

以下図の右がそのイメージです。同じ人に対して、メルマガを送ったとき・送らなかったときの売上はどちらか片方しか観測できません。よって異なる人の結果から効果を推定します。

セレクションバイアス

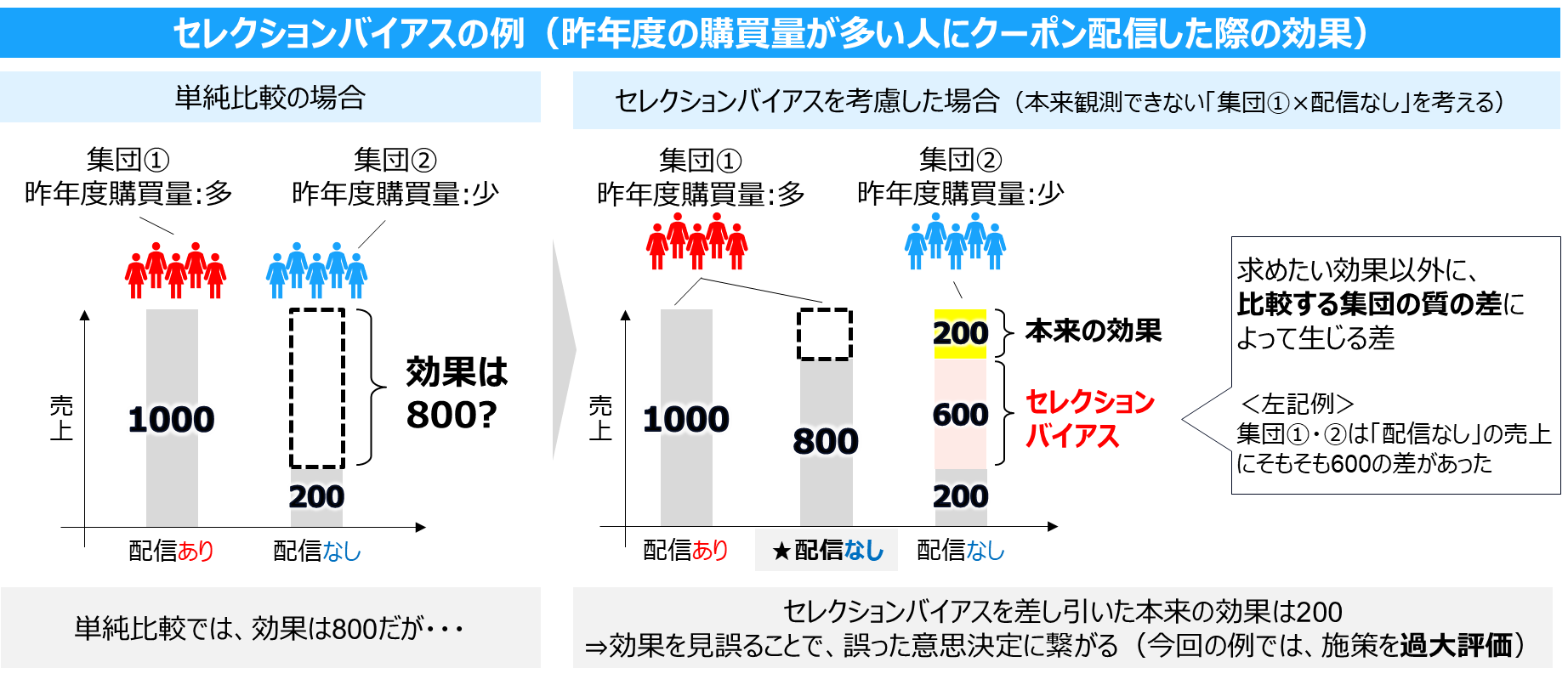

上述の通り理想の比較ができない特性から、推定される効果には、ほぼ確実にセレクションバイアス(=求めたい効果以外に、比較する集団の質の差によって生じる差)の影響が入ります。これを見落とすと、効果を見誤り、誤った意思決定に繋がる恐れがあります。

以下は、昨年度の購買量が多い人にクーポン配信した際の、クーポンの効果検証を行う状況を図にしています。仮に集団①と集団②で、クーポンを配信しなかった場合の売上にそもそも大きな差があった場合、この差がセレクションバイアスとしてクーポンの効果と混ざってしまいます。

効果検証では、適切なデータ取得 × 適切なデータ分析を行い、セレクションバイアスをできるだけ除外=真の効果に近い値を推定することで、意思決定の質向上を目指します。

効果検証が求められるビジネスシーン

基本的に、主観・経験に基づく意思決定を行う場合(リリース直後のサービスを高速で改善したい場合等)以外のシーンでは、効果検証は必要だと考えています。以下はその例です。

- クーポンメール配信の効果検証(投入コストに見合う売上増加が得られたか)

- アプリUIの変更評価(クリック改善等に繋がったか)

- 機械学習モデルのインパクト評価(従来業務と比べて、機械学習を活用することで導入コスト以上の効果が得られるか)

このようなシーンで、適切な効果検証ができれば、各種KPIを改善する意思決定に繋げることが可能です。逆に誤った結果を出すと、意味のない施策を続ける等、KPI悪化に繋がる可能性があります。

用語の定義

以降本記事では、下記表内の各種用語を使っていきます

| 用語 | 定義 |

|---|---|

| 介入 | ビジネスでとった何らかのアクション(効果を求めたいアクション)の総称 |

| 介入群 | 効果検証実施時に、介入を行う集団 |

| コントロール群(CT群) | 効果検証実施時に、介入を行わない集団 |

| 割り当て | 効果検証の対象集団を、介入群・コントロール群に分配すること |

| 共変量 | セレクションバイアスを発生させていると分析者が想定する変数 |

2.基本の効果検証とビジネスにおける効果検証の複雑さ

RCT(Randomized Controlled Trial)

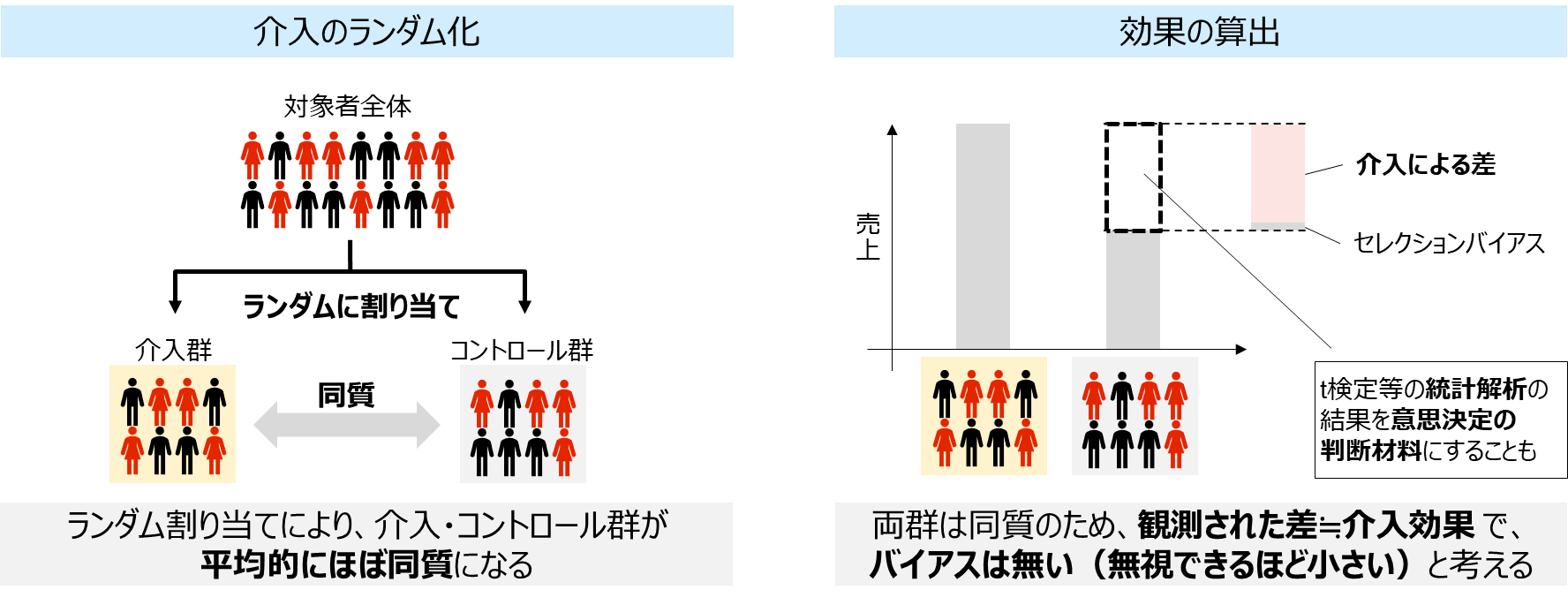

RCT(A/Bテストと呼ばれることも)は、最も基本的な効果検証手法です。介入をランダム化することで、介入・CT群が介入の有無以外は平均的には同質となり、比較結果には他の要因の影響が入らない、と考えます。分析時には、平均値と信頼区間を確認し、統計検定を行うことも多いですが、本記事ではその内容については割愛します。

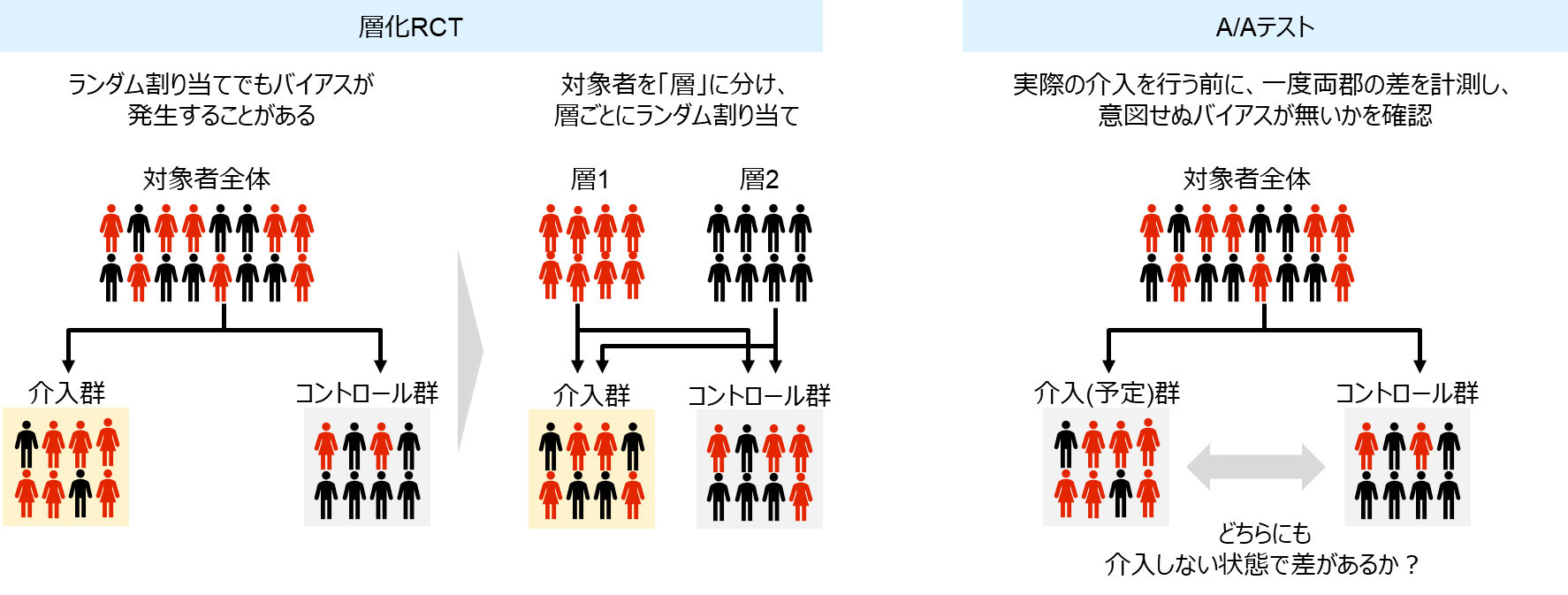

RCTの説明としてはこれだけですが、実際には完璧なランダムを作ることは難しく、またランダムを作れたと思っても実際に計測してみると意図せぬ差が見つかる、なんてことも良くあります。

そのため、層化RCTでより確実にランダムを作ったり、A/Aテストで介入・CT群の意図せぬ差を事前確認する等、適切なRCTを行うための手段が多数あります。

RCTができないビジネスシーン

RCTはシンプルかつ強力な効果検証手法ですが、一方で「介入をランダムに割り当てる」ことは分析観点の理想なので、時にビジネス観点の理想と一致しません。以下はその状況例です。

- 法律・政策の変更(そもそもランダムが無理)

- 値段設定の変更(人ごとにランダムに値段を変えることによる社会的リスク)

- 介入群はランダムでも、実際に介入を受けるかはランダムではない(例:メールを送っても全員は開かない)

- RCTにより新しいデータを取得するためのコストが無い

- 売上の目標が達成できていないので、見込みのない人も含めてランダムにメールを配信するのでは無く、売上UPが見込めそうな特定の人たちに配信したい

このような場合に、単純に介入群とCT群を比較してしまうと、セレクションバイアスを含む結果となってしまいます。

そこで次からは、このようなRCTができない状況でも活用できる効果検証手法を紹介します

3.効果検証の分析手法紹介

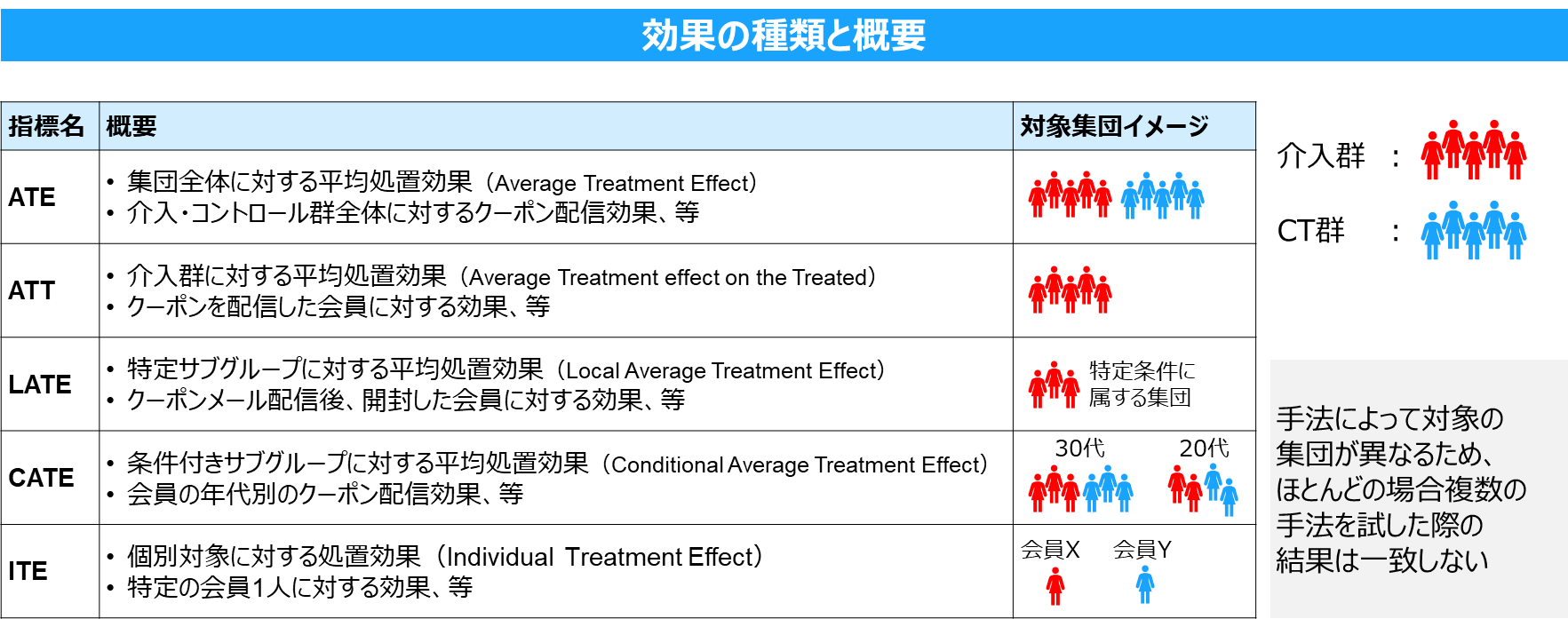

効果検証手法によって推定される「効果」の種類

手法の前に、効果検証の手法によって推定される効果の種類について最初に触れます。

効果検証の各手法は、前提として本来観測できない効果を推定するかつRCTでもないという性質上、何かしらの仮定や制約条件を置いています。

中でも 誰に対する効果なのか は、推定された効果の値を見る上で重要な考え方になります。

以下に、代表的な効果の種類をまとめています。全体に対する効果を表すATEから、個人に対する効果を表すITEまであり、手法により推定する効果が異なるため、同じデータに対して複数手法を試した結果は一致しないことが多いです。

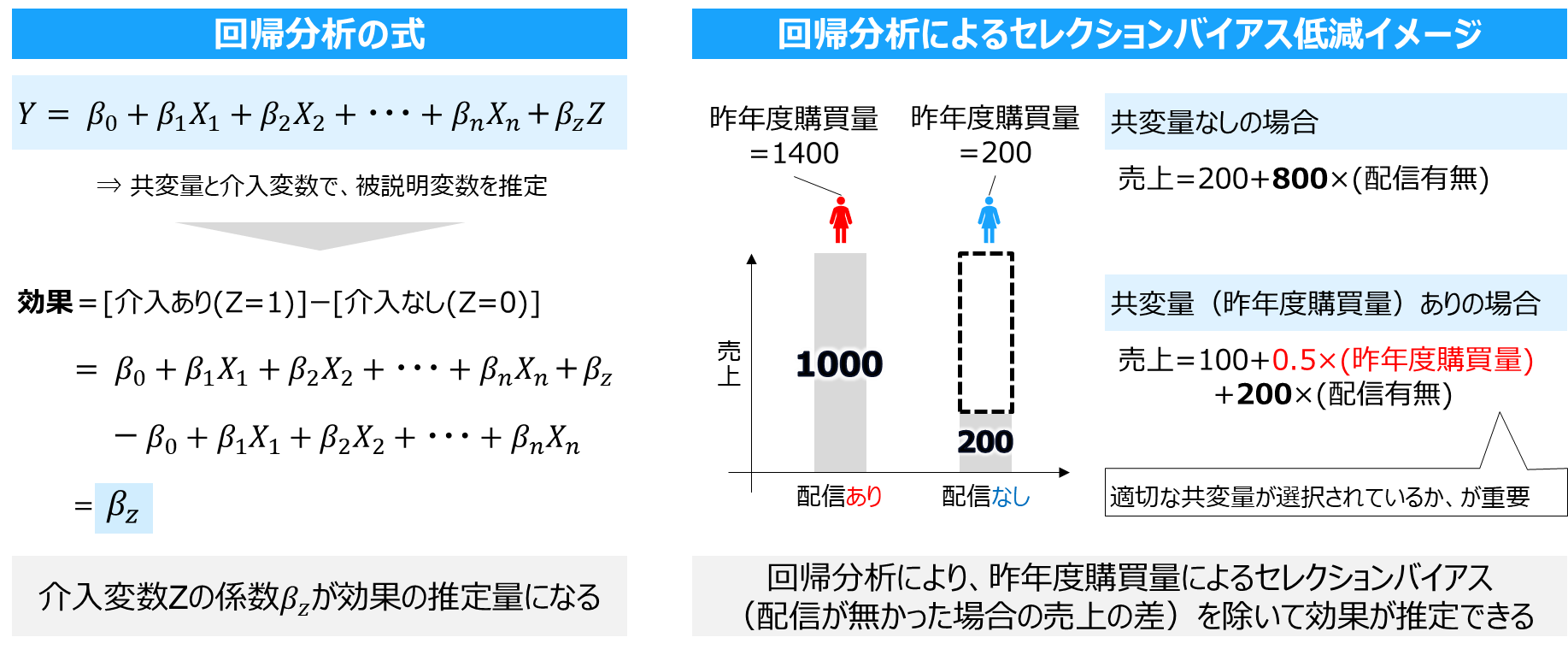

手法1:回帰分析

セレクションバイアスを取り除く基本的な手法です。効果検証だけでなく幅広い領域で使われる手法なので、見覚えのある方も多いかと思いますが、効果検証では、被説明変数Yを、介入変数Zと共変量Xで推定する式になります。これにより、共変量によるバイアスを除外し介入の効果を推定します。適切な共変量の選択が重要となります。(全データから回帰係数を算出するため、ATEを推定)

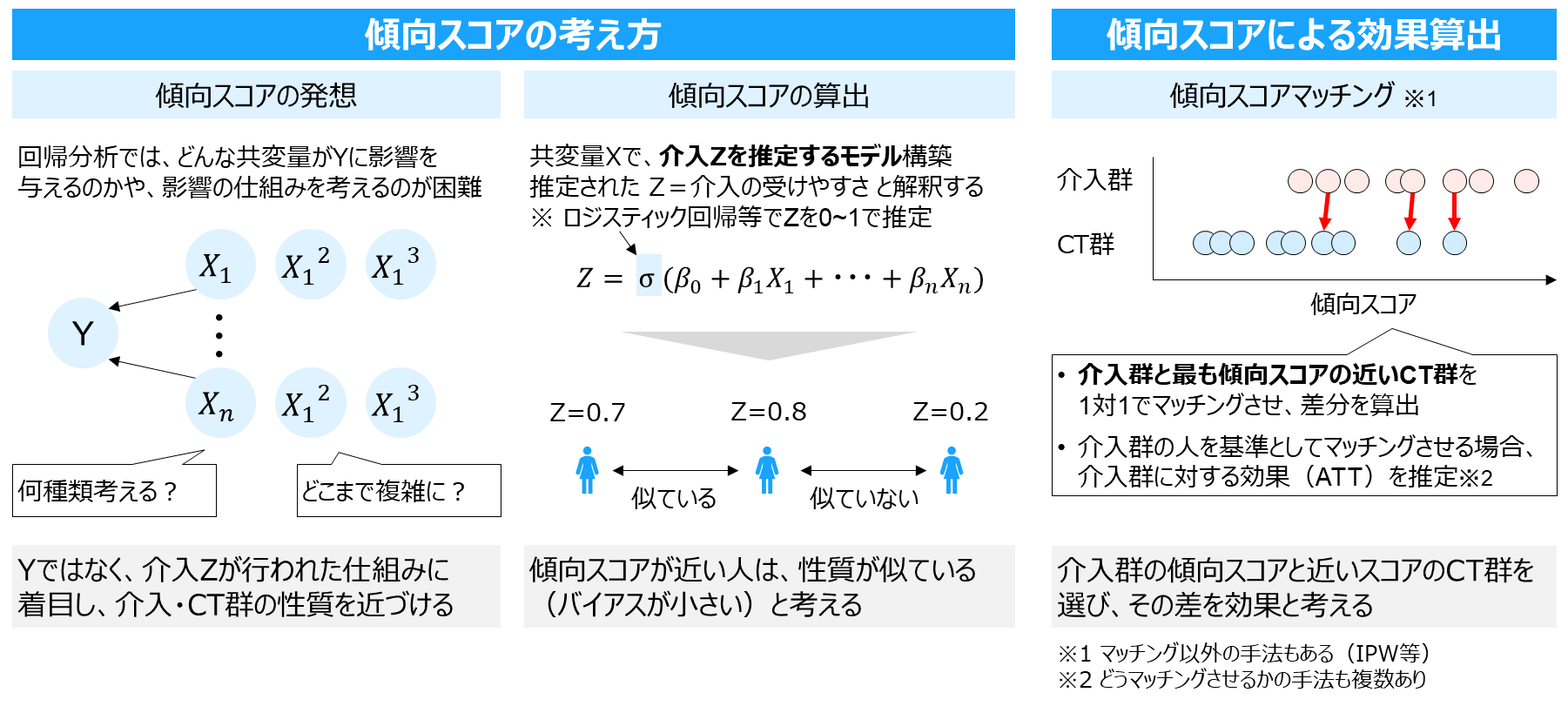

手法2:傾向スコア

傾向スコアは、例えば介入が複雑なルールで決められている状況や、共変量の候補が膨大な場合等、回帰分析で使うための適切な変数選択が困難な場合に活用します。

共変量を介入の受けやすさという1つの指標(=傾向スコア)に集約し、傾向スコアが似ている人同士を比較することで効果を推定します(傾向スコアが似た人=似た特性の人)

以下画像では、傾向スコアを用いて効果を推定する手法の一例として、傾向スコアマッチングを取り上げています。

傾向スコアを活用する際は、マッチング含めどのような手法を選択するか、さらにマッチングを選択した場合にも、どのようにマッチングさせるか等のアルゴリズム選択がポイントになってきます。

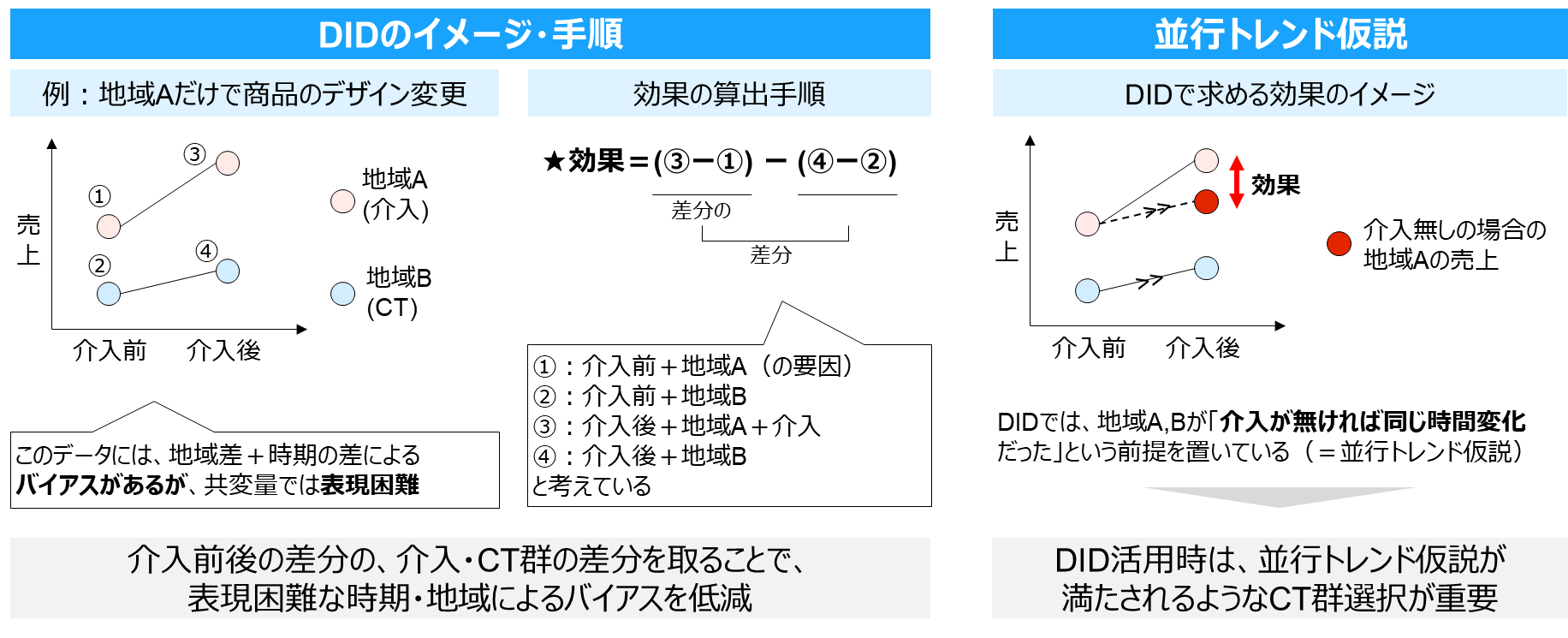

手法3:DID(差分の差分法)

DIDは、介入群・CT群のセレクションバイアスが表現困難だが、それぞれの介入前後のデータがある場合に活用します。介入・CT群の「介入前後の差分」の差分を取ることで、効果を算出します。

以下では、地域・時期、のバイアスがある場合を例にしています(共変量で表しにくい要因)。DIDでは、並行トレンド仮説が成り立っていることが重要なので、そのためのコントロール群選択がポイントになります。

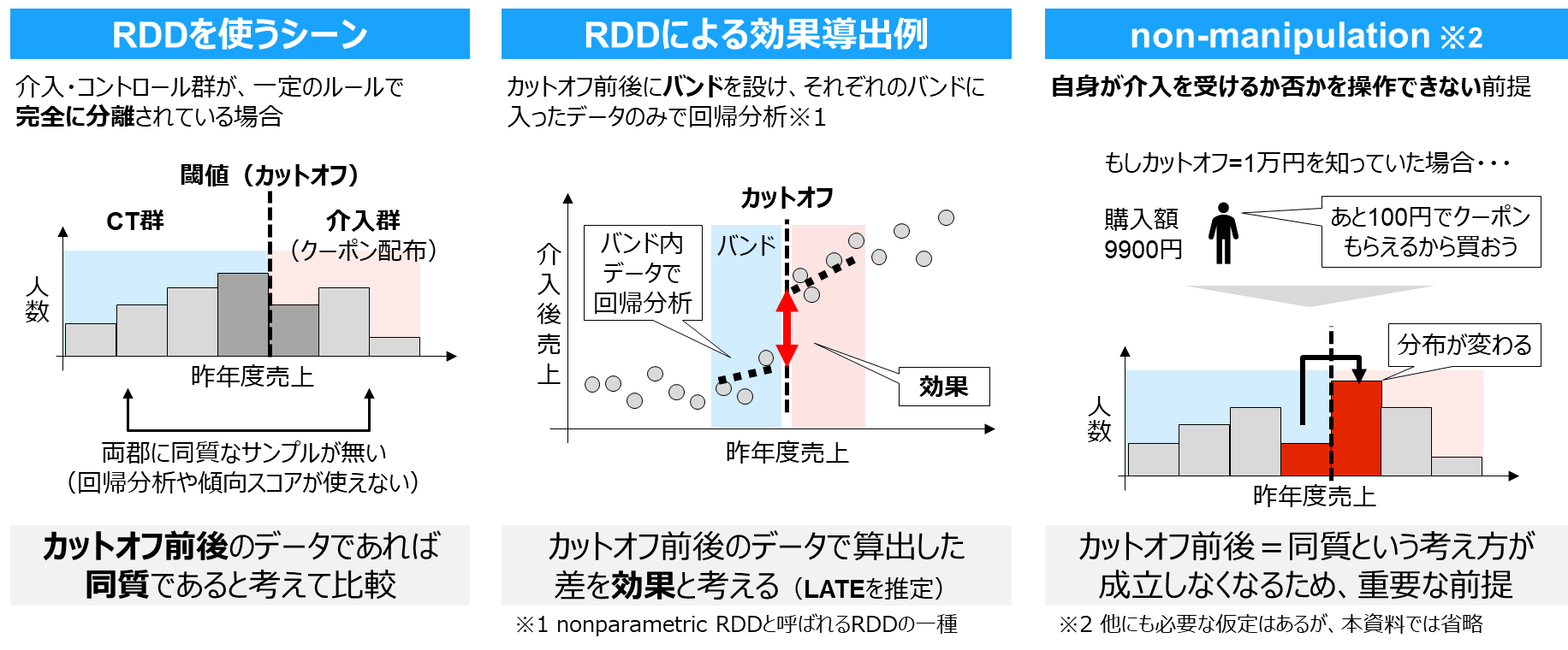

手法4:RDD(回帰不連続デザイン)

RDDは、例えば「昨年度の売上が1万円以上の人だけを対象にクーポン配布する(逆に、1万円より下の人には配布しない)」のように、介入群とコントロール群が一定のルールによって完全に分離されている場合に活用できます。(詳細割愛しますが、回帰分析や傾向スコアでは、介入群とコントロール群に少数でも同質なサンプルがあることが必要です)

このような状況において、ルールの閾値付近のデータは同質だと考えて、閾値付近のデータに着目して効果を算出します。このとき、閾値付近=同質という前提を守るために、non-manipulation(以下右側)という仮定が必要です。

実際に効果検証を行う際の注意点

他にも手法はたくさん(Causal Impact、合成コントロール法、IV(操作変数法)、Meta-Learner・・・等)ありますが、一旦本記事ではここまでとしておきたいと思います。

さて、ここまでいくつか手法を紹介しましたが、結局のところどんな手法を使ったとしてもセレクションバイアスがどの程度残っているかを評価することはできません。

そのため、介入の特性(どんな対象や割り当てルールか、社内の他の介入が被っていないか、等)を理解し、共変量を十分に検討する等、業務の知識を踏まえた上で、出た結果を信じられるための検討が分析手法選択と同程度以上に重要になります。

4.効果検証の事例紹介

ここでは、NTTデータにて、実際にお客様に対してご支援させていただいた事例について、1つご紹介します。(具体の業界名や数値は出せないことはご了承ください)

架電業務における機械学習モデル導入の効果検証

本事例は、既存業務に機械学習モデルを導入した時に、導入コストと見合うほどの効果が得られたかを検証した事例です。RCTの事例になります。

※私達のチームでは、DataRobot等を活用して機械学習モデルを構築し、その導入に際しての効果検証を行うことが多いため、この事例を紹介しています。

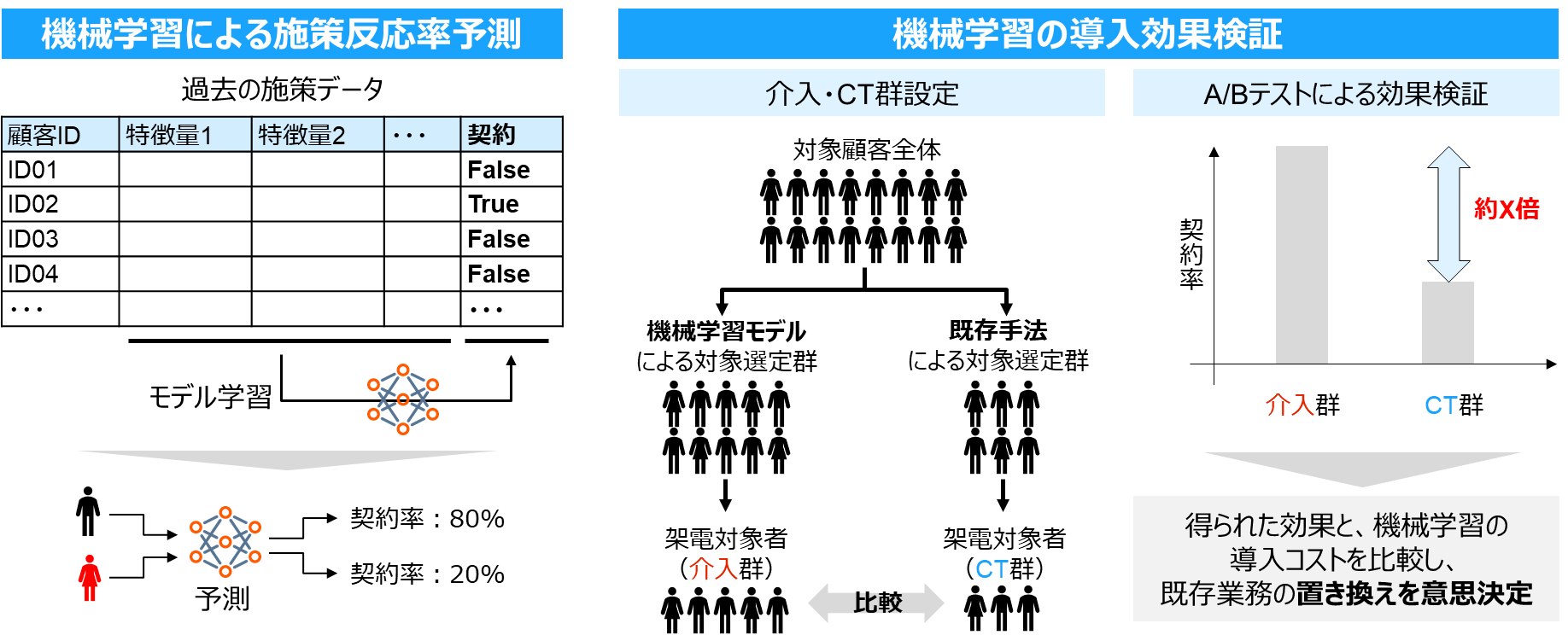

本事例は、架電業務(電話による契約獲得)の効率化を目指した案件になります。既存の業務では、担当者の経験から架電対象者を選定しているところを、機械学習によって、架電対象者リストの中から契約確率が高い人を推定し、確率の高い人から架電することで、より効率的な契約獲得ができるかを効果検証します。

以下図がその概要です。

左側は、機械学習モデルをつくるまでの流れを記載しています。

学習データとして、過去の架電実績から、契約してくれた人(True)、してくれなかった人(False)、さらにその特徴(年代、居住地等)を表すデータを収集します。

そして、契約の有無を予測対象として機械学習モデルを用いて、契約してくれる人のパターンを学習します。

モデル学習後、今回の架電候補者の特徴を入力すると、各対象者の契約確率が予測値として算出される(この人は契約確率80%、この人は20%、等)ため、確率が高い人に向けて架電します。

右側では、このモデルが本当に既存のやり方より有用なのかを効果検証した内容です。

まず、対象の顧客全体を、既存手法で対象者を選定する群と、機械学習で選定する群に分けます。その後、それぞれの群で対象者を選定した際の契約率を比較します。

実際この場合には、機械学習の方が高い契約率だった、という結果が得られました。後はお客様側で、得られたこの効果の値を元に、既存業務を機械学習による業務に変えていく意思決定を下すこととなります。

ポイントとしては、RCTの章でもご説明した通り、対象群を分けるときに、しっかりと共変量の偏りが無いかをチェックして、RCTが成り立つかを確認していたところになります。

補足:より高度な分析手法

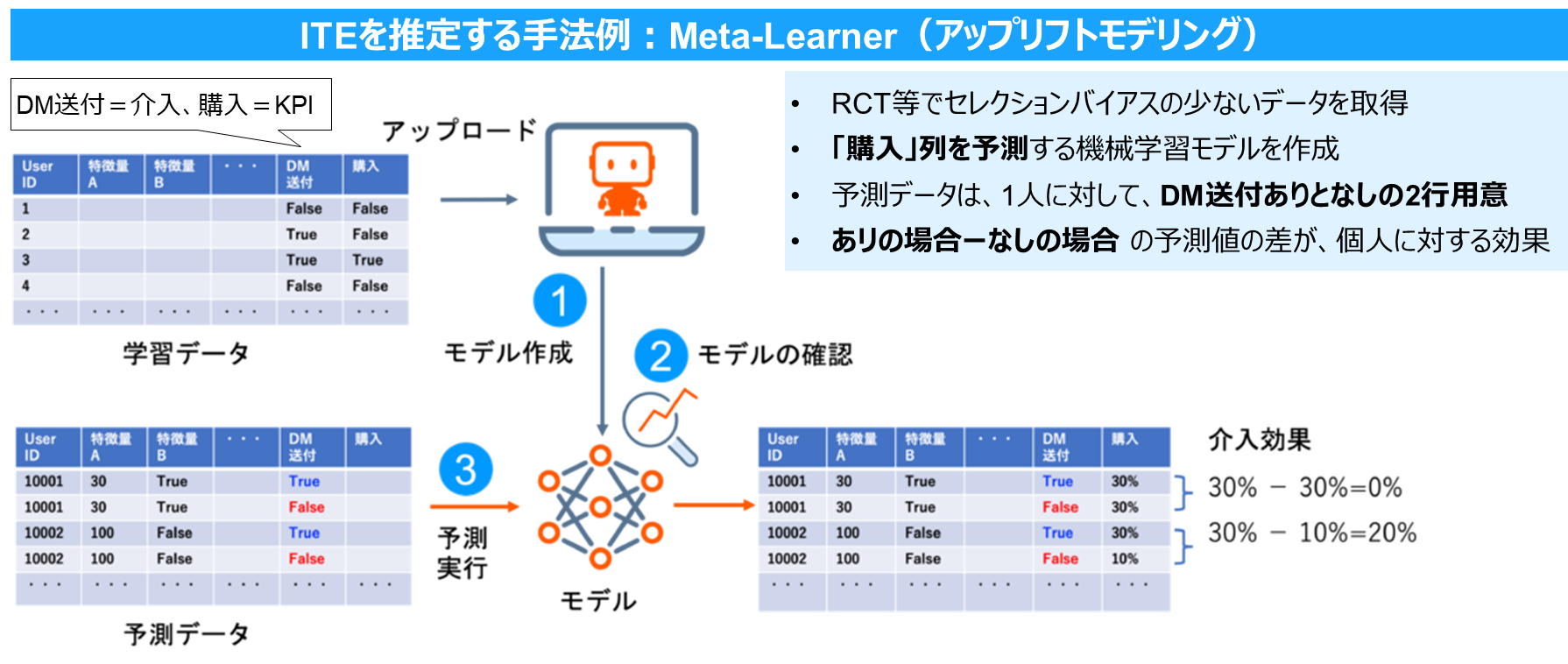

事例が1つだと寂しいので、より高度な分析手法の活用について、アップリフトモデリングを紹介したいと思います。

本記事でここまで紹介した内容は、基本的に平均的な効果を推定するものですが、より介入の意思決定を効率的行うために、個人に対する効果(ITE)推定に対する需要も上がってきています。

以下ではITEを推定する手法として、Meta-Learnerの一種であるアップリフトモデリングを紹介します。こちら、DataRobot社のページから抜粋して記載しております。

この手法では、RCT等で取得したデータを使って、さらに高度な介入を目指します。

上記例では、RCTを行った過去のDM施策について、DMの送付有無+商品の購入有無の2列を用意し、このデータで購入を予測するモデルを学習させます。

そして予測時には、1人の顧客に対して、「DM送付=あり」と「DM送付=なし」の2行分を用意して、それぞれの場合の購入確率を予測させます。この2つの差分=個人に対する効果と考えられるため、より差分が大きい=DM送付による購買確率が上がりやすい人をターゲットにしていく、という考え方になります。

5.まとめ

今回は、効果検証についてご紹介しました。ただ、実際にこれをビジネスで活用するには「正しい情報がビジネスの価値になる」という状態になっていることが重要です。(お互いに正しい知識を持つ、等)

また、我々のような分析の立場からは、施策の対象・前提等を理解し、介入の目的を明確化することや、手法の前提が成り立つような状況を作り出すために、担当者に働きかけることも要求されます。

ここまで書いてきた内容が、実際にこれから効果検証を行う方にとっての一助になれば幸いです。

今後も他の機能紹介記事や、デモ記事を紹介していきたいと思います!

参考書籍

本ブログ作成にあたっては、下記書籍を参考にしました。

- 効果検証入門〜正しい比較のための因果推論/計量経済学の基礎,技術評論社

- Pythonで学ぶ効果検証入門,オーム社

仲間募集

NTTデータ テクノロジーコンサルティング事業本部 では、以下の職種を募集しています。

1. クラウド技術を活用したデータ分析プラットフォームの開発・構築(ITアーキテクト/クラウドエンジニア)

クラウド/プラットフォーム技術の知見に基づき、DWH、BI、ETL領域におけるソリューション開発を推進します。

https://enterprise-aiiot.nttdata.com/recruitment/career_sp/cloud_engineer

2. データサイエンス領域(データサイエンティスト/データアナリスト)

データ活用/情報処理/AI/BI/統計学などの情報科学を活用し、よりデータサイエンスの観点から、データ分析プロジェクトのリーダーとしてお客様のDX/デジタルサクセスを推進します。

https://enterprise-aiiot.nttdata.com/recruitment/career_sp/datascientist

3.お客様のAI活用の成功を推進するAIサクセスマネージャー

DataRobotをはじめとしたAIソリューションやサービスを使って、

お客様のAIプロジェクトを成功させ、ビジネス価値を創出するための活動を実施し、

お客様内でのAI活用を拡大、NTTデータが提供するAIソリューションの利用継続を推進していただく人材を募集しています。

https://nttdata.jposting.net/u/job.phtml?job_code=804

4.DX/デジタルサクセスを推進するデータサイエンティスト《管理職/管理職候補》

データ分析プロジェクトのリーダとして、正確な課題の把握、適切な評価指標の設定、分析計画策定や適切な分析手法や技術の評価・選定といったデータ活用の具現化、高度化を行い分析結果の見える化・お客様の納得感醸成を行うことで、ビジネス成果・価値を出すアクションへとつなげることができるデータサイエンティスト人材を募集しています。ソリューション紹介

Trusted Data Foundationについて

~データ資産を分析活用するための環境をオールインワンで提供するソリューション~

https://www.nttdata.com/jp/ja/lineup/tdf/

最新のクラウド技術を採用して弊社が独自に設計したリファレンスアーキテクチャ(Datalake+DWH+AI/BI)を顧客要件に合わせてカスタマイズして提供します。

可視化、機械学習、DeepLearningなどデータ資産を分析活用するための環境がオールインワンで用意されており、これまでとは別次元の量と質のデータを用いてアジリティ高くDX推進を実現できます。

TDFⓇ-AM(Trusted Data Foundation - Analytics Managed Service)について

~データ活用基盤の段階的な拡張支援(Quick Start) と保守運用のマネジメント(Analytics Managed)をご提供することでお客様のDXを成功に導く、データ活用プラットフォームサービス~

https://www.nttdata.com/jp/ja/lineup/tdf_am/

TDFⓇ-AMは、データ活用をQuickに始めることができ、データ活用の成熟度に応じて段階的に環境を拡張します。プラットフォームの保守運用はNTTデータが一括で実施し、お客様は成果創出に専念することが可能です。また、日々最新のテクノロジーをキャッチアップし、常に活用しやすい環境を提供します。なお、ご要望に応じて上流のコンサルティングフェーズからAI/BIなどのデータ活用支援に至るまで、End to Endで課題解決に向けて伴走することも可能です。

NTTデータとDatabricksについて

NTTデータは、お客様企業のデジタル変革・DXの成功に向けて、「databricks」のソリューションの提供に加え、情報活用戦略の立案から、AI技術の活用も含めたアナリティクス、分析基盤構築・運用、分析業務のアウトソースまで、ワンストップの支援を提供いたします。NTTデータとTableauについて

ビジュアル分析プラットフォームのTableauと2014年にパートナー契約を締結し、自社の経営ダッシュボード基盤への採用や独自のコンピテンシーセンターの設置などの取り組みを進めてきました。さらに2019年度にはSalesforceとワンストップでのサービスを提供開始するなど、積極的にビジネスを展開しています。

これまでPartner of the Year, Japanを4年連続で受賞しており、2021年にはアジア太平洋地域で最もビジネスに貢献したパートナーとして表彰されました。

また、2020年度からは、Tableauを活用したデータ活用促進のコンサルティングや導入サービスの他、AI活用やデータマネジメント整備など、お客さまの企業全体のデータ活用民主化を成功させるためのノウハウ・方法論を体系化した「デジタルサクセス」プログラムを提供開始しています。

https://www.nttdata.com/jp/ja/lineup/tableau/

NTTデータとAlteryxについて

Alteryx導入の豊富な実績を持つNTTデータは、最高位にあたるAlteryx Premiumパートナーとしてお客さまをご支援します。

導入時のプロフェッショナル支援など独自メニューを整備し、特定の業種によらない多くのお客さまに、Alteryxを活用したサービスの強化・拡充を提供します。

NTTデータとDataRobotについて

NTTデータはDataRobot社と戦略的資本業務提携を行い、経験豊富なデータサイエンティストがAI・データ活用を起点にお客様のビジネスにおける価値創出をご支援します。

NTTデータとInformaticaについて

データ連携や処理方式を専門領域として10年以上取り組んできたプロ集団であるNTTデータは、データマネジメント領域でグローバルでの高い評価を得ているInformatica社とパートナーシップを結び、サービス強化を推進しています。

https://www.nttdata.com/jp/ja/lineup/informatica/

NTTデータとSnowflakeについて

NTTデータではこれまでも、独自ノウハウに基づき、ビッグデータ・AIなど領域に係る市場競争力のあるさまざまなソリューションパートナーとともにエコシステムを形成し、お客さまのビジネス変革を導いてきました。

Snowflakeは、これら先端テクノロジーとのエコシステムの形成に強みがあり、NTTデータはこれらを組み合わせることでお客さまに最適なインテグレーションをご提供いたします。