Open-interpreterは便利だが、GPT4のAPIを叩きまくったらとんでもねー金額になったずら。

ということあると思います。

せっかくGPU(グラボ)持っているなら、ローカルでサクサクと無料で動かせる、Code-LlamaでOpen-interpreterを動かしたい。

ということあると思います。

でも、ローカルでOpen-interpreterを動かしたら、手の施しようがないくらい環境がぐちゃぐちゃになってしまった。

ということあると思います。

そこで今回はDocker(コンテナ型の仮想環境)をつかって、ぐちゃらない方法を模索します。

→流れ

1.Dockerのインストール

2.Dockerfileの作成

3.Dockerイメージの作成

4.Dockerコンテナの作成

5.DcokerでGPU処理できる環境の構築 ←いまここ

6.Open-interpreterをインストール

7.やったぜ!お金を気にせずコーディング

という妄想をしたのですが、私にはよくわからなかったので頭のいいひとはコメントください。

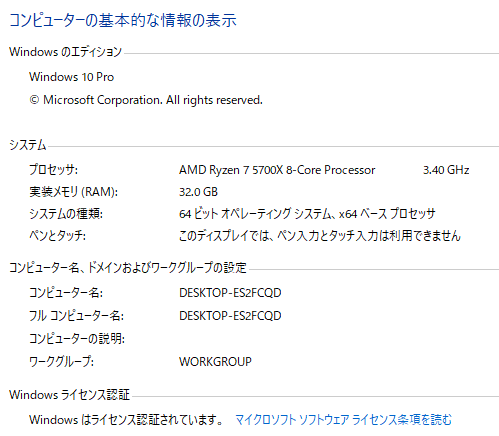

■いまの環境

GPU RTX3080

(コンテナの中身)

anaconda version 1.11.3

Python 3.11.3

まぁ、よくわからないけど動くプログラムがあふれる時代が来るのでしょうきっと。しらんけど。

English

Open-interpreter is useful, but I got a ton of money when I started hitting all the GPT4 APIs.

I'm sure there are times when this is the case.

If you have a GPU, you want to run Open-interpreter with Code-Llama, which can be run locally.

But if you run Open-interpreter locally, the environment is so messed up that you can't do anything about it.

I'm sure there are times when you want to run Open-interpreter locally.

This time, we will use Docker (containerized virtual environment) to find a way to avoid messy environment.

→Flow

Install Docker

Creating Dockerfile

Creating a Docker image

- Create Docker container

5.Create GPU processing environment with Dcoker ←here we are now

6.Install Open-interpreter

- We did it! Coding without worrying about money

Current environment

img

GPU RTX3080

(Container contents)

anaconda version 1.11.3

Python 3.11.3

Well, there will probably come a time when there will be a lot of programs that work even though we don't know what they are. I don't know.