TRELLIS.2とは?

2025年12月17日にマイクロソフトが公開した画像から3Dデータを生成する技術

原論文:https://arxiv.org/pdf/2512.14692

3行要約

- 本研究は、複雑なトポロジーと詳細な外観を表現できる「O-Voxel」という新しい疎なボクセル構造を導入し、ジオメトリとマテリアルの両方を統一的にエンコードします。

- O-Voxelに基づき、高空間圧縮率を実現するSparse Compression VAE (SC-VAE) を設計し、高解像度3D生成を可能にするコンパクトな潜在空間を学習します。

- この学習された潜在空間上で大規模なフローマッチング生成モデルを訓練することで、既存モデルをはるかに超える高品質で効率的な3Dアセット生成を実現しました。

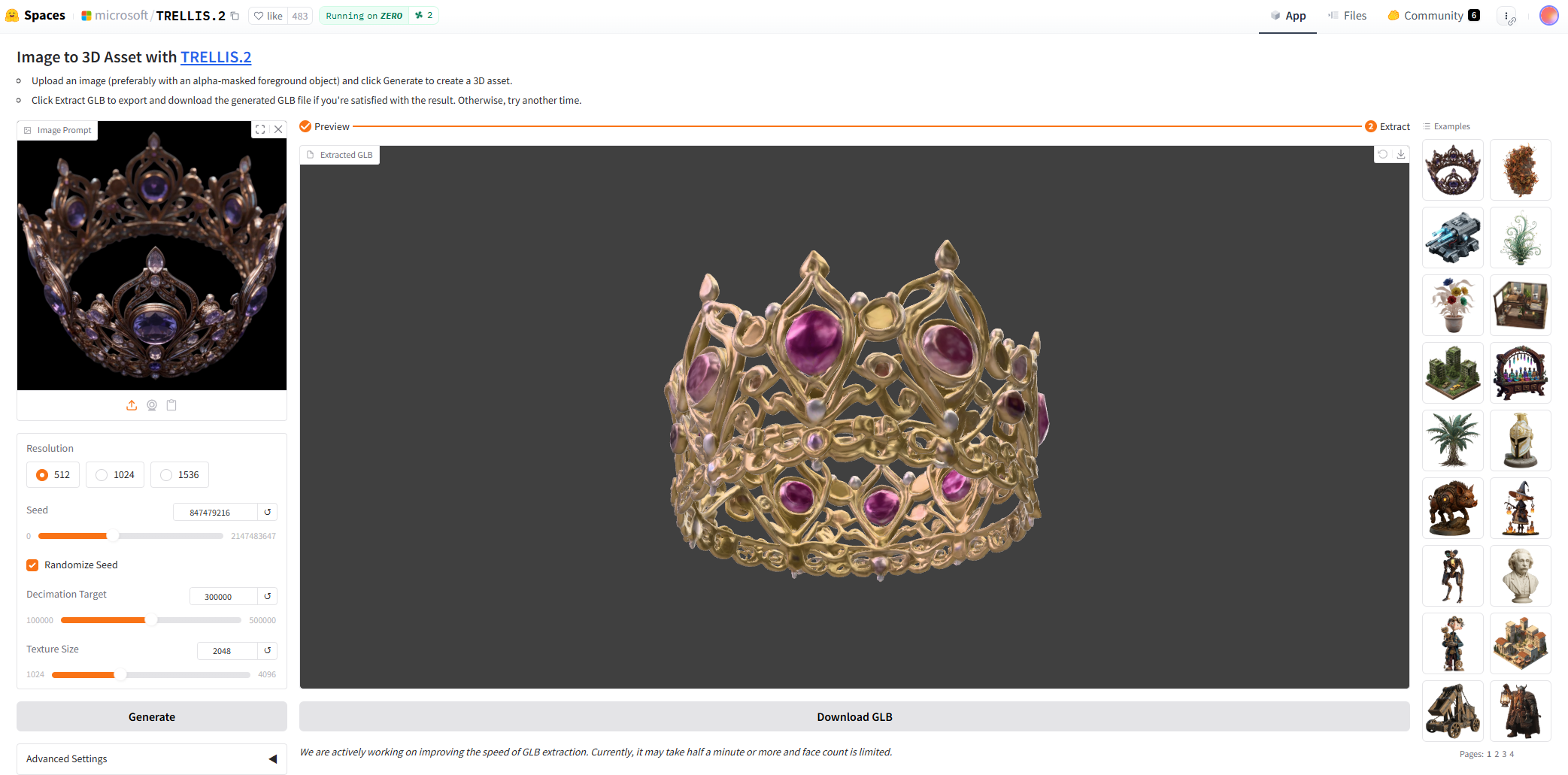

hugging faceにデモが公開されているので試してみた.

サンプルの冠画像を3D化してデータをダウンロード

とても混んでいるのか、GPUリソースの割り当てが少ないので、1日に何度も試すことは出来なそう(画像1,2枚?)

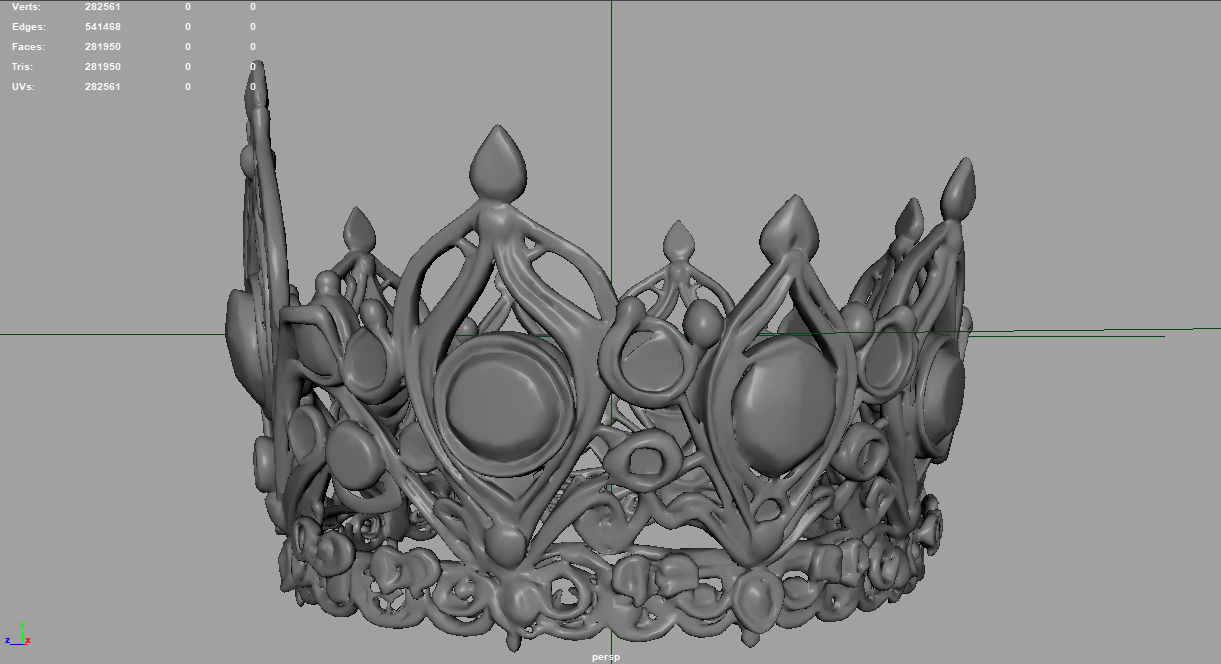

glbからfbxに変換(web上に変換サービスあり)してmayaにインポートしてみた(なんとmayaは標準でglbをサポートしてない)

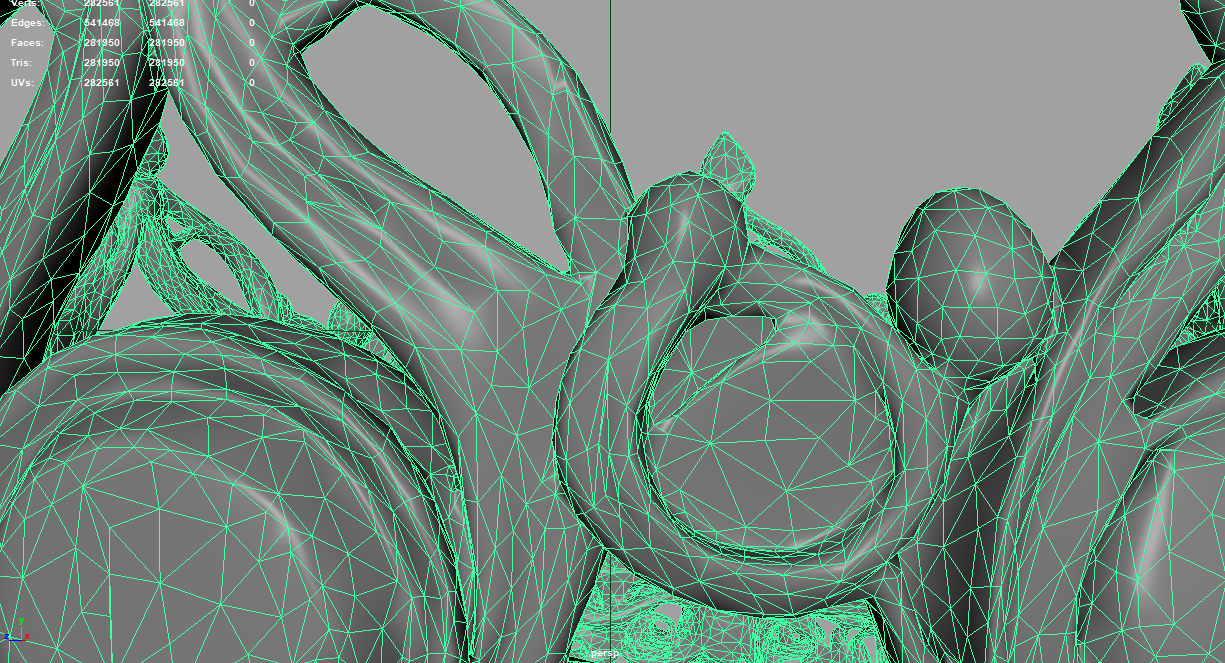

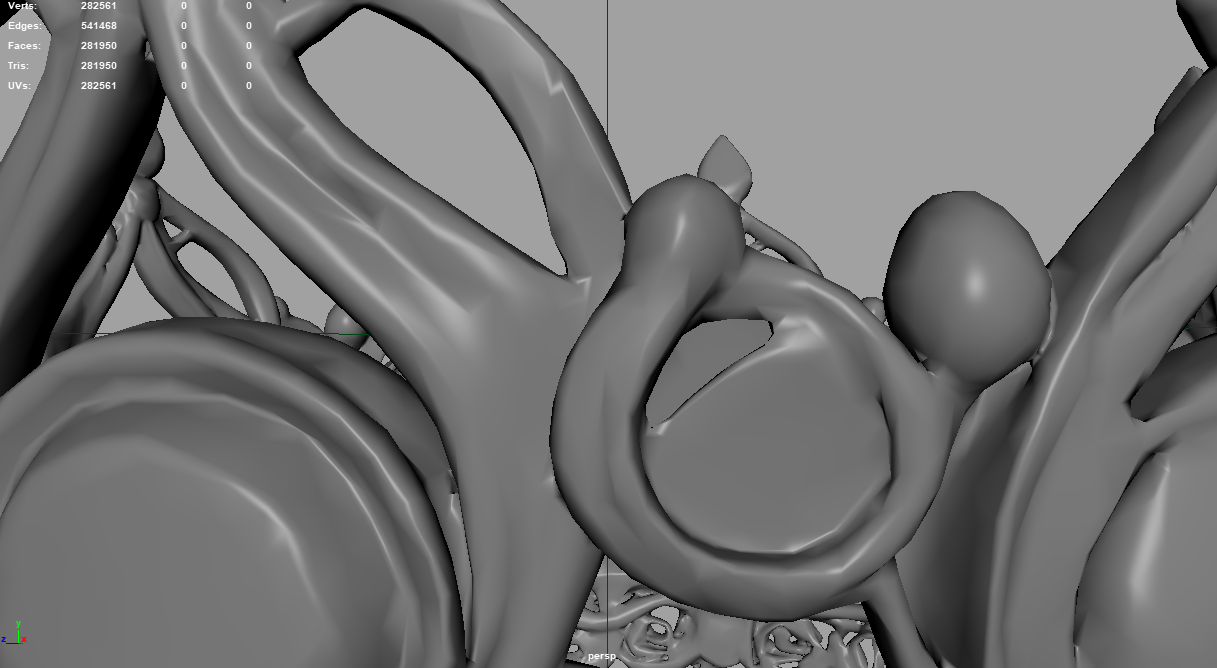

よりで見ると、ところどころ、ん?、となる部分もあるが、メッシュ解像度を上げればもっと高精細になるのだろう.

PBRテクスチャも生成できるようだが、HuggingFaceのデモから出力できるのかは不明

パーツ分割は対応していない模様

HuggingFaceでは試しにくいのでローカルでの環境構築を考えたがVRAM 24GB以上のGPUが必要らしく即断念.ちなみにcolabで実行する方法を紹介している人もいた(H100を使う、つまりサブスクしている前提)

Hunyuanには低メモリでも動くようにカスタムされた亜種も公開されているので、しばらく待ては普通のゲーミングPCくらいでもテスト出来るようになるかも?

Tripo, Hunyuanなど画像から3Dデータを生成する手法はこの1年で大幅に進歩したと思う.

動画生成の進化も凄いし、3DCG関係の仕事、今後どう変化していくのだろうか…

参考: