シリーズ一覧

概要

この資料は、QA4AIコンソーシアムが作成するAIプロダクト品質保証ガイドライン(2019.5)を短くまとめたものです。

元のドキュメントは読み物としては良いのですが、典型的な逆茂木型文章であり、分かりづらいのでまとめました。

本稿の使い方

- AIプロダクト品質保証ガイドラインの概要をざっと把握

- 気になったところや詳細を知りたいところは公式の資料を見る

といった使い方をしていただければと思います。

※AIプロダクト:AI技術を用いた製品やサービス

免責事項

本稿は学習の成果物の一つとして作成したものであり、記載内容の正確さは担保致しません。

したがって、本稿に記載した内容に基づくあらゆる事項について一切の責任を負いかねますので、予めご了承ください。

目次

- 目的とスコープ

- AIプロダクトの品質保証の枠組み

-

技術カタログ

本稿のターゲット

本稿のターゲット - 生成系システム

- スマートスピーカー

- 産業用プロセス

- 自動運転

- AIプロダクト品質保証コンソーシアムについて

3. 技術カタログ

前提

機械学習には大きく分けて「教師あり学習」「教師なし学習」「強化学習」がある。

「教師あり学習」は、昨今の性能向上やタスクの明確さから実運用が比較的進んでいるため、

本章では、教師あり学習の品質を中心に扱う。

用語の説明

| No | 用語 | 本章における意味 |

|---|---|---|

| 1 | 訓練データ/学習データ | 学習アルゴリズムを実装したプログラムの入力データ |

| 2 | 学習プログラム | 学習アルゴリズムを実装したプログラム |

| 3 | モデル | 学習プログラムの実行により得られ、 識別・予測・制御などを行うソフトウェア部品であり、 入出力の関係性を表したもの |

| 4 | ハイパーパラメータ | 学習のおけるパラメータオプション(訓練により得られるものではない) |

| 5 | 敵対的サンプル | (正常に振る舞う入力に比べて)微量に変化しているだけだが、出力を大きく変えるような入力データ |

| 6 | (モデルの)性能 | 正解率や精度等の指標で表されるもの。ISO25010 品質モデルで言えば「正確性」に相当する概念 |

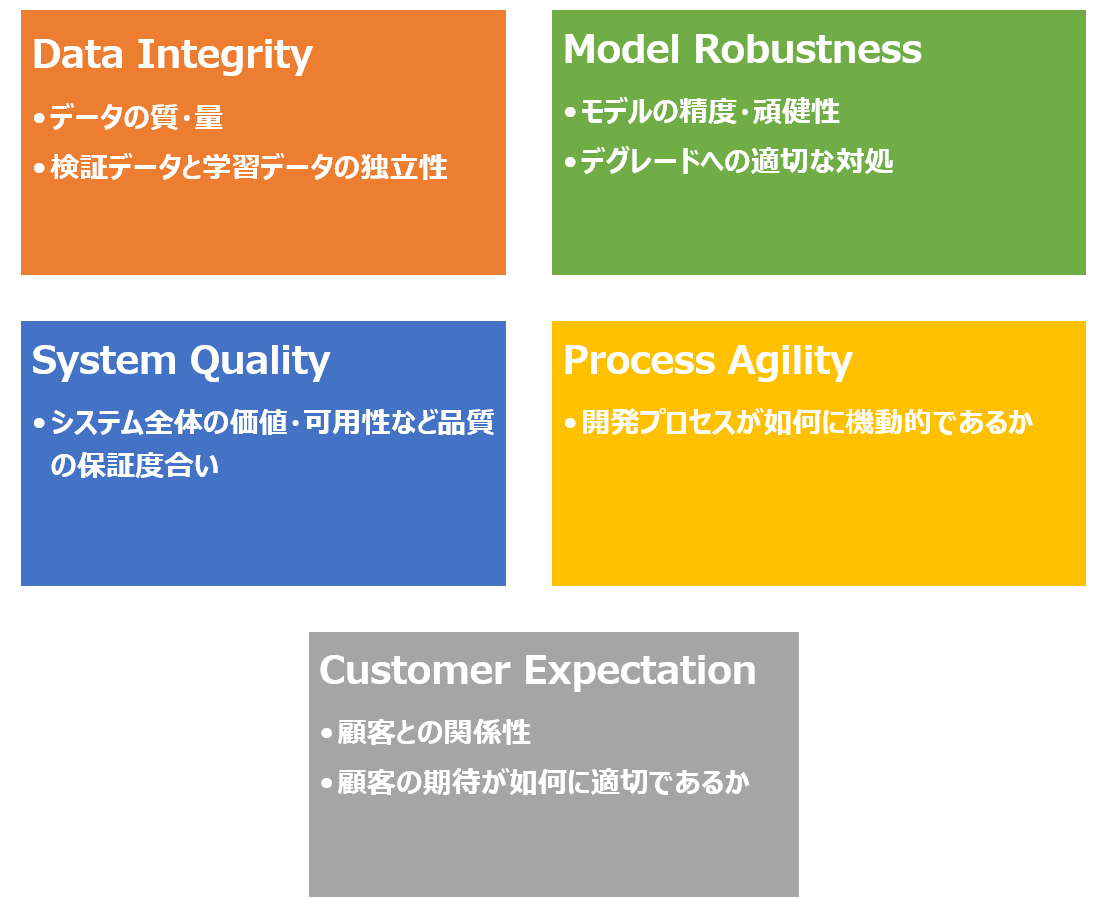

再掲:AIプロダクトの品質保証において考慮すべき軸

3.1. AIプロダクト固有の品質特性

3.1.1. (教師あり学習の)モデルに対する性能指標

Model Robustness に関連

(1)分類タスクにおける性能指標

- 正解率、混同行列、ROC、AUCなどの詳細は下記サイトなどを参考にしてください

- 要求やユースケースに合わせて適合率と再現率どちらを優先するか判断することが多い

- 3クラス以上の分類の場合は、クラスごとの適合率を求めたりその平均(マクロ平均)を求めたりする

(2)回帰タスクにおける性能指標

- 予測値と実測値の誤差をとらえる指標が用いられる

(3)汎化性能の指標

- 訓練データに限らない一般的なデータに対する性能を指す(一般化エラーを評価するなどと表現する)

- 過学習(オーバーフィッティング、High Variance)

- 訓練データ固有の規則性・判断基準に合わせすぎて、他の入力データに対する性能が悪い

- 未学習(アンダーフィッティング、High Bias)

- 訓練データの中でさえ必要な規則性や判断基準を表現できていない

- 汎化性能を向上させるために交差検証などを行う

3.1.2. データに対する評価

Data Integrity に関連

- 不適切な訓練データは不適切なモデルを出力する(GIGO)

-

不適切な訓練データとは

- ラベル付けに誤りがあるデータ(運用時の利用用途に照らし合わせて正確である必要がある)

- 運用データ内の規則性(傾向、分布)と**異なる規則性(傾向、分布)**を持っている

- 運用データに含まれるパターンを網羅できていない

- 評価用データについても同様の注意が必要

- この他、一般的なデータ品質(追跡可能性や移植性など)についても留意する e.g. ISO/IEC 25012

3.1.3. 頑健性

Model Robustness に関連

- 何かの変化に対してもモデルが安定して性能を達成するという品質特性を、頑健性(Robustness)と呼ぶ

3.1.4. 説明可能性

System Quality に関連

- システムからの出力を用いる人間が、出力を得る際に用いられた判断基準(モデルが学習した規則性)について把握することができる程度

- 要求や振る舞いを明確に形式知として書き出せない場合でも機能を実現できることが機械学習の強みである

- 一方で、人間が出力を参考にして意思決定を行う場合など、アプリケーションによっては説明可能性・解釈性が必要となる

3.1.5. 機械学習を用いたシステム全体における品質

System Quality に関連

- モデルの精度等は100%にはならないし、それを達成することがシステム開発の根本的な目標ではない

- ビジネス・システムの観点から目標KPIを定義し、その観点から品質を論じる必要がある

- 仮説検定を行う

3.2. AIプロダクトにおける品質管理

Process Agility に関連

モデルの品質、およびモデルを含むシステム全体のマネジメントにおいては以下を留意する必要がある。

(1)ステークホルダーの理解・協力を得る

- 探索的・試験的なプロセスを辿り、場合によっては要求やユースケースも調整する必要がある為、

- その辺の理解を得る必要がある

(2)性能劣化やその要因(候補)を迅速に検出できる監視機構を設ける

- 最初から性能劣化することは織り込み済みで開発すべき、したがって監視機構を設けておく

- 性能劣化が回避できないのは、全ての場面を想定して開発(訓練データ作成や学習)をすることができないからである

- 結果としての性能だけでなく、入力値の範囲や分布など個々の要素や互いの関連についての監視も行う

(3)オンライン学習を行う(実行時のデータもまた訓練データである)

- 実行時のデータを訓練データとして継続的に学習(モデル更新)し続けることで最新の分布に対応できる

- ただし、不適切なデータによってモデルが不適切に更新されないように

- 継続的学習を自動化する際は、訓練データ選別・性能評価・テストも合わせて自動化する

(4)同一モデルを再現できるように情報を記録しておく

- モデルを構築した状況を理解する為に、再現可能な状態にしておくことが望ましい

- モデルは訓練データ・学習アルゴリズム(を実装したプログラム)・ハイパーパラメータとセットであるので、

- それらをまとめて記録しておく必要がある

再掲:AIプロダクトの品質保証において考慮すべき軸

3.3. AIプロダクトの品質保証技術

性能観点以外の品質保証技術については、現在発展途上であり、アプリケーションへの依存性も高い。

ここでは、汎用的な技術について述べる。

3.3.1. 疑似オラクル

Model Robustness および System Quality に関連

- 検証したいシステムの多数・多種な入力を試すための比較システム(別の実装や古いバージョン)を疑似オラクルという

- ※疑似オラクルに関する記述は理解に苦しんだので、ここでは参考になりそうな文献を列挙します

3.3.2. メタモルフィックテスティング

Model Robustness および System Quality に関連

- 「入力に対してある一定の変化を与えると、出力の変化が理論上予想できる」という関係(メタモルフィック関係)を用いることで、正否判断が可能なテストを得ること

- 「出力が期待通りではない=コーディングミス or 実装されたモデルに対する理解の誤り」を意味するが、

- メタモルフィック関係が本来成り立つと確信できるものであれば、その関係が成り立たないケースは実装不具合を示唆すると考えられる

- ※参考文献

3.3.3. 頑健性検査

Model Robustness および System Quality に関連

- 入力するテストデータに変化を加えて、出力が変化しないかを評価するなどがある

- 例えば、入力が画像データの場合

- 照度変化

- 一部他画像と合成

- ゆがみ

- 一部欠損

3.3.4. (ニューラルネットワークにおける)カバレッジ

Model Robustness に関連

- 盲目的に従来のプログラムに対するカバレッジ指標と同等に解釈、運用すべきではない

- なぜなら、各ニューロンの数値大小を用いて、テストの多様性に関する評価や多様なテストを生成する手法が考えられているものの、

- 必ずしも求められる品質と強い相関があるわけではないことも報告されているからである

3.3.5. 説明可能性・解釈性のための技術

System Quality に関連

- 個々の出力に対する説明

- 入力データのうちどの部分がある出力の決定に影響を大きく与えたのかといった情報を提示する技術

- モデル全体に関する説明

- IF-THENルール形式や決定木を用いて、モデル全体が身に着けた判断基準や規則性を人が解釈できるようにする技術

- 参考:David Gunning, Explainable Artificial Intelligence (XAI)

次章につづく