Unity CatalogのSystem Tableがリリースされた事で、こちらの方法でも確認出来るようになりました。

Console上でのデータ分析(AWS/GCPのみ)については、続編としてこちらの記事もご覧ください。

はじめに

AWS Databricksの使用料を確認した際に、UI上だけでは細かい分析ができなかったので詳細データを取得して分析してみましたので、その方法をご紹介したいと思います。

使用料や利用料金を確認するには?

AzureとAWS/GCPで確認の仕方は異なります。Azureの場合はAzure Serviceに組み込まれているため、Azure Portalから確認することが可能です。AWS/GCPは Databricks Account Console上から確認することができます。今回はAWS/GCPのケースにフォーカスしております。

Databricks Account Console -> [Usage]

上図のように、Workspace毎やSKU毎に使用量(DBU)や料金($)を確認できます。日付指定もできるため簡易的な確認はこの画面で十分そうです。しかしもっと細かくクラスター単位やユーザー単位での使用量の分析やプロジェクト毎の使用量を把握したい場合はこの画面だけでは足りそうもありません。

詳細データを取得する

上図のUsage画面には、もう一つ機能として詳細データ(csv)を取得することができます。右上の**[Usage actions]**をクリックすると以下の画面が現れます。 取得する期間を指定してDownloadするとcsvファイルが取得できます。

どのようなデータが取得できるかというと以下のようなスキーマ情報になります。

https://docs.databricks.com/administration-guide/account-settings/usage-analysis.html#csv-file-schema

他にもAPI経由で取得することができるため、継続的にモニタリングしたい場合はAPI経由でS3などのストレージに保管するように設定するといいと思います。設定方法

Databricks 利用料金データを S3に保存するように設定するには?

https://qiita.com/maroon-db/items/3b8f6216d29ce8f7baec

データを使って分析してみる

せっかくなのでDatabricks上で分析してみたいと思います。最後にサンプルノートブックも用意しておりますのでお手元で試してみてください。

また今回のサンプルノートブックはマニュアルにあるサンプルコードをカスタマイズして利用しております。

1) データのアップロード

先ほどダウンロードしたファイルをS3ストレージもしくはDatabricks上にアップします。S3上に保存してそれをマウントして利用することで長期的な運用が可能になるのでお勧めですが、お試しであれば直接アップロードでもいいかと思います。

2) サンプルノートブックのインポート

今回は[こちらのサンプルノートブック](https://sajpstorage.blob.core.windows.net/maruyama/public_share/AWS Usage Analysis Dashboard.html)を利用します。自分の環境にインポートしてご利用ください。

3) ファイルパスと料金設定の確認

アップロードしたファイルパスの編集と、利用しているEditionや各料金設定を確認します。金額設定はこちらの内容を元に金額を算出するためお客様の契約内容に応じて変更してください。defaultの金額はこちらで確認できます。[AWS Pricing]

(https://databricks.com/product/aws-pricing)

(契約内容によっては割引が適用されているケースもあります。)

4) RunAll実行と処理概要

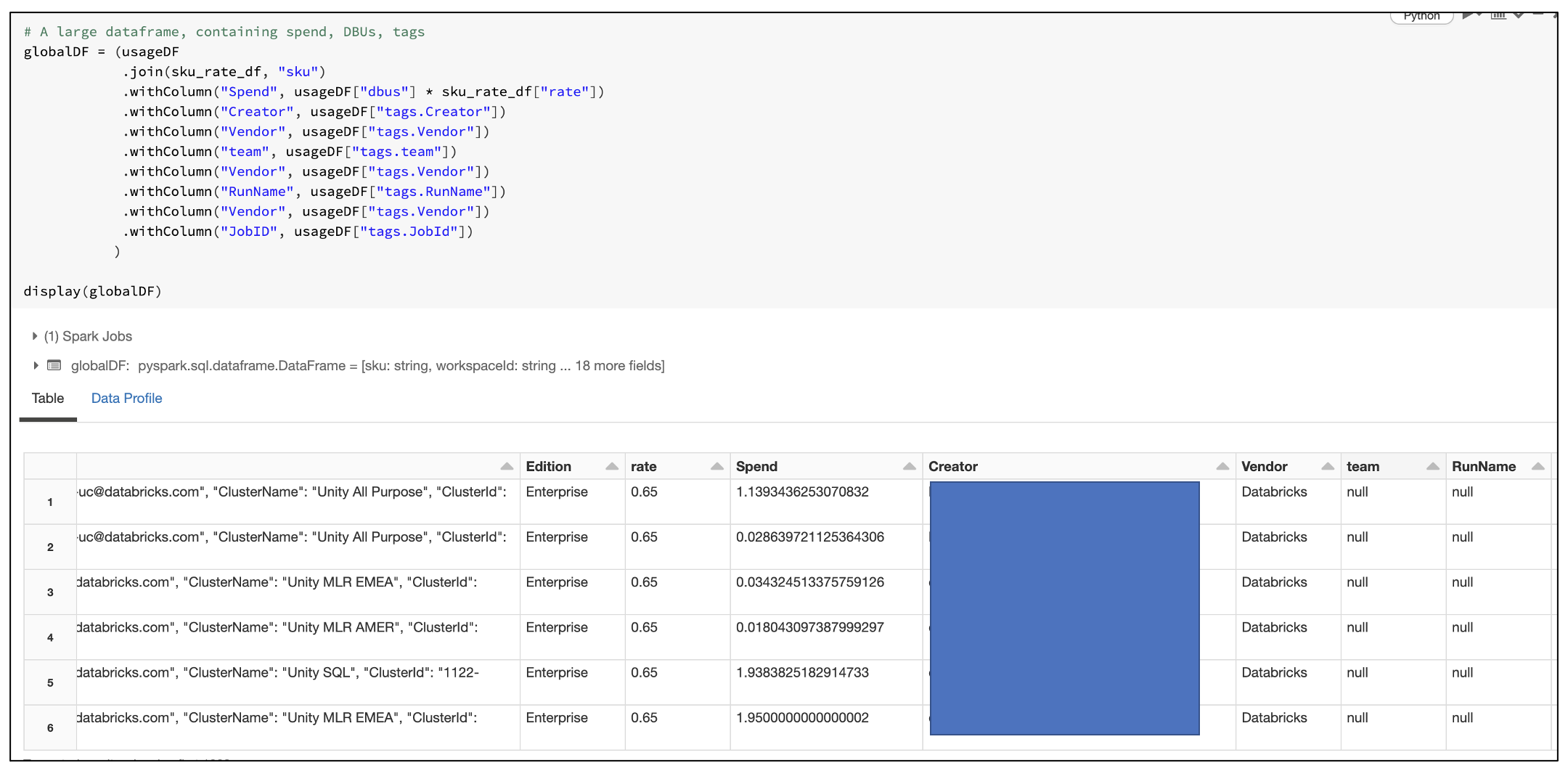

あとはRunAll実行します。どのようなことを実行しているかというと今回取得した詳細データには、各Cluster毎のdbuが算出されておりますが、金額までは算出されておりません。そのため別途price表を作成してjoinしております。

join後のglobal data(globalDF)

取得したデータ(usageDF)に金額リスト(sku_rate_df)をjoinし、tag情報をいくつかパースしたデータフレームになります。tag情報は独自に追加できるため、適宜変更してご利用ください。

widget作成

またwidgetを作成してこの後、日付やtag指定などを出来るようにオプションを追加しております。Widgetを利用するとインタラクティブな分析が可能になります。

usage関数作成(累積算出のため)

こちらはオリジナルのサンプルノートブックにあったため利用させていただきました。この後の処理が簡素化できるのと累積表示が可能になります。

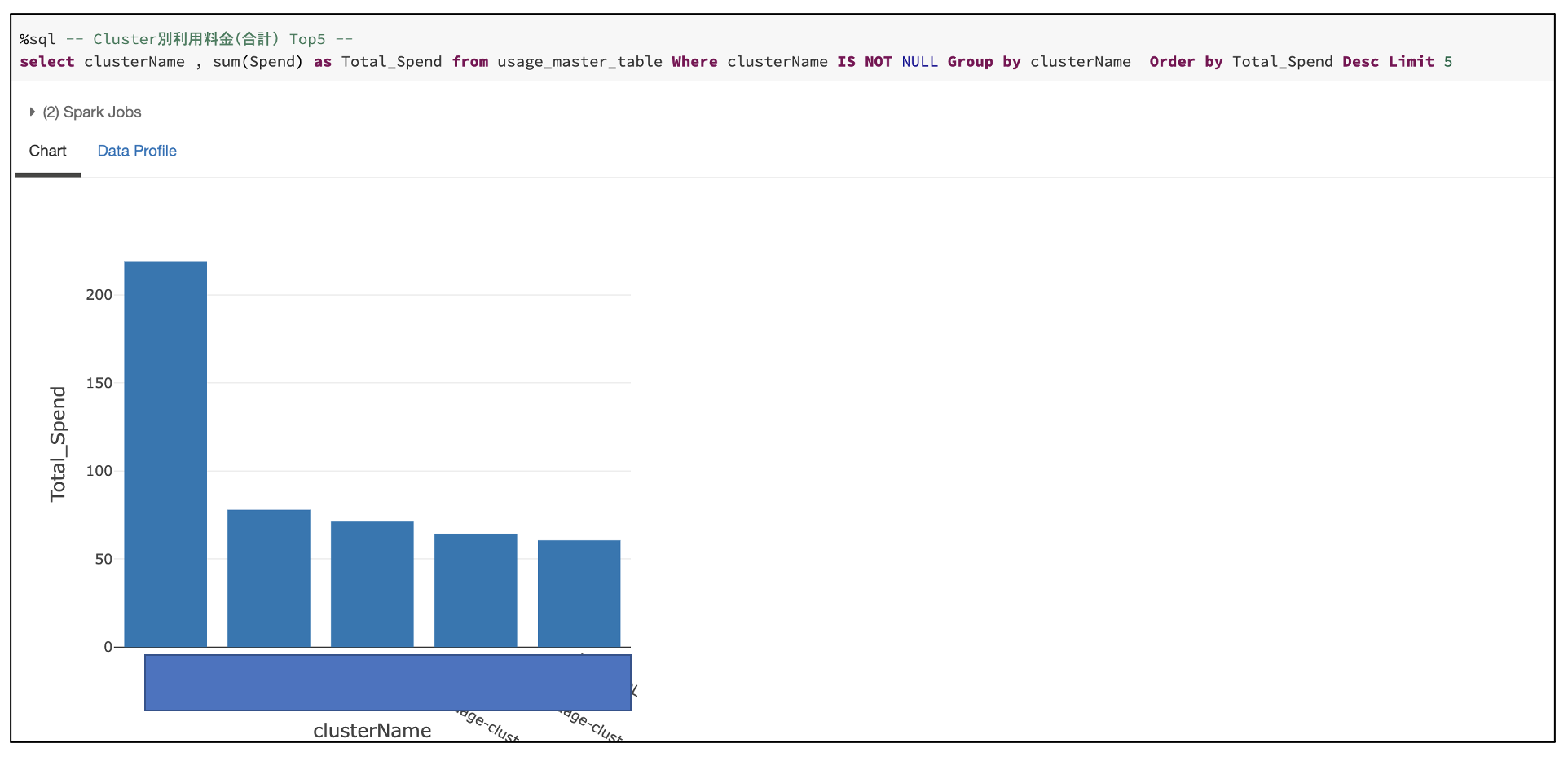

5) 分析してみる

それでは早速いくつか分析グラフを用意しましたのでみてみたいと思います。

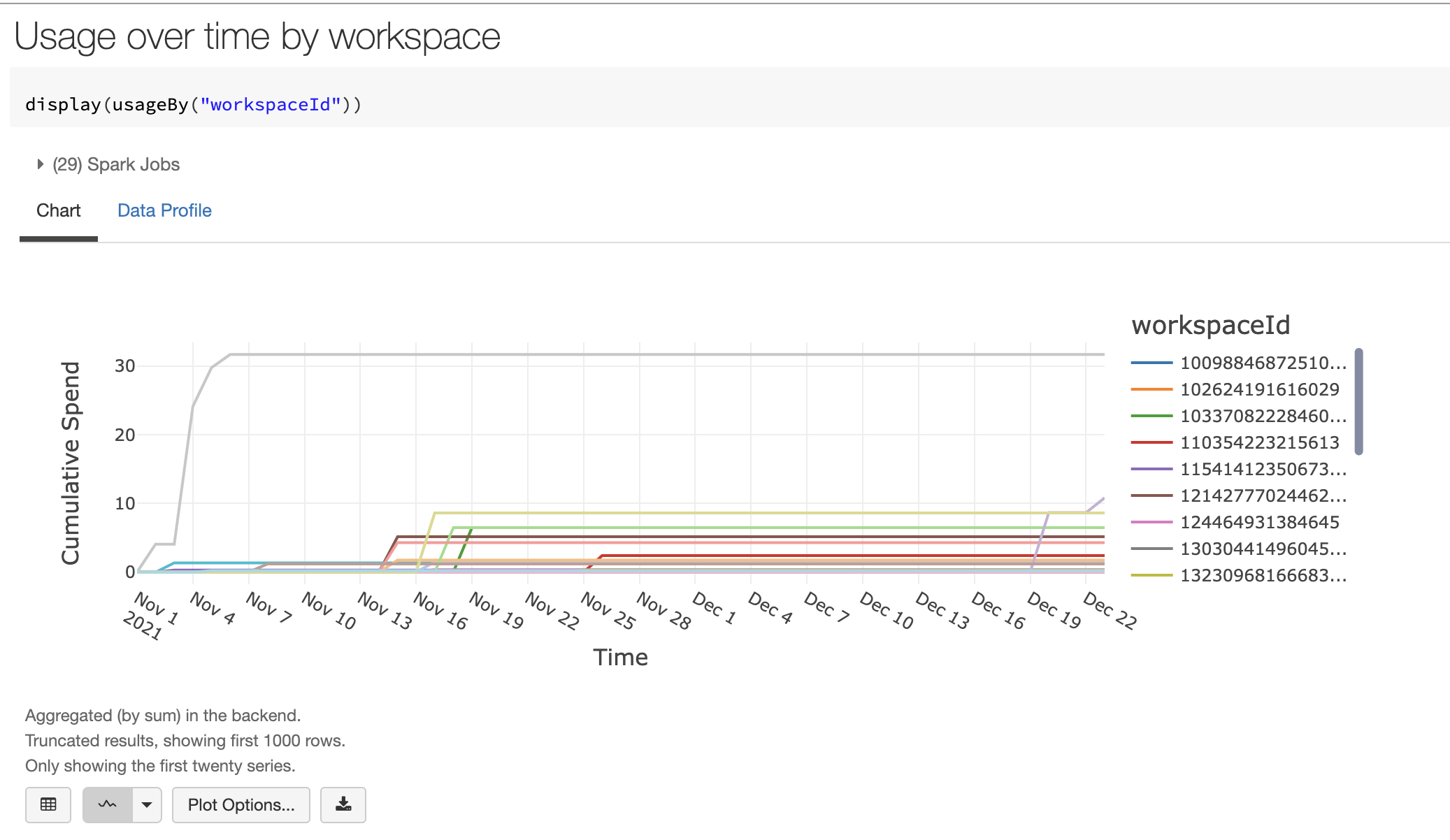

workspace毎の使用金額

会社内で複数のワークスペースを用意している場合、ワークスペース毎にモニタリングすることは非常に重要です。ここでは累積データを使いました。

[plot Option]で累積ではないデータでの表示やDBU表示に切り替えることができます。

SKU毎の使用金額

Notebook上で実行したものはAll Purposeとして課金され、Job実行ではJobとして課金されます。そのためSKU単位で見ることでどのような処理が多いかが確認できます。

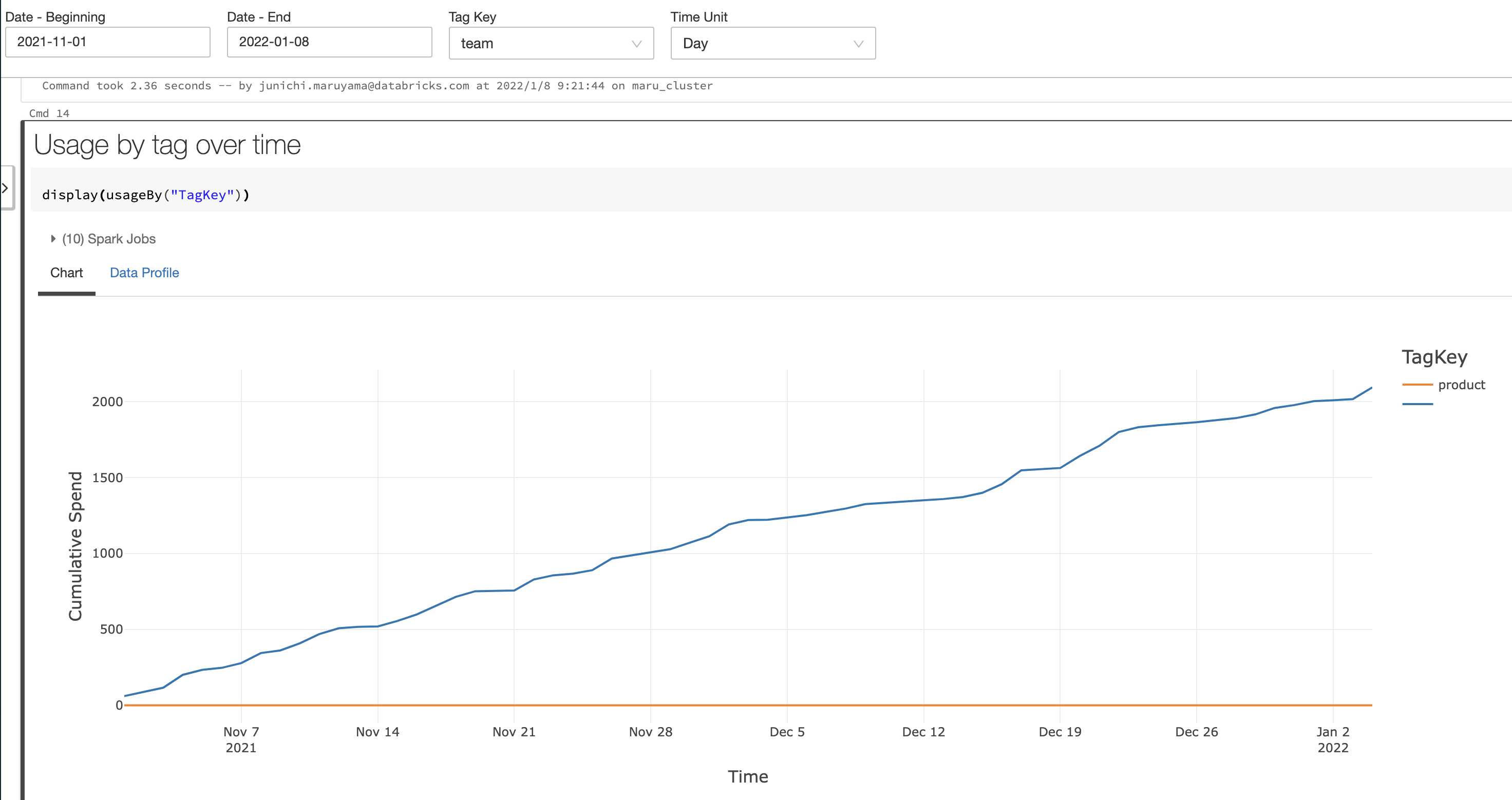

Tag毎の使用金額

Widgetのtagを指定することで、tag単位での使用料を確認できます。

以下はteamというタグを指定してますが、teamタグがないケースが多いため殆どnullになってしまってます。global設定でデフォルトtagなど指定すると更に良いかと。

tableを作成することでSQLを使った分析が可能になります。またDatabricks SQLからもアクセスできるようになり、ダッシュボード作成や外部のBIツールからのアクセスが可能になります。

勿論他にも様々な分析ができるかと思います。是非お試しください。

7) Databricks SQL Dashboardで運用しよう

長期的なモニタリングを考えるなら是非Dashboardを作成して運用してみてください。Alert設定も可能ですので使いすぎの場合などアラートをあげて対応することが可能になります。

ここからはノートブックは利用しませんが、運用時には取得したデータを加工してDelta Tableとして保存する必要があるので、このノートブックをJob登録して定期実行すると良いかと思います。

Databricks SQLを使ったDashboard作成はまた別の記事でご紹介いたします。