1. 概要

Open AI のgpt-oss-120b をきっかけにローカルLLM デビューをしました。

最近流行りのChat GPT や Copilot, Claude, Grok, Gemini,DeepSeek,Llama など、さまざまな LLM サービスが登場していますが、クラウドサービスが主流のため、情報を外部に出したくない用途などでは導入しずらいことも多くあります。

そんなわけで、ローカルLLM とCData MCP Server を使って、オフライン環境で使えるオンプレミスLLM を構築する方法について解説します。

MCP (Model Context Protocol) とは

MCP (Model Context Protocol) は、AI アプリケーションを外部システムに接続するためのオープンソース標準規格です。

MCP を使用することで、Claude や ChatGPT などのAI アプリケーションが、データ ソース(ローカル ファイル、データベースなど)、ツール(検索エンジンなど)、ワークフロー(専用のプロンプトなど)に接続して、重要な情報にアクセスし、タスクを実行できるようになります。

CData MCP Server とは

CData MCP Servers は、Model Context Protocol(MCP)とCData の400以上のSaaS / DWH / DB に対応するコネクタライブラリを統合した製品です。

業務システムのデータ活用はAI におまかせ | CData MCP Servers

CData MCP Server を使うことで、LLM とさまざまなデータソースを連携させることができるようになります。

2. 使用環境

PC 環境としては、1 ~2 世代前のゲーミングPC にメモリを積んだような感じです。

| CPU | AMD Ryzen 7 5700X |

| MEM | KOWIN DU3200(DDR4 3200MHz 32GB x 4) 128GB |

| GPU | NVIDIA GeForce RTX 4070 Ti Super 16GB |

| SSD | crucial CT1000P1SSD8JP |

| OS | Microsoft Windows 10 Pro |

3. 導入方法

3.1. LM Studio のインストール

まずは、LM Studio をダウンロードしてインストールします。

LM Studio は、Windows, Linux, MacOS 版がありますが、CData MCP Server は、Windows 用とMac 用なのでWindows またはMac のいずれかを選びます。

LM Studio - Local AI on your computer

3.2. CData MCP Server のインストール

今回の主役である、CData MCP Server をダウンロードします。

今回は、簡単な解説用として、SQL Server を使用しました。

他にも、Oracle, SQL Server, MySQL, PostgreSQL, DB2 などのデータベースや、SAP をはじめとしたERP などさまざまな製品に対応したMCP Server があります。

注意点として、2025/12/01 時点では、MCP Server 製品のダウンロード方法が若干分かりずらくなっています。

3.2.1. CData のWebページから、使用したいコネクタを選択します

CData Drivers - 270種類以上のSaaS / DB とノーコードでデータ連携 | CData Software Japan

3.2.2. コネクタにある「AI (MCP)」を選択します

3.2.3. 「無償トライアルをダウンロード」をクリック

「無償トライアルでスタート →」 の下にある「オンプレミスのローカルMCPサーバーをお探しですか?」と書かれている方のリンクをクリックします。

「無償トライアルでスタート →」の方をクリックすると、Connect AI のページに移動してしまいます。

3.2.4. Windows, またはMac のいずれかの「ダウンロード」をクリック

これで、目的のMCP Server がダウンロードできます。

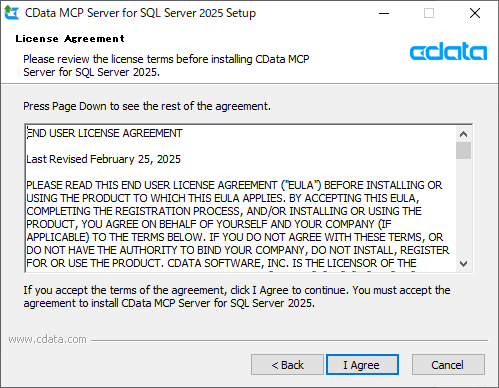

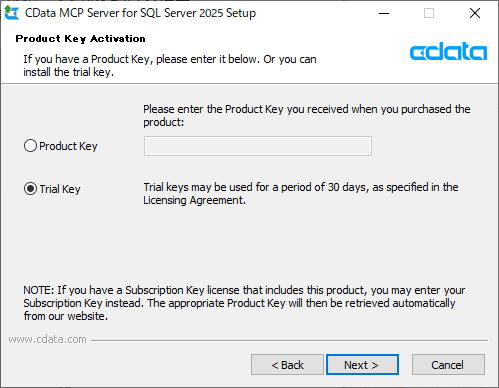

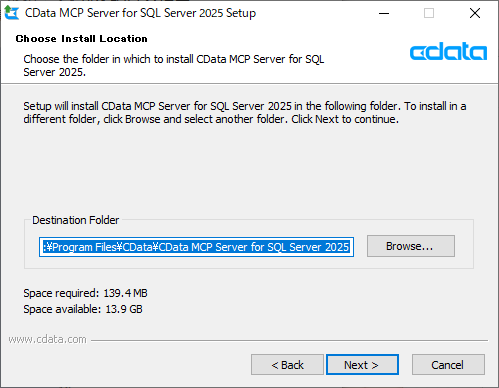

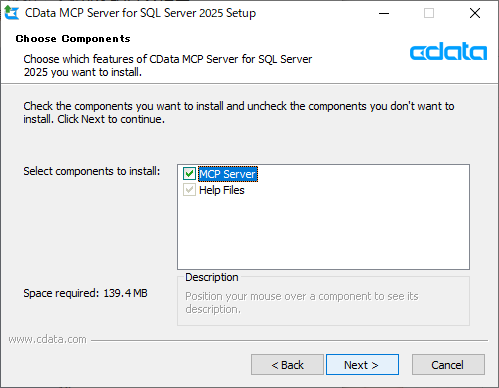

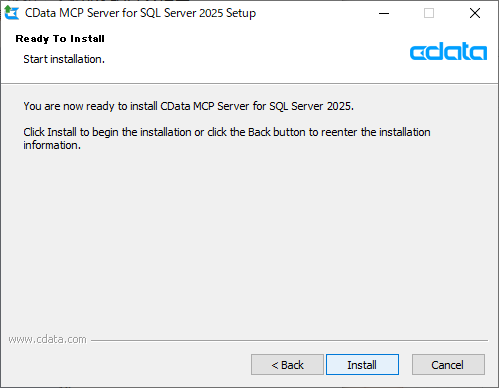

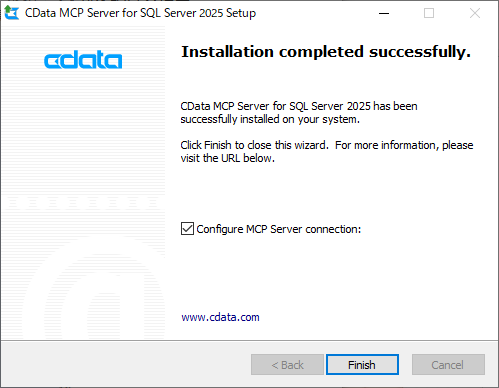

3.3. MCP Server のインストール

画面の通り進むだけでOKです。

|

|

|

|

|

|

|

|

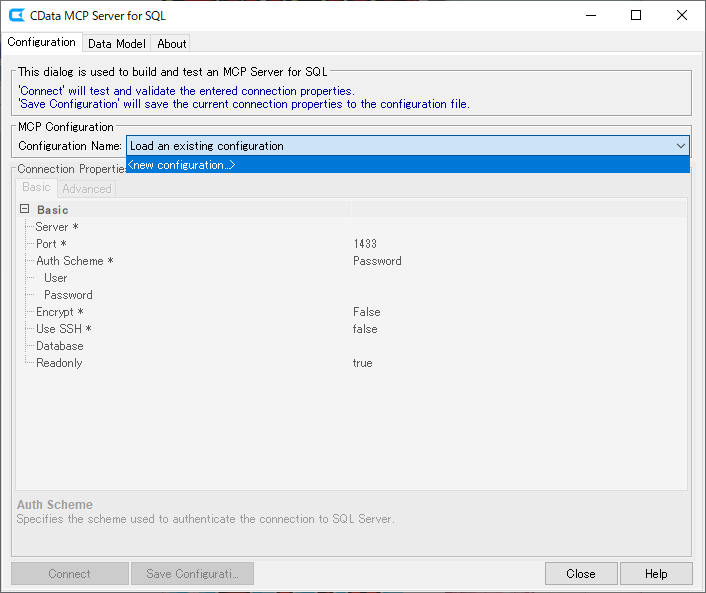

3.4. MCP Server の接続設定

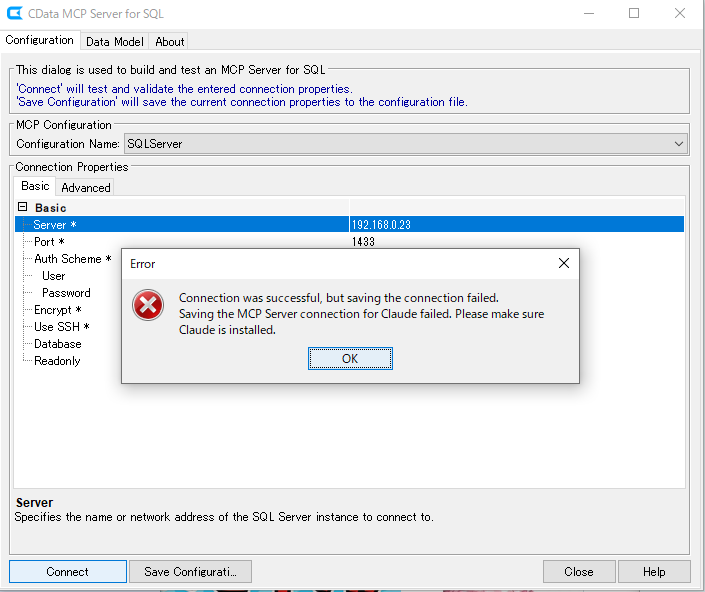

インストールが完了してそのまま「Finish」をクリックすると、Configuration Tool が起動します。

後から起動する場合は、インストールフォルダーのlib フォルダーにある"cdata.mcp.*.jar" を実行すればConfiguration Tool を起動できます。

|

|

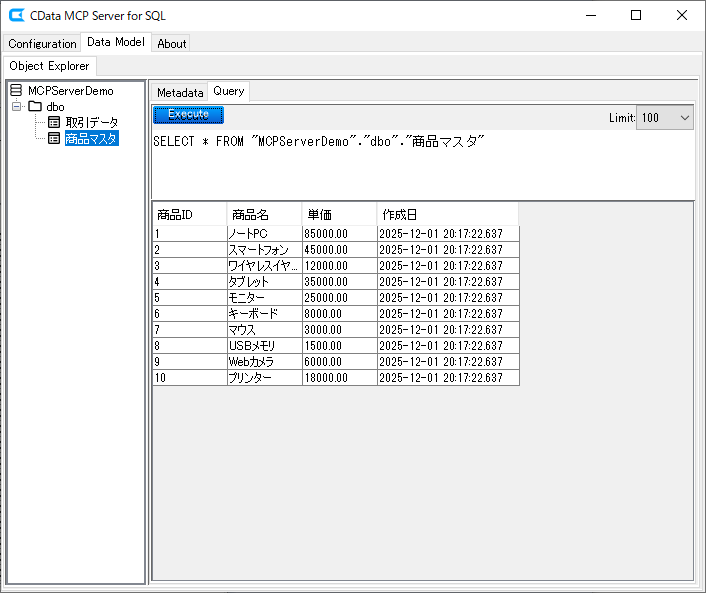

「Data Model」タブでスキーマ情報などが正しく取得できてることを確認したら、MCP Server の設定は完了です。

今回は、デモ用として、取引データと商品マスタという2つのテーブルにデータを入れてあります。

|

|

ちなみに、設定内容は"%APPDATA%\CData\xxx Data Provider"というフォルダーに"<Configuration Name>.mcp"というファイルで保存されています。

3.5. LM Studio の準備

3.5.1. モデルのロード

LM Studio を起動したら、使いたいモデルをロードします。

初めての場合は、左側にある「探索」からモデルを検索します。

今回は、openai/gpt-oss-120b を使用します。

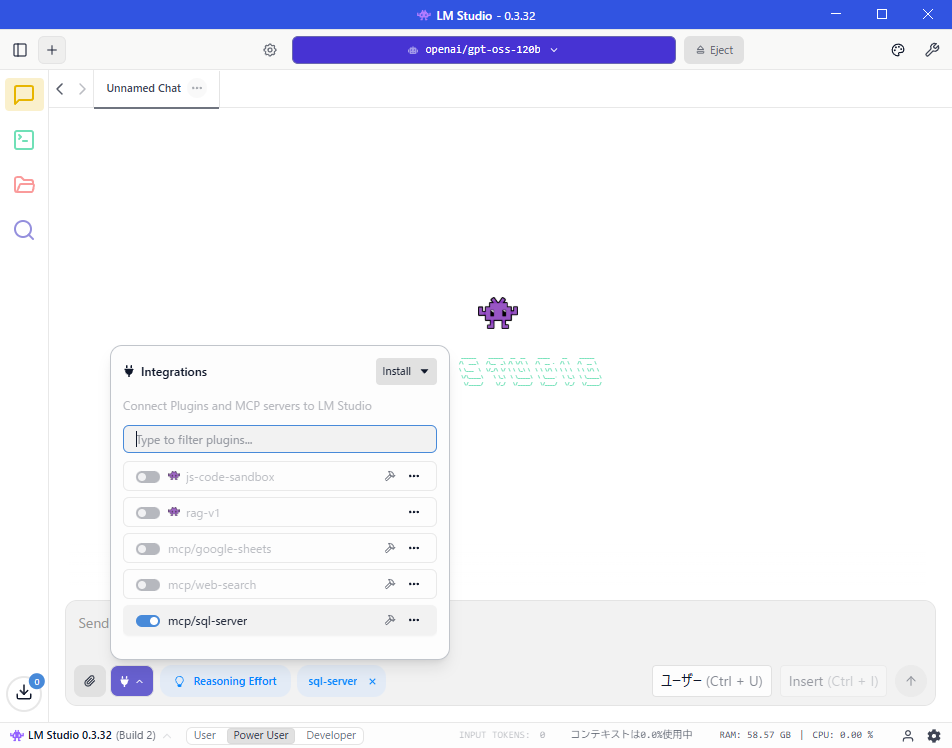

3.5.2. mcp.json の設定

モデルからMCP Server を使えるようにするため、mcp.json で呼び出し方法を記述します。

CData MCP Server の場合は、SQLServer のところを使いたいコネクタに置き換えて書けばOKです。

Integrations - Install から Edit mcp.json"をクリック

下記のように記述します。

```json:mcp.json

{

"mcpServers": {

"SQLServer": {

"command": "C:\\Program Files\\CData\\CData MCP Server for SQL Server 2025\\jre\\bin\\java.exe",

"args": [

"-jar",

"-Dfile.encoding=UTF-8",

"C:/Program Files/CData/CData MCP Server for SQL Server 2025/lib/cdata.mcp.sql.jar",

"SQLServer"

]

}

}

}

```

設定を保存すると、下記のようにmcp/sql-serverという項目が増えているので、有効にすれば、モデルがSQL Server へアクセスできるようになります。

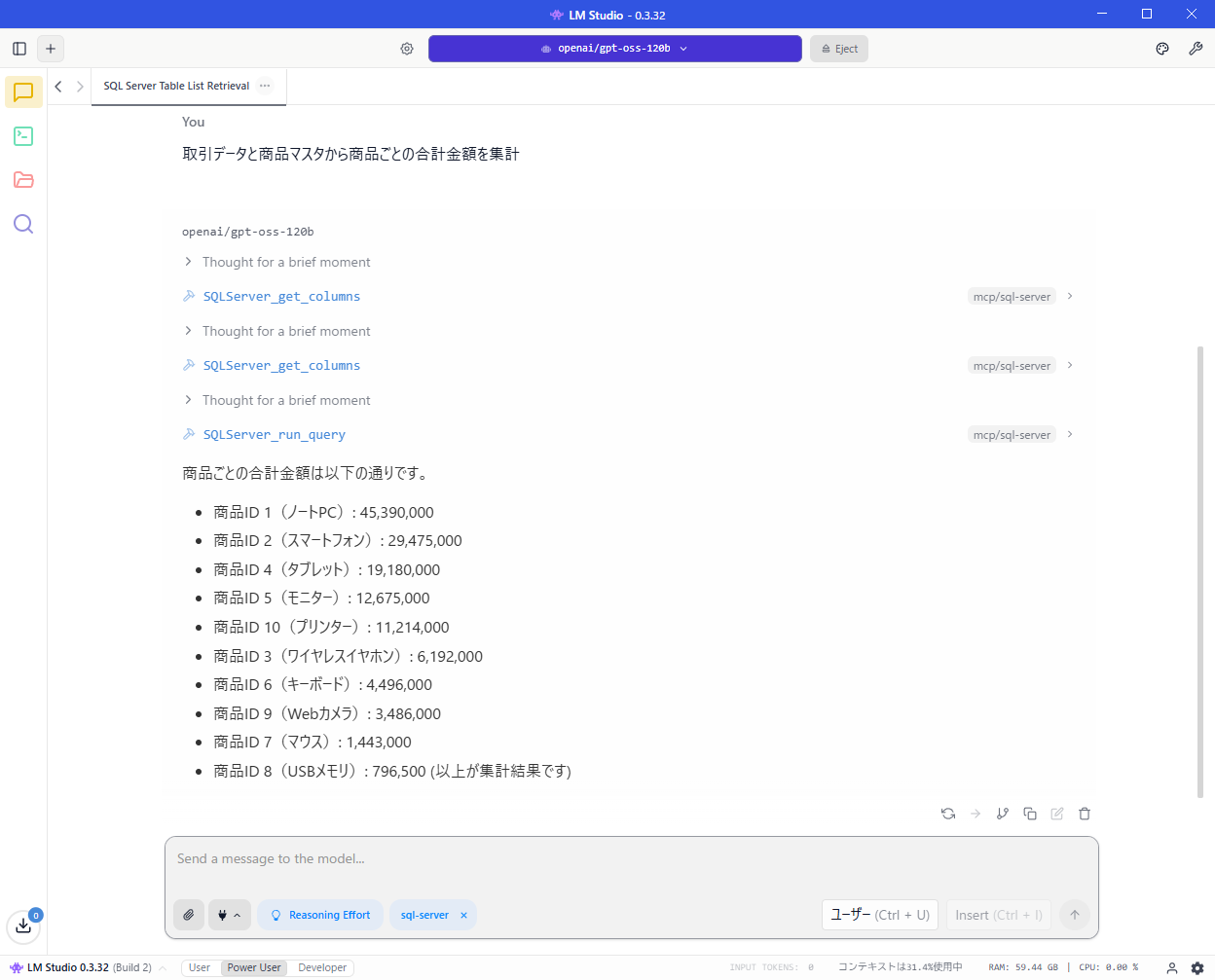

4. 使ってみる

mcp/sql-server を有効にしてプロンプトを実行すると、LLM がSQL Server からデータを取得して結果を返してくれます。

5. 外部からアクセスできるようにする

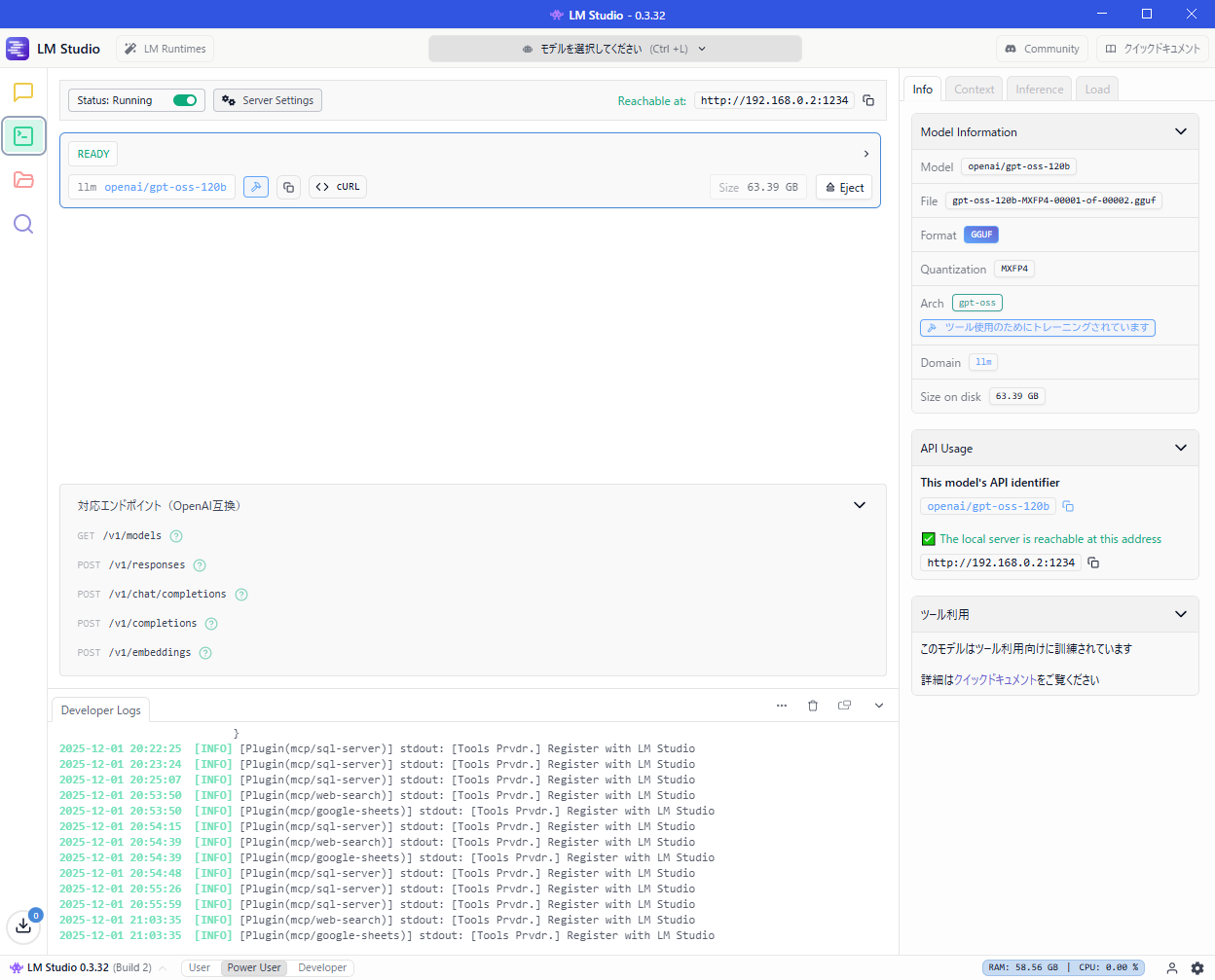

[開発者] タブにある「Status: Running」を有効にすると、API 経由でLM Studio へアクセスできるようになります。

デフォルトでは、同一PC 内からのアクセスに限定されていますが、「ローカルネットワークで提供」を有効にすれば、別PC からのアクセスもできるようになります。

6. LLM を動かすPCについて

OpenAI のサイトには下記のように記載されています。

gpt-oss-120b と gpt-oss-20b 両方のウェイトは、Hugging Face から無料でダウンロードでき、MXFP4 でネイティブに数値化されています。これにより、 gpt-oss-120B モデルは80GB のメモリ内で実行でき、gpt-oss-20b は16GB のみ必要とします。

もし、まともにGPU のみで実行しようとすると、NVIDIA RTX PRO 6000 Blackwell Workstation Edition [PCIExp 96GB] とかが必要になります。

しかし、速度を妥協できるなら、CPU でも動作させることができます。

今回の例でも、GPU のVRAM は16GB しかなく、モデルの大半はCPU 側のメモリに置かれた状態で動作していますが、4~5 token/sec ぐらいのスピードは出ています。

ボトルネックになっているのは恐らくDDR4 のメモリ帯域なので、DDR5 メモリならもう少し改善されるでしょう。

ローカルLLM に適しているPC としては、Windows であればRyzen AI Max+ 395 でメモリ128GB を搭載したモデルや、メモリ128GB 以上を搭載したMac があります。

どちらも、ユニファイドメモリというCPU/GPU でメモリを共有する仕組みを採用しており、CPUとGPU で柔軟にメモリを融通できるうえ、メモリ帯域が広いので、そこそこのパフォーマンスを出すことができます。

注意点としては、これらのPC は後からメモリを増設することができないので、導入する際は、予算の許す限り最大のメモリを積んでいるモデルを購入する必要があります。

7. gpt-oss-20b の場合

一応、テーブル一覧を取得することまではできましたが、テーブルのデータを取得してくれず、集計などはできませんでした。

プロンプトを工夫すればいけるのかもしれませんが、120b のような使い勝手にはならないでしょう。

お金を節約するために時間を浪費するよりは、素直に課金してしまうことをお勧めします。

8. まとめ

「最近AI が凄いらしい」とか、「AI を導入して業務効率を改善しよう」などと思ったとき、最初にネックとなるのがセキュリティの問題だと思います。

そして「クラウドなんて信用ならん!」などと言う人がいて、導入を反対されることもあるでしょう。

そんなときは、「ローカルLLM なら外部にデータが流れないので安心です」と言って、業務PC にハイスペックPC を導入してもらいましょう。

PC と合わせてデュアルまたはトリプルディスプレイを導入できればベストです。

PC 性能が上がればそれだけでも確実に業務効率を改善することができます(w