1: マジックワードの死と、科学的検証の夜明

巷で囁かれる「プロンプト・エンジニアリングの終わり」。

実際問題、AIの性能向上に伴い、小手先の作文技術の工夫をしなくても、安定して高品質な出力が得られるようになってきています。

しかしそれは、技術の”死”を意味していません。

プロンプト・エンジニアリングは、個人の感覚に頼った「作文技術」や「おまじない」の『詐欺師と有象無象が群がる胡散臭い時代』がようやく終わり、

より体系的で再現性のある「コンテクスト・エンジニアリング(情報環境の設計)」、

さらにAIの思考プロセス自体を設計する「コグニティブ・プロンプティング」(思考関数の設計)という『真っ当な工学の時代』へと進化しようとしています。

Google公式資料が告げた「時代の終わり」

その象徴が、2025年1月にGoogleが公開した技術資料「Prompt Engineering Whitepaper」です。

この資料は「ペルソナ設定」や「ステップ・バイ・ステップ思考」といったテクニックを集大成しました。

それは、これらがもはや一般教養になったという公式な宣言に他なりません。

しかし、本質は別にあります。

資料の後半で紹介されている「ReAct」や「Tree of Thoughts (ToT)」(Chain of Thought、思考の連鎖の発展系)のようなTIPSを超えた、もはや枯れたとも言えるほどのフレームワークは、PE黎明期から存在する理論体系ですが、これらのテクニックは非常に誤解された形で、広まってしまっています。

「段階的に指示する」「タスクを分解する」「構造化する」といった、どこか抽象的で安易な翻訳のTIPSだけを目にして、何となくふんわり実践した事がある人は多いでしょうが、効果を強烈に実感するような事はほとんどないはずです。

しかし、元の理論を紐解くと、そのニュアンスが大きく異なることに気付くはずです。

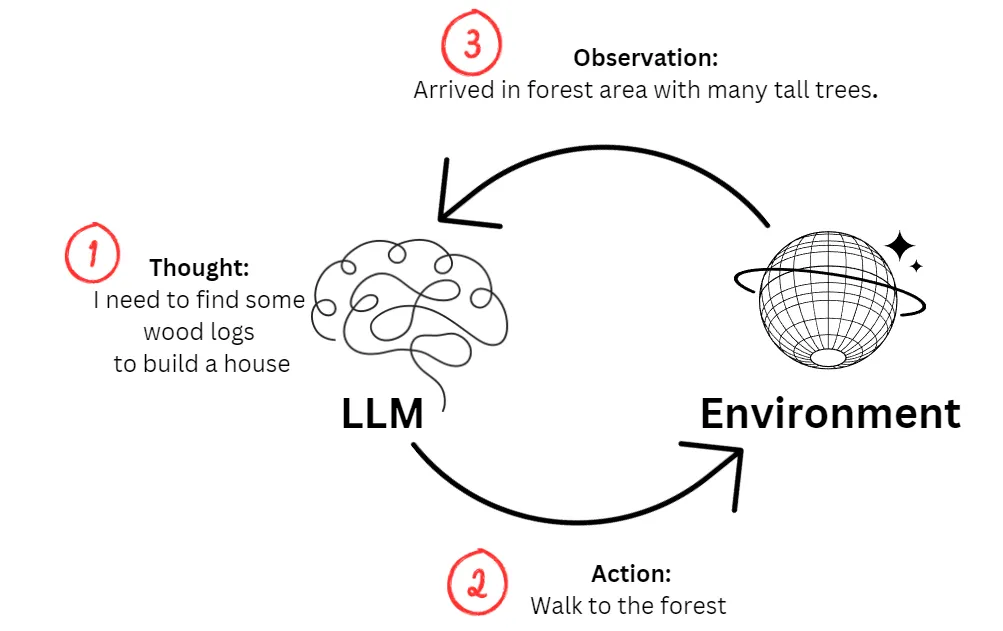

例えば、ReAct (Reason + Act) という手法を例にとりましょう。

この理論の本質は、「考えながら闇雲に動く」のではなく、

- まず思考を整理し(Reasoning)、

- その計画通りに実行し(Acting)、

- 得られた結果を観測し、次の思考の材料とする(Observation)

という、思考と行動の明確なサイクルを回す方が、結果的に効率的だという人間的な真理をAIに適用する、極めてシンプルなものです。

しかし、この「思考と行動のループ」という動的な本質が抜け落ち、「タスクを分解しましょう」というような曖昧で効果の薄いお作法だけが切り取られて、広まってしまいました。

アカデミズムの基本である、

- 「どのタイミングで(When)」

- 「どのドメインで(Where)」

- 「どの戦略を(How)」

- 「なぜ行使すべきか(Why)」

という体系を理解しようとせずに、対症療法のTIPSを覚えただけで、理解したと勘違いさせる安易な言説の蔓延こそが、この技術の本質的な価値を見えなくさせています。

AIという鏡を通じて、私たちが日常でいかに『言葉』を雑に扱ってきたかが、科学的に暴かれ始めたという現実を指して、「プロンプト・エンジニアリングが死んだ」という言説が、現在俎上に上がっているのです。

これは、言葉という最も身近な道具を蔑ろにした、私たちの「反省」のプロセスそのものです。

なぜ「10年の経験を持つPythonエンジニア」と書かねばならなかったのか?

この現実は、最も有名な「マジックワード」である役割設定(ロールプレイ)の本質を解き明かします。

あなたは〇〇の専門家です。

多くの人が思考停止で「あなたは〇〇の専門家です」と書いてきました。

しかし、熟練者ほど、これだけでは不十分だと直感し、無意識に具体性=コンテクストを付け加えていたはずです。

あなたは10年の経験を持つPythonエンジニアです。

FastAPIとUvicornを使った開発経験を元に回答してください。

この直感的な工夫には、科学的な裏付けがあります。

【有益な刃】:思考エンジンを起動する役割

-

どんな役割か?

「裁判官」「プログラマー」など、客観的に定義された思考プロセスを持つ専門職。 -

なぜ効くのか?

AIに「専門家」として振る舞うよう指示すると、自発的に物事を順序立てて考えるようになり(思考の連鎖)、複雑な問題の正答率が劇的に向上します(arXiv:2308.07702)。 - 結論:論理的な分析や専門知識が必要な場合に極めて有効。 「経験年数」や「使用技術」といった確からしいディテールを加えれば、さらに思考の焦点が絞られ、精度が高まります。

【無益な刃】:トーンを変えるだけの役割

-

どんな役割か?

「教師」「母親」など、専門性よりも一般的な人格や態度を示す役割。 -

なぜ効かないのか?

客観的なタスクの性能向上にはほとんど貢献しません(arXiv:2311.10054)。AIは丁寧な口調にはなりますが、賢くなるわけではないのです。 - 結論:答えの質を高める目的で使うべきではない。 不要なディテールは、むしろAIの思考を阻害するノイズになります。

【有害な刃】:思考を破壊する役割

-

どんな役割か?

人種、性別、宗教といった個人のアイデンティティに関わる役割。 -

なぜ危険なのか?

ネット上の歪んだ偏見(バイアス)をAIに増幅させ、推論性能を70%以上も低下させるなど、深刻な悪影響が確認されています(arXiv:2311.04892)。 - 結論:絶対に使用してはならない。 AIの論理性を破壊し、有害なステレオタイプを再生産する、極めて無責任な行為です

このテクニックの鍵は、その役割が、

- 「客観的に定義された思考プロセス」を持つか

- それとも「主観的なイメージ」に過ぎないか

という点にあります。

例えば、以下のような役割設定は、専門性を指示しているように見えて、実はAIの選択を助けるどころか混乱させる典型例です。

-

「プロの議事録係」

一見具体的ですが、「議事録」に求められる思考プロセスは文脈で全く異なります。社内会議では要点を抽出する編集的思考が、公式な国会答弁では一言一句を記録する記録的思考が求められます。AIはどちらのモードで動くべきか判断できず、中途半端な出力を生成します。 -

「凄腕のコンサルタント」「一流のビジネスマン」

「凄腕」や「一流」は主観的な評価であり、具体的な思考の軸をAIに与えられません。結果として、自信ありげな口調で中身のないビジネス用語を並べるだけに終わります。 -

「コミュニケーションの達人」

これも曖昧です。「コミュニケーション」の目的(説得、共感、情報伝達など)が不明瞭なため、AIはどの能力を発揮すべきか判断できません。

これらは全て、AIに「役割」という名の衣装を着せているだけで、その頭脳である思考エンジンを正しく起動できていない状態なのです。

結局のところ、私たちがロールプレイに期待すべきは、単なる口調の模倣ではありません。その役割が持つ論理的な思考のフレームワークをAIにインストールし、活用させることなのです。

AIはあなたの意図を「察しない」

ここまでの話で明らかなのは、人間同士の対話が膨大な「暗黙知」に支えられているのに対し、AIとの対話にはそれらが一切存在しないという事実です。

人間相手なら、こちらの意図を「察して」最適な提案をしてくれるかもしれません。

しかし、AIは「察する」意志を持たない純粋な情報処理機械です。

AIとの対話では、常に人間側が能動的に「察して」、必要な情報をすべて言語化して与える必要があります。

ここに、プロンプト・エンジニアリングが次のステージへ移行する必然性が生まれています。

2: 暗黙知の形式知化:コンテクスト・エンジニアリングの時代へ

「コンテクスト・エンジニアリング」という言葉は、2025年夏頃からアンドレイ・カルパシー氏(元テスラAI責任者、OpenAI創設メンバー)をはじめとする世界のトップランナー達によって提唱され始めた概念です。

The New Skill in AI is Not Prompting, It's Context Engineering

「プロンプト・エンジニアリング」よりも「コンテクスト・エンジニアリング」という言葉に賛成だ

コンテクスト・エンジニアリングこそが、次のステップのために、コンテキストウィンドウを「ちょうど良い情報」で満たすための、繊細なアートであり科学なのだ

その本質は、AIとの対話を「指示書(プロンプト)のやり取り」から、

「情報環境(コンテクスト)の設計」へと捉え直すことにあります。

| 観点 | 旧来のプロンプト・エンジニアリング | コンテクスト・エンジニアリング |

|---|---|---|

| 主たる対象 | 静的な「文字列(String)」 | 動的な「情報環境(System)」 |

| 目的 | 最適な「おまじない」の手動探索 | 期待する出力を得るための「文脈生成」の自動最適化 |

| アプローチ | 感覚、TIPS集 | 情報ロジスティクス、システム設計 |

このシフトの背景には、2つの巨大な技術変化があります。

- コンテキストウィンドウの爆発的増大

- RAG(外部DBからの動的情報検索)の一般化

もはや主戦場は、単一の「指示書」をどう工夫するかではありません。

タスク成功に必要な「最適な文脈」を、いかにシステムとして構築するか。その高度な設計技術へと完全に移行したのです。

「あれ、取って」がAIに通じない理由

人間同士の会話は、驚くほどコンテクストに依存しています。

食卓で家族に「あれ、取って」と言えば、視線の先にある醤油差しを指していることが瞬時に伝わるでしょう。ここには、

- 共有された物理空間(「食卓」という場)

- 過去の経験(いつも醤油を使うこと)

- 関係性(家族であること)

といった膨大な「暗黙の前提」が存在します。

AIとの対話は、この前提が一切ない状態から始まります。

AIにとって、私たちの要求は常に「文脈から切り離されたテキストデータ」に過ぎません。

AIがタスクを遂行できるよう、必要な情報環境そのものを設計し、言語化して提供すること。

これが「コンテクスト・エンジニアリング」の核心です。

コンテクストの構成要素:AIのための世界設定の「7つの道具」

優れたコンテクスト・エンジニアリングとは、単に長い指示を書くことではありません。

それは、AIの思考の「初期設定」をデザインする行為です。

以下の「7つの道具」を意図的に言語化し、構造化して提供することで、AIの思考をガイドします。

| 要素 | 説明 | 具体例 |

|---|---|---|

| 前提 (Premise) | 思考の土台となる、揺るぎない基本方針や共通認識。 | 「当社のブランドイメージは『信頼性』と『革新性』です」 |

| 状況 (Situation) | タスクが発生した直接的な背景や、現在置かれている具体的な状況。 | 「競合A社が値下げキャンペーンを開始し、市場シェアが奪われつつあります」 |

| 目的 (Purpose) | この対話を通じて、最終的に達成したい具体的なゴール。 | 「対抗キャンペーンの企画案を3つ、ブレインストーミングしたい」 |

| 動機 (Motive) | なぜその目的を達成したいのか、という根源的な理由や意図。 | 「短期的な売上回復だけでなく、顧客ロイヤルティを高めることが真の狙いです」 |

| 制約 (Constraint) | 遵守すべきルール、条件、限界。 | 「予算は500万円以内」「法務部のコンプライアンス指針に従うこと」 |

| 形式 (Format) | 期待するアウトプットの具体的な構造やスタイル。 | 「各案について、ターゲット・手法・期待効果を箇条書きでまとめてください」 |

| 参照 (Reference) | 思考のベースとして利用すべき情報源、データ、手本。 | 「添付の過去成功事例PDFを分析し、今回の企画に活かせる点を抽出してください」 |

これらの要素を組み合わせることで、私たちはAIに対して「醤油差しが置かれた食卓」という仮想の状況を構築し、タスクの成功確率を劇的に高めることができるのです。

これはもはや、AIをハックする「裏技」ではありません。

AIという「意志なき知性」と共に働くための、極めて論理的で再現性のある「協業のための設計技術」なのです。

RAG(情報) vs プロンプト(知の体系)

コンテクストを構成する二大要素、RAGとプロンプトの本質的な違いの理解も極めて重要です。

- RAGは「情報」を提供する。

- プロンプトは「物の見方の体系」を提供する。

プロンプトの真価は、LLMに「物の見方の体系(思考フレームワーク)」を設定することです。

この違いを、具体的なビジネス分析の例で考えてみましょう。

ある企業A社の経営状況を分析したいとします。

ケース①:RAGだけを与えた場合(大量の魚を渡すだけ)

RAGでA社の決算短信やニュース記事を大量に取得し、AIにこう指示します。

以下の資料を基に、A社の状況を要約してください。

[RAGによって取得された大量のテキストデータ...]

これでは、単なる「情報の羅列」しか得られず、意思決定には使えません。

ケース②:RAG + 優れたプロンプトを与えた場合(魚の調理法を教える)

同じ情報(RAG)を使いつつ、プロンプトで「思考の型」を指定します。

以下の資料を基に、**SWOT分析のフレームワークを用いて**、A社の状況を分析してください。

[RAGによって取得された大量のテキストデータ...]

この指示により、AIは単なる要約マシンから分析ツールへと変わります。

AIは「SWOT分析」というレンズを通して情報を取捨選択・分類し、「A社の強みは技術力だが、弱みはマーケティング力」といった構造化されたインサイトを生成します。

RAGが大量の魚を網で引き揚げてくるのに対し、

優れたプロンプトは、その魚を「刺し身」「焼き魚」「煮付け」に調理するための調理法をAIに与えるのです。

優れた「思考の型」がなければ、大量の情報も意味をなしません。

この課題は、もはやコンテクスト・エンジニアリングの枠を超え、AIの「思考プロセス」そのものを設計するという、次のステージへと我々を導きます。

3:AIの「思考プロセス」を設計する時代へ:コグニティブ・プロンプティング

コンテクスト・エンジニアリングがAIに必要な入力(Input)の工学だとすれば、

その先には、AIの推論プロセス(Process)そのものを工学的に扱う、新たな地平が広がっています。

それは、「何をしてほしいか(What)」から「どのように考えてほしいか(How)」へ、すなわちAIの思考プロセス自体を設計する時代の幕開けです。

コンテクスト・エンジニアリングの先にある地平

AIに「より良い考え方」を教えるための新しい設計手法が次々と生まれています。

ここではその代表的なアプローチを3つ紹介します。

1. 認知的プロンプティング (Cognitive Prompting)

-

― 人間の思考プロセスをAIにインストールする ―

- 考え方:人間が問題を解く思考プロセス(ゴール設定、問題分解、情報フィルタリング等)を、そのままAIへの指示(プロンプト)にする手法。人間の問題解決プロセスを模倣することで、LLMの思考をガイドします。(論文リンク)

悪い例 ✗:

この記事を要約してください。

これでは、AIがどの部分を重要と判断するかは運任せになってしまいます。

良い例 ✓(認知的プロンプティング):

目的:記事の要約

そのために、まず以下の思考プロセスを**順番に**実行してください。

1. **主張の特定:** この記事が最も伝えたい中心的な主張(結論)を一行で抜き出してください。

2. **根拠の分解:** 上記の主張を支えている主要な根拠を、重要だと思う順に3つリストアップしてください。

3. **統合と要約:** 最後に、ステップ1と2の結果だけを使って、全体を300字以内で要約してください。

【効果】

AIに行き当たりばったりの要約をさせるのではなく、「主張→根拠→統合」という編集者の思考フローを強制することで、アウトプットの質と一貫性を劇的に向上させます。

2. メタ認知プロンプティング (Metacognitive Prompting)

-

― AIに「自己反省」をさせて賢くする ―

- 考え方:AI自身に「自分の思考プロセスは適切か?」と自己評価させ、自己修正の機会を与えることで、より信頼性の高い推論を促すアプローチ。(解説リンク)

悪い例 ✗:

新しいエナジードリンクのマーケティングプランを考えてください。

これでは、現実離れした、あるいは考慮漏れの多いプランが出てくる可能性があります。

良い例 ✓(メタ認知プロンプティング):

まず、新しいエナジードリンクのマーケティングプランの**草案**を作成してください。

次に、その草案に対して、あなた自身が最も厳しい批評家になったつもりで、以下の3つの観点から**自己評価**をしてください。

- 前提に誤りはないか?

- ターゲット層に本当に響くか?

- 予算内で実行可能か?

最後に、その自己評価に基づいて草案を改善した**最終版**を提出してください。

【効果】

一度出した答えの弱点をAI自ら補強させる「自己反省ループ」をプロンプトに組み込むことで、より堅牢で現実的なアウトプットを引き出すことができます。

3. 体系的フレームワーク (Systematic Frameworks)

-

― プロンプトを「設計図」として構造化する ―

- 考え方:「役割」「目的」「制約」「例外処理」といった構成要素に従ってプロンプトを体系的に設計し、指示の曖昧さを排除して応答の安定性と再現性を高めるアプローチ。5Cフレームワーク(arXiv:2507.07045)などが知られています。

- 悪い例 ✗:

弊社の新サービスのブログ記事を書いて。ターゲットは若者で、親しみやすい感じでよろしく。

これでは、担当者によって解釈が大きく変わってしまい、品質が安定しません。

良い例 ✓(体系的フレームワーク):

以下のフレームワークに従って、ブログ記事を作成してください。

- **役割(Role):** 若者向けテックメディアのコンテンツライター

- **目的(Objective):** 新サービスXの認知度向上と、事前登録サイトへの誘導

- **ターゲット(Target):** 18歳から24歳の大学生、特にガジェット好き

- **制約(Constraint):** 専門用語は避ける。文字数は800字以内。

- **例外処理(Exception):** 競合他社の製品名は直接出さないこと。

- **出力形式(Format):** Markdown形式。記事の最後に必ず事前登録へのリンクを設置。

【効果】

誰がプロンプトを実行しても、常に同じ品質のアウトプットが期待できるようになります。指示の抜け漏れがなくなり、チームでのAI活用や、業務プロセスの自動化において絶大な効果を発揮します。

新たな力に伴う、新たな責任

この「思考を設計する」という力は、大きな可能性と共に、未知のリスクもはらんでいます。

それは、「良い思考のフレームワーク」と「悪い思考のクセ(認知バイアス)」が紙一重だという問題です。

研究(arXiv:2506.12338)では、人間の認知バイアス(例:「最初に見た情報に引っ張られる」)をプロンプトに含めると、AIの性能が著しく低下することが示されています。

我々が良かれと思って与える「考え方の指針」は、本当にAIの助けになっているのか? 知らず知らずのうちに、我々のバイアスを注入し、その能力を歪めていないか?

という、難しい問いに直面します。

思考を助ける「レンズ」と、推論を歪める「色眼鏡」。

その境界線は、まだ誰にも明確には引けていません。

4: 「対話の設計者」であるための基本原則

プロンプト・エンジニアリングは「おまじない」の時代を終え、人間の認知領域に踏み込む未知の分野へと進化しました。

この技術の普遍性こそが、逆説的にその習熟難易度を高めています。

この混沌とした時代を乗り切るため、全ての設計の土台となる3つの基本原則に立ち返りましょう。

原則①:最終的な責任は、常に人間にある

AIは責任主体にはなり得ません。

AIの出力によって生じるいかなる結果も、それを利用した人間の責任です。

人間が理解・判断できない事柄をAIに委ねることこそが、問題の根源です。

原則②:「ハルシネーション」を前提とし、検証可能な事実のみを扱う

ハルシネーションはAIの「特性」です。

AI活用の本質とは、客観的な「検証基準」を人間が精密に構築するプロセスそのものです。

AIを疑うのではなく、あなた自身を常に疑う姿勢が求められます。

原則③:手法(How)ではなく、原理(Why)と、文脈の一貫性を追求する

AIモデルは変化し続けるため、昨日有効だった手法(How)が明日には機能しなくなるかもしれません。

変化に振り回されないためには、原理(Why)を理解し、揺るぎない「自分の指針」を持つことが重要です。

次々と現れるテクニックに目を奪われがちですが、最終的に問われるのは、あなた自身の「思考を設計する力」です。

優れたプロンプターとは、変化の波を乗りこなす人物ではなく、

その波に惑わされず、対話の「目的」という錨を自らの意思で深く下ろせる人物です。

AIが社会に溶け込むにつれて、この「錨を下ろす力」は、もはや専門職の名称ではなくなります。

それは、誰もが自身の思考と行動に責任を持つために求められる、新しい時代の教養となるのです。