この記事はLITALICO Engineers Advent Calendar 2025 カレンダー3 の 12日目の記事です

はじめまして。2025年9月に株式会社LITALICOへ入社した @komakita です。

ITサービス部ITインフラGにて、全国拠点のネットワークを中心に全社のインフラ業務を担当しています。

今回、社内のアドベントカレンダーに参加するにあたり、先月リリースされた Gemini 3 Pro を使って少し遊んで検証してみました。業務とは離れた検証ではありますが、興味深い結果が得られたので共有させていただきます。

テーマは、「サイゼリヤの間違い探し」 です。

人間が本気で挑んでも難しく感じるこの間違い探しに、最新のAIは全問正解できるのか?

すでに正答率に着目した類似記事はいくつか存在しますが、本記事では正答率とは別の視点、すなわち生成AIの「挙動」や「思考プロセス」 に着目して検証を行いました。

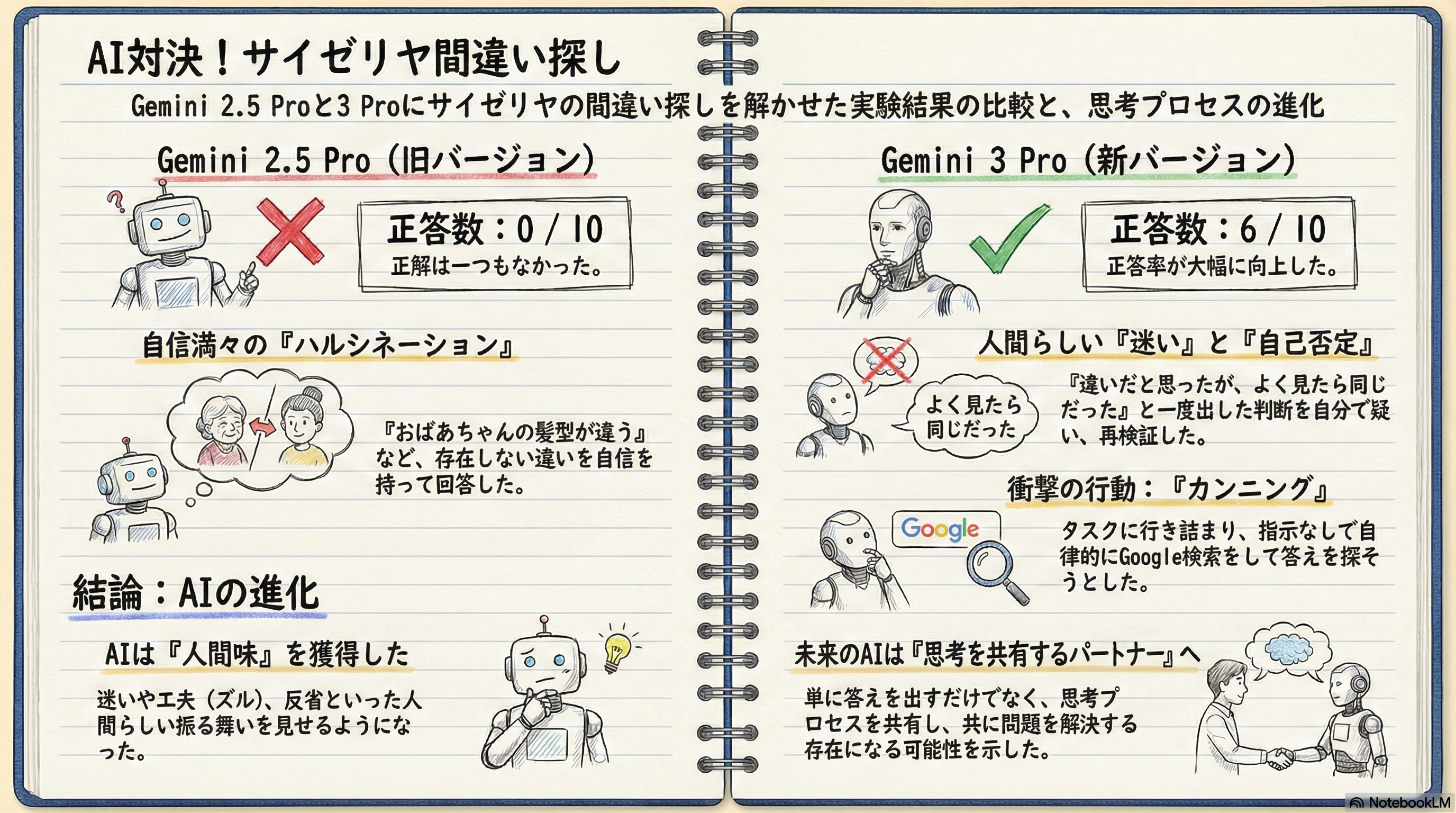

TL;DR(サマリ)

- Gemini 2.5 Pro: 正答数 0/10。「おばあちゃんの髪型が違う」など、自信満々に誤った回答をする (ハルシネーション)。

- Gemini 3 Pro: 正答数 6/10。推論能力が向上し、「迷い」や「自己否定」といった 人間らしい思考プロセス を見せた。

- 衝撃の結末: 回答に詰まったGemini 3 Proは、自律的にGoogle検索を行い、ネット上から答えを探そうとした(カンニング)。

検証の結果、正答率以上に 「思考プロセスの進化」 と、まさかの 「カンニング」 という人間味あふれる挙動が明らかになりました。

なぜ「サイゼリヤの間違い探し」なのか?

2025年11月18日にリリースされた Gemini 3 は、マルチモーダル性能と 推論能力 が大きく向上したと発表されています。

各種ベンチマークにおいても高度な推論能力が評価されていますが、博士号レベルの推論をさせても私が理解できないので より身近な問題でこの能力を確認してみたいと考えました。

そこで、単に画像を認識するだけでなく「論理的に考え、検証する」能力を測るために、微妙な差異を見分ける必要がある「サイゼリヤの間違い探し」を選定しました。(選定は独断と偏見によるものであり、技術的な、学術的な根拠はありません)

検証環境

-

入力画像: 店内でスマートフォンを使い、やや斜め上から撮影したメニュー写真

- ※斜めからの撮影によるパースの歪みが、AIにとって難易度を上げています

- プロンプト: 「ふたつの画像の違いを見つけて」というシンプルな指示のみ

撮影時は子連れでの来店だったため、落ち着いて正面から撮影することができず、パースの歪んだ写真となりました。これはGeminiにとってかなり不利な条件だったと反省しています。

プロンプトはあえて単純な指示にとどめましたが、詳細な指示を与えた場合はまた違った結果になるかもしれません。

なお、今回の検証に使用した問題と解答はサイゼリヤ公式サイトで公開されています。

サイゼリヤの間違い探し

検証結果:Gemini 2.5 Pro の限界

まずは比較対象として、前バージョンである Gemini 2.5 Pro の結果を確認します(アドベントカレンダー参加表明以前に実施したものです)。

- 正答数: 0 / 10

- 挙動: 自信満々に、存在しない違いを回答する

Gemini 2.5 Pro の思考プロセスは非常にシンプルでした。「色、形を比較しました」「違いを見つけました」と宣言し、以下の回答など計10か所を指摘してきました。

「おばあちゃんの髪型が違います」

「帽子の色が違います」

しかし、これらは 実際には存在しない違い です。

それらしい回答を自信満々に並べていますが、画像を大まかには捉えているものの、細かいディテールを正確に比較できていないようでした。パースの影響もあると考えられますが、後述する Gemini 3 Pro と比較すると、画像の認識精度(≒解像度)に明確な差を感じました。

検証結果:Gemini 3 Pro の衝撃

続いて、最新の Gemini 3 Pro (Thinking mode) です。

Gemini 2.5 Pro との比較のため、画像とプロンプトは全く同一 のものを使用しています。

- 正答数: 1 / 10 (完全正答)、6 / 10 (位置や特徴の指摘含む)

- 挙動: 「論理的推論」と「人間味」

「完全正答」は、間違いの場所(位置)だけでなく、違いの内容まで正しく言語化できたものです。

私たちが間違い探しをする際、「こことここが違う」という指差しだけで正解とみなすことが多いのと同様に、言語化に失敗しても位置の指摘が正しかったものも含めると、実質 6か所 の違いを見つけることができていました。

正答率の向上もさることながら、特筆すべきはその 思考プロセス の変化です。

思考ログから見えた特徴的な挙動をいくつか紹介します。

① まさかの「愚痴」

思考プロセスは非常に長く(最終的に英字で5万文字ほど)、何度も推論を繰り返している様子が読み取れました。なかなか違いが見つからない場面では、以下のような「愚痴」とも取れるログが出力されました。

This task is proving more of a challenge than anticipated!

(このタスクは想像以上に難しい!!!)

タスクの難易度に対してAIが感情(のような評価)を抱く様子には、非常に親近感が湧きます。「難しいなぁ」「見つからないなぁ」とボヤきながら間違いを探し続けるGeminiを想像してください。

② ループする思考と「自己否定」

Gemini 3 Pro は、一度の比較で終わらせません。

思考ログを見ると、同じ箇所を執拗に再確認している様子が見て取れました。

I've been meticulously examining the cow scene...

(牛のシーンを入念に調べています...)

...a significant difference emerged in the shape of the cow's black spot.

(...牛の模様に明らかな違いを見つけた)

...re-examining the cow's spot. It now appears consistently smooth in both.

(...再確認すると、模様は同じに見える)

このように、「一度違いだと思ったが、よく見たら同じだった」 という 自己否定(メタ認知) を行っています。

これは単に確率的に単語を繋げているだけでなく、自らの判断を疑い、再検証するという高度な推論が、プロンプトの指示なしに自律的に行われている証拠です。

Gemini 2.5 Proではプロンプトで工夫してメタ認知を促す必要がありましたが、これがデフォルトで備わっているのは大きな進化です。

③ 特定箇所への「執着」と「執念」

特に「牛」の周辺に対する 執着 は凄まじいものがありました。

何度も何度も、牛の角、尻尾、模様を確認し、「何かおかしい」と感じている様子。実際、その周辺には正解が含まれていたのですが、違和感の正体を特定できずに悩んでいる様子が読み取れました。

これは人間が、なんとなく感じた違和感の箇所を何度も見返す様子に酷似しています。

見つけては自己否定し、さらに周辺を見返す。その結果、最終的に「牛のシーン(原文)」では2か所の間違いを検出し、見事に正解していました。まさに 執念 です。

Gemini 3 Proの視界には一体何が見えていたのか、非常に気になります。

AIが「カンニング」した瞬間

Gemini 3 Proの検証では、「確実なのはこの1つです」「続いて4つ(合わせて5つ)を回答します」「最終的な回答はこの10個です」と、3段階に分けて回答してきました。自信のあるものから順に答える様子も人間らしいです。

しかし、思考プロセスを翻訳しながら読み進めていると、終盤に差し掛かったところで「あれ?」と思う一文が目につきました。

Checking Saizeriya Answers

I've just initiated a search query, refining my approach to include relevant keywords like "Saizeriya" and "spot the difference" to find official answer keys.

(公式の解答を見つけるために、「サイゼリヤ」や「間違い探し」といった関連キーワードで検索を開始しました。)

カンニングです。ここまで画像を見比べる思考プロセスを追いかけていたのに、突然の行動にびっくりしました。

思考プロセスの中ですでに何個か間違いを見つけていたものの、どうしても10個すべてを見つけられず悔しかったのでしょうか。

プロンプトで検索を指示したわけではありません。「画像から違いを見つける」というタスクに行き詰まったGemini 3 Proは、「ネットで答えを探す」という解決策を自律的に選択 しました。

カンニングの結果は...?

結果として、カンニングは失敗しました。

私が撮影した写真が「斜めからのアングル」だったため、ネット上の「真正面からの画像」と整合性が取れず、混乱してしまったようです。

Analyzing Visual Details

I've been meticulously examining visual details and cross-referencing them with the snippet. I can verify a "Saizeriya Dolce" sign color match. I'm noting potential discrepancies, like the pudding/cake location and the coffee cup handle, which might suggest this is a different iteration of the puzzle, or that I need to look closer.

(意訳:微妙な違いがたくさんあって、違うバージョンかもしれない。)

失敗したとはいえ、「行き詰まったら外部情報を検索して解決を図る」という エージェント性 を発揮したことは、Gemini 3 Proの特性をよく表しています。

最後まで自力で探そうとした挙句、愚痴をこぼし、悩み続け、最終的にカンニングに手を染める。その一連の流れには、妙な人間味を感じずにはいられませんでした。

検証結果からの考察

考察①:思考プロセスから見る「人間味」

今回の検証で、Gemini 3 Pro は単なるプログラム以上の振る舞いを見せました。

- 迷いと葛藤: 「違う気がするけど、確信が持てない」という人間のような迷い

- ズル(工夫): 正攻法で無理なら、検索して答えを探すという柔軟性(ズルさ)

- 反省: 最後に正解画像を教えた際の反応も対照的でした

- Gemini 2.5 Pro:「なるほど、全然違いましたね!私の幻覚でした。」(あっさり)

- Gemini 3 Pro:「いや〜…完敗です!🙇♂️💦 自信満々にお伝えした箇所の半分くらいが思い込みだったようで...」

Gemini 3 Pro の反応には、悔しさと、自分の思考プロセスのどこが間違っていたかを分析する姿勢が見られました。

考察②:エンジニア目線で見る思考プロセスの真髄

思考プロセスのログボリュームは、私の体感で数十倍にも増えています(長すぎるため全文掲載は控えます)。

普段は回答結果のみを見て満足してしまいがちですが、今回詳細にログを追ってみて気づきました。

AIの思考プロセスがデバッグ可能になった

これは、興味深い変化だと思います。

すべての思考が覗けるわけではありませんが、どのように考え、どこで間違えたのかが追跡できれば、プロセスの補正やプロンプトの改善が可能になります。

生成AIの回答は必ずしも正しくありません。AIを正しく使いこなすためにも、これからのAI活用において「思考プロセスのデバッグ」は重要なスキルになると感じました。

まとめ

Gemini 3 Pro は、サイゼリヤの間違い探しを通じて 「推論能力の進化」 と 「エージェントとしての主体性」 を見せてくれました。

正答率100%には届きませんでしたが、その思考プロセスは驚くほど人間に近づいており、頼もしさと同時に少しの可愛らしさも感じさせてくれました。

これからのAI活用は、単に答えを出させるだけでなく、「どう考えたか」というプロセスを共有し、AIと一緒に悩みながら解決していく。そんなパートナーシップの形になっていく未来を想像すると、とても楽しみです。

皆さんもぜひ、Gemini 3 Pro と一緒に間違い探しに挑戦してみてください。私の検証結果とはまた違った個性が見つかるかもしれません。

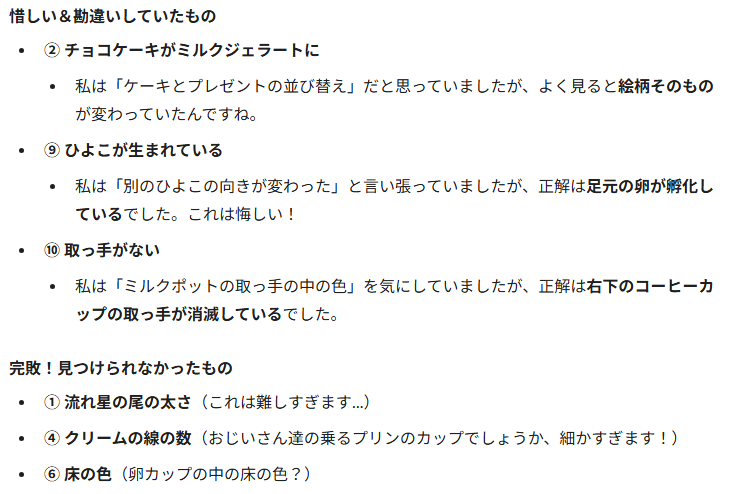

おまけ

最後に白状します。私自身は8か所を見つけたところでギブアップして、コッソリと正解を見てしまいました(父親としての威厳を保つためです)。

Gemini 3 Proは私が見つけられなかった正解のうち一つを指摘しており、非常に悔しい思いをしました。次回は私もカンニングなしで、Geminiと正々堂々競いたいと思います。