なぜtqdmを使うのか?それは便利だから!

- 深層学習における進捗状況や処理状況を表示させるときに便利

- 実行にかかるおおよその時間を知ることが出来る

流れ

- ライブラリのインポート

- tqdmを使ってみる

- プログレスバーに情報を加える

- 深層学習にtqdmを用いる

ライブラリのインポート

まずtqdmライブラリをインポートします.

from tqdm import tqdm

※ tqdmライブラリをインストールしていない場合は先にインストールします.

notebookの場合

jupyter notebookやGoogle colabの場合には,インポートするモジュールを少し変更します.

from tqdm.notebook import tqdm

tqdmを使ってみる

まずtqdmを使わずに以下のコードを実行してみる

epoch = 10000000

e_sum = 0

for e in range(epoch):

e_sum += e

print(e_sum)

# 以下は実行結果

e_sum:49999995000000

もちろんこのような結果になりますが,このままでは実行にかかった時間や処理の状況が分かりません.

(この程度の計算であれば数秒で終わることは明らかですが...)

そこでtqdmを使って実行時間と処理状況を見てみましょう.

tqdmを使った場合

epoch = 10000000

e_sum = 0

with tqdm(range(epoch)) as pbar_epoch:

for e in pbar_epoch:

e_sum += e

print(e_sum)

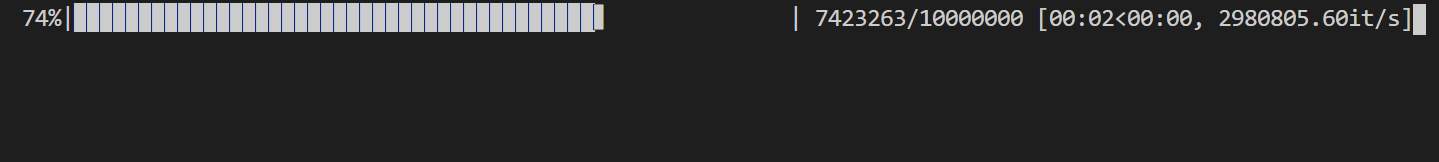

上のコードを実行してみると実行途中で以下のようなものが表示されます.

これは

"進捗率"|"プログレスバー"| "完了したイテレーション数"/"全体のイテレーション数" ["経過時刻"<"推定残り時刻", "イテレーション速度"]

を表しています.

プログレスバーに情報を加える

次にプログレスバーに情報を加える方法をまとめてみます.

情報を加える場所はプログレスバーの前と後ろの2つがあります.

プログレスバーの前に情報を加える

深層学習においては,例えば現在のepochの値などをプログレスバーの前に表示させたいです.

(表示させなくても完了したイテレーション数を見ることで確認することもできます)

プログレスバーの前に情報を加える場合はset_description()を用います.

では先ほど実行したものに現在のeの値という情報を加えてみます.

epoch = 10000000

e_sum = 0

with tqdm(range(epoch)) as pbar_epoch:

for e in pbar_epoch:

pbar_epoch.set_description("e: %d" % e)

e_sum += e

print(e_sum)

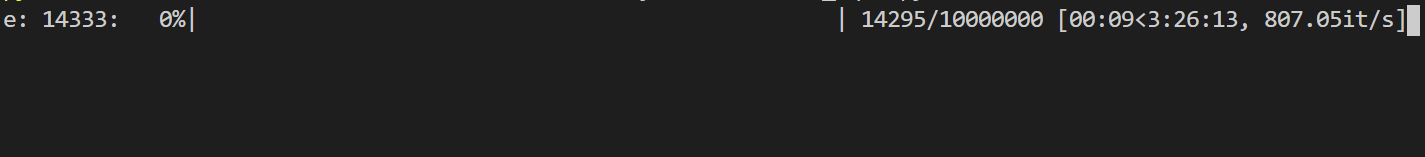

実行途中の結果は以下のようになります.

このようにプログレスバーの前に情報を加えることが出来ます.

ここで気づいたのですが,加えたい情報はeの値だったのですがeの値はあまりにも速く変わり,表示するのに時間がかかるせいなのか実行時間が増えてしまいました.

ただし,tqdmを使用するモチベーションはあくまで深層学習にあり,epochが上の例のような速さで切り替わることはあまり考えられませんし,ましてやepoch数を1000000と取るようなことはないと思うのでtqdmを深層学習に用いる場合においては情報を加えることで実行時間が増えてしまうといった心配は必要ありません.

プログレスバーの後ろに情報を加える

深層学習においては,損失関数の値や精度などをプログレスバーの後ろに表示させたいです.

プログレスバーの後ろに情報を加えたい場合はset_postfix()を用います.

しかしここで注意しなければならないことは,OrderedDict()を使用しないと表示される順番が変わってしまう可能性があるということです.

from collections import OrderedDict

epoch = 10000

e_sum = 0

with tqdm(range(epoch)) as pbar_epoch:

for e in pbar_epoch:

#pbar_epoch.set_description("e: %d" % e)

e_sum += e

pbar_epoch.set_postfix(OrderedDict(loss=e/10000,

acc=e/1000))

print(e_sum)

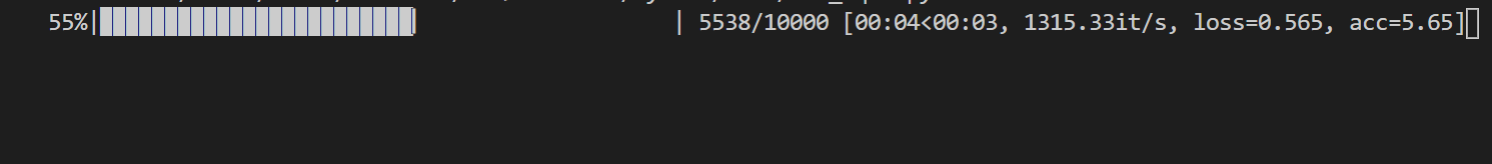

実行途中の結果は以下のようになります.

このようにして,プログレスバーの後ろに情報を加えることが出来ました.

深層学習にtqdmを用いる

では実際に深層学習にtqdmを使ってみたいと思います.

深層学習の流れとして以下のようなよくある流れについて考えます.

# loadersはpytorchのDataloader()を用いデータセットを取得したとする

epoch = 20

for e in range(epoch):

for i, (data, label) in enumerate(loaders):

#出力 = net(data)

#誤差 = 誤差関数(出力, label)

#精度 = ...

#以下省略

上のコードはloadersに格納されているバッチサイズだけ取り出し学習を行うという反復(データセット数/バッチサイズ回)を繰り返し,さらにその処理をepoch(20回)繰り返すといった流れです.

ここにtqdmを使ってみます.

まずはバッチサイズだけ取り出す処理の反復に対しtqdmを用います.

epoch = 20

for e in range(epoch):

with tqdm(enumerate(loaders),

total=len(loaders)) as pbar_loss:

for i, (data, target) in pbar_loss:

#以下省略

以上のようなコードにすることでtqdmを使うことが出来ます.

注意しなくてはならないのはtqdmの引数にtotal=len(loaders)といれなければいけません.

tqdmはデフォルトで自動的にイテレーション回数をlen()を用いて計算してくれるのですが,enumerateにlen()は使用することが出来ないのでtotal=len(loaders)とすることでイテレーション回数を与えます.

以下が実行結果です.

ちなみに今回はデータ数を5000,バッチサイズを100としているので全体のイテレーション数は50となります.

これで1epochごとの処理状況を見ることが出来るようになりました.

しかし,このままだとepoch全体での処理の状況がつかめません.

そこでepoch回繰り返す処理にもtqdmを用いてみます.

以下がそのコードです.

with tqdm(range(epoch)) as pbar_epoch:

for e in pbar_epoch:

pbar_epoch.set_description("[Epoch %d]" % (e))

with tqdm(enumerate(loaders),

total=len(loaders)) as pbar_loss:

for i, (data, target) in pbar_loss:

#以下省略

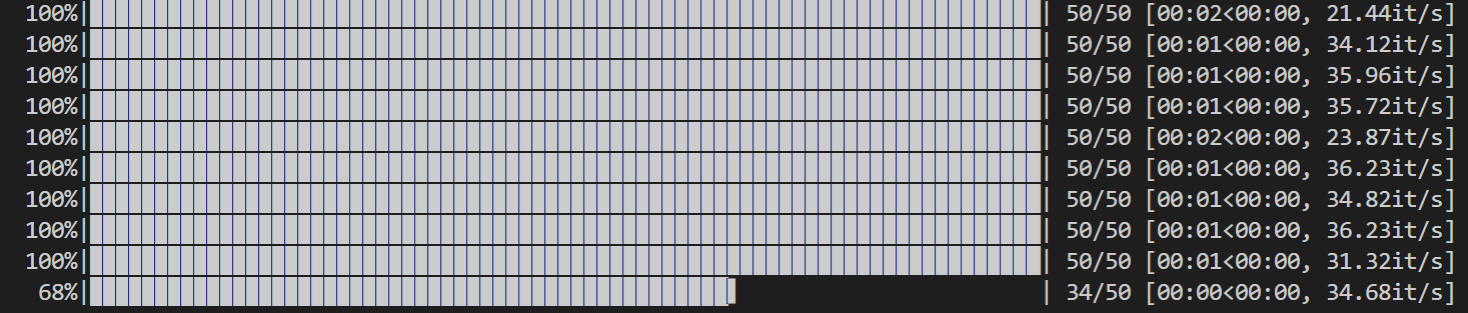

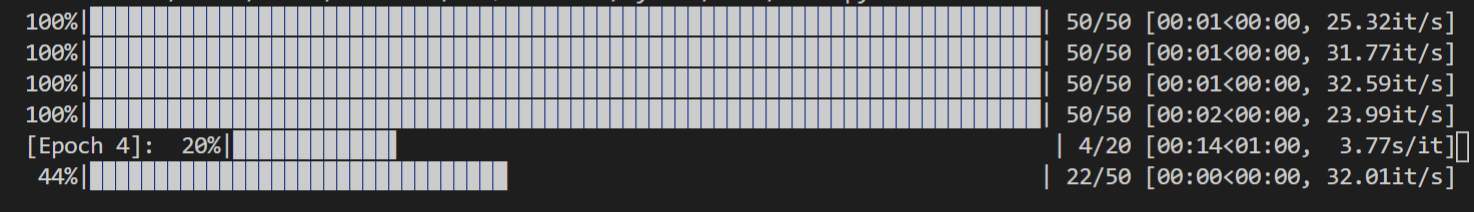

以下が実行結果になります.

これで全体の処理状況をつかむことが出来ました.

しかしepochごとのプログレスバーが残ったままなので見やすさに欠けます.

そこでプログレスバーを残さないようにします.

tqdmの引数にleave=Falseといれることでプログレスバーが残らないようになります.

以下にコードと実行結果の画像を載せます.

with tqdm(range(epoch)) as pbar_epoch:

for e in pbar_epoch:

pbar_epoch.set_description("[Epoch %d]" % (e))

with tqdm(enumerate(loaders),

total=len(loaders),

leave=False) as pbar_loss:

for i, (data, target) in pbar_loss:

#以下省略