はじめに

今回、AWS公式のAmazon Forecast ハンズオンをやってみました。せっかくなので記事にしたいと思います。ハンズオンとしては、過去の家庭の電⼒使⽤量のサンプルデータから学習を行い、その後の使⽤量を予測するモデルをAmazon Forecastを使って構築する内容になっています。

それではやっていきましょう!

データの準備

最初に、Forecastにデータを渡すための準備をします。

やることは簡単で、S3を作成してそこにcsvファイルをアップロードするだけです。

今回はハンズオンで用意されているサンプルを使用しています。

データのインポート

ここからが本番です。

最初にデータセットグループを作成します。このデータセットグループはデータセットや学習結果、予測などを入れていく箱のようなひとまとまりの事です。

- データセットグループの名前

- Forecastのドメイン

以上の2点を設定します。

ドメインとはデータのスキーマを指定するもので、売り上げ予想用のドメインやEC2の容量を予測するためのドメインが用意されています。詳しくは公式ドキュメントを参照ください。今回のハンズオンでは、用意されているドメインに当てはまるものが無いのでCustomを選択しています。

次にデータセットを作っていきます。最初のブロックでは

- データセット名

- データの時系列間隔

- データスキーマ

以上3点を設定します。

Frequent of your dataには、学習に使用するデータの時系列情報の間隔を指定します。今回のサンプルでは1時間ごとの電力使用量を扱っているので、1 hourを指定しています。

Data schimaはデータのスキーマを指定するもので、Schema builderを指定し、学習に使用するサンプルデータと同じ順序になるように設定します。ハンズオン資料の当時はJSONで指定する方法しかなかったようですが、今はGUIでも設定できるのは小さな幸せですね。

次のブロックでインポートするデータの設定をします。

- インポートデータ名

- タイムゾーン

- インポートするデータのファイル形式

- データの場所

- IAMロール

以上の5点を設定します。

名前は他のインポートデータと区別できるようにしておきます。

データの場所としては、先ほど作成しアップロードしたサンプルデータのS3のパスを指定します。

また、IAMロールは自動的に必要な権限だけを持ったロールを作成してくれます。作成されるロールにアタッチされているポリシーはS3に関する権限だけを持っています。別で用意したIAMロールを使用する場合はそちらを指定します。最後に削除するので、ロール名を覚えておきます。

作成されるポリシー※参考

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": [

"s3:GetObject",

"s3:PutObject",

"s3:DeleteObject",

"s3:ListBucket"

],

"Resource": [

"arn:aws:s3:::*"

]

}

]

}

この状態でStartを押すとデータセットグループが作られ、データセットにデータのインポートが始まります。Import your dataがActiveに変わり、Train a predictorのStartに色が付いたら完了です。

↓↓↓↓

データを学習

続いてデータをForecastに学習させて、予測子(Predictor)というものを作成します。

- 予測子名

- データの時系列間隔

- どのくらい先を予測させるのか

以上のオプションを除いた3点を設定します。

Forecast Frequencyはデータセットを作成した時に、Frequent of your dataで設定した値と揃えます。今回は1hourにしています。

Forecast horizonがどれくらい先を予測させるのかを指定する値で、今回は36として、36時間分の予測をしてもらいます。

Forecast dimensionsはFrequencyがdayより間隔が広い場合に設定でき、開始点を指定できます。例えばFrequencyがdayでdimensionsの値を10にした場合、午前10時から翌日の9:59までが1日分としてデータが管理されます。今回はデータが時間単位のため特に指定しません。

Forecast quantilesは分位数の設定です。分位数とは統計解析において、データの相対的位置をみるのに用いる数値のことで、データを4分割している場合は4分位数と呼ぶそうです。今回はデフォルトの値で設定します。

トレーニングを開始したら、左メニューにPredictorの項目があるので、選択すると対象データセットグループのPredictor一覧が表示されます。ここのステータスがAvtiveになれば完了です。ここは時間がかかるため休憩したり、ここまでのまとめ等ができます。

↓↓↓↓

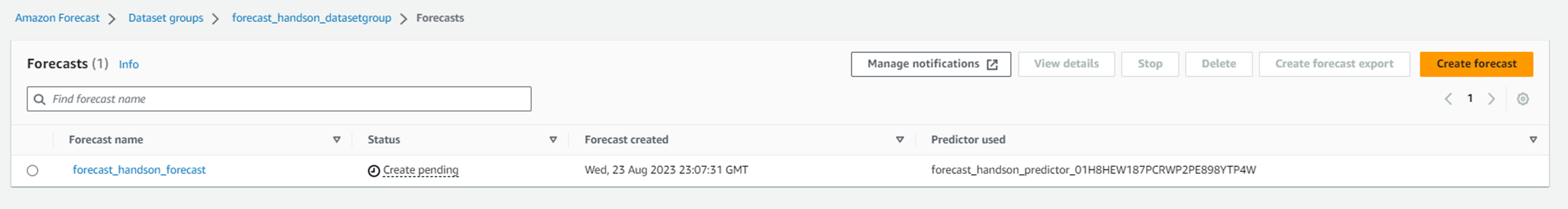

予測の作成

トレーニングが完了したら、Forecastが作成できるようになるので、Forecast generationのStartから作成します。

- Forecast名

- 使用する予測子(Predictor)

- 学習データのうち、どのアイテムの予測を作成するか

以上のオプションを除いた3点を設定します。

Predictorは先ほど作成したものを指定します。

Forecast quantilesはオプションで、分位数を指定する項目で、今回はデフォルトのため特に設定しません。

Items for generating forecastsは、今回扱うデータのアイテムが電力使用量の1つのためAll Itemsを選択します。

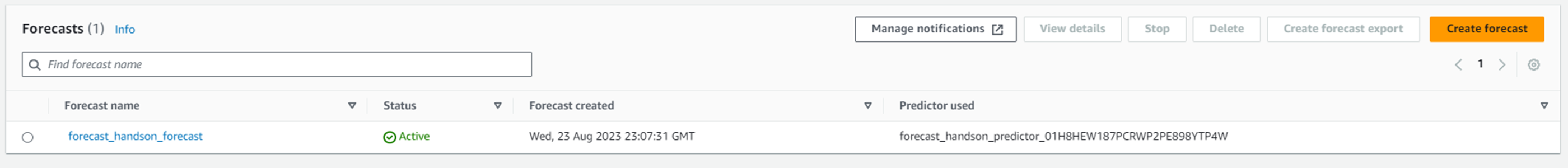

左メニューにForecastの項目ができるので、選択すると対象データセットグループのForecastの一覧が表示されます。ここのステータスがAvtiveになれば完了です。

↓↓↓↓

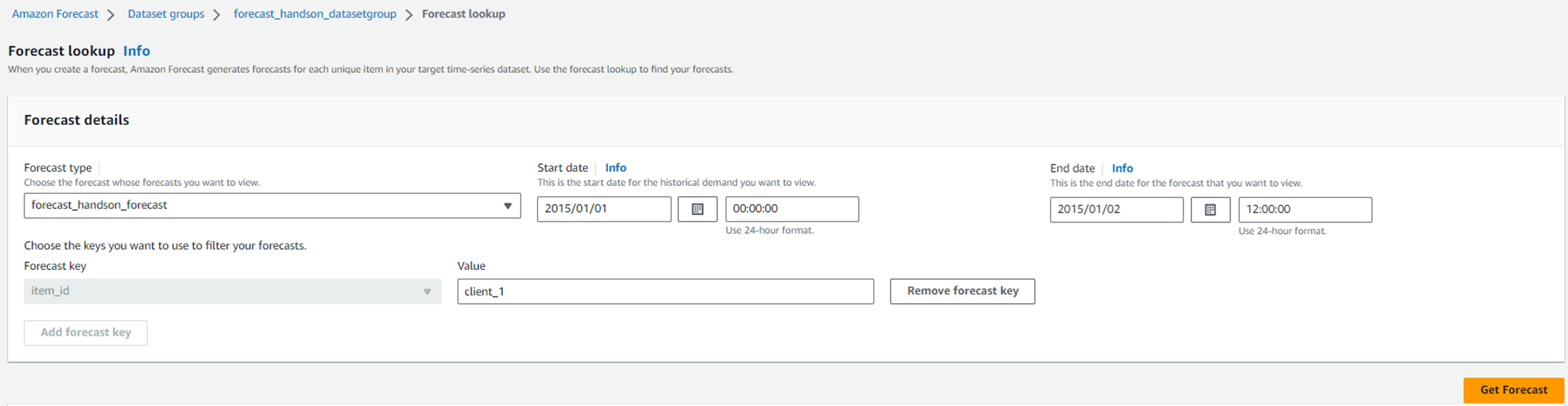

予測の確認

Forecastの作成が完了したらダッシュボードのForecastの枠にQuery forecastが表示されます。

予測を確認していきます。

- どのForecastを使うか

- 開始時間

- 終了時間

- 確認するアイテムのIDの値

対象のForecastは先ほど作ったものを指定します。

開始時間はサンプルデータの末尾の時間を指定し、終了時間はForecast作成時にForecast horizonに設定した値だけ後ろの時間に設定します。今回のサンプルデータは2015年の1/1 0:00までのため、開始時間は2015年1/1 0:00、終了時間はForecast horizonに36と設定したので、36時間後の2015年1/2 12:00とします。

Forecast keyのValueには、画像の通りサンプルデータではclient_1~client_10まであるので、client_1を指定します。

全部記載したのがこちら↓です。

Get Forecastを押すと予測結果が画面下部に表示されます。

P50が示す値は、50%の確率でこの値を下回ることを表しています。

P10が示す値は、10%の確率でこの値を下回ることを表しているので、最低でもこれくらいの値を取りうることを表しています。需要予測の場合は、在庫を抱えずにすべて売り切れる個数のイメージです。

逆にP90が示す値は、90%の確率でこの値を下回ることを表しているので、最高でもこれくらいの値に収まることを表しています。需要予測の場合は、欠品させたくない商品はこの値に合わせて発注するイメージです。

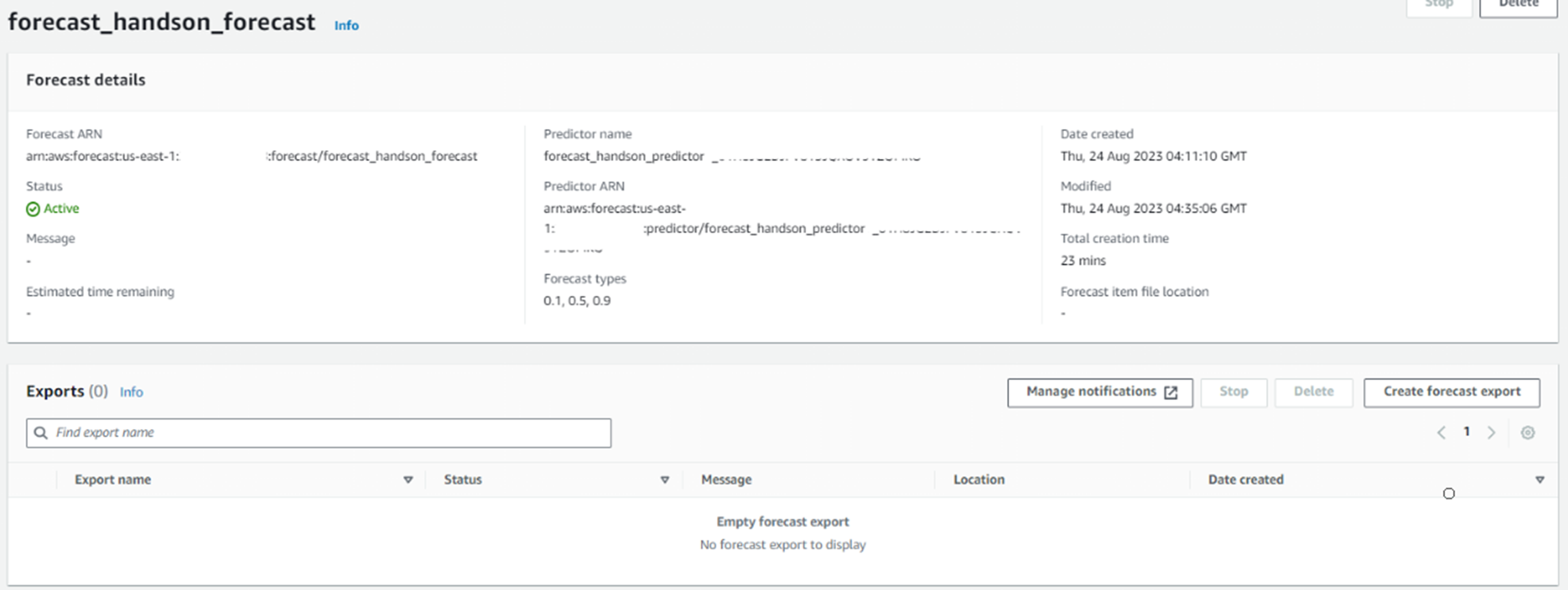

予測のエクスポート

左メニューにForecastの項目から作成したForecastを開き、Create forecast exportボタンからエクスポートします。

- エクスポート名

- IAMロール

- 暗号化キー

- ファイル形式

- エクスポート先

以上を設定します。

IAMロールは先ほどデータセットを作成した時と同じものを指定します。

暗号化キーはオプションで、エクスポート時に使用する暗号化キーを指定します。暗号化しない場合は設定しなくても大丈夫です。

ファイル形式はインポート時と同じですが、CSV or PARQUETを選ぶことができます。

エクスポート先にはS3のURIを設定します。※スクショは入力前のものです。

設定が終わったら下部のCreate forecast exportを押します。

指定したS3バケットにエクスポートされているのが確認できれば完了です。

環境掃除

最後に環境掃除をします。

左メニューからForecast → Predictor → Dataset → Datasetgroupの順に選び削除します。

S3のページに移動し、インポート用のサンプルデータやエクスポートした予測を削除し、バケットも削除します。

IAMロールは忘れやすいので注意です。

終わりに

今回、初めてAWSの機械学習系サービスを触ってみました。コードも特に必要なく、コンソールだけで完結しているため機械学習の知識が無くても予測まで作れてしまいました。一方で、よくわからず予測まで作れてしまった感もあります。

扱うデータや各パラメータの調整、その予測から何を見出すのかなど使いこなせたらカッコいいなと思いました。

Amazon Forecastは、EC2の容量や販売個数、株価などなど時系列情報を持ったデータであれば、予測が作成できますので、興味がある方は是非触ってみてもらえたら、そのきっかけがこの記事だと嬉しいです。

p.s.面白かったし他の機械学習系のサービスを触ってみようかな

その勢いでAWS MLSも取得したい!な、と。