はじめに

KLab機械学習グループの濱田です.KLabアドベントカレンダー2021 22日目のこの記事では,トップAI会議で使われる査読割当てシステムToronto Paper Matching System (TPMS)の仕組みを解説します.加えて,TPMSを使う会議で適切な査読者に論文が割り当てられやすくなるような論文の書き方について,私の考えを紹介します.

この記事の第一の対象読者は,基本的な研究のやり方と英語論文の書き方は習得したけれど,なかなかトップAI会議に通らず悩んでいる投稿経験3~10回程度の方です.研究内容は良いはずだし,文章も十分に磨いたはずなのに,それでもなぜか査読者と分かり合えず苦労しているならば,この記事は役に立つと思います.

第二の対象読者は,後進を指導するベテランの方です.トップAI会議に何本も採択されているベテランの方は,すでにTPMS論文を読んでいたり,TPMSを使う会議で論文が採択されやすくなる「作文のコツ」を経験を通して身に着けていると思います.しかしその経験を他人に伝えるのは案外難しいものです.そんなときにTPMSの仕組みから根拠づけてノウハウを説明すると受け入れてもらいやすくなるかもしれません.実際,この文章は私自身がトップAI会議向けの論文執筆のノウハウを言語化し,その効果を客観的・定量的にチームメンバーに伝えるために書いています.

TL; DR

TPMSの攻略情報だけ知りたい人は,適切な査読者とマッチするには?をご覧ください.

さらに時間がない人は,👇だけ覚えて帰ってください.よいクリスマスを!

- ペルソナ分析しよう:投稿先会議に論文が何本も採択されているシニア研究者の中から,自分と近い問題や技術を扱っている人を探し出します.そのうち,価値観の近そうな人を想定査読者,価値観が異なる人を非想定査読者に設定します.

- ターゲティングしよう:想定査読者が最近出版した論文で使われている特徴的な単語を自分の論文にも含めます.同義語・類義語の使い分けは想定査読者に合わせます.非想定査読者が使っている単語は避けます.

- 導線設計しよう:想定査読者がBiddingしたくなるタイトルをつけます.アブストラクトは対象領域における代表的研究との差分と利点がわかるように書きます.イントロには貢献を査読採点項目と一対一対応する形で書きます.図表は登場順に眺めるだけで貢献内容が伝わるように作って配置します.

上記の内容から「あぁ…検索エンジン最適化(SEO)ならぬ TPMS最適化(TPMSO) をするんだな…」となんとなく想像できると思います.これらを意識して論文の文言を微調整するだけでも,査読ガチャで爆死する確率はかなり減ると思います.さらに,この記事をすべて読んでTPMSを✟完全理解✟することで,好意的な査読者とマッチする優しい世界が訪れることでしょう.それでは,長文ですがお付き合いください!

背景

TPMSはNIPS2010で初めて導入され,そのソースコードや解説論文は2013年には公開されています.それにもかかわらず,なぜ2021年の今になってTPMSを理解する必要が出てきたのかを説明します.

投稿数の爆発的増加

下図は近年のAI系国際会議の採択率(左図)と投稿数(右図)の推移を示しています.

図出典:lixin4ever/Conference-Acceptance-Rate: Acceptance rates for the major AI conferences

投稿数はほとんどの会議で2016年頃から急増しています.なかでも,もともと投稿数が1000件を超えていた大規模会議での増加ペースが著しく,前年比+30~80%の勢いで増え続けています.AIブーム以降の新規参入者によって,一部の人気会議への一極集中が起こっていることが読み取れます.本記事では便宜上,2020年の投稿数が2014年の2倍以上になったAI系国際会議を総称してトップAI会議とよぶことにします.

対して,採択率は若干の減少傾向にあるものの,投稿数ほどの変化はありません.これは,トップAI会議の規模が投稿数にほぼ比例して指数関数的にスケールしたことを意味しています.しかし,会議規模の急速な拡大は,論文の査読プロセスに様々な弊害をもたらしました.以下の記事は近年のトップAI会議の査読プロセスが抱えるいくつかの課題を指摘しています.

Some Issues in the Review Process of Machine Learning Conferences

And what we can do to solve them

査読が運ゲーに

近年のトップAI会議の査読プロセスが抱える問題の中でも,論文投稿者にとって死活問題なのが査読者のミスマッチです.適切な査読者が割り当てられないと,ちょっと驚くような査読が返ってきます.そうなったら最後,どんなに懸命に査読回答をしても挽回できません.恥ずかしながら,私自身のAAAI-22の例を紹介しましょう.

査読ガチャ負けた時点でこうなるとは思ってたけど,アブスト1文目でフィッティング手法だと書いてるのに査読者4人中2人が「最適化手法と比較せよ」と言ってきて「提案手法はフィッティング手法なので最適化手法とは比較しようがない」と返したらさらに評価下げられるのTOP AI CONFERENCEしぐさがすごい

— はま (@hmkz_) December 2, 2021

世界よ,これがトップAI会議だ.ミスマッチが起きた時点でほぼ負け確なのです.近年のトップAI会議における査読者割り当てが査読ガチャとよばれる由縁です.

なぜこんなことになるのかと言えば,単純にキャパオーバーです.AAAI-22では,査読者全員がボーダー以上の判定をした論文がRejectされて話題になりました.このスレッドを辿れば同様の人達が何人も声を上げています.決して稀なケースではないことが分かると思います.

近年のトップAI会議は,査読者が全会一致で推薦する論文さえもが取りこぼされていくほどの過当競争にあります.一度でも悪い評価がついた論文は,たとえそれが査読者の誤りによるものだとしても,救済している余裕はありません.いい査読者を引き当て,無傷で切り抜けないかぎり採択は望めない時代になっています.Our @RealAAAI'22 *rejected* paper:

— Miltos Allamanis 🇪🇺 (@miltos1) December 1, 2021

R1-Accept

R2-Weak Accept

R3-Borderline Accept

R4-Accept

Meta Review-"The reviewers all agree that this paper is above the acceptance bar. This paper has very interesting idea, proposes solid model, with thorough experiments and analysis."

(1/2) https://t.co/UyDyKikhEV

査読システムをハックすることの是非について

これからTPMSOのやり方を解説していくわけですが,論文の中身とは無関係な作業にエフォートを割くことに反感を覚える方もいると思います.こういった知識が流通することで,本質をないがしろにした競争に拍車がかかるのではないかと心配する方もいるでしょう.

私としても,中身のある論文を書くことが第一だと信じています.そのうえで,不運な不採択を減らすためにTPMSOをする,という使い方をお勧めします.適切なマッチングが行われるようになり,限りある査読リソースが有効活用されるようになることは,業界全体にとってもメリットなはずです.

良い論文を書くための方法は今でも変わりません.以下の2つの記事にはそのエッセンスが詰まっていますので,未読の方はぜひ読んでみてください.これらを実践してみて,それでも採択に届かないときの「最後の一歩」を本記事では後押しするつもりです.

典型的な査読プロセス

TPMSの仕組みを解説する前に,査読プロセス全体を理解しておきましょう.論文が不採択となる要因は様々です.査読プロセス全体を通してどこにどんな要因があるのかを俯瞰し,正しく原因を突き止めてボトルネックを解消することが採択率向上につながります.

ICLRはWebサイトで査読プロセスを公開しているため,それを紹介します.多くのAI会議は多少の違いはありますが,大枠としては似たようなプロセスになります.

図出典:https://iclr.cc/Conferences/2021/ReviewerGuide#review%20process

論文の採否は以下の3階層を経て判断されます(規模の大きい会議では4階層になることもあります).

- Program Chair (PC): 会議全体のまとめ役.Area Chairに論文を割り当てる.分野間を調整し,論文の最終的な採否判断をする.

- Area Chair (AC): 会議の1分野のまとめ役.Reviewerに論文を割り当てる.Reviewerの査読結果を総括して論文の採否をPCに推薦する.

- Reviewer: 論文の査読者.個々の論文を読んで評価し,査読コメントを書く.

査読者の割り当ては,大きく言って以下の4要因で決まります.

- Area selection: 分野選択.論文投稿者が選ぶこともあれば(大会議に多い),ACが選ぶこともある(ICLRは後者).

- Expertise-paper matching: 専門性と論文のマッチング.投稿論文と近い専門性をもつ査読者をマッチングする.主にここでTPMSが使われる.

- Bidding: 入札.査読者が読みたい論文を指名する.

- Conflict of Interest: 利益相反.投稿者と査読者が同じ職場だったり,資金提供関係があったりしないように除外リストを指定する.

まず何よりもArea selectionが重要です.多くの会議では,分野ごとに査読者が分かれています.そのため分野選択を誤るとミスマッチはほぼ避けられません.投稿者自身で分野を選ぶ会議では,1つのprimary subjectと最大5つ程度のsecondary subjectを選択できるはずです.多くの研究には研究対象(例:音楽を)と方法論(例:Transformerで生成する)という2つのsubjectがあると思いますが,primary subjectは研究対象にしたがって決めたほうが,興味をもって読んでくれる査読者に当たりやすいです.secondary subjectは関連のある分野をすべて選ぶのではなく,方法論を理解するために必要な最小限の予備知識にしたがって選ぶことをお勧めします.採択論文には著者が選択したsubjectが記載されていますので,過去3年ほどの論文を見て,自分と似た研究が何を選択しているかを参考にしてください.

次に重要なのがExpertise-paper matchingで,Biddingは3番目です.ほとんどの会議ではTPMSスコアでソートされた論文リストが査読者に提示され,Biddingが行われるためです.ほとんどの査読者はリストの上位から順番にbidしてゆき,50位以下はそもそも検討しません.Biddingは「ぜひ読みたい」「査読者が足りなければ読む」「読みたくない」といった3~4段階評価であることが多いです.査読者が高評価した論文が実際に割り当てられるとは限りませんが,もし高評価した論文が実際に割り当てられれば高い関心をもって読んでもらえますので,できるだけ多くの査読者にbidしてもらえることは重要です.なお,TPMSスコアは同点となることが多く,同点の論文はPaper ID順にソートされます.なので,Submissionがオープンしたらすぐに空の投稿をして,できるだけ若いPaper IDを取得しましょう.

Conflict of Interestは工夫の余地がありません.正直に申告しましょう.

Toronto Paper Matching System

ここから本題に入っていきます.論文と査読者のマッチングシステムToronto Paper Matching System (TPMS)はオープンソースソフトウェアです.そのマッチングアルゴリズムを解説した論文が出版されています.以下のサイトからソースコードと論文が入手できます.

The Toronto Paper Matching System: An automated paper-reviewer assignment system

論文著者らは,TPMSの最初のバージョンをNIPS2010のために作りました.その後改良され,2012年にマイクロソフトのConference Management Toolkit (CMT)に統合されました.それ以来,機械学習とコンピュータビジョンのコミュニティの主要な会議で広く採用されています1.この論文はシステムの概要,学習モデルと評価方法の概要,最近の進展と未解決な課題について述べています.

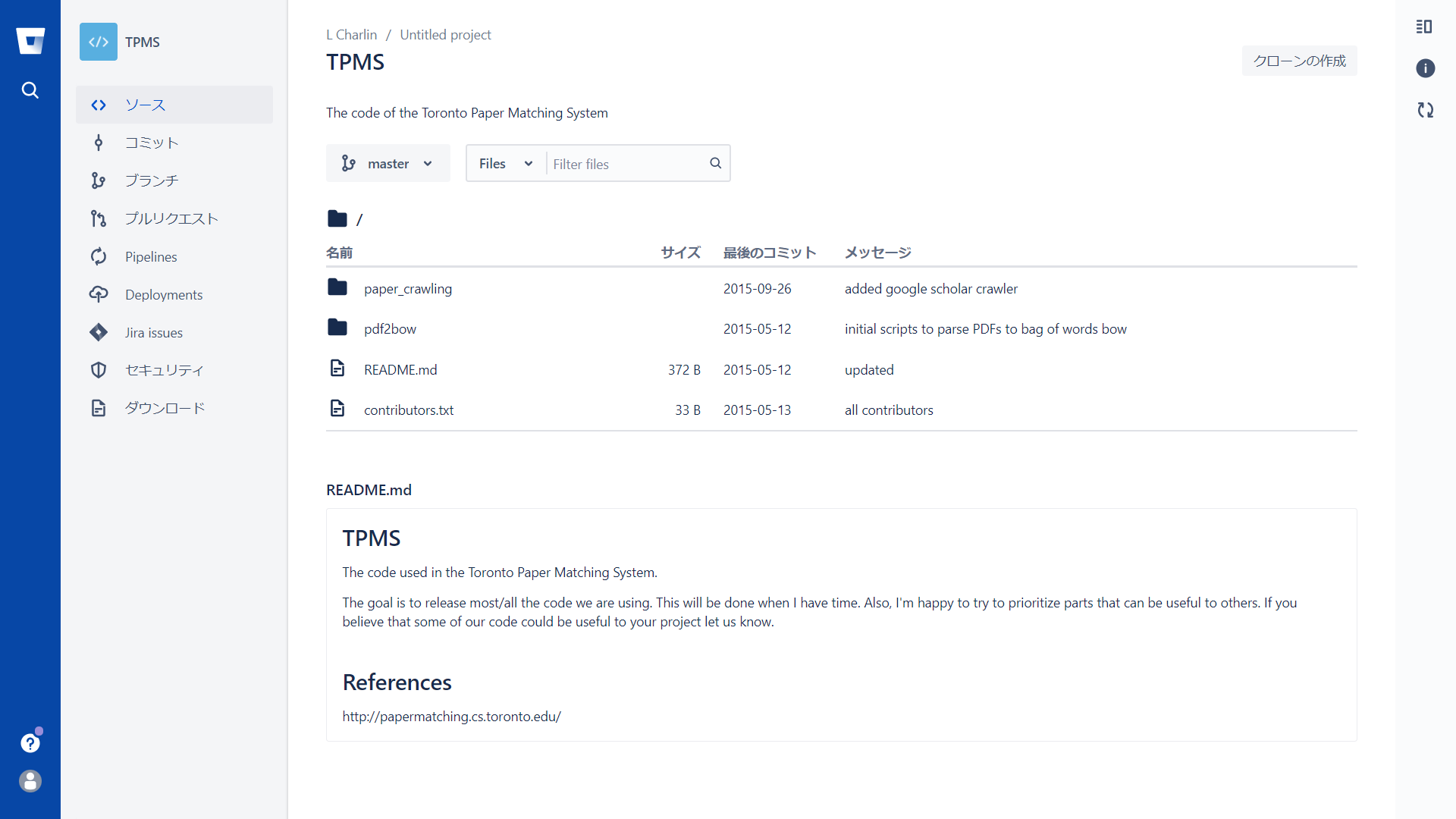

以下,この論文を参照しつつ,TPMSが論文と査読者をどのようにマッチングしているかを解説します.なお,この論文はICML2013に採録されたものです.出版からすでに8年が経過していますので,TPMSは論文出版当時とは変わっている可能性があります.とはいえ,下図(2021年12月22日撮影)のようにリポジトリの更新は2015年9月26日で止まっています.仮にこのリポジトリの内容が今のCMTで使われているものならば,論文版と現行版に大きな差分はないのではないかと思います.

図1: TPMSのソースコードリポジトリ(2021年12月22日)

1. はじめに

査読プロセスでは,千本以上の論文を数百人の査読者からなるプールに含まれる査読者に割り当てます.論文のトピックと査読者の専門性のマッチングします.様々な大域的制約(査読者の負荷,利益相反,どの論文にも一定数の査読者が割り当てられていること,など)も考えないといけないので完全には非中心化できません.一方で,時間の制約もあるのでとても一人ではできません.TPMSの第一のモチベーションは自動化によって査読割り当てに要する時間を減らすことです.

第二のモチベーションは,論文に対する適切な査読者を見つけることです.査読者プールを拡大し,研究の派閥を乗り越えることが狙いです.特に機械学習のような急速に拡大している分野では,新しい査読者を迎え入れることは重要です.

NIPS2010で使用した最初のシステムでは,論文への査読者割り当ては,査読者によるBiddingとのマッチを最大化する問題として定式化されていました.しかし,これでは査読者にすべての論文に対して好みを検討してもらう必要が生じます.そのため,より自動化されたシステムが作られました.

2. 枠組みの概要

TPMSでは,査読者の専門性に基づいてマッチングを行います.より詳しくいえば,それぞれの論文に対して,それぞれの査読者の専門性を評価します.この評価に基づいて,論文の最適な割当てを計算します.

学術的な専門性はその人の仕事に反映されるものなので,出版された論文を調べるのが最も簡単です.そこでTPMSでは,それぞれの査読者の論文リストを使います.論文をモデル化するための特徴量として,それぞれの論文の未加工のテキストが使われます.

性能を向上させるために投稿論文に対して査読者が自己申告した専門性も使います.この評価をスコアとよびます.スコアは専門性を表すという点が,従来のBiddingでは査読者の興味を表していたことと違います.

評価されたスコアで,欠損したスコアを予測します.そして査読者・論文のスコア行列を使って割当てを決定します.

図出典:TPMS論文Figure 1.

図出典:TPMS論文Figure 1.

論文では,TPMSが使われたいくつかの会議の上位レベルのワークフローを紹介しています.

NIPS 2010

Area chair (AC)たちの専門性をモデリングしました.ACの専門性スコアの初期値を出版論文(平均32本/人)で評価しました.このスコアは査読者の専門性の聞き取り(elicitation)に使用しました.聞き取りは2ラウンド制で,最初のラウンドでは,最も信頼できる論文としてシステムに選ばれた(論文毎にACたちの分布の逆エントロピーで推定)約2/3の論文を残しました.ここで計算したスコアを使って教師あり学習をして,残り1/3の論文の情報の聞き取りに進みました.査読者に対しては,初期スコアを用いて,各査読者に約8本の論文にBiddingするように依頼しました.これら2つの情報源を使って,査読者のランキングリストをACに提供しました.

ICCV-2013

投稿論文の著者が,査読を依頼したいACを5人まで推薦でき,スコアによる聞き取りを制限できました.スコアはACの割り当てに使われました.ACが各論文の査読者を推薦しました.TPMSの初期スコアは査読者候補リストをランキングするために使われました.

ICML 2012

ACと査読者の両方がすべての論文に対して専門性を評価しました.TPMSの初期スコアは,それぞれの査読者に対してパーソナライズされた候補論文ランキングを生成するために使われ,ACと査読者はそれをもとにどの論文を査読するか相談しました.TPMSは,査読者とACの両方に対して教師あり学習モデルにおいて記録されたスコアを使いました.予測されたスコアはACと1人の査読者を割り当てるために使われ,ACは残り2人の査読者を割り当てました.より詳しくは https://hunch.net/?p=2407 を参照してください.

2.1. 専門性の能動的な聞き取り

前節で述べたように,初期スコアは査読者の専門性の能動的な聞き取りをガイドするために使われます.まず,初期スコアを使ってマッチングプログラムを走らせます.すなわち,初期スコアを査読者への(最適な)論文割り当てを見つけるために使用します.そして,割り当てられたすべての論文に対する査読者の専門性を質問します.直感的には,この質問は有益です.なぜなら,現在のスコアに基づいて,査読者は読みたい論文を答えるからです(したがって非常に否定的な割り当てはとても有益です).マッチング制約を適用することで,運営はユーザ毎に聞き取りするスコアの数を調整できます(実際,査読者に最終的に割り当てる数よりも多くの質問をすることは有用です).聞き取りしたスコアはマッチング制約により強いバイアスがかかっていることに注意してください(スコアはランダムに欠損します).とはいえ実用上は,これは問題にはならないようです.

2.2. ソフトウェアの側面

[略.ソフトウェア実装の話.]

システムには主に2つの機能があります.1つは査読者の出版論文を保存する機能です.これらの論文を査読者のアーカイブとよびます.査読者はURLを入力すると,システムは自動的にPDFをダウンロードします.査読者のローカルからPDFをアップロードする機能もあります.運営は自分でアーカイブを構築することもできます.Google Scholar profileをクロールするオプションも用意されています.

2つ目の主な機能は,CMTと協調動作する機能です.TPMSはCMTから情報を取得でき,CMTからTPMSスコアが見られます.

[略.APIやプロトコルなどの話.]

3. 関連研究

[略.2013年当時は色々ありましたが,2021年現在ではほぼTPMSに収束したので.]

4. モデルの学習とテスト

査読の異なるステージでは異なるデータが使えるため,それぞれに応じたモデルを作ります.まず,査読者のアーカイブと投稿論文から専門性を評価するモデルを説明します.次に,真の専門性スコアを使う教師ありモデルを説明します.

表記法

$P$: 投稿論文の集合.個々の論文を表す添字は$p$で表します.

$A$: 査読者の論文アーカイブの集合.査読者$r$のアーカイブは$A_r$で表します.

査読者の論文は結合されて1つのドキュメントとしてアーカイブされます.

$f(\cdot), g(\cdot)$: 論文(投稿またはアーカイブ)を特徴量の集合にマップする関数です.特徴量はbag-of-word表現の単語カウントでもいいし,LDAで学習した高レベルの特徴量でもいいです.

4.1. 初期スコアモデル

言語モデル

査読者のスコアは,査読者のアーカイブと投稿論文のドット積で予測されます.

$$s_{rp} = f(A_r)f(P_p)' \qquad\qquad (1)$$

特徴量$f$としては様々なものが考えられますが,最も良く使われるのは単語カウントです.単語間の条件付き独立性を仮定すると,これは以下と等価です.

$$s_{rp} = \sum_{w\in P_p} \log f(A_{rw}) \qquad\qquad (2)$$

$$f(A_{rw}) = \left(\frac{N_{A_r}}{N_{A_r}+\mu}\right) \frac{|w_{A_r}|}{N_{A_r}} + \left(\frac{\mu}{N_{A_r}+\mu}\right) \frac{|w|}{N} \qquad\qquad (3)$$

ここで,$N_{A_r}$は$r$のアーカイブにおける総単語数,$N$はコーパスの総単語数,$|w_{A_r}|$は$r$のアーカイブにおける単語$w$の出現数,$|w|$はコーパスにおける出現数,$\mu$は平滑化パラメタです.

Latent Dirichlet Allocation (LDA)

(Eq. 1)の$f$として,論文に対してLDAを適用して得られるトピック表現を使う方法もあります.

[訳注:後述の実験ではLDAが良い性能を示していますが,実際の多くの会議では単語モデルが使われているようです.]

4.2. 教師ありスコア予測モデル

スコアが利用できるときは,教師あり回帰モデルが使えます.

線形回帰

最もシンプルな回帰モデルでは,投稿論文の単語カウントを使って査読者ごとに個別のモデルを学習します.

$$s_{rp} = \theta_r f(P_p)' \qquad\qquad (4)$$

ここで,$\theta_r$はモデルパラメタです.このモデルは実用上うまく動作することが示されており,特にたくさんのスコアを聞き取れるときにはうまくいきます.このモデルの非線形版や序数版なども試しましたが,有意な性能改善は得られませんでした.

会議では,一部の査読者からはスコアが非常に小数または全く観測できないことが多いため問題になります.そのため,査読者と投稿論文の間でモデルパラメタを共有することは有益です.さらに,査読者間のアーカイブ情報を再利用することも役立つでしょう.ICMLで使用されたパラメタ共有モデルは以下になります.

$$s_{rp} = b + b_r + (\theta+\theta_p)f(P_p)' + (\omega + \omega_r)g(A_r)' \qquad\qquad (5)$$

ここで,$b$は大域バイアスです.$\theta$と$\omega$は査読者と論文で共有されるパラメタで,それぞれ投稿とアーカイブの特徴量の重みをエンコードしたものです.$b_r$, $\theta_p$,$\omega_r$は個々の論文または査読者に関するパラメタです.ICML-12では,$f(P_p)$は論文$p$の単語カウントで,$g(A_r)$は査読者$r$のアーカイブの正規化された単語カウントでした.モデルはVowpal Wabbitを使って,二乗誤差と$L_2$正則化でオンライン学習されました.

[略.正則化係数について.]

確率的行列分解

査読者の論文スコアの予測は協調フィルタリングのタスクだとみなせる.PMFはSVDの確率的拡張であり,典型的な協調フィルタリングのタスクでとてもうまくいくことが示されている.スコアは2つの低ランク行列のドット積で(確率的に)モデル化される:$s_{rp} = \theta_r \omega_P'$.PMFは論文と査読者の情報を何も使わないので,その性能はコールドスタートに苦しむ.とはいえ,比較対象として興味深いベースラインではある.

著者らは識別的RBMをはじめとするいくつかの学習法も試した.

4.3. マッチングの定式化

マッチングでは論文を査読者に割り当てます.これは以下の制約のもとでの最適化問題になります.

- a) それぞれの論文は一定数の査読者$R_\text{target}$に査読されなければならない.

- b) 査読者は査読できる論文数に上限$P_\text{max}$がある.

- c) 上記の制約を満たす範囲で会議運営はそれぞれの論文にベストな査読者を割り当てたい.

これを定式化すると以下のようになります.

$$

\begin{array}

\text{maximize}

& J(y) = \sum_r \sum_p s_{rp} y_{rp}\

\text{subject to}

&y_{rp} \in \{0, 1\}, \forall r, p \qquad\qquad (6)\

&\sum_r y_{rp} = R_\text{target}, \forall p\

&\sum_p y_{rp} \le P_\text{max}, \forall r.

\end{array}

$$

ここで$y_{rp}$は$r$に$p$を割り当てたら1,さもなければ0のフラグ変数です.

4.4. 評価

良い論文査読者を見つけることに最も関心があるので,TPMSによる割当てを過去の実際の会議の割当てとの一致度で評価できれば理想です.実際にはそれは手に入らないので,代わりの評価指標を使っています.

4.4.1. データセット

NIPS-10

NIPS2010に投稿された1251論文と48人のACからなるデータセットです.投稿論文とアーカイブは22535単語からなります.

ICML-12

ICML2012に投稿された857論文と431査読者からなるデータセットです.投稿論文とアーカイブは21409単語からなります.

4.4.2. 初期スコアの品質

聞き取りしたスコアを使わずに,投稿論文とアーカイブのみから推定した初期スコアの品質を評価します.言語モデルとして単語頻度表現word-LMと30トピックのLDA表現topic-LMを比較します.

Table 1はword-LMで予測した上位10査読者とtopic-LMで予測したそれのNDCG(平均類似度)です.値が1に近いとき両者のランキングは類似しています.

表出典:TPMS論文Table 1.

表出典:TPMS論文Table 1.

Figure 3はある論文に対する上位40査読者のスコアを示しています.topic-LMは少数の上位査読者をその他の査読者から分離できています.一方で,word-LMは上位1, 2人を除いてすべての査読者が近いスコアに集中しています.topic-LMの挙動は賢く思えます.なぜなら,典型的な論文には,少数の非常に質の高い査読者と大量の専門性の低い査読者がいるからです.トピック空間で処理を行うことでうまく分離できた理由は,単語空間にある個々の著者の執筆スタイルなどのノイズを削減できるからかもしれないと論文著者は予想しています.

表出典:TPMS論文Figure 3.

4.4.3. 最終スコアの品質

最終スコアはholdoutで簡単に評価できます.Table 2はLR (Eq. 4), LR-shared (Eq. 5), PMFのテストRMSEを示しています.LR-sharedがパラメタを共有する方法はどちらのデータセットにも有効だとわかります.スコア予測が良いモデルほどマッチングも良くなっていました.

表出典:TPMS論文Table 2.

5. 今後の展望と持続可能性

[略]

6. 現在および将来の方向性

- A) 会議間でのスコアの再利用

- B) 投稿締切前のスコア聞き取り

- C) データのリリース

- D) よりCMTと統合する

謝辞

[略]

適切な査読者とマッチするには?

以上の論文の内容をふまえて,どのようにすれば適切な査読者に論文が渡りやすくなるのかを考えてみます.まず,TPMS論文のポイントは以下になります.

- TPMSは査読者$r$の論文$p$に対する専門性をスコア$s_{rp}$で表します.

- スコアは査読者の論文$A_r$と投稿論文$P_p$の単語頻度ベクトル$f(\cdot)$の内積$s_{rp}=f(A_r)f(P_p)'$で計算されます.

- 論文は査読者・論文双方の割当て本数に関する制約のもとで$\displaystyle \sum_{(p,r)\in 割当て} s_{rp}$を最大化するように割り当てられます.

- 自己申告の専門性スコアやBiddingも考慮されます.

- 査読プロセスは会議によって異なり,Area Chair (AC)のスコアリングのみにTPMSを使うこともあれば,ACと査読者全員のスコアリングに使うこともあります.

したがって,論文が適切な査読者に割り当てられるためには,望ましい査読者のスコアを最大化すると同時に望ましくない査読者のスコアを最小化するように論文を書く必要があります.そのために重要なポイントは以下の3つです.

- ペルソナ分析しよう:投稿先会議に論文が何本も採択されているシニア研究者の中から,自分と近い問題や技術を扱っている人を探し出します.そのうち,価値観の近そうな人を想定査読者,価値観が異なる人を非想定査読者に設定します.

- ターゲティングしよう:想定査読者が最近出版した論文で使われている特徴的な単語を自分の論文にも含めます.同義語・類義語の使い分けは想定査読者に合わせます.非想定査読者が使っている単語は避けます.

- 導線設計しよう:想定査読者がBiddingしたくなるタイトルをつけます.アブストラクトは対象領域における代表的研究との差分と利点がわかるように書きます.イントロには貢献を査読採点項目と一対一対応する形で書きます.図表は登場順に眺めるだけで貢献内容が伝わるように作って配置します.

ペルソナ分析しよう

査読者プールを推測して,その中からマッチしてほしい人(想定査読者)を決めます.逆に,マッチしてほしくない人(非想定査読者)も決めます.それらをペルソナ(典型的な査読者像)として,論文執筆時の単語選択の参考にします.

まず,公開情報から査読者プールを推測します.会議の常連の大部分はその会議の査読者もしています.実際AAAI-22では,論文投稿フォームにおいて査読を引き受けることの承諾が求められました.したがって,投稿先の会議に複数回採択されている人が査読者の候補としてプールされている可能性が高いです.

推測プールから自分の研究に関心を持ってくれそうな研究者を探します.まず一番は自分の研究のベースとなった論文の著者でしょう.その著者とよく共著している研究者も有望です.自分が引用した論文の著者も内容的に関連が深いならアリです.

自分の研究に批判的な態度をとりそうな研究者も探します.世の中には,自分と似た研究をしているのに思想や動機が根本的に違う人がいます.そんな査読者に論文が渡ったら最後,研究の動機を丁寧に説明すればするほど価値観の違いがあらわになって,喧嘩別れにしかなりません.残念ながら,論文で他人の価値観を変えることはまずできません.したがって,避けるべき査読者を意識することも同じくらい重要です.

想定査読者にも非想定査読者にも実在する個人を選びますが,ピンポイントにその人に査読してもらうことを狙うものではありません.大規模会議ではそんなことはほぼ不可能です.あくまでも典型的な査読者像を代表する「ペルソナ」として利用します.そのため,できるだけシニアの研究者を選びます.数多くの研究者を輩出してきたシニア研究者ならば,近い傾向の研究者が多数いるはずだからです.シニアの名前は論文のラストオーサーにあります.そこで,論文のラストオーサーを(非)想定査読者に選びます.

なお,多くのAI会議では,査読はダブルブラインドレビュー(著者は査読者を知らず,査読者は著者を知らない)で行われます.自分の論文に割り当てられた査読者を特定することは不正行為になります.ここで選ぶ研究者は,あくまでも論文を書く際の想定読者にとどめるように気を付けてください.

ターゲティングしよう

想定査読者が最近出版した論文で使われている特徴的な単語を自分の論文にも含めます.非想定査読者が使っている単語は避けます.そのために,TPMSに登録されるであろう論文を調べます.

査読者は自身の専門性をTPMSに計算させるため,自分がこれまでに書いた論文を登録します.すべての論文が登録されるとはかぎりません.登録の手間からいって,以下の順に登録されやすくなっています.実際はGoogle Scholarだけ調べれば十分だと思います.足りなければarXivも使いましょう.

- Google Scholarから辿れる論文

- オープンアクセス論文やプレプリント

- 有料論文

参考にする論文が決まったら,そこで使われている単語を調べて,特徴的な単語を自分の論文でも使う/使わないようにします.最初に述べたように,類似度は査読者のアーカイブから作った特徴量ベクトルの内積で計算されるのでした.「想定査読者がよく使う,分野では珍しい単語」が有効な特徴量になります.また,適切な査読者に当たりやすくするだけでなく,不適切な査読者に当たりにくくすることも重要です.そのために,同義語・類義語を使います.広く使われる概念には同じ概念に複数の名前が付いているものです.どの用語を使うかは分野によって違います.想定する査読者にとって馴染みのある用語を一貫して使いましょう.たとえば統計学と機械学習では以下のような用語法の違いがあります(引用ツイートはネタなのであまり真に受けないでください).

The best words trophy goes to… pic.twitter.com/L6KtGasnom

— Maarten van Smeden (@MaartenvSmeden) December 19, 2021

実際には分野といっても一枚岩ではないので,想定査読者と非想定査読者の論文を直接比較して用語法の違いを認識するのが大事です.また,TPMSでは文書構造による単語の重みづけ(タイトルに登場する単語は重要度2倍,など)は行っていないので,特徴的な単語を無理にタイトルやアブスト等に含める必要はありません.

導線設計しよう

ここからは,無事適切な査読者にマッチした後の話です.多くの査読者は,割り当てられた論文を以下の流れで読んでいきます.

- タイトルを読む

- アブストを読む

- イントロを読む

- 図表を順に見る

- 結論を読む

- その他の本文を順に読む

この導線を意識して論文を書くと査読しやすくなります.査読者は複数の査読を抱えていて,すべての論文に十分な時間をかける余裕がないこともあります.他の論文より優先して査読したくなるタイトルをつけてください.アブストラクトは対象領域における代表的研究との差分と利点がわかるように書きます.イントロには貢献を査読採点項目と一対一対応する形で書きます.ほぼ同じ内容を査読コメントに書いてもらえると理想です.図表を登場順に眺めるだけで貢献内容が伝わるようにし,結論でそれを言語化してまとめます.

まとめ

TPMSは多くのトップAI会議で使われる査読割り当てシステムです.査読者の専門性をスコアリングします.スコアは投稿論文と査読者の論文の類似度で決まります.類似度は単語頻度ベクトルのドット積で計算されます.TPMSの仕組みが分かったら,想定査読者と非想定査読者のペルソナ分析をして,用語法を合わせてターゲティングして,biddingから査読採点までの導線設計をしましょう.

まぁ,ここまでやっても落ちます.それがトップAI会議です.でも本稿に書いたことを実践できていれば平均3回くらいで通ります.トップAI会議の採択率が20%前後であることを考えれば,かなり効果があるのがわかると思います.また,落ちているうちに新しい研究を進めれば,論文ポートフォリオが形成されます.1つの会議に複数の論文を投稿していると,投稿数の何割かは安定して通るようになります.めげずに頑張りましょう!

-

2013年の時点でNIPS, ICML, UAI, AISTATS, CVPR, ICCV, ECCV, ECML/PKDD, ACML, ICGVIPで使われています.2021年現在では機械学習とコンピュータビジョンの主要な会議のほぼすべてで使われています. ↩