最近の勉強で学んだ事を、ノート代わりにまとめていきます。

主に自分の学習の流れを振り返りで残す形なので色々、省いてます。

Webエンジニアの諸先輩方からアドバイスやご指摘を頂けたらありがたいです!

robots.txtを追加する必要が発生!

robots.txtは「サイト内の指定したページに対して、検索エンジンがクロールを行わない様に命令できる」機能

サイト内検索結果ページや自動生成ページ等、検索エンジンに表示される必要のないページへのクロールを制御する事で、あなたのサイトをより最適化する事ができ、場合によっては大きなSEO改善効果に繋がるケースがある。

上記のことをしたい場合は、robots.txtファイルを追加して以下の様な中身にする!

robots.txt

User-Agent:*

Disallow:

Sitemap:http://example.com/sitemap.xml

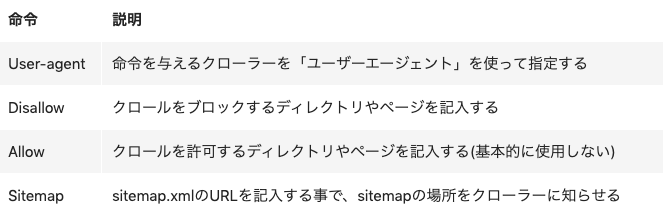

細かい命令方法はこれらで設定できる