はじめに

昨年のアドベントカレンダーでは、PR Agent の導入についての記事を投稿させていただきました。

本記事では、そこから 1年間運用してきた中で直面した課題と、その改善策 について紹介していきます。

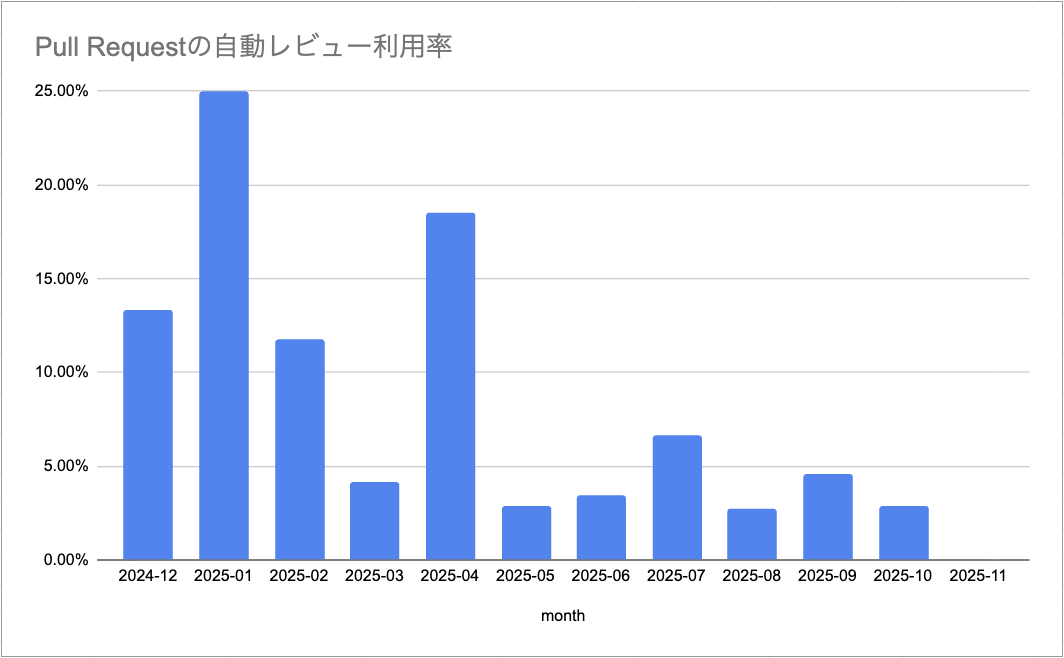

利用率の推移について

PR Agentを導入した結果、主要なリポジトリのPRに対する自動レビュー採用割合は以下のように推移しました。

導入当初は興味本位で使ってもらえていたものの、時間の経過とともに利用率は徐々に低下していきました。

なぜこのような結果になってしまったのか、その原因について考察していきます。

原因1. 導入直後のレビュー品質の低さ

まず直面したのが、導入直後のレビュー品質の低さ です。

指摘が的外れだったり表面的なものが多く、「たまに良いことを言うな」という評価に落ち着いた印象でした。

AI レビューを導入するにあたり、「AI のコメントにも真摯に対応する」という姿勢は組織内で共有できており、的外れな指摘であっても客観的な意見として受け止め、丁寧に対応していました(この姿勢自体は、今でも重要だと考えています)。

一方で、AIに「問題ない」ことを説明するコスト も発生しており、それが体験の悪さにつながってしまいました。

精度が低かった原因としては、設定をほぼデフォルトのまま使用していたことや、現在と比べると性能の低いモデルを使っていたことが挙げられます。

体感にはなりますが、モデルを o4-mini に変更したタイミングでレビュー内容は大きく改善し、使い慣れた Cursor や Claude Code の AI Agent による改善提案に近い体験が得られるようになりました。

原因2. UXの設計の甘さ

次に、UXの設計がイマイチだったことが挙げられます。

弊社では扱うリポジトリが多いため、どのリポジトリでも /review などのコメントを打つだけで AI による自動レビューが実行される仕組みにしていました。

ここで問題になったのが、レビュイーの中で 自動レビューを使う人と使わない人が分かれてしまった ことです。

本来、自動レビューはレビュアーの負担軽減を目的としており、レビュアーが必要に応じて PR にコメントして自動レビューを実行すること自体は何も問題ありません。

しかし、他人の PR に対して自動レビューを入れることへの心理的ハードルが、想像以上に高かった ことに気づきました。

これは私個人の感覚かもしれませんが、「AI のレビューを他人のコードに入れることへの気まずさ」がありました。

(社内メンバーの中で自動レビューを追加されて怒るような人はいないのですが・・)

これらは組織内で共通認識を持つことで解消できた可能性もありますが、

多少でコストがかかったとしても、PRのステータスが Draft から Ready for review に変わった段階で自動的にレビューが走るような仕組み にしておいた方が、導入効果は高かったと感じています。

原因3. 目標もなく漠然とした運用

そもそも自動レビューの導入は、組織の課題解決というよりも、個人の興味から始まった取り組み でした。

そのため、組織としての具体的な目標と紐づけることもなく、関連する指標の計測も行っていなかったため、長期間にわたって「お試し」状態の運用が続いていました。

この状態では、自動レビューのメンテナンスも気が向いたときになってしまいますし、利用者の中には 存在自体を忘れていた人もいたかもしれません。

自分が「良い」と思ったツールを導入する際は、

既存の運用に対する影響やコストを下げることを考えるだけでなく、周囲を巻き込みながら組織として推進していかないと、中途半端に終わってしまう ということを学びました。

まとめ

自動レビューを導入したものの、思うように活用されなかった件について、その原因を振り返ってきました。

今後、自動レビューをしっかり運用していくにあたり、以下の3点を意識していきたいと思います。

- レビュー品質を重点的にチェックすること(特にモデルの選択が重要)

- 自社の運用に合わせつつ、利用者が意識せずとも使える UX を設計すること

- 継続的な測定を行い、明確な目標を持って運用すること

まだまだインティメート・マージャー アドベントカレンダーは続きます!

明日の記事もお楽しみに!