DOKはコンテナー型のGPUサービスで、NVIDIA V100やH100を実行時間課金で利用できるサービスです。

コンテナー型GPUクラウドサービス 高火力 DOK(ドック) | さくらインターネット

今回はこのDOKを使って、Ollama経由でPhi-4を使ってみます。DOKを利用すれば、ローカルにGPUがなくとも、速いレスポンスが得られます。

必要なもの

Docker(ローカル。強力なGPUは不要です)

Ollamaとは

Ollamaは、LLMを簡単に実行できるオープンソース・ソフトウェアです。Llama 3やMistral、そして今回試すPhi-4など、さまざまなモデルに対応しています。CLIで利用することが多いですが、今回はWeb APIとして立ち上げて、Open WebUIから操作します。

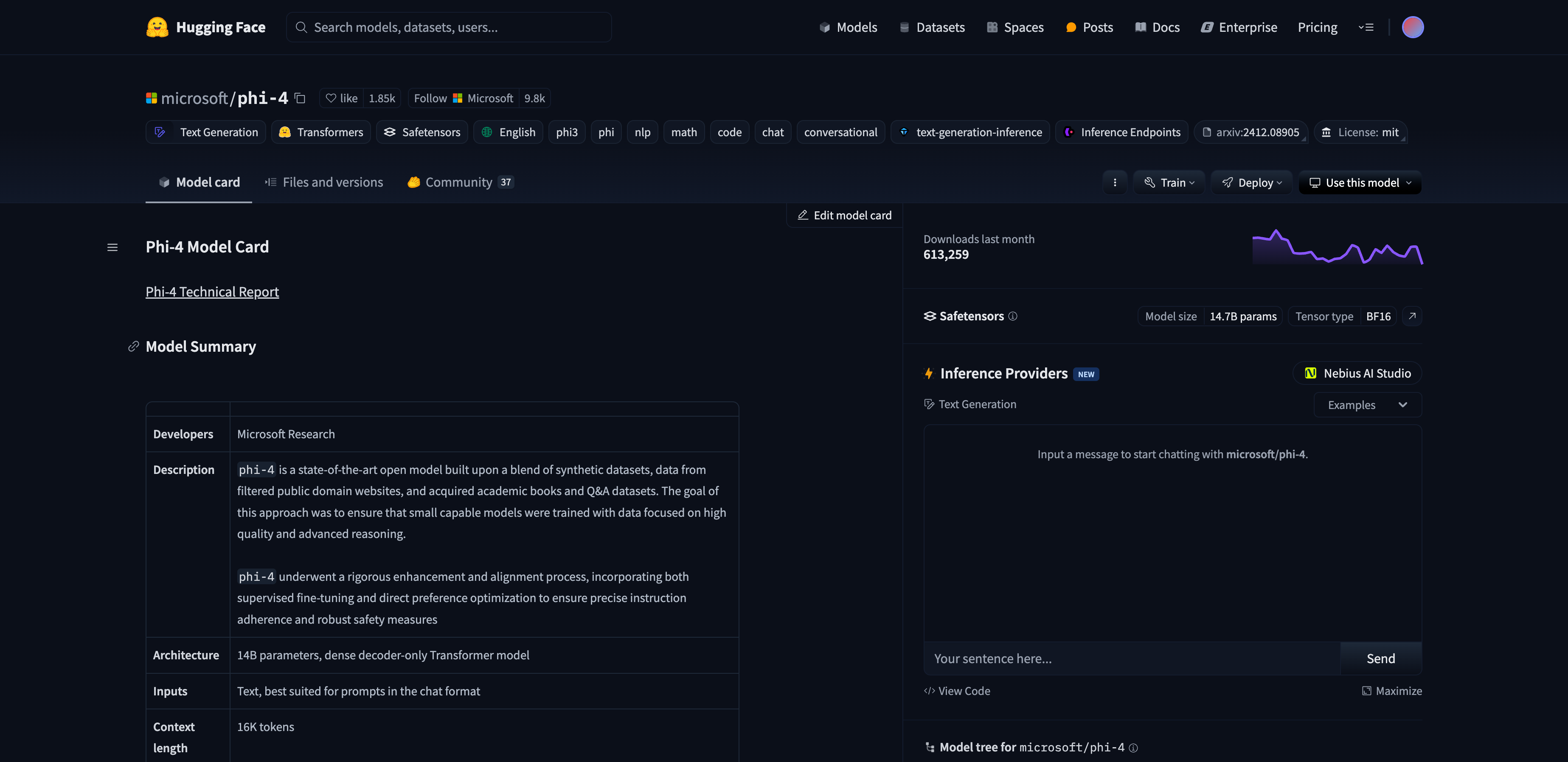

Phi-4とは

Phi-4は、Microsoftが2024年12月に発表したSLMです。パラメータ数は140億(14b)で、大規模なモデルです。ライセンスはMIT Licenseとなっており、商用利用も可能です。

日本語も問題なく利用でき、コーディング能力にも優れています。

microsoft/phi-4 · Hugging Face

実行する

DOKで、下記の条件でタスクを作成します。

| 項目 | 設定 |

|---|---|

| イメージ | ollama/ollama |

| HTTPポート | 11434 |

実行して、しばらく待つとHTTPアクセスできるURL( https://UUID.container.sakurausercontent.com のような)が発行されます。

Open WebUIで操作する

ローカルで実行します。これはGPUが不要なので、Dockerさえ実行できれば、どこでも実行できます。先ほど出力されたURLを OLLAMA_BASE_URL として指定します。

docker run -p 8080:8080 \

# 発行されたURLに置き換え

-e OLLAMA_BASE_URL=https://UUID.container.sakurausercontent.com \

-v open-webui:/app/backend/data \

--name open-webui --restart always ghcr.io/open-webui/open-webui:main

そして、ブラウザで http://localhost:8080 にアクセスします。以下のような画面が表示されます。

モデルの追加

設定の中にある接続設定から、モデルを追加します。今回はphi4を追加しました。サイズは14bになります。ダウンロードはDOK側で行われます。

ダウンロードさえ終われば、チャットが利用できます。

チャットでの利用

夏目漱石について日本語で教えて と入力すると、返答が返ってきます。結果はかなり正しい内容ではないかと思います。少なくとも素のDeepSeekよりは正しい印象です。

さくらインターネットについて聞く

さくらインターネットについても説明してもらいました。こちらも読んでみて、特に違和感はありませんでした。

プログラミング

React + TailwindでTodoアプリを作ってもらいました。一度作成した後、タスクの編集機能を追加していますが、それも問題なく動作しました。

注意点

DOK上でコンテナが実行されている限り、課金が発生します。使い終わったら、タスクを終了してください。

なお、執筆時点(2025年6月現在)では、h100-80gbが0.11円/秒とキャンペーン中になっています(2025年7月末までの価格)。

まとめ

今回はDOKでPhi-4を試しました。v100-32gbを使いましたが、より大規模なモデルを利用するならh100-80gbもあります。大規模LLMの学習や評価に使うと、ローカルのGPUを使うよりも早く結果が得られます。ぜひ試してみてください。

DOKはタスク実行用途での利用が多いですが、HTTPアクセスを使えばJupyter Notebookなども利用できます。ぜひAI・機械学習に活用してください。