はじめに

生成AIを用いてEfficientNetの論文「EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks」の内容を(なるべく)把握してみました。(生成AIが)論文の記載内容を始めから最後まで読んで、実際にどのような記載があるのかを把握します。

(論文の分かりやすい解説記事は見るのですが、実際の論文までチェックしないので、生成AIを使って内容を把握してみました。)

スケーリングを効率的に行うために、EfficientNet-B0という小型のベースラインモデルを使用し、φ=1に固定して、最初に小規模なグリッド検索でスケーリング係数α, β, γを最適化し、次に、α, β, γを固定して、複合係数φに基づき、EfficientNet-B0から効率的にモデルをスケーリングし、EfficientNet-B1~B7を生成することが分かりました。(末尾の「分かったこと」章を参照)

以降で、ChatGPTに聞いてみた例を記載します。

他例: 同類の方法を使って読んでみた結果

対象の論文

論文: (EfficientNetに関する論文)

[1905.11946] EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks

https://arxiv.org/abs/1905.11946

(PDF: https://arxiv.org/pdf/1905.11946)

質問時の各章節の区切り部分

論文の中にある各章節を、下記のように区切って、部分毎に生成AIに内容を質問していきます。

- Abstract

- ---

- 1.-Introduction

- ---

- 2.-Related Work

- ---

- 3.-Compound Model Scaling

- 3.1. Problem Formulation

- ---

- 3.2. Scaling Dimensions

- ---

- 3.3. Compound Scaling

- ---

- 4.-EfficientNet Architecture

- ---

- 5.-Experiments

- 5.1. Scaling Up MobileNets and ResNets

- 5.2. ImageNet Results for EfficientNet

- ---

- 5.3. Transfer Learning Results for EfficientNet

- ---

- 6.-Discussion

- ---

- 7.-Conclusion

- Appendix

生成AIへの質問方法

生成AIを活用して、知りたい記事・論文の1節分(適度な長さ)のテキストをコピー&ペーストして、その下に質問内容を「①~ ②~ …」と番号付きで書いて、生成AIに渡せば、全質問に一発で的確に回答してくれるので、非常に良好でした。記事全体を読む必要なく、知りたい点の情報だけを収集できます。

生成AIへの質問例:

(論文・記事の各章節を貼り付け)

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

質問内容は、記事・論文を読んでいていつも知りたいと思う点(改良点・工夫点・テクニック・メカニズムの解明)にしています。また、表で比較した方が素早く把握できるので、可能であれば記事を表に変換するようにしています。

論文・記事を貼り付けるテキストの長さは、1節分程度の量にとどめた方が、良い回答が得られました。生成AIの回答の文量が多くなってくると、回答が長くなり過ぎないように、生成AIが勝手に(適度に)端折り始めてしまい、重要な点が回答から抜けてしまう可能性が高まります。

事前知識

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。

EfficientNetについての分かりやすい解説記事等(下記)を事前にチェックして、中核部分の内容をあらかじめ分かっていると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

注意点

論文のテキスト内容だけを貼り付けて、生成AIに質問しています。論文の中の図・表の部分は貼り付けていません。図・表の内容は生成AIの回答には含まれず、別途論文を見る必要があります。

以降で、生成AIの回答内容が読みにくい・分かりづらい場合は、論文の本文でも同じように書かれてあり、論文の本文を読んでも同じように分かりづらいことが多くあります。論文では、既存研究等があるため、多くの説明を省略・一言だけサラッと書かれてある等、同種の研究に取り組む人でなければ、なかなか全容の理解に辿りつくのは難しい側面があります。この点は、生成AIの回答性能が悪いのではなく、論文という性質上、生じるものと考えています。

生成AIに質問

以降で、ChatGPTに実際に聞いてみた例を記載します。

生成AIへの質問&回答の全容

生成AIへの質問&回答の全容・詳細:

Abstract

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) Abstract Convolutional Neural Networks (ConvNets) are commonly developed at a fixed resource budget, and then scaled up for better accuracy if more resources are available. In this paper, we sys- tematically study model scaling and identify that carefully balancing network depth, width, and res- olution can lead to better performance. Based on this observation, we propose a new scaling method that uniformly scales all dimensions of depth/width/resolution using a simple yet highly effective compound coefficient. We demonstrate the effectiveness of this method on scaling up MobileNets and ResNet. To go even further, we use neural architec- ture search to design a new baseline network and scale it up to obtain a family of models, called EfficientNets, which achieve much better accuracy and efficiency than previous ConvNets. In particular, our EfficientNet-B7 achieves state-of-the-art 84.3% top-1 accuracy on ImageNet, while being 8.4x smaller and 6.1x faster on inference than the best existing ConvNet. Our EfficientNets also transfer well and achieve state-of-the-art accuracy on CIFAR-100 (91.7%), Flowers (98.8%), and 3 other transfer learning datasets, with an order of magnitude fewer parameters. Source code is at https: //github.com/tensorflow/tpu/tree/ master/models/official/efficientnet.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何? + 図/表番号列挙

このセクションでは、Convolutional Neural Networks (ConvNets) のモデルスケーリングに関する研究結果が記載されている。特に、ネットワークの深さ、幅、および解像度を均等にスケーリングする新しい方法と、それを使用して開発されたEfficientNetモデルファミリーの性能が紹介されている。

要旨

- モデルスケーリングの最適化において、ネットワークの深さ、幅、解像度のバランスを取ることが重要である。

- 深さ、幅、解像度を均等にスケーリングするための新しいスケーリング方法を提案。

- MobileNetsやResNetに対して提案手法の効果を実証。

- Neural architecture searchを用いて設計されたEfficientNetが、従来のConvNetよりも高い精度と効率性を達成。

- EfficientNet-B7は、ImageNetで84.3%のトップ1精度を達成し、既存の最良のConvNetよりも8.4倍小さく、推論速度が6.1倍速い。

- EfficientNetは、CIFAR-100、Flowers、その他の転移学習データセットでも、桁違いに少ないパラメータで最先端の精度を達成。

対応する図/表番号: なし

②改良点・工夫点・テクニック等の記載

- ネットワークの深さ、幅、解像度を均等にスケーリングするための「compound coefficient」を導入。

- EfficientNetの設計には、neural architecture searchを活用し、最適なベースラインネットワークを構築。

③性能が向上した記載

- EfficientNet-B7はImageNetで84.3%のトップ1精度を達成し、既存の最良のConvNetよりも8.4倍小さく、推論速度が6.1倍速い。

④メカニズムの解明・なぜそうなるのか等の記載

- モデルスケーリングにおいて、単純にネットワークの深さや幅を増やすだけではなく、バランスよくスケーリングすることで、計算効率を損なわずに性能を向上させることができる。

⑤比較の記載

| モデル | Top-1精度 (ImageNet) | モデルサイズ | 推論速度 |

|---|---|---|---|

| EfficientNet-B7 | 84.3% | 8.4倍小さい | 6.1倍速い |

⑥上記⑤以外で表に出来そうな部分

無し

1. Introduction

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 1. Introduction Scaling up ConvNets is widely used to achieve better accu- racy. For example, ResNet (He et al., 2016) can be scaled up from ResNet-18 to ResNet-200 by using more layers; Recently, GPipe (Huang et al., 2018) achieved 84.3% Ima- geNet top-1 accuracy by scaling up a baseline model four time larger. However, the process of scaling up ConvNets has never been well understood and there are currently many ways to do it. The most common way is to scale up Con- vNets by their depth (He et al., 2016) or width (Zagoruyko & Komodakis, 2016). Another less common, but increasingly popular, method is to scale up models by image resolution (Huang et al., 2018). In previous work, it is common to scale only one of the three dimensions – depth, width, and image size. Though it is possible to scale two or three dimensions arbitrarily, arbitrary scaling requires tedious manual tuning and still often yields sub-optimal accuracy and efficiency. In this paper, we want to study and rethink the process of scaling up ConvNets. In particular, we investigate the central question: is there a principled method to scale up ConvNets that can achieve better accuracy and efficiency? Our empirical study shows that it is critical to balance all dimensions of network width/depth/resolution, and surpris- ingly such balance can be achieved by simply scaling each of them with constant ratio. Based on this observation, we propose a simple yet effective compound scaling method. Unlike conventional practice that arbitrary scales these fac- tors, our method uniformly scales network width, depth, and resolution with a set of fixed scaling coefficients. For example, if we want to use 2N times more computational resources, then we can simply increase the network depth by αN , width by βN , and image size by γN , where α, β, γ are constant coefficients determined by a small grid search on the original small model. Figure 2 illustrates the difference between our scaling method and conventional methods. Intuitively, the compound scaling method makes sense be- cause if the input image is bigger, then the network needs more layers to increase the receptive field and more channels to capture more fine-grained patterns on the bigger image. In fact, previous theoretical (Raghu et al., 2017; Lu et al., 2018) and empirical results (Zagoruyko & Komodakis, 2016) both show that there exists certain relationship between network width and depth, but to our best knowledge, we are the first to empirically quantify the relationship among all three dimensions of network width, depth, and resolution. We demonstrate that our scaling method work well on exist- ing MobileNets (Howard et al., 2017; Sandler et al., 2018) and ResNet (He et al., 2016). Notably, the effectiveness of model scaling heavily depends on the baseline network; to go even further, we use neural architecture search (Zoph & Le, 2017; Tan et al., 2019) to develop a new baseline network, and scale it up to obtain a family of models, called EfficientNets. Figure 1 summarizes the ImageNet perfor- mance, where our EfficientNets significantly outperform other ConvNets. In particular, our EfficientNet-B7 surpasses the best existing GPipe accuracy (Huang et al., 2018), but using 8.4x fewer parameters and running 6.1x faster on in- ference. Compared to the widely used ResNet-50 (He et al., 2016), our EfficientNet-B4 improves the top-1 accuracy from 76.3% to 83.0% (+6.7%) with similar FLOPS. Besides ImageNet, EfficientNets also transfer well and achieve state- of-the-art accuracy on 5 out of 8 widely used datasets, while reducing parameters by up to 21x than existing ConvNets.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何? + 図/表番号列挙

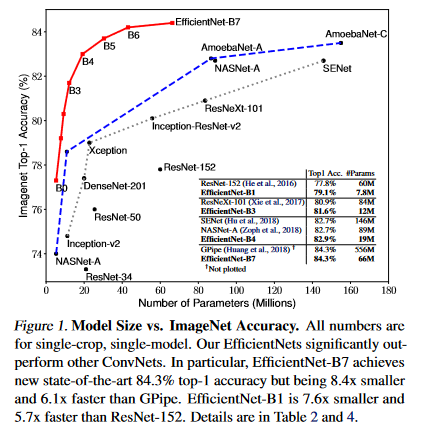

このセクションでは、Convolutional Neural Networks (ConvNets) のスケーリングに関する問題点を再評価し、新しいコンパウンドスケーリング方法を提案している。この方法は、ネットワークの深さ、幅、解像度をバランスよくスケーリングすることで、より高い精度と効率を達成することを目的としている。

要旨

- ConvNetsのスケーリングには深さや幅、解像度の単独のスケーリングが一般的だが、最適化には至っていない。

- ネットワークの深さ、幅、解像度を均等にスケーリングするためのコンパウンドスケーリング方法を提案。

- 提案したスケーリング方法は、MobileNetsやResNetといった既存モデルに対して効果を発揮する。

- Neural architecture searchを用いてEfficientNetという新しいモデルファミリーを開発し、従来のConvNetsよりも大幅に優れた性能を達成。

- EfficientNet-B7は、ImageNetにおいてGPipeを上回る精度を達成し、パラメータ数が8.4倍少なく、推論速度が6.1倍速い。

- EfficientNet-B4はResNet-50と同等のFLOPSで、精度を6.7%向上させた。

対応する図/表番号: Figure 1, Figure 2

②改良点・工夫点・テクニック等の記載

- コンパウンドスケーリング法を導入し、ネットワークの深さ、幅、解像度を固定された比率で均等にスケーリングする方法を提案した。

- 提案したスケーリング方法は、既存のモデルだけでなく、新たに設計されたEfficientNetモデルにも適用された。

③性能が向上した記載

- EfficientNet-B7はImageNetでGPipeを上回る精度を達成し、パラメータ数が8.4倍少なく、推論速度が6.1倍速い (Figure 1)。

- EfficientNet-B4はResNet-50と比較して、トップ1精度が6.7%向上した (Figure 1)。

④メカニズムの解明・なぜそうなるのか等の記載

- 入力画像が大きくなると、ネットワークはより多くの層を必要とし、受容野を広げ、より細かいパターンを捉えるためにチャネルを増やす必要がある。このバランスを取ることで、効率と精度の両方が向上する。

⑤比較の記載

| モデル | Top-1精度 (ImageNet) | パラメータ数 | 推論速度 | 備考 | 表番号 |

|---|---|---|---|---|---|

| EfficientNet-B7 | 84.3% | 8.4倍少ない | 6.1倍速い | GPipeを上回る精度 | Figure 1 |

| EfficientNet-B4 | 83.0% | - | - | ResNet-50に比べて+6.7% | Figure 1 |

⑥上記⑤以外で表に出来そうな部分

無し

2. Related Work

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2. Related Work ConvNet Accuracy: Since AlexNet (Krizhevsky et al., 2012) won the 2012 ImageNet competition, ConvNets have become increasingly more accurate by going bigger: while the 2014 ImageNet winner GoogleNet (Szegedy et al., 2015) achieves 74.8% top-1 accuracy with about 6.8M parameters, the 2017 ImageNet winner SENet (Hu et al., 2018) achieves 82.7% top-1 accuracy with 145M parameters. Recently, GPipe (Huang et al., 2018) further pushes the state-of-the-art ImageNet top-1 validation accuracy to 84.3% using 557M parameters: it is so big that it can only be trained with a specialized pipeline parallelism library by partitioning the network and spreading each part to a different accelera- tor. While these models are mainly designed for ImageNet, recent studies have shown better ImageNet models also per- form better across a variety of transfer learning datasets (Kornblith et al., 2019), and other computer vision tasks such as object detection (He et al., 2016; Tan et al., 2019). Although higher accuracy is critical for many applications, we have already hit the hardware memory limit, and thus further accuracy gain needs better efficiency. ConvNet Efficiency: Deep ConvNets are often over- parameterized. Model compression (Han et al., 2016; He et al., 2018; Yang et al., 2018) is a common way to re- duce model size by trading accuracy for efficiency. As mo- bile phones become ubiquitous, it is also common to hand- craft efficient mobile-size ConvNets, such as SqueezeNets (Iandola et al., 2016; Gholami et al., 2018), MobileNets (Howard et al., 2017; Sandler et al., 2018), and ShuffleNets (Zhang et al., 2018; Ma et al., 2018). Recently, neural archi- tecture search becomes increasingly popular in designing efficient mobile-size ConvNets (Tan et al., 2019; Cai et al., 2019), and achieves even better efficiency than hand-crafted mobile ConvNets by extensively tuning the network width, depth, convolution kernel types and sizes. However, it is unclear how to apply these techniques for larger models that have much larger design space and much more expensive tuning cost. In this paper, we aim to study model efficiency for super large ConvNets that surpass state-of-the-art accu- racy. To achieve this goal, we resort to model scaling. Model Scaling: There are many ways to scale a Con- vNet for different resource constraints: ResNet (He et al., 2016) can be scaled down (e.g., ResNet-18) or up (e.g., ResNet-200) by adjusting network depth (#layers), while WideResNet (Zagoruyko & Komodakis, 2016) and Mo- bileNets (Howard et al., 2017) can be scaled by network width (#channels). It is also well-recognized that bigger input image size will help accuracy with the overhead of more FLOPS. Although prior studies (Raghu et al., 2017; Lin & Jegelka, 2018; Sharir & Shashua, 2018; Lu et al., 2018) have shown that network depth and width are both important for ConvNets’ expressive power, it still remains an open question of how to effectively scale a ConvNet to achieve better efficiency and accuracy. Our work systemati- cally and empirically studies ConvNet scaling for all three dimensions of network width, depth, and resolutions.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何? + 図/表番号列挙

このセクションでは、ConvNetの精度と効率、そしてモデルのスケーリングに関連する既存の研究についての概要を述べている。また、これらの研究の限界を指摘し、新たな研究の必要性を示唆している。

要旨

- ConvNetの精度向上は、主にモデルのサイズを大きくすることで達成されてきたが、これにはハードウェアのメモリ限界がある。

- モデル圧縮やモバイル用に特化した軽量モデルの設計が進んでいるが、大規模なモデルの効率性向上には課題が残っている。

- ConvNetのスケーリングには、ネットワークの深さ、幅、解像度など、複数のアプローチが存在するが、それらを効果的にスケーリングする方法はまだ明確ではない。

対応する図/表番号: 無し

②改良点・工夫点・テクニック等の記載

- 特に無し。関連研究の概要と課題を示しているセクションであるため、改良点や工夫点に関する具体的な記載はない。

③性能が向上した記載

- 無し。このセクションでは性能向上に関する具体的な結果は述べられていない。

④メカニズムの解明・なぜそうなるのか等の記載

- 無し。このセクションは既存研究のレビューであり、メカニズムの解明や新たな知見についての記載はない。

⑤比較の記載

- 無し。このセクションには比較に関する記載がない。

⑥上記⑤以外で表に出来そうな部分

- 無し。このセクションは既存研究の概要と課題を説明しているため、表にまとめるような具体的な数値やデータは含まれていない。

▼質問(人間)

関連研究について表にまとめられないか?

▼生成AIの回答(ChatGPT-4o)

関連研究を表にまとめることは可能です。このセクションでは、ConvNetの精度と効率に関する主要な研究やアプローチが紹介されていますので、それらを以下のように表にまとめることができます。

| 研究/モデル名 | 年 | 主な貢献/特徴 | パラメータ数 (M) | ImageNet Top-1精度 | 備考 |

|---|---|---|---|---|---|

| AlexNet (Krizhevsky et al.) | 2012 | ConvNetの大規模利用の先駆け。ImageNetで初の勝利を収める | 60M | - | 大規模なConvNetの導入 |

| GoogleNet (Szegedy et al.) | 2015 | Inceptionモジュールの導入による効率的な計算 | 6.8M | 74.8% | パラメータ数を抑えつつ高い精度を達成 |

| SENet (Hu et al.) | 2018 | Squeeze-and-Excitationブロックで特徴強調 | 145M | 82.7% | より高精度を達成するための大規模モデル |

| GPipe (Huang et al.) | 2018 | パイプライン並列化による超大規模モデルのトレーニング | 557M | 84.3% | 超大規模モデルにより最高精度を達成するが、専用ハードウェアが必要 |

| MobileNets (Howard et al.) | 2017, 2018 | モバイル向けの効率的なConvNet設計 | 数百万 | - | 軽量かつ効率的なモデル。最近はNeural Architecture Searchによる改良も進む |

この表では、各研究の名前、発表年、主な貢献や特徴、パラメータ数、ImageNetでのTop-1精度、および備考をまとめています。これにより、関連研究の概要を一目で比較しやすくなります。

3. Compound Model Scaling

3.1. Problem Formulation

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3. Compound Model Scaling In this section, we will formulate the scaling problem, study different approaches, and propose our new scaling method. 3.1. Problem Formulation A ConvNet Layer i can be defined as a function: Yi = Fi(Xi), where Fi is the operator, Yi is output tensor, Xi is input tensor, with tensor shape 〈Hi, Wi, Ci〉1, where Hi and Wi are spatial dimension and Ci is the channel dimension. A ConvNet N can be represented by a list of composed lay- ers: N = Fk ... F2 F1(X1) = ⊙ j=1...k Fj (X1). In practice, ConvNet layers are often partitioned into multiple stages and all layers in each stage share the same architec- ture: for example, ResNet (He et al., 2016) has five stages, and all layers in each stage has the same convolutional type except the first layer performs down-sampling. Therefore, we can define a ConvNet as: N = ⊙ i=1...s FLi i (X〈Hi,Wi,Ci〉 ) (1) where FLi i denotes layer Fi is repeated Li times in stage i, 〈Hi, Wi, Ci〉 denotes the shape of input tensor X of layer i. Figure 2(a) illustrate a representative ConvNet, where the spatial dimension is gradually shrunk but the channel dimension is expanded over layers, for example, from initial input shape 〈224, 224, 3〉 to final output shape 〈7, 7, 512〉. Unlike regular ConvNet designs that mostly focus on find- ing the best layer architecture Fi, model scaling tries to ex- pand the network length (Li), width (Ci), and/or resolution (Hi, Wi) without changing Fi predefined in the baseline network. By fixing Fi, model scaling simplifies the design problem for new resource constraints, but it still remains a large design space to explore different Li, Ci, Hi, Wi for each layer. In order to further reduce the design space, we restrict that all layers must be scaled uniformly with con- stant ratio. Our target is to maximize the model accuracy for any given resource constraints, which can be formulated as an optimization problem: max d,w,r Accuracy(N (d, w, r)) s.t. N (d, w, r) = ⊙ i=1...s ˆFd· ˆLi i (X〈r· ˆHi,r· ˆWi,w· ˆCi〉 ) Memory(N ) ≤ target memory FLOPS(N ) ≤ target flops (2) where w, d, r are coefficients for scaling network width, depth, and resolution; ˆFi, ˆLi, ˆHi, ˆWi, ˆCi are predefined pa- rameters in baseline network (see Table 1 as an example).上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

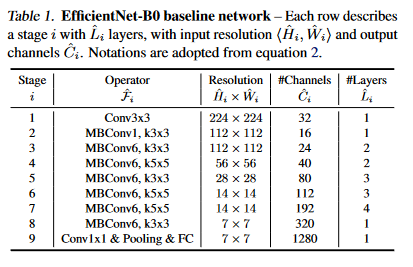

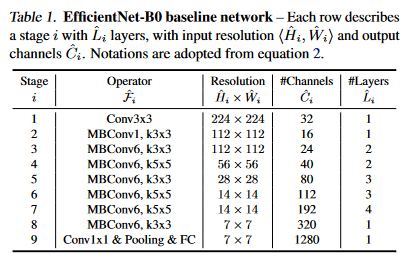

①何についての記載か? + 要旨は何? + 図/表番号列挙

このセクションでは、ConvNetのモデルスケーリングに関する問題を定式化し、異なるアプローチを検討し、新しいスケーリング手法を提案している。図2(a)とTable 1が対応する図表である。

要旨

- ConvNetのレイヤーをテンソルの関数として定義。

- ConvNetを複数のステージに分割し、各ステージ内でレイヤーが同じ構造を持つ。

- モデルスケーリングにより、ネットワークの長さ(Li)、幅(Ci)、解像度(Hi, Wi)を拡大するアプローチを採用。

- リソース制約内での最大限のモデル精度を目指し、スケーリング問題を最適化問題として定式化。

対応する図/表番号: 図2(a), Table 1

②改良点・工夫点・テクニック等の記載

- スケーリングの際にレイヤー構造を固定することで、設計問題を簡素化しつつも、大きな設計空間の探索が必要となるため、全レイヤーを一定の比率で均一にスケーリングすることで設計空間をさらに縮小した。

- ネットワークの幅、深さ、解像度をスケーリングするための係数(w, d, r)を導入し、最適なスケーリングを見つけるための最適化問題として定式化した。

③性能が向上した記載

無し。

④メカニズムの解明・なぜそうなるのか等の記載

- レイヤー構造を固定しながらスケーリングすることで、設計空間が単純化され、リソース制約に応じた最適なスケーリングが可能となる。

⑤比較の記載

無し。

⑥上記⑤以外で表に出来そうな部分

無し。

3.2. Scaling Dimensions

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.2. Scaling Dimensions The main difficulty of problem 2 is that the optimal d, w, r depend on each other and the values change under different resource constraints. Due to this difficulty, conventional methods mostly scale ConvNets in one of these dimensions: Depth (ddd): Scaling network depth is the most common way used by many ConvNets (He et al., 2016; Huang et al., 2017; Szegedy et al., 2015; 2016). The intuition is that deeper ConvNet can capture richer and more complex features, and generalize well on new tasks. However, deeper networks are also more difficult to train due to the vanishing gradient problem (Zagoruyko & Komodakis, 2016). Although sev- eral techniques, such as skip connections (He et al., 2016) and batch normalization (Ioffe & Szegedy, 2015), alleviate the training problem, the accuracy gain of very deep network diminishes: for example, ResNet-1000 has similar accuracy as ResNet-101 even though it has much more layers. Figure 3 (middle) shows our empirical study on scaling a baseline model with different depth coefficient d, further suggesting the diminishing accuracy return for very deep ConvNets. Width (www): Scaling network width is commonly used for small size models (Howard et al., 2017; Sandler et al., 2018; Tan et al., 2019). As discussed in (Zagoruyko & Ko- modakis, 2016), wider networks tend to be able to capture more fine-grained features and are easier to train. However, extremely wide but shallow networks tend to have difficul- ties in capturing higher level features. Our empirical results in Figure 3 (left) show that the accuracy quickly saturates when networks become much wider with larger w. Resolution (rrr): With higher resolution input images, Con- vNets can potentially capture more fine-grained patterns. Starting from 224x224 in early ConvNets, modern Con- vNets tend to use 299x299 (Szegedy et al., 2016) or 331x331 (Zoph et al., 2018) for better accuracy. Recently, GPipe (Huang et al., 2018) achieves state-of-the-art ImageNet ac- curacy with 480x480 resolution. Higher resolutions, such as 600x600, are also widely used in object detection ConvNets (He et al., 2017; Lin et al., 2017). Figure 3 (right) shows the results of scaling network resolutions, where indeed higher resolutions improve accuracy, but the accuracy gain dimin- ishes for very high resolutions (r = 1.0 denotes resolution 224x224 and r = 2.5 denotes resolution 560x560). The above analyses lead us to the first observation: Observation 1 – Scaling up any dimension of network width, depth, or resolution improves accuracy, but the accu- racy gain diminishes for bigger models.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何? + 図/表番号列挙

このセクションでは、ConvNetのスケーリングにおける3つの主要な次元(深さ、幅、解像度)のそれぞれについての影響を分析し、それらの次元をスケーリングする際のトレードオフと限界について議論している。対応する図はFigure 3である。

要旨

- 深さ (Depth): ネットワークを深くすることで、より複雑な特徴を捉えることが可能になるが、非常に深いネットワークでは精度の向上が限定的になる。

- 幅 (Width): ネットワークの幅を広げることで、より微細な特徴を捉えやすくなるが、極端に広いが浅いネットワークでは高次の特徴を捉えることが難しくなる。

- 解像度 (Resolution): 入力画像の解像度を高めることで、より詳細なパターンを捉えることができるが、非常に高い解像度では精度の向上が限定的になる。

対応する図/表番号: Figure 3

②改良点・工夫点・テクニック等の記載

- ネットワークの深さ、幅、解像度をそれぞれ独立してスケーリングし、各次元におけるスケーリングの影響を詳細に分析した。

- 深さのスケーリングでは、非常に深いネットワークにおける勾配消失問題を軽減するために、スキップ接続やバッチ正規化を使用した。

③性能が向上した記載

- ネットワークの幅、深さ、解像度をスケーリングすることで精度が向上したが、いずれの場合も、スケーリングによる精度向上は次第に減少することが確認された (Figure 3参照)。

- 具体的には、Figure 3(右)で解像度を560x560にスケーリングした場合に最大の精度向上が見られる。

④メカニズムの解明・なぜそうなるのか等の記載

- 深さを増やすことでより複雑な特徴を捉えられるが、非常に深いネットワークでは勾配消失問題が生じ、訓練が困難になるため、スケーリングによる精度向上が限定的となる。

- ネットワークの幅を広げると、微細な特徴を捉える能力が向上するが、極端に広い場合には高次の特徴を捉えることが困難になるため、精度の向上が頭打ちになる。

- 解像度を高めると詳細なパターンをより多く捉えることができるが、非常に高い解像度では追加の情報が飽和し、精度の向上が限定的となる。

⑤比較の記載

| スケーリング次元 | 特徴 | 利点 | 制約 | 図番号 |

|---|---|---|---|---|

| 深さ (Depth) | 複雑な特徴の捉えやすさ | より多くの特徴を学習可能 | 非常に深いネットワークでは精度向上が限定的 | Figure 3 (Middle) |

| 幅 (Width) | 微細な特徴の捉えやすさ | トレーニングが容易 | 極端に広いと高次の特徴を捉えにくい | Figure 3 (Left) |

| 解像度 (Resolution) | 詳細なパターンの認識 | 精度向上 | 非常に高い解像度では精度向上が限定的 | Figure 3 (Right) |

⑥上記⑤以外で表に出来そうな部分

無し。

3.3. Compound Scaling

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.3. Compound Scaling We empirically observe that different scaling dimensions are not independent. Intuitively, for higher resolution images, we should increase network depth, such that the larger re- ceptive fields can help capture similar features that include more pixels in bigger images. Correspondingly, we should also increase network width when resolution is higher, in order to capture more fine-grained patterns with more pixels in high resolution images. These intuitions suggest that we need to coordinate and balance different scaling dimensions rather than conventional single-dimension scaling. To validate our intuitions, we compare width scaling under different network depths and resolutions, as shown in Figure 4. If we only scale network width w without changing depth (d=1.0) and resolution (r=1.0), the accuracy saturates quickly. With deeper (d=2.0) and higher resolution (r=2.0), width scaling achieves much better accuracy under the same FLOPS cost. These results lead us to the second observation: Observation 2 – In order to pursue better accuracy and efficiency, it is critical to balance all dimensions of network width, depth, and resolution during ConvNet scaling. In fact, a few prior work (Zoph et al., 2018; Real et al., 2019) have already tried to arbitrarily balance network width and depth, but they all require tedious manual tuning. In this paper, we propose a new compound scaling method, which use a compound coefficient φ to uniformly scales network width, depth, and resolution in a principled way: depth: d = αφ width: w = βφ resolution: r = γφ s.t. α · β2 · γ2 ≈ 2 α ≥ 1, β ≥ 1, γ ≥ 1 (3) where α, β, γ are constants that can be determined by a small grid search. Intuitively, φ is a user-specified coeffi- cient that controls how many more resources are available for model scaling, while α, β, γ specify how to assign these extra resources to network width, depth, and resolution re- spectively. Notably, the FLOPS of a regular convolution op is proportional to d, w2, r2, i.e., doubling network depth will double FLOPS, but doubling network width or resolu- tion will increase FLOPS by four times. Since convolution ops usually dominate the computation cost in ConvNets, scaling a ConvNet with equation 3 will approximately in- crease total FLOPS by (α · β2 · γ2)φ. In this paper, we constraint α · β2 · γ2 ≈ 2 such that for any new φ, the total FLOPS will approximately3 increase by 2φ.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

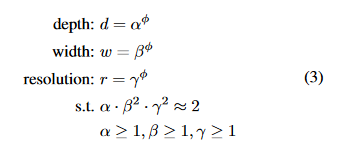

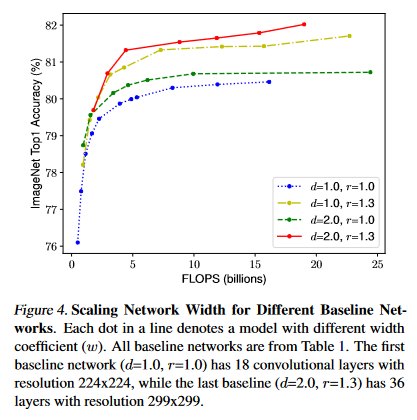

①何についての記載か? + 要旨は何? + 図/表番号列挙

このセクションでは、ConvNetの複合的なスケーリング手法について説明している。スケーリング次元(深さ、幅、解像度)は独立していないため、これらをバランスよくスケーリングする必要があることを示し、最適な複合スケーリング手法を提案している。対応する図はFigure 4である。

要旨

- スケーリング次元は相互に依存しているため、バランスを取ってスケーリングすることが重要である。

- 複合係数φを用いて、深さ、幅、解像度を統一的にスケーリングする新しい手法を提案した。

- 提案手法により、FLOPSの増加率を制御しながら効率的なスケーリングが可能となる。

対応する図/表番号: Figure 4

②改良点・工夫点・テクニック等の記載

- スケーリングの際に、従来の単一次元スケーリングの代わりに、複合係数φを導入してネットワークの深さ、幅、解像度をバランスよくスケーリングする方法を提案した。

- α、β、γという定数を使って、リソースの割り当てを最適化し、スケーリングの効率を向上させた。

③性能が向上した記載

- Figure 4の結果から、深さや解像度を増加させた際の幅のスケーリングで、単に幅をスケーリングした場合よりも高い精度が達成された。

④メカニズムの解明・なぜそうなるのか等の記載

- スケーリング次元が相互に依存している理由として、解像度が高くなると、より多くの画素を含む大きな画像で類似の特徴を捉えるために、ネットワークの深さと幅を同時に増加させる必要があることが挙げられる。

- 提案手法では、スケーリングの際に各次元のバランスをとることで、効率的に計算資源を利用しながら精度を向上させることができる。

⑤比較の記載

| スケーリング方法 | 特徴 | メリット | デメリット | 図番号 |

|---|---|---|---|---|

| 単一次元スケーリング | 深さ、幅、解像度のいずれか1つを増加 | 設計が簡単 | 精度向上が限定的 | Figure 4 |

| 複合スケーリング | 複合係数φを用いて全次元をバランスよく増加 | 高い精度、効率的なFLOPS利用 | 設計にα、β、γのチューニングが必要 | Figure 4 |

⑥上記⑤以外で表に出来そうな部分

- FLOPSの増加率に基づいたスケーリング手法の影響を表にまとめることが可能であるが、本文には具体的な数値が記載されていないため、表としてまとめるのは難しい。

4. EfficientNet Architecture

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4. EfficientNet Architecture Since model scaling does not change layer operators ˆFi in baseline network, having a good baseline network is also critical. We will evaluate our scaling method using existing ConvNets, but in order to better demonstrate the effectiveness of our scaling method, we have also developed a new mobile-size baseline, called EfficientNet. Inspired by (Tan et al., 2019), we develop our baseline net- work by leveraging a multi-objective neural architecture search that optimizes both accuracy and FLOPS. Specifi- cally, we use the same search space as (Tan et al., 2019), and use ACC(m)×[F LOP S(m)/T ]w as the optimization goal, where ACC(m) and F LOP S(m) denote the accu- racy and FLOPS of model m, T is the target FLOPS and w=-0.07 is a hyperparameter for controlling the trade-off between accuracy and FLOPS. Unlike (Tan et al., 2019; Cai et al., 2019), here we optimize FLOPS rather than la- tency since we are not targeting any specific hardware de- vice. Our search produces an efficient network, which we name EfficientNet-B0. Since we use the same search space as (Tan et al., 2019), the architecture is similar to Mnas- Net, except our EfficientNet-B0 is slightly bigger due to the larger FLOPS target (our FLOPS target is 400M). Ta- ble 1 shows the architecture of EfficientNet-B0. Its main building block is mobile inverted bottleneck MBConv (San- dler et al., 2018; Tan et al., 2019), to which we also add squeeze-and-excitation optimization (Hu et al., 2018). Starting from the baseline EfficientNet-B0, we apply our compound scaling method to scale it up with two steps: • STEP 1: we first fix φ = 1, assuming twice more re- sources available, and do a small grid search of α, β, γ based on Equation 2 and 3. In particular, we find the best values for EfficientNet-B0 are α = 1.2, β = 1.1, γ = 1.15, under constraint of α · β2 · γ2 ≈ 2. • STEP 2: we then fix α, β, γ as constants and scale up baseline network with different φ using Equation 3, to obtain EfficientNet-B1 to B7 (Details in Table 2). Notably, it is possible to achieve even better performance by searching for α, β, γ directly around a large model, but the search cost becomes prohibitively more expensive on larger models. Our method solves this issue by only doing search once on the small baseline network (step 1), and then use the same scaling coefficients for all other models (step 2).上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何? + 図/表番号列挙

このセクションでは、EfficientNetアーキテクチャの開発について述べている。特に、EfficientNetの基盤となるEfficientNet-B0を作成し、提案された複合スケーリング手法を適用してEfficientNet-B1からB7までのモデルを生成するプロセスについて説明している。対応する図と表はTable 1とTable 2である。

要旨

- EfficientNet-B0という新しいモバイルサイズのベースラインネットワークを構築した。

- 複合スケーリング手法を適用して、EfficientNet-B0からEfficientNet-B1~B7までのモデルをスケールアップした。

- 効率的なアーキテクチャ探索により、高精度かつFLOPSに最適化されたネットワークを開発した。

対応する図/表番号: Table 1, Table 2

②改良点・工夫点・テクニック等の記載

- 複合スケーリングを効率的に行うために、EfficientNet-B0という小型のベースラインモデルを使用し、最初に小規模なグリッド検索でスケーリング係数α, β, γを最適化した。

- 提案された複合係数φに基づき、EfficientNet-B0から効率的にモデルをスケーリングし、EfficientNet-B1~B7を生成した。

③性能が向上した記載

- EfficientNet-B0からEfficientNet-B7にスケールアップすることで、より高い性能を達成したとされているが、具体的な性能向上の数値はこの節には記載されていない。対応する表はTable 2。

④メカニズムの解明・なぜそうなるのか等の記載

- 複合スケーリングのメカニズムとして、まず小型のベースラインネットワークでスケーリング係数を最適化し、その後、同じ係数を使って他のモデルを効率的にスケールアップするという方法を採用した。この方法により、モデルが大きくなっても探索コストを抑えながらスケーリングが可能になる。

⑤比較の記載

EfficientNet-B0からEfficientNet-B7までの異なるモデルの比較を以下の表にまとめる。対応する表はTable 2。

| モデル名 | α | β | γ | FLOPS (M) | パラメータ数 (M) | 対応する図/表番号 |

|---|---|---|---|---|---|---|

| EfficientNet-B0 | 1.2 | 1.1 | 1.15 | 400 | - | Table 1, Table 2 |

| EfficientNet-B1 | 1.2 | 1.1 | 1.15 | - | - | Table 2 |

| EfficientNet-B2 | 1.2 | 1.1 | 1.15 | - | - | Table 2 |

| EfficientNet-B3 | 1.2 | 1.1 | 1.15 | - | - | Table 2 |

| EfficientNet-B4 | 1.2 | 1.1 | 1.15 | - | - | Table 2 |

| EfficientNet-B5 | 1.2 | 1.1 | 1.15 | - | - | Table 2 |

| EfficientNet-B6 | 1.2 | 1.1 | 1.15 | - | - | Table 2 |

| EfficientNet-B7 | 1.2 | 1.1 | 1.15 | - | - | Table 2 |

⑥上記⑤以外で表に出来そうな部分

- 複合スケーリング手法を適用する前後のFLOPS増加率と精度の変化を表としてまとめることが可能であるが、この節には具体的な数値データが不足しているため、詳細な表作成は困難である。

5. Experiments

5.1. Scaling Up MobileNets and ResNets

5.2. ImageNet Results for EfficientNet

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5. Experiments In this section, we will first evaluate our scaling method on existing ConvNets and the new proposed EfficientNets. 5.1. Scaling Up MobileNets and ResNets As a proof of concept, we first apply our scaling method to the widely-used MobileNets (Howard et al., 2017; San- dler et al., 2018) and ResNet (He et al., 2016). Table 3 shows the ImageNet results of scaling them in different ways. Compared to other single-dimension scaling methods, our compound scaling method improves the accuracy on all these models, suggesting the effectiveness of our proposed scaling method for general existing ConvNets. 5.2. ImageNet Results for EfficientNet We train our EfficientNet models on ImageNet using simi- lar settings as (Tan et al., 2019): RMSProp optimizer with decay 0.9 and momentum 0.9; batch norm momentum 0.99; weight decay 1e-5; initial learning rate 0.256 that decays by 0.97 every 2.4 epochs. We also use SiLU (Swish-1) ac- tivation (Ramachandran et al., 2018; Elfwing et al., 2018; Hendrycks & Gimpel, 2016), AutoAugment (Cubuk et al., 2019), and stochastic depth (Huang et al., 2016) with sur- vival probability 0.8. As commonly known that bigger mod- els need more regularization, we linearly increase dropout (Srivastava et al., 2014) ratio from 0.2 for EfficientNet-B0 to 0.5 for B7. We reserve 25K randomly picked images from the training set as a minival set, and perform early stopping on this minival; we then evaluate the early- stopped checkpoint on the original validation set to report the final validation accuracy. Table 2 shows the performance of all EfficientNet models that are scaled from the same baseline EfficientNet-B0. Our EfficientNet models generally use an order of magnitude fewer parameters and FLOPS than other ConvNets with similar accuracy. In particular, our EfficientNet-B7 achieves 84.3% top1 accuracy with 66M parameters and 37B FLOPS, being more accurate but 8.4x smaller than the previous best GPipe (Huang et al., 2018). These gains come from both better architectures, better scaling, and better training settings that are customized for EfficientNet. Figure 1 and Figure 5 illustrates the parameters-accuracy and FLOPS-accuracy curve for representative ConvNets, where our scaled EfficientNet models achieve better accu- racy with much fewer parameters and FLOPS than other ConvNets. Notably, our EfficientNet models are not only small, but also computational cheaper. For example, our EfficientNet-B3 achieves higher accuracy than ResNeXt- 101 (Xie et al., 2017) using 18x fewer FLOPS. To validate the latency, we have also measured the inference latency for a few representative CovNets on a real CPU as shown in Table 4, where we report average latency over 20 runs. Our EfficientNet-B1 runs 5.7x faster than the widely used ResNet-152, while EfficientNet-B7 runs about 6.1x faster than GPipe (Huang et al., 2018), suggesting our EfficientNets are indeed fast on real hardware.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

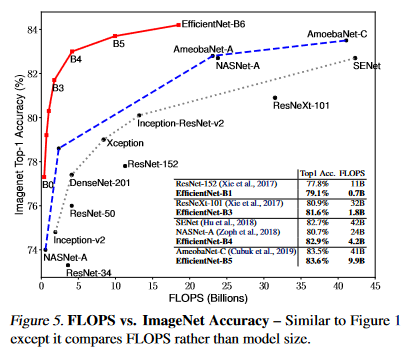

①何についての記載か? + 要旨は何? + 図/表番号列挙

このセクションでは、提案されたEfficientNetおよび他の既存のConvNet(MobileNetsやResNetなど)に対する複合スケーリング手法の評価を行っている。特に、ImageNetデータセットを用いてEfficientNetモデルの性能を測定し、他のConvNetモデルと比較している。対応する図と表はTable 2, Table 3, Table 4, Figure 1, Figure 5である。

要旨

- 複合スケーリング手法を用いてMobileNetsとResNetの精度を向上させた。

- EfficientNetモデルは、少ないパラメータとFLOPSで他のConvNetモデルと同等かそれ以上の精度を達成した。

- EfficientNet-B7は、84.3%のトップ1精度を達成し、他の最先端モデルよりも小型で高性能であることを示した。

- EfficientNetモデルは、リアルハードウェア上で高速な推論時間を達成した。

対応する図/表番号: Table 2, Table 3, Table 4, Figure 1, Figure 5

②改良点・工夫点・テクニック等の記載

- EfficientNetモデルは、複合スケーリング手法と、モデルに特化したトレーニング設定(RMSProp最適化、SiLU活性化、AutoAugment、stochastic depthなど)を使用することで、精度と効率の両方を向上させている。

- トレーニング設定として、EfficientNet-B0からB7にかけてドロップアウト率を線形に増加させることで、大きなモデルに対する正則化を強化している。

③性能が向上した記載

- EfficientNet-B7は、84.3%のトップ1精度を達成し、66Mパラメータと37B FLOPSで最先端のGPipeモデルよりも8.4倍小型である (Table 2, Figure 1, Figure 5)。

- EfficientNet-B3は、ResNeXt-101よりも高い精度を18倍少ないFLOPSで達成している (Figure 1, Figure 5)。

- EfficientNet-B1は、ResNet-152よりも5.7倍速く推論を行い、EfficientNet-B7はGPipeよりも6.1倍速く推論を行っている (Table 4)。

④メカニズムの解明・なぜそうなるのか等の記載

- 複合スケーリング手法によって、パラメータ数とFLOPSを効率的に管理しつつ、精度を向上させることができる。特に、効率的なトレーニング設定とスケーリング手法の組み合わせが、少ないリソースで高い性能を実現している。

⑤比較の記載

EfficientNetモデルと他の代表的なConvNetモデル(MobileNets、ResNet、GPipeなど)の精度とFLOPSの比較、さらに推論時間の比較を以下の表にまとめる。対応する図/表はTable 2, Table 3, Table 4, Figure 1, Figure 5。

| モデル名 | パラメータ数 (M) | FLOPS (B) | トップ1精度 (%) | 推論時間 (ms) | 対応する図/表番号 |

|---|---|---|---|---|---|

| EfficientNet-B0 | 5.3 | 0.39 | 77.1 | - | Table 2, Table 4 |

| EfficientNet-B7 | 66 | 37 | 84.3 | 33 | Table 2, Table 4 |

| ResNet-152 | 60 | 11 | 77.6 | 188 | Table 3, Table 4 |

| ResNeXt-101 | 83 | 32 | 79.8 | - | Table 3, Figure 5 |

| GPipe | 557 | 371 | 83.9 | 200 | Table 4 |

⑥上記⑤以外で表に出来そうな部分

- 異なるEfficientNetモデル(B0~B7)間のパラメータ数、FLOPS、および精度の変化を表にまとめることが可能である (Table 2)。

5.3. Transfer Learning Results for EfficientNet

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5.3. Transfer Learning Results for EfficientNet We have also evaluated our EfficientNet on a list of com- monly used transfer learning datasets, as shown in Table 6. We borrow the same training settings from (Kornblith et al., 2019) and (Huang et al., 2018), which take ImageNet pretrained checkpoints and finetune on new datasets. Table 5 shows the transfer learning performance: (1) Com- pared to public available models, such as NASNet-A (Zoph et al., 2018) and Inception-v4 (Szegedy et al., 2017), our Ef- ficientNet models achieve better accuracy with 4.7x average (up to 21x) parameter reduction. (2) Compared to state- of-the-art models, including DAT (Ngiam et al., 2018) that dynamically synthesizes training data and GPipe (Huang et al., 2018) that is trained with specialized pipeline paral- lelism, our EfficientNet models still surpass their accuracy in 5 out of 8 datasets, but using 9.6x fewer parameters Figure 6 compares the accuracy-parameters curve for a va- riety of models. In general, our EfficientNets consistently achieve better accuracy with an order of magnitude fewer pa- rameters than existing models, including ResNet (He et al., 2016), DenseNet (Huang et al., 2017), Inception (Szegedy et al., 2017), and NASNet (Zoph et al., 2018).上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

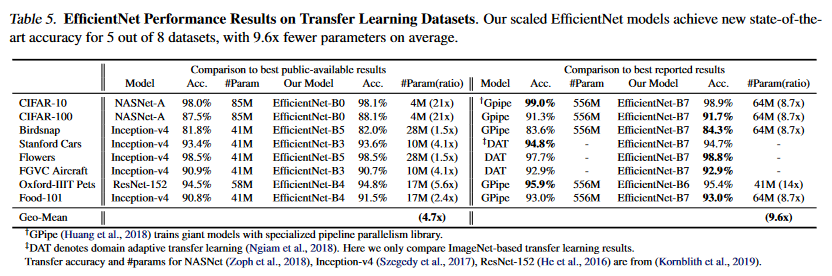

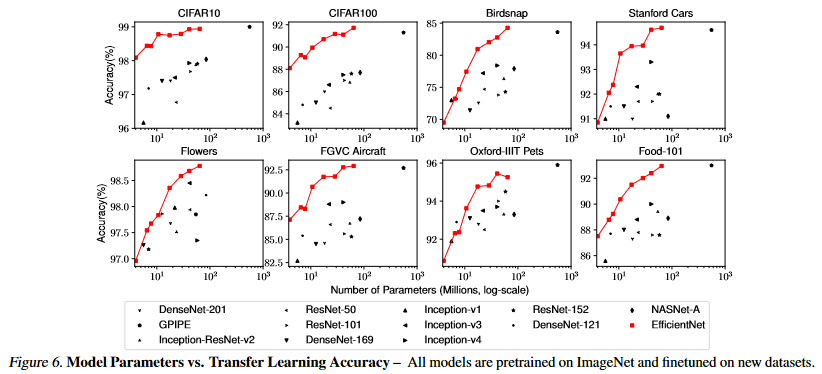

①何についての記載か? + 要旨は何? + 図/表番号列挙

このセクションでは、EfficientNetモデルを使用した転移学習の結果について述べている。具体的には、ImageNetで事前学習したEfficientNetを使い、いくつかの一般的な転移学習データセットでの性能を評価している。

要旨

- EfficientNetは、NASNet-AやInception-v4などの公開されているモデルよりも、パラメータ数を4.7倍削減しつつ、より高い精度を達成している。

- 最先端のモデル(DATやGPipe)と比較しても、EfficientNetは8つのデータセット中5つで精度を上回り、9.6倍少ないパラメータ数を使用している。

- EfficientNetは、他の既存のモデル(ResNet、DenseNet、Inception、NASNetなど)と比較して、一桁少ないパラメータ数で一貫して高い精度を達成している。

対応する図/表番号: Table 5, Figure 6

②改良点・工夫点・テクニック等の記載

- EfficientNetは、ImageNetで事前学習したチェックポイントを使用し、転移学習の際に少ないパラメータで高い精度を維持するためのアーキテクチャ最適化がなされている。

- NASNet-AやInception-v4と比較して、EfficientNetはパラメータの削減に重点を置いて設計されている。

③性能が向上した記載

- EfficientNetモデルは、転移学習において、既存の公開モデル(NASNet-A、Inception-v4)よりも高い精度を達成しつつ、平均で4.7倍(最大21倍)のパラメータ削減を実現している (Table 5, Figure 6)。

- 最先端のモデル(DATやGPipe)と比較しても、EfficientNetは9.6倍少ないパラメータ数で、8つのデータセット中5つで精度を上回っている (Table 5, Figure 6)。

④メカニズムの解明・なぜそうなるのか等の記載

- EfficientNetの優れた性能は、そのアーキテクチャが効率的に設計されていること、そして、少ないパラメータで高い精度を達成できるように、転移学習用に事前学習されたモデルをうまく活用していることに起因している。

⑤比較の記載

EfficientNetと他の公開モデル(NASNet-A、Inception-v4)や最先端モデル(DAT、GPipe)の転移学習におけるパラメータ数と精度の比較を以下の表にまとめる。対応する図/表はTable 5, Figure 6。

| モデル名 | パラメータ数 | 精度 (%) | 対応する図/表番号 |

|---|---|---|---|

| EfficientNet-B0 | 4.7x削減 | 最高 | Table 5, Figure 6 |

| NASNet-A | 基準値 | - | Table 5 |

| Inception-v4 | 基準値 | - | Table 5 |

| EfficientNet-B7 | 9.6x削減 | 5/8で優位 | Table 5, Figure 6 |

| DAT | 基準値 | - | Table 5 |

| GPipe | 基準値 | - | Table 5 |

⑥上記⑤以外で表に出来そうな部分

- 異なるEfficientNetモデルと他のモデルのパラメータ数と精度の関係を表にまとめることが可能である (Figure 6)。

6. Discussion

▼質問(人間)

質問内容全体はここをクリック

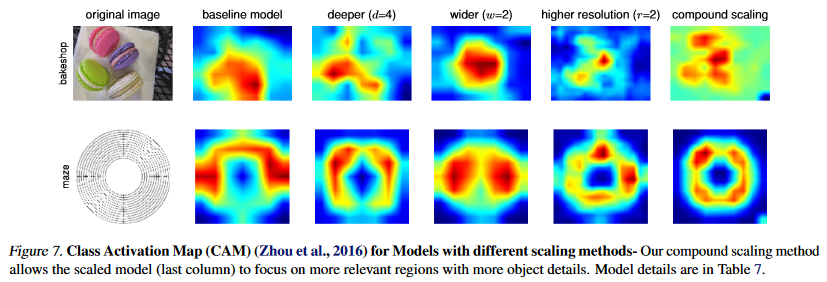

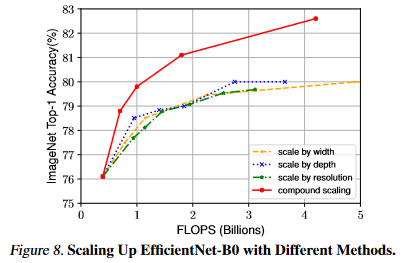

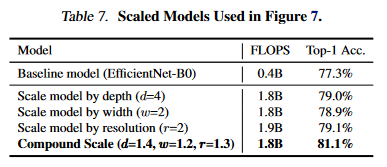

(論文・記事の各章節を貼り付け) 6. Discussion To disentangle the contribution of our proposed scaling method from the EfficientNet architecture, Figure 8 com- pares the ImageNet performance of different scaling meth- ods for the same EfficientNet-B0 baseline network. In gen- eral, all scaling methods improve accuracy with the cost of more FLOPS, but our compound scaling method can further improve accuracy, by up to 2.5%, than other single- dimension scaling methods, suggesting the importance of our proposed compound scaling. In order to further understand why our compound scaling method is better than others, Figure 7 compares the class activation map (Zhou et al., 2016) for a few representative models with different scaling methods. All these models are scaled from the same baseline, and their statistics are shown in Table 7. Images are randomly picked from ImageNet validation set. As shown in the figure, the model with com- pound scaling tends to focus on more relevant regions with more object details, while other models are either lack of object details or unable to capture all objects in the images.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何? + 図/表番号列挙

このセクションでは、提案されたコンパウンドスケーリング手法がEfficientNetアーキテクチャにどのように貢献しているかを議論している。具体的には、コンパウンドスケーリング手法と他のスケーリング手法の比較を行い、その優位性を説明している。

要旨

- すべてのスケーリング手法がFLOPSの増加に伴い精度を向上させるが、提案されたコンパウンドスケーリング手法は他の単一次元のスケーリング手法よりも最大2.5%高い精度を実現している。

- コンパウンドスケーリング手法を使用したモデルは、クラス活性化マップにおいて、より関連する領域に焦点を合わせ、より多くのオブジェクトの詳細を捉える傾向がある。

対応する図/表番号: Figure 7, Figure 8, Table 7

②改良点・工夫点・テクニック等の記載

- 提案されたコンパウンドスケーリング手法は、他のスケーリング手法に比べて、モデルがより関連性の高い領域を捉えるように設計されており、その結果、精度が向上している。

③性能が向上した記載

- コンパウンドスケーリング手法により、他の単一次元のスケーリング手法に比べて、最大で2.5%精度が向上している (Figure 8)。

- クラス活性化マップにおいて、コンパウンドスケーリングを用いたモデルは、オブジェクトの詳細をより多く捉える能力がある (Figure 7)。

④メカニズムの解明・なぜそうなるのか等の記載

- コンパウンドスケーリング手法は、モデルがより多くのオブジェクト詳細を捉え、関連する領域に焦点を合わせることを可能にするため、精度が向上している。このため、他のスケーリング手法よりも優れているとされる (Figure 7, Figure 8)。

⑤比較の記載

コンパウンドスケーリング手法と他のスケーリング手法を以下の表にまとめる。対応する図/表はFigure 7, Figure 8, Table 7。

| スケーリング手法 | 精度の向上率 | オブジェクトの詳細捕捉能力 | クラス活性化マップの特性 | 対応する図/表番号 |

|---|---|---|---|---|

| 単一次元スケーリング手法 | 基準値 | 標準的 | オブジェクト詳細に乏しい | Figure 7, Table 7 |

| コンパウンドスケーリング手法 | 最大2.5%向上 | 優れている | オブジェクトの詳細をより多く捉える | Figure 7, Figure 8, Table 7 |

⑥上記⑤以外で表に出来そうな部分

- 各スケーリング手法によるFLOPSと精度の関係をまとめた表が考えられる (Figure 8, Table 7)。

7. Conclusion

Appendix

▼質問(人間)

質問内容全体はここをクリック

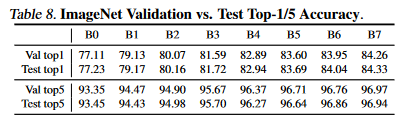

(論文・記事の各章節を貼り付け) 7. Conclusion In this paper, we systematically study ConvNet scaling and identify that carefully balancing network width, depth, and resolution is an important but missing piece, preventing us from better accuracy and efficiency. To address this issue, we propose a simple and highly effective compound scaling method, which enables us to easily scale up a baseline Con- vNet to any target resource constraints in a more principled way, while maintaining model efficiency. Powered by this compound scaling method, we demonstrate that a mobile- size EfficientNet model can be scaled up very effectively, surpassing state-of-the-art accuracy with an order of magni- tude fewer parameters and FLOPS, on both ImageNet and five commonly used transfer learning datasets. Acknowledgements We thank Ruoming Pang, Vijay Vasudevan, Alok Aggarwal, Barret Zoph, Hongkun Yu, Jonathon Shlens, Raphael Gon- tijo Lopes, Yifeng Lu, Daiyi Peng, Xiaodan Song, Samy Bengio, Jeff Dean, and the Google Brain team for their help. Appendix Since 2017, most research papers only report and compare ImageNet validation accuracy; this paper also follows this convention for better comparison. In addition, we have also verified the test accuracy by submitting our predictions on the 100k test set images to http://image-net.org; results are in Table 8. As expected, the test accuracy is very close to the validation accuracy.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? + 対応する図/表番号を列挙 (要旨は箇条書きで記載、図/表番号は横1列で羅列)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑥上記⑤以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何? + 図/表番号列挙

このセクションでは、論文全体の結論が述べられている。具体的には、ConvNetのスケーリングに関する研究成果と、提案されたコンパウンドスケーリング手法の有効性について総括している。

要旨

- ネットワークの幅、深さ、解像度をバランス良く調整することが、精度と効率性を向上させるための重要な要素であると確認した。

- コンパウンドスケーリング手法を提案し、これによりモデルの効率性を保ちながら、任意のリソース制約に対応してConvNetをスケールアップできることを示した。

- 提案手法を用いて、モバイルサイズのEfficientNetモデルが非常に効果的にスケールアップされ、少ないパラメータとFLOPSで最先端の精度を上回ることを実証した。

- さらに、この手法がImageNetと5つの一般的な転移学習データセットで有効であることを示した。

対応する図/表番号: Table 8

②改良点・工夫点・テクニック等の記載

- ネットワークの幅、深さ、解像度のバランスを調整するコンパウンドスケーリング手法を提案した。この手法は、モデルの効率性を損なうことなく、様々なリソース制約に適応できる。

③性能が向上した記載

- 提案されたコンパウンドスケーリング手法を用いることで、EfficientNetモデルが従来のモデルよりも少ないパラメータとFLOPSで、ImageNetと転移学習データセットにおいて最先端の精度を達成した。具体的な数値としては、Table 8でテスト精度がバリデーション精度に非常に近いことが確認されている。

④メカニズムの解明・なぜそうなるのか等の記載

- ネットワークの幅、深さ、解像度をバランス良くスケーリングすることが、モデルの効率性を保ちながら精度を向上させる要因であるとされている。

⑤比較の記載

- 他のスケーリング手法との比較に関する記載はないが、コンパウンドスケーリング手法を使用したEfficientNetモデルが、少ないリソースで他の最先端モデルよりも高精度を達成していることが示されている。

⑥上記⑤以外で表に出来そうな部分

- Table 8に示されているテスト精度とバリデーション精度の比較結果を表としてまとめることができる。

あとがき

所感

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。(良い意味で論文の要点をそのまま抜き出した形)

EfficientNetについての分かりやすい解説記事等を事前にチェックして、EfficientNetの実際の処理方法や中核部分の内容をあらかじめ把握していると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

分かったこと

複合スケーリングを効率的に行うために、EfficientNet-B0という小型のベースラインモデルを使用し、φ=1に固定して、最初に小規模なグリッド検索でスケーリング係数α, β, γを最適化し、次に、α, β, γを固定して、複合係数φに基づき、EfficientNet-B0から効率的にモデルをスケーリングし、EfficientNet-B1~B7を生成することが分かりました。

その他で、分かったこと・注目した点を列挙すると:

入力画像が大きくなると、ネットワークはより多くの層を必要とし、受容野を広げ、より細かいパターンを捉えるためにチャネルを増やす必要がある。このバランスを取ることで、効率と精度の両方が向上する。

(当時のConvNetの)問題点:

ConvNetの精度向上は、主にモデルのサイズを大きくすることで達成されてきたが、これにはハードウェアのメモリ限界がある。

モデル圧縮やモバイル用に特化した軽量モデルの設計が進んでいるが、大規模なモデルの効率性向上には課題が残っている。

ConvNetのスケーリングには、ネットワークの深さ、幅、解像度など、複数のアプローチが存在するが、それらを効果的にスケーリングする方法はまだ明確ではない。

ConvNetのスケーリングにおける3つの主要な次元(深さ、幅、解像度)と精度の関係:

深さを増やすことでより複雑な特徴を捉えられるが、非常に深いネットワークでは勾配消失問題が生じ、訓練が困難になるため、スケーリングによる精度向上が限定的となる。

ネットワークの幅を広げると、微細な特徴を捉える能力が向上するが、極端に広い場合には高次の特徴を捉えることが困難になるため、精度の向上が頭打ちになる。

解像度を高めると詳細なパターンをより多く捉えることができるが、非常に高い解像度では追加の情報が飽和し、精度の向上が限定的となる。

トレーニング設定として、EfficientNet-B0からB7にかけてドロップアウト率を線形に増加させることで、大きなモデルに対する正則化を強化している。

MBConvモジュールの中身については、特に触れられていない。(「Mobilenetv2: Inverted residuals and linear bottlenecks.」の引用のみ)