こんにちは、Bright DataのCynthiaです。

ローカル環境では完璧に動作していたAIエージェントが、本番環境でWebサイトにアクセスした瞬間にブロックされてしまった経験はありませんか?

データ取得の失敗は、ワークフローの停止や出力の信頼性低下に直結します。

Webサイト側も、決して意地悪でブロックしているわけではありません。競合による価格情報のスクレイピング対策、サーバーリソースの保護、不審なトラフィックの排除など、正当な理由があります。

しかし厄介なのは、こうした防御システムが「悪意あるスクレイパー」と「あなたの有益なAIエージェント」を見分けられないことです。

この記事では、

- AIエージェントがブロックされる仕組み

- それを回避して安定運用するためのインフラ選定

- 倫理的なベストプラクティス

という3点について解説します。

なぜAIエージェントは「怪しい!」と判断されるのか

Webサイトの防御システムは、主に以下の4つの層でボットを検知しています。どれか一つでも引っかかれば、エージェントはブロックされます。

-

IPベースのレート制限 (IP-based rate limiting)

特定のIPアドレスからのリクエスト頻度を監視します。例えば「10秒間に50回」といった、人間では不可能な頻度のアクセスがあれば、即座にアラートが作動します。 -

ブラウザフィンガープリント (Browser fingerprinting)

JavaScriptを使用して、ヘッドレスブラウザ特有の痕跡を探します。

プラグインの欠如、不自然な画面解像度、WebGL機能の欠如などは、現代の検知システムに対して「私はボットです」と自己紹介しているようなものです。 -

振る舞い分析 (Behavioral analysis)

人間らしさに欠ける行動パターンを監視します。

クリック間のタイミングが完璧に一定だったり、マウスの動きが直線的すぎたり、フォーム入力が異常に速かったりする場合、こうした挙動はすぐに検知対象となります。 -

地理的な不整合 (Geographic inconsistencies)

「ニューヨークのユーザー」としてアクセスしているはずなのに、実際のIPアドレスがフランクフルトのデータセンターのものである場合、フラグが立てられます。

Webサイト側は、こうした防御を意図的に、まるで城壁のように多層で構築しています。この城壁の「たった一つの穴」でも対応を欠けば、エージェントは無慈悲にブロックされてしまいます。

エージェントがブロックされると、データが欠損したり、ワークフローが途中でストップしたり、最悪の場合、出力結果が不安定化するデータ取得の事故を引き起こします。

エージェントを常に安定稼働させ、ブロックされない状態で運用し続けるためには、これらの防御要因すべてに対応でき、ブロック発生時には即座に検知し、リカバリできる専用のインフラが必要不可欠です。

Webサイト側は、こうした防御を意図的に多層で構築しています。

どれか一つでも対応を欠けば、エージェントはブロックされてしまいます。

エージェントがブロックされると、取得データが欠けたり、ワークフローが途中で止まったり、出力結果が不安定になったりします。

エージェントを常にブロックされない状態で運用するためには、これらすべての要因に対応でき、ブロック発生時には即座に検知できる専用のインフラが必要です。

あなたのエージェントの目的に応じた適切なツールを選ぶことが重要です。

目的に応じたインフラの選び方

エージェントが何をするかによって、必要な「武器」は異なります。

1. 検索エンジンのデータ取得なら:SERP API

Googleなどの検索エンジの検索結果が必要な場合、自分でスクレイパーを構築し、プロキシを回転させ、HTMLパーサーを書くこともできますが、数時間でブロックされるのがオチです。

Bright DataのSERP APIを使えば、プロキシ管理やCAPTCHA対策、HTML解析を気にする必要がなくなります。

検索エンジンにブロックされる可能性が高いスクレイパーを自前で構築する代わりに、SERP APIコールを実行するだけで、結果をJSONまたはHTML形式でダイレクトに受け取ることができます。

このAPIを利用することで、

- クリーンな結果(トップニュース記事、リンク、スニペットなど)を返却する

- 適切な

hl(言語) およびgl(ロケーション) パラメータを設定するだけで、自動的に現地の検索結果を取得できます。

SERP APIを使って、データ取得のインフラ管理から解放され、より重要なビジネスロジックの開発に集中しましょう!

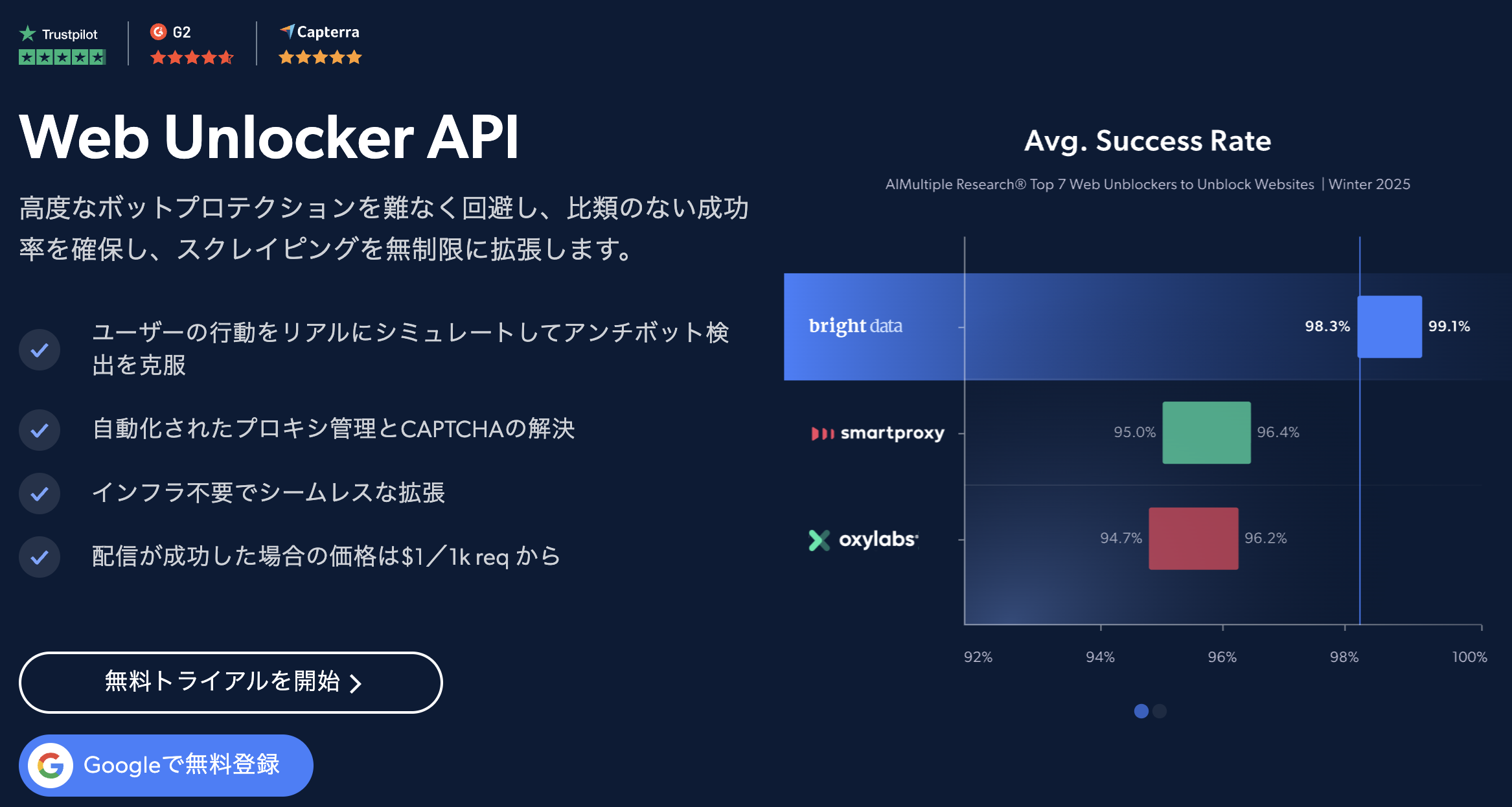

2. 一般的なWebサイトのスクレイピングなら:Web Unlocker

検索エンジン以外のサイトの場合、Bright DataのWeb Unlockerが「高度なプロキシレイヤー」として機能します。

仕組みはとてもシンプルです。

- リクエスト: ターゲットURLを送信するだけ。

- 処理: プロキシの回転、ブラウザフィンガープリント管理、各種アンチボット対策はサービス側が自動で処理。

- レスポンス: クリーンなHTMLまたはJSONを受け取る。

これによって、プロキシプールの構築・維持、ブラウザフィンガープリントの管理、ブロック内容に応じた再試行ロジックの実装、さらにはサイトごとに異なる回避手法の監視といった厄介な作業から完全に解放されます。

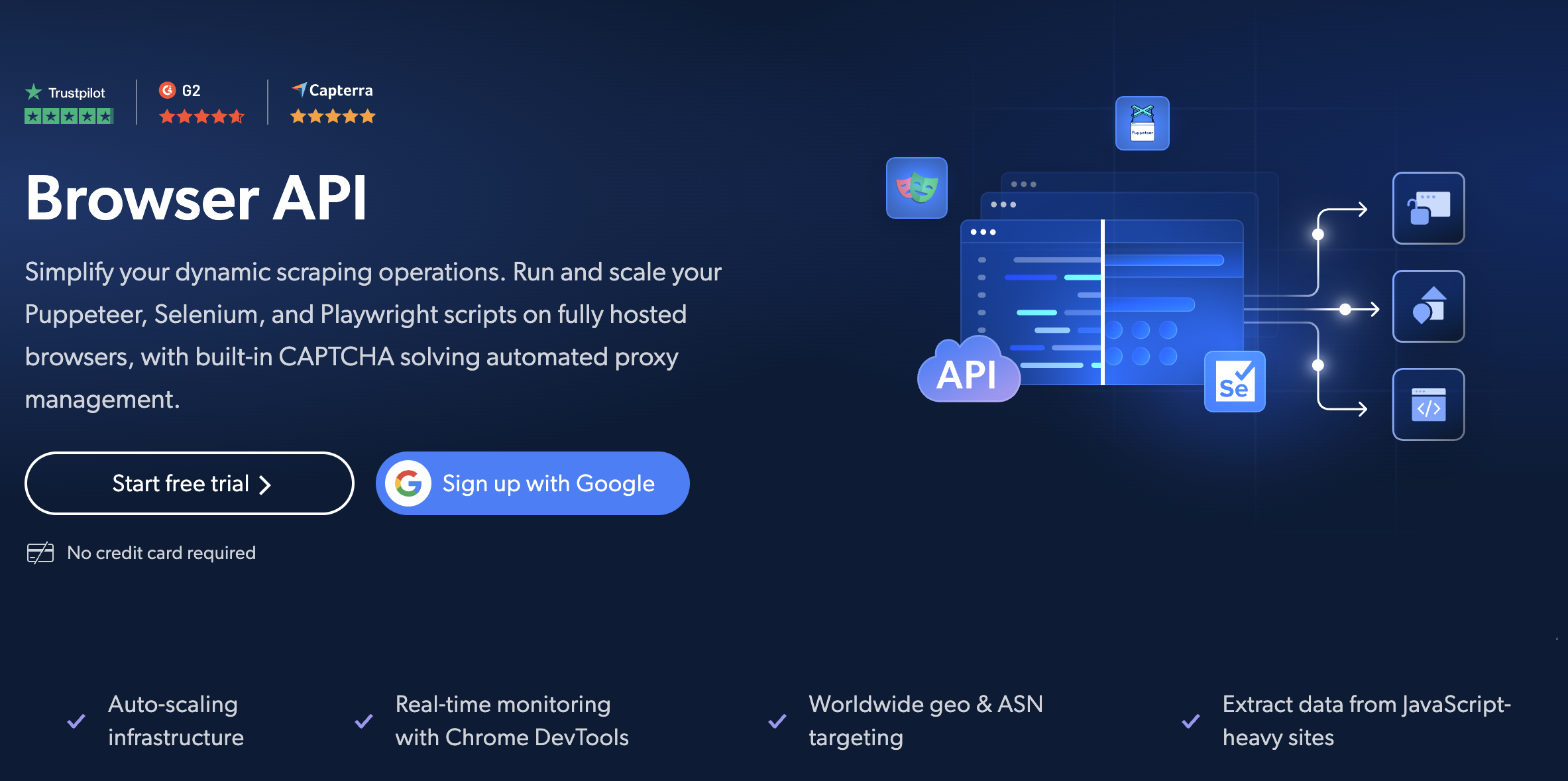

3. 複雑なインタラクションが必要なら:Browser API

単純なHTTPリクエストでは完結しないワークフローもありますよね。

ログイン、複数ステップのフォーム入力、無限スクロールの処理、JavaScriptでレンダリングされるコンテンツの待機などには、実際のブラウザ環境が必要です。

例えば、「旅行サイトにログインし、検索を実行し、無限スクロールで結果をページングしながらデータを取得する」といった操作をHTTPリクエストだけで実装するのは極めて困難です。

Bright DataのBrowser APIは、ヘッドレスブラウザ環境内でこれらの操作をスクリプト化できます。指紋認証やIPアドレスの自動回転、CAPTCHA処理をインフラ側が担当するため、あたかも「本物のブラウザ」のパワーと「Bright Dataのブロック回避基盤」の保護を同時に提供するものです。

エージェントをブロックさせないためのテクニック

適切なAPIを選ぶことは戦いの半分にすぎません。残りの半分は、スクレイピングのロジックとエージェントの設計におけるベストプラクティスです。

リクエスト速度の制御

エンタープライズ級のプロキシを使っていても、サイトに大量のリクエストを送れば防御システムが作動します。HTTP 429エラー(Too Many Requests)はまさに「炭鉱のカナリア」とも言える危険信号です。

そもそも、実際のユーザーが1秒間に100件もリクエストを送ることはありません。AIエージェントも同じで、「人間らしいペース」を守る必要があります。

そのため、次の点に気を付けましょう:

- 並列数の制限: ターゲットサイトへの並列接続は、3〜5件程度に抑えましょう。

-

429 Errorへの対応: エラーが出たらすぐに同時実行数を減らしてください。 - リクエストの平準化: トークンバケット方式やキューシステムを使用してリクエストを適切に間引き、急激なスパイク(アクセスの急増)を避けましょう。

堅牢なページネーション設計

検索結果や商品リストなど、複数ページにまたがるコンテンツを扱う場合は、次の点を意識しましょう。

-

ネイティブな仕組みを利用

サイト上の正規の「次へ」リンクを辿るか、公式のAPIエンドポイントやJSONベースのページネーションAPIを直接叩くなど、サイトが提供している本来の方法に従うのが基本です。

Bright DataのWeb Unlockerは、これらをシームレスに処理できます。 -

無限スクロールへの対応

無限スクロールや動的読み込みのサイトでは、Browser APIを使うことで、自然なブラウジングパターンを保ちながらスクロール操作をスクリプト化できます。 -

終了条件を明確にする

暴走的なスクレイピングを避けるため、最大ページ数を設定したり、新しい結果が返ってこなくなった時点で停止したり、同じコンテンツが繰り返し表示されたときに終了するなど、明確な停止ロジックを組み込んでおくことが重要です。

地理と言語のターゲティング

AIエージェントでサイトをスクレイピングする際は、そのサイトを利用しているユーザーの場所と言語を考慮する必要があります。

たとえばフランスのサイトであれば、フランスのIPを経由し、Accept-Languageヘッダーもフランス語に合わせるのが自然です。

なぜ重要なのか:

- 正確なデータが取れる: その地域の実際のユーザーが目にするコンテンツをそのまま取得でき、データの精度と関連性が高まります。

- ブロックを避けられる: ドイツのサイトに突然アメリカやアジアのIPから大量アクセスが来れば、アンチボットシステムは即座に異常と判断します。

Bright Data では、必要な国コードをプロキシに指定し、ローカライズ用パラメータ(Google検索ならhl/glなど)を設定するだけで、その地域のユーザープロファイルに自然に溶け込むアクセスが可能になります。

コンプライアンスと倫理の遵守

どれだけ強力でブロックされにくいAIエージェントを作ったとしても、法的・倫理的なルールを守ることは同じくらい重要です。

-

robots.txtと利用規約を遵守する

スクレイピングを始める前に、robots.txtで禁止されていないか必ず確認しましょう。法的拘束力が弱いケースでも、従うこと自体が誠実な運用姿勢につながります。 -

個人情報やセンシティブなデータを避ける

公開されている情報のみを収集するように設定してください。

非公開の個人データをスクレイピングすることはプライバシー規制に抵触する恐れがあります。 -

Bright Dataのコンプライアンス機能を活用する

Bright DataではKYC(顧客確認)プロセスやリアルタイム監視により、プロジェクトが正当であることを確認しています。

また、GDPR・CCPAをはじめとする主要なデータ保護法にも準拠しています。 -

透明性と説明責任を確保する

データ収集のログを適切に保持し、利用者から削除依頼があった場合に対応できる仕組みを用意しましょう。

とくにスクレイピングデータを使ったAPIやサービスを提供する場合は欠かせません。

まとめ:本番環境で動き続けるエージェントとは

PoCと本番システムの最大の違いは、どれだけ適切なインフラを備えているかにあります。

本番環境に安定して動作し続けるエージェントは、CAPTCHAやIPローテーションを自動処理するインフラを備え、指数バックオフ付きの再試行ロジック、適切な同時実行数制御、そして確実なセッション管理を組み合わせて構築されます。

Bright DataのWeb Unlocker、SERP API、Browser APIといった強力な基盤を活用すれば、最新のアンチボット対策はインフラ側で処理されるため、あなたはブロックと戦うのではなく、エージェントのロジック開発に集中できます。

本番環境でブロックされにくいAIエージェントを実現する鍵は、まさにこの基盤づくりにあります。

Bright Dataをご利用して、安定したデータパイプラインを構築し、AIエージェントの真の価値を引き出しましょう。

少しでもご興味がありましたら、ぜひ無料トライアルでお確かめください!

Bright Dataを今すぐ試しませんか (無料トライアルはこちら)

通常、新規登録後は「Playgroundモード」と呼ばれる無料トライアルが自動的に開始し、2ドルの少量クレジットが付与されます。期間限定で今回のリンクを経由して新規登録していただくと、通常の2ドルに加え、さらに10ドルのクレジットが付与されます!