やりたいこと

OSS の LLM をローカルで実行できる Ollama で以前はちょっとした作業が必要だった GGUF モデルを直接実行できるようになったようなので試してみます。

GGUF とは?

C 言語で用いられる機械学習用のライブラリである「GGML」で使われるバイナリ形式のファイル。モデルの重みやモデルのメタ情報なども保存でき、1ファイルだけで完結できるのがメリット。

llama.cpp でも使われていて、Ollama でも利用可能になっている。

実行してみる

以前、日本語の OSS モデルである ELYZA を Ollama で使ったので、それを今回も使ってみます。

その記事はこちら。Ollama のセットアップなどもこの記事を参考。

ELYZA の HaggingFace でのリポジトリはこちら。

Ollama で実行してみる。

docker exec -it ollama ollama run huggingface.co/elyza/Llama-3-ELYZA-JP-8B-GGUF

モデルのダウンロードが始まり、完了すると入力待ちになる! (時間はけっこうかかります)

>>> Send a message (/? for help)

ひとまずあいさつしてみる。

>>> こんにちは

こんにちは!お話ししましょうか?

非常に簡単ですね!

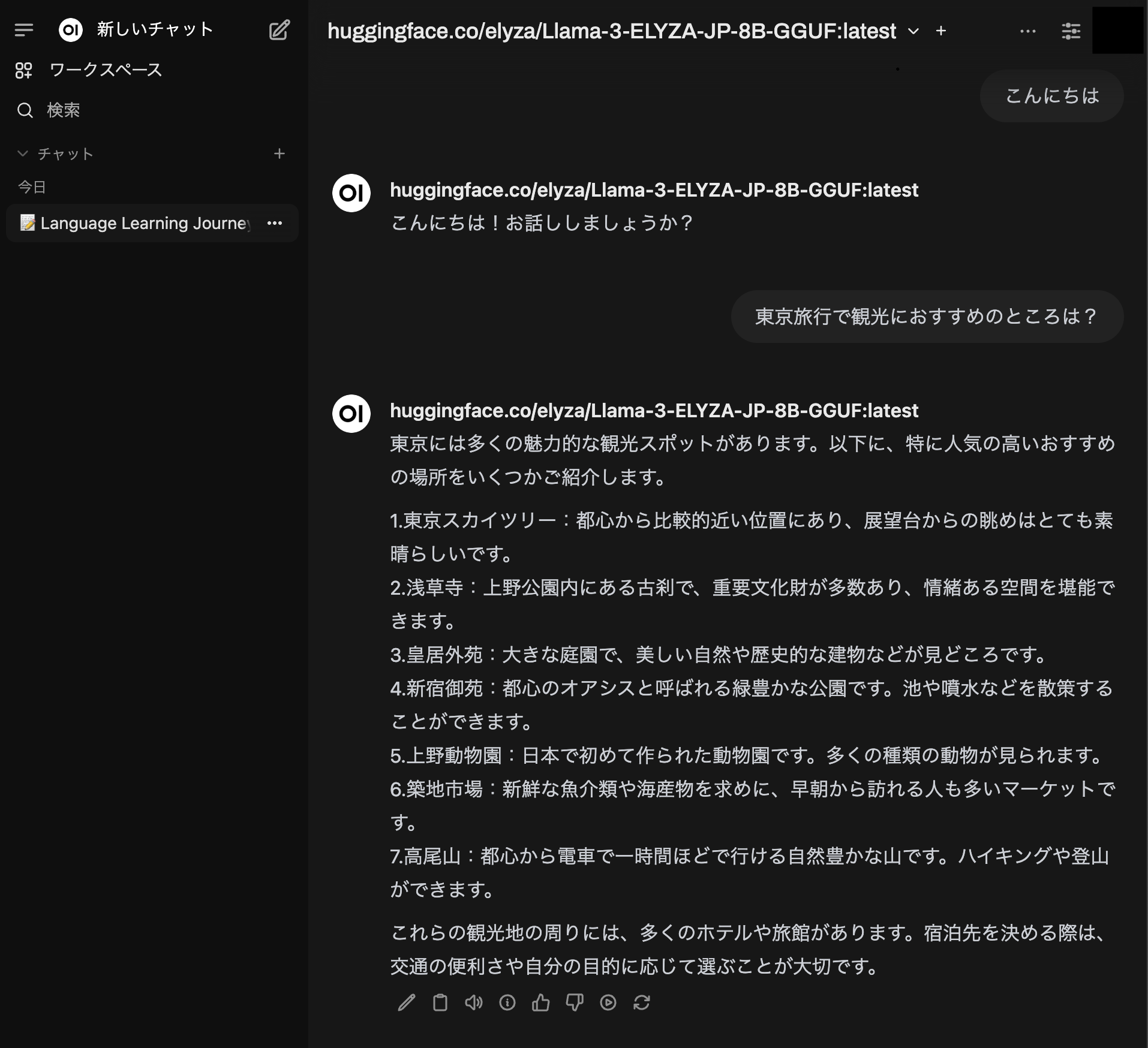

OpenWebUI でも利用可能!

ということで

Ollama で GGUF 形式のモデルを簡単に利用できるようになりました。以前まではひと手間必要だったのが地味にめんどくさかったのですが、非常に楽になりました。

セキュリティやデータプライバシーの関係で、LLM をセルフホストしたい場合などは助かりそうですね!

以上です。