Woo, Sanghyun and Park, Jongchan and Lee, Joon-Young and So Kweon, "CBAM: Convolutional Block Attention Module", in ECCV2018.Online PDF at CVF

1.どんなもの?

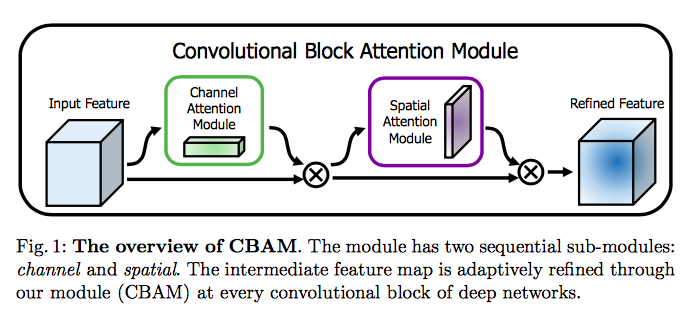

・Attention構造を組み込んだ畳み込みニューラルネットワークモジュールを提案

・特徴マップから、channelと空間の2つの別々の次元に沿ってAttentionマップを推定し、特徴マップとAttentionマップを乗算して新しい特徴マップを作る

・軽量なので色々なCNNに組み込むことができ、End-to-Endに学習が可能

・そのうちコードを公開する予定らしい

2.先行研究と比べて何がすごいか?

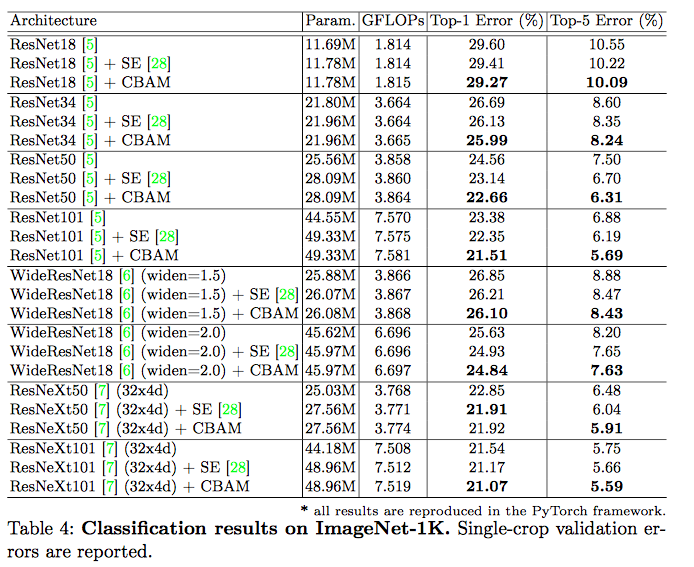

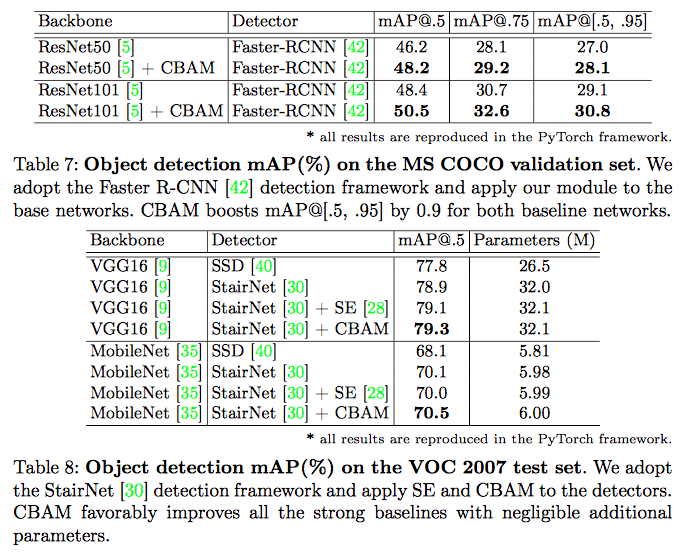

提案したモジュールを接続することにより、複数のベンチマーク(ImageNet-1K、MS COCO、およびVOC 2007)でさまざまなネットワークのパフォーマンスが向上したこと

3.技術や手法の肝はどこにあるか?

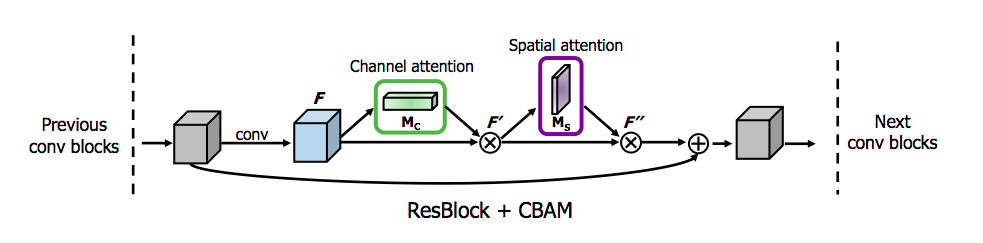

特徴マップに対してチャネル方向のAttentionを行なった後、spatial方向でAttentionをかける

$$ F \in R^{C\times H\times W},M_c \in R^{C\times 1 \times 1},M_s \in R^{1\times H \times W}$$

$$F'=M_c(F)\otimes F$$

$$F''=M_s(F')\otimes F'$$

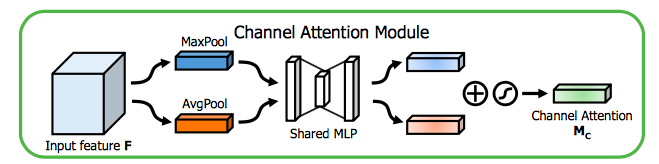

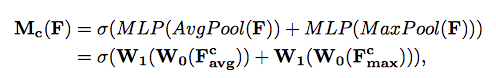

Channel Attention Module

チャネルの注目は、入力画像が与えられると意味があるものに焦点を当てる

平均値プーリングと最大値プーリングを行い、1つの隠れ層を有するMLPに入力し、出力された特徴ベクトルを足し合わせて新しい特徴ベクトルを作る

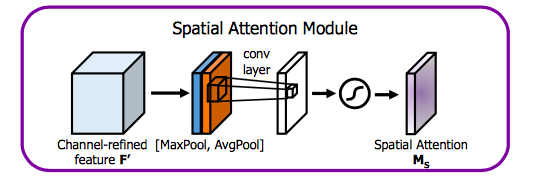

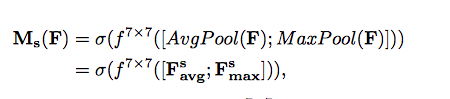

Spatial Attention Module

チャネルと組み合わせることで「何」が「どこ」にあるかについて焦点を当てる

チャネル方向に平均値プーリングと最大値プーリングを行い、フィルタサイズ7x7で畳み込みをすることで新しい特徴マップを作る

4.どうやって有効だと検証した?

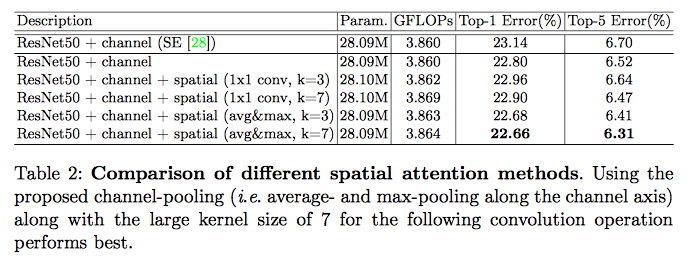

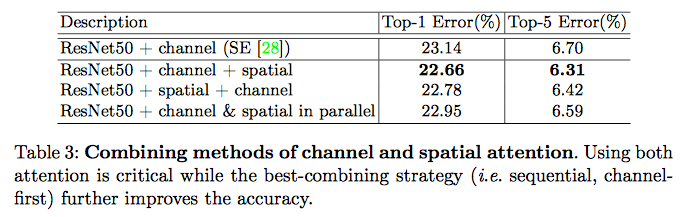

このネットワークを選択するに至った実験

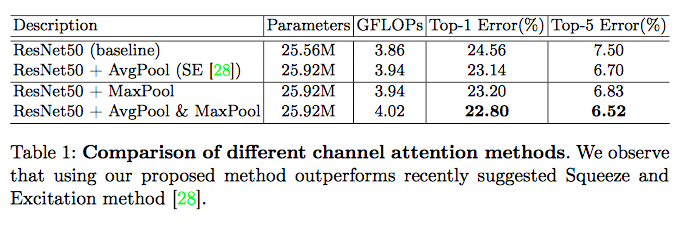

Channel方向のAttentionについて

2D Spatial方向のAttentionについて

二つのAttention構造を組み合わせる

実験

Squeeze-and-Excitation Networks(同じようなやつ)よりうまくいってるらしいpdf