やりたいこと

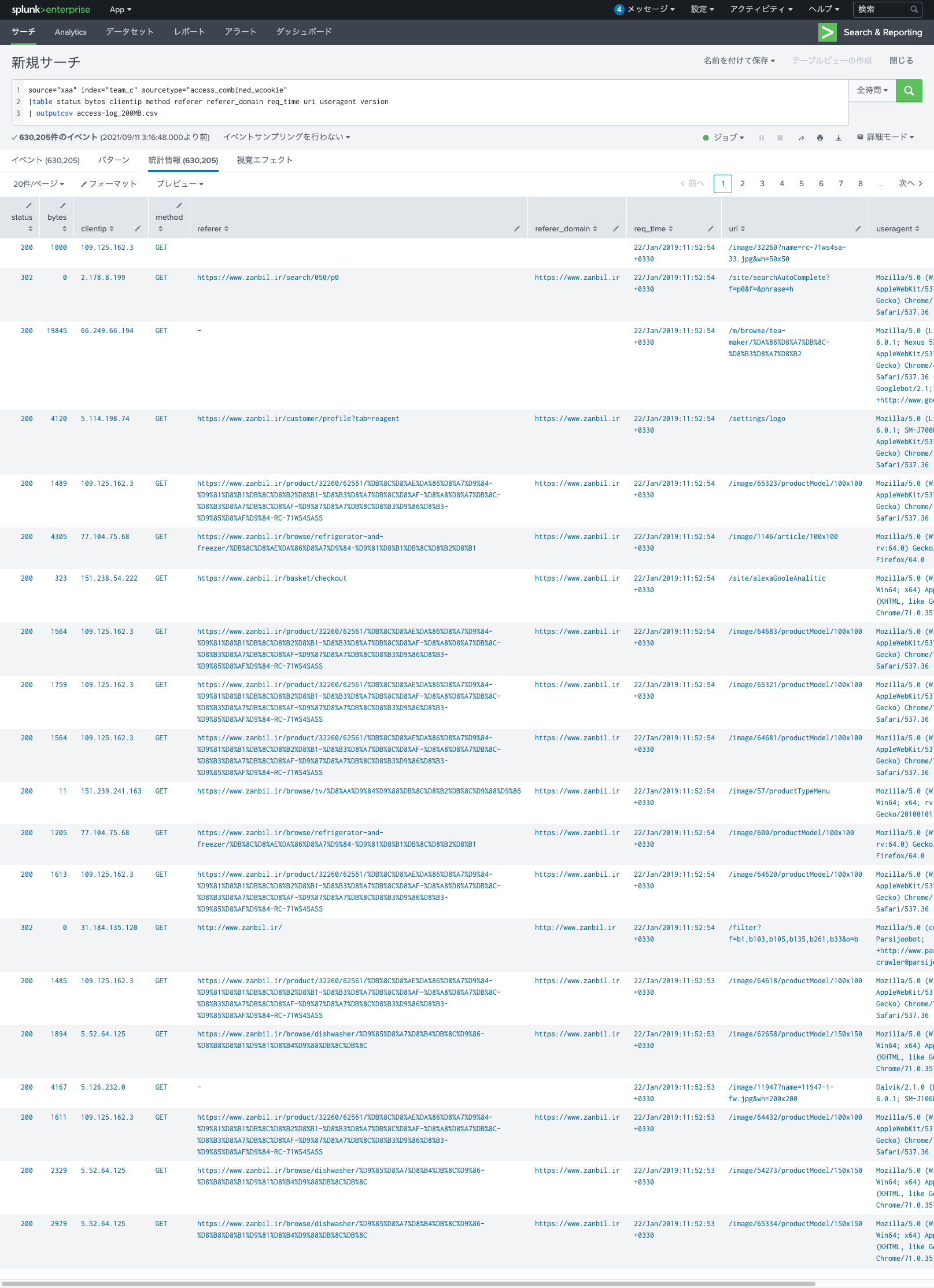

1.Splunkを使い、access.logをCSVに変換 ⇦今回の内容

2.CSVファイルをもとにJupyterLab上で教師データを作る

3.ディープラーニングを用いて、予測精度を確かめる

Splunkを使う理由

将来的にデータの自動取り込みを行うことを想定して、非構造化データの自動収集に定評のあるSplunkを選定。

あわせて、JupyterLabでアドホックに調査・分析・処理するにあたり、使い慣れているCSVファイル形式で行いたい。

環境

・JupyterLab 2.1.4 @ AWS Cloud9

・Python 3

・Splunk Enterprise 8.1 @ AWS EC2

データ取得

検証用で使うaccess.logを入手する。今回はKaggleから頂戴した。

ログファイルを解凍すると3.5GBほどあり、Splunkの無料枠では上限に達するため分割してから取り込むことに。

[ec2-user@ip-192-168-0-5 ~]$ split -b 200MB access.log

[ec2-user@ip-192-168-0-5 ~]$ ll

合計 5447932

-rw-rw-r-- 1 ec2-user ec2-user 3502440823 2月 13 2021 access.log

-rw-r--r-- 1 ec2-user ec2-user 277102492 9月 11 03:00 access.log.zip

-rw-rw-r-- 1 ec2-user ec2-user 200000000 9月 11 03:03 xaa

-rw-rw-r-- 1 ec2-user ec2-user 200000000 9月 11 03:03 xab

-rw-rw-r-- 1 ec2-user ec2-user 200000000 9月 11 03:03 xac

-rw-rw-r-- 1 ec2-user ec2-user 200000000 9月 11 03:03 xad

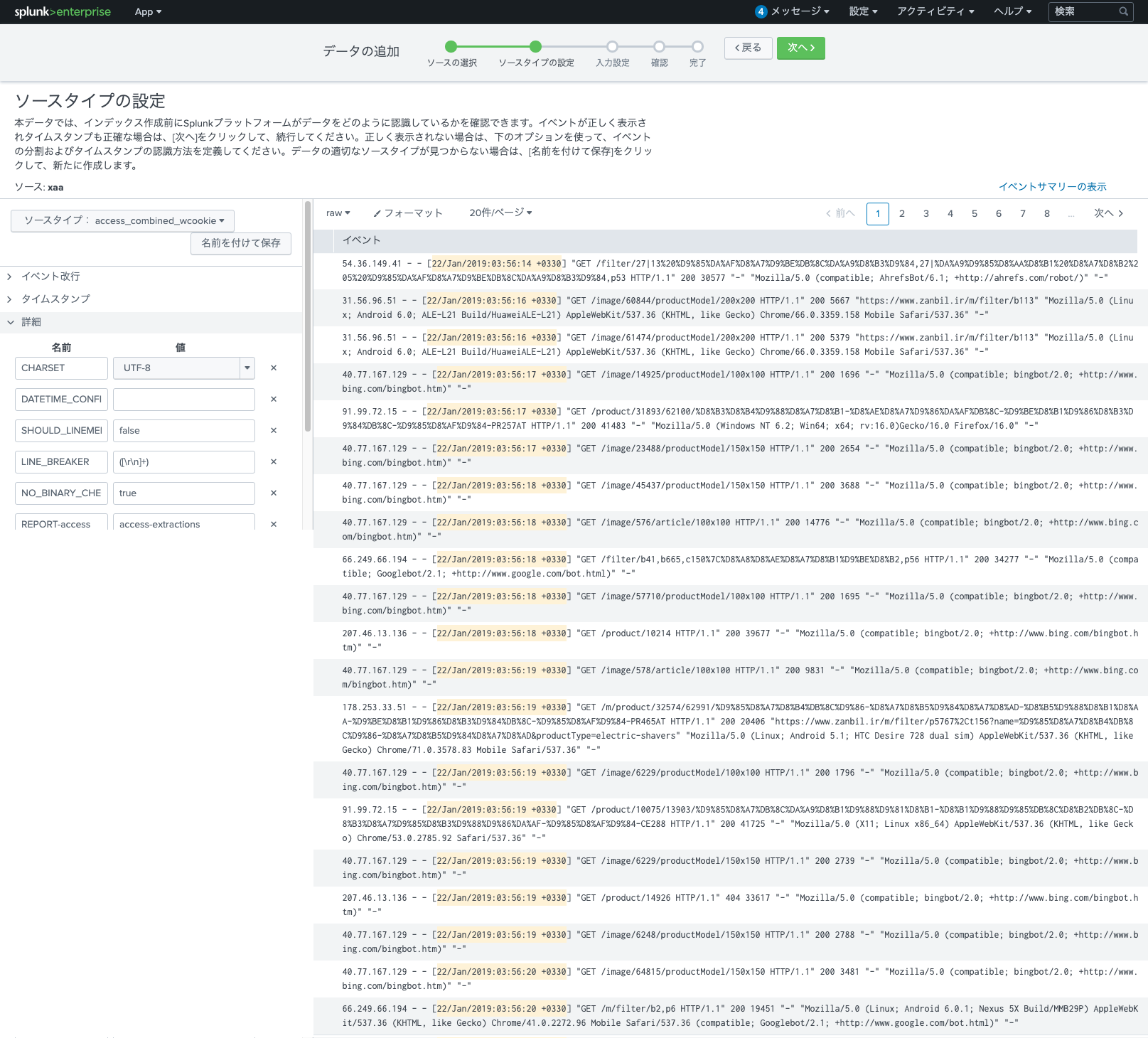

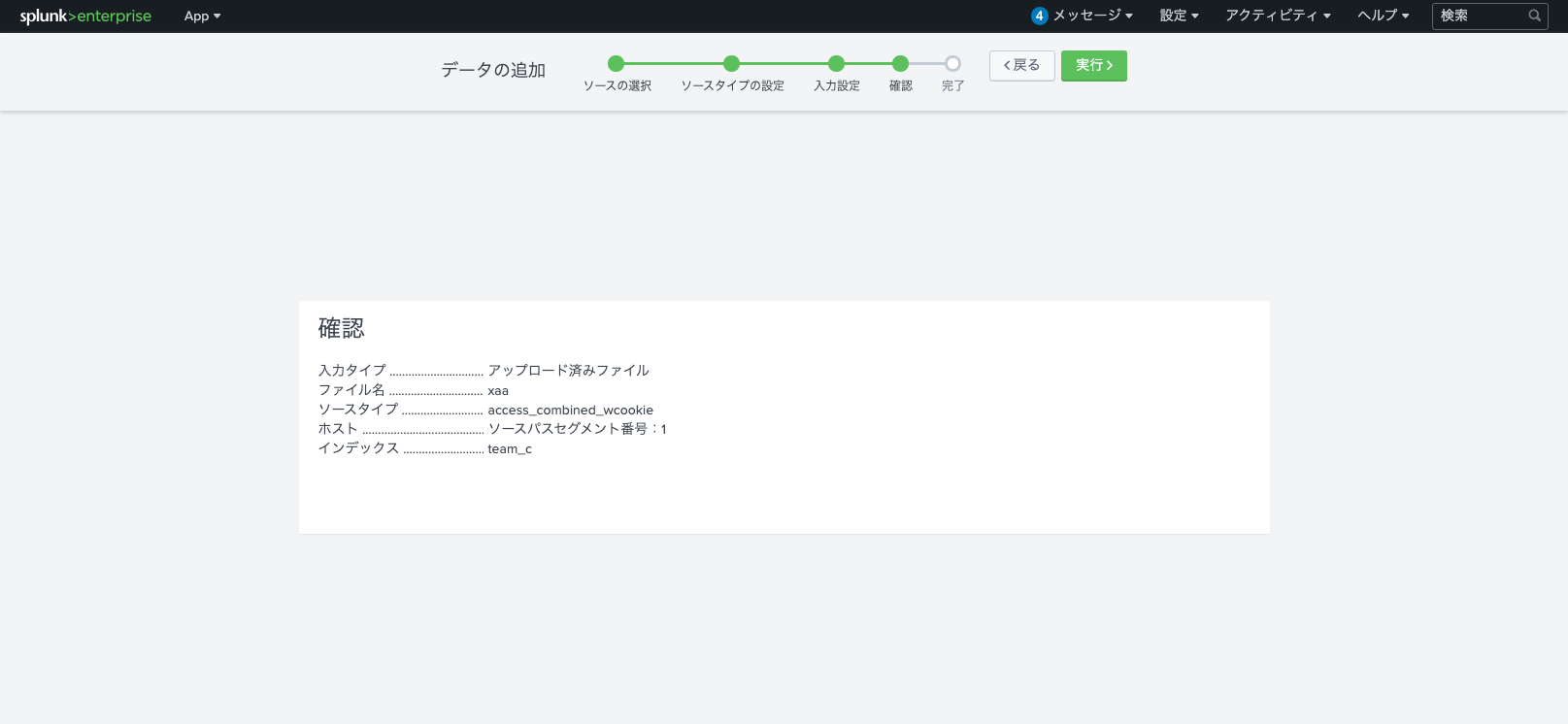

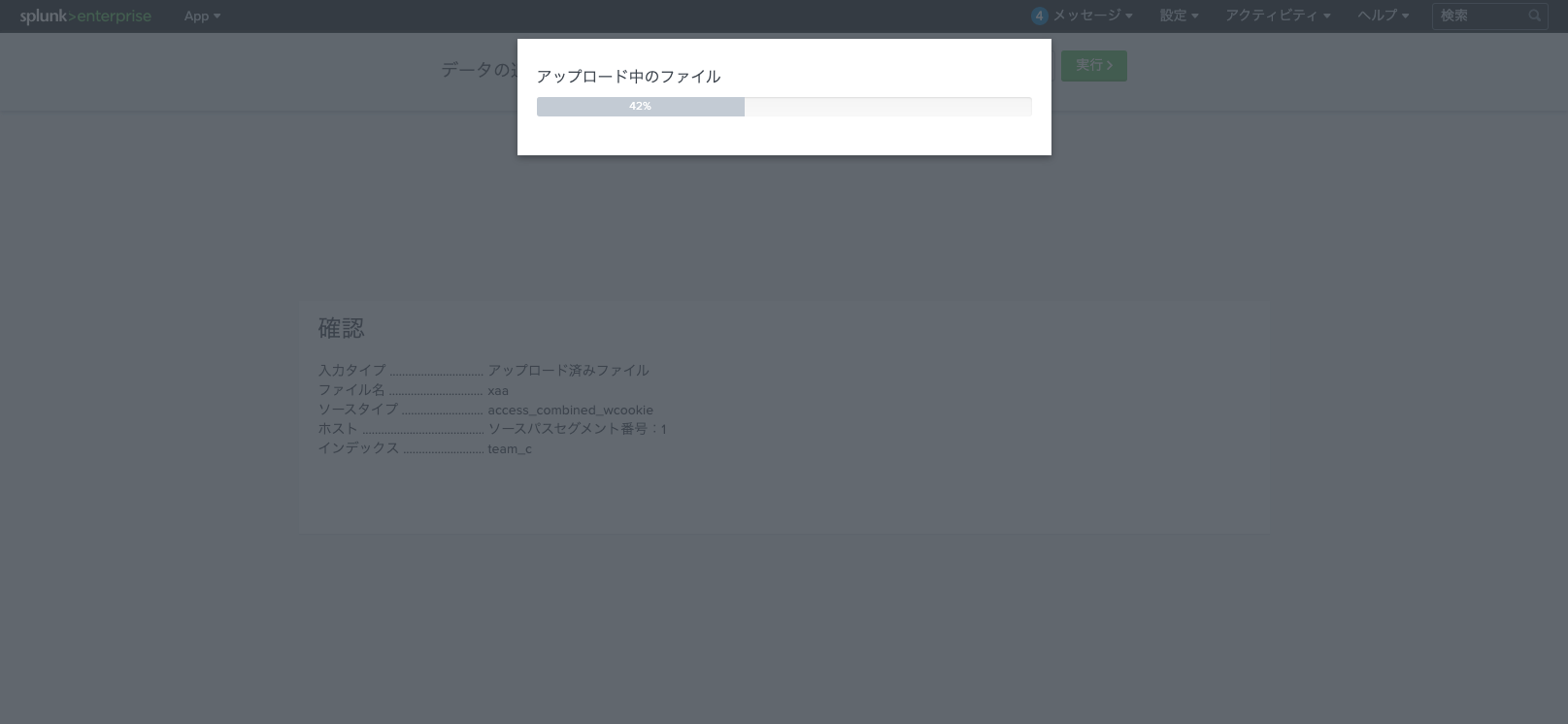

Splunk取り込み

分割したファイルの内、xaaファイルを利用した。

以後、Web GUIからアップデートを実施。