まえがき

pythonスクリプトを起動して、ブラウザからUI画面に入って操作できる仕組みのようです。

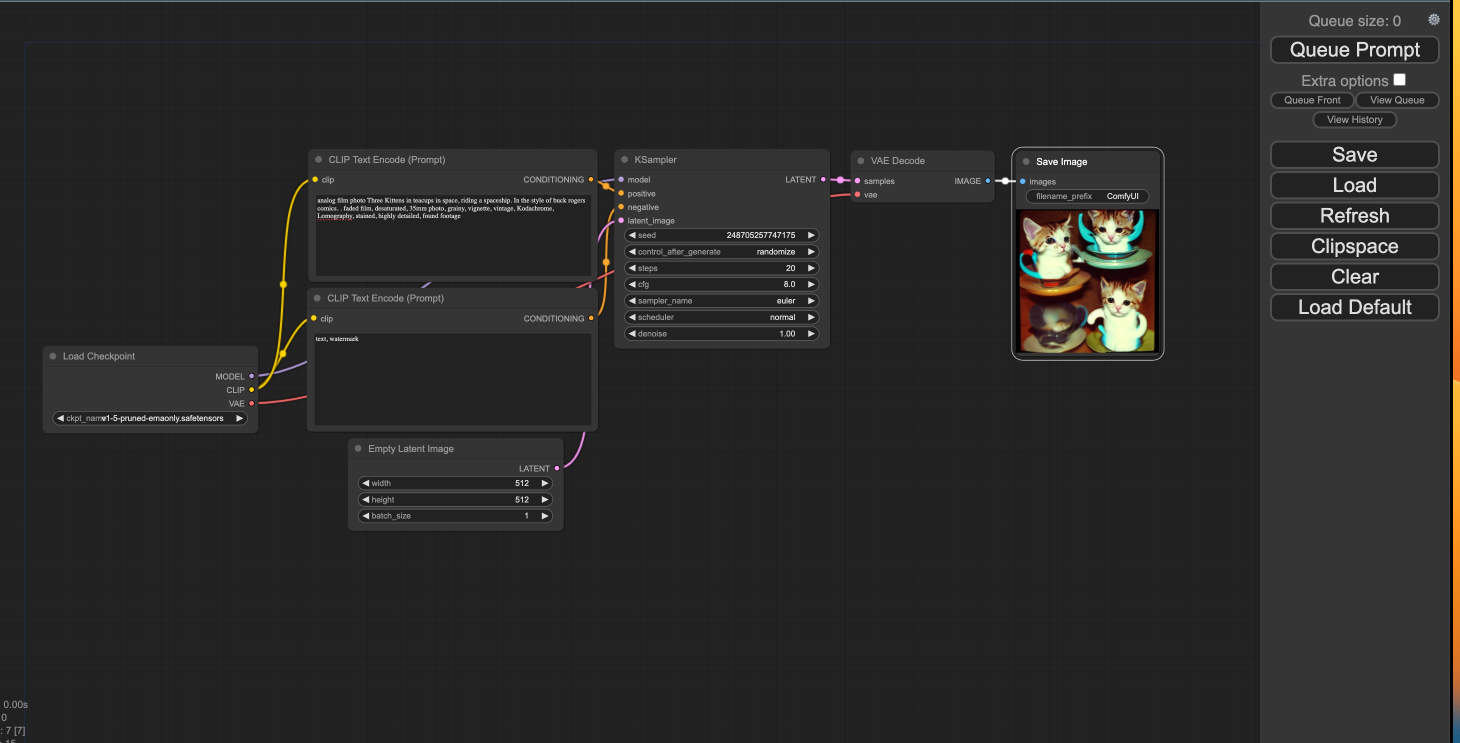

ノードベースのUIでフローを組むことができるのでアーティストやデザイナー的な感覚でも

AIフローを組んで遊べるようになれそうだったのでまずは遊べるところまでのメモです。

手軽に楽しみたい方は親切な方がGoogle Colabバージョンを作っていただいてるようです。 https://colab.research.google.com/github/mkshing/notebooks/blob/main/stable_video_diffusion_img2vid.ipynb?authuser=2#scrollTo=aaimSFWfLPgb

ComfyUIをM1AppleSiliconインストール

HomeBrewとPython3.xが事前にインストールされている状態からスタートします。

スペックはこんな感じ。

英語が得意な方は、ReadMeにわかりやすく書いてあった。

ComfyUIをローカルにクローン

インストールしたいところにcdで移動してgitクローン。

git clone https://github.com/comfyanonymous/ComfyUI?tab=readme-ov-file

次にAccelerated PyTorch training on Mac の指示に従ってconda環境整備。

curl -O https://repo.anaconda.com/miniconda/Miniconda3-latest-MacOSX-arm64.sh

sh Miniconda3-latest-MacOSX-arm64.sh

pip3が入っていたのでこちらでインストール。

pip3 install --pre torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/nightly/cpu

動作確認

ターミナルにpythonと打ってインタラクティブモードで起動して、以下を貼り付ける。

import torch

if torch.backends.mps.is_available():

mps_device = torch.device("mps")

x = torch.ones(1, device=mps_device)

print (x)

else:

print ("MPS device not found.")

結果にこれが出れば成功らしい。

tensor([1.], device='mps:0')

次にComfyUIで画像生成してみる。

ComfyUIのディレクトリに移動

cd ComfyUI

PIPインストールで依存したライブラリーをインストール

pip install -r requirements.txt

学習モデルをComfyUI/models/checkpoints/ に格納する必要がある。

以下のリンクから学習済みモデルをインストール。v1-5-pruned-emaonly.safetensorsってモデルをダウンロードして先ほどのフォルダに格納。

main.pyを起動。

python main.py

ブラウザを開いて http://127.0.0.1:8188/ を開く

プロンプトを適当に打って、Queue Promtで実行する。

数秒待つと、一番右のノードに猫ちゃんが出てきた。わーい🙌

これでノードをつなげてAIパイプラインを感覚的に組めそう。いっぱい遊べそうすな。

おわり。

参考リンク