はじめに

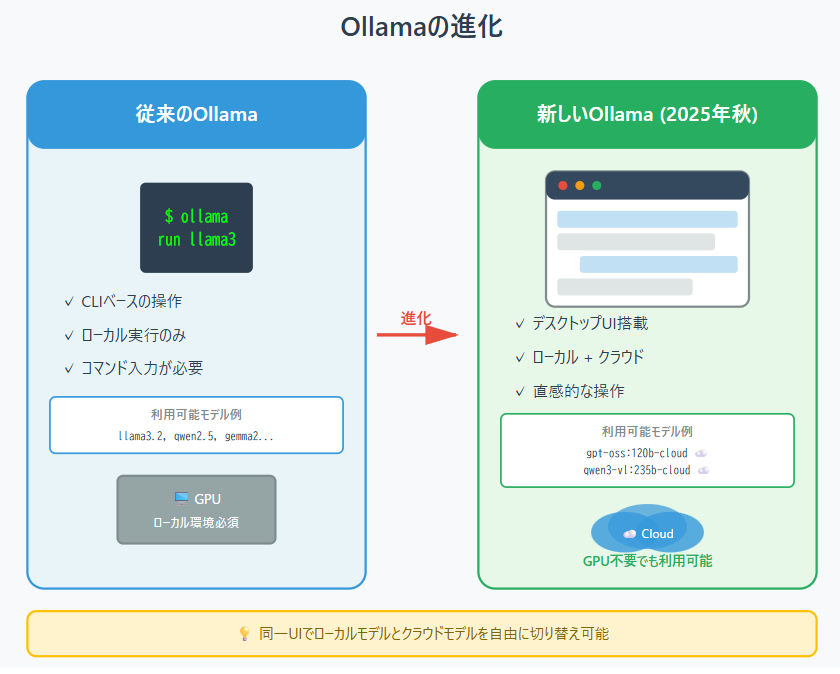

これまでOllamaといえば「CLIで動かすローカルLLM」の印象が強いツールでした。しかし、2025年秋現在、Ollamaはクラウドモデル対応と同時に、デスクトップアプリに統合されたUI の提供が進んでいます。

本記事では、実際にOllama付属のUIでクラウドモデルを試してみた感想を紹介します。

検証環境

- OS: Windows 11

-

Ollama バージョン:

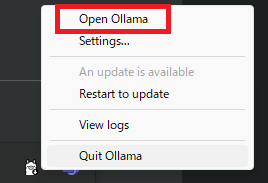

ollama v0.12.5(2025年10月時点) - 実行方法: タスクトレイのOllamaアイコンから「Open Ollama」を選択

UIの起動方法

起動の流れ

- Ollamaをインストールすると、デスクトップアプリケーションとして常駐

- タスクトレイ(Windowsの場合)のOllamaアイコンを右クリック

- メニューから「Open Ollama」を選択

- 専用のUIウィンドウが起動し、チャット形式の画面が表示されます

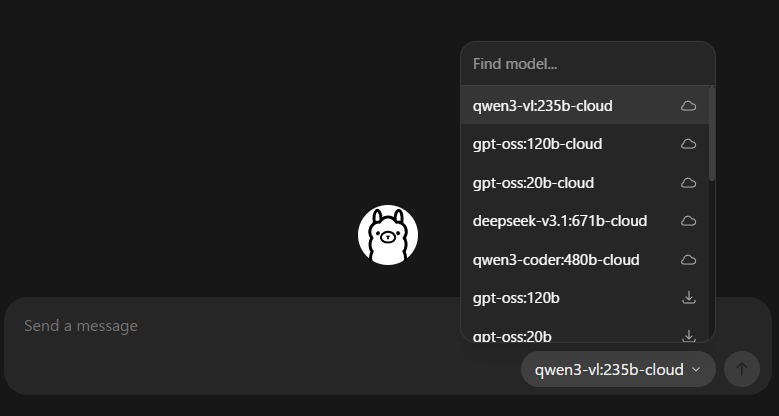

- olllmaのアカウントでログインするとクラウドモデルが使えるようなります。

UIイメージ(実際の画面例)

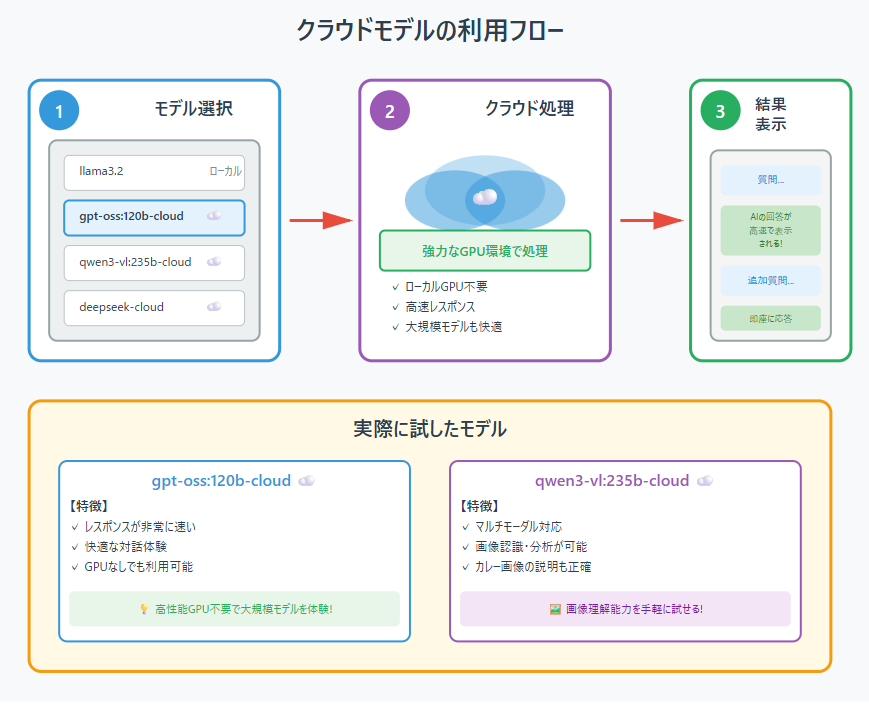

クラウドのモデルは雲のアイコンがついてます。

gpt-ossやqwen3やdeepseekなどのモデルが現時点で利用できました。(2025年10月時点)

クラウドモデルを使ってみた

ローカルとクラウドの統一感

- モデル名の末尾に「-cloud」が付くとクラウド実行モード

- 同一UIでローカル/クラウド両方のモデルを切替可能

- GPUのない端末でもクラウドモデルが動くのが便利

- クラウドモデルを使用するには、Ollamaアカウントでのサインインが必要

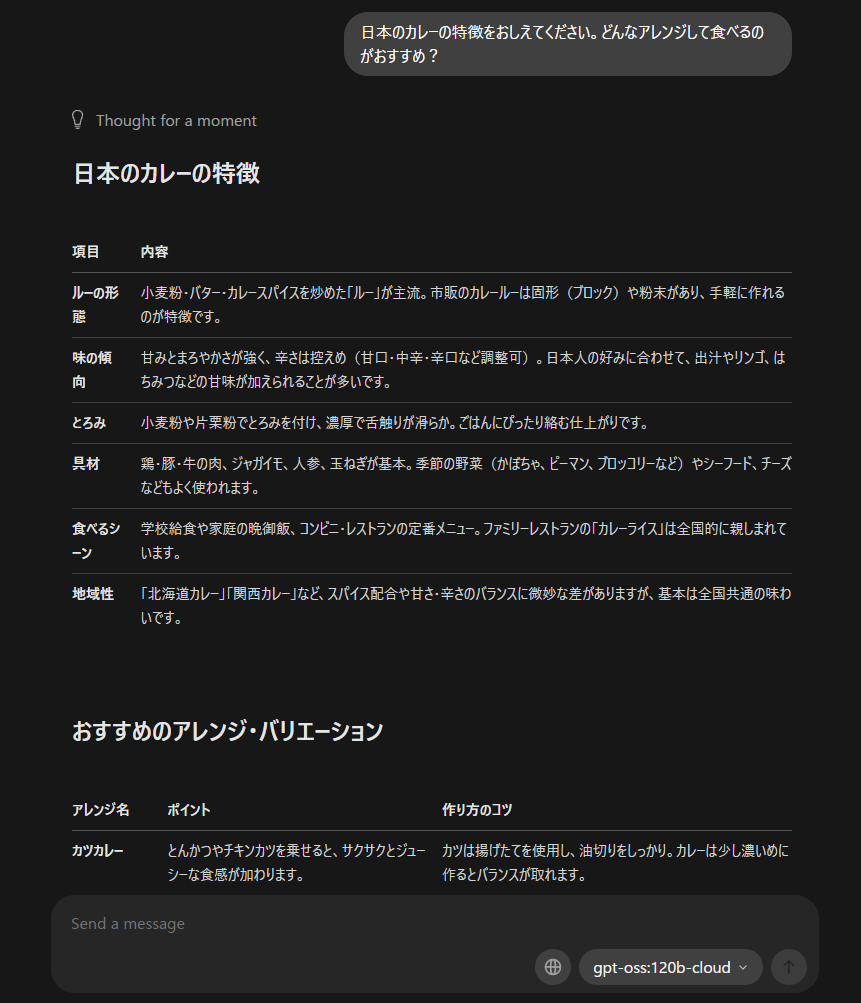

gpt-oss:120b-cloud はレスポンスが非常に速く、快適に利用できました。

物理的に高性能なGPU環境を持っていなくても、クラウド経由で大規模モデルを手軽に試せるのが魅力です。

もし「気になるモデル」「試してみたかったモデル」がある方は、Ollamaをインストールして実際に試してみるのもおすすめです。ローカル環境でもクラウド環境でも、手軽に最新のLLMを体験できます。

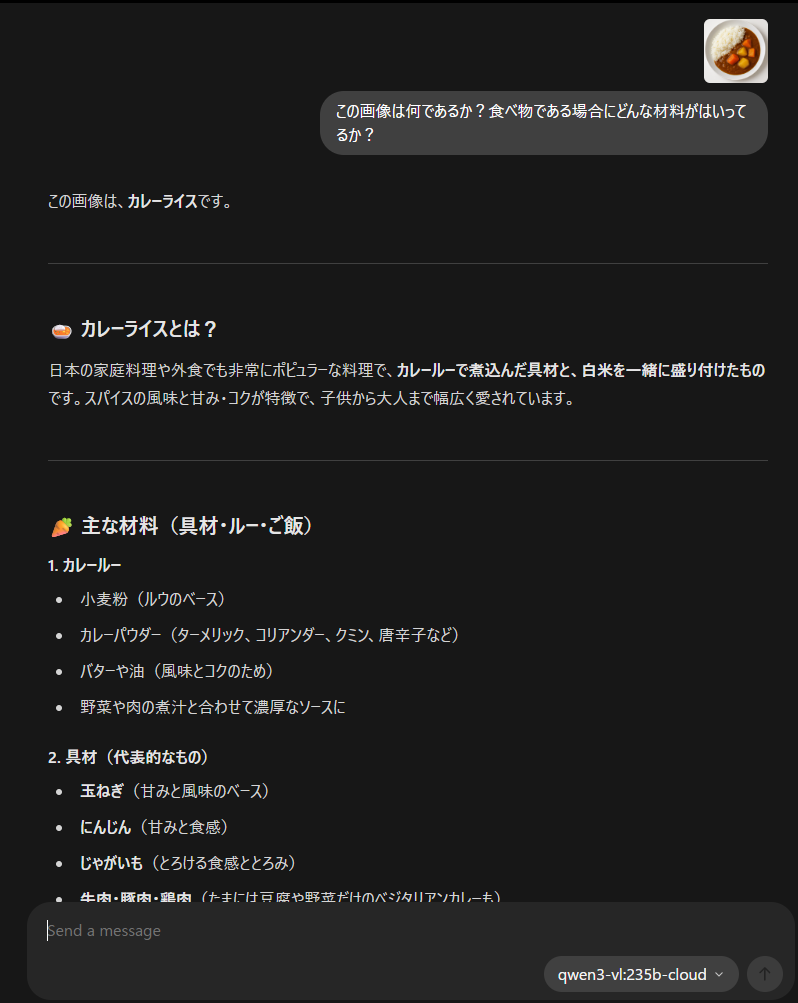

qwen3-vl:235b-cloud も試してみました。

カレーの画像を入力して分析させたところ、画像内容をしっかり理解して説明してくれる印象でした。

マルチモーダルモデルとしての性能を手軽に体験できるのは魅力です。

実際に使ってみた感想

ChatGPTやGeminiのような自然なUIで対話できます。モデル選択もUI上でクリックだけで変更可能で、llama3.2とqwen3-vl:235b-cloudの切替も簡単に行えました。

ローカルモデルでは処理が重い大規模なモデルも、クラウド版なら快適に動作します。特にGPUを搭載していない環境では、この恩恵が大きいと感じました。

実用的な使い方の提案

クラウドモデルは、気軽に実験や検証を行うのにぴったりです。

プロンプトの工夫やモデル比較、アイデア検証などに使えます。

機密情報を含まない範囲で試すなら、高性能モデルを簡単に体験できるのが魅力です。

まとめ

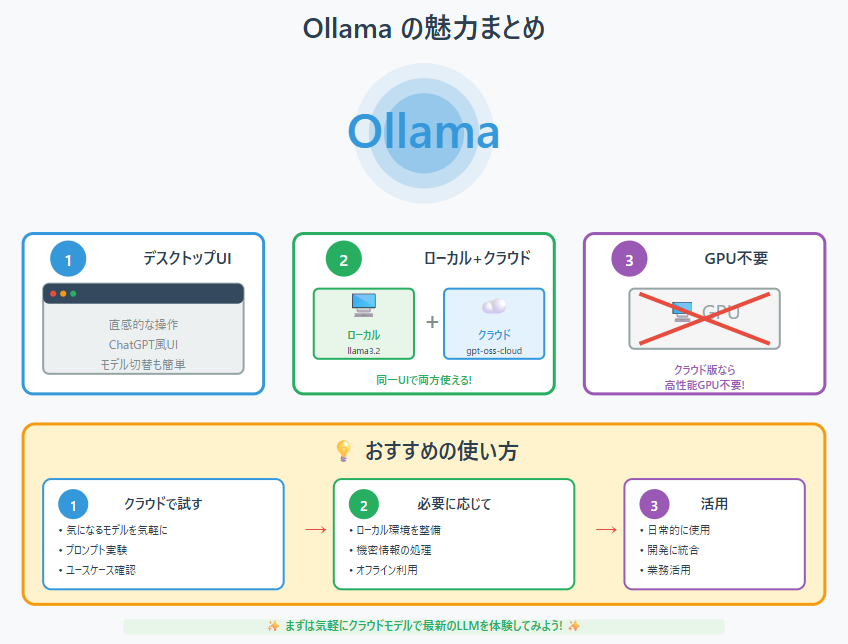

Ollamaの付属UIは、軽快で直感的に使えるデスクトップインターフェースとして実用性の高いツールです。

特に、クラウドモデル対応によりGPUを持たない環境でも高性能なLLMを利用できるようになった点は大きな進化といえます。日常的なプロンプト実験やモデル比較など、個人レベルでの検証にも非常に扱いやすい印象です。

まずはクラウドモデルで試してユースケースを確認し、必要に応じてローカル環境を整えるのも良いでしょう。

また、個人的な挑戦としてクラウド上でさまざまなモデルを試してみるのもおすすめです。

参考情報