環境

MacbookAir M3

macOS Tahoe 26.1

Docker version 29.1.2

Open Notebookセットアップ

Open Notebookのイメージはdocker hubにあるそうなので、

dockerで起動させるためにdocker-compose.ymlを書く

services:

open-notebook:

image: lfnovo/open_notebook:v1-latest-single

ports:

- "8502:8502" # WebUI用

- "5055:5055" # API用

environment:

OLLAMA_API_BASE=http://host.docker.internal:11434

SURREVAL_URL=root

SURREVAL_USER=root

SURREVAL_PASSWORD=root

SURREVAL_NAMESPACE=open_notebook

SURREVAL_DATABASE=production

volumes:

- ./notebook_data:/app/data

- ./surreal_data:/mydata

restart: always

あとはDockerを起動させる

docker compose up -d

localhost:8502でWebUIにアクセスできたら成功!

Ollamaセットアップ

次にローカルで動かすLLMをセットアップする。

1, Ollamaをインストール

サイトからOllamaをインストールしてきます。

(以下のコマンドでも可能)

curl -fsSL https://ollama.ai/install.sh | sh

一応入ったかどうか確認

$ ollama --version

ollama version is 入ったバージョン

2, モデルを入れる

今回はqwen3を入れてみる

ollama pull qwen3

3, ネットワークの設定

私はOpen NotebookをDockerでOllamaをローカルで建てるのですが、

Ollamaはローカルホストからの通信しかバインドしないので

Dockerの通信を拒否してしまいます。

OllamaにDockerからの通信も受け付けてもらうために環境変数を設定しておきます。

echo 'export OLLAMA_HOST=0.0.0.0:11434' >> ~/.zshrc

Open NotebookのModelを設定する

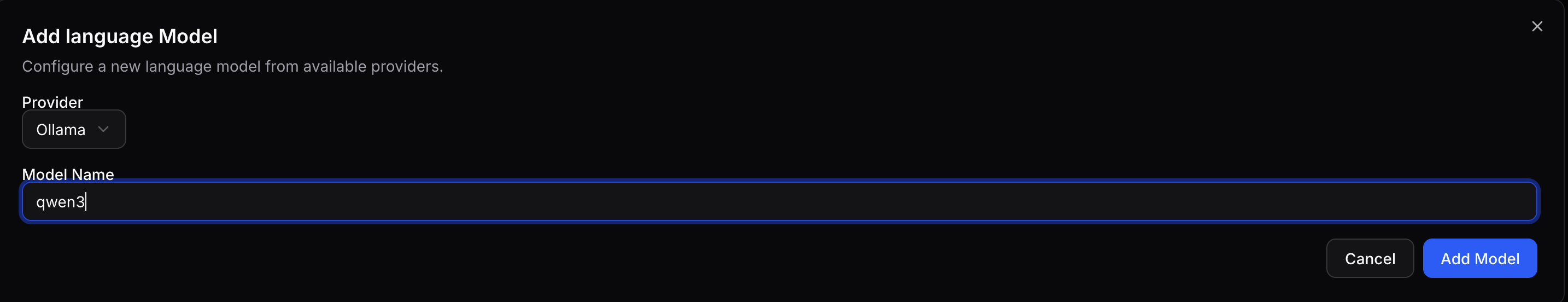

左のサイドバーから「Models」を選び、

「Language Model」を「Add Model」からモデルを追加する

(今回はProviderをOllama、Model Nameをqwen3)

「Chat Model」と「Transformation Model」をqwen3に設定

これでセットアップは完了です!

参考リンク

公式レポジトリ

open_notebookのdockerイメージ

更新履歴

12/19 compose.ymlのOLLAMA_API_BASEのアドレスが異なっていたので修正